GBDT (梯度提升决策树) 又叫 MART(Multiple Additive Regression Tree),是一种表达能力比较强的非线性模型。GBDT是基于Boosting 思想的ensemble模型,选择决策树作为基分类器,具有以下优点:

- 处理稠密连续值特征(特征的量纲、取值范围无关,故可以不用做归一化)

- 学习模型可以输出特征的相对重要程度,可以作为一种特征选择的方法

- 对数据字段缺失不敏感

- 根据熵增益自动进行特征转换、特征组合、特征选择和离散化,挖掘高维的组合特征,省去了人工转换的过程,并且支持了多个特征的Interaction

Gradient Boosting算法基本流程:

在每一轮迭代中,首先计算出当前模型在所有样本上的负梯度,然后以该值为目标训练一个新的弱分类器进行拟合,并利用损失函数计算出该弱分类器的权重,最终实现对模型的更新

采用决策树作为弱分类器的 Gradient Boosting算法被称为GBDT, GBDT 中使用的决策树通常为 CART。

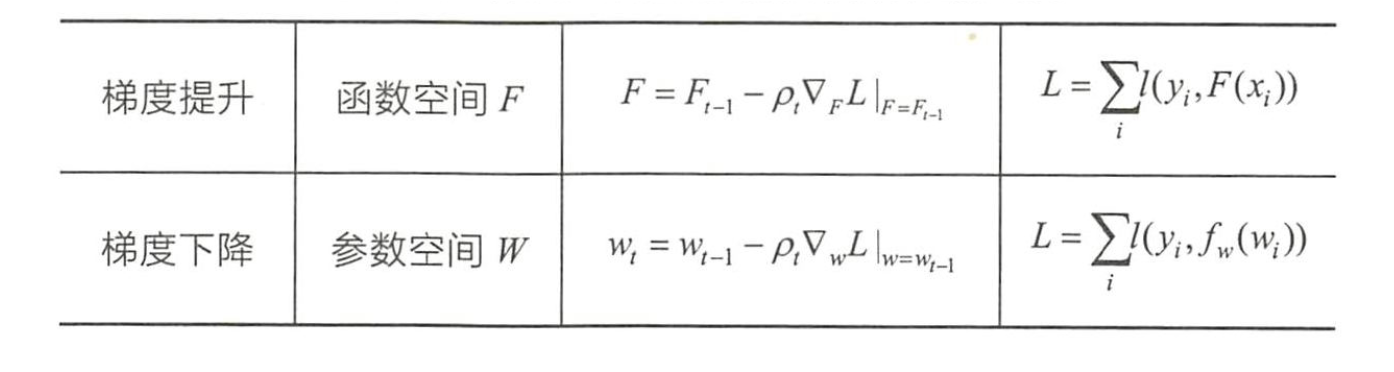

梯度提升和梯度下降的异同

GBDT 使用梯度提升( Gradient Boosting )作为训练方法,而在逻辑回归或者神经网络的训练过程中往往采用梯度下降( Gradient Descent )作为训练方法,二者之间有什么联系和区别吗?

两者都是在每一轮迭代中, 利用损失函数相对于模型的负梯度方向的信息来对当前模型进行更新,只不过在梯度下降中, 模型是以参数化形式表示,从而模型的更新等价于参数的更新, 而在梯度提升中,模型并不需要进行参数化表示,而是直接定义在函数空间中,从而大大扩展了可以使用的模型种类。