基本术语

数据

- 特征,⼜称为属性

- 属性值:特征的离散取值,或者,连续取值;

- 样本维度(Dimensionality):特征个数

- 特征张成的空间:属性空间/特征空间/输⼊空间

- 标记张成的空间:标记空间/输出空间

- ⽰例(Instance)/样本(Sample):⼀个对象的输⼊(⽐如,⼀个⻄⽠的描述)⽰例不含标记

- 样例(Example):⽰例+标记

- 训练集 = ⼀组训练样例

- 测试集 = ⼀组测试样例

任务

根据标记的取值

- 分类。标记是离散的

- 回归。标记是连续的

- 聚类。标记是空的,自动分组

根据标记的完整程度

- 有监督学习

- 无监督学习

- 半监督学习

概念学习

最理想的就是学习到概念

假设空间:所有的可能假设

版本空间:和训练集一致的假设集合

归纳偏好:学习过程中对某种类型假设的偏好称作归纳偏好

根本目标就是泛化能力

未来的样本未知,假设和现在的历史数据分布一致来逼近泛化能力

有一个算法好,那么一定有另一个算法在另一个问题上更好

没有免费的午餐,脱离具体问题讨论算法无意义

模型评估

目标:模型在未来数据的表现最好

未来数据得不到,利用假设根据历史性能来选择

经验性能

过拟合

训练样本学习的太好,把一些训练样本的特征作为所有样本的一般性质,导致泛化能力下降

欠拟合

对训练样本的一般性质尚未学习好

经验性能估计

- 留出法,切割为训练和测试集

- 需要保证切割的一致性,分布一致

- 需要保证类别一致

- 多次随机划分,结果取平均值

- 交叉验证法,切割k-1作为训练,1作为测试(K折训练是每一次从头开始训练还是叠加训练?如果是在选择算法的时候使用K折,然后把结果平均作为最后的结果。那如果是确定了算法需要求一个最好的结果呢)

- 如果k=样本数目,那就是留一法。不受随机划分影响,结果准确,计算复杂

- 自助法,boostrapping,有放回的取m次,m无穷大时会有0.368的样本永远不被选中

- 数据集小,难以划分的时候可以用

- 在集成学习中好用

- 一般在数据够的时候,使用留出法和交叉验证

性能度量

性能度量是衡量模型泛化能力的评价标准,反映了任务需求;

使用不同的性能度量往往会导致不同的评判结果

回归任务最常使用的就是均方误差

分类任务用精度和错误率,错误率是分错的占所有样本的比例,精度是分对的占所有的总数

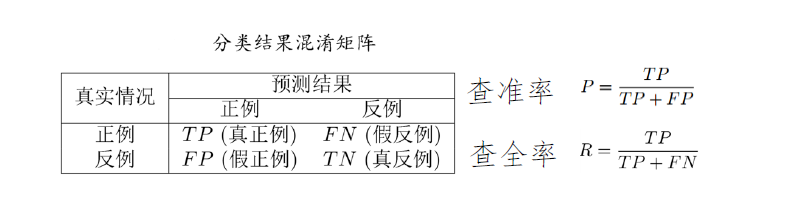

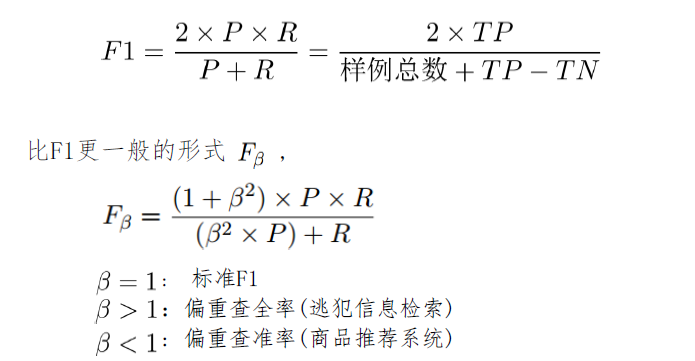

根据学习器的预测结果按正例可能性大小对样例进行排序,并逐个把样本作为正例进行预测,则可以得到查准率-查全率曲线,简称“P-R曲线”用平衡点来比较。更加常用的就是F1

查准:正确正例/模型认为的正例

查全:正确正例/总的正例

类似于PR曲线,可以用每一个样本的预测值作为阈值计算结果,然后横坐标是假正率,纵坐标是真正例率

- 若一条曲线包住另一条,包住的好

- 若有交叉,AUC大的好,即面积大的好

在预测的时候不同类型的错误带来的代价不同,因此为了权衡,赋予非均等代价

比较检验

没看懂

二项检验

T检验

交叉验证 T检验

偏差和方差

简单的说,偏差是训练集上模型输出和标注的差,体现了训练是否充分

方差是同样大小的训练数据得到的结果的差距,体现的是一种数据对模型的扰动

高方差低偏差:过拟合

低方差高偏差:欠拟合