AI绘画相信大家都已经不陌生了,虽然AI绘画出图很方便,但是要让其生成一副自己满意的图,还是需要费一番心思,有时候多次调整关键词就是生成不了自己想要的画面,这些一直以来都是AI绘画的痛点

但就在最近,一款名为“ControlNet”AI绘画插件的出现,几乎可以说是完美解决了AI绘画的痛点,它可以几乎做到完美控制画面

目前ControlNet能做到骨骼绑定,精准控线,依据3D视图的法线进行绘图,线稿上色,依据深度图结构透视精准重绘(可以简单理解为3渲2)等

注意:目前ControlNet是AI绘画界最大的热点,其更新速度极快,考虑到时效性,本文仅作当前参考

ControlNet的绘画模式是:先让用户输入一张参考图,然后程序根据此图按一定的模式预处理一张新图,之后再由AI根据这两幅图绘制出成品;当然,用户可以关闭程序的预处理功能,直接输入一张用户自己处理好的图片当作预处理图,之后AI仅根据这副图生成成品。

如果有人对AI绘画不够了解,可以参考我之前的一篇介绍AI绘画的文章

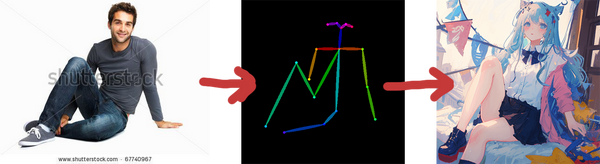

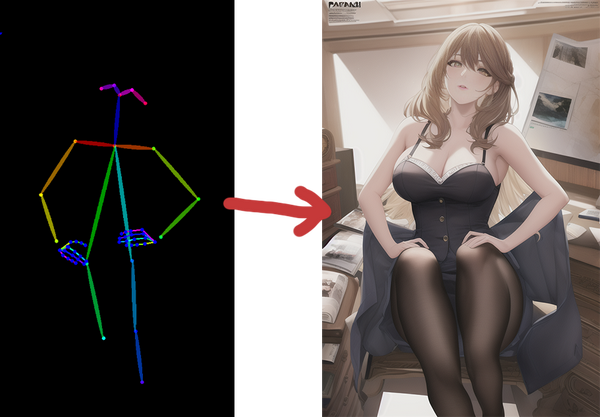

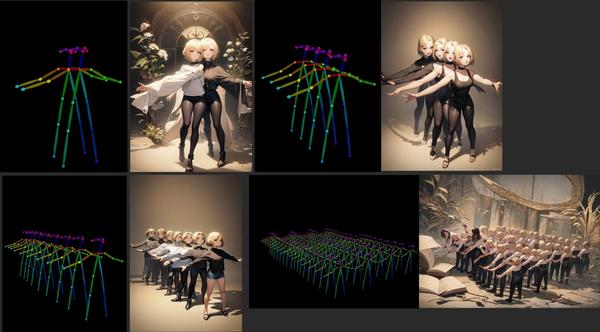

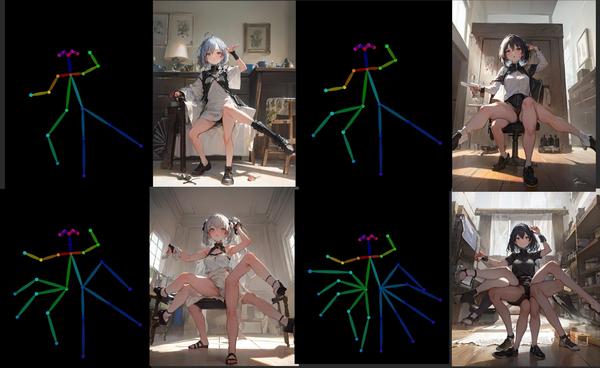

一.骨骼绑定-OpenPose

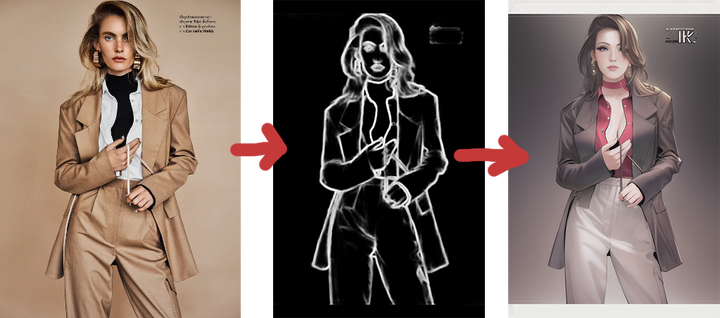

用户可以输入一张姿势图片(推荐使用真人图片)作为AI绘画的参考图,输入prompt后,之后AI就可以依据此生成一副相同姿势的图片;当然了,用户可以直接输入一张姿势图,如下图:

注意:OpenPose模型已经更新手部骨骼了,手指的问题和多人问题将很快被解决

二.精准控线

2.1 Canny模型

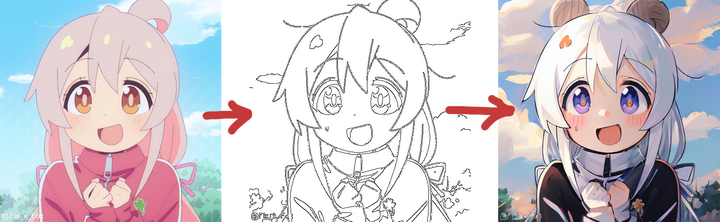

用户输入一张动漫图片作为参考,程序会对这个图片预加载出线稿图,之后再由AI对线稿进行精准绘制(细节复原能力强)

2.2 Hed模型

相比Canny自由发挥程度更高

2.3 Scribble模型

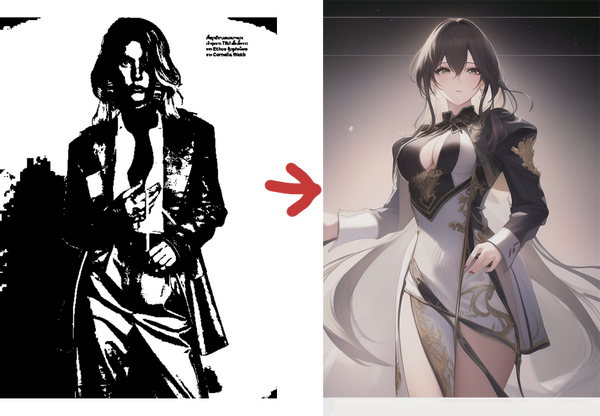

涂鸦成图,比Canny自由发挥程度更高,以下为低权重成图

2.4 Seg模型

区块标注,适合潦草草图上色

2.5 Mlsd模型

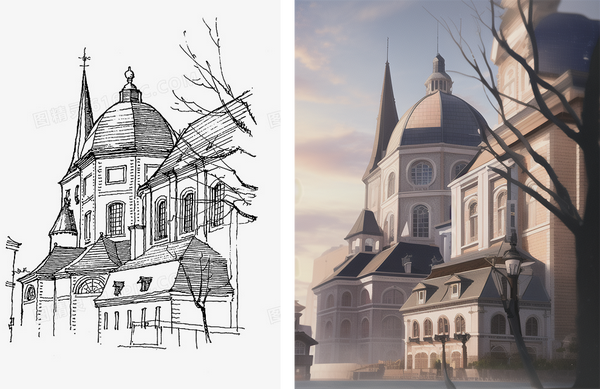

建筑物线段识别

三.三维制图

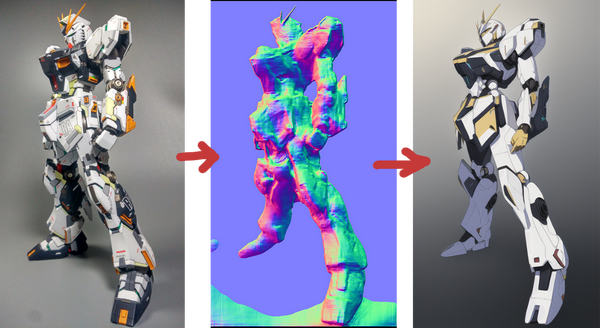

3.1 Normal模型

适用于3维制图,用于法线贴图,立体效果

AI会提取用户输入的图片中3D物体的法线向量,以法线为参考绘制出一副新图,此图与原图的光影效果完全相同

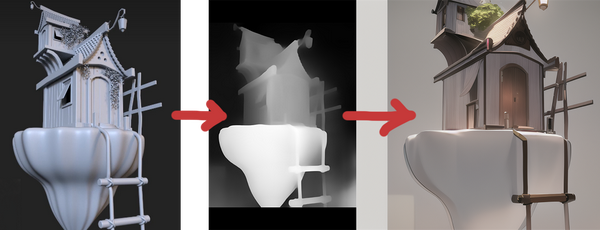

3.2 Depth模型

该模型可以较好的掌握图片内的复杂3维结构层次,并将其复现

它会从用户输入的参考图中提取深度图,再依据此重现画面的结构层次

这也就说明了我们可以直接通过3D建模软件直接搭建出一个简单的场景,再将其抛给AI绘画”Depth”模型去”渲染“

ControlNet安装教程

前提:你要将AI绘画的WebUI更新到最新版本

将https://github.com/Mikubill/sd-webui-controlnet仓库中的内容拉取到WebUI文件目录下extensions文件夹内

也可以直接下载zip

下载该网站下的内容https://huggingface.co/lllyasviel/ControlNet/tree/main/annotator/ckpts,将其放到插件目录下的annotator下的ckpts目录

下载https://huggingface.co/webui/ControlNet-modules-safetensors/tree/main下的模型到插件目录下的models目录

现在你的ControlNet已经安装完毕

具体使用教程推荐B站视频https://www.bilibili.com/video/BV1Wo4y1i77v

2023/2/20更新

我发现现在很多人对于AI绘画的认知还是停留在prompt(关键词)时代

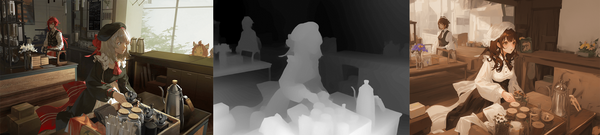

其实现在的AI绘画领域主要比拼的是AI绘画大模型和Lora模型的综合运用,一个好的AI绘画模型对画面的质量是起决定性作用的,Prompt已经显得没有之前那么重要

此外,AI绘画的开源和插件化也使得训练AI模型的成本大大降低。以前只有大型公司才能拥有足够的资源来训练高质量的AI模型,现在通过开源的代码库和插件,个人也可以在自己的电脑上训练高质量的AI模型,甚至可以根据自己的需求进行定制。这种开源的趋势使得AI绘画技术更加民主化,让更多的人能够参与到AI艺术的创作和研究中来

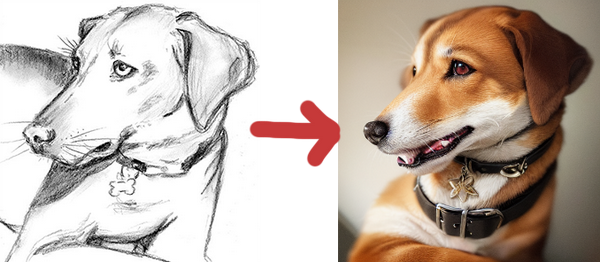

以下分享一些来源于网络中各路大佬利用优质AI绘画大模型结合优质Lora模型生成的图