了解技术原理

1.背景

AI模型可大致分为决策式/分析式AI(Discriminant/Analytical AI)和生成式AI(GenerativeeAI)两类。

决策式AI:学习数据中的条件概率分布,根据已有数据进行分析、判断、预测,主要应用模型有用于推荐系

统和风控系统的辅助决策、用于自动驾驶和机器人的决策智能体。

生成式Al:学习数据中的联合概率分布,并非简单分析已有数据而是学习归纳已有数据后进行演技创造,基

于历史进行模仿式、缝合式创作,生成了全新的内容,也能解决判别问题。

PitchBook联合发布的2022年智能应用前40榜单(IntelligentApplications40,IA40)IA40招募了来自40多家顶级风险投资和投资公司的50多名风险50亿美元,其中包括Runway、Jasper、Copy.ai在内的14家生成式A相关公司,占比达35%。

多家知名风投公司看好生成式AI赛道:

Coatue发布的《AI2022:爆发》认为规模化突破使得AI在短时间内变得指数级强大,其应用场景迅速突破。

2022年10月,StabilityAI完成1.01亿美元融资,估值10亿美元,投资方包括Coatue、LightspeedVenture Partners和OShaughnessyVentures。公司由前英国对冲基金经理EmadMostaque于2020年成立。

2022年10月,Jasper完成1.25亿美元融资,估值达15亿美元,投资者包括Coatue、BessemerrVenture Partners、IVP等多家机构。

2019年,OpenAI获得微软10亿美元投资,2021年OpenAl估值已达200亿美元。

2.现状

架构改进:深度神经网络的学习能力和模型的大小呈正相关,但规模越大训练难度越高,需要对结构进行改进,拥有更强并行性的Transformer架构带来了深度神经网络参数量从最早的几万到目前的数千亿的跃升。

模型发展:GPT-3、CLIP、Difusion、DALL·E2等模型的提出极大提升了AI处理NLP、跨模态、生成问题的能力。

数据增多:拥有的优质训练数据越多,算法从中学习的效果越好。随着数字时代的到来,生成数据的工具和软件越来越普遍,数据总量呈指数增长,可供A训练的数据质量和数量均有很大提升。

算力提升:大规模深度学习模型的参数和数据量达到了一定量级,需要相应算力的支撑,目前,大规模模型的训练算力是原来的10到100倍。

领域代表

1.语言

GPT:2018年由OpenAI提出,参数量1.17亿,预训练数据量约5GB,基于Transformer模型充分利用海量无标注文本进行预训练,赋予文本大模型在小数据集、零数据集下的理解和生成能力,提升了生成式AI的认知能力。2020年GPT-3推出,参数量达1750亿,预训练数据量达45TB,除自然语言推理、句子关系判断、问答、常识推理、分类等常见NLP任务外,GPT-3在操写文章、编写

CLIP:2021年由OpenAI提出,利用文本信息监督视觉任务自训练,训练数据集为40亿个“文本-图像”对,采用Transfomer模型对图像的patch序列进行建模,将不同模态的原始数据映射到统一或相似的语义空间,实现不同模态信号间的相互理解,拥有寻找不同模态数据间关系的能力,基于此能够实现不同模态数据间转化与生成,进一步可以根据图片生成对应语言描述也可以根据语言提示生成对应的图片,极大丰富了生成式AI技术的应用广度,为AIGC带来了更多的可能性。

2.图像

扩散模型(Diffusionmodel):扩散模型的概念最早在2015年“DeepUnsuperviseddLearningusingNonequilibrium Thermodynamics”中被提出。2020“DenoisingDifusionProbabilisticModels”中提出DDPM模型用于图像生成。扩散模型通过给图像增加高斯噪声破坏训练数据来学习,找出逆转噪声过程的方法,利用学习到的去噪声方法实现从随机输入中合成新的图像。该算法在分子图生成中可以进行药物分子和蛋白质分子的生成。

DALL·E2:2022年4月由OpenAI提出,基于CLIP实现文本与图像的联系,基于Diffusion从视觉语义生成图像,使用先验模型实现从文本语义到相应视觉语义的映射,最终实现以下功能:

1)根据文本生成图片:

2)将图像扩展到画布之外:

3)根据文本对图像进行编辑,实现添加或删除元素:

4)给定一张图片生成保持原风格的变体。

现阶段价值

辅助大批量内容生产,生成初稿

代表产品

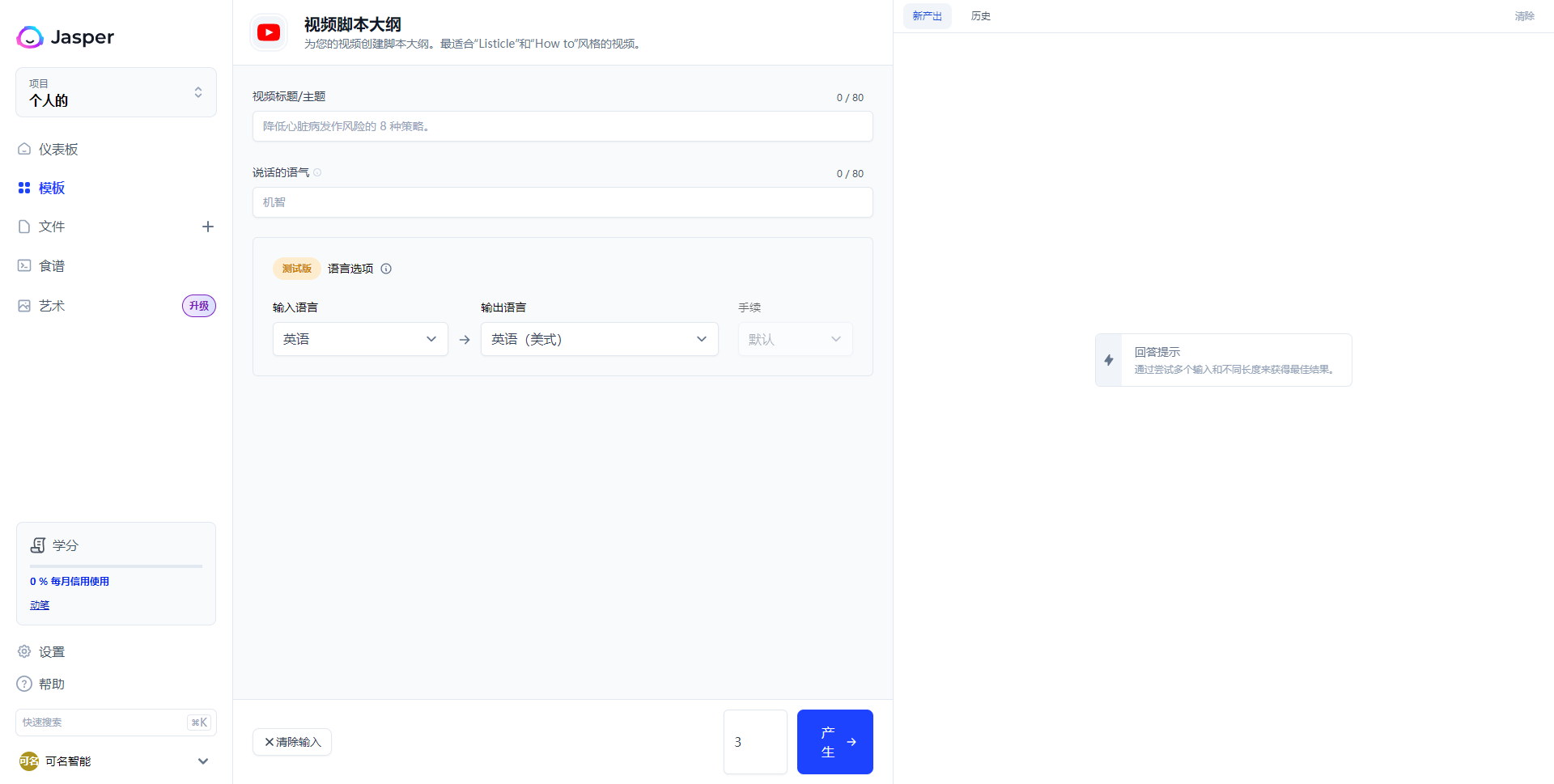

Jasper-文本

历史

新产出

视频脚本大纲

JASPER

为您的视须创建脚本大铜.最适合”LISTICLE”IRHOW TO’风格的视须.

项目

视频标题/主题

0/80

个人的

降低心应病发作风险的8种策略.

仪表板

说话的语气

0/80

:模板

机弯

十

文件

食谱

语言选项 ?

河试版

图艺术

升级

手续

输出语言

输入语言

英语(关式)

英语

默认

回答提示

通过尝试多个输入和不同长底来获得最佳结果.

学分

0%句月信用使用

数字

设置

帮助

快速换卖

生

X消除输入

可名智能

生成垂直平台的专属的文案

例如:

youtube平台视频脚本大纲生成

fotor-图片

FOTOR

俊林

CLICK HERE TO UPGRADE AND GET UNLIMITED ACCESS

NUMBER OF IMAGES

FROM IMAGE

FROM TEXT

GENERATED RATIOS R

GALLERY

MY LIKES

STYLES R

RANDOM

LOPANES

UKLYO-E

PSYCHEDELIG

OLL PAINTING

DETALLS

LIGHT EFFECTS

DOWNLOAD ALL

COMPOSITION G

CENERATE

LIGHTING,BOCKGROUND BLUR BOKEHILL, TRONDING ON PBRIV LANBOX STUDIO GHIBRLY HIGH QUALIY ARTWORK

输入描述文案生成不同风格的图片

例如:

Anime art, anime key visual of elegant young female, long blonde hair and large eyes, finely detailed perfect face, laying down in the grass at sunset, golden hour sunset lighting, background blur bokeh!!, trending on pixiv fanbox, studio ghibli, extremely high quality artwork

动漫艺术,优雅年轻女性的动漫关键视觉,长长的金发和大眼睛,精致完美的脸庞,日落时躺在草地上,金色的日落灯光,背景模糊bokeh!!,pixiv fanbox的趋势,吉卜力工作室,极高质量的艺术品

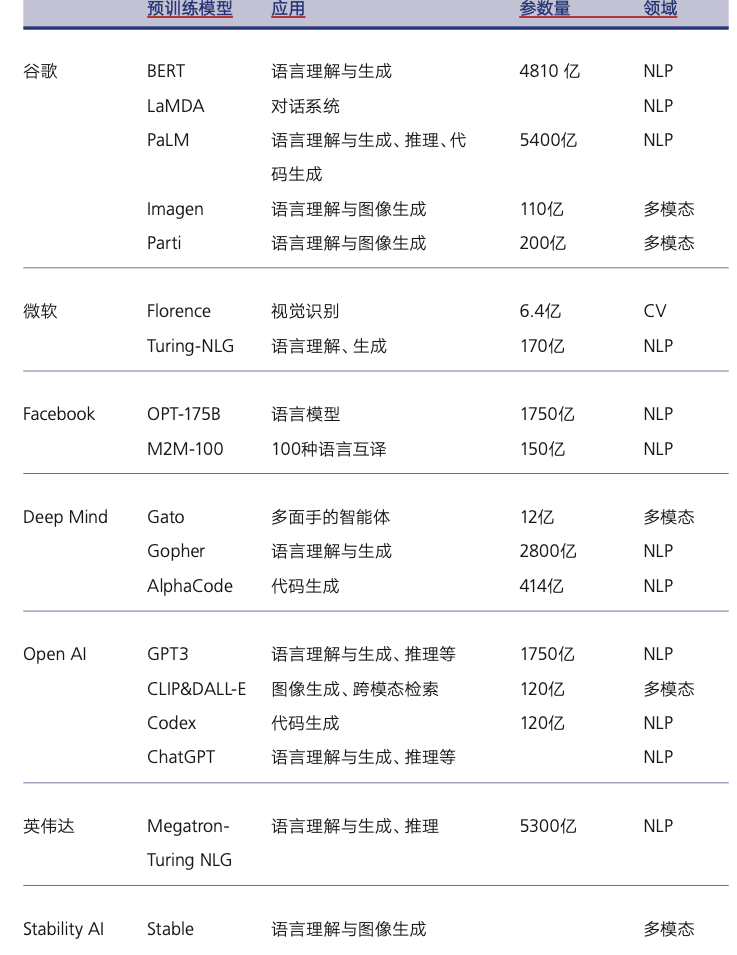

领域

预训练模型

参数量

应用

语言理解与生成

NLP

4810亿

谷歌

BERT

NLP

LAMDA

对话系统

NLP

5400亿

语言理解与生成,推理,代

PALM

码生成

语言理解与图像生成

多模态

110亿

IMAGEN

语言理解与图像生成

多模态

200亿

PARTI

视觉识别

FLORENCE

微软

CV

6.4亿

TURING-NLG

语言理解,生成

NLP

170亿

语言模型

NLP

1750亿

OPT-175B

100种语言互译

NLP

150亿

M2M-100

多面手的智能体

12亿

多模态

DEEP MIND

GATO

GOPHER

语言理解与生成

2800亿

NLP

ALPHACODE

代码生成

414亿

NLP

语言理解与生成,推理等

NLP

GPT3

1750亿

OPEN AL

多模态

120亿

图像生成,跨模态检索

CLIP&DALL-E

CODEX

120亿

NLP

代码生成

语言理解与生成,推理等

CHATGPT

NLP

英伟达

语言理解与生成,推理

5300亿

MEGATRON-

NLP

TURING NLG

STABILITY AI

多模态

语言理解与图像生成

STABLE

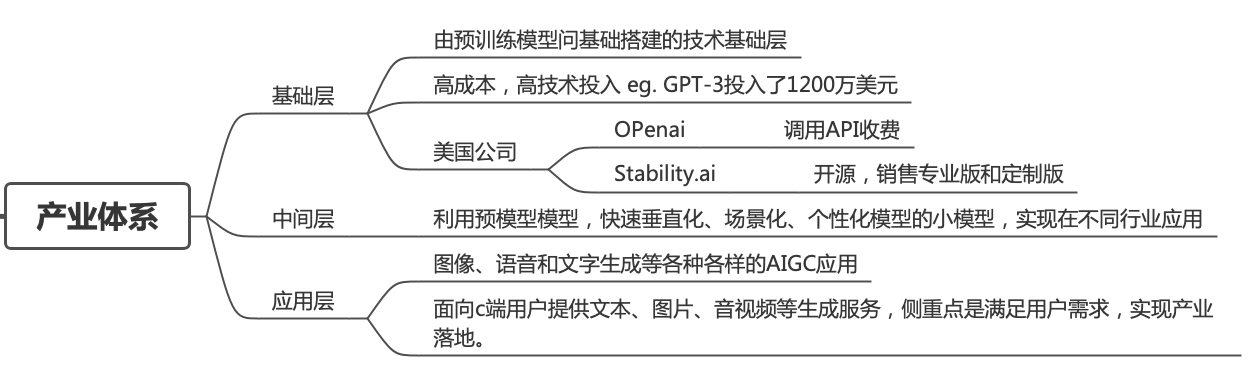

产业体系

由预训练模型问基础搭建的技术基础层

高成本,高技术投入EG.GPT-3投入了1200万美元

基础层

调用API收费

OPENAI

美国公司

开源,销售专业版和定制版

STABILITY.AI

产业体系

利用预模型模型,快速垂直化,场景化,个性化模型的小模型,实现在不同行业应用

中间层

图像,语音和文字生成等各种各样的AIGC应用

应用层

面向C端用户提供文本,图片,音视频等生成服务,侧重点是满足用户需求,实现产业

落地.

⚠️1、AIGC领域小公司的机会在哪里?

现阶段AIGC方向对于大部分公司,应用层的机会更多。考虑技术成本(算法工程师)算力成本和时间成本。基础层和中间层的成本太高。

⚠️2、在应用层中小公司做什么最合适?

训练数据和用户反馈是应用层的核心竞争力,谁能最快的拿到应用数据训练出垂直领域超用户预期的产品应用,并快速获取用户,迭代产品。谁能在该垂直领域最先站稳脚步。

⛳️ 结论

●垂类的aigc公司若能利用好私有化数据做“小而美”应用,会更有优势

chatgpt再nb,简历生成也比不过boss直聘AI团队做(也许他们会做),光有数据还不行,天然的简历曝光→双方对话→发送简历,这些行业积累..应该不会轻易被copy