逻辑回归是经典的二分类模型。但实际上除了二分类问题,现实生活中存在大量的多分类问题,比如图像识别,人脸识别等。那逻辑回归是否也可以用在多分类问题呢?

答案是可以的。其实任何的二分类模型均可以用在多分类的问题上,包括经典的SVM模型。但使用二分类模型解决多分类问题时,需要用到一些技巧。

先不考虑如何把二分类器应用在多分类问题上,而是如何把原来的二分器改造成多分类模型。 对于逻辑回归来说,这个方案是可行的。对于多分类任务,我们其实可以使用多元逻辑回归模型。

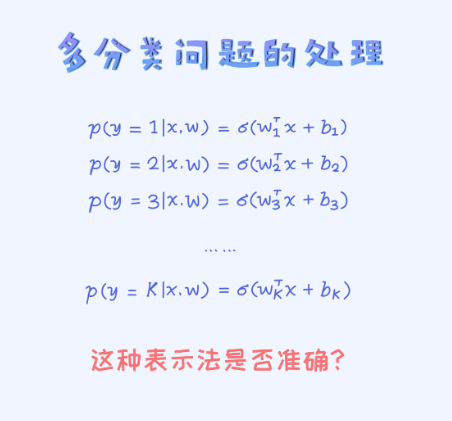

那具体如何实现多元逻辑回归呢? 一个简单直接的方法就是引入多组参数。我们先来看一个方案。

答案是不合理的。如果不仔细看的话,很有可能觉得这个方案是正确的。比如我们去预测一个样本的时候,可以分别计算出 从而选择对应概率值最大的那个y值。同时,由于加了逻辑函数,每一个条件概率都在0和1之间,所以也满足了概率的定义。那具体哪方面不合理呢?

从而选择对应概率值最大的那个y值。同时,由于加了逻辑函数,每一个条件概率都在0和1之间,所以也满足了概率的定义。那具体哪方面不合理呢?

在统计学里有一条准则叫做sum rule。 我们可以这么理解,给定一个样本,假设能计算出这个样本分别属于类别1, 类别2,…类别K的概率,而且总共有K个类别,那这时候,这些概率也需要满足一个式子:就是所有条件概率之合等于1.

所以呢,上述的改造是不正确的。虽然每个条件概率都落在(0, 1)之间,但它们之合并不等于1。这就要求在这个基础上还需要做一些改造,使得所有概率之合等于1。

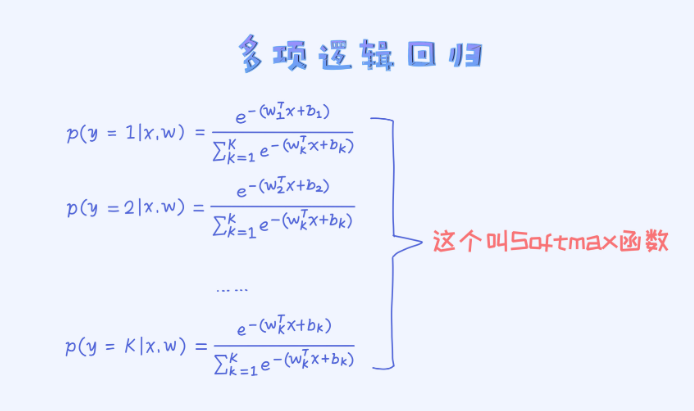

改造后的函数叫作大名鼎鼎的Softmax, 也是深度学习里最常用的一个函数。

对于每一个条件概率来说,分子和分母都是正数,所以概率值也是正数。然而,在这里每一个条件概率的分母是所有分子之合,所以所有条件概率之和也必然会等于1,而且同时满足每一个概率值落在(0, 1)区间。

所以,总体来讲,Softmax函数满足所有必要的条件。