概述

Zookeeper 是一个开源的分布式的,为分布式应用提供协调服务的 Apache 项目。

工作机制

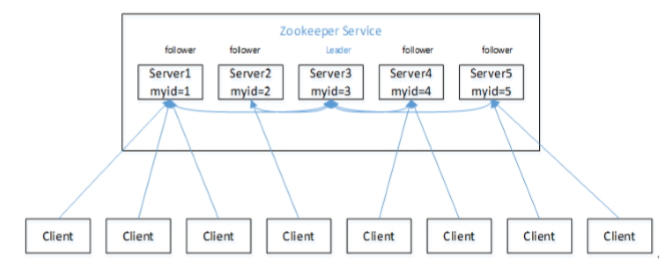

特点

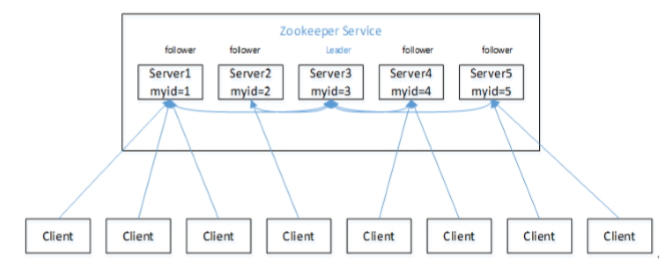

1)Zookeeper:一个领导者(Leader),多个跟随者(Follower)组成的集群。2)集群中只要有半数以上节点存活,Zookeeper集群就能正常服务。3)全局数据一致:每个Server保存一份相同的数据副本,Client无论连接到哪个Server,数据都是一致的。4)更新请求顺序进行,来自同一个Client的更新请求按其发送顺序依次执行。5)数据更新原子性,一次数据更新要么成功,要么失败。6)实时性,在一定时间范围内,Client能读到最新数据。

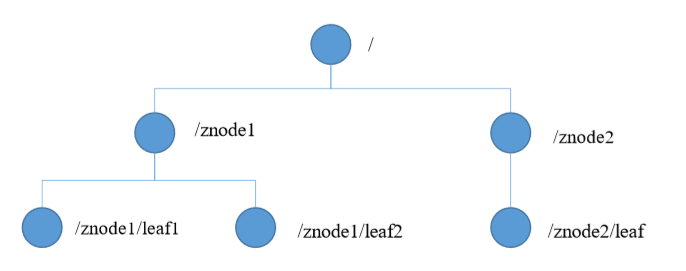

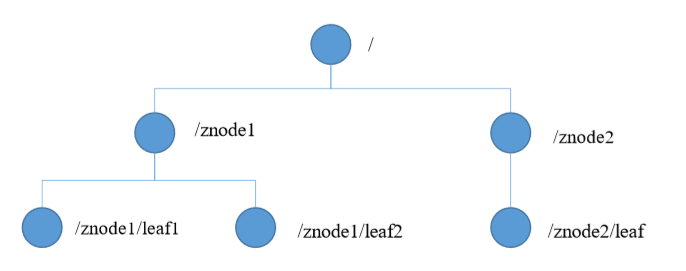

数据结构

ZooKeeper数据模型的结构与Unix文件系统很类似,整体上可以看作是一棵树,每个节点称做一个ZNode。每一个ZNode默认能够存储1MB的数据,每个ZNode都可以通过其路径唯一标识。

应用场景

提供的服务包括:统一命名服务、统一配置管理、统一集群管理、服务器节点动态上下线、软负载均衡等。

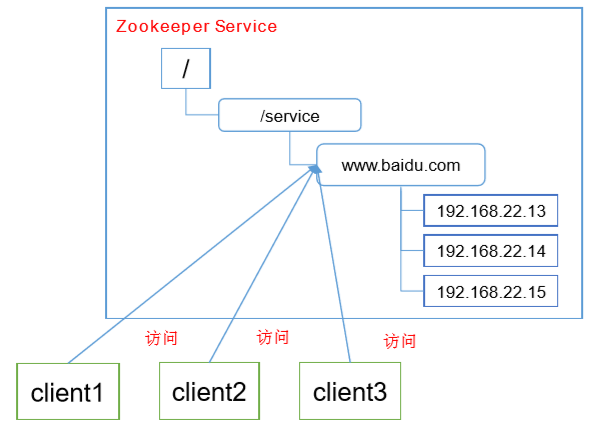

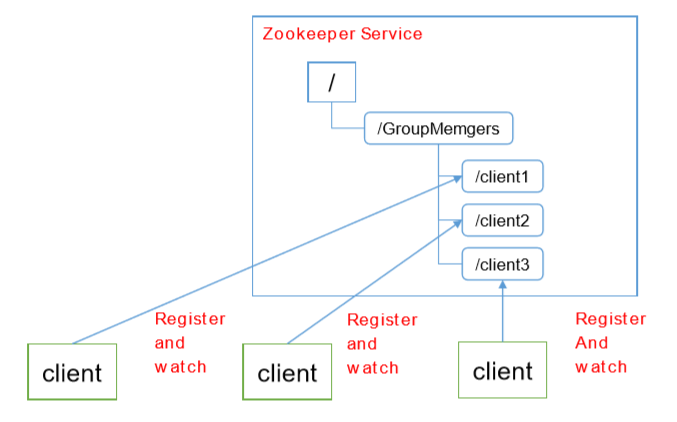

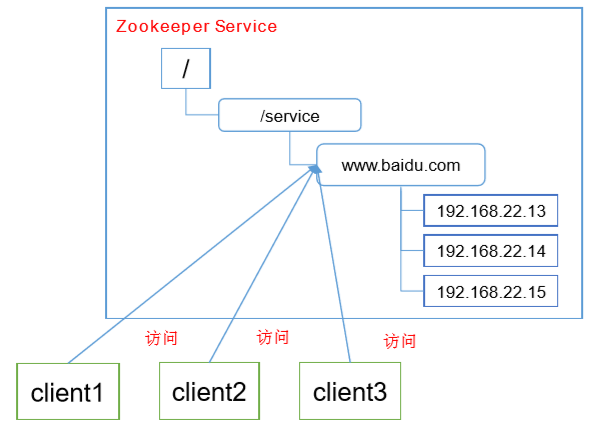

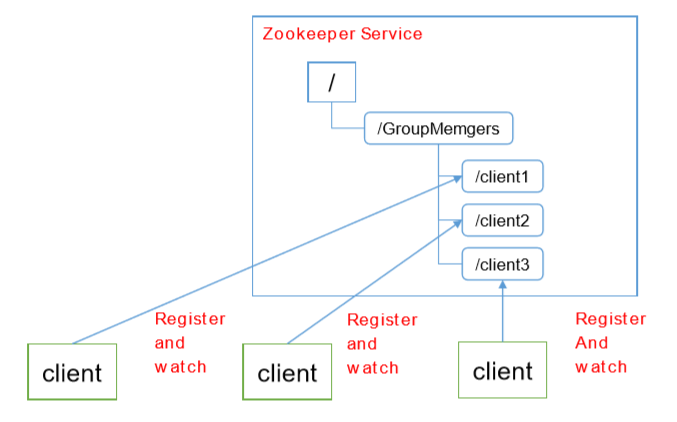

统一命名服务

在分布式环境下,经常需要对应用/服务进行统一命名,便于识别。例如:IP不容易记住,而域名容易记住。

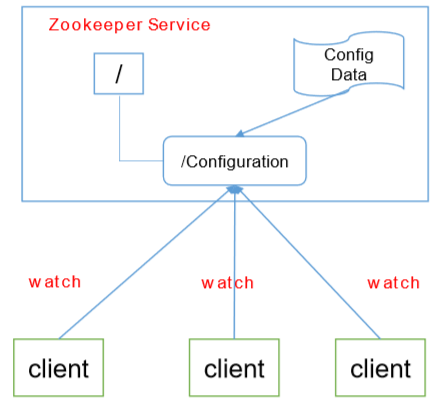

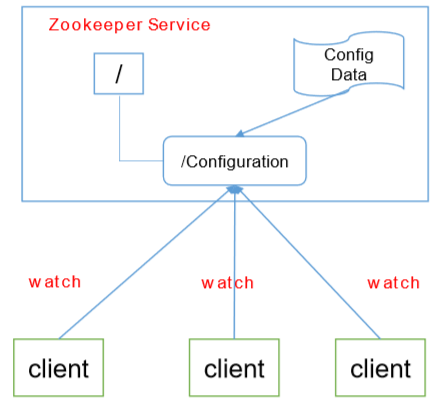

统一配置管理

1.分布式环境下,配置文件同步非常常见。(1)一般要求一个集群中,所有节点的配置信息是 一致的,比如 Kafka 集群。(2)对配置文件修改后,希望能够快速同步到各个节点上。2.配置管理可交由ZooKeeper实现。(1)可将配置信息写入ZooKeeper上的一个Znode。(2)各个客户端服务器监听这个Znode。(3)一旦Znode中的数据被修改,ZooKeeper将通知各个客户端服务器。

统一集群管理

1.分布式环境中,实时掌握每个节点的状态是必要的。 (1)可根据节点实时状态做出一些调整。2.ZooKeeper可以实现实时监控节点状态变化 (1)可将节点信息写入ZooKeeper上的一个ZNode。 (2)监听这个ZNode可获取它的实时状态变化。

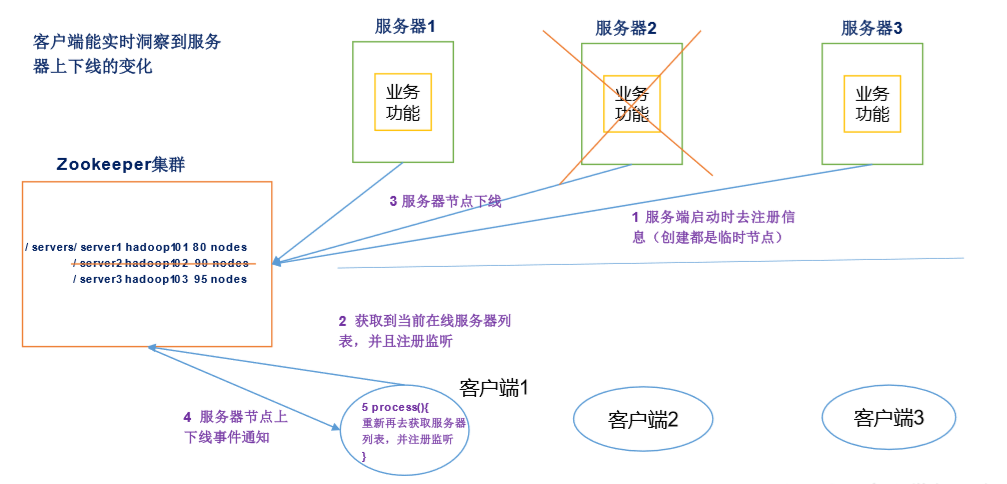

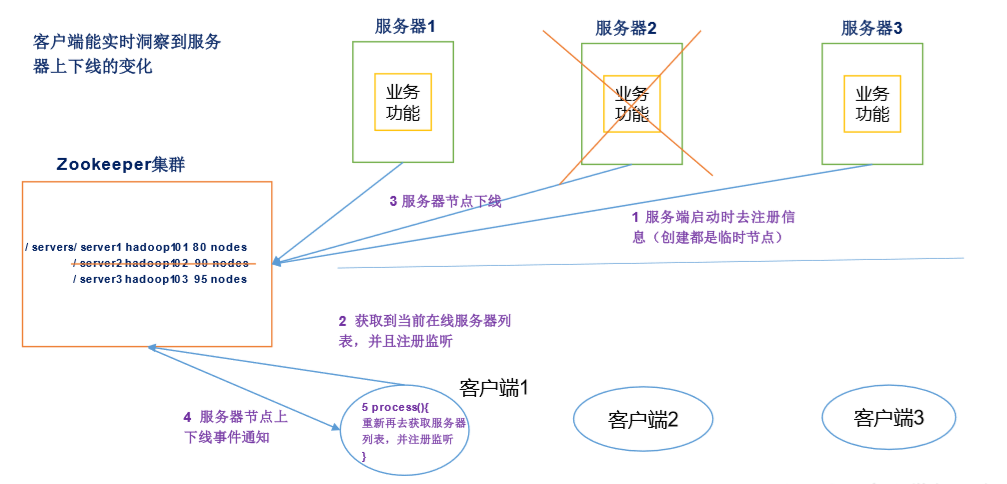

服务器动态上下线

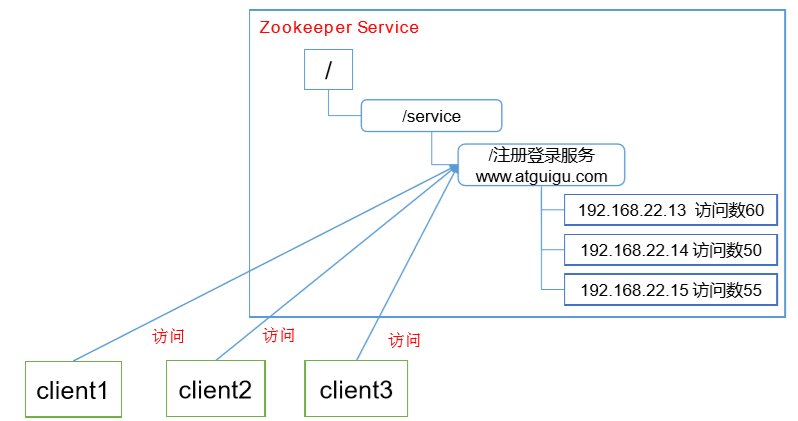

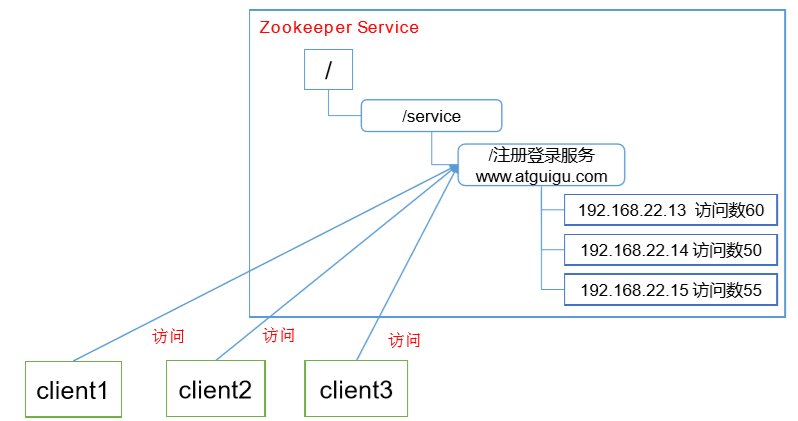

软负载均衡

在Zookeeper中记录每台服务器的访问数,让访问数最少的服务器去处理最新的客户端请求

Zookeeper安装

1.安装前准备(1)安装 Jdk (2)拷贝 Zookeeper 安装包到 Linux 系统下 (3)解压到指定目录 tar -zxvf zookeeper3.4.10.tar.gz -C /opt/module/2.配置修改(1)将/opt/module/zookeeper-3.4.10/conf 这个路径下的 zoo_sample.cfg 修改为 zoo.cfg mv zoo_sample.cfg zoo.cfg (2)打开 zoo.cfg 文件,修改 dataDir 路径 vim zoo.cfg 修改如下内容: dataDir=/opt/module/zookeeper-3.4.10/zkData (3)在/opt/module/zookeeper-3.4.10/这个目录上创建 zkData 文件夹 mkdir zkData3.操作 Zookeeper (1)启动 Zookeeper bin/zkServer.sh start(2)查看进程是否启动 jps - QuorumPeerMain (3)查看状态 bin/zkServer.sh status (4)启动客户端 bin/zkCli.sh(5)退出客户端 quit(6)停止 Zookeeper bin/zkServer.sh stop

配置参数

Zookeeper中的配置文件zoo.cfg中参数含义解读如下: 1.tickTime =2000:通信心跳数,Zookeeper 服务器与客户端心跳时间,单位毫秒 Zookeeper使用的基本时间,服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个tickTime时间就会发送一个心跳,时间单位为毫秒。 它用于心跳机制,并且设置最小的session超时时间为两倍心跳时间。(session的最小超时时间是2*tickTime) 2.initLimit =10:LF 初始通信时限 集群中的Follower跟随者服务器与Leader领导者服务器之间初始连接时能容忍的最多心跳数(tickTime的数量),用它来限定集群中的Zookeeper服务器连接到Leader的时限。 3.syncLimit =5:LF 同步通信时限 集群中Leader与Follower之间的最大响应时间单位,假如响应超过syncLimit * tickTime,Leader认为Follwer死掉,从服务器列表中删除Follwer。 4.dataDir:数据文件目录+数据持久化路径 主要用于保存 Zookeeper 中的数据。 5.clientPort =2181:客户端连接端口 监听客户端连接的端口。

Zookeeper原理

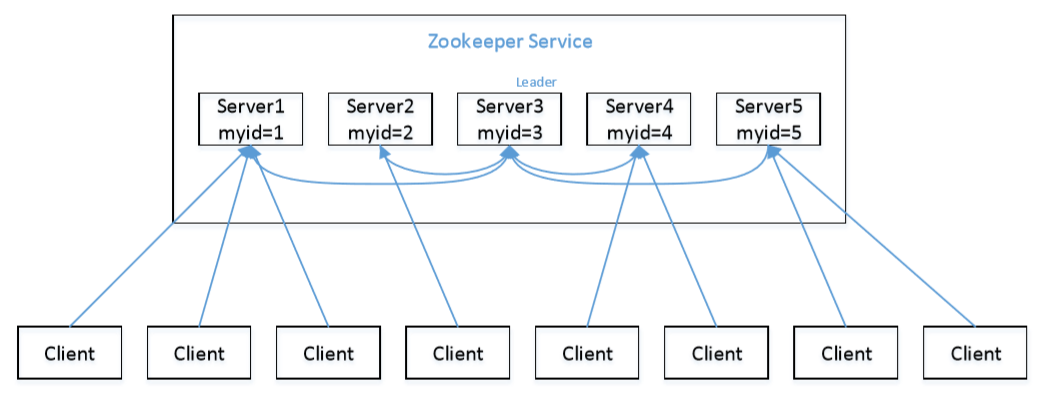

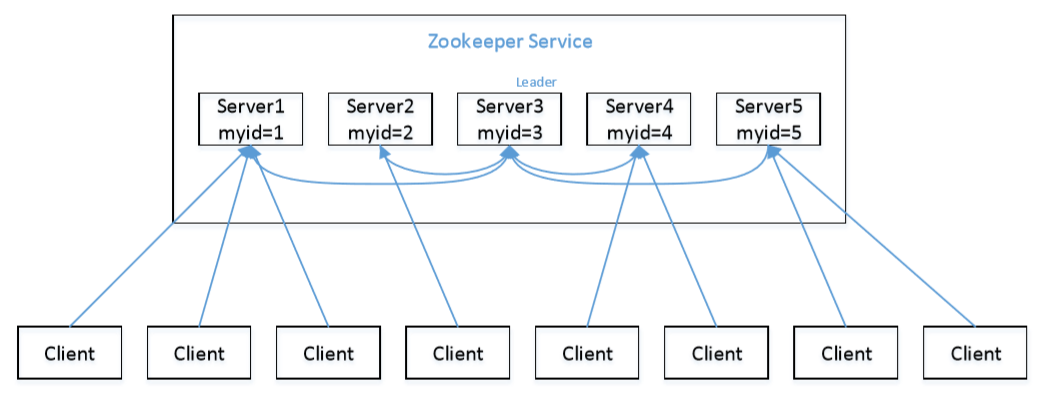

选举机制

1)半数机制:集群中半数以上机器存活,集群可用。所以 Zookeeper 适合安装奇数台服务器。 2)Zookeeper 虽然在配置文件中并没有指定 Master 和 Slave。但是,Zookeeper 工作时,是有一个节点为 Leader,其他则为 Follower,Leader 是通过内部的选举机制临时产生的。 3)以一个简单的例子来说明整个选举的过程。 假设有五台服务器组成的 Zookeeper 集群,它们的 id 从 1-5,同时它们都是最新启动的,也就是没有历史数据,在存放数据量这一点上,都是一样的。假设这些服务器依序启动,来看看会发生什么,如下图:

(1)服务器 1 启动,发起一次选举。服务器 1 投自己一票。此时服务器 1 票数一票,不够半数以上(3 票),选举无法完成,服务器 1 状态保持为 LOOKING; (2)服务器 2 启动,再发起一次选举。服务器 1 和 2 分别投自己一票并交换选票信息:此时服务器 1 发现服务器 2 的 ID 比自己目前投票推举的(服务器 1)大,更改选票为推举服务器 2。此时服务器 1 票数 0 票,服务器 2 票数 2 票,没有半数以上结果,选举无法完成,服务器 1,2 状态保持 LOOKING (3)服务器 3 启动,发起一次选举。此时服务器 1 和 2 都会更改选票为服务器 3。此次投票结果:服务器 1 为 0 票,服务器 2 为 0 票,服务器 3 为 3 票。此时服务器 3 的票数已经超过半数,服务器 3 当选 Leader。服务器 1,2 更改状态为 FOLLOWING,服务器 3 更改状态为 LEADING; (4)服务器 4 启动,发起一次选举。此时服务器 1,2,3 已经不是 LOOKING 状态,不会更改选票信息。交换选票信息结果:服务器 3 为 3 票,服务器 4 为 1 票。此时服务器 4服从多数,更改选票信息为服务器 3,并更改状态为 FOLLOWING; (5)服务器 5 启动,同 4 一样当小弟。

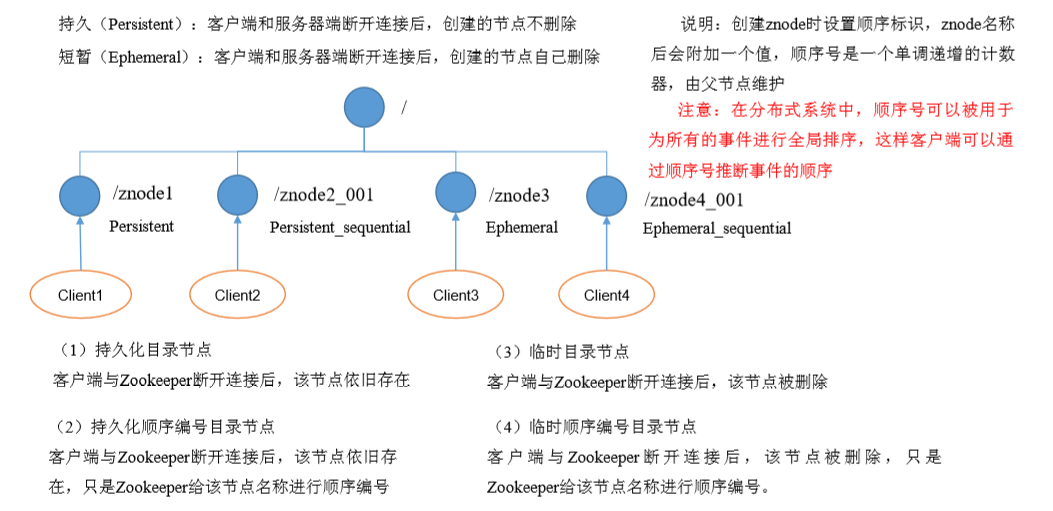

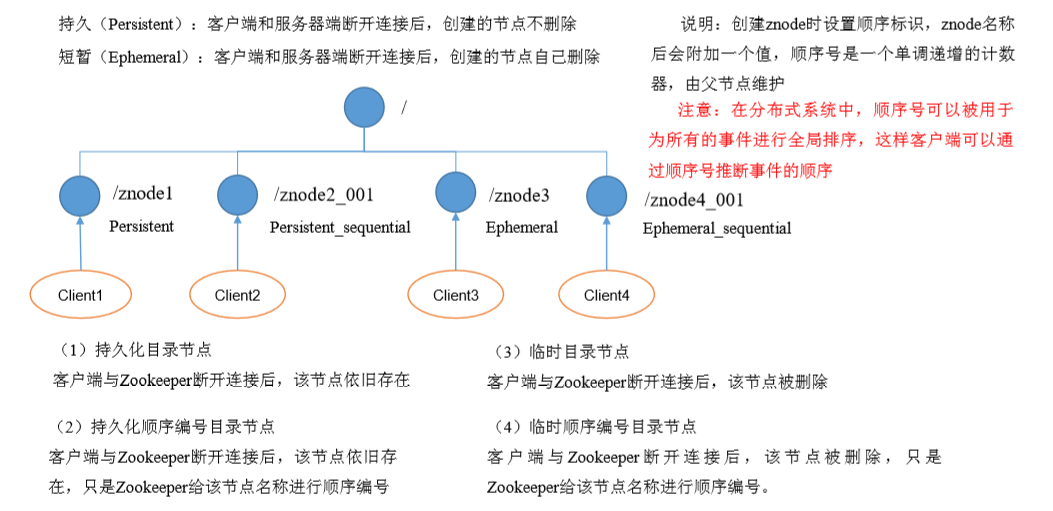

节点类型

Stat 结构体

1)czxid-创建节点的事务 zxid 每次修改ZooKeeper状态都会收到一个zxid形式的时间戳,也就是ZooKeeper事务ID。 事务 ID 是 ZooKeeper 中所有修改总的次序。每个修改都有唯一的 zxid,如果 zxid1 小于 zxid2,那么 zxid1 在 zxid2 之前发生。 2)ctime - znode 被创建的毫秒数(从 1970 年开始) 3)mzxid - znode 最后更新的事务 zxid 4)mtime - znode 最后修改的毫秒数(从 1970 年开始) 5)pZxid-znode 最后更新的子节点 zxid 6)cversion - znode 子节点变化号,znode 子节点修改次数 7)dataversion - znode 数据变化号 8)aclVersion - znode 访问控制列表的变化号 9)ephemeralOwner- 如果是临时节点,这个是 znode 拥有者的 session id。如果不是临时节点则是 0。 10)dataLength- znode 的数据长度 11)numChildren - znode 子节点数量

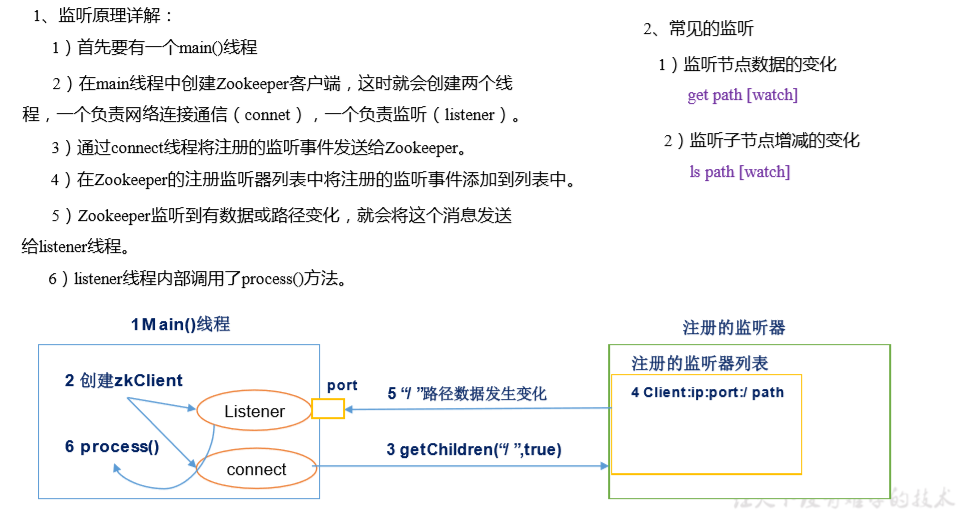

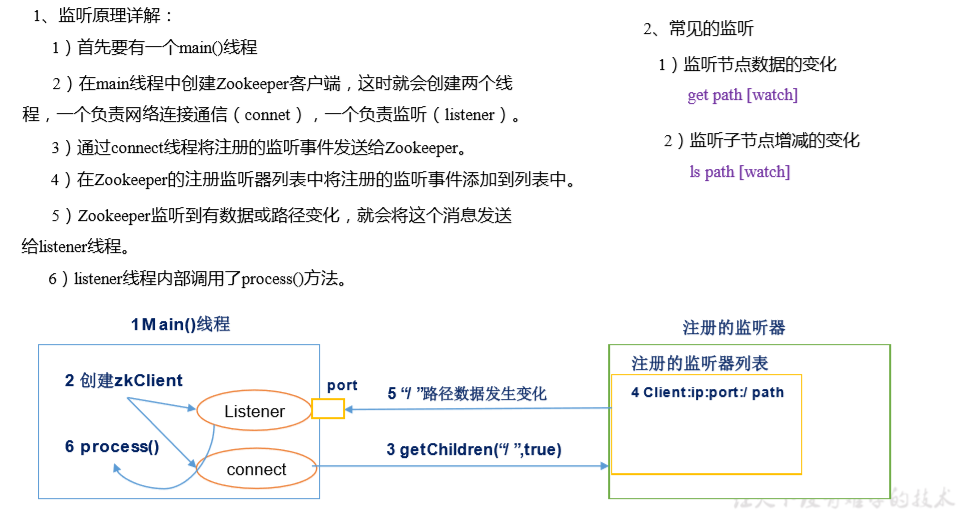

监听器原理

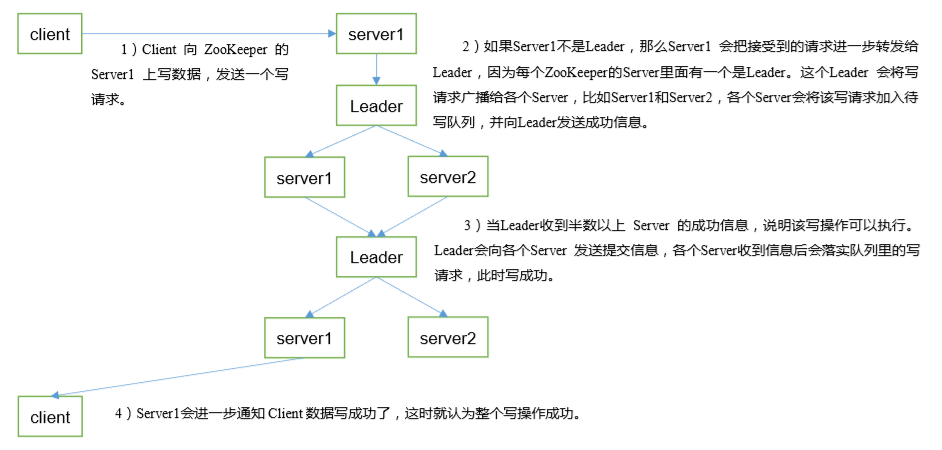

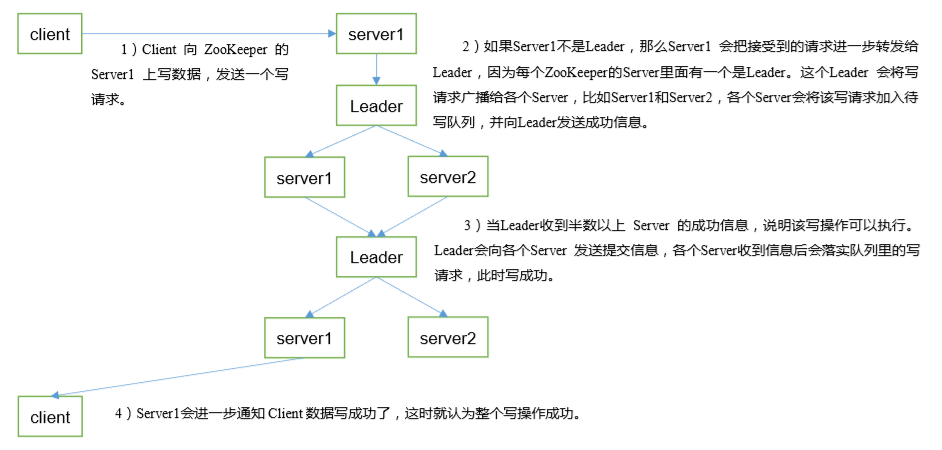

写数据流程

API使用

添加 pom 文件 <dependencies> <dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>RELEASE</version> </dependency> <dependency> <groupId>org.apache.logging.log4j</groupId> <artifactId>log4j-core</artifactId> <version>2.8.2</version> </dependency> <!-- https://mvnrepository.com/artifact/org.apache.zookeeper/zook eeper --> <dependency> <groupId>org.apache.zookeeper</groupId> <artifactId>zookeeper</artifactId> <version>3.4.10</version> </dependency></dependencies>拷贝 log4j.properties 文件到项目根目录需要在项目的 src/main/resources 目录下,新建一个文件,命名为“log4j.properties”,在 文件中填入。 log4j.rootLogger=INFO, stdout log4j.appender.stdout=org.apache.log4j.ConsoleAppender log4j.appender.stdout.layout=org.apache.log4j.PatternLayout log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n log4j.appender.logfile=org.apache.log4j.FileAppender log4j.appender.logfile.File=target/spring.log log4j.appender.logfile.layout=org.apache.log4j.PatternLayout log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n 创建 ZooKeeper 客户端private static String connectString = "hadoop102:2181,hadoop103:2181,hadoop104:2181";private static int sessionTimeout = 2000;private ZooKeeper zkClient = null;@Before public void init() throws Exception { zkClient = new ZooKeeper(connectString, sessionTimeout, new Watcher(){ @Override public void process(WatchedEvent event){ // 收到事件通知后的回调函数(用户的业务逻辑) System.out.println(event.getType() + "--" + event.getPath()); // 再次启动监听 try { zkClient.getChildren("/", true); }catch (Exception e){ e.printStackTrace(); } } });}创建子节点// 创建子节点@Testpublic void create() throws Exception{ // 参数 1:要创建的节点的路径; 参数 2:节点数据 ; 参数 3:节点权 限 ;参数 4:节点的类型 String nodeCreated = zkClient.create("/atguigu", "jinlian".getBytes(), Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);}获取子节点并监听节点变化// 获取子节点@Testpublic void getChildren() throws Exception{ List<String> children = zkClient.getChildren("/", true); for (String child : children){ System.out.println(child); } // 延时阻塞 Thread.sleep(Long.MAX_VALUE);}判断 Znode 是否存在// 判断 znode 是否存在@Testpublic void exist() throws Exception{ Stat stat = zkClient.exists("/eclipse", false); System.out.println(stat == null ? "not exist" : "exist");}

Zookeeper 实战

xsync同步脚本(需要基于hadoop)

先安装rsyncrsync主要用于备份和镜像,具有速度快、避免复制相同内容和支持符号链接的优点。rsync和scp区别1.用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。2.scp是把所有文件都复制过去。yum -y install rsync基本语法rsync -rvl $pdir/$fname $user@hadoop$host:$pdir/$fname命令 选项参数 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称-r 归档拷贝-v 显示复制过程-l 拷贝符号链接1.创建xshync脚本<!---创建文件夹--->[lovefo@hadoop102 ~]$ mkdir bin[lovefo@hadoop102 ~]$ cd bin/[lovefo@hadoop102 bin]$ touch xsync[lovefo@hadoop102 bin]$ vi xsync2.编写内容:#! /bin/bash# $#:表示传递给脚本或函数的参数个数。#1 获取输入参数的个数,如果没有参数直接退出pcount=$#if((pcount==0));thenecho no args;exit;fi#2 获取文件名称p1=$1fname='basename $p1'echo fname=$fname#3 获取上级目录到绝对路径pdir='cd -p $(dirname $p1);pwd'echo pdir=$pdir#4 获取当前用户的名称user='whoami'#5循环for((host=103;host<105;host++));do# hadoop$hostecho -----------hadoop$host-----------rsync -rvl $pdir/$fname $user@hadoop$host:$pdirdone3.修改脚本xsync具有执行权限chmod 777 xsync4.调用脚本形式xsync 文件名称

分布式安装部署

1.集群规划在 hadoop102、hadoop103 和 hadoop104 三个节点上(奇数)部署 Zookeeper。以下操作都在hadoop102上操作即可。2.解压安装(1)解压 Zookeeper 安装包到/opt/module/目录下 tar -zxvf zookeeper3.4.10.tar.gz -C /opt/module/(2)同步/opt/module/zookeeper-3.4.10 目录内容到 hadoop103、hadoop104 xsync zookeeper-3.4.10/3.配置服务器编号(1)在/opt/module/zookeeper-3.4.10/这个目录下创建 zkData mkdir -p zkData(2)在/opt/module/zookeeper-3.4.10/zkData 目录下创建一个 myid 的文件 touch myid 注意:添加 myid 文件,注意一定要在 linux 里面创建,在 notepad++里面很可能乱码 (3)编辑 myid 文件 vi myid 在文件中添加与 server 对应的编号: 2(4)拷贝配置好的 zookeeper 到其他机器上 xsync myid 并分别在 hadoop103、hadoop104 上修改 myid 文件中内容为 3、44.配置 zoo.cfg 文件(1)重命名/opt/module/zookeeper-3.4.10/conf 这个目录下的 zoo_sample.cfg 为 zoo.cfg mv zoo_sample.cfg zoo.cfg(2)打开 zoo.cfg 文件 vim zoo.cfg 修改数据存储路径配置 dataDir=/opt/module/zookeeper-3.4.10/zkData 增加如下配置 #######################cluster########################## server.2=hadoop102:2888:3888 server.3=hadoop103:2888:3888 server.4=hadoop104:2888:3888(3)同步 zoo.cfg 配置文件 xsync zoo.cfg(4)配置参数解读 server.A=B:C:DA 是一个数字,表示这个是第几号服务器; 集群模式下配置一个文件 myid,这个文件在 dataDir 目录下,这个文件里面有一个数据就是 A 的值,Zookeeper 启动时读取此文件,拿到里面的数据与 zoo.cfg 里面的配置信息比较从而判断到底是哪个 server。 B 是这个服务器的地址; C 是这个服务器 Follower 与集群中的 Leader 服务器交换信息的端口; D 是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的Leader,而这个端口就是用来执行选举时服务器相互通信的端口。5.集群操作(1)分别启动 Zookeeper进入到Zookeeper目录,分别启动各个服务器的Zookeeper服务器1:bin/zkServer.sh start服务器2:bin/zkServer.sh start服务器3:bin/zkServer.sh start(2)查看状态服务器1:bin/zkServer.sh status服务器2:bin/zkServer.sh status服务器3:bin/zkServer.sh status

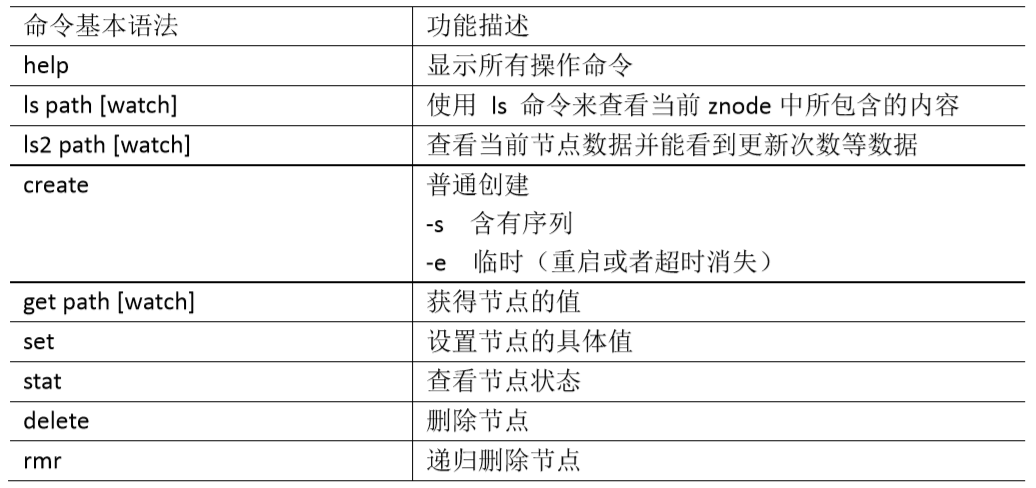

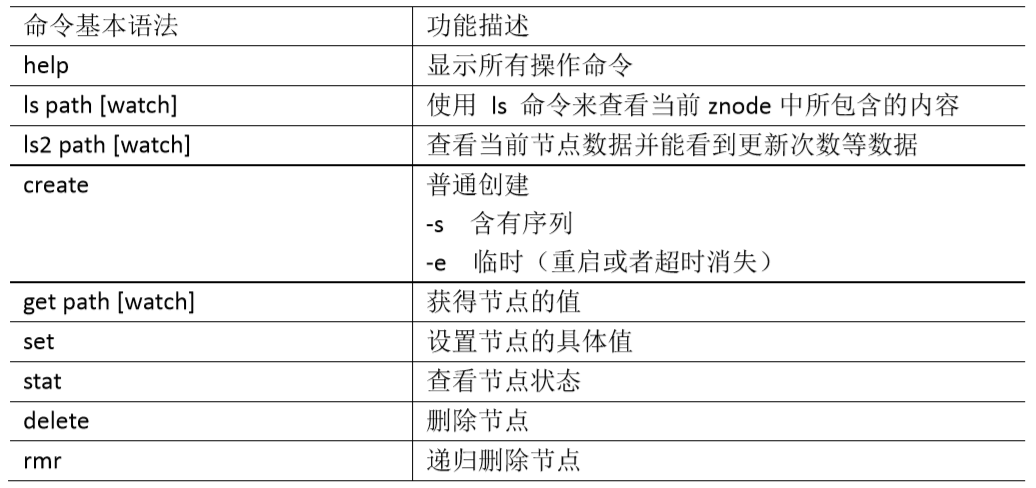

客户端命令行操作

1.启动客户端 bin/zkCli.sh2.显示所有操作命令help3.查看当前 znode 中所包含的内容ls /4.查看当前节点详细数据ls2 /5.分别创建 2 个普通节点create /sanguo "jinlian"create /sanguo/shuguo "liubei"6.获得节点的值get /sanguoget /sanguo/shuguo7.创建短暂节点 create -e /sanguo/wuguo "zhouyu"(1)在当前客户端是能查看到的ls /sanguo(2)退出当前客户端然后再重启客户端quitbin/zkCli.sh(3)再次查看根目录下短暂节点已经删除ls /sanguo8.创建带序号的节点(1)先创建一个普通的根节点/sanguo/weiguocreate /sanguo/weiguo "caocao"(2)创建带序号的节点create -s /sanguo/weiguo/xiaoqiao "jinlian"create -s /sanguo/weiguo/daqiao "jinlian" create -s /sanguo/weiguo/diaocan "jinlian"如果原来没有序号节点,序号从 0 开始依次递增。如果原节点下已有 2 个节点,则再排序时从 2 开始,以此类推。9.修改节点数据值set /sanguo/weiguo "simayi"10.节点的值变化监听(1)在 hadoop104 主机上注册监听/sanguo 节点数据变化get /sanguo watch(2)在 hadoop103 主机上修改/sanguo 节点的数据set /sanguo "xisi"(3)观察 hadoop104 主机收到数据变化的监听显示节点数据有变化了11.节点的子节点变化监听(路径变化)(1)在 hadoop104 主机上注册监听/sanguo 节点的子节点变化ls /sanguo watch (2)在 hadoop103 主机/sanguo 节点上创建子节点create /sanguo/jin "simayi"(3)观察 hadoop104 主机收到子节点变化的监听显示节点数据有变化了12.删除节点delete /sanguo/jin13.递归删除节点rmr /sanguo/shuguo14.查看节点状态stat /sanguo