分类

要尝试分类,一种方法是使用线性回归并将所有大于 0.5 的预测映射为 1,将所有小于 0.5 的预测映射为 0。但是,这种方法效果不佳,因为分类实际上不是线性函数。

分类问题就像回归问题,不同的是我们现在要预测的值仅采用少量离散值。 现在,我们将专注于二元分类问题,其中 y 只能取两个值,0 和 1。(我们在这里所说的大部分内容也将推广到多类情况。)例如,如果我们正在尝试 为电子邮件构建垃圾邮件分类器,则可能是一封电子邮件的某些特征,如果是垃圾邮件,则 y 可能为 1,否则为 0。 因此,y∈{0,1}。 0也称为负类,1为正类,有时也用符号“-”和“+”表示。 给定 ,对应的

也称为训练示例的标签。

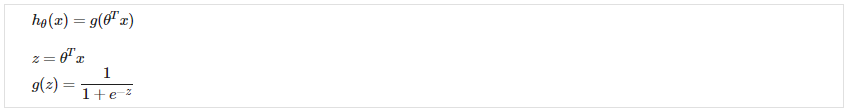

假设表示

我们可以忽略 y 是离散值这一事实来解决分类问题,并使用我们旧的线性回归算法尝试在给定 x 的情况下预测 y。 但是,很容易构建此方法性能很差的示例。 直观上,当我们知道 y ∈ {0, 1} 时,取大于 1 或小于 0 的值也是没有意义的。 为了解决这个问题,让我们改变假设的形式以满足

。 这是向 Logistic Function插入

来实现的。

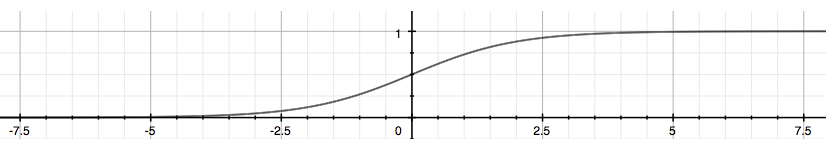

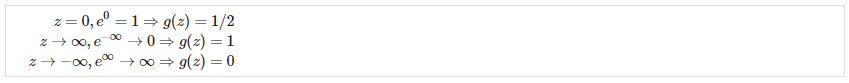

我们的新形式使用“Sigmoid 函数”,也称为“逻辑函数”:

下图向我们展示了 sigmoid 函数的样子:

此处显示的函数 g(z) 将任何实数映射到 (0, 1) 区间,使其可用于将任意值函数转换为更适合分类的函数。

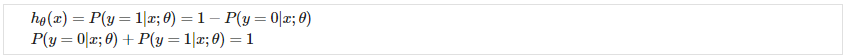

会给我们输出为 1 的概率。例如

给我们 70% 的概率我们的输出是 1。我们的预测为 0 的概率只是我们预测为 1 的概率的补码(例如,如果它是 1 的概率是 70%,那么它是 0 的概率是 30%)。

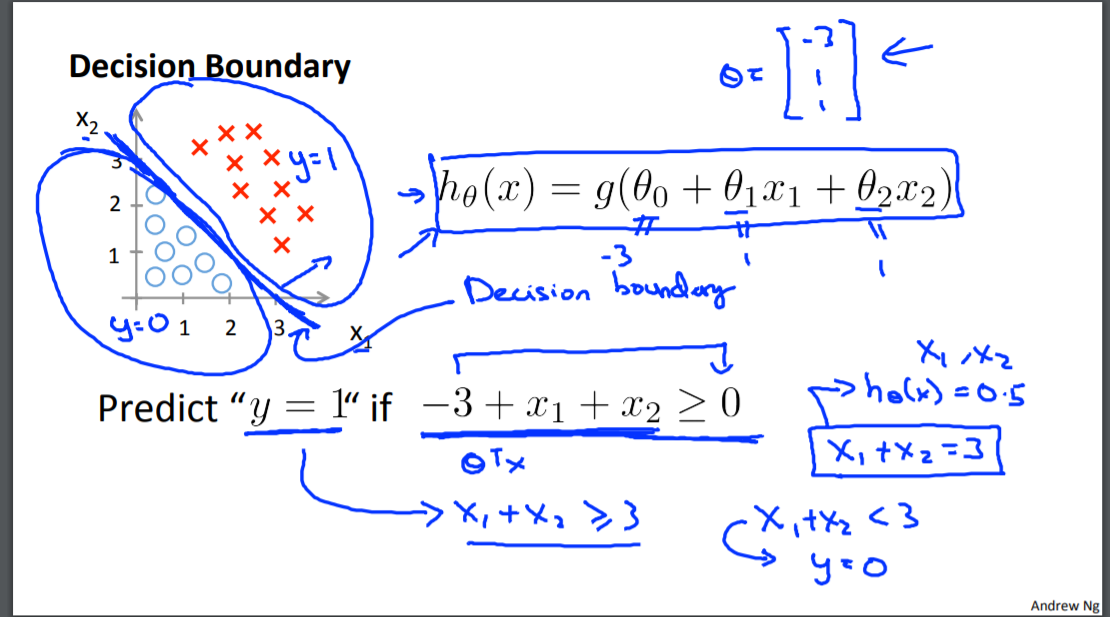

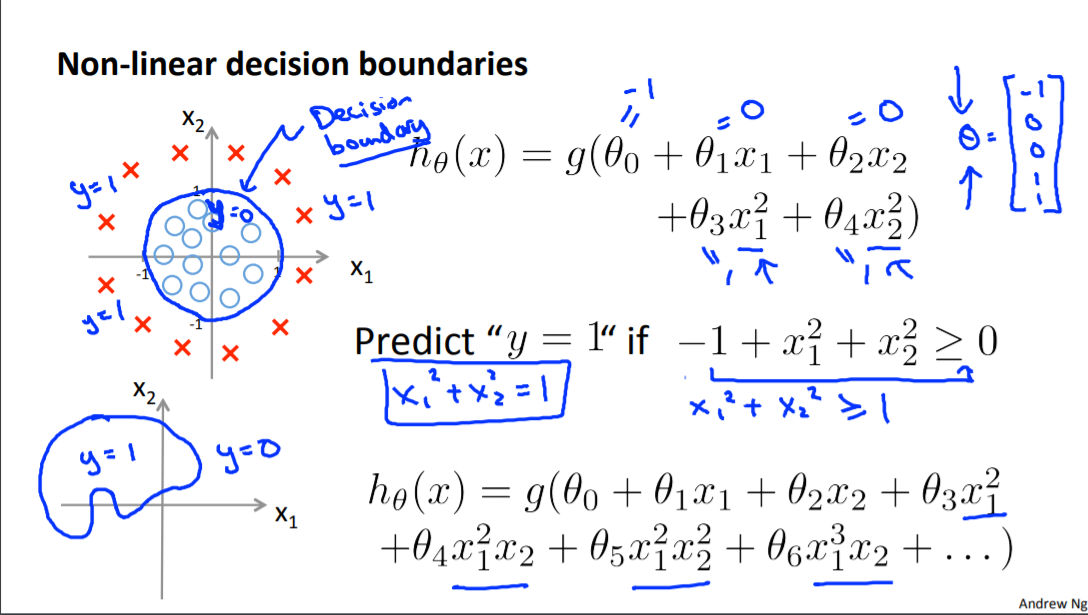

决策边界

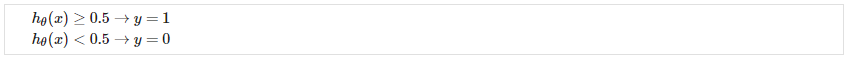

为了获得离散的 0 或 1 分类,我们可以将假设函数的输出转换如下:

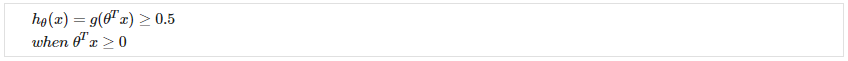

我们的逻辑函数 g 的行为方式是,当其输入大于或等于 0 时,其输出大于或等于 0.5:

当输入为时:

决策边界是分隔 y = 0 和 y = 1 区域的线。它由我们的假设函数创建。