在这篇文章里,我们将介绍Berkeley出品的Soft Actor-Critic(SAC)算法,该算法整合了 Actor-Critic、Off-Policy、Maximum Entropy Model 三大框架,极大程度的解决了以上RL算法的缺陷,相较于传统 RL 方法,也有着全新的贝尔曼方程表达式,同时在机器人等连续控制任务中有着非常出色的表现。

摘要

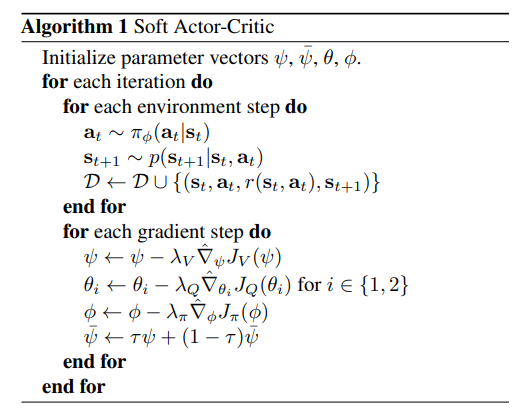

算法

![📝[SAC]Soft Actor-Critic: Off-Policy Maximum Entropy Deep Reinforcement Learning with a Stochastic Actor - 图2](/uploads/projects/crazyalltnt@rl-paper/7c306101c003730e962589bf4a242388.png)

参考

- 最前沿:深度解读Soft Actor-Critic 算法

- 强化学习之图解SAC算法

- SAC论文解读以及简易代码复现

- 【强化学习算法 11】SAC

- Soft Actor-Critic论文阅读及代码实现

- 详解soft actor-critic