这篇论文是DeepMind在2016年发表在ICML上的论文,提出了大名鼎鼎的 A3C 算法,不再使用经验池,异步并行执行多个 Agents 来探索环境,整合了Value based 和 Policy Based两种主流的强化学习方法,在Atari 2600等模拟环境中取得SOTA成绩。

摘要

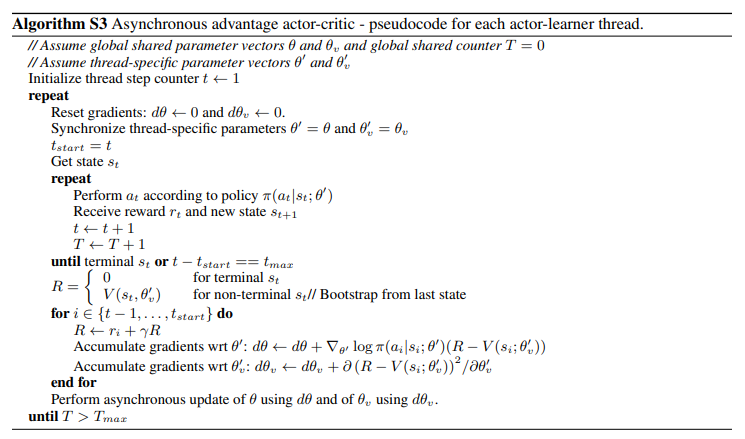

对于深度强化学习,我们提出了一个概念简单和轻量级的框架,使用异步梯度下降优化深度神经网络控制器。我们提出了四种标准强化学习算法的异步变体,并表明并行actor-learners对训练有一种稳定的效果,使得所有四种方法成功地训练神经网络控制器。==性能最好的方法是actor-learners的异步变体,在单多核CPU而不是GPU上训练一半时间的同时,超过了目前Atari领域的最先进技术。==此外,我们还展示了A2C成功地解决了一系列连续的电机控制问题,以及使用视觉输入导航随机3D迷宫的新任务。

算法

参考

- 【DRL-14】Asynchronous Advantage Actor-Critic

- 第十五章 异步A3C(Asynchronous Advantage Actor-Critic,A3C)-强化学习理论学习与代码实现

- 深度增强学习(DRL)漫谈 - 从AC(Actor-Critic)到A3C(Asynchronous Advantage Actor-Critic)

- 论文阅读-A3C

- 强化学习(十五) A3C

- 【论文翻译】Asynchronous Methods for Deep Reinforcement Learning(A3C)