评价指标——有监督学习

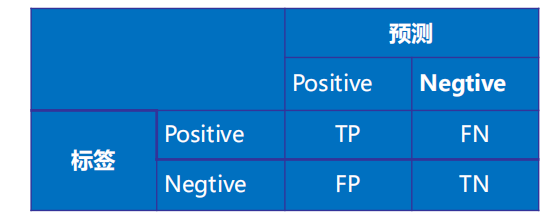

模型判断错误与混淆矩阵

- 假阳例/False Positive:

- 模型判断是狗子,其实不是

- 错误的正例(阳性)样本,其实是负例(反例/阴性)

- 假阴例/False Negative:

- 模型判断不是狗子,其实是

- 错误的负例(反例/阴性)样本,其实是正例(阳性)

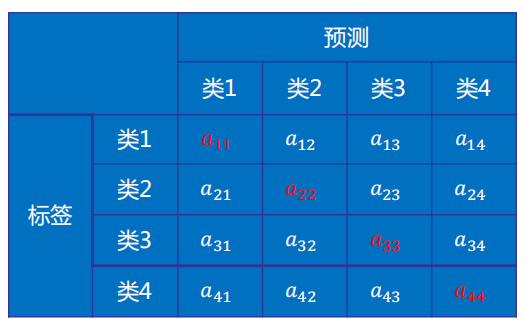

混淆矩阵

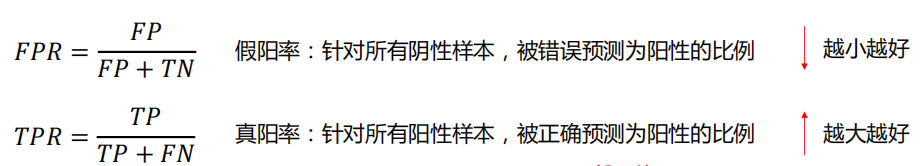

真阳率和假阳率

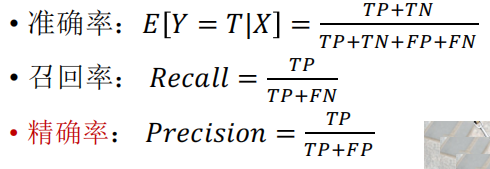

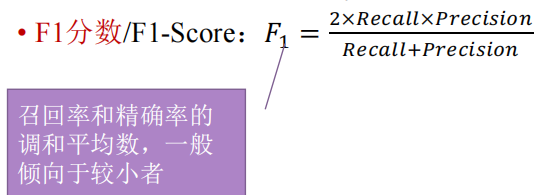

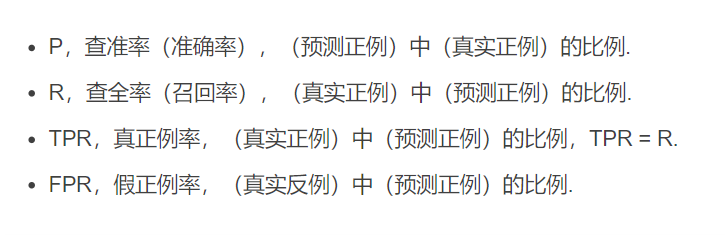

TPR =RecallF1分数和BEP

BEP 是 P=R时的取值

其作用是用来度量模型的好坏举例

类1、类2、类3、类4的Recall和 PrecisionRecall 和Precision的含义

召回率针对所有真实为阳例的样本,召回率高说明在真实为阳例的样本中,成功预测其为阳例的数量多;极端情况是全部预测为阳例,全部阳例样本被成功预测,但是这样不合常理。比如如果有很多阴例,那么模型会产生很多错误预测,此时精确率很低。而召回率低说明在真实为阳例的样本中,成功预测其为阳例的数量少,模型对阳例的预测。

精确率针对所有预测为阳例的样本,精确率高说明在预测为阳例的所有样本中,真实情况的确为阳例的数量多;而精确率低说明在预测为阳例的所有样本中,真实情况的确为阳例的数量少。比如如果有很多阴例的样本,全部预测为阳例。为什么要引入Recall和Precision

recall和precision是用来指标评价模型的两个不同指标。

根据实际需求不同,有时需要提升一个指标,牺牲另外一个。

比如在预测地震的时候需要尽可能把所有要发生地震的成功预测,但可能会产生很多误报即错误预测,但此时是误报没有关系,但如果没有预测出要发生的地震那么这个模型就不好,此时我们牺牲了精确率,提高召回率。

但是在另一个场景,比如刷脸支付,如果产生很多错误预测,把你的脸检测成别人的脸,就会出现金融风险,让别人替你买单,对银行损失很大。但如果没有预测出你是谁,即无法识别,可以多预测几次,没有关系,所以此时会提升精确率,牺牲召回率。ROC曲线

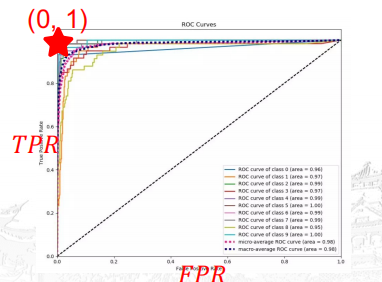

随着阈值的不同,FPR和TPT都在同步变化,

(FPR, TPR)所构成的曲线则称为ROC曲线

ROC曲线与坐标轴围成的面积,称为AUC(area under curve)

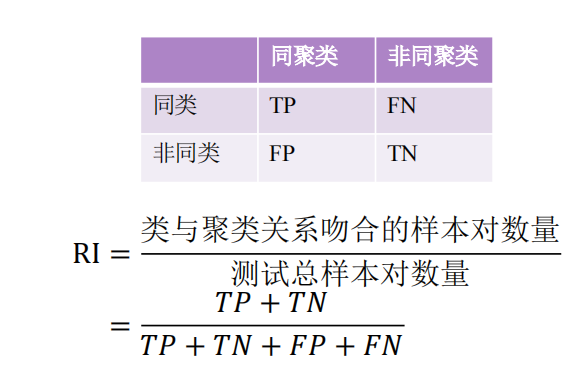

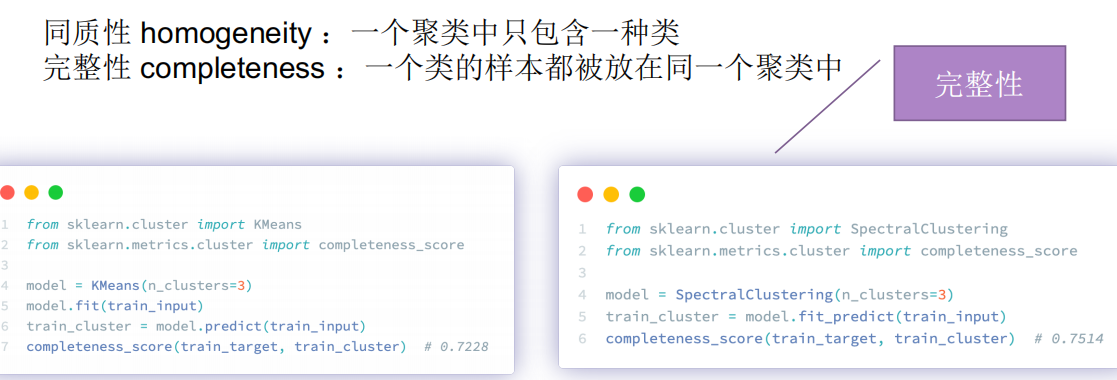

评价指标——无监督学习

评价指标:Rand指数(RI)