损失函数汇总

官方链接: https://pytorch.org/docs/stable/_modules/torch/nn/modules/loss.html

| 损失函数 | 名称 | 适用场景 |

|---|---|---|

| torch.nn.MSELoss() | 均方误差损失 | 回归 |

| torch.nn.L1Loss() | 平均绝对值误差损失 | 回归 |

| torch.nn.CrossEntropyLoss() | 交叉熵损失 | 多分类 |

| torch.nn.NLLLoss() | 负对数似然函数损失 | 多分类 |

| torch.nn.NLLLoss2d() | 图片负对数似然函数损失 | 图像分割 |

| torch.nn.KLDivLoss() | KL散度损失 | 回归 |

| torch.nn.BCELoss() | 二分类交叉熵损失 | 二分类 |

| torch.nn.MarginRankingLoss() | 评价相似度的损失 | |

| torch.nn.MultiLabelMarginLoss() | 多标签分类的损失 | 多标签分类 |

| torch.nn.SmoothL1Loss() | 平滑的L1损失 | 回归 |

| torch.nn.SoftMarginLoss() | 多标签二分类问题的损失 | 多标签二分类 |

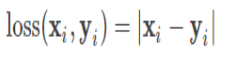

L1损失函数

预测值与标签值进行相差,然后取绝对值,根据实际应用场所,可以设置是否求和,求平均,公式可见下,Pytorch调用函数:nn.L1Loss

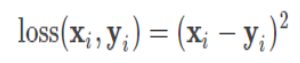

L2损失函数

预测值与标签值进行相差,然后取平方,根据实际应用场所,可以设置是否求和,求平均,公式可见下,Pytorch调用函数:nn.MSELoss

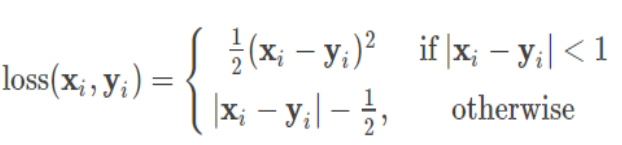

Huber Loss损失函数

简单来说就是L1和L2损失函数的综合版本,结合了两者的优点,公式可见下,Pytorch调用函数:nn.SmoothL1Loss

二分类交叉熵损失函数

简单来说,就是度量两个概率分布间的差异性信息,在某一程度上也可以防止梯度学习过慢,公式可见下,Pytorch调用函数有两个,一个是nn.BCELoss函数,用的时候要结合Sigmoid函数,另外一个是nn.BCEWithLogitsLoss()

多分类交叉熵损失函数

也是度量两个概率分布间的差异性信息,Pytorch调用函数也有两个,一个是nn.NLLLoss,用的时候要结合log softmax处理,另外一个是nn.CrossEntropyLoss