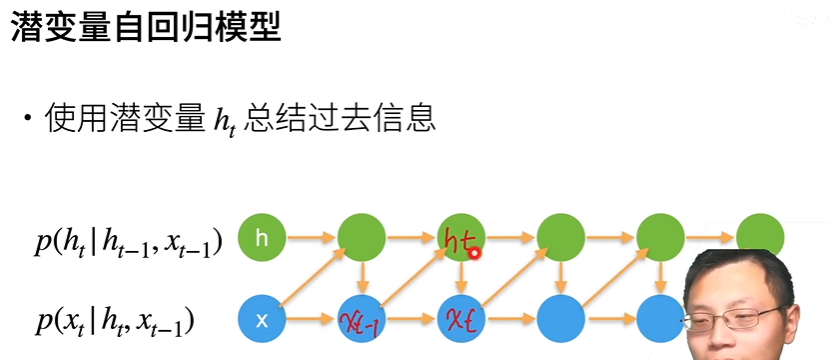

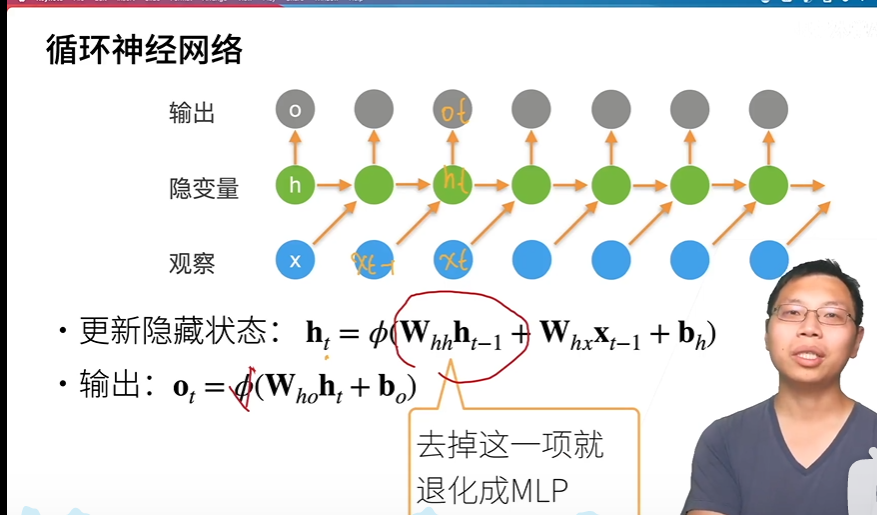

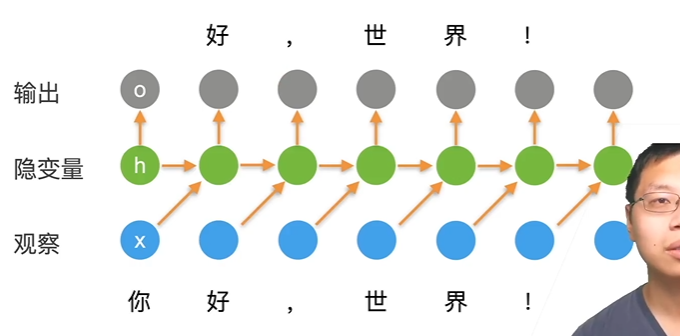

- 核心在于:用了隐藏变量。没有对x建模,所有的信息都存在隐变量中,存入了时序信息。

- 如果去掉了W(hh)*h(t-1),本质上就是一个MLP,反过来说,就是加上它才能使当前时刻能和历史时刻发生关系

- 过程:

- 输入“你”,更新当前的h(t),预测“好”- 输入“好”,更新当前的h(t+1),预测“,”- o(t)和x(t-1)是一 一匹配,当前的o(t)是用来预测当前的x(t)的,也就是说,t时候的预测是要先于输入的- 做损失函数loss时,是o(t)和x(t)的关系。

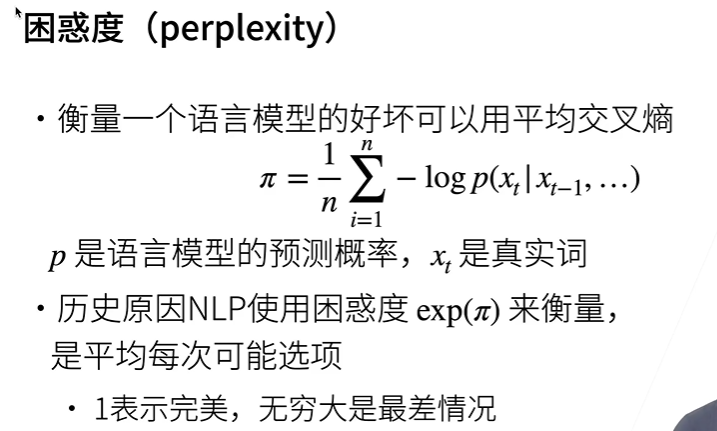

使用困惑度的好处:1)放大了平均交叉熵

2)数值为k,说明下一个词可能在k个词里都有可能,因此效果更差

g:所有层的梯度,是一个向量

相当于:如果长度太大,就把它拉回来,也就是投影。