从一个句子生成另一个句子

以机器翻译为例:

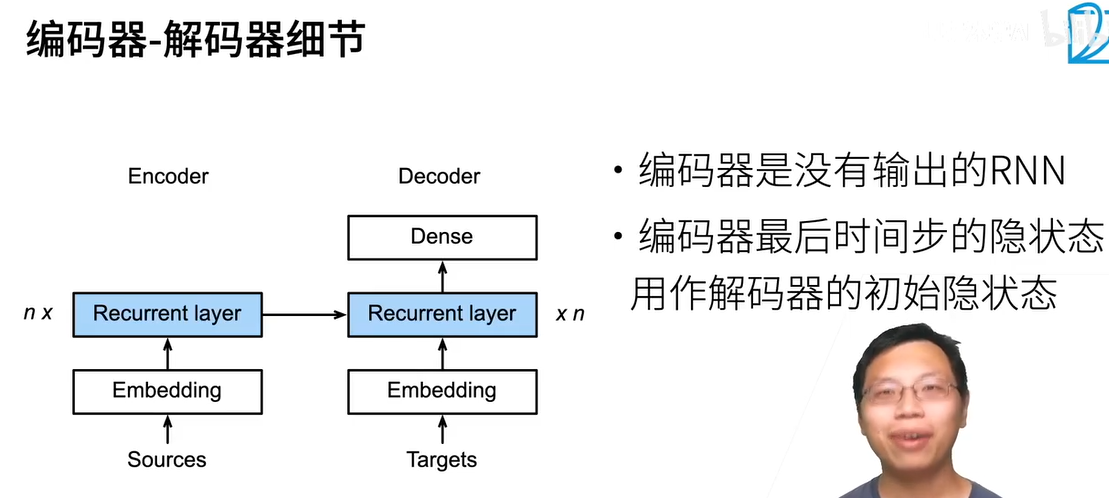

- 双向RNN经常会用在encoder中,但是不能用在decoder,因为decoder是用来做预测的

- 不需要长度相同,source长度任意,target长度也任意

- encoder不需要全连接层

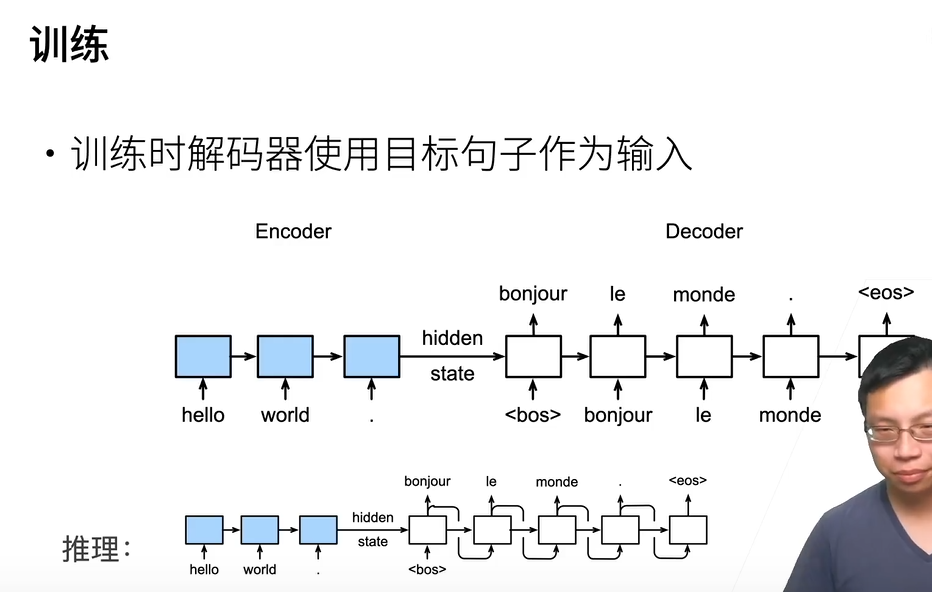

- 训练和推理的不同,在decoder的训练的target输入是用的正确的句子,推理只能把前一个时间步的预测的结果作为输入

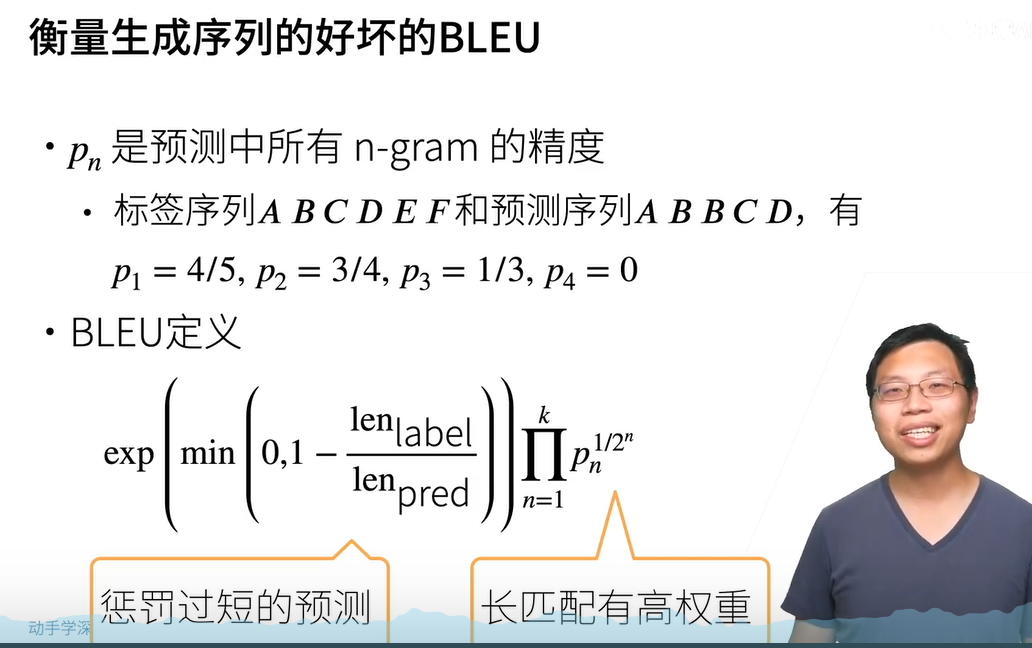

当预测的句子和正确的句子之间的长度不一致时,如何去衡量?

- p(n)相当于在计算子序列的出现的频率。2-gram对应的p2的计算为:预测序列中AB BB BC CD 共4个,而在标签序列中出现的次数为3,故为3/4

- 惩罚过短的预测:预测的句子越短,精度肯定很高,因此要避免。

- 长匹配配有高权重:n越大,对应的预测的句子越长,p(n)<1,指数小于1,且n越大,指数越小,p(n)的(1/2的n次方)越大。对应一个长匹配的句子,达到了更大的权重的目的