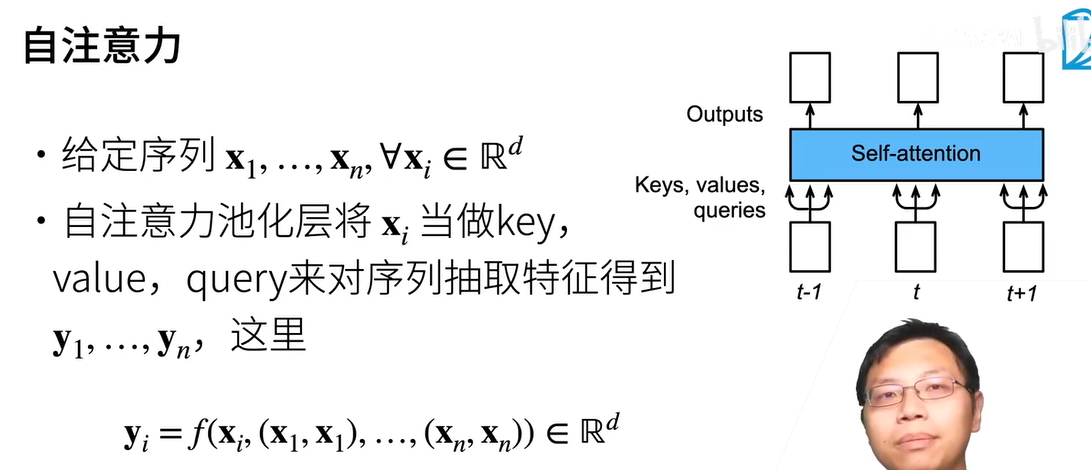

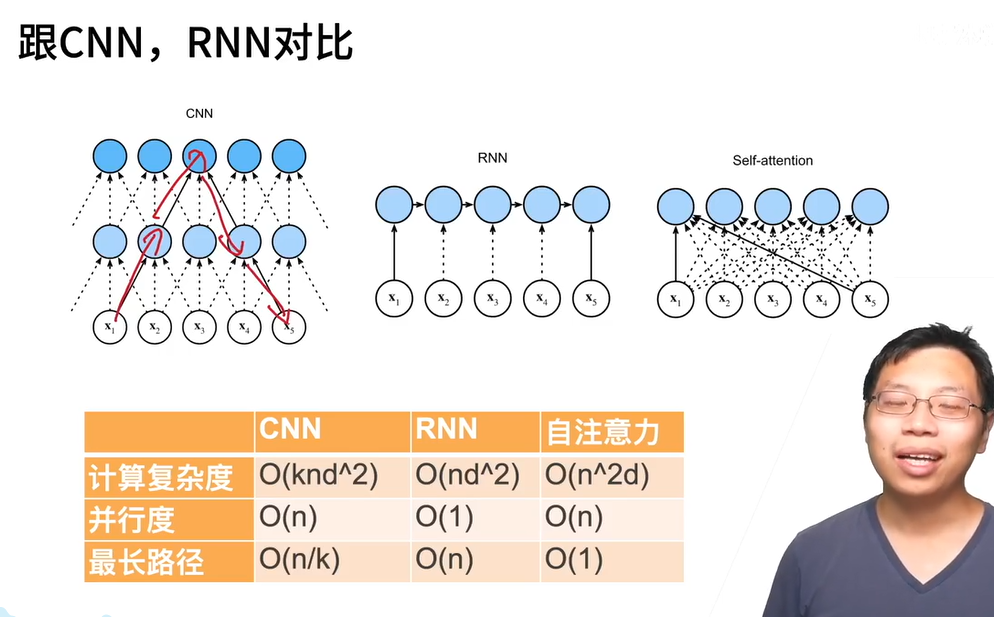

子注意力机制,比较适合序列很长的数据,因为它可以无视宽度,对每一个词都有它的匹配。需要层层相连。

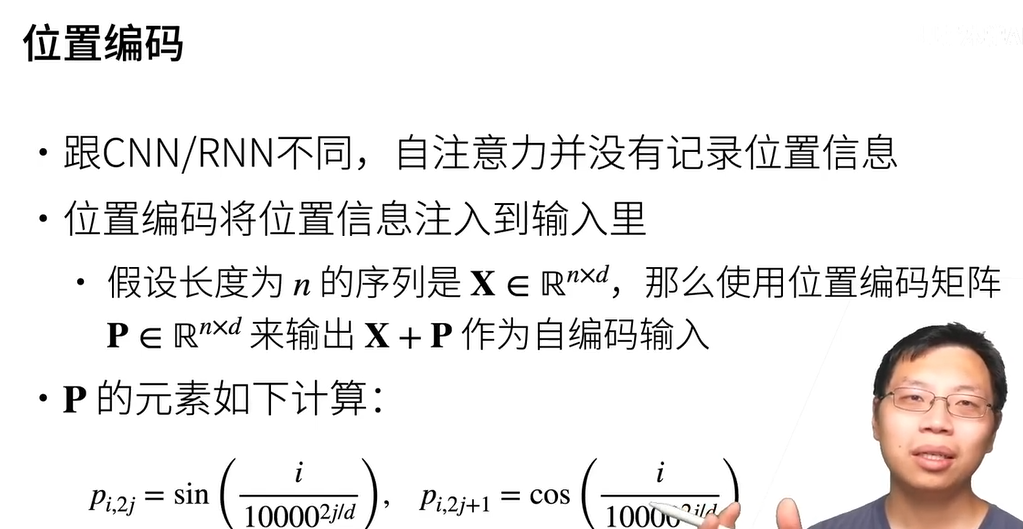

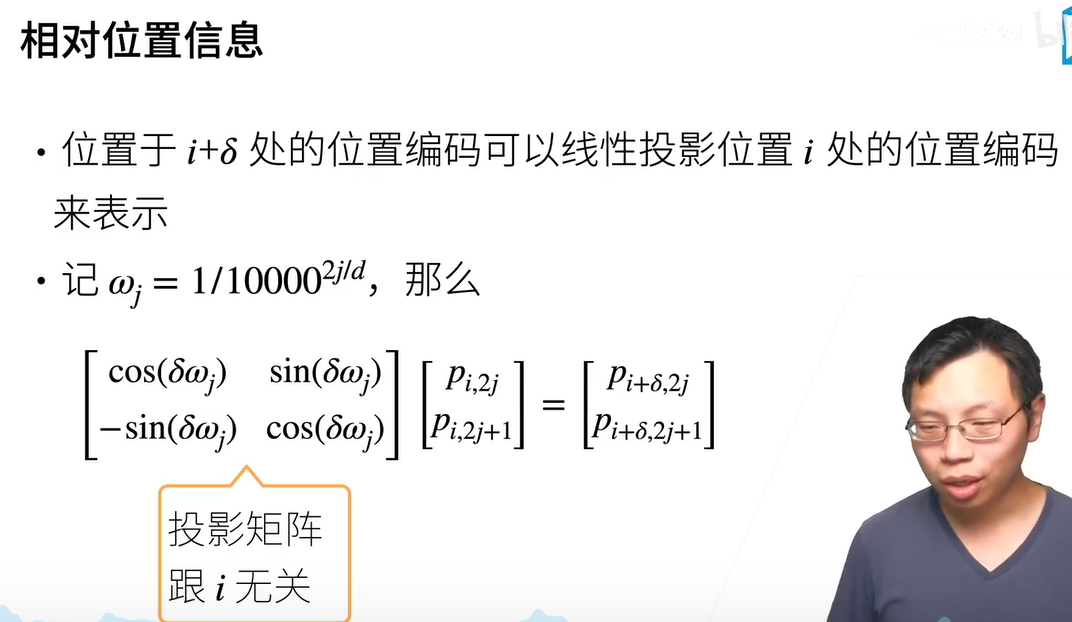

用sin cos可以更好的去关心词跟词之间的相对位置,相对位置的一个好处,在对一个长序列时,如果需要切断或者增加它,相对位置仍不会发生太大变化,

用sin cos可以更好的去关心词跟词之间的相对位置,相对位置的一个好处,在对一个长序列时,如果需要切断或者增加它,相对位置仍不会发生太大变化,

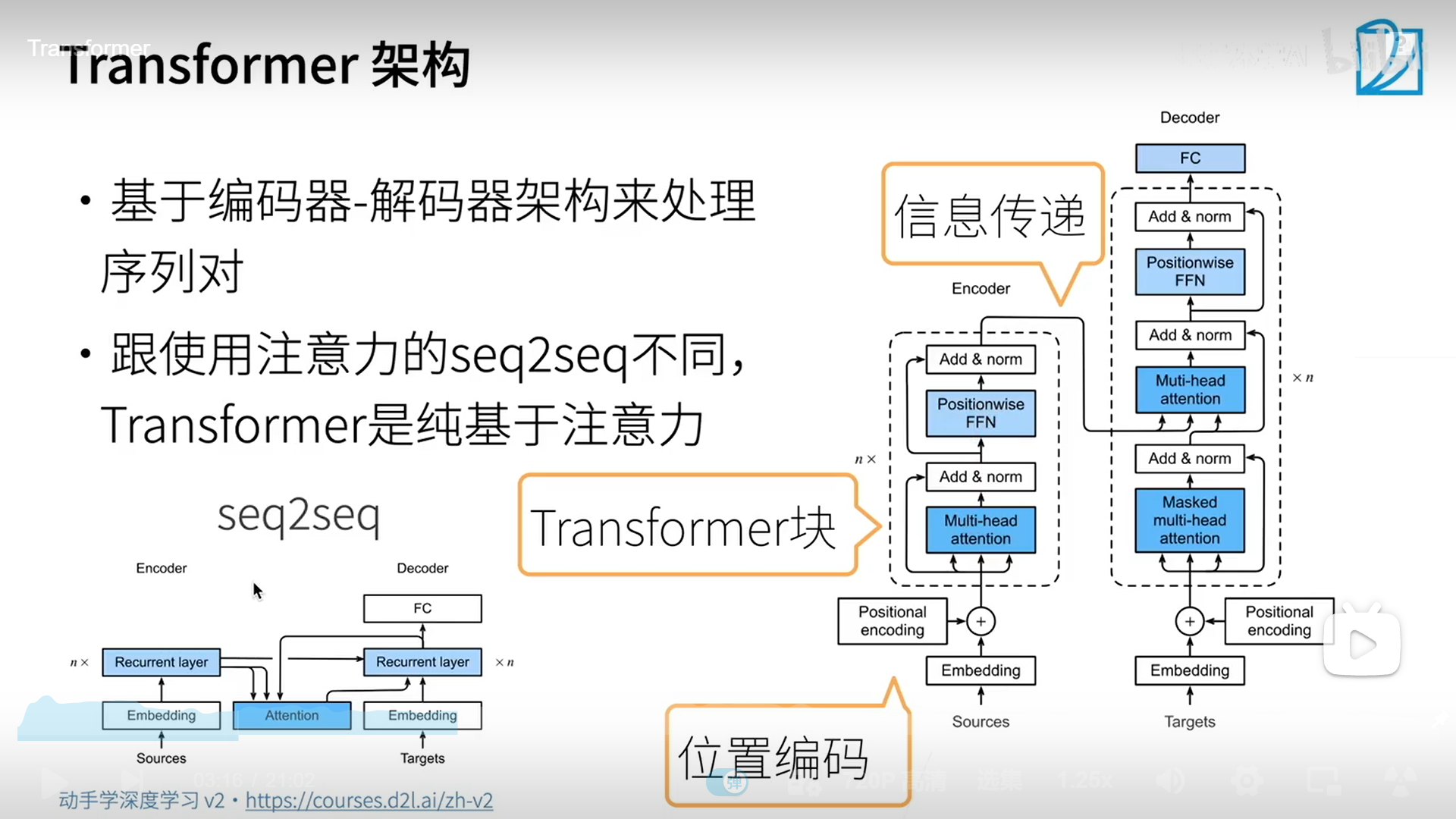

架构

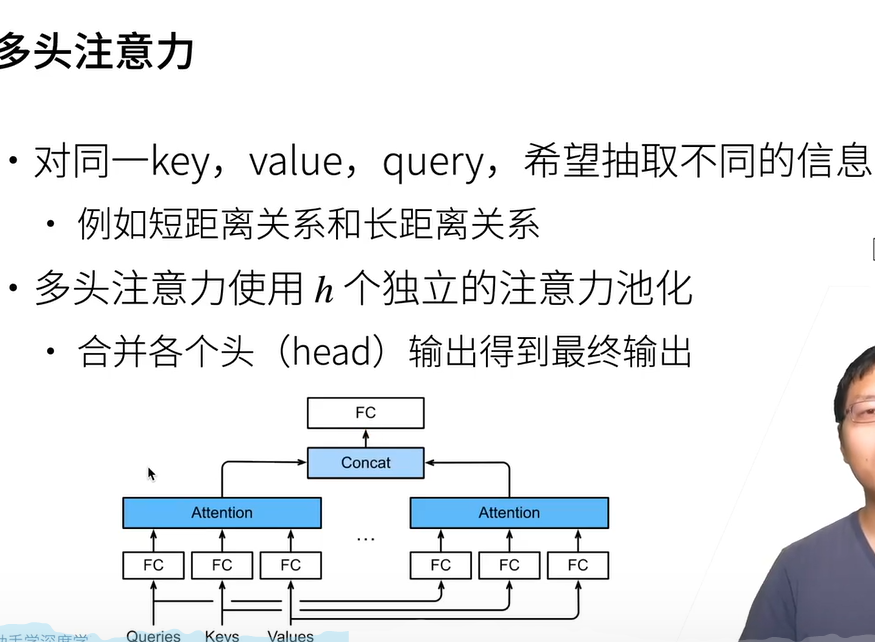

多头注意力

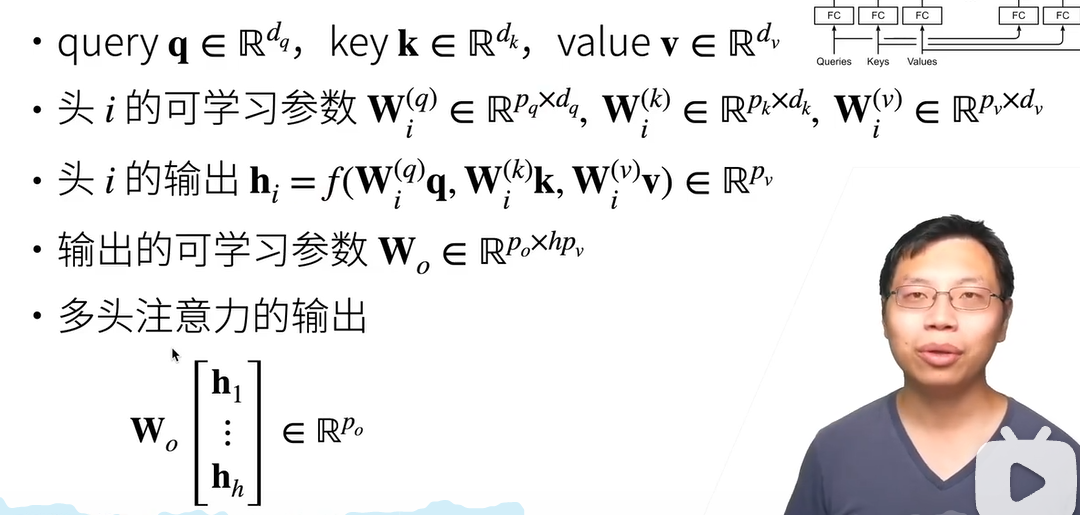

多头注意力数学形式

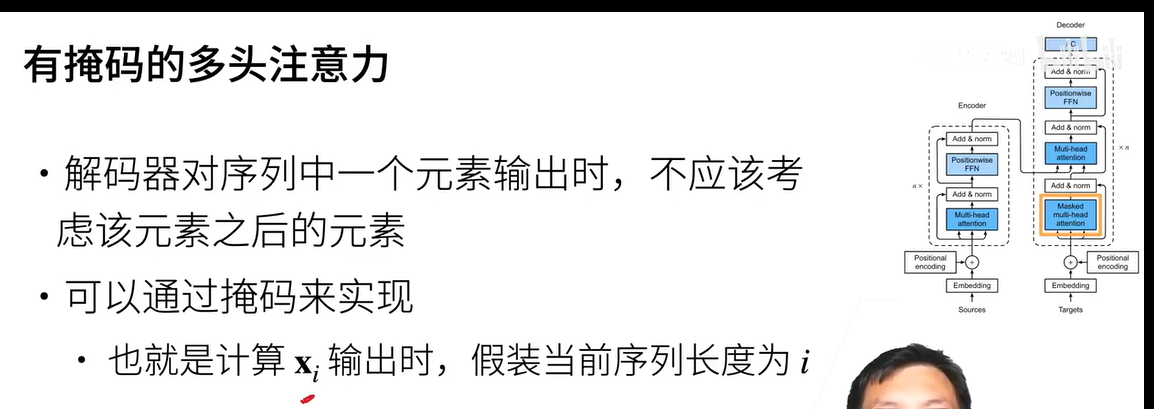

带掩码的

attenton它是不携带时间序列信息的, 在编码时可以不考率信息全部暴露出来,

但是解码不行,解码需要把后面的信息mask掉,于是可以通过掩码来实现

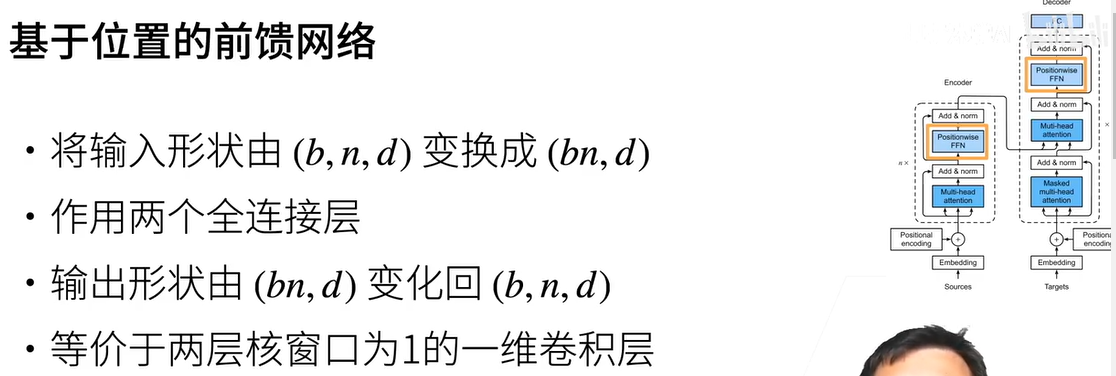

基于位置的前馈网络(其实是全连接)、

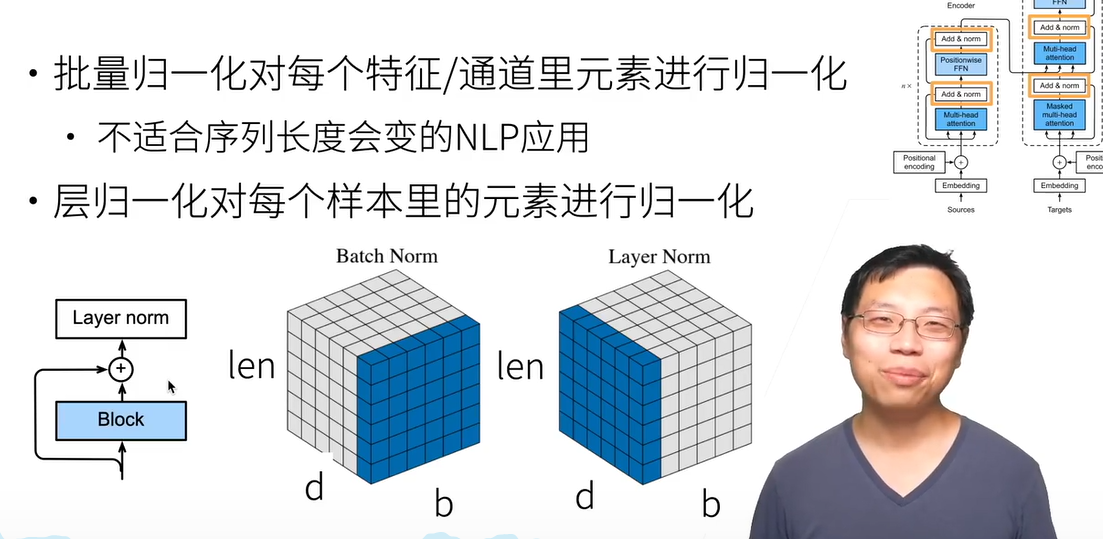

层归一化(add norm)

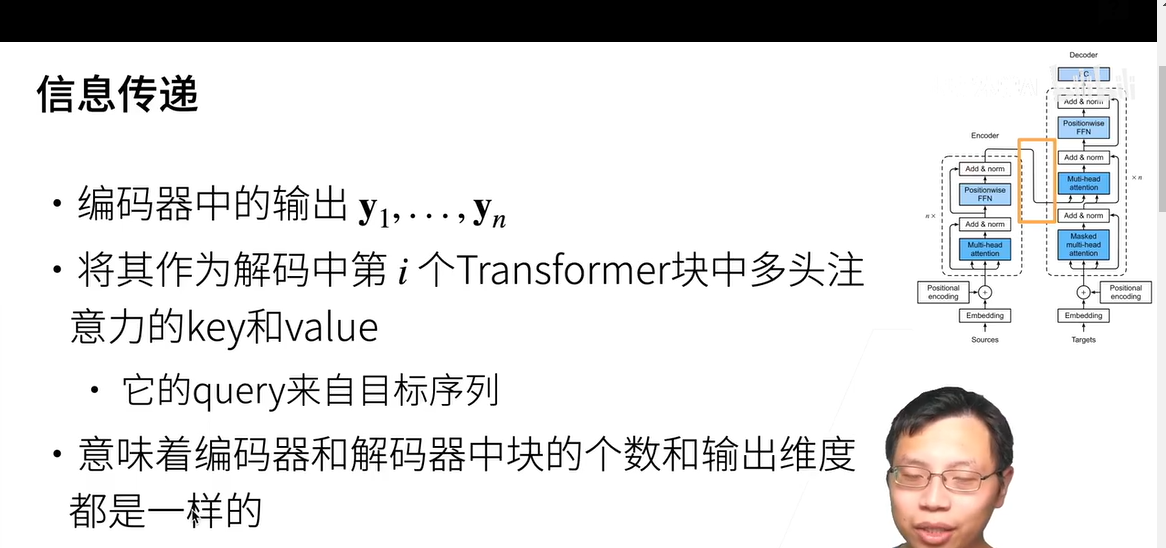

信息传递

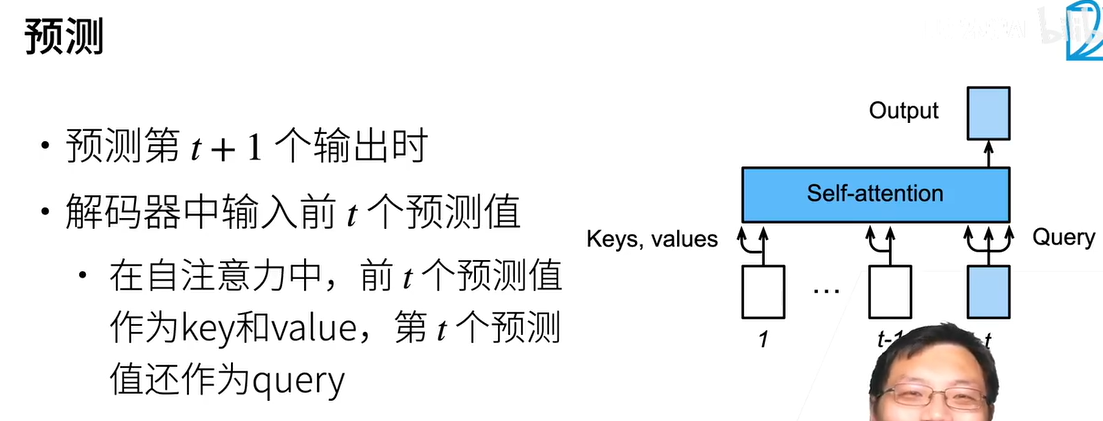

预测