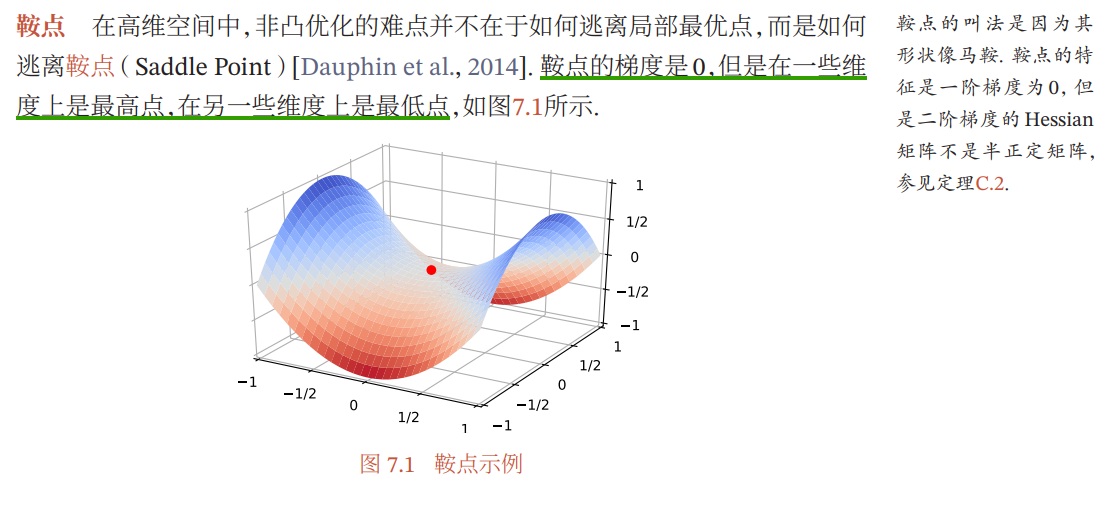

1.1 鞍点

误区:我们习惯性认为在dl训练过程会遇到局部最优点,并想方设法,譬如学习率余弦退火,来跳出局部最优点。或者索性在多个局部最优点间进行比较,直接拿表现最好的模型定为最终模型。

正解:在高维空间中,非凸优化的难点并不在于如何逃离局部最优点,而是逃离鞍点。

为什么呢?原因:局部最优点在所有维度上偏导都是0,也就是说其在所有维度(方向)上都是(这一小区域)的最低点,这种概率非常低。如果说在某维度上是局部最优点(该维度偏导为0,驻点)的概率为p,假设有10000维,则该点为所有维度上都是局部最优点的概率为p^10000,近乎不可能。

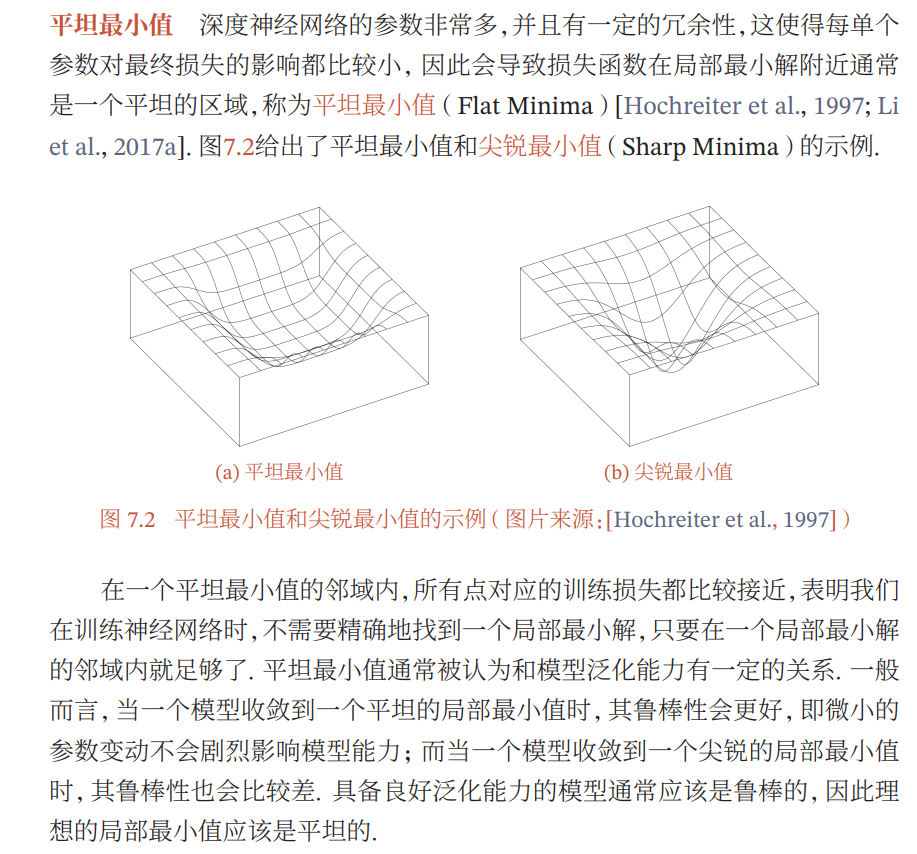

1.2 平坦最小值

1.3 局部最小解的等价性

划重点:结合第2点来看,当找到平坦最小值时(可以理解为几个epoch内损失函数几乎没变化),没有必要一定找出全局最小解!