1.正则化

(1)正则化作用

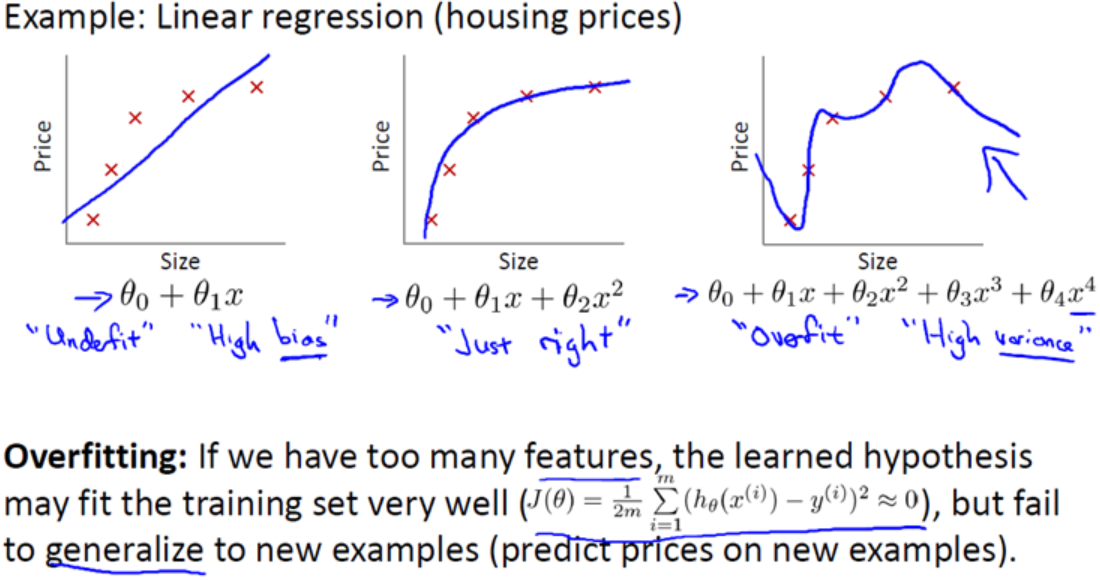

在线性回归或者逻辑回归中会出现过拟合的情况,它们对训练数据拟合得很好,但是却不能有效地进行预测。线性回归过拟合:

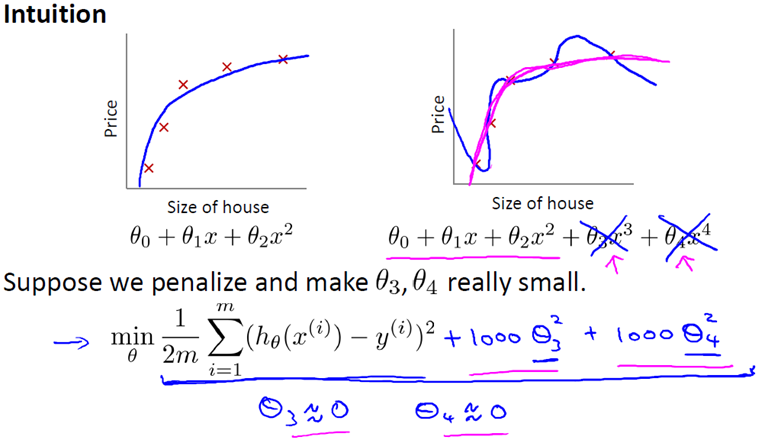

一旦出现过拟合,解决方法有两种,(1)丢弃一些对我们最终预测结果影响不大的特征,具体哪些特征需要丢弃可以通过PCA算法来实现;(2)使用正则化技术,保留所有特征,但是减少特征前面的参数θ的大小,具体就是修改线性回归中的损失函数形式即可。例如对于前面线性回归的例子,当我们要避免过拟合,一个很好的策略就是减少θ、 θ的值,极端的情况是让这两个参数约等于0。

这里hθ(x)=θ0+θ1x1+θ2x22;设想如果θ3和θ4 足够小,那么此时后面的两项θ3x33+θ4x44这两项可以忽略不计,此时的曲线就是一条光滑的曲线,因此就不会发生过拟合的问题。此时就引出了我们的正则化公式。

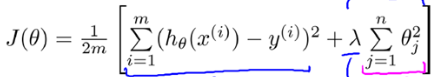

下面的这项就是一个正则化项

λ在这里称为正则化参数,λ 要做的就是控制在两个不同的目标中的平衡关系:第一个目标就是更好地拟合训练数据,而第二个目标就是保持函数形式相对简单,来避免过拟合。而θ,则是我们可以调节的参数,我们通过取损失函数的最小值,实际上也就是为了找到最好的参数θ0,θ1,θ2….

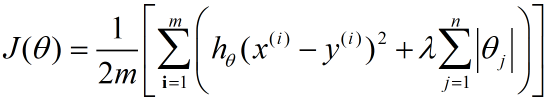

(2)L1和L2正则化

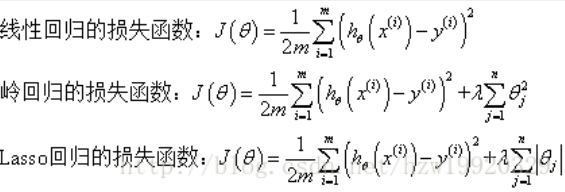

L1和L2正则化都是在代价函数后面再加上一个正则化项,L2正则化增加的是下面这部分:

L1正则化则是在后面增加的绝对值

先说结论:L2正则化可以减少每个样本权重系数的大小,岭回归用的就是这种正则化方式;L1正则化直接将权重系数小的样本删掉,Lasso回归用的就是这种正则化方式;而Elastic Net回归,既包含了L1正则化,也包含了L2正则化。

关于L1和L2正则化是如何减少这部分的,目前还没有找到一个比较好的博客,下面两篇算是比较好的,但是没有完全看明白。

(1) 正则化方法:L1和L2 regularization、数据集扩增、dropout

(2)L1正则化与L2正则化

2.岭回归

前面说过,解决过拟合有两种方式:(1)丢弃一些对我们最终预测结果影响不大的特征;(2)使用正则化技术,保留所有特征,但是减少特征前面的参数θ的大小。岭回归以及Lasso回归就是通过第二种方式这么做的,这是岭回归和Lasso回归的一大重要作用。岭回归与Lasso回归还有一个重要的作用是通过正规方程方法求解θ的过程中出现的x转置乘以x不可逆这两类问题的。线性回归、岭回归和Lasso回归的损失函数分别如下所示。

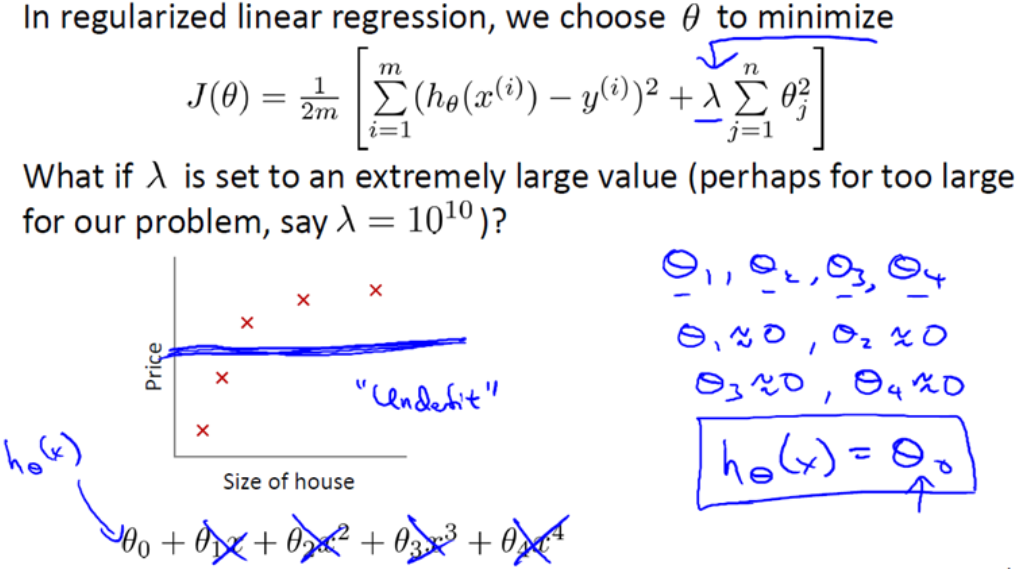

其中λ称为正则化参数,如果λ选取过大,会把所有参数θ均最小化,造成欠拟合,为什么?假设λ=1010,我们的参数θ为了损失函数最小,该怎么调整??这些参数会接近于零,最终我们的拟合函数hθ(x)=θ0,这句话的另一种方式来表达就是这种假设有过于强烈的”偏见” 或者过高的偏差 (bais),认为预测的价格只是等于 θ 。对于数据来说这只是一条水平线。

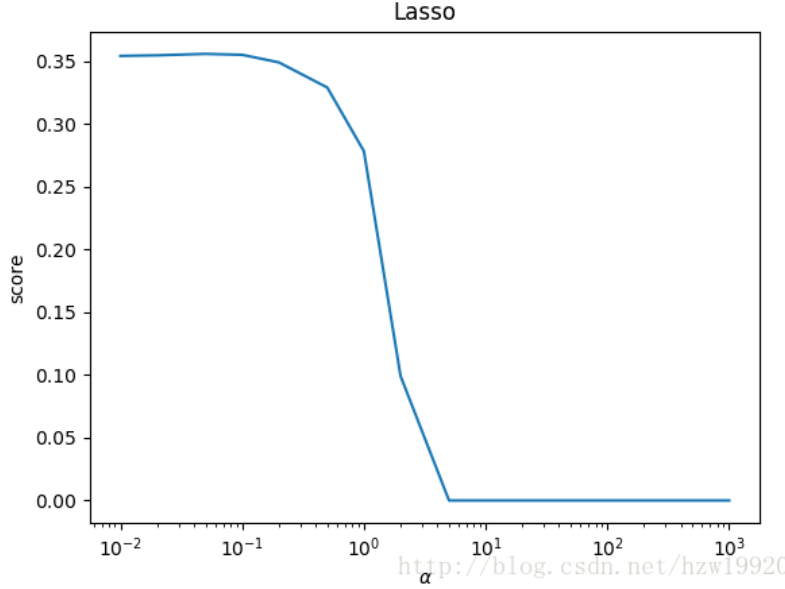

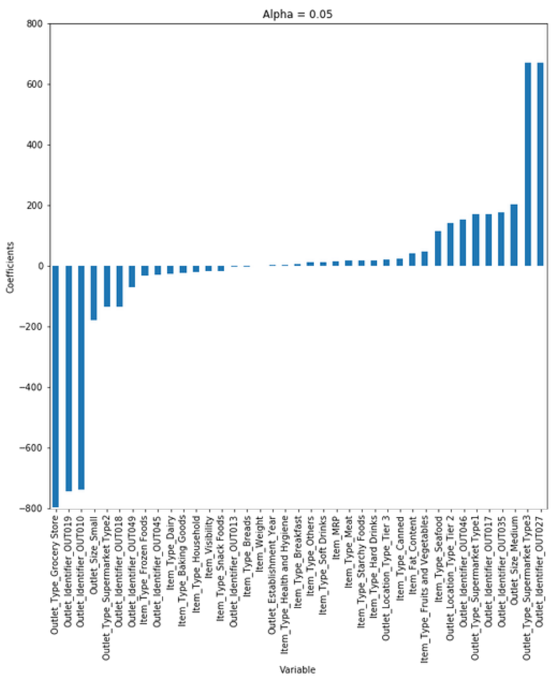

如果λ选取过小,会导致对过拟合问题解决不当。岭回归与Lasso回归最大的区别在于岭回归引入的是L2范数惩罚项,Lasso回归引入的是L1范数惩罚项,Lasso回归能够使得损失函数中的许多θ均变成0,这点要优于岭回归,因为岭回归是要所有的θ均存在的,这样计算量Lasso回归将远远小于岭回归。岭回归和Lasso回归的损失函数图像分别如下所示。

可以看到,Lasso回归最终会趋于一条直线,原因就在于好多θ值已经均为0,而岭回归却有一定平滑度,因为所有的θ值均存在。

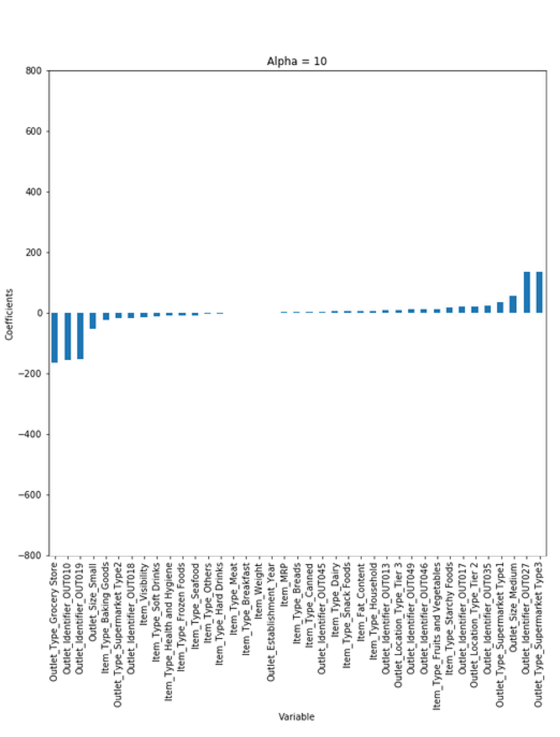

在sklearn中,岭回归、Lasso回归和Elastic Net回归都是调用的线性回归。岭回归只有一个参数α,正则化之后各权重可以理解为等比例缩小。可以看到,随着α的增加,一些权重很小的参数变得很小很小(解决于0但非0)

from sklearn.linear_model import Ridge

3.Lasso回归

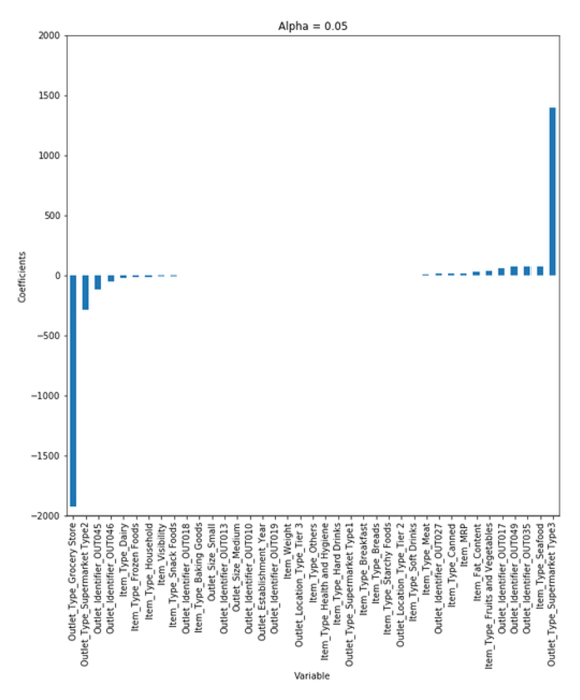

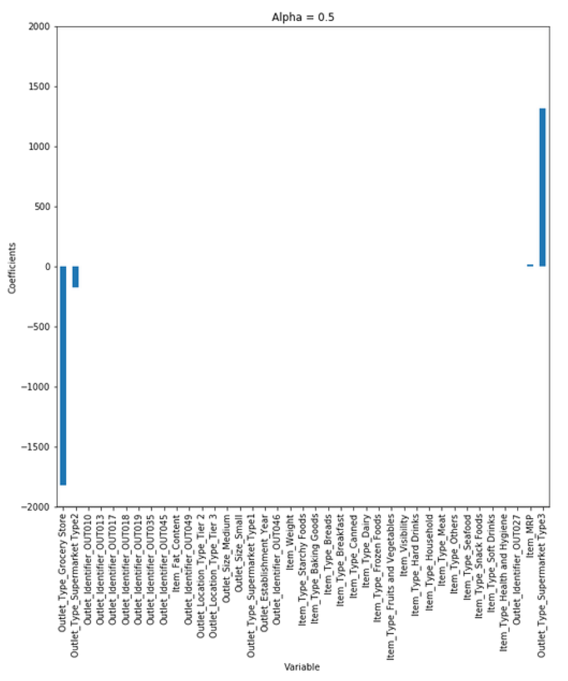

Lasso(Least Absolute Shrinkage Selector Operator)通常来讲,比岭回归的速度更快并且预测的准确率会更好。关于它的运作方式这部分不再赘述,看文章最后的PDF即可。Lasso回归和岭回归一样,也是只有一个参数α,随着α的增大,权重系数小的样本直接被去掉了。

4.Elastic Net 回归

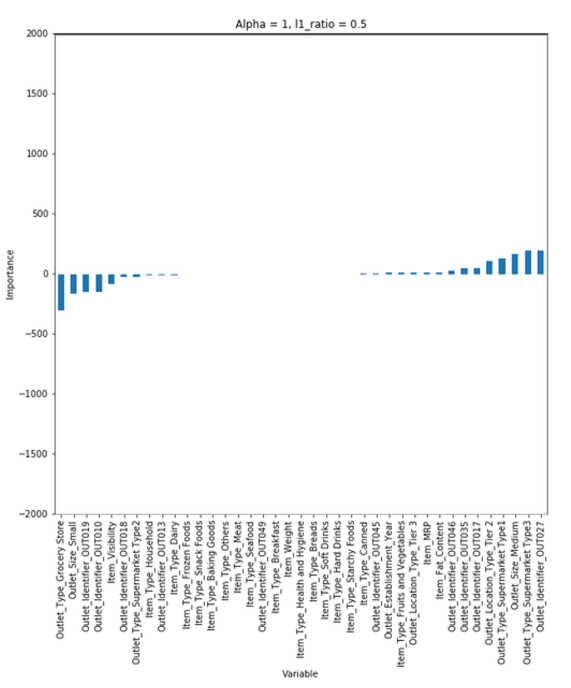

Elastic Net综合了岭回归和Lasso回归,在sklearn中它有两个参数α和L1,这里

当我们给定了α和L1之后,a和b就可以求出来。当α=1,0

更多关于岭回归、Lasso回归以及Elastic Net回归可以看下面的PDF,非常详细,通俗易懂。

linear regression.pdf