Sentinel是一个面向云原生微服务的流量控制、熔断降级组件。

替代Hystrix,针对问题:服务雪崩、服务降级、服务熔断、服务限流

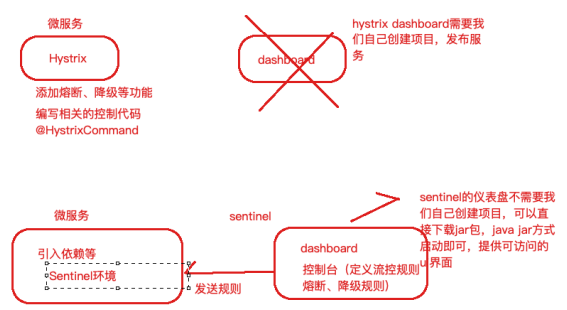

Hystrix: 服务消费者(自动投递微服务)—>调用服务提供者(简历微服务) 在调用方引入Hystrix—> 单独搞了一个Dashboard项目—>Turbine

1)自己搭建监控平台 dashboard

2)没有提供UI界面进行服务熔断、服务降级等配置(而是写代码,入侵了我们源程 序环境)

Sentinel:

1)独立可部署Dashboard/控制台组件

2)减少代码开发,通过UI界面配置即可完成细粒度控制(自动投递微服务)

Sentinel 分为两个部分:

核心库:(Java 客户端)不依赖任何框架/库,能够运行于所有 Java 运行时环 境,同时对 Dubbo / Spring Cloud 等框架也有较好的支持。

控制台:(Dashboard)基于 Spring Boot 开发,打包后可以直接运行,不需要额外的 Tomcat 等应用容器。

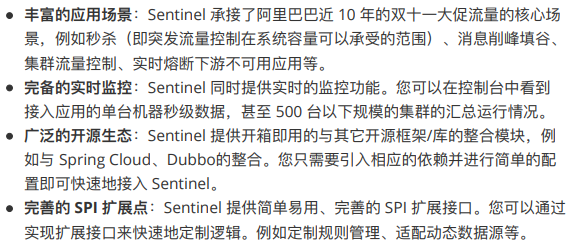

Sentinel 具有以下特征

Sentinel 的主要特性

Sentinel 部署

下载地址:https://github.com/alibaba/Sentinel/releases 我们使用v1.7.1

启动:java -jar sentinel-dashboard-1.7.1.jar &

用户名/密码:sentinel/sentinel

刚开始登录是空的,因为还没有服务进行建立联系

改造微服务使用Sentinel

1、引入Sentinel核心包

在自动投递微服务进行的熔断降级等控制,那么接下来我们改造自动投递微服务,引入Sentinel 核心包。

改造自动投递微服务 lagou-service-autodeliver8098-sentinel,没有服务端火客户端的说法,就是核心环境

<!--sentinel 核心环境 依赖--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-sentinel</artifactId></dependency>

2、application.yml修改

(配置sentinel dashboard,暴露断点依然要有,删除原 有hystrix配置,删除原有OpenFeign的降级配置

要和sentinel仪表盘的地址进行通信

server:port: 8098spring:application:name: lagou-service-autodelivercloud:nacos:discovery:server-addr: 127.0.0.1:8848,127.0.0.1:8849,127.0.0.1:8850sentinel:transport:dashboard: 127.0.0.1:8080 # sentinel dashboard/console 地址port: 8719 # sentinel会在该端口启动http server,那么这样的话,控制台定义的一些限流等规则才能发送传递过来,#如果8719端口被占用,那么会依次+1management:endpoints:web:exposure:include: "*"# 暴露健康接口的细节endpoint:health:show-details: always#针对的被调用方微服务名称,不加就是全局生效lagou-service-resume:ribbon:#请求连接超时时间ConnectTimeout: 2000#请求处理超时时间##########################################Feign超时时长设置ReadTimeout: 3000#对所有操作都进行重试OkToRetryOnAllOperations: true####根据如上配置,当访问到故障请求的时候,它会再尝试访问一次当前实例(次数由MaxAutoRetries配置),####如果不行,就换一个实例进行访问,如果还不行,再换一次实例访问(更换次数由MaxAutoRetriesNextServer配置),####如果依然不行,返回失败信息。MaxAutoRetries: 0 #对当前选中实例重试次数,不包括第一次调用MaxAutoRetriesNextServer: 0 #切换实例的重试次数NFLoadBalancerRuleClassName: com.netflix.loadbalancer.RoundRobinRule #负载策略调整logging:level:# Feign日志只会对日志级别为debug的做出响应com.lagou.edu.controller.service.ResumeServiceFeignClient: debug

上述配置之后,启动自动投递微服务,启动简历微服务,自动投递微服务要调用简历微服务的,

先到nacos看服务提供者是否注册上去,然后再到Sentinel去看。

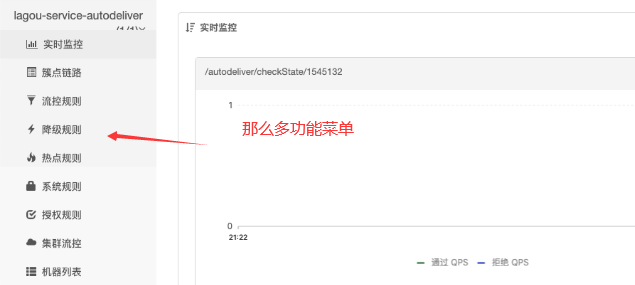

使用Sentinel 监控自动投递微服务

此时我们发现控制台没有任何变化,因为懒加载,我们只需要发起一次请求触发即可

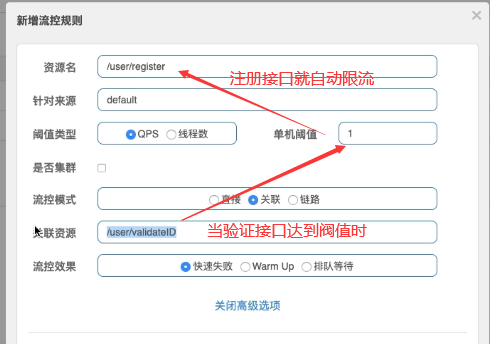

3、Sentinel 限流规则模块

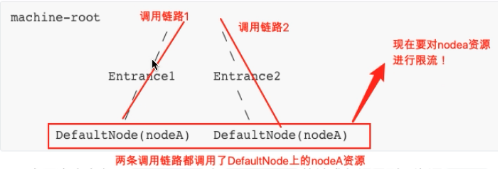

其中有三种模式:直接、关联、链路。 还有很多规则模块

(左:直接、右:关联)

所谓指定调用链路是指定入口(只需要关注指定的入口)

(左:链路、右:预热)

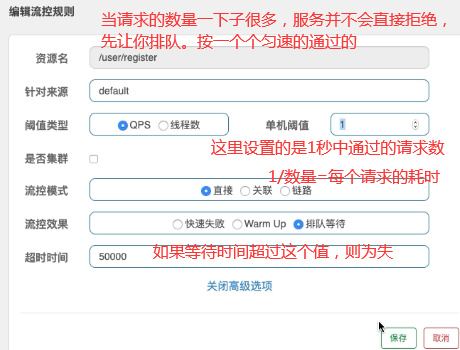

排队:*(几乎同时请求,但是后台通过是1秒一个)

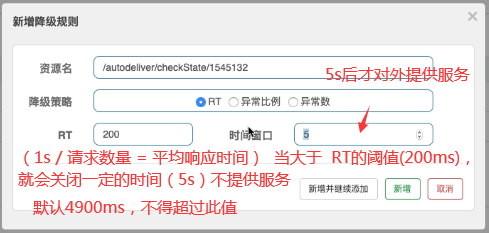

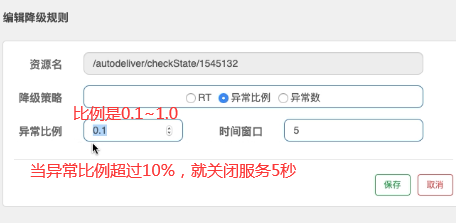

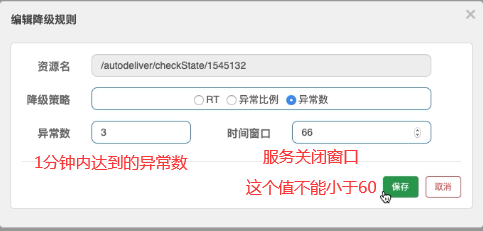

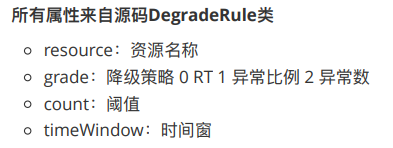

4、Sentinel 降级规则模块

但是请求数都要大于五个才开始算的,不超过是不算的。

5、自定义兜底方法

这是对服务消费者这段进行写兜底方法的。

在Controller中,添加@SentinelResource注解,value就相当于一个标识。

blockHandler是降级的方法,fallback是异常时候回退的方法,

blockHandlerClass,fallbackClass是他们所对应的类

@GetMapping("/checkState/{userId}")// @SentinelResource注解类似于Hystrix中的@HystrixCommand注解@SentinelResource(value = "findResumeOpenState",blockHandlerClass = SentinelHandlersClass.class,blockHandler = "handleException",fallbackClass = SentinelHandlersClass.class,fallback = "handleError")public Integer findResumeOpenState(@PathVariable Long userId) {// 模拟降级:异常比例//int i = 1/0;Integer defaultResumeState = resumeServiceFeignClient.findDefaultResumeState(userId);return defaultResumeState;}

可以在一个通用类中定义

public class SentinelHandlersClass {// 整体要求和当时Hystrix一样,这里还需要在形参中添加BlockException参数,用于接收异常// 注意:方法是静态的public static Integer handleException(Long userId, BlockException blockException) {return -100;}public static Integer handleError(Long userId) {return -500;}}

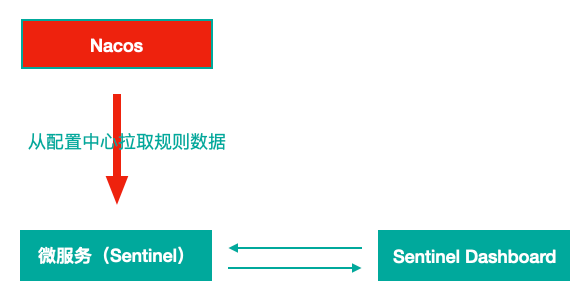

基于 Nacos 实现 Sentinel 规则持久化

Sentinel Dashboard中添加的规则数据存储在内存,微服务停掉规则数据就消失,在生产环境下不合适。我们可以将Sentinel规则数据持久化到Nacos配置中心,让微服务从Nacos获取规则数据。(即使重新启动也是从nacos获取)

为了实现微服务能从nacos上获取信息,需要以下几步操作:

1、自动投递微服务的pom.xml中添加依赖

把nacos当做Sentinel的一个数据源

<!-- Sentinel支持采用 Nacos 作为规则配置数据源,引入该适配依赖 --><dependency><groupId>com.alibaba.csp</groupId><artifactId>sentinel-datasource-nacos</artifactId></dependency>

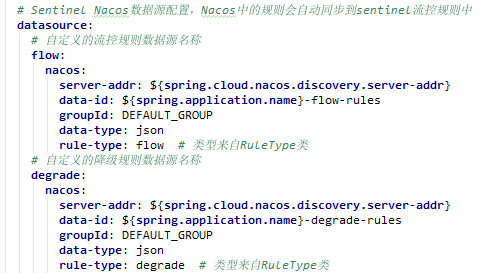

2、自动投递微服务的application.yml中配置Nacos数据源

配置数据源,那么肯定有datasource,而且和transport是同一个级别,sentinel会自动从nacos同步过来的

下面定义两个数据源,

完整配置如下:

server:port: 8098spring:application:name: lagou-service-autodelivercloud:nacos:discovery:server-addr: 127.0.0.1:8848,127.0.0.1:8849,127.0.0.1:8850sentinel:transport:dashboard: 127.0.0.1:8080 # sentinel dashboard/console 地址port: 8719 # sentinel会在该端口启动http server,那么这样的话,控制台定义的一些限流等规则才能发送传递过来,#如果8719端口被占用,那么会依次+1# Sentinel Nacos数据源配置,Nacos中的规则会自动同步到sentinel流控规则中datasource:# 自定义的流控规则数据源名称flow:nacos:server-addr: ${spring.cloud.nacos.discovery.server-addr}data-id: ${spring.application.name}-flow-rulesgroupId: DEFAULT_GROUPdata-type: jsonrule-type: flow # 类型来自RuleType类# 自定义的降级规则数据源名称degrade:nacos:server-addr: ${spring.cloud.nacos.discovery.server-addr}data-id: ${spring.application.name}-degrade-rulesgroupId: DEFAULT_GROUPdata-type: jsonrule-type: degrade # 类型来自RuleType类management:endpoints:web:exposure:include: "*"# 暴露健康接口的细节endpoint:health:show-details: always#针对的被调用方微服务名称,不加就是全局生效lagou-service-resume:ribbon:#请求连接超时时间ConnectTimeout: 2000#请求处理超时时间##########################################Feign超时时长设置ReadTimeout: 3000#对所有操作都进行重试OkToRetryOnAllOperations: true####根据如上配置,当访问到故障请求的时候,它会再尝试访问一次当前实例(次数由MaxAutoRetries配置),####如果不行,就换一个实例进行访问,如果还不行,再换一次实例访问(更换次数由MaxAutoRetriesNextServer配置),####如果依然不行,返回失败信息。MaxAutoRetries: 0 #对当前选中实例重试次数,不包括第一次调用MaxAutoRetriesNextServer: 0 #切换实例的重试次数NFLoadBalancerRuleClassName: com.netflix.loadbalancer.RoundRobinRule #负载策略调整logging:level:# Feign日志只会对日志级别为debug的做出响应com.lagou.edu.controller.service.ResumeServiceFeignClient: debug

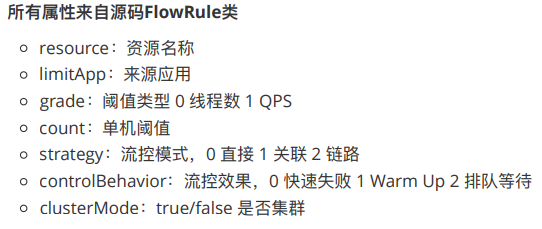

3、Nacos Server中添加对应规则配置集

(public命名空间—>DEFAULT_GROUP中 添加)

流控规则配置集 lagou-service-autodeliver-flow-rules

[{"resource":"findResumeOpenState","limitApp":"default","grade":1,"count":1,"strategy":0,"controlBehavior":0,"clusterMode":false}]

降级规则配置集 lagou-service-autodeliver-degrade-rules

[{"resource":"findResumeOpenState","grade":2,"count":1,"timeWindow":5}]

注意

1)一个资源可以同时有多个限流规则和降级规则,所以配置集中是一个json数组

2)Sentinel控制台中修改规则,仅是内存中有效,不会修改Nacos中的配置 值,重启后恢复原来的值; Nacos控制台中修改规则,不仅内存中有效,Nacos 中持久化规则也有效,重启后规则依然保持

Nacos + Sentinel + Dubbo 三剑合璧

删除OpenFeign 和 Ribbon,使用Dubbo RPC 和 Dubbo LB

使用Dubbo,那么消费者和提供者都是依赖于接口的,所以将接口抽取成一个接口服务

1、 需要删除或者注释掉父工程中的热部署依赖

<!--热部署--><!--<dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-devtools</artifactId><optional>true</optional></dependency>-->

2、创建接口项目(D)

提取dubbo服务接口工程,lagou-service-dubbo-api ,消费者和服务提供者都依赖于这个数据接口

public interface ResumeService {Integer findDefaultResumeByUserId(Long userId);}

3、服务提供者工程改造

1、服务提供者添加Dubbo依赖(T)

改造提供者工程(简历微服务) ,删除原有ResumeService接口,引入dubbo服务接口工程中的 ResumeService接口(刚创建Dubbo接口项目),

pom文件添加spring cloud + dubbo整合的依赖,同时添加刚刚创建的dubbo服务接口工程依赖

<!--spring cloud+dubbo 依赖--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-dubbo</artifactId></dependency><dependency><groupId>com.alibaba.csp</groupId><artifactId>sentinel-apache-dubbo-adapter</artifactId></dependency><!--dubbo 服务接口依赖--><dependency><groupId>com.lagou.edu</groupId><artifactId>lagou-service-dubbo-api</artifactId><version>1.0-SNAPSHOT</version></dependency>

2、服务提供者的实现类上添加dubbo的注解 (T)

适当调整代码,在service的实现类上添加dubbo的 @Service注解 。

通过@Service注解 表示标识当做服务进行发布出去

@Servicepublic class ResumeServiceImpl implements ResumeService {// 将远程接口进行注入(使用Duboo就是为了向使用本地接口一样的原则)@Autowiredprivate ResumeDao resumeDao;//......方法中通过注入的接口进行调用}

3、配置文件中添加dubbo配置 (T)

application.yml或者bootstrap.yml配置文件中添加dubbo配置

将包扫描到的东西注册到注册中心

dubbo:scan:# dubbo 服务扫描基准包base-packages: com.lagou.edu.service.implprotocol:# dubbo 协议name: dubbo# dubbo 协议端口( -1 表示自增端口,从 20880 开始)port: -1host: 127.0.0.1registry:# 挂载到 Spring Cloud 的注册中心#把注册中心挂载到当前的注册中心,也就是nacos中address: spring-cloud://localhost

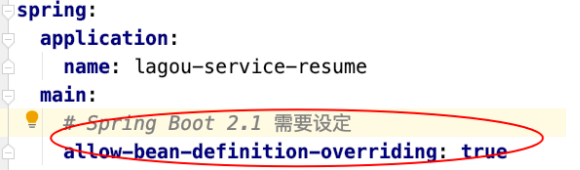

另外增加一项配置

完整配置:

server:port: 8084spring:application:name: lagou-service-resumedatasource:driver-class-name: com.mysql.jdbc.Driverurl: jdbc:mysql://localhost:3306/lagou?useUnicode=true&characterEncoding=utf8username: rootpassword: 123456jpa:database: MySQLshow-sql: truehibernate:naming:physical-strategy: org.hibernate.boot.model.naming.PhysicalNamingStrategyStandardImpl #避免将驼峰命名转换为下划线命名# nacos配置cloud:nacos:discovery:# 集群中各节点信息都配置在这里(域名-VIP-绑定映射到各个实例的地址信息)server-addr: 127.0.0.1:8848,127.0.0.1:8849,127.0.0.1:8850# nacos config 配置config:server-addr: 127.0.0.1:8848,127.0.0.1:8849,127.0.0.1:8850# 锁定server端的配置文件(读取它的配置项)namespace: 07137f0a-bf66-424b-b910-20ece612395a # 命名空间idgroup: DEFAULT_GROUP # 默认分组就是DEFAULT_GROUP,如果使用默认分组可以不配置file-extension: yaml #默认properties# 根据规则拼接出来的dataId效果:lagou-service-resume.yamlext-config[0]:data-id: abc.yamlgroup: DEFAULT_GROUPrefresh: true #开启扩展dataId的动态刷新ext-config[1]:data-id: def.yamlgroup: DEFAULT_GROUPrefresh: true #开启扩展dataId的动态刷新main:allow-bean-definition-overriding: truemanagement:endpoints:web:exposure:include: "*"dubbo:scan:# dubbo 服务扫描基准包base-packages: com.lagou.edu.service.implprotocol:# dubbo 协议name: dubbo# dubbo 协议端口( -1 表示自增端口,从 20880 开始)port: -1host: 127.0.0.1registry:# 挂载到 Spring Cloud 的注册中心address: spring-cloud://localhost

运行发布之后,会发现Nacos控制台已经有了服务注册信息,从元数据中可以 看出,是dubbo注册上来的

4、服务消费者工厂改造

接下来改造服务消费者工程—>自动投递微服务

pom.xml中删除OpenFeign相关内容

application.yml配置文件中删除和Feign、Ribbon相关的内容;代码中删除 Feign客户端内容;

1、服务消费者添加Dubbo依赖 (X)

pom.xml添加内容和服务提供者一样 ,需要Dubbo依赖,还需要添加新创建的接口项目

<!--spring cloud+dubbo 依赖--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-dubbo</artifactId></dependency><dependency><groupId>com.alibaba.csp</groupId><artifactId>sentinel-apache-dubbo-adapter</artifactId></dependency><!--dubbo 服务接口依赖--><dependency><groupId>com.lagou.edu</groupId><artifactId>lagou-service-dubbo-api</artifactId><version>1.0-SNAPSHOT</version></dependency>

2、配置文件中添加dubbo相关内容(X)

application.yml配置文件中添加dubbo相关内容

服务消费者是要消费服务,那么就需要知道服务中心在哪里,通过 subscribed-services订阅

dubbo:registry:# 挂载到 Spring Cloud 注册中心address: spring-cloud://localhostcloud:# 订阅服务提供方的应用列表,订阅多个服务提供者使用 "," 连接subscribed-services: lagou-service-resume

同样,也配置下spring.main.allow-bean-definition-overriding=true

3、Controller中注入接口对象(X)

@RestController@RequestMapping("/autodeliver")public class AutodeliverController {@Referenceprivate ResumeService resumeService;// ....方法,像调用本地接口一样去调用服务}

运行发布之后,同样会发现Nacos控制台已经有了服务注册信息

测试:

发请求,向客户端发出请求,查看效果

SCA 小结

1)因为内容重叠,SCA 中的分布式事务解决⽅案 Seata 会在紧接着的Mysql课程中 讲解。

2)SCA实际上发展了三条线

第一条线:开源出来一些组件

第二条线:阿里内部维护了一个分支,自己业务线使用

第三条线:阿里云平台部署一套,付费使用从战略上来说,SCA更是为了贴合阿里云。目前来看,开源出来的这些组件,推广及普及率不高,社区活跃度不高,稳定性 和体验度上仍需进一步提升,根据实际使用来看Sentinel的稳定性和体验度要好 于Nacos。