Hadoop HA模式搭建(高可用)

1:集群规划

一共三台虚拟机,分别为master、worker1、worker2;

namenode三台上都有,resourcemanager在worker1,woker2上。

| master | woker1 | worker2 | |

|---|---|---|---|

| NameNode | yes | yes | yes |

| DataNode | no | yes | yes |

| JournalNode | yes | yes | yes |

| NodeManager | no | yes | yes |

| ResourceManager | no | yes | yes |

| Zookeeper | yes | yes | yes |

| ZKFC | yes | yes | yes |

2:Zookeeper集群搭建:

参考

https://blog.csdn.net/l1682686/article/details/107998554

3:修改Hadoop集群配置文件

core-site.xml:

<configuration><!-- 指定hdfs的nameservice为cluster1 --><property><name>fs.defaultFS</name><value>hdfs://cluster1/</value></property><!-- 指定hadoop临时目录 --><property><name>hadoop.tmp.dir</name><value>/home/hadoop/data/tmp/</value></property><!-- 指定zookeeper地址 --><property><name>ha.zookeeper.quorum</name><value>master:2181,worker1:2181,worker2:2181</value></property><!-- hadoop链接zookeeper的超时时长设置 --><property><name>ha.zookeeper.session-timeout.ms</name><value>1000</value><description>ms</description></property><!--以下设置和本次HA配置无关<property><name>hadoop.proxyuser.hadoop.hosts</name><value>*</value></property><property><name>hadoop.proxyuser.hadoop.groups</name><value>*</value></property>--></configuration>

hdfs-site.xml:

<configuration><!-- 指定副本数 --><property><name>dfs.replication</name><value>2</value></property><!-- 配置namenode和datanode的工作目录-数据存储目录 --><property><name>dfs.namenode.name.dir</name><value>/home/hadoop/data/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>/home/hadoop/data/dfs/data</value></property><!-- 启用webhdfs --><property><name>dfs.webhdfs.enabled</name><value>true</value></property><!--指定hdfs的nameservice为cluster1,需要和core-site.xml中的保持一致dfs.ha.namenodes.[nameservice id]为在nameservice中的每一个NameNode设置唯一标示符。配置一个逗号分隔的NameNode ID列表。这将是被DataNode识别为所有的NameNode。例如,如果使用"cluster1"作为nameservice ID,并且使用"nn1"和"nn2"作为NameNodes标示符--><property><name>dfs.nameservices</name><value>cluster1</value></property><!-- cluster下面有3个NameNode,分别是nn1,nn2,nn3--><property><name>dfs.ha.namenodes.cluster1</name><value>nn1,nn2,nn3</value></property><!-- nn1的RPC通信地址 --><property><name>dfs.namenode.rpc-address.cluster1.nn1</name><value>master:9000</value></property><!-- nn1的http通信地址 --><property><name>dfs.namenode.http-address.cluster1.nn1</name><value>master:9870</value></property><!-- nn2的RPC通信地址 --><property><name>dfs.namenode.rpc-address.cluster1.nn2</name><value>worker1:9000</value></property><!-- nn2的http通信地址 --><property><name>dfs.namenode.http-address.cluster1.nn2</name><value>worker1:9870</value></property><!-- nn3的RPC通信地址 --><property><name>dfs.namenode.rpc-address.cluster1.nn3</name><value>worker2:9000</value></property><!-- nn3的http通信地址 --><property><name>dfs.namenode.http-address.cluster1.nn3</name><value>worker2:9870</value></property><!-- 指定NameNode的edits元数据的共享存储位置。也就是JournalNode列表该url的配置格式:qjournal://host1:port1;host2:port2;host3:port3/journalIdjournalId推荐使用nameservice,默认端口号是:8485 --><property><name>dfs.namenode.shared.edits.dir</name><value>qjournal://master:8485;worker1:8485;worker2:8485/cluster1</value></property><!-- 指定JournalNode在本地磁H的位置 --><property><name>dfs.journalnode.edits.dir</name><value>/home/hadoop/data/Hadoop-HA/journaldata</value></property><!-- 开启NameNode失败自动切换 --><property><name>dfs.ha.automatic-failover.enabled</name><value>true</value></property><!-- 配置失败自动切换实现方式 --><property><name>dfs.client.failover.proxy.provider.cluster1</name><value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value></property><!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行 --><property><name>dfs.ha.fencing.methods</name><value>sshfenceshell(/bin/true)</value></property><!-- 使用sshfence隔离机制时需要ssh免登陆 --><property><name>dfs.ha.fencing.ssh.private-key-files</name><value>/home/hadoop/.ssh/id_rsa</value></property><!-- 配置sshfence隔离机制超时时间 --><property><name>dfs.ha.fencing.ssh.connect-timeout</name><value>30000</value></property><property><name>ha.failover-controller.cli-check.rpc-timeout.ms</name><value>60000</value></property></configuration>

mapred-site.xml

<configuration><!-- 指定mr框架为yarn方式 --><property><name>mapreduce.framework.name</name><value>yarn</value></property><!-- 指定mapreduce jobhistory地址 --><property><name>mapreduce.jobhistory.address</name><value>master:10020</value></property><!-- 任务历史服务器的web地址 --><property><name>mapreduce.jobhistory.webapp.address</name><value>master:19888</value></property></configuration>

都修改好了,就分发给其他集群节点

(在hadoop/etc路径下)

scp -r hadoop/ hadoop@worker1:PWDscp -r hadoop/ hadoop@worker2:PWD

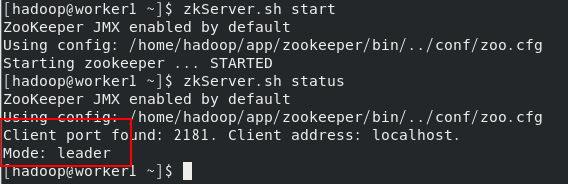

4:启动zookeeper集群

在每台机器上启动:

zkServer.sh startzkServer.sh status

5: 格式化namenode、zkfc

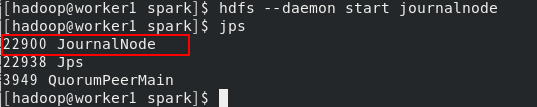

首先,在所有虚拟机上启动journalnode:

hdfs --daemon start journalnode

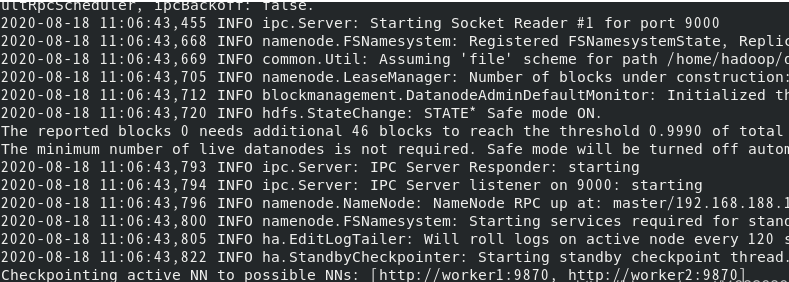

都启动完毕之后,在master节点上,格式化namenode

hadoop namenode -format

然后单独启动namenode:

hdfs namenode

然后,在另外两台机器上,同步格式化好的namenode:

hdfs namenode -bootstrapStandby

应该能从master上看到传输信息。

传输完成后,在master节点上,格式化zkfc:

hdfs zkfc -formatZK

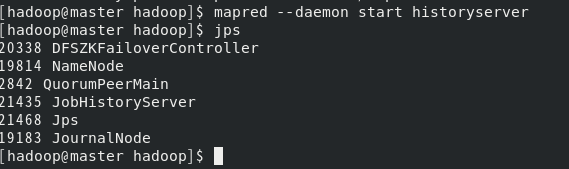

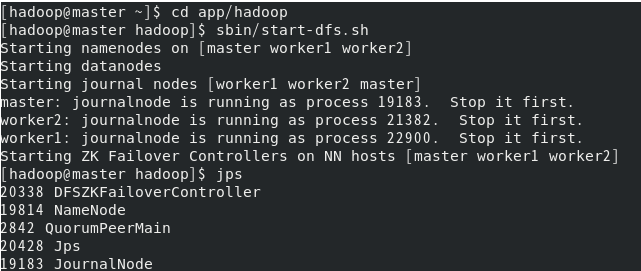

6:启动hdfs

在master节点上,先启动dfs:

start-dfs.sh

可以看到各个节点的进程启动情况:

master:

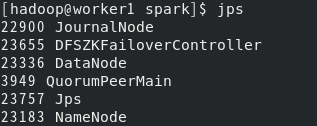

worker1:

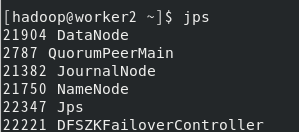

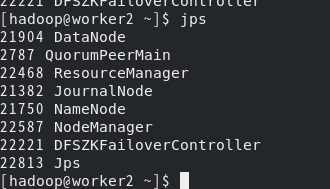

worker2:

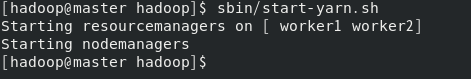

然后启动yarn:

start-yarn.sh

worker1:

worker2:

启动mapreduce任务历史服务器:

mapred --daemon start historyserver

7:尝试HA模式

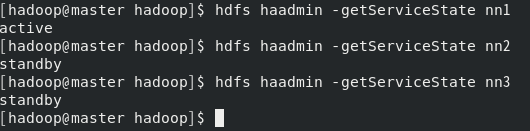

首先看看各个namenode主机状态:

hdfs haadmin -getServiceState nn1

可以看到,有两个standby,一个active。

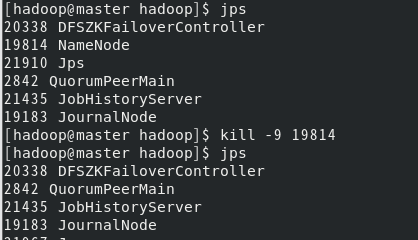

在active的master节点上,kill掉namenode进程:

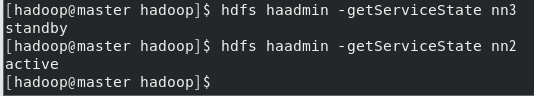

再次查看节点状态:

可以看到,nn2已经切换为active,Hadoop 高可用集群基本搭建完成。