作者的谷歌学术:https://scholar.google.com/citations?user=rmsIyGMAAAAJ&hl=en

一、问题与现状

尽管机器学习模型被广泛使用,但是大部分模型都还是黑盒。 理解预测背后的理由,非常重要,能够帮助决策者依据预测做出行动与计划。同时,也帮助专家理解模型,能够把不靠谱的模型转换为一个靠谱的模型。

在本论文中,提出了LIME算法,一种可以应用于任何分类器的预测解释,主要思想是基于预测的局部值给出可解释的模型。

二、介绍

机器学习在科学和技术领域得到很大进展与应用。但是,能否可以把机器学习分类器当做一种工具,在一些产品中使用,最关键的问题是:模型是可信,模型的预测结果是否可信。对于可信度的定义有两种角度:一是 对预测结果的相信。比如:能够充分相信预测结果并基于此做出相应的行动。二是 对模型相信。比如:模型是否以可靠的形式 work。

一些case

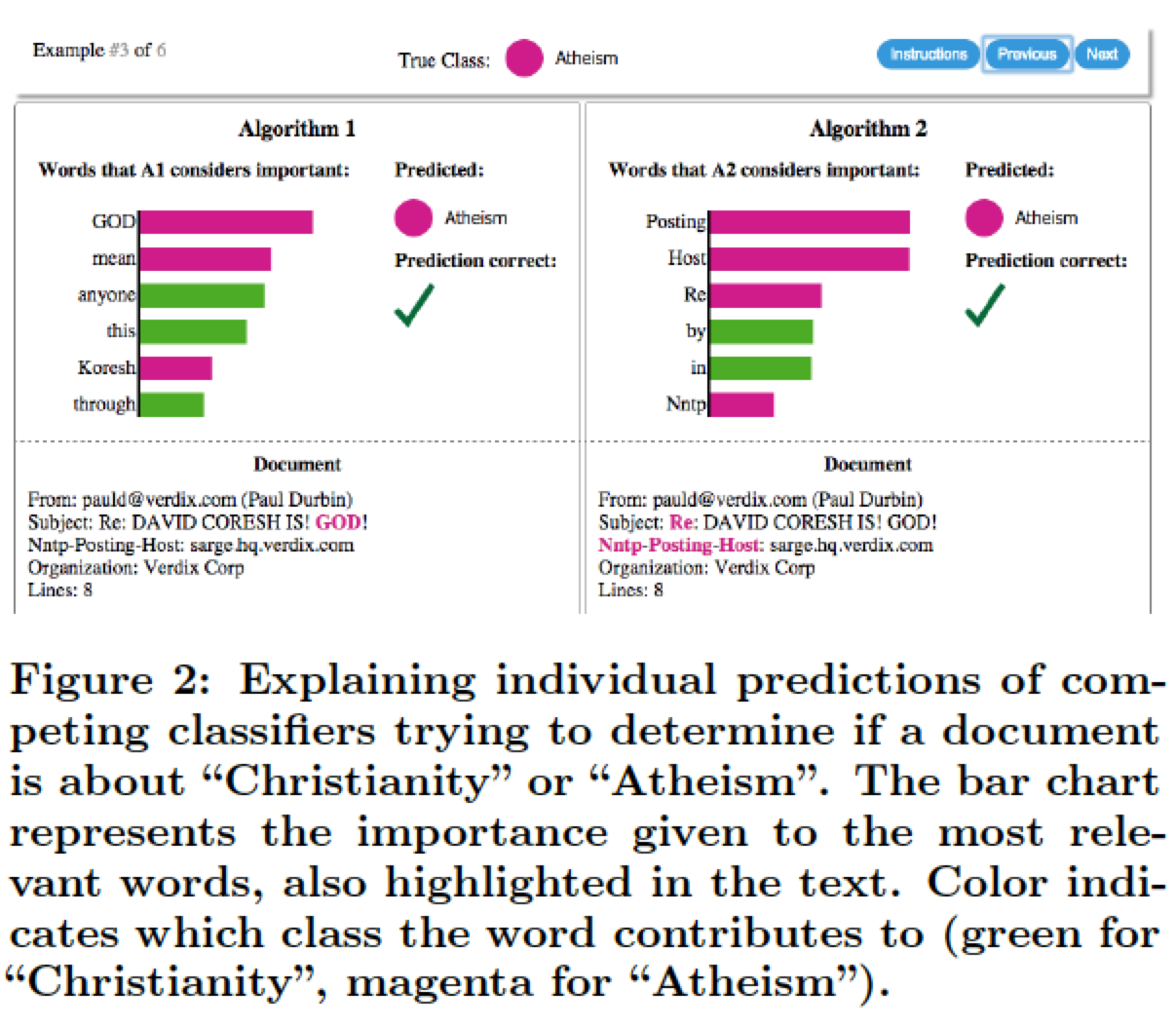

预测是否是Chritianity(基督徒)绿色、无神论者(athesim)洋红色。

好的解释器(explainer)有哪些特点

具有可解释性(interpretable):提供关于变量(variable)与响应(response)间的定性的可理解的关系。比如说:有几千个样本对预测有较大的贡献,即使特征权重是可以观察到的,但仍然不能可靠的解释预测结果被得到原因。 根本上:不同特征值给出不同的解释。==》有模型权重不一定够,还需要对不同样本能有不同的解释。

local fidelity(局部保真度):特征从全局来看可能是重要的,但是局部来看,可能没有那么重要。确保local fidelity很重要,因为对于复杂模型gloabl fidelity 不一定靠谱,挑战性较高。

三、Local Interpretable Model-agnostic Explanations (LIME)

LIME 算法是一种局部解释性方法。

可解释的数据表征:Interpretable Data Representation,可说明的解释前提是数据对于人来说可以理解的。