一、问题与现状

论文发现overparameterized 神经网络模型 的泛化性比 小的 好,这和经典的函数复杂度理念存在矛盾点,传统方法任务更小的模型有更好的泛化性。<br /> 论文探讨了复杂度与泛化性间的关系full-batch 训练、使用随机label 会降低模型的泛化性<br /> 数据增强、Relu等非线性变化 会提高模型的泛化性。<br /> 论文用input-output的Jacobian norm 来衡量泛化性。

二、介绍

很多相关文献都表明,大的模型网络不仅在测试集上有很好表现,在测试集上也有更好的表现。

not only do large networks demonstrate good test performance, but larger networks often generalize better

这和Occam’s razor 相互违背,

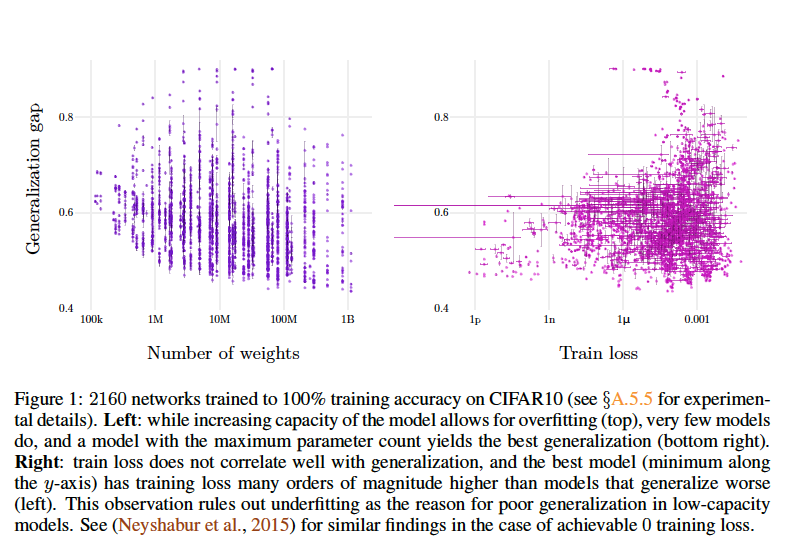

上图表明,模型越复杂,测试集上误差越小;训练集误差 和泛化性误差相关性较弱。