https://www.bilibili.com/video/BV1Wv411h7kN?p=38

一、背景与问题

self-attention:和cnn一样,是一种架构。

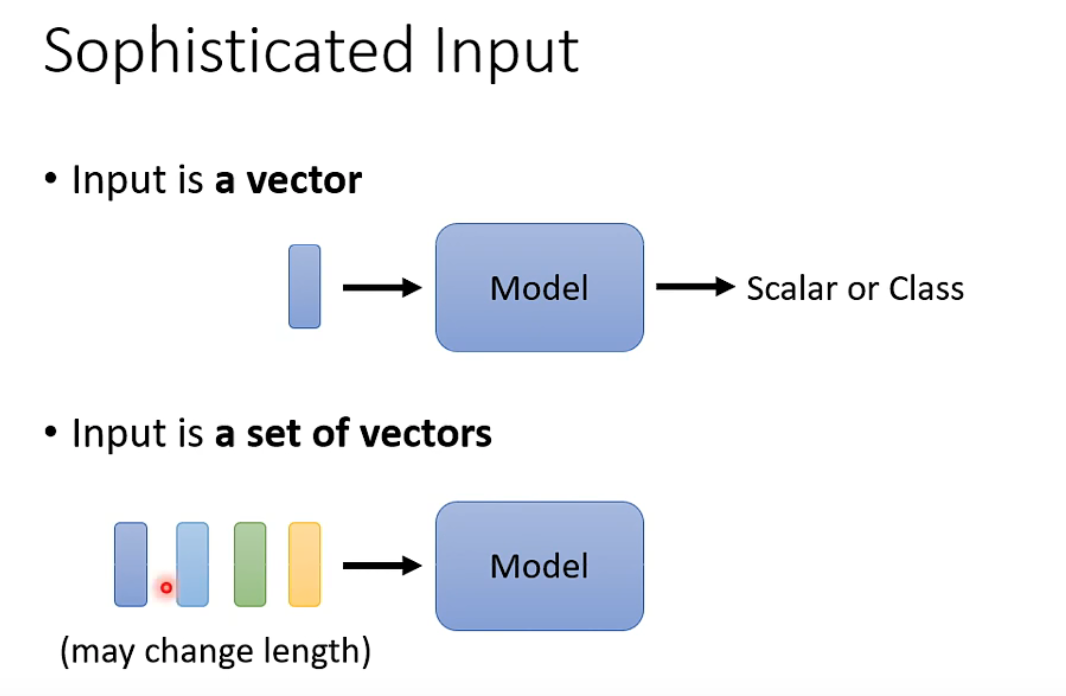

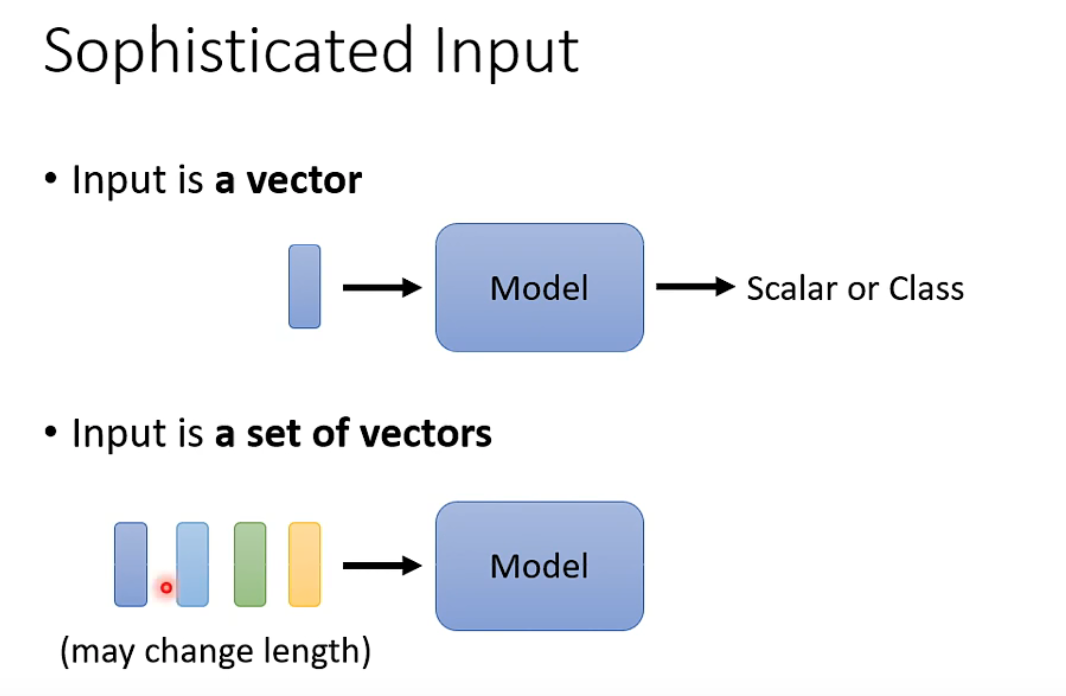

常见情况:输入是固定长度的向量,输出是标量或类别。

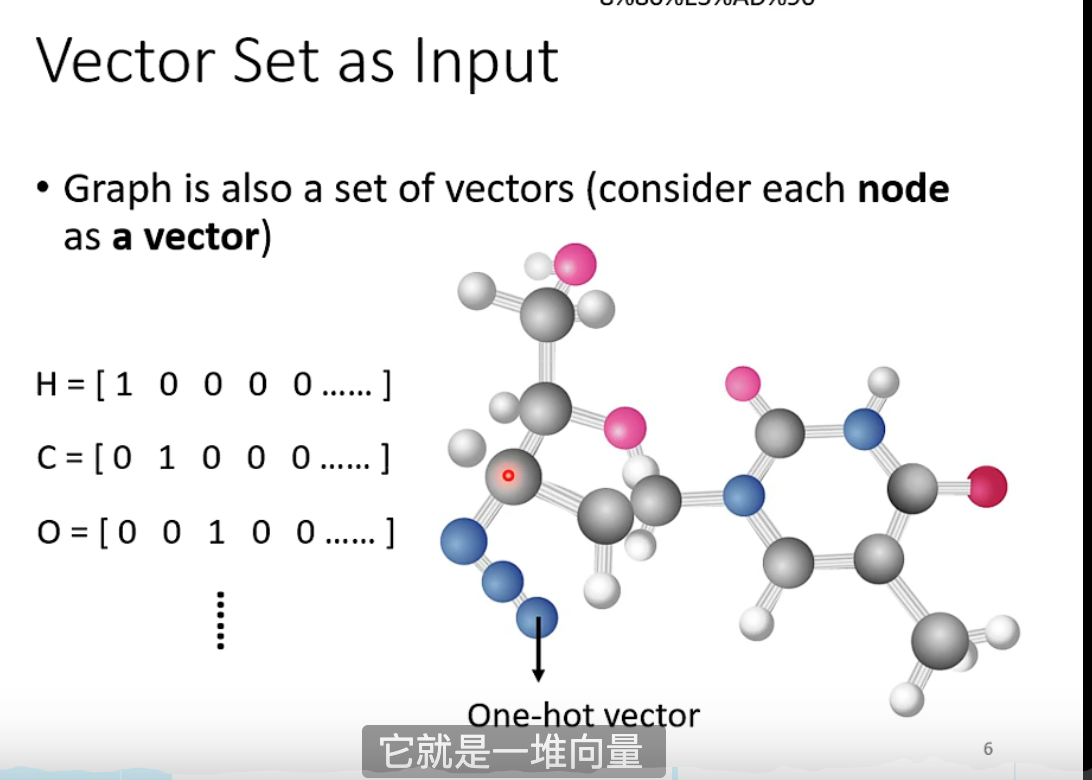

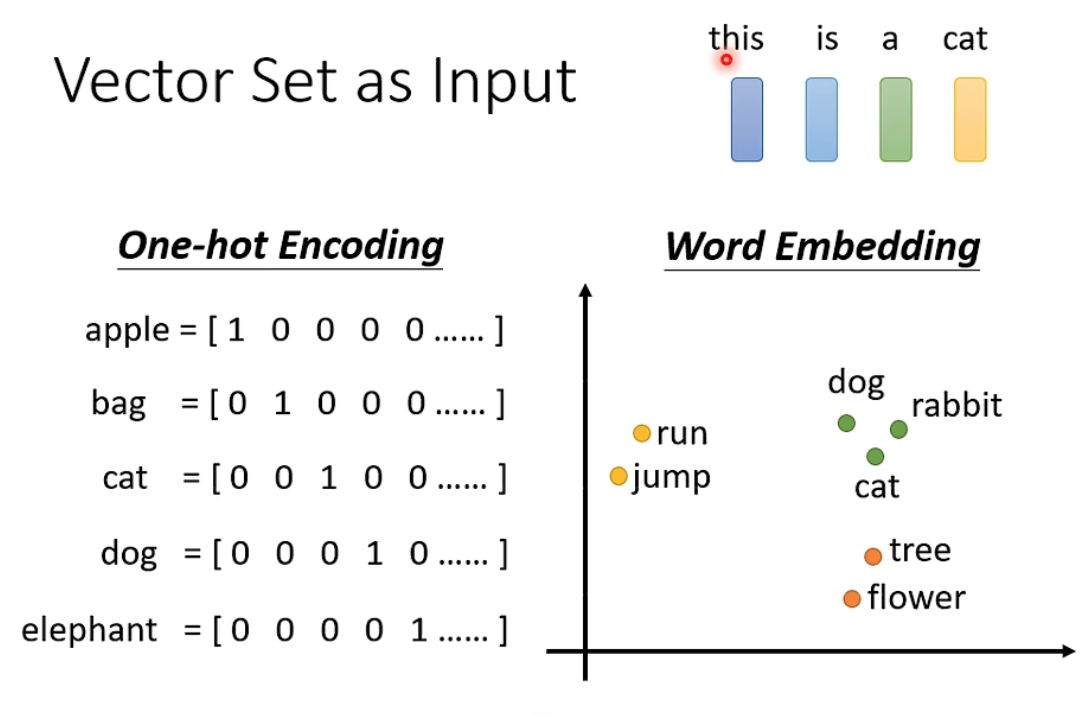

特殊情况:输入是不固定长的向量集合。

1.1 输入向量

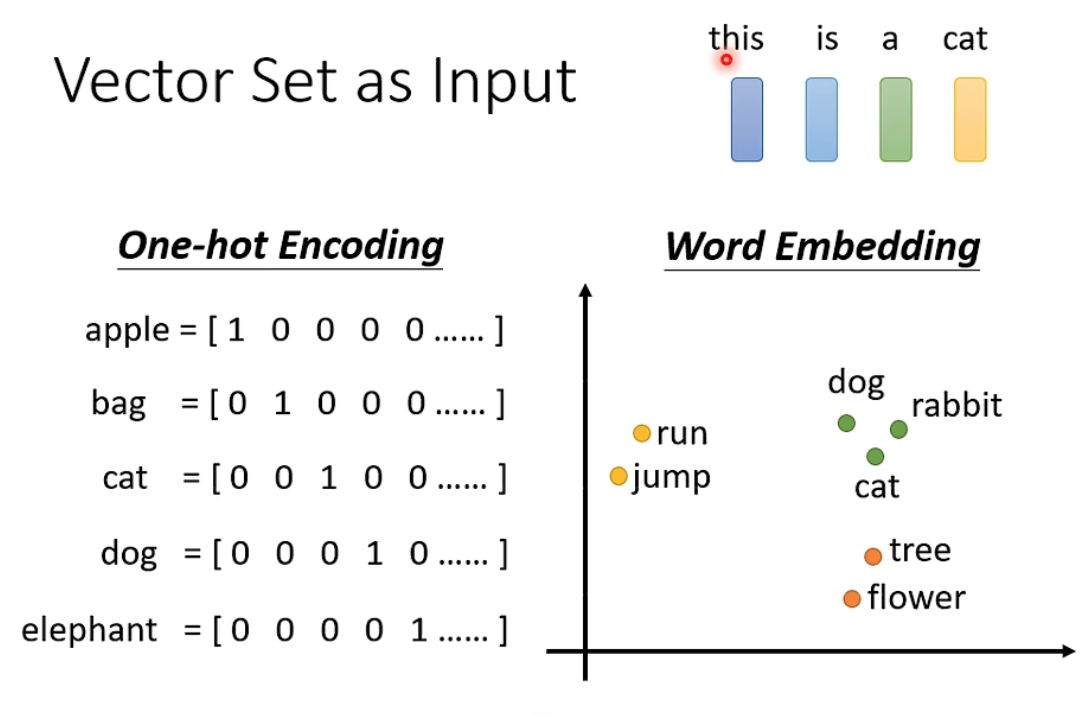

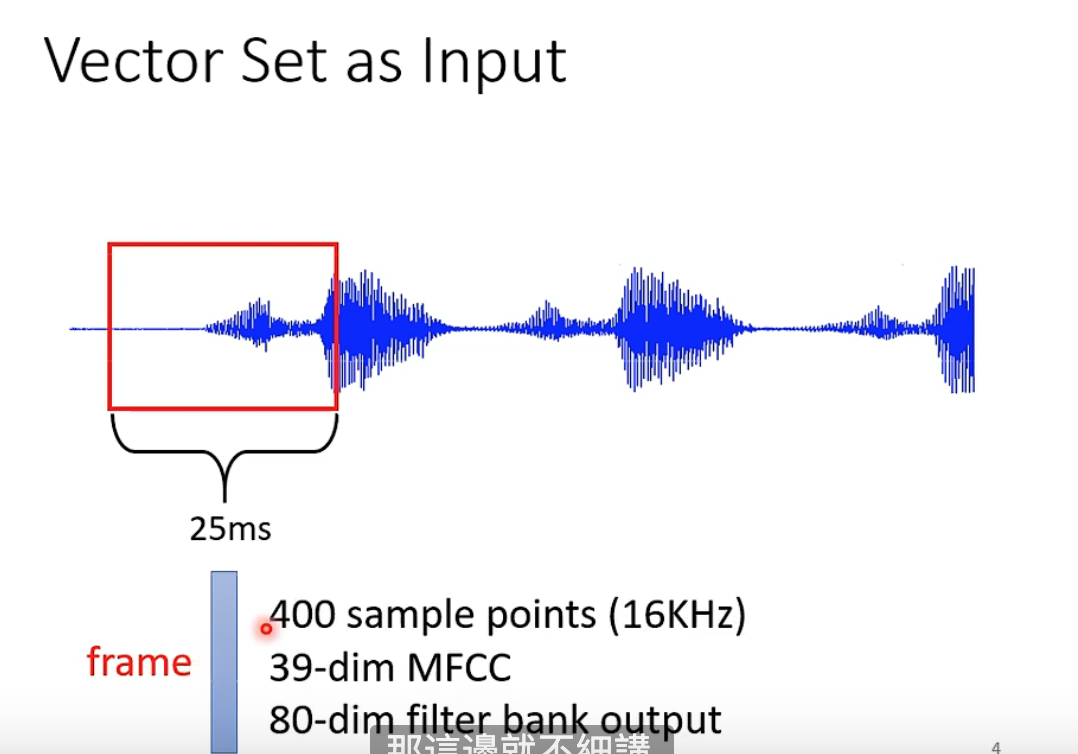

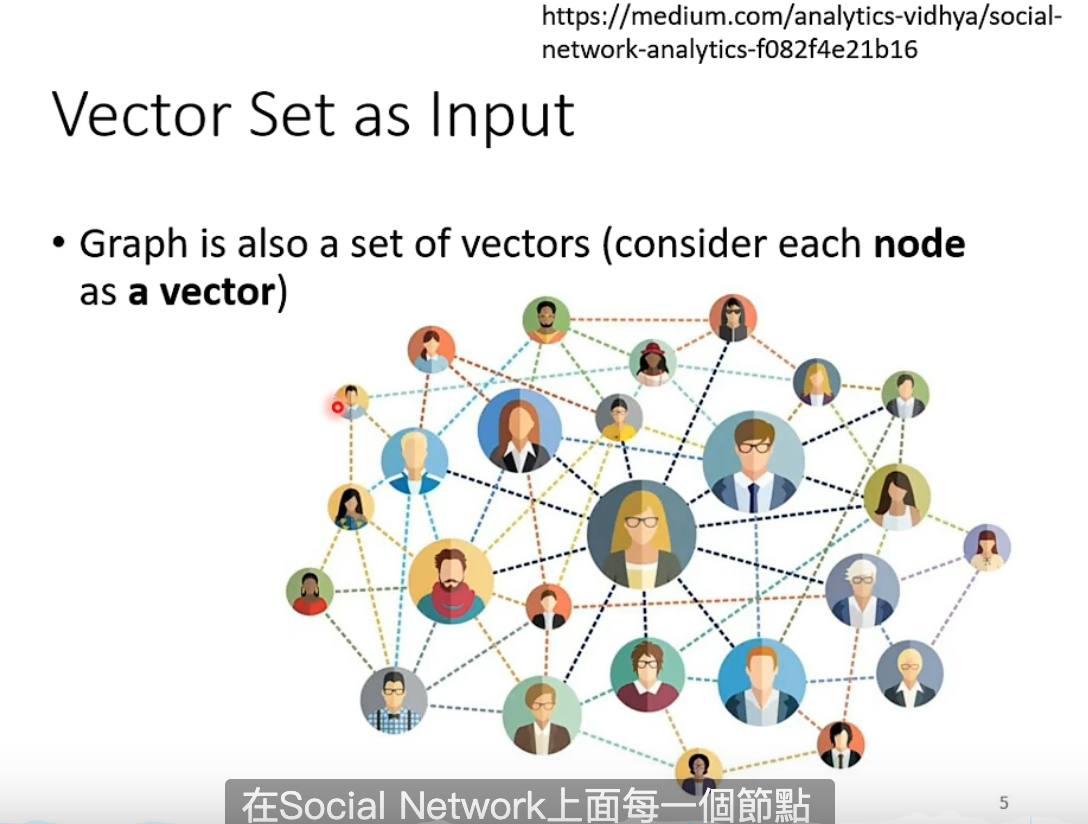

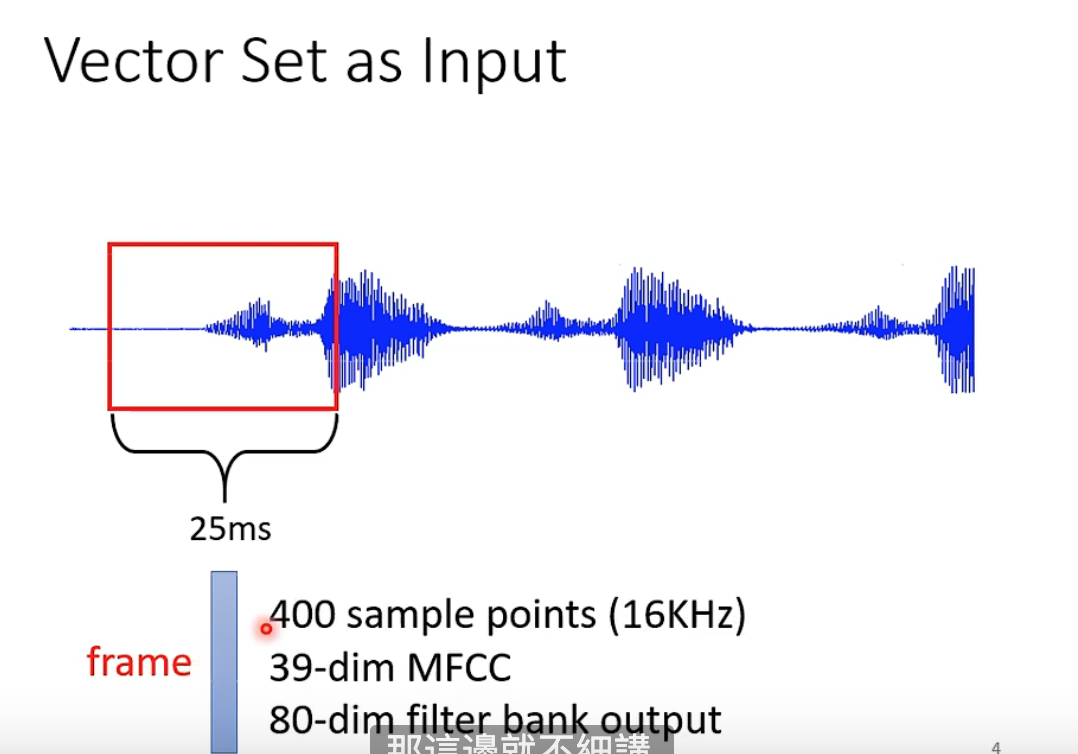

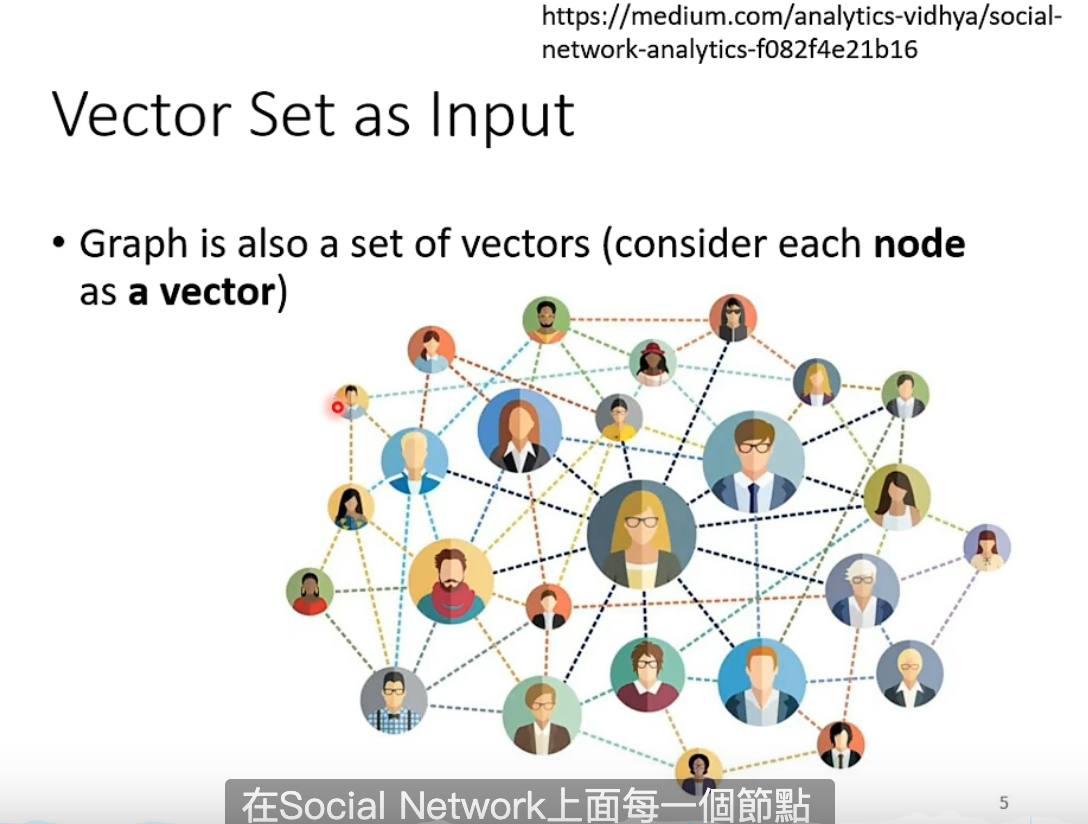

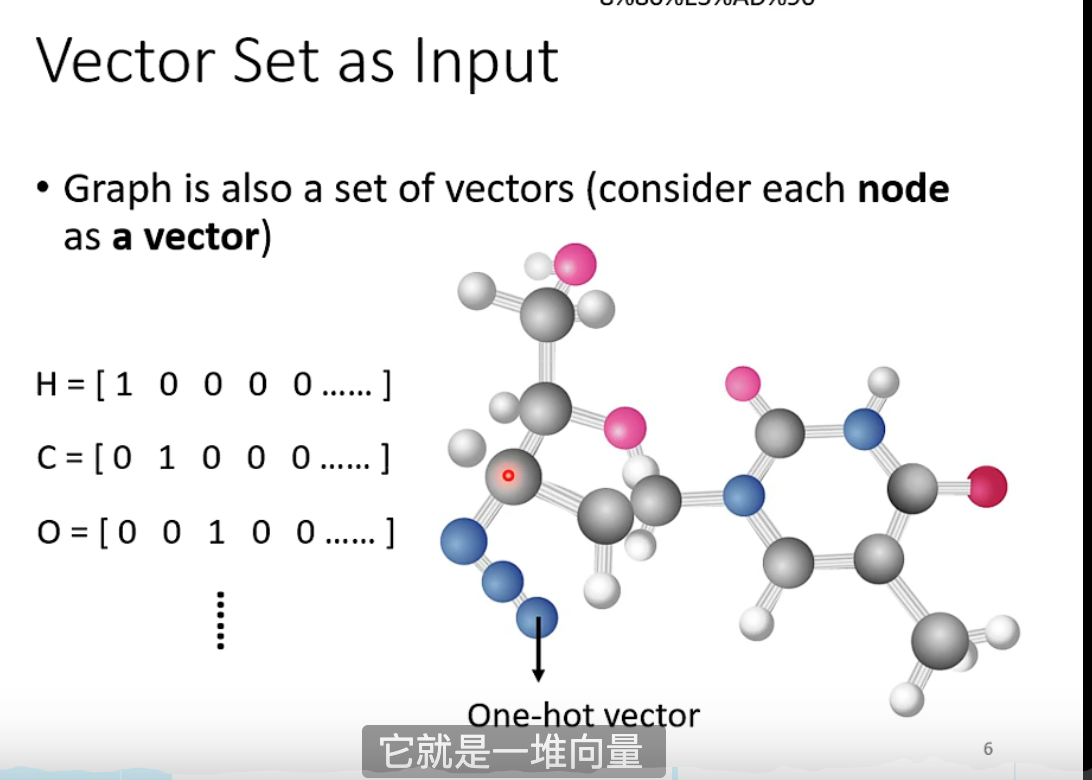

句子中词可以作为向量;声音;社交节点。

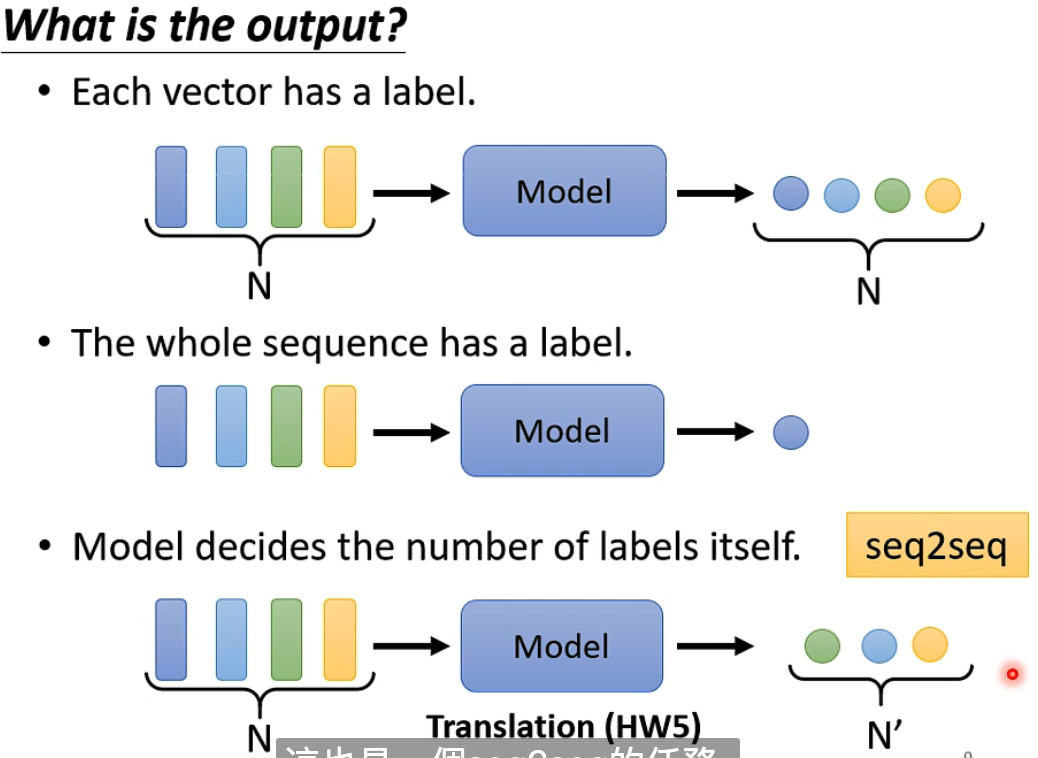

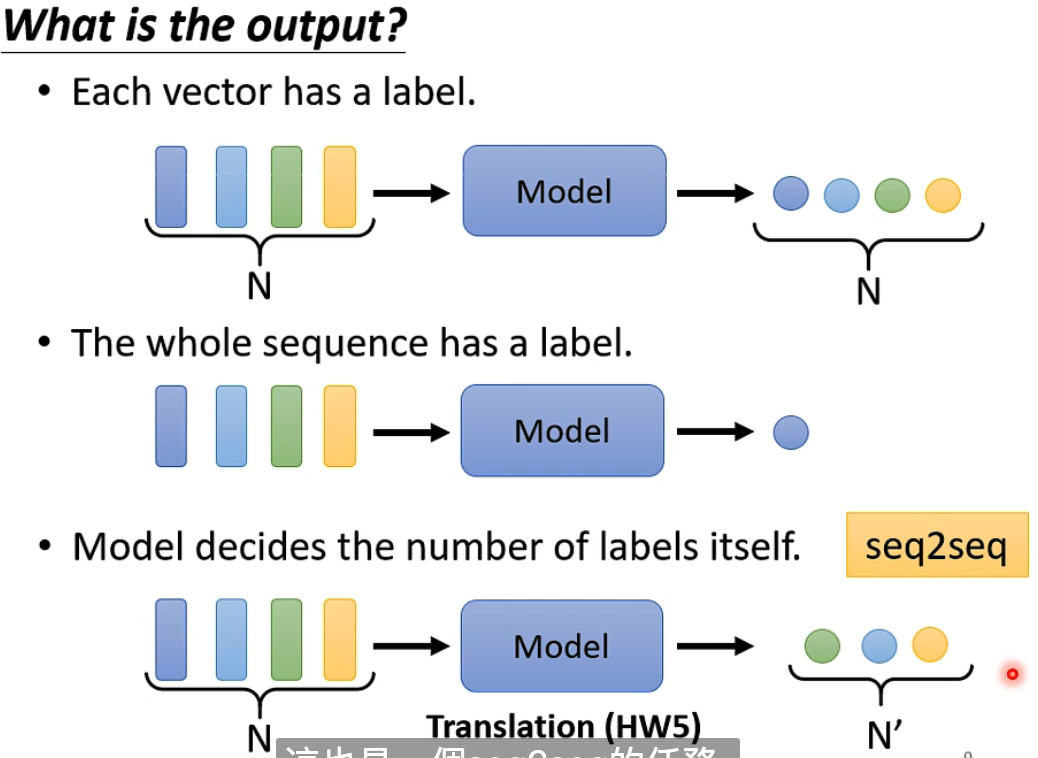

1.2 输出向量形式

https://www.bilibili.com/video/BV1Wv411h7kN?p=38

self-attention:和cnn一样,是一种架构。

常见情况:输入是固定长度的向量,输出是标量或类别。

特殊情况:输入是不固定长的向量集合。

句子中词可以作为向量;声音;社交节点。

让时间为你证明