什么是爬虫?

爬虫就是按照一定规则自动访问网络上的信息并把内容下载下来的程序或脚本。

爬虫可以做什么?

爬虫作为获取网络信息资源的程序,通过规则可以获取网站中具体数据信息。通过爬虫进行数据采集可以获得大量数据,进而进行数据分析。在日常工作中,常使用Python进行爬虫编写。

爬虫介绍

在Python中常用的爬虫工具包有:urlib,requests,selenium,beautifulsoup,xml,httpx等。

爬虫类型

- 通用爬虫:

从一个url扩展到整个web的爬虫。

- 聚焦爬虫:

针对特定需求,有选择性地爬取相关网站数据的爬虫。

- 增量式爬虫:

用来监测网站数据更新的情况,以便爬取到网站最新更新出来的数据(爬没爬过的数据)。

- 分布式爬虫:

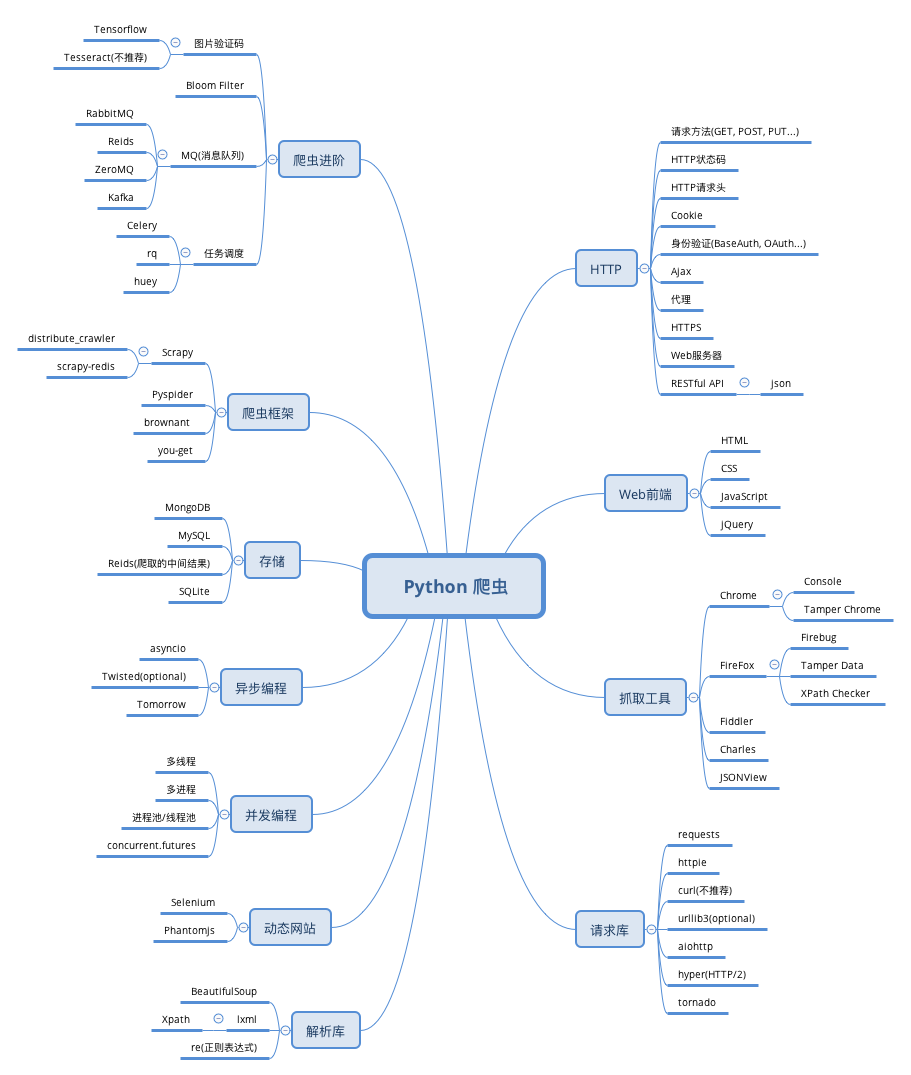

爬虫学习思维导图