问题设定

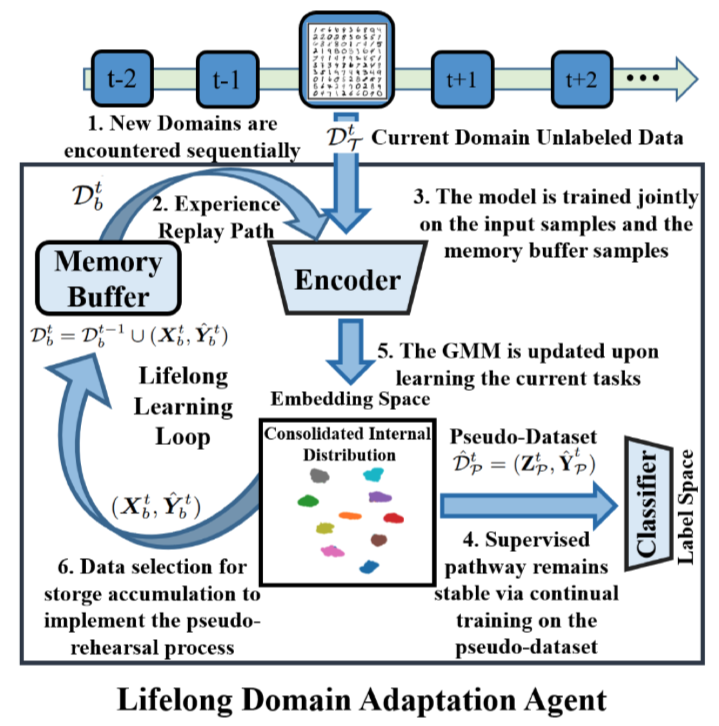

Unsupervised domain adaptation (UDA) 和 Continual Learning (CL) 相结合,利用无标记数据持续学习新任务的数据分布偏移,同时保持以往任务中的知识。UDA 可以解决数据分布偏移的问题,但是同时需要源域、目标域的数据,用于估计分布之间的距离;CL 则更多考虑数据中有标记的情况,使用标记来样本模型迁移到新的任务中。

初始化阶段,有来自源域的标记数据集,其中

。利用

%22%20aria-hidden%3D%22true%22%3E%0A%20%3Cuse%20xlink%3Ahref%3D%22%23E1-MJSCR-44%22%20x%3D%220%22%20y%3D%220%22%3E%3C%2Fuse%3E%0A%20%3Cuse%20transform%3D%22scale(0.707)%22%20xlink%3Ahref%3D%22%23E1-MJSCR-53%22%20x%3D%221095%22%20y%3D%22-222%22%3E%3C%2Fuse%3E%0A%3C%2Fg%3E%0A%3C%2Fsvg%3E#card=math&code=%5Cmathcal%7BD%7D%7B%5Cmathcal%7BS%7D%7D&id=FNGeK)训练一个初始化分类模型 。

随后的 个时刻中,将会有若干个仅包含无标记数据的任务

相继到来:满足 。

模型需要能够在每个时刻中,利用无监督数据集 进行迭代在目标域上泛化性能良好。

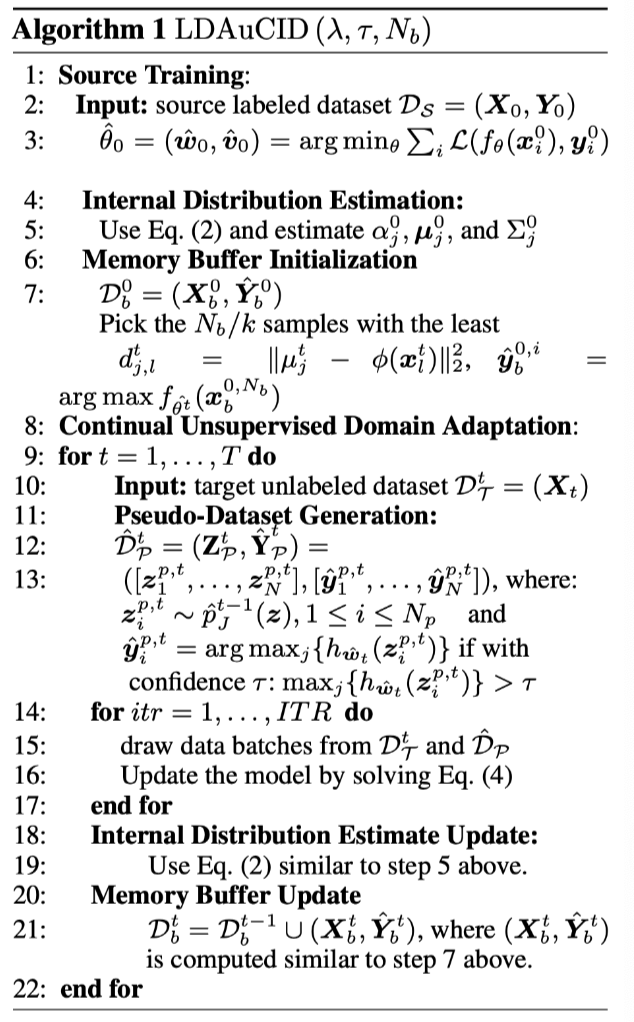

所提方法

表示刻画表示分布

利用源域数据学习一个%22%20aria-hidden%3D%22true%22%3E%0A%20%3Cuse%20xlink%3Ahref%3D%22%23E1-MJSCR-44%22%20x%3D%220%22%20y%3D%220%22%3E%3C%2Fuse%3E%0A%20%3Cuse%20transform%3D%22scale(0.707)%22%20xlink%3Ahref%3D%22%23E1-MJSCR-53%22%20x%3D%221095%22%20y%3D%22-222%22%3E%3C%2Fuse%3E%0A%3C%2Fg%3E%0A%3C%2Fsvg%3E#card=math&code=%5Cmathcal%7BD%7D%7B%5Cmathcal%7BS%7D%7D&id=tTEJk)学习一个能够较好区分类别的特征表示,然后使用一个拥有

个部分的 GMM 对特征表示进行拟合(每个类别都是用一个高斯分布来拟合):

表示更新与分类器巩固

在任意后续时刻 ,将

定义为此时刻估计得到的 GMM,从总采样得到高维特征与伪标记组成的数据集

,其中:

做两件事:(1) 使分类器在采样数据集中保持泛化能力 (2) 优化表示,拉近新任务的数据分布与已有GMM数据分布之间的距离:

克服灾难性遗忘

其中,为了克服灾难性遗忘,还加入了一个缓存用来存储已见任务的数据,并且在缓存上优化相同事情:

伪代码

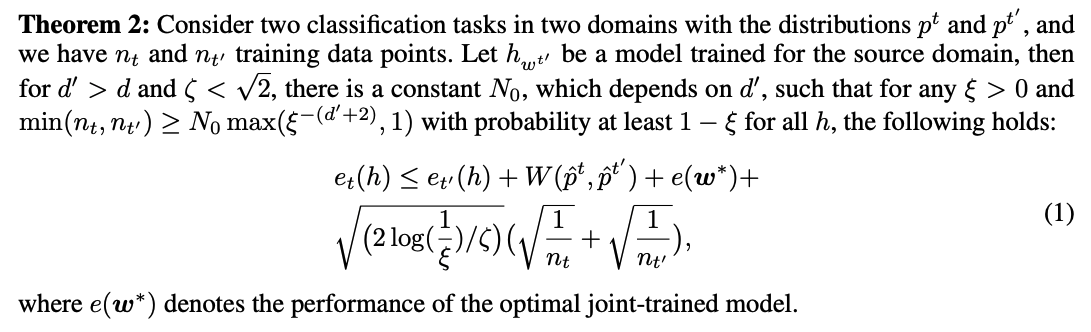

理论分析

理论分析是关于模型在以往任务上的性能,比较偏向于 Continual Learning。利用了 Domain Adaptation 里的一个理论辅助证明了当模型泛化到目标域时,旧任务上的性能有一定的保证。