grpc-go 中如下连接服务器,请求将在多个IP之间轮转。

conn, err := grpc.Dial("dns:///rng-headless:8081",grpc.WithBalancerName(roundrobin.Name),grpc.WithInsecure())

标准的目标名应该是这样的:”dns://authority/endpoint_name”,此处 authority 为空,详见:https://github.com/grpc/grpc/blob/master/doc/naming.md

服务器开3个实例,所有请求在3个实例上轮转:

[jinqing@host-10-2-3-4 RoundRobin]$ kubectl run -it --rm jinqing-roundrobin --image=jinq0123/roundrobin:4If you don't see a command prompt, try pressing enter.2018/08/28 10:18:01 request 77543835766365665592018/08/28 10:18:02 request 25438765992196757462018/08/28 10:18:03 request 9272042619371812132018/08/28 10:18:04 request 77543835766365665592018/08/28 10:18:05 request 25438765992196757462018/08/28 10:18:06 request 927204261937181213...

服务器返回一个随机数,不同实例的随机数不同。代码是从https://github.com/kcollasarundell/balancing-on-k8s修改的。

...const (port = ":8081")type server struct{}var r int64func init(){rand.Seed(time.Now().UnixNano())r = rand.Int63()}func (s *server) Rng(context.Context, *rng.Source) (*rng.RN, error) {return &rng.RN{RN: r}, nil}func main() {lis, err := net.Listen("tcp", port)if err != nil {log.Fatalf("failed to listen: %v", err)}s := grpc.NewServer()rng.RegisterRngServer(s, &server{})// Register reflection service on gRPC server.reflection.Register(s)if err := s.Serve(lis); err != nil {log.Fatalf("failed to serve: %v", err)}}

先编译,打包成镜像,然后用balancing-on-k8s\backend\kube.yaml运行:

kubectl apply -f kube.yaml

backend\kube.yaml创建了一个 ClusterIP 服务和一个 Headless 服务,部署了 3 个服务器实例。

[jinqing@host-10-2-3-4 RoundRobin]$ kubectl get svcNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGEkubernetes ClusterIP 10.96.0.1 <none> 443/TCP 93drng-cluster ClusterIP 10.111.30.205 <none> 8081/TCP 4hrng-headless ClusterIP None <none> 8081/TCP,8080/TCP 4h

客户端是一个简单的grpc, 定时发送请求,打印返回的随机数。balancing-on-k8s\clientSideBalancer\RoundRobin\main.go中的地址需要添加端口,不然grpc会去连接 443 端口而失败。

扩容后,测到大概3分钟后才看到负载转移。缩容后会立即生效。

kubectl scale --replicas=5 deployment/rng

如果去除 “dns:///”, 仅仅是域名加端口:

conn, err := grpc.Dial("rng-headless:8081",grpc.WithBalancerName(roundrobin.Name),...

则只会请求同一个实例。只有当该实例pod被删除后才会切换到另一个实例。

以上转自:https://blog.csdn.net/jq0123/article/details/82179864

实际:经过测试,并没负载转移,可能是版本问题?例如:从1台扩容到3台,只要最开始连的那一台掉线,才会触发一次dns解析

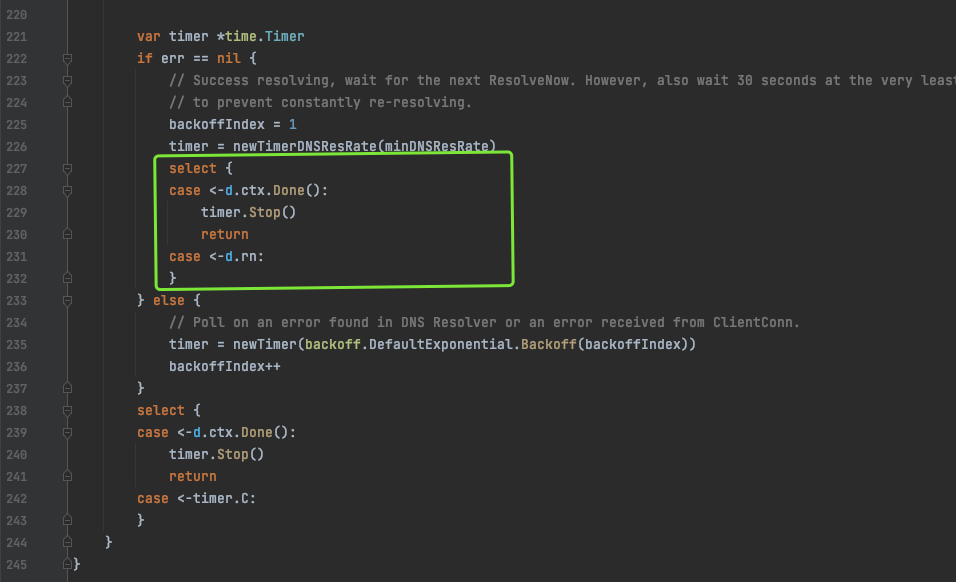

代码位置 :grpc@v1.40.0/internal/resolver/dns/dns_resolver.go:209

验证结果:解析成功后,代码会卡在这里,只有内部连接池里面有任意一条连接断掉,才会重新触发dns解析

强迫症表示无法接受该方案!

那我们换一种思路,自己手动写一个解析器,监听dns,只要dns发生了变化,立马更新连接,就如etcd实现的负载均衡一样。解决方案:kuberesolver

// Import the moduleimport "github.com/sercand/kuberesolver/v3"// Register kuberesolver to grpc before calling grpc.Dialkuberesolver.RegisterInCluster()// if schema is 'kubernetes' then grpc will use kuberesolver to resolve addressescc, err := grpc.Dial("kubernetes:///service.namespace:portname", opts...)