一、安装

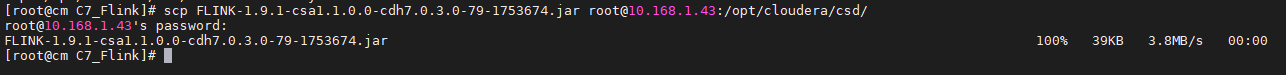

准备Flink1.9.1的csd文件,并放置到Cloudera Manager Server服务器的/opt/cloudera/csd目录下,然后重启Cloudera Manager Server服务

cp a bsystemctl restart cloudera-scm-server

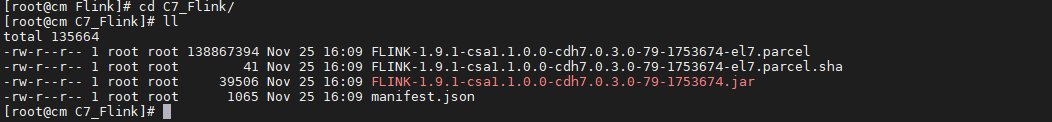

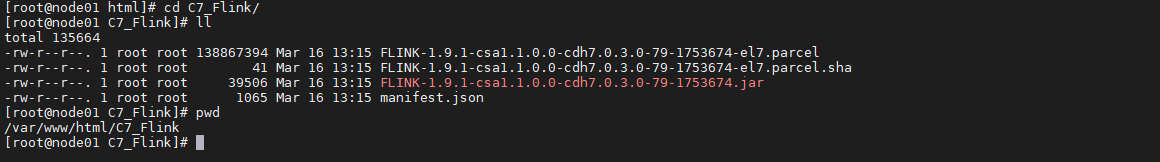

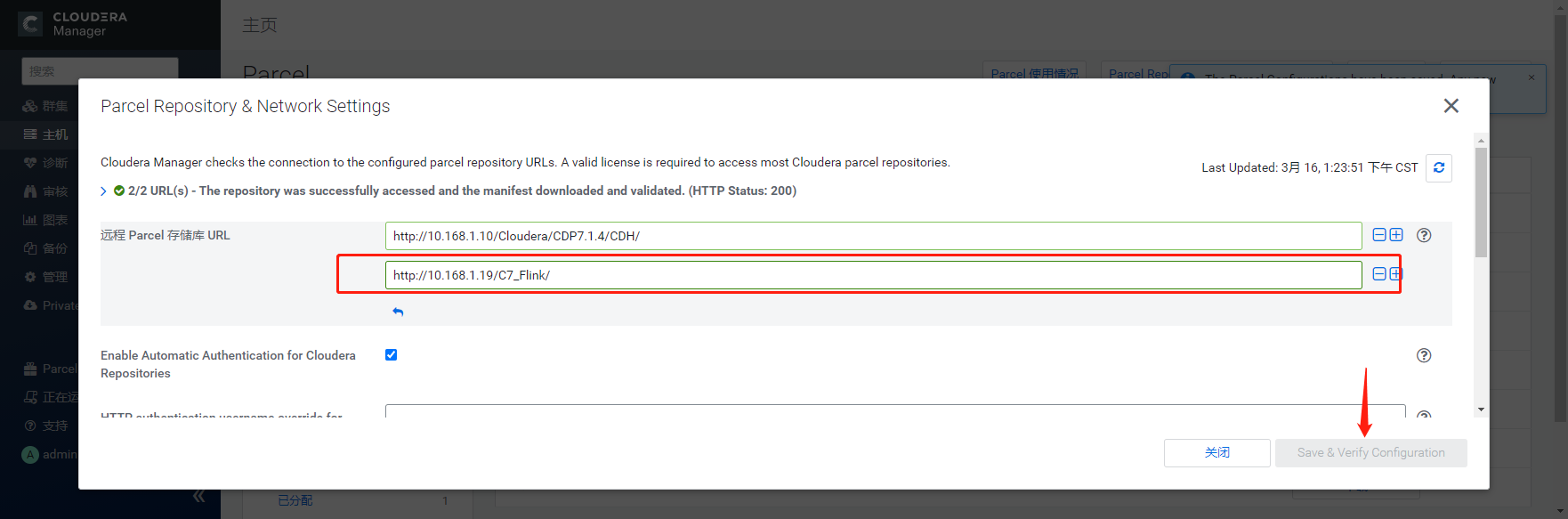

下载Flink1.9.1的Parcel并部署到httpd服务的/var/www/html/C7_Flink目录下

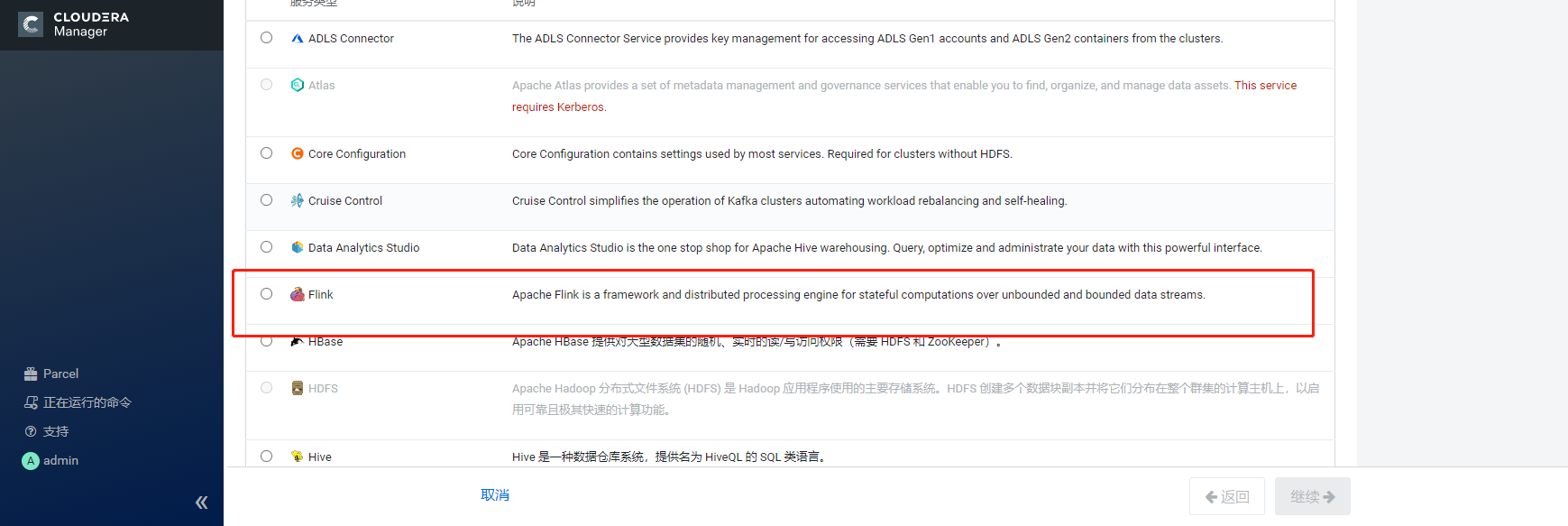

- CM重启完成以后,添加服务页面可以看到有Flink服务

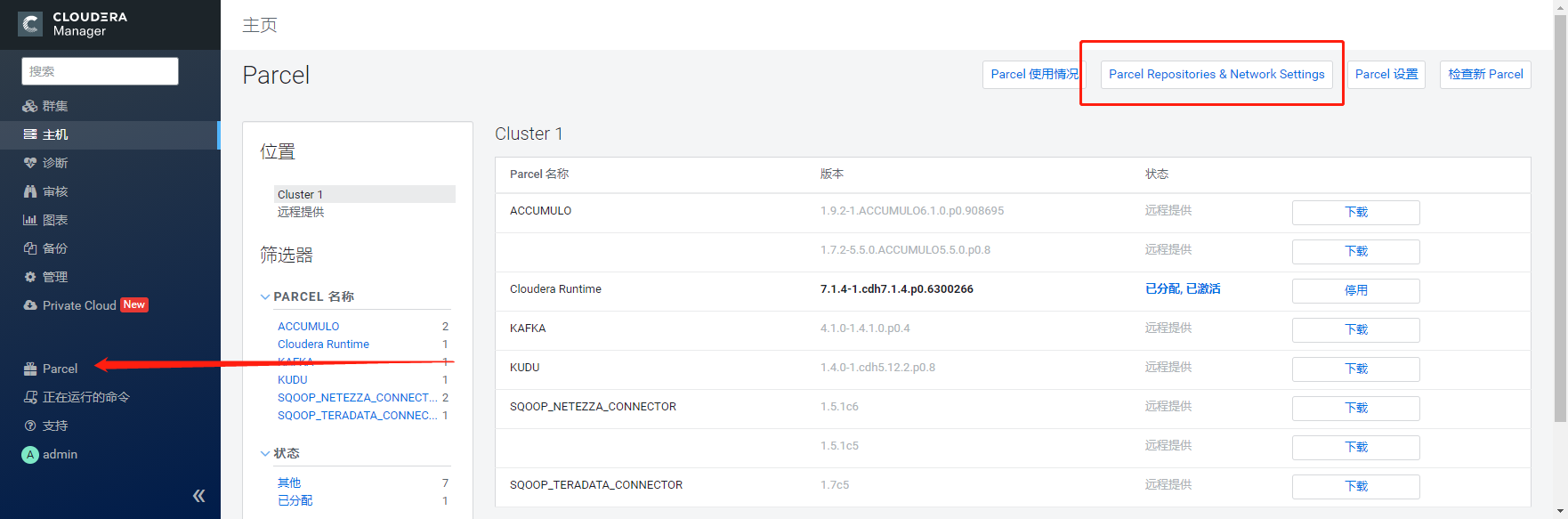

- 登录CM,在左侧菜单栏点击“Parcel”按钮,进入Parcles管理界面进行配置,点击“Parcel Repositories & Network Settings”菜单配置Flink的本地parcel库

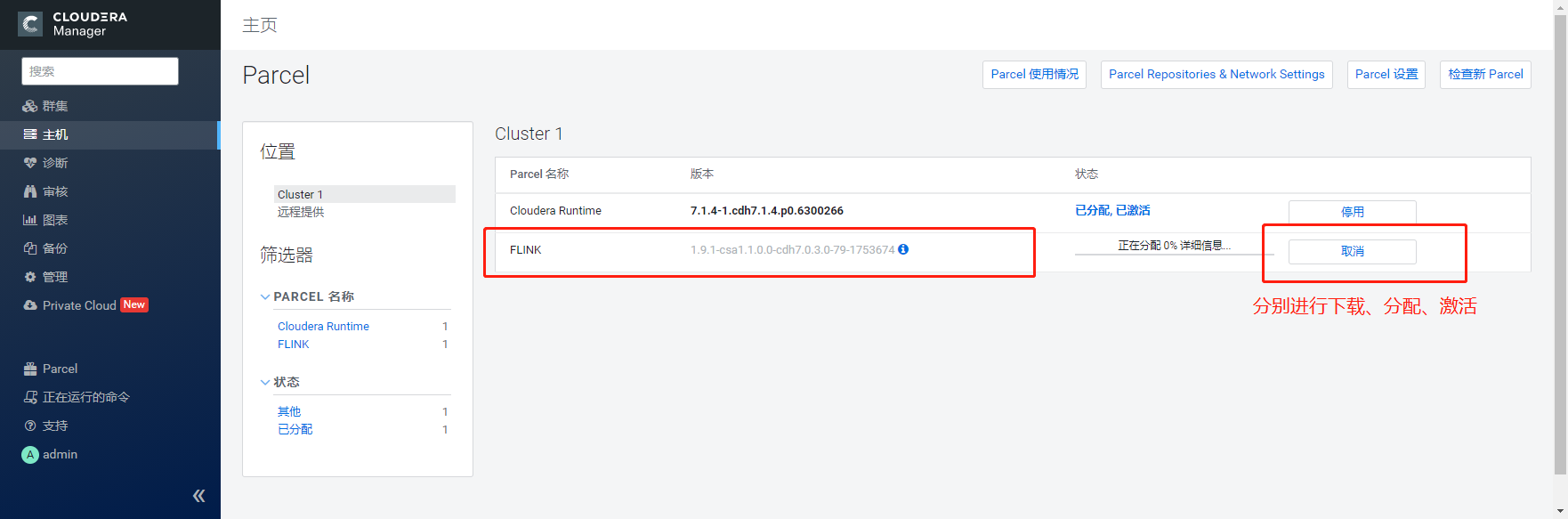

- 完成配置后,点击“Save & Verify Configuration”,关闭配置配置界面可以看到Flink的信息

- 分别进行 “下载、分配、激活”操作,完成后显示如下:

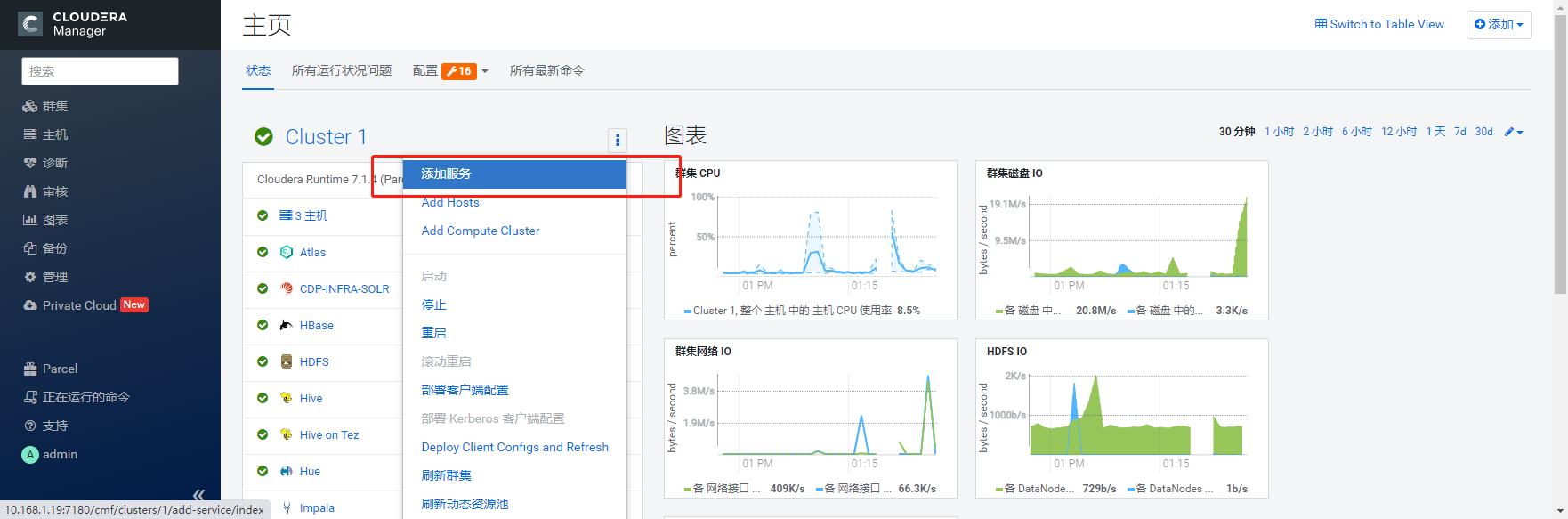

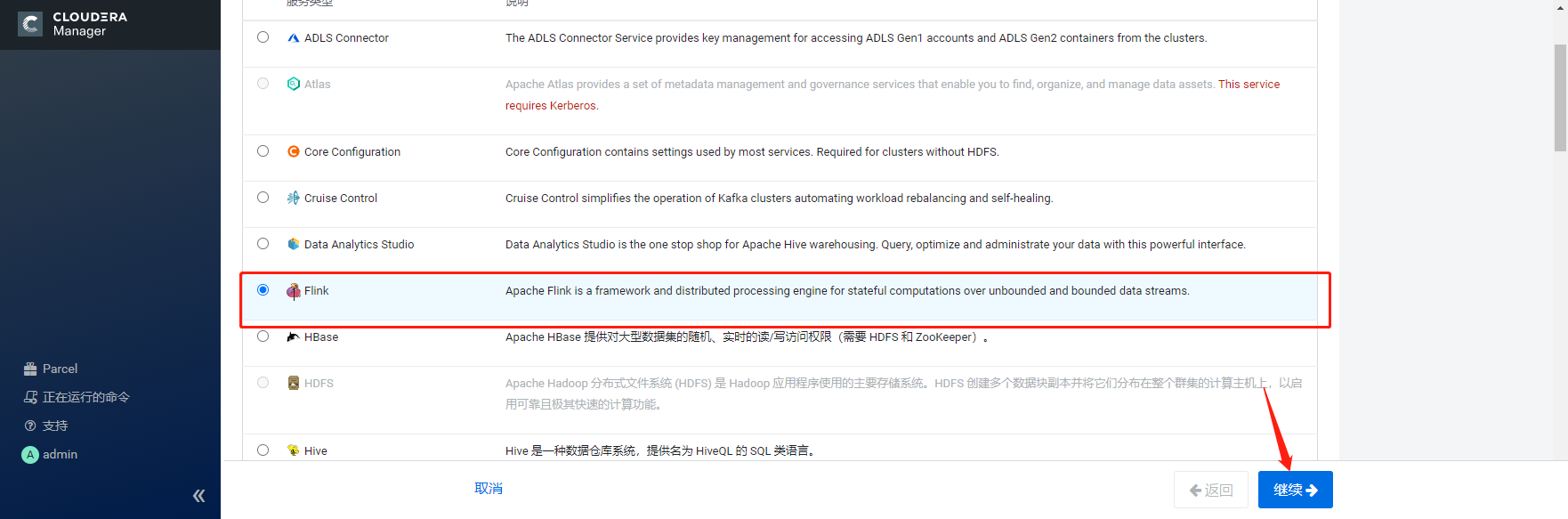

- 进入CM主页点击“添加服务”。

- 选择Flink History Server以及Gateway节点,点击继续

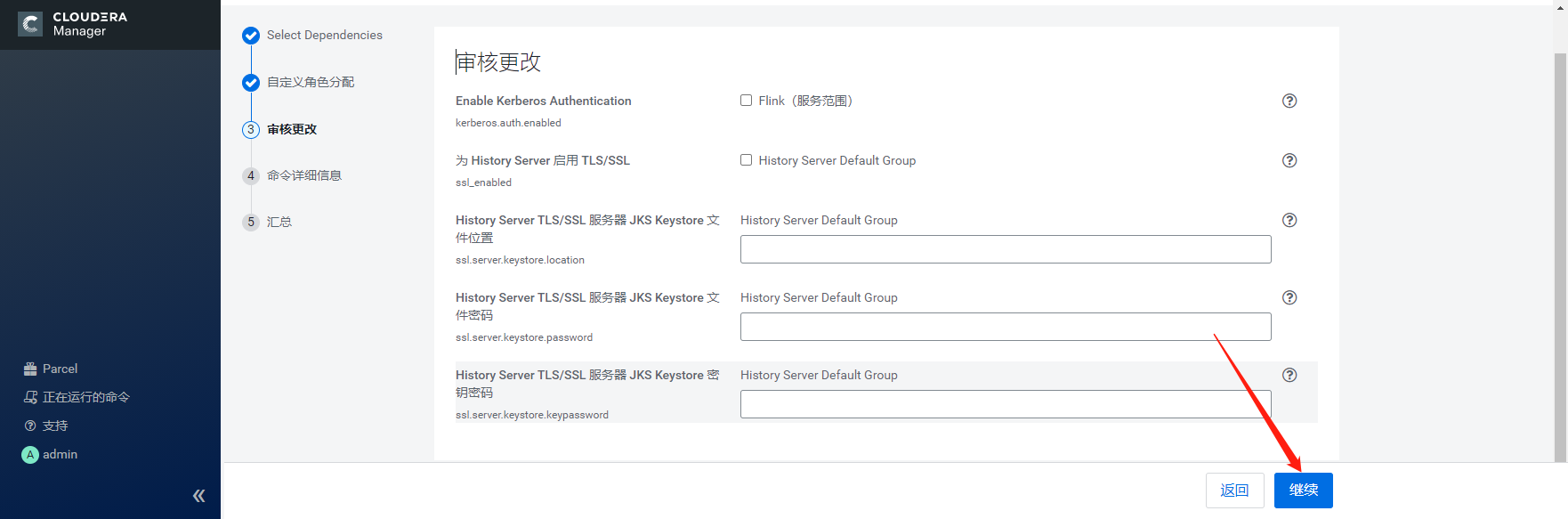

- 点击继续

- 等待Flink History Server启动成功,完成后点击继续

- 安装完成,点击完成回到CM主页,发现Flink的状态为灰色,CMS有重启提示,按照提示重启CMS服务,重启过程略。重启完成后显示Flink服务正常。

二、测试

1.执行Flink自带的example的wordcount例子。

2.查看输出结果。

3.在YARN和Flink的界面上分别都能看到这个任务。

四、问题

参考:https://ci.apache.org/projects/flink/flink-docs-release-1.8/release-notes/flink-1.8.html

参考:https://issues.apache.org/jira/browse/FLINK-11266

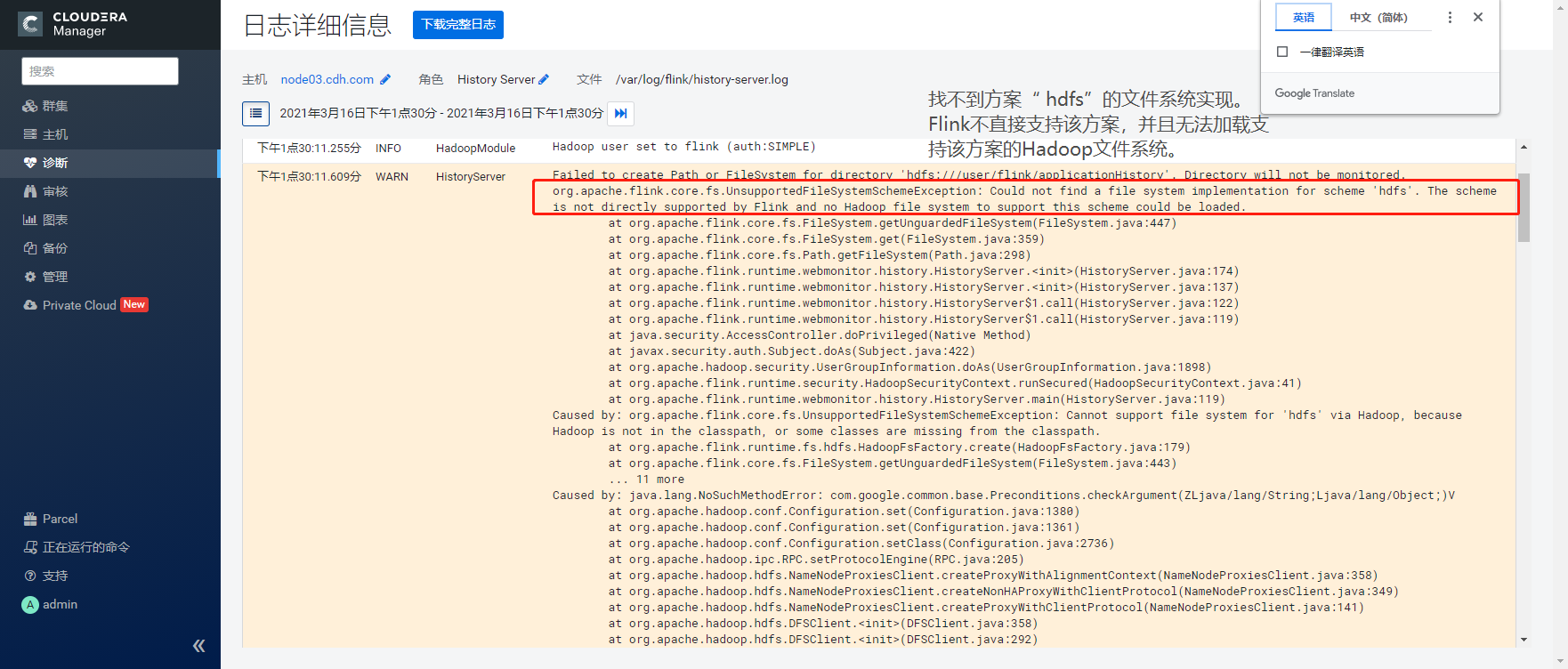

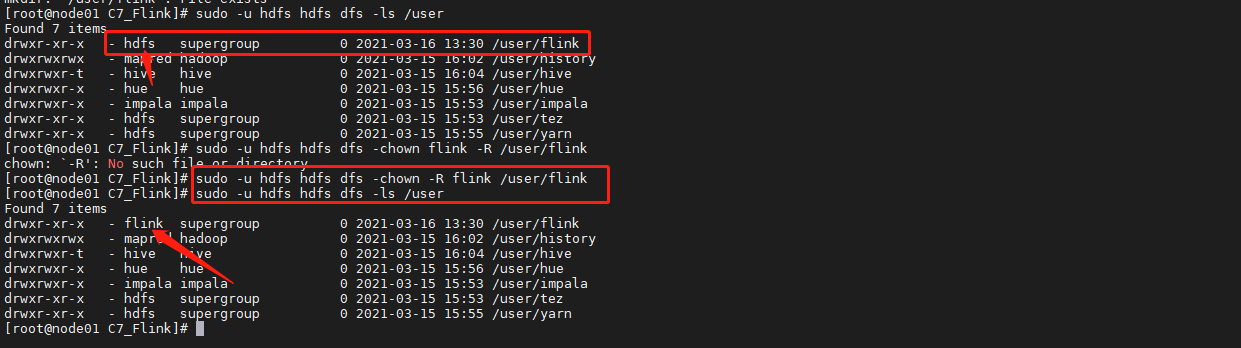

- Flink启动

- 原因:如果要操作hdfs的话,必须要在flink安装目录的 lib 下加上额外的jar包,所以这里原因就是在flink集群的CLASS_PATH下缺少了 HDFS相关的ja

jar包下载地址:

https://repo.maven.apache.org/maven2/org/apache/flink/flink-shaded-hadoop-2-uber/2.7.5-7.0/flink-shaded-hadoop-2-uber-2.7.5-7.0.jar

-

三、总结

在CDP DC上基于Parcel的方式安装Flink1.9.1与CDH5和CDH6集群下安装Kafka、Spark等服务方式一致。

- 对于CDP DC中不自带的服务需要将csd添加的CM节点的/opt/cloudera/csd目录下,并重启cloudera-scm-server服务。

- Flink是依赖Yarn、HDFS、Zookeeper服务运行,所以在CDP DC集群中至少要确保这个几个服务都已安装。