1.涉及的基本组件技术

Hadoop:HDFS MapReduce(清洗) YARN、需要部署Hadoop集群 Hive:外部表、SQL 、解决数据倾斜 、sql优化、基于元数据管理、SQL 到MR过程 Flume:将数据抽取到hdfs 调度:crontab、shell、Azkaban HUE:可视化的notebook,CM自带 ,排查数据

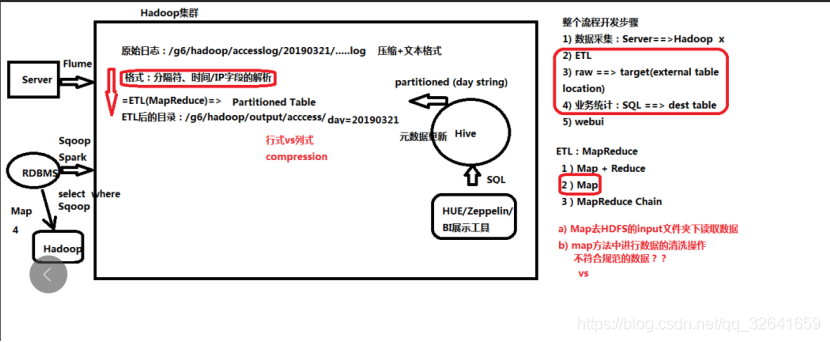

2.处理流程

大数据开发:关注的是2、3、4步骤。1,2,3都是属于ETL步骤,但是1可能是早就有的任务。

步骤1:使用flume/logstash抽取服务器上的日志数据以及使用sqoop/spark抽取关系型数据库的数据将数据抽取到hdfs(压缩+普通文本格式)。

步骤2:将hdfs上数据通过(MR/Spark/Flink)清洗处理后存放数仓(hive),此时

步骤3:将原始的数据放到目标位置,hive的外部表

步骤4:业务计算 将结果放到,业务表(数据集市)

步骤5:应用程序查询访问,我们这儿可通过HUE查看信息

备注1:HUE是个非常强大且方便的可视化界面。在界面能操作hadoop生态圈的组件以及查询 查询组件显示信息。使用场景:排查数据

备注2: zeppelin和HUE较类似的一个工具,但是比HUE好用,目前市场主流是以改zeppelin源码去做自己的可视化界面。

备注3:步骤2、3、4,的数据落地hdfs时,数据压缩格式、数据的存储格式选择很重要