前言

在 C 站(NSFW 警告)上我们可以看到 UP 主们上传了非常多的优质 AI 模型以及示例生成图,以及用户自身使用这些模型生成的图。当我们浏览到自己比较中意的图时,想要在本地复刻出图的效果的时候就需要了解这张图的生成配置。

查看配置

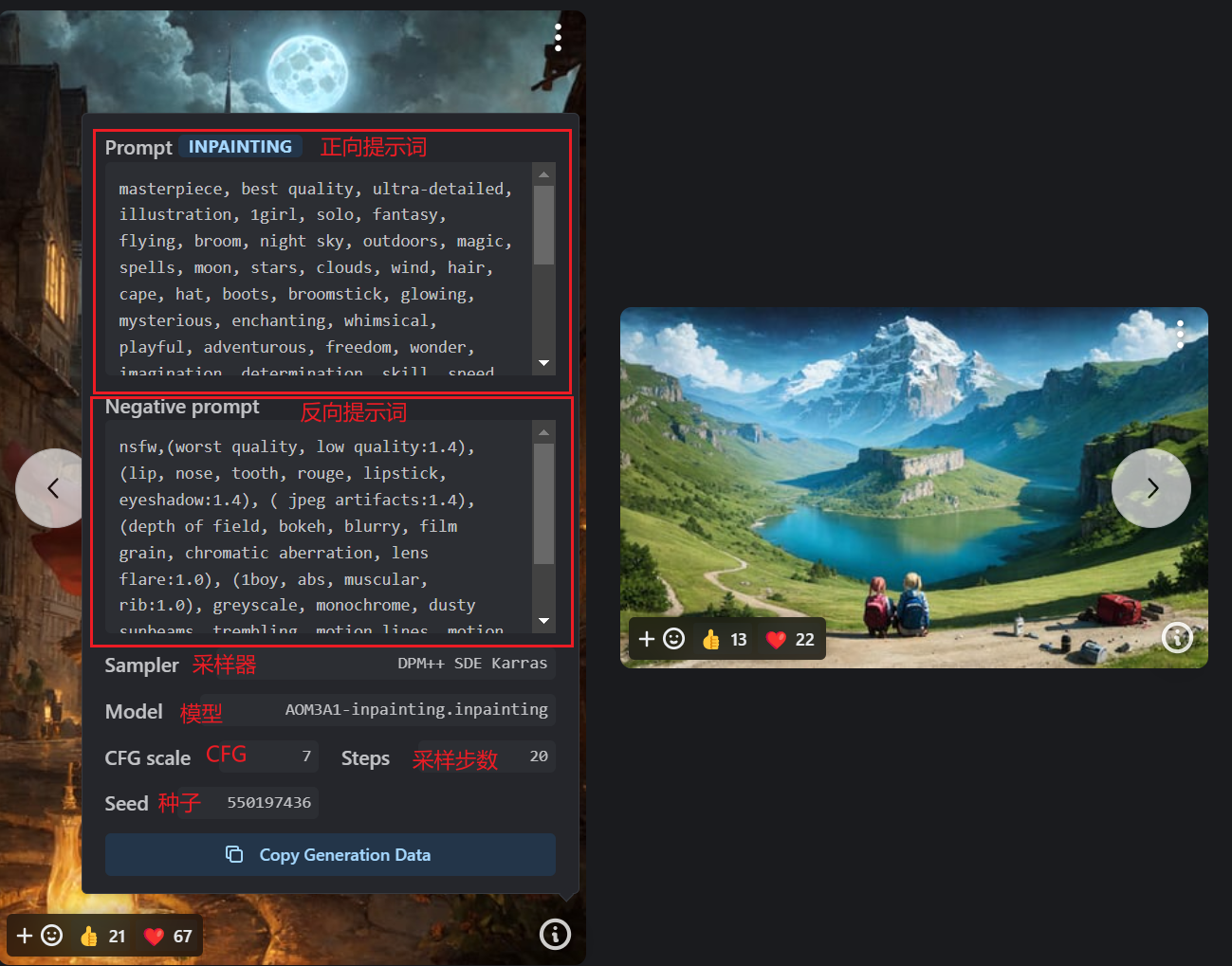

大多数情况下你可以在在图片的右下角看到有个信息框:

点开后可以看到生成这张图所用的正向提示词,反向提示词,采样器,模型,采样步数,种子,CFG scale 值等。

手动配置

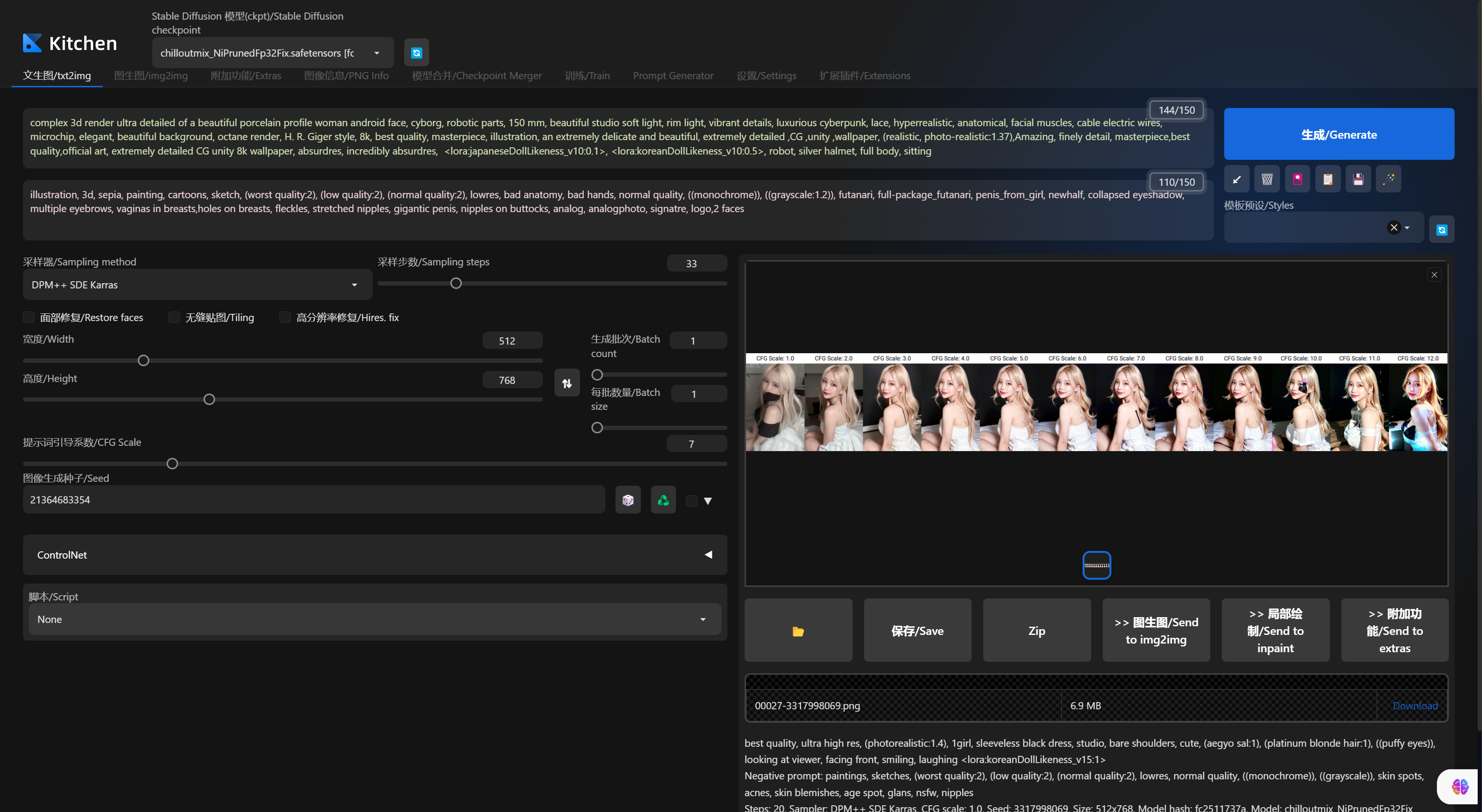

手动配置即手动将这些配置输入到 stable-diffusion-webui 的相应配置中,这种方式是最直观最简单的的应用配置方式。缺点是需要自己手动复制粘贴的次数多,且一些高级配置不会列在这个信息框中所以即使你按照信息框中的配置也不是完全的配置。

自动生成数据

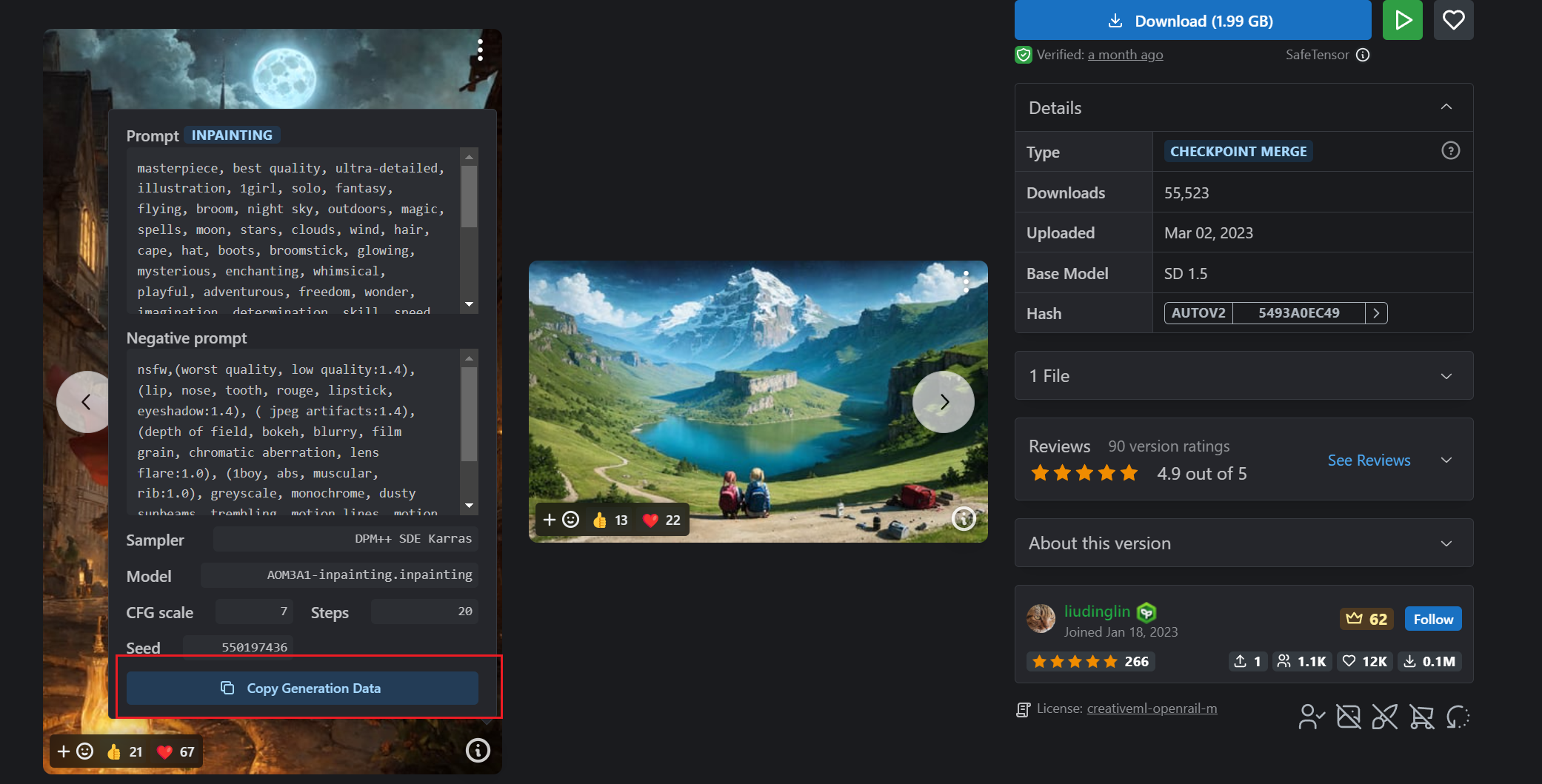

仔细看信息框下面可以复制生成数据,点击后将数据粘贴到正向提示词中。

然后点击“生成按钮”下面的箭头。

可以看到 webui 会自动将配置应用到下面的生成器中,这种方式即使是没有列出的配置也会应用在 webui 中,方便且精确

常见问题

1. 为什么复制数据之后生成的图片和原片完全不同?

效果不同可能包含以下几个原因:

- 提示词中可能包含 lora,embedding 等模型的提示词,可以检查一下正反提示词中是否包含你本地没有的插件。

- 即使这些模型有,但这些插件的版本和名称可能与作者的不相同也会导致效果不同,webui 是根据名称去定位模型的。

- 机器本身的配置不同,也会导致效果有差异。

2. 如何提高和原片的相似程度

可以使用 ControlNet 来控制画面,我们来看一组对,:

当我使用 ControlNet 将原图作为输入使用 depth 深度算法生成时,可以看到已经相当接近原片了,可惜 AI 将椅子当成了衣服在渲染。