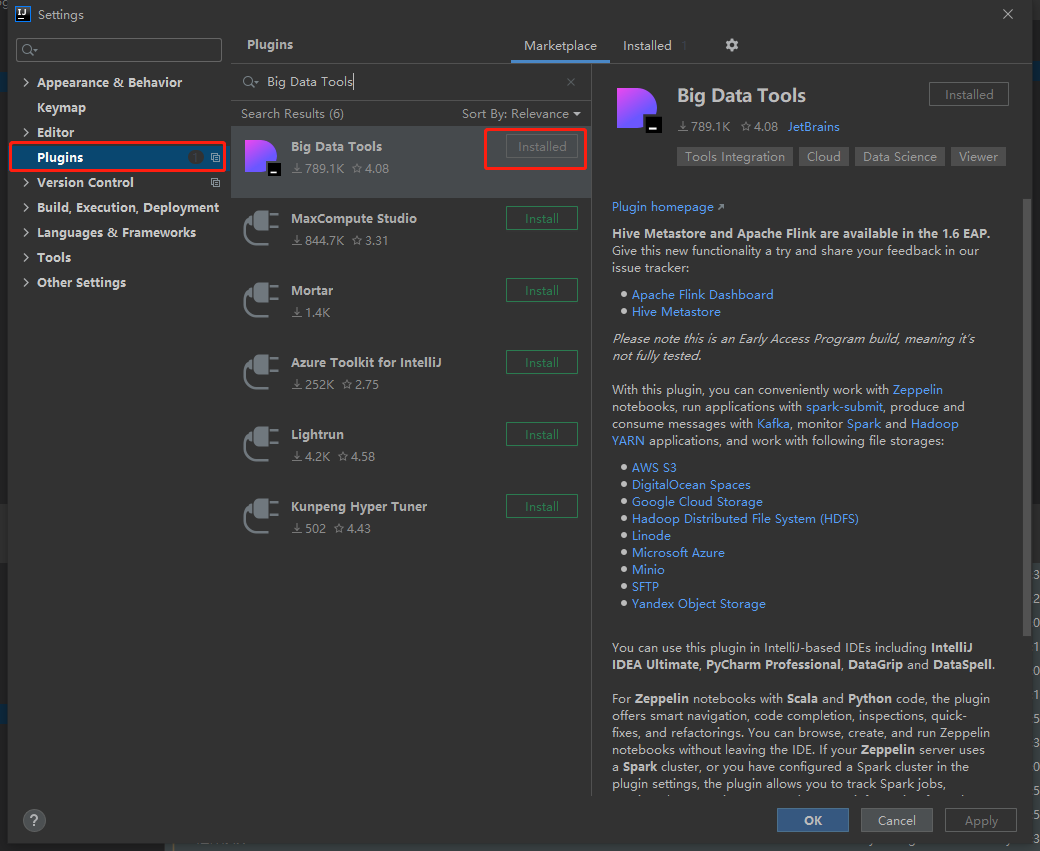

1.在IDEA中下载BigDataTools插件

(1)在File中找到Setting选项,点击进入

(2)在左侧菜单找到Plugins,在上方搜索框输入Big Data Tools,然后点击Install

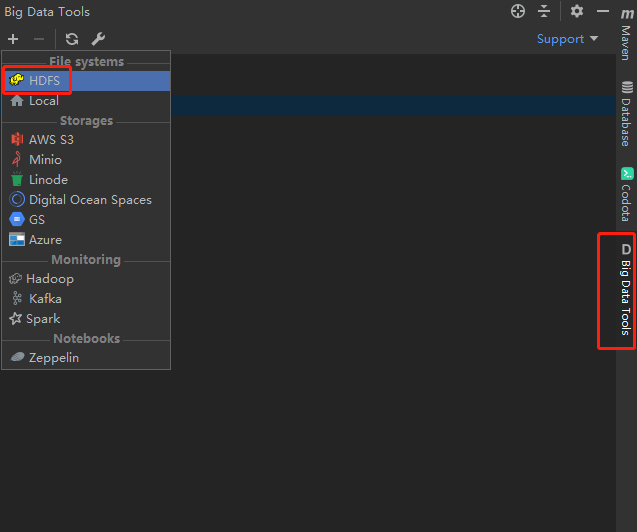

(3)安装完成后,你的右侧就有了该插件,然后我们新增一个HDFS的链接

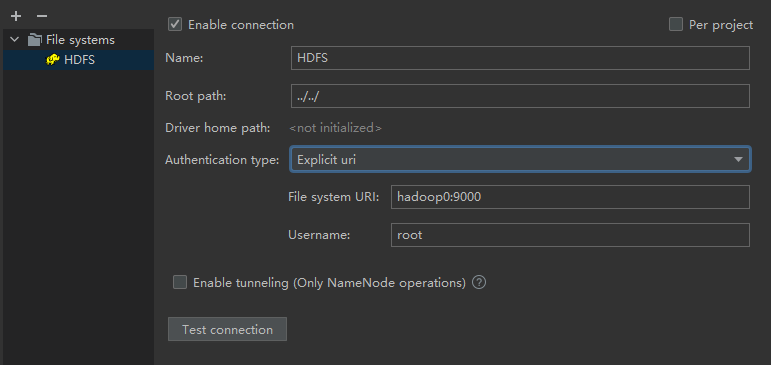

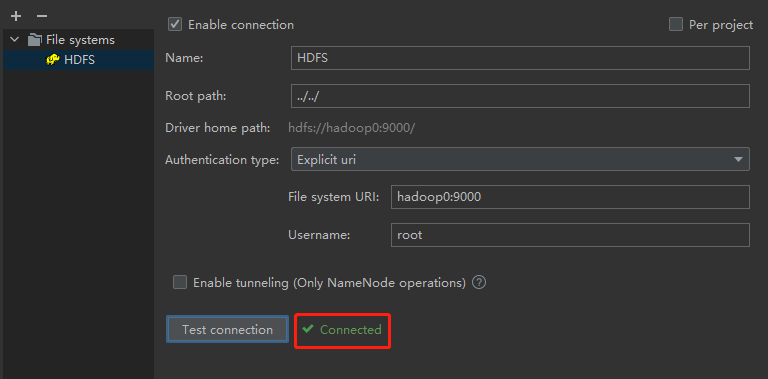

(4)开始配置链接,Name一行随便起,那个是你显示在IDEA中的名称,RootPath默认不改动,Authentication type这里选URL,因为你的Hadoop在虚拟机中,然后下面的文件系统URL则填入你虚拟机的HDFS的地址即可,Username为你虚拟机的用户名,填写完成后点击测试链接,测试成功则皆大欢喜,但多半是不会成功的,会提示找不到HADOOP_HOME的环境变量,那么我们需要再做一步操作了

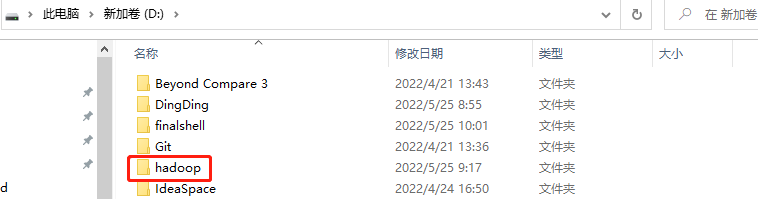

2.将虚拟机安装的Hadoop复制到Windows下

(1)利用FTP工具将虚拟机上安装的Hadoop下载到Windows中,我这里放到了D盘

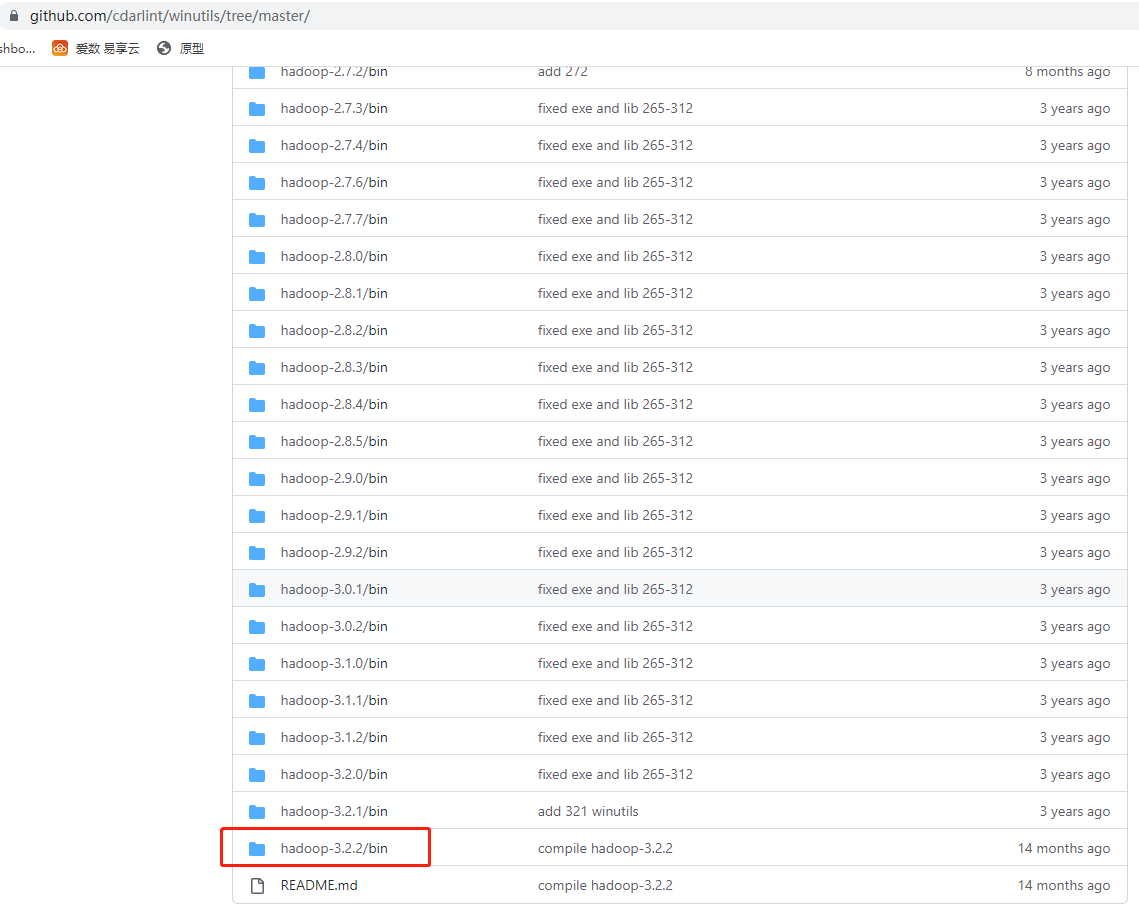

(2)然后我们需要利用一个叫做winutils的工具来帮助我们链接,下载地址在这(选择离你版本最近的即可):https://github.com/cdarlint/winutils/tree/master/,我这里使用的是3.3.3版本,所以选择3.2.2版本

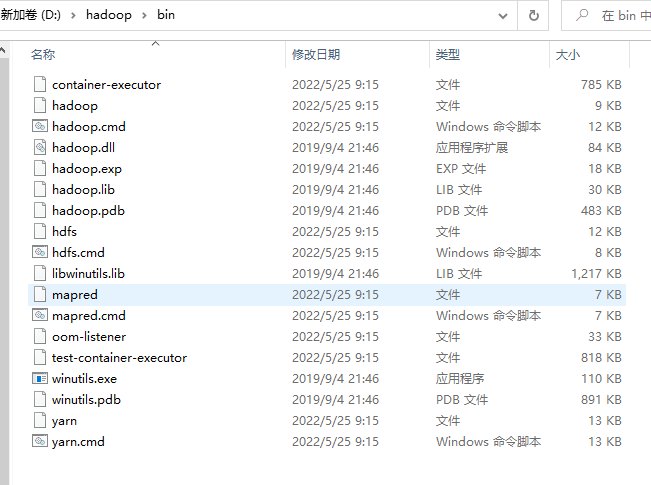

(3)然后我们将从GitHub上下载的文件bin目录里面的内容整个拖入本地的Hadoop文件夹中的bin文件夹,整个bin文件目录最后是这样的,复制完成后将hadoop.dll放入到c盘的windows下的system32文件夹中

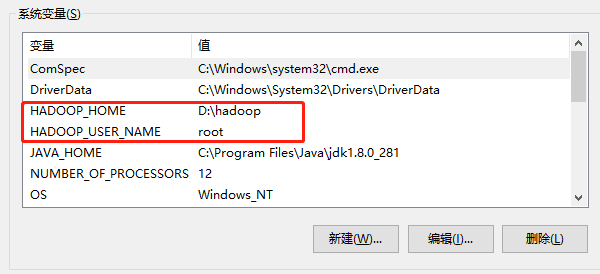

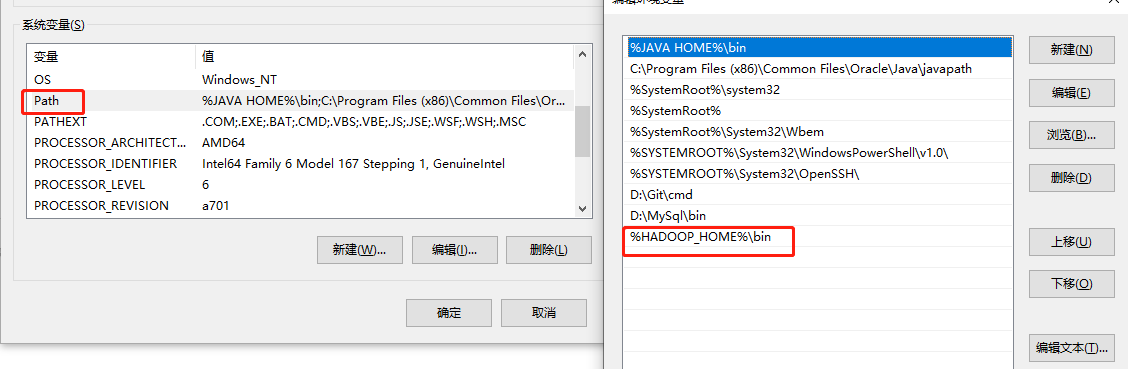

(4)接下来配置环境变量,如图

(5)配置好后,首先在HDFS上创建一个空文件夹

hdfs dfs mkdir /test

(6)然后我们再次点击测试链接,即可看到已经链接成功了~

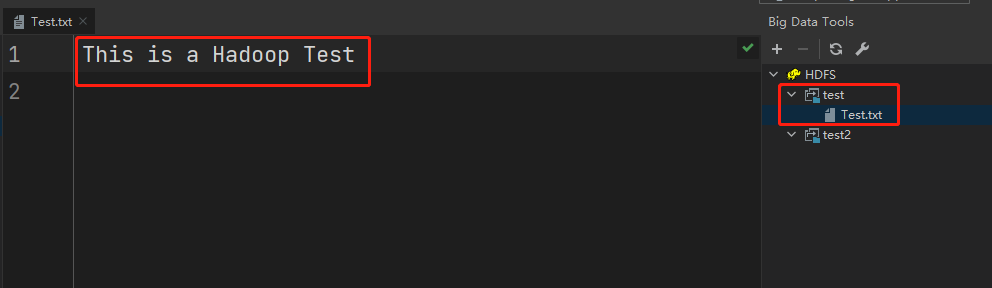

(7)然后我们测试一下,利用shell命令创建一个空文件并写入内容

hdfs dfs -touchz /test/Test.txtecho "This is a Hadoop Test" | hdfs dfs -appendToFile - /test/Test.txt

然后我们在IDEA的插件中查看该文件

这样的话我们的windows环境与IDEA插件也可以使用了,也测试了一些简单的HDFS的shell命令,接下来就该利用API去执行了~~~