-

1.准备工作

所需工具:VMware workstation 15.5 pro、CentOS-7-x86_64-DVD-2009.iso、jdk-8u281-linux-x64.rpm、FinalShell

2.开始搭建

(1)首先安装VMware workstation,只需要更改一下安装路径即可,其他无脑下一步

(2)然后创建虚拟机,镜像选择CentOS即可,内存分配为宿主机的一半,硬盘内存为200G,其他均为默认即可

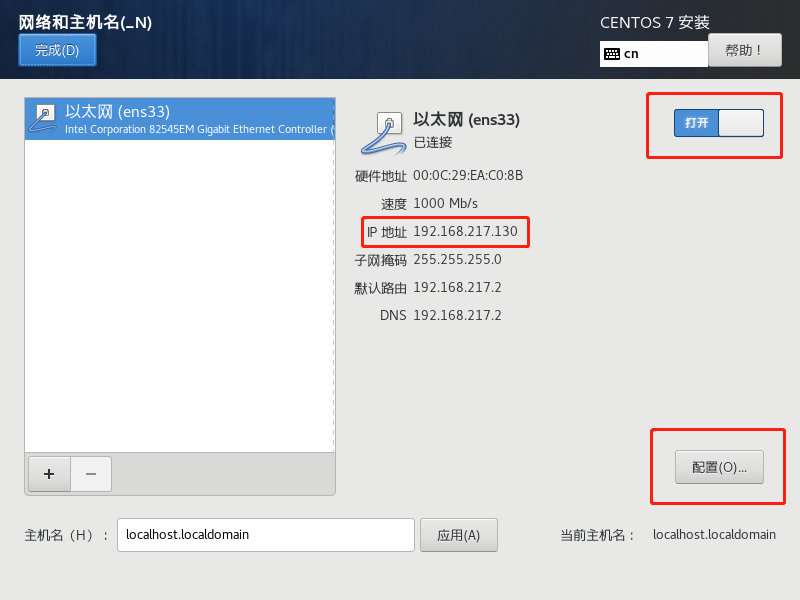

(3)配置IP为手动,主要是为了固定IP,在安装页面点击这里

然后选择开启,记住这个IP地址,这个是我们一会需要配置的,然后点击下方配置

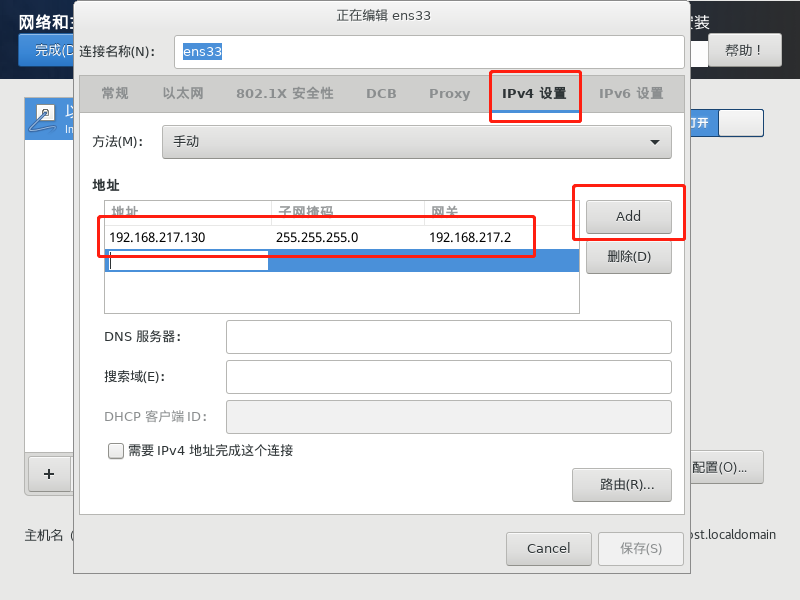

照如下配置即可,地址就是你刚才记录的那个IP,子网掩码就是255.255.255.0,网关就配置为192.168.217.2

然后等待系统安装完成

(4)修改主机名

hostnamectl set-hostname hadoop0

(5)配置Hosts文件

vi /etc/hosts

然后在末尾添加一行

192.168.217.129 hadoop0

(6)关闭防火墙(生产环境开放所需端口,因为是开放环境为了方便直接把防火墙禁用)

systemctl stop firewalld.servicesystemctl disable firewalld.service

(7)禁用seliunx

vi /etc/seliunx/config

(8)配置SSH免密登陆

为了方便后续Hadoop各组件之间使用SSH登陆(免输密码)

因为是新虚拟机,不存在旧的秘钥,我们直接创建新秘钥

cd /rootssh-ketgen -t dsa

一路回车采用默认即可

然后将生产的秘钥文件id_dsa.pub复制到SSH指定的秘钥文件authorized_keys即可

cat id_dsa.pub >> authorized_keys

然后测试一下

ssh hadoop0

然后输入yes继续链接,没有提示输入密码,则证明免密码登陆配置成功

(9)重启

reboot

自此,关于我们虚拟机的配资就完成了,接下来开始Hadoop环境的搭建

3.Hadoop环境的搭建

(1)安装JDK

关于Liunx下JDK的安装我直接有写过,直接参考这篇:Liunx安装JDK

(2)安装Hadoop

下载地址: https://dlcdn.apache.org/hadoop/common/hadoop-3.3.3/hadoop-3.3.3.tar.gz

下载完成后用FTP工具上传到/usr/local目录下,然后解压

cd /usr/localtar -xvf hadoop-3.3.3.tar.gz

为了方便操作,我们给解压出来的文件夹改名

mv hadoop-3.3.3 hadoop

(3)配置环境变量

vi /etc/profile

然后将下面的内容配置到环境变量中,最终文件的配置内容如下(内含JDK与Hadoop)

export JAVA_HOME=/usr/java/jdk1.8.0_281-amd64export HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbinexport CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport JRE_HOME=$JAVA_HOME/jreexport HDFS_NAMENODE_USER=rootexport HDFS_DATANODE_USER=rootexport HDFS_SECONDARYNAMENODE_USER=rootexport YARN_RESOURCEMANAGER_USER=rootexport YARN_NODEMANAGER_USER=root

然后使配置立即生效

source /etc/profile

(4)配置hadoop-env.sh

切换到Hadoop的配置目录/usr/local/hadoop/etc/hadoop,修改其中的hadoop-env.sh,将“# JAVA_HOME=/usr/Java/testing hdfs dfs -ls” 修改为 “JAVA_HOME=/usr/java/jdk1.8.0_281-amd64”

(5)配置core-site.xml

该文件还在该目录,在和标签之间配置HDFS的访问URL与端口

<property><name>fs.defaultFS</name><value>hdfs://hadoop0:9000</value><descripttion>NameNode URL</descripttion></property>

(6)配置hdfs-site.xml

该文件还在该目录,在和标签之间配置NameNode和DataNode的元数据存储路径,以及NameNode和SecondNameNode的访问端口

<property><name>dfs.datanode.data.dir</name><value>file:///usr/local/hadoop/data/datanode</value></property><property><name>dfs.namenode.name.dir</name><value>file:///usr/local/hadoop/data/namenode</value></property><property><name>dfs.namenode.http-address</name><value>hadoop0:50070</value></property><property><name>dfs.namenode.secondary.http-address</name><value>hadoop0:50090</value></property>

(7)配置yarn-site.xml

该文件还在该目录,在和标签之间配置弄的manager和resourcemanager的访问端口

<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.aux-services.mapreduce_shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>hadoop0:8025</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>hadoop0:8030</value></property><property><name>yarn.resourcemanager.address</name><value>hadoop0:8050</value></property>

自此关于Hadoop的配置也已经完成~

4.Hadoop验证与启动

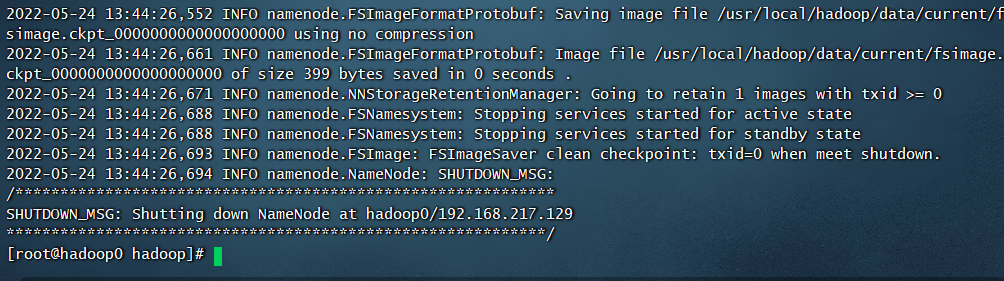

(1)格式化Hadoop

hadoop namenode -format

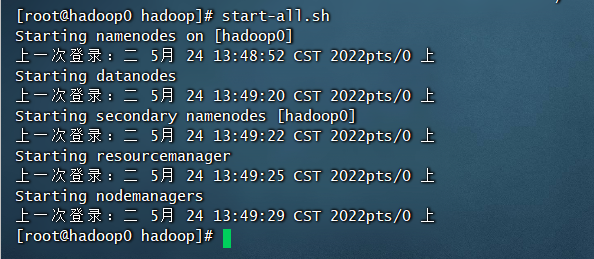

(2)启动Hadoop

使用start-all.sh脚本启动所有Hadoop进程

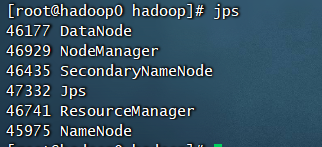

(3)查看相关进程是否已启动

jps

可以看到五个进程都已启动

5.简单使用

查看HDFS中的文件

hadoop fs -ls /

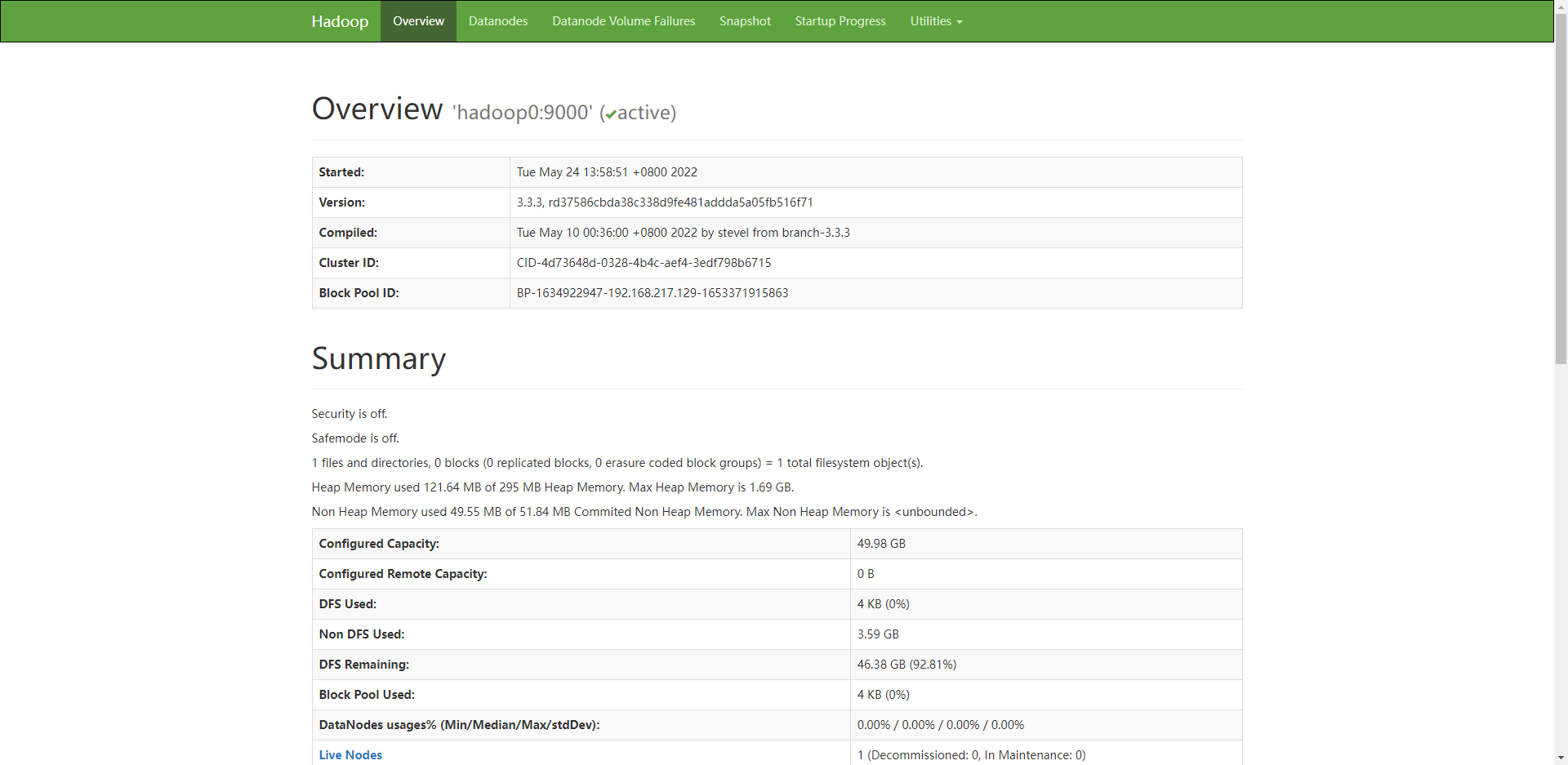

浏览器访问

关于Hadoop的环境搭建就到此结束了~环境搭建好了下一步就是了解Hadoop的两大核心:HDFS与MapReduce

关于正式环境下集群如何搭建参考这篇文章

https://blog.csdn.net/m0_59209350/article/details/117879855

这里记录一个IDEA使用Big Data Tools插件的博客,按照博客所写亲测可用

https://blog.csdn.net/weixin_44155966/article/details/108820920