一、实验目的

利用深度学习实现手写数字识别,当输入一张手写图片后,能够准确的识别出该图片中数字是几。输出内容是0、1、2、3、4、5、6、7、8、9的其中一个。

二、实验原理

(1)采用用全连接神经网络训练

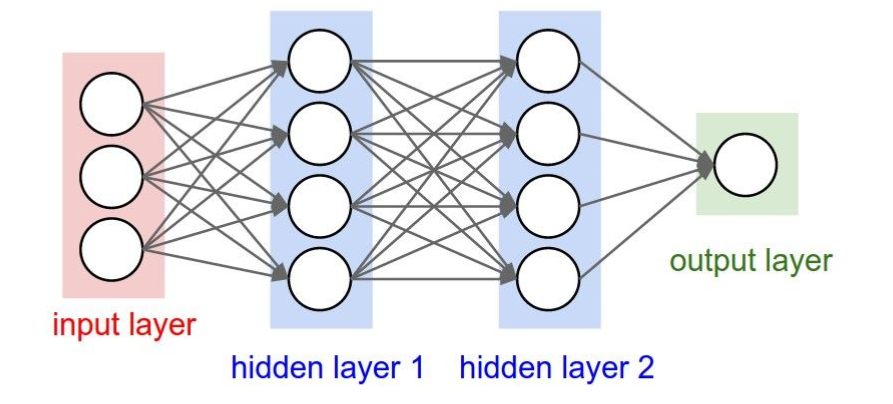

全连接神经网络模型是一种多层感知机(MLP),感知机的原理是寻找类别间最合理、最具有鲁棒性的超平面,感知机最具代表的是SVM支持向量机算法。神经网络同时借鉴了感知机和仿生学,通常来说,动物神经接受一个信号后会发送各个神经元,各个神经元接受输入后根据自身判断,激活产生输出信号后汇总从而实现对信息源实现识别、分类,一个典型的神经网络如下图所示:

上图是典型的全连接神经网络模型(DNN),有的场合也称作深度神经网络,与传统的感知机不同,每个结点和下一层所有结点都有运算关系,这就是名称中‘全连接’的含义,在实践中全连接神经网络通常有多个隐藏层,增加隐藏层可以更好分离数据的特征,但过多的隐藏层也会增加训练时间以及产生过拟合。

在训练全连接神经网络时,先是通过前向传播,得到预测结果,再反向传播去调整模型权重。

(2)反向传播

反向传播根据前向传播产生的损失函数值,沿输出端向至输入端优化每层之间参数,在此过程中运算利用梯度下降法优化参数,神经网络求解参数本质上仍然是规划中求最优解问题,现代机器学习框架如Tensorflow、pytorch、keras将梯度下降法、Booting、Bagging这些优化中常用技巧封装起来,开发者只要专注于数据建模即可。

(3)训练mnist手写数字识别

利用交叉熵作为损失函数实现对minist数据集的识别,minist数据集是手写数字的图像样本,DNN识别图像的过程就是把图像正确的归为0-9这10个数字,所以这是一个分类算法的实现。

三、实验内容

(1)训练模型

数据集:采用TensorFlow2.3的TensorFlow-datasets内置的mnist数据集

神经网络:全连接

损失函数:分类交叉熵

优化器:Adam

评价准则:准确率

Epochs:100

(2)测试模型

测试集:采用TensorFlow2.3的TensorFlow-datasets内置的mnist数据集,形状改为28*28

(3)环境

Python 3.8 TensorFlow 2,3 Tensorflow_datasets 2.1 scipy numpy PIL matplotlib scipy

四、实验过程

(1)导入包

import osimport scipyimport tensorflow as tfimport tensorflow_datasets as tfdsimport matplotlib.pyplot as pltimport numpy as npfrom PIL import Image

(2)导入Mnist数据集并标准化数据

# 载入mnist数据集dataset, metadata = tfds.load("mnist", as_supervised=True, with_info=True)mnist = tf.keras.datasets.mnist(x_train, y_train), (x_test, y_test) = mnist.load_data()x_train, x_test = x_train / 255.0, x_test / 255.0x_test, y_test = x_test / 255.0, y_test / 255.0

(3)搭建全连接模型

model = tf.keras.models.Sequential([tf.keras.layers.Flatten(),tf.keras.layers.Dense(128, activation=tf.nn.relu),tf.keras.layers.Dropout(0.2),tf.keras.layers.Dense(10, activation=tf.nn.softmax)])

(4)训练模型并保存模型权重

# 模型保存路径checkpoint_path = "model/cp.ckpt"checkpoint_dir = os.path.dirname(checkpoint_path)# 创建一个保存模型权重的回调cp_callback = tf.keras.callbacks.ModelCheckpoint(filepath=checkpoint_path,save_weights_only=True,verbose=1)# 训练模型的配置model.compile(optimizer='adam',loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 开始训练模型model.fit(x_train, y_train,validation_data=(x_test, y_test),epochs=100,callbacks=[cp_callback])

(5)测试模型

path = './test_pic/mnist_train_0.jpg'im = Image.open(path)plt.imshow(im)plt.show()pic = np.array(img2vec(path))print("\n识别结果:\n{}".format(np.argmax(model.predict(pic.reshape(1, 28, 28)))))print()

(6)工具函数,把图片统一大小并二值化

def img2vec(path):'''jpg转换为向量Args:path: the path of your pic'''try:im = Image.open(path).convert('L')im = im.resize((28, 28))tmp = np.array(im)vec = tmp.ravel()return vecexcept:print("图片不存在")

五、实验分析

(1)训练过程

Epoch=100,训练准确率能达到99.6%

Epoch 98/1001850/1875 [============================>.] - ETA: 0s - loss: 0.0117 - accuracy: 0.9962Epoch 00098: saving model to model/cp.ckpt1875/1875 [==============================] - 3s 1ms/step - loss: 0.0118 - accuracy: 0.9962 - val_loss: 1.9510 - val_accuracy: 0.0000e+00Epoch 99/1001867/1875 [============================>.] - ETA: 0s - loss: 0.0121 - accuracy: 0.9962Epoch 00099: saving model to model/cp.ckpt1875/1875 [==============================] - 3s 2ms/step - loss: 0.0121 - accuracy: 0.9962 - val_loss: 2.0950 - val_accuracy: 0.0000e+00Epoch 100/1001863/1875 [============================>.] - ETA: 0s - loss: 0.0113 - accuracy: 0.9961Epoch 00100: saving model to model/cp.ckpt1875/1875 [==============================] - 3s 1ms/step - loss: 0.0113 - accuracy: 0.9961 - val_loss: 1.8876 - val_accuracy: 0.0000e+00

(2)测试模型

保存mnist的200张图片作为预测使用,能准确预测出图片中的数字。

六、实验体会与心得

该手写数字识别是入门深度学习最简单的例子,数据集小,实现简单,通过对一个这个例子的实现,明白了深度学习的计算步骤。以及实现的流程。可以入门更难的例子。