频率派vs贝叶斯派

将频率引入机器学习是一件很自然的事,可以把数据当作是一个概率模型。对概率的理解有两大学派:频率派(Frequentits)和贝叶斯派(Bayesian)。

符号说明:表示含

个样本(sample)的数据,每个样本为

维向量,

表示参数(parameter)。

频率派的观点

频率派认为参数是一个固定的未知常数(unknown constant),

为随机变量(random variable),

独立同分布于

。样本总体的分布为

为了求

采用最大似然估计(MLE: maximum likelihood estimation)得到:

频率派的观点:一旦表现度量确定之后,机器学习的问题就基本上转换成了一个优化问题(optimization problem),要做的工作就是设计一个高效求解的优化算法。

贝叶斯派的观点

贝叶斯派将当作是一个随机变量,

符合某种分布,记为

,称为先验分布(prior)。

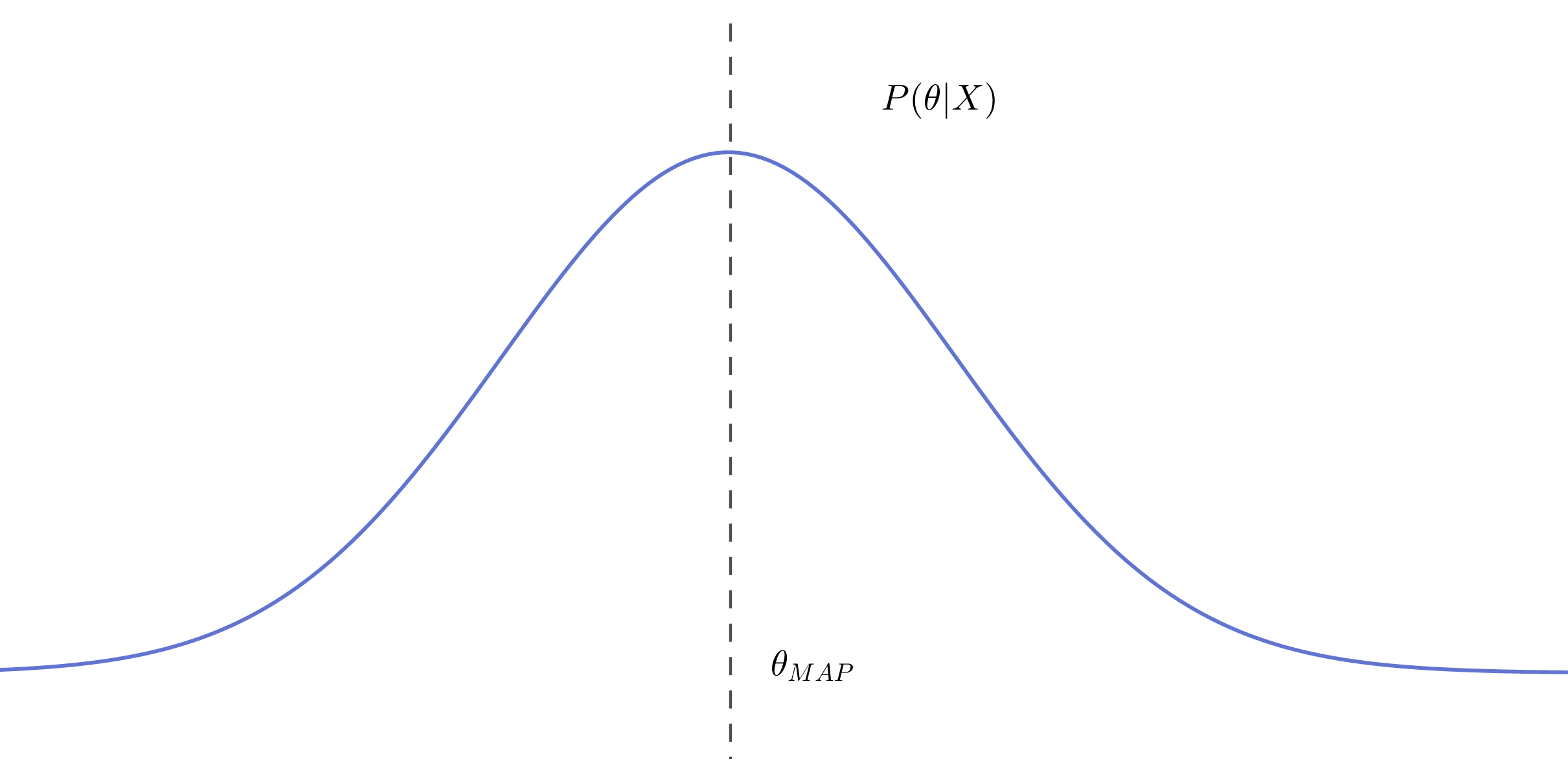

最大后验估计

根据贝叶斯公式:

使用最大后验估计(MAP: maximum a posteriori probability estimate)来估计:

使用MAP来估计,本质上是以使得后验概率最大的

来代替一个随机变量

,因此MAP本质上并不是真正的贝叶斯估计。

贝叶斯估计

真正的贝叶斯估计就是要求后验概率分布:

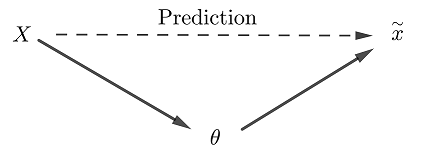

我们求得后验概率分布的目的就是为了进行贝叶斯预测,

贝叶斯预测

我们就后验概率分布的目的就是为了进行推断,即求,

为一个新的数据。

根据概率的链式法则,得到:

上式推导:

根据链式法则和乘法公式

两端消去共同项,得到:

小结

频率派和贝叶斯派分别给出了一系列的机器学习算法。频率派的观点导出了一系列的统计机器学习算法,而贝叶斯派导出了概率图理论。

统计机器学习过程实际上就是先设计一个模型(判别模型、概率模型、非概率模型等等),再根据模型设计一个损失函数,最后使用具体算法(梯度下降、牛顿法等)进行求解,所以从频率派的的角度来看机器学习本质就是一个优化问题,因此优化方法有很多应用。

贝叶斯派的算法,无论是后验概率的建模还是应用后验概率分布进行推断,积分都占有重要地位。所以,从贝叶斯角度来看机器学习本质就是求积分的过程,因为贝叶斯估计中分母是个积分过程,因此采样积分方法如 MCMC 有很多应用。