0. 文档收集

CV 中的 MTL,MTL 中的痛点:多任务的 Loss 加权和

推荐的 MTL,loss weight、output weight、label weight

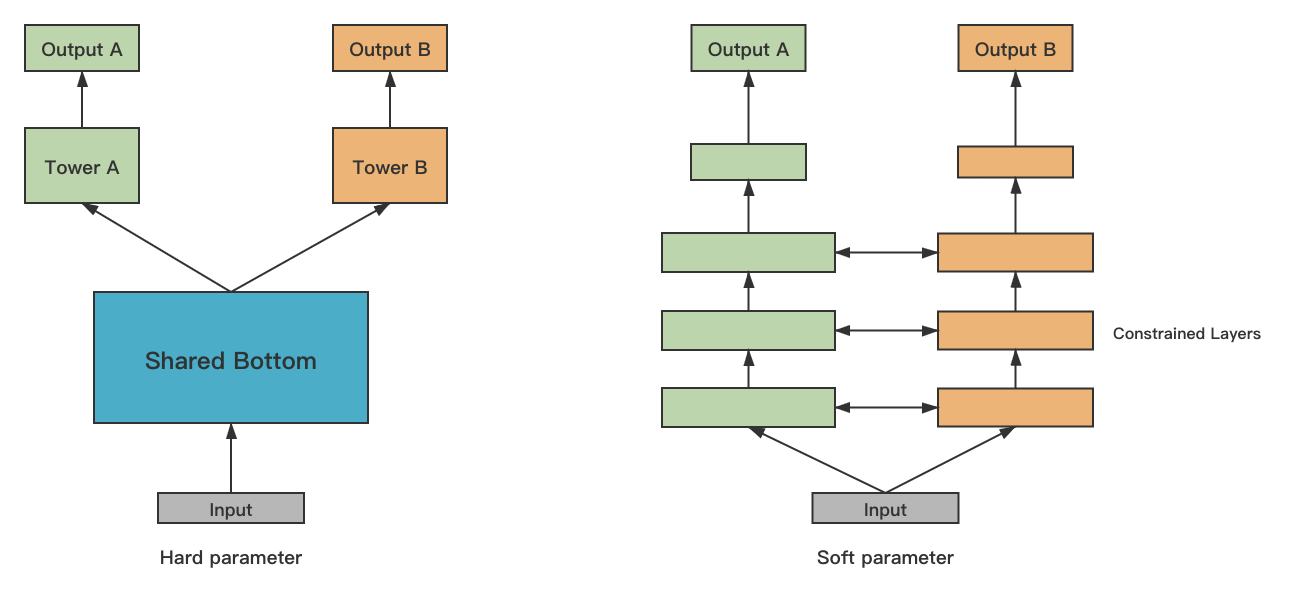

多任务可以分为 hard 和 soft 看两种参数共享模式:

- hard:常用的是 share bottom,适合关联性比较强的任务,可以共享参数,降低网络过拟合,提高泛化能力

Task Weight —— MTL 的关键

grad norm、weight ascent

MTL 如果有 N 格 task,就会有 N 个 loss

- 这 N 个 loss 怎么训练?—— loss weight

- N 个 task 的输出,排序时如何使用?—— output weight

- 正负样本不均衡时,该如何处理?—— label weight

1. label weight

正负样本不均衡时,比如点击的正负样本比例为 1:10,则可以提高正样本权重,来提升 AUC。通过调整权重使得正负比例在 1:2 左右比较合适,如果调整为 1:1 可能会导致各个子任务之间学习相互抑制

2. loss weight

调整损失的权重, 让共享层更关注某一个任务,也能解决一部分样本分布不均衡带来的过拟合。

但是如何给每个 task 分配合适的 loss weight?

- 人工预设,需要很强的先验知识,而且很难保证调参得到的权重参数是最优解