:::info

基于模型的方法——通过与环境的交互来学习转移和奖励模型。

本章讨论了通过与环境交互来学习基本动态和奖励的最大似然和贝叶斯方法。

- 最大似然方法包括计算状态转移和记录收到的奖励大小,以估计模型参数。将讨论使用不断更新的模型进行规划的几种方法。(必须依靠启发式探索策略来获得合适的解决方案)

贝叶斯方法涉及计算模型参数的后验分布。求解最优探索策略通常很难,但通常可以通过后验采样获得合理的近似值。 :::

1. 最大似然模型 Maximum Likelihood Models

:::info 前面介绍,强化学习涉及使用有关过去状态转移和奖励的信息来进行决策。本节描述如何获得潜在问题的最大似然估计。 ::: 最大似然估计可用于生成价值函数估计,该估计可与探索策略一起用于生成动作。

记录转移数量,这表明在采取动作

时观察到从

转移到

的次数。于是转移函数的最大似然估计为:

,其中

,如果

,则转移概率估计为

。

当收到奖励时,更新,即在

状态下采取动作

时获得的所有奖励的总和。奖励函数的最大似然估计是平均奖励:

,如果

,则估计值为

。

如果我们事先知道转移概率或奖励,那么我们可以将和

初始化为

以外的值。

2. 更新方案 Update Schemes

:::info 当我们更新模型的最大似然估计时,还需要更新我们的计划。本节讨论了针对不断变化的模型的几种更新方案。主要考虑因素之一是计算效率。 :::

- 完全更新 Full Updates

使用第7.7节中的线性规划公式求解最大似然模型,对价值函数进行完全更新。在每一步之后,得到一个新的模型估计并重新求解。

- 随机更新 Randomized Updates

在每次状态转换时重新计算最优策略通常在计算上非常麻烦。另一种方法是在先前访问的状态以及一些随机选择的状态下,对估计模型执行Bellman更新。

- 按优先级排列的更新 Prioritized Updates

优先级扫描prioritized sweeping:使用优先级队列来帮助确定哪些状态最需要更新。通过更新在不断发展的环境模型中 似乎最需要的状态的值 来集中重新规划。?

3. 探索 Exploration

无论更新方案如何,通常都必须遵循某种形式的探索策略。我们可以调整上一章中介绍的探索算法,以用于多状态问题。上一章讨论的探索策略的一个局限性是,它们不能从当前状态以外的状态对探索行为进行推理。已经提出了几种算法来解决这个问题。

R-MAX算法:名字来源于为未探索的状态-动作对分配最大的奖励,少于次访问的状态-动作对被认为探索不足:

,其中

是可达到的最大奖励。R-MAX中的转移模型被修改为

,使未被探索的状态-动作对保持在相同的状态。因此,未开发状态的值为

,提供了探索它们的激励。这种探索激励使我们不再需要单独的探索机制。

4. 贝叶斯方法 Bayesian Methods

基于贝叶斯模型的方法保持可能问题的概率分布,允许对探索进行原则性推理。

与之前讨论的最大似然方法相比,贝叶斯方法在不依赖启发式探索策略的情况下平衡了探索和利用。

在贝叶斯强化学习中,我们指定了所有模型参数的先验分布。这些模型参数可能包括控制即时奖励分配的参数,但本节主要关注控制状态转移概率的参数。

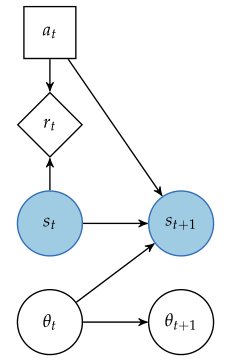

问题的结构可以用下图所示的动态决策网络表示,其中模型参数是显式的。阴影节点表明状态是观测到的,但模型参数反之。一般假设模型参数是时不变的,。然而,当转移到新的状态时,

的信念会随着时间而改变。

对于转移概率的信念可以用Dirichlet分布的集合来表示,每个源状态和动作都有一个分布。对于给定的和

,每个Dirichlet分布表示

上的分布。如果

是一个

元素向量,表示下一状态上的分布,那么先验分布是:

,其中

是与从状态

采取动作

开始的转移相关的计数向量。通常使用所有部分设置为

的统一先验,但转移动态的先验知识可以用于以不同的方式初始化计数。

的分布是Dirichlet分布乘积的结果:

5. 贝叶斯自适应马尔可夫决策过程 Bayes-Adaptive Markov Decision Processes

贝叶斯自适应马尔可夫决策过程 Bayes-adaptive Markov decision process:将具有未知模型的MDP中最优行动问题表述为具有已知模型的高维MDP。

贝叶斯自适应MDP中的状态空间是笛卡尔积,其中

是模型参数

上的可能信念空间。虽然

是离散的,但

通常是高维连续状态空间。贝叶斯自适应MDP中的状态是一对

,由基础MDP中的当前状态

和信念状态

组成。动作空间和奖励函数与基础MDP相同。

贝叶斯自适应MDP中的转移函数为,即给定智能体以置信度

从

开始并采取动作

,以置信度

转移到状态

的概率。新的置信状态

可以根据贝叶斯规则确定计算,如果将这个确定性函数表示为

,即

,则转移函数可以分解为:

,其中,

为Kronecker delta function函数,当

时

,否则为

。

其中,第二项可以使用积分计算:

当由16.4节中的式子表示时,上式可变为:

将具有已知模型的MDP的Bellman最优性方程(7.5节)推广到模型未知的情况:

但是,不能直接应用策略迭代或价值迭代,因为是连续的;可以使用第8章的近似方法或第9章的在线方法。

*补充内容见第16章。

6. 后验采样 Posterior Sampling

求解信念空间上的最优价值函数的另一种方法是使用后验采样posterior sampling(15.4节引入)。

后验采样posterior sampling:假设是真实模型,从当前信念

中提取一个样本

,然后求解最佳动作。然后我们更新信念,提取新的样本,并求解相应的MDP。

后验采样的一个优点是,不必决定启发式探索参数。但是,在每一步的求解MDP都可能很昂贵。

后验采样求解从信念状态采样的MDP,而不是对所有可能的MDP进行推理,降低了求解贝叶斯自适应MDP的高计算复杂度。