:::info

强化学习智能体必须平衡环境探索与通过交互获得的知识利用。

本章通过关注单一状态的问题,介绍了与权衡勘探-开发的相关挑战。还介绍了具有多状态的MDP中的探索。

:::

1. 赌博机问题 Bandit Problems

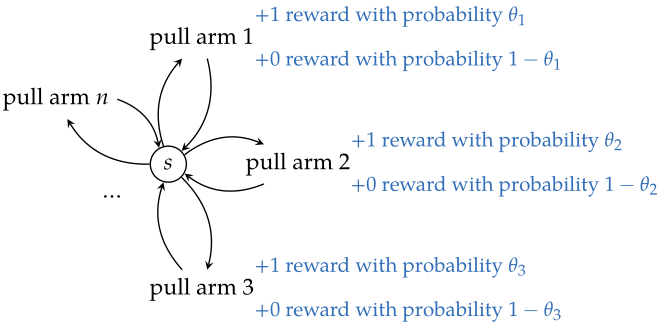

许多现实世界的问题可以被定义为多臂赌博机。赌博机问题可以被定义为一个具有单一状态、种行动和未知随机的奖励函数

的

步MDP,通过采取不同的行动获得随机奖励。

2. 贝叶斯模型估计 Bayesian Model Estimation

用beta分布来表示臂(动作

)的获胜概率

的信念。假设

的先验一致,

次赢和

次输之后的

的后验为

,获胜的后验概率为:(beta分布计算公式)

贪心动作greedy action:使预期即时回报最大化的行为,即,使在二元赌博机问题中获胜的后验概率最大的行为。

3. 无向探索策略 Undirected Exploration Strategies

无向探索undirected exploration:一种特殊探索类型,不使用来自先前结果的信息来指导非贪婪行动的探索。

最常见的无向探索策略之一是贪婪探索。该策略以

的概率随机选择一个臂,以

的概率选择贪婪的臂

,其中,

是使用上一节给出的贝叶斯模型通过动作

获胜的后验概率。一种常见的调整是

随时间衰减,例如使用指数衰减:

,其中

。

另一种策略是explore-then-commit exploration,在前个时间步长中均匀地随机选择动作。在此之后,选择贪婪的动作。

4. 定向探索策略 Directed Exploration Strategies

定向探索directed exploration:使用从之前收集的信息来指导非贪心动作的探索,例如softmax探索策略。

- softmax探索策略:以与

成比例的概率选择动作

,精度参数

在每一步都按系数

进行缩放,以控制探索量。

各种探索策略都基于不确定性下的乐观主义思想。?

- 分位数探索quantile exploration:选择

分位数最高的臂作为收益概率。

的值在不确定性下导致乐观,激励探索没有被尝试过的行动。

值越大,探索越多。

- UCB1探索 UCB1 exploration:选择能使

最大化的行动

,其中

为采取行动

的次数,且

。

的值越大,需要进行更多的探索。

- 后验采样posterior sampling/随机概率匹配randomized probability matching/Thompson sampling:实现简单,不需要仔细的参数调优。从与各种动作相关的奖励的后验分布中采样,选择具有最大采样值的动作。

5. 最优探索策略 Optimal Exploration Strategies

与臂相关的beta分布通过计数

参数化。

代表了对回报的信念,因此代表了一种信念状态belief state。

构造一个MDP,其状态是长度为的向量,表示智能体在

臂赌博机问题上的信念。动态规划可以用来解决这个MDP,以获得一个最优的策略

,指定要拉动的臂。

用表示拉动臂

后的预期收益,然后找到最佳动作。最优效用函数和最优策略可以用

表示:

对进行分解:

更一般地表示为:

其中,第一项和第二项分别与臂的胜利和失败相关。

的值是获胜的后验概率(可调)。上式中的第一个

记录一次胜利,而第二个

记录一次失败。

为

臂胜利的回报。

虽然这个动态规划解是最优的,但信念状态的数目是,但计算成本很高。

6. 多状态探索 Exploration with Multiple States

在具有多状态的一般强化学习环境中,必须使用有关状态转移的观测来为决策提供信息。

将在接下来的几章中讨论很多方法来模拟问题和执行探索。