//设置hadoop用户名System.setProperty("HADOOP_USER_NAME", "admin")//初始化SparkConf对象,设置基本任务参数val conf = new SparkConf()//设置目标Master机器地址.setMaster("local[*]")//设置任务名称.setAppName("WC")// .setMaster("spark://hdp03:10016").setJars(List("/Users/twx/code-space/internet/SparkSyllabusBook/chapter-3/target/chapter-3-1.0-SNAPSHOT.jar")).setIfMissing("spark.driver.host", "172.26.1.184")/实例化SparkContext,Spark的对外接口,即负责用户与Spark内部的交互通信val sc = new SparkContext(conf)

方式二

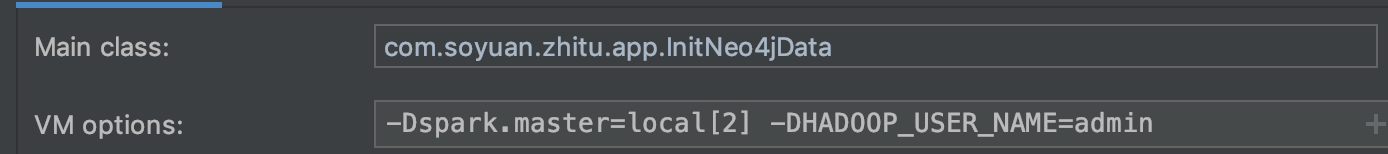

在VM options中指定hadoop_user_name和spark.master