- 1 Docker Compose">1 Docker Compose

- 1.1 Docker Compose 简介">1.1 Docker Compose 简介

- 1.2 Docker-compose 能干嘛">1.2 Docker-compose 能干嘛

- 1.3 Docker-compose 下载">1.3 Docker-compose 下载

- 1.4 Docker-compose 使用">1.4 Docker-compose 使用

- 1.5 Yaml 规则">1.5 Yaml 规则

- 1.6 使用 Compose 一键部署 WordPress 博客">1.6 使用 Compose 一键部署 WordPress 博客

- 1.7 实战">1.7 实战

- 1.8 Docker-compose 常用的命令">1.8 Docker-compose 常用的命令

- 1.9 小总结:">1.9 小总结:

- 2 Docker Swarm">2 Docker Swarm

- 3 Docker Stack">3 Docker Stack

- 4 Docker Secret">4 Docker Secret

- 5 Docker Config">5 Docker Config

- 6 扩展到 Kubernetes">6 扩展到 Kubernetes

Video Reference:【狂神说Java】Docker进阶篇超详细版教程通俗易懂_哔哩哔哩_bilibili

1 Docker Compose

1.1 Docker Compose 简介

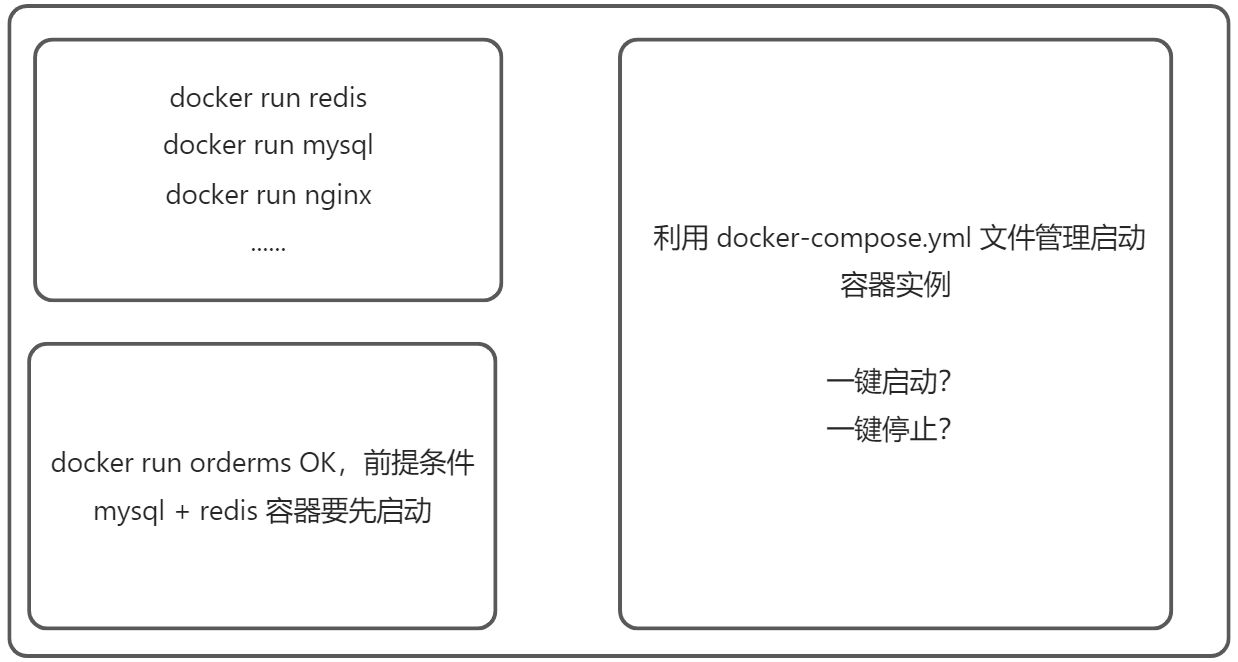

Docker Compose是一个用来定义和运行复杂应用的Docker工具。一个使用Docker容器的应用,通常由多个容器组成。使用Docker Compose不再需要使用shell脚本来启动容器。 Compose 通过一个配置文件来管理多个Docker容器,在配置文件中,所有的容器通过services来定义,然后使用docker-compose脚本来启动,停止和重启应用,和应用中的服务以及所有依赖服务的容器,非常适合组合使用多个容器进行开发的场景。 Docker-compose 是 Docker 官方的开源项目,负责实现对 Docker 容器集群的快速编排 Docker-compose 是 Docker 公司推出的一个工具软件,可以管理多个 Docker 容器组成一个应用。需要定义一个YAML格式的配置文件 docker-compose.yml ,写好多个容器之间的调用关系。然后,只要一个命令,就能同时启动/关闭这些容器。:::color1

docker-compose 还是非常爽的,用了以后,完全不像用 docker 启动容器 最简单的理解就是把多个docker容器的启动命令写在一个脚本里,批量启动容器(写好多个容器之间的命令关系) Docker Compose来轻松高效的管理容器。定义运行多个容器。:::

- 用 Dockerfile 定义你的应用环境,这样它就可以在任何地方被复制。

- 在 docker-compose.yml 中定义组成应用程序的服务。所以它们可以在一个孤立的环境中一起运行。

- 运行docker compose up , docker compose up命令将启动并运行整个应用程序。你也可以使用compose standalone(docker-compose binary)运行docker-compose。

Compose 是 Docker 官方的开源项目,需要独立安装! Dockerfile 让程序在任何地方运行。Docker Compose 是单个机器的容器编排工具。Docker Compose docker-compose.yml 文件示例

Docker-Compose 项目是 Docker 官方的开源项目,负责实现对 Docker 容器集群的快速编排。 Docker-Compose 将所管理的容器分为三层,分别是工程/项目(project),服务(service)以及容器(container)。 Docker-Compose 运行目录下的所有文件(docker-compose.yml,extends 文件或环境变量文件等)组成一个工程,若无特殊指定工程名即为当前目录名。一个工程当中可包含多个服务,每个服务中定义了容器运行的镜像、参数、依赖。一个服务当中可包括多个容器实例。 Docker-Compose 并没有解决负载均衡的问题,因此需要借助其他工具实现服务发现及负载均衡,比如 Consul。

version: "3.9" # optional since v1.27.0services:web:build: .ports:- "8000:5000"volumes:- .:/code- logvolume01:/var/logdepends_on:- redisredis:image: redisvolumes:logvolume01: {}

Docker Compose :重要的概念使用 Docker Compose 可以轻松、高效的管理容器,它是一个用于定义和运行多容器 Docker 的应用程序工具。

- 服务 services:容器,应用。(Web、Redis、MySQL)

- 项目 project:一组关联的容器。博客

1.2 Docker-compose 能干嘛

Docker 建议我们每一个容器中只运行一个服务,因为docker容器本身占用资源极少,所以最好是将服务单独的分割开来,但是这样我们又面临了一个问题? 如果我们需要同时部署好多个服务,难道要每个服务单独写Dockerfile,然后再构建镜像,镜像容器,这样会很累,所以docker官方给我们提供了 docker-compose 多服务部署工具。 例如要实现一个Web微服务项目,除了Web服务容器本身,往往还需要再加上后端的数据库mysql服务容器,redis服务器,注册中心eureka,甚至还包括负载均衡容器等等。。。 Compose 允许用户通过一个单独的 docker-compose.yml 模板文件(YAML格式)来定义一组相关联的应用容器为一个项目(project)。 可以很容易的用一个配置文件定义一个/一组多容器的应用,然后使用一条指令安装这个应用的所有依赖,完成构建。Docker-Compose解决了容器与容器之间如何管理编排的问题。:::color1

Docker compose 是单机(本机)的多容器管理技术 K8s 是跨主机的集群部署工具:::

1.3 Docker-compose 下载

1.3.1 官网

https://docs.docker.com/compose/compose-file/compose-file-v3/

1.3.2 官网下载

https://docs.docker.com/compose/install/

GitHub 项目地址:https://github.com/docker/compose ### 1.3.3 安装步骤 #查看最新版docker-compose 需要登录到GitHub项目中,然后修改下载的URL即可。

$ sudo curl -L "https://github.com/docker/compose/releases/download/v1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose# curl -SL https://github.com/docker/compose/releases/download/v2.7.0/docker-compose-$(uname -s)-$(uname -m) -o /usr/local/bin/docker-compose# curl -SL https://github.com/docker/compose/releases/download/v2.7.0/docker-compose-linux-x86_64 -o /usr/local/bin/docker-compose# 若无法下载,则科学上网# sudo curl -L https://get.daocloud.io/docker/compose/releases/download/1.25.1/docker-compose-`uname -s`-`uname -m` \#-o /usr/local/bin/docker-compose#下载最新版$ curl -L https://get.daocloud.io/docker/compose/releases/download/v2.10.2/docker-compose-`uname -s`-`uname -m` \> /usr/local/bin/docker-compose# 添加执行权限$ sudo chmod +x /usr/local/bin/docker-compose$ sudo ln -s /usr/local/bin/docker-compose /usr/bin/docker-compose$ docker-compose versionDocker Compose version v2.10.2

1.3.4 卸载步骤

$ sudo rm -rf /usr/local/bin/docker-compose

1.4 Docker-compose 使用

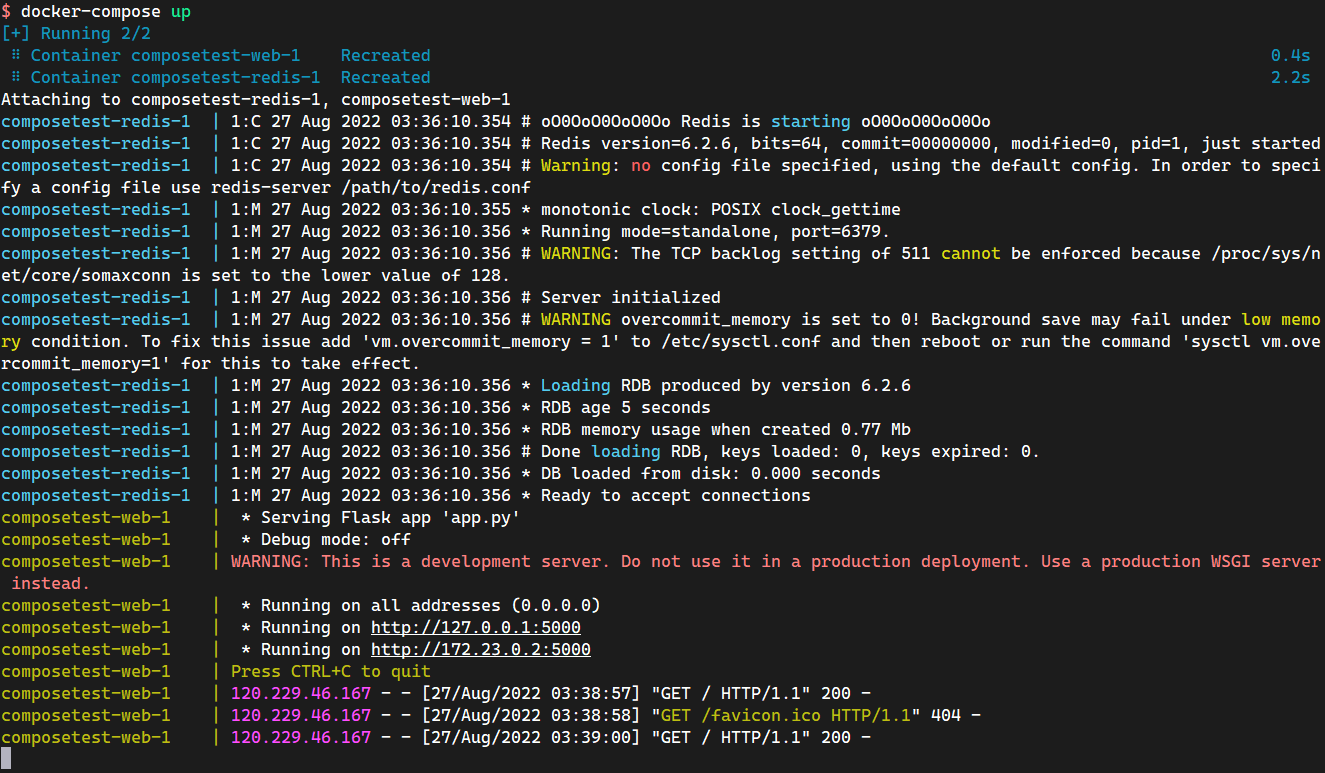

官方文档地址:Get started with Docker Compose 官方使用 Python 应用计数器(涉及Redis) 通过Docker Compose上构建一个简单的python web应用程序,该应用程序使用Flask框架并在Redis中维护一个计数器,用来记录该Web应用被访问的次数。创建一个 app.py Python 文件

$ mkdir -pv /opt/composetest$ cd /opt/composetest

在您的项目目录中创建另一个名为 requirements.txt 的文件,并将其粘贴到:

import timeimport redisfrom flask import Flaskapp = Flask(__name__)cache = redis.Redis(host='redis', port=6379)def get_hit_count():retries = 5while True:try:return cache.incr('hits')except redis.exceptions.ConnectionError as exc:if retries == 0:raise excretries -= 1time.sleep(0.5)@app.route('/')def hello():count = get_hit_count()return 'Hello World! I have been seen {} times.\n'.format(count)

创建 Dockerfile

cat > requirements.txt <<EOFflaskredisEOF

定义一个 docker-compose

$ vim Dockerfile# syntax=docker/dockerfile:1FROM python:3.7-alpineWORKDIR /codeENV FLASK_APP=app.pyENV FLASK_RUN_HOST=0.0.0.0RUN apk add --no-cache gcc musl-dev linux-headersCOPY requirements.txt requirements.txtRUN pip install -r requirements.txtEXPOSE 5000COPY . .CMD ["flask", "run"]#这告诉Docker:# 从Python 3.6映像开始构建映像。# 将当前目录添加.到/ code映像中的路径中。# 将工作目录设置为/code。# 安装Python依赖项。# 将容器的默认命令设置为python app.py .

查看目录树并运行 docker-compose

$ vim docker-compose.ymlversion: "3.9"services:web:build: .#修改了 ports 宿主机的暴露端口,默认官网是8000:5000ports:- "8010:5000"redis:image: "redis:alpine"

$ ls -ltotal 16-rw-r--r-- 1 root root 514 Aug 27 11:19 app.py-rw-r--r-- 1 root root 111 Aug 27 11:24 docker-compose.yml-rw-r--r-- 1 root root 281 Aug 27 11:22 Dockerfile-rw-r--r-- 1 root root 12 Aug 27 11:21 requirements.txt$ docker-compose up

$ curl 139.198.105.99:8010Hello World! I have been seen 3 times.

$ docker-compose lsNAME STATUS CONFIG FILEScomposetest running(2) /root/docker-compose/composetest/docker-compose.yml

:::color1

- 应用 app.py

- Dockerfile 应用打包为镜像

- Docker-compose.yml 文件(定义整个服务,需要的环境,Web,Redis)完整的上线服务!

- 启动 Compose 项目(docker-compose up)

:::

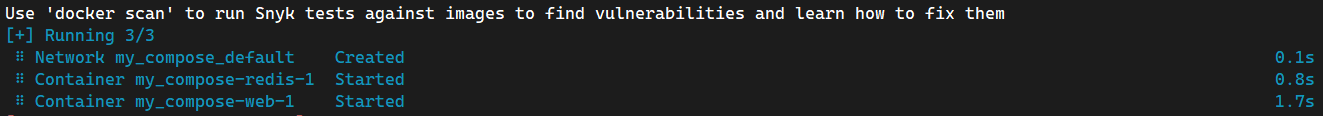

流程:- 创建网络

- 执行 docker-compose up

- 启动服务 docker-compose.yml

默认的服务名 服务名_服务名-num

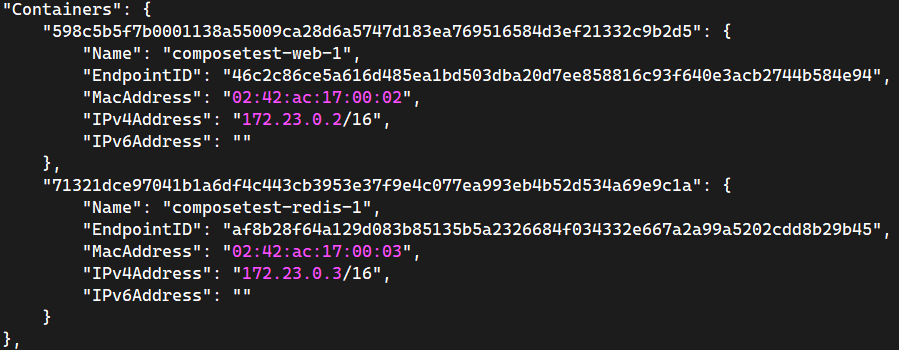

[+] Running 3/3⠿ Network composetest_default Created 0.1s⠿ Container composetest-redis-1 Created 0.3s⠿ Container composetest-web-1 Created 0.3s#composetest-web-1 格式:#1.文件夹名 composetest#2.docker-compose.yml 中定义了 services(服务):$ cat docker-compose.ymlversion: "3"services:web:build: .ports:- "8010:5000"redis:image: "redis:alpine"#查看composetest项目的镜像$ docker imagesREPOSITORY TAG IMAGE ID CREATED SIZEcomposetest_web latest 1677ee6e9825 About an hour ago 185MBredis alpine 3900abf41552 9 months ago 32.4MBpython 3.7-alpine a1034fd13493 9 months ago 41.8MB#查看composetest项目创建的容器$ docker ps | grep composetest71321dce9704 redis:alpine "docker-entrypoint.s…" 55 minutes ago Up 55 minutes 6379/tcp composetest-redis-1598c5b5f7b00 composetest_web "flask run" 55 minutes ago Up 55 minutes 0.0.0.0:8010->5000/tcp, :::8010->5000/tcp composetest-web-1

- num:副本数量

#3.网络规则$ docker network lsNETWORK ID NAME DRIVER SCOPEcf80f623fe5f composetest_default bridge local#Docker Compose在项目中的内容都在同一个网络下。可以通过域名访问。#Docker 在每一个项目中都会维护一个各自的网络。$ docker network inspect composetest_default

#停止 docker-compose 服务#需要在docker-compose 的项目目录下执行$ docker-compose down或者使用 Ctrl + C终止服务

:::color1

在没有使用 docker-compose 之前,都是单个 docker run 启动容器,如果启动多个容器,那么操作起来十分麻烦 使用 docker-compose 之后,通过 docker-compose 编写的 yaml 配置文件,只需要docker-compose up 就可以一键启动多个容器,十分的方便。以及一键停止服务。 需要注意的是:docker compose 是用于单个机器上的容器编排工具,而 Docker Swarm 和 主流的K8s 则是集群级别的容器编排工具(通俗的说就是多台机器上的容器编排工具):::

Docker 小结: 1、Docker 镜像;docker run —> 容器 2、Dockerfile 构建镜像(服务打包) 3、docker-compose 启动项目(编排、多个微服务 / 环境) 4、Docker 网络!1.5 Yaml 规则

docker-compose.yml 文件Docker-compose 版本和 Docker 引擎是对应,并且是向下兼容的特性。Docker-compose.yml 官方文档:Compose file version 3 reference

| Compose file format | Docker Engine release |

|---|---|

| Compose specification | 19.03.0+ |

| 3.8 | 19.03.0+ |

| 3.7 | 18.06.0+ |

| 3.6 | 18.02.0+ |

| 3.5 | 17.12.0+ |

| 3.4 | 17.09.0+ |

| 3.3 | 17.06.0+ |

| 3.2 | 17.04.0+ |

| 3.1 | 1.13.1+ |

| 3.0 | 1.13.0+ |

| 2.4 | 17.12.0+ |

| 2.3 | 17.06.0+ |

| 2.2 | 1.13.0+ |

| 2.1 | 1.12.0+ |

| 2.0 | 1.10.0+ |

#docker-compose.yml只有3层version: '' #版本services: #服务服务名1: web#服务配置image: nginxcontainer_name: nginx01build: .networks:服务名2: redis......服务名3: mysql......#其他配置: 网络/卷挂载/全局规则networks:volumes:configs:

:::color1

只要多写,多看,Docker-compose.yml 配置! 1、官网文档:- https://docs.docker.com/compose/compose-file/compose-file-v3/ (目前主流)

- https://docs.docker.com/compose/compose-file/compose-file-v2/

:::

小总结:示例:

version: '3.7' # 指定 compose 文件的版本services: # 定义所有的 service 信息, services 下面的第一级别的 key 既是一个 service 的名称aaa: #服务aaabuild: # 与image二选一,指定包含构建上下文的路径, 或作为一个对象,该对象具有 context 和指定的 dockerfile 文件以及 args 参数值context: . # context: 指定 Dockerfile 文件所在的路径dockerfile: Dockerfile # dockerfile: 指定 context 指定的目录下面的 Dockerfile 的名称(默认为 Dockerfile)args: # args: Dockerfile 在 build 过程中需要的参数 (等同于 docker container build --build-arg 的作用)JAR_FILE: service.jarcache_from: # v3.2中新增的参数, 指定缓存的镜像列表 (等同于 docker container build --cache_from 的作用)labels: # v3.3中新增的参数, 设置镜像的元数据 (等同于 docker container build --labels 的作用)shm_size: # v3.5中新增的参数, 设置容器 /dev/shm 分区的大小 (等同于 docker container build --shm-size 的作用)#ports:# - "80:80"# - "443:443"ports: # 建立宿主机与容器间的端口映射关系,上面是短语法写法,下面是长语法写法- target: 80 # 容器端口published: 80 # 宿主机端口protocol: tcp # 协议类型mode: host # host在每个节点上发布主机端口,ingress 对于集群模式端口进行负载均衡- target: 443published: 443protocol: tcpmode: hostcommand: # 覆盖容器启动后默认执行的命令, 支持 shell 格式和 [] 格式configs: # 不知道怎么用cgroup_parent: # 为容器指定父 cgroup 组,意味着将继承该组的资源限制。container_name: # 指定容器的名称 (等同于 docker run --name 的作用)deploy: # v3 版本以上, 指定与部署和运行服务相关的配置, deploy 部分是 docker stack 使用的, docker stack 依赖 docker swarmendpoint_mode: vip # v3.3 版本中新增的功能, 指定服务暴露的方式# vip # Docker 为该服务分配了一个虚拟 IP(VIP), 作为客户端的访问服务的地址# dnsrr # DNS轮询, Docker 为该服务设置 DNS 条目, 使得服务名称的 DNS 查询返回一个 IP 地址列表, 客户端直接访问其中的一个地址labels: # 指定服务的标签,这些标签仅在服务上设置mode: replicated # 指定 deploy 的模式# global # 每个集群节点都只有一个容器# replicated # 用户可以指定集群中容器的数量(默认)placement:constraints:- node.role==manager # 不知道怎么用replicas: 1 # deploy 的 mode 为 replicated 时, 指定容器副本的数量resources: # 资源限制limits: # 设置容器的资源限制cpus: "0.5" # 设置该容器最多只能使用 50% 的 CPUmemory: 50M # 设置该容器最多只能使用 50M 的内存空间reservations: # 设置为容器预留的系统资源(随时可用)cpus: "0.2" # 为该容器保留 20% 的 CPUmemory: 20M # 为该容器保留 20M 的内存空间restart_policy: # 定义容器重启策略, 用于代替 restart 参数condition: on-failure # 定义容器重启策略(接受三个参数)# none: # 不尝试重启# on-failure: # 只有当容器内部应用程序出现问题才会重启# any : # 无论如何都会尝试重启(默认)delay: 10s # 尝试重启的间隔时间(默认为 0s)max_attempts: 6 # 尝试重启次数(默认一直尝试重启)window: 120s # 检查重启是否成功之前的等待时间(即如果容器启动了, 隔多少秒之后去检测容器是否正常, 默认 0s)update_config: # 用于配置滚动更新配置parallelism: 1 # 一次性更新的容器数量delay: 10s # 更新一组容器之间的间隔时间order: stop-first # v3.4 版本中新增的参数, 回滚期间的操作顺序# stop-first #旧任务在启动新任务之前停止(默认)# start-first #首先启动新任务, 并且正在运行的任务暂时重叠failure_action: continue # 定义更新失败的策略# continue # 继续更新# rollback # 回滚更新# pause # 暂停更新(默认)# monitor # 每次更新后的持续时间以监视更新是否失败(单位: ns|us|ms|s|m|h) (默认为0)max_failure_ratio: 0 # 回滚期间容忍的失败率(默认值为0)rollback_config: # v3.7 版本中新增的参数, 用于定义在 update_config 更新失败的回滚策略parallelism: 1 # 一次回滚的容器数, 如果设置为0, 则所有容器同时回滚delay: 0 # 每个组回滚之间的时间间隔(默认为0)failure_action: continue # 定义回滚失败的策略# continue # 继续回滚# pause # 暂停回滚monitor: 10s # 每次回滚任务后的持续时间以监视失败(单位: ns|us|ms|s|m|h) (默认为0)max_failure_ratio: 0 # 回滚期间容忍的失败率(默认值0)order: stop-first # 回滚期间的操作顺序# stop-first # 旧任务在启动新任务之前停止(默认)# start-first # 首先启动新任务, 并且正在运行的任务暂时重叠devices: # 指定设备映射列表 (等同于 docker run --device 的作用)depends_on: #依赖容器- db- redisdns: # 设置 DNS 地址(等同于 docker run --dns 的作用)dns_search: # 设置 DNS 搜索域(等同于 docker run --dns-search 的作用)tmpfs: # v2 版本以上, 挂载目录到容器中, 作为容器的临时文件系统(等同于 docker run --tmpfs 的作用, 在使用 swarm 部署时将忽略该选项)entrypoint: # 覆盖容器的默认 entrypoint 指令 (等同于 docker run --entrypoint 的作用)env_file: # 从指定文件中读取变量设置为容器中的环境变量, 可以是单个值或者一个文件列表, 如果多个文件中的变量重名则后面的变量覆盖前面的变量, environment 的值覆盖 env_file 的值RACK_ENV=developmentvolumes: # 定义容器和宿主机的数据卷映射关系- "/u01:/u01" # 映射容器内的 /u01 到宿主机的 /u01目录environment: # 设置环境变量, environment 的值可以覆盖 env_file 的值 (等同于 docker run --env 的作用)- TZ=Asia/Shanghai- PORT_TO_EXPOSE=80- LOG_PATH=/opt/proj/logs- PROFILES_ACTIVE=prodexpose: # 暴露端口, 但是不能和宿主机建立映射关系, 类似于 Dockerfile 的 EXPOSE 指令external_links: # 连接不在 docker-compose.yml 中定义的容器或者不在 compose 管理的容器(docker run 启动的容器, 在 v3 版本中使用 swarm 部署时将忽略该选项)extra_hosts: # 添加 host 记录到容器中的 /etc/hosts 中 (等同于 docker run --add-host 的作用)healthcheck: # v2.1 以上版本, 定义容器健康状态检查, 类似于 Dockerfile 的 HEALTHCHECK 指令test: NONE # 检查容器检查状态的命令, 该选项必须是一个字符串或者列表, 第一项必须是 NONE, CMD 或 CMD-SHELL, 如果其是一个字符串则相当于 CMD-SHELL 加该字符串# NONE # 禁用容器的健康状态检测# CMD # test: ["CMD", "curl", "-f", "http://localhost"]# CMD-SHELL # test: ["CMD-SHELL", "curl -f http://localhost || exit 1"] 或者 test: curl -f https://localhost || exit 1interval: 1m30s # 每次检查之间的间隔时间timeout: 10s # 运行命令的超时时间retries: 3 # 重试次数start_period: 40s # v3.4 以上新增的选项, 定义容器启动时间间隔disable: true # true 或 false, 表示是否禁用健康状态检测和 test: NONE 相同image: # 指定 docker 镜像, 可以是远程仓库镜像、本地镜像init: # v3.7 中新增的参数, true 或 false 表示是否在容器中运行一个 init, 它接收信号并传递给进程isolation: # 隔离容器技术, 在 Linux 中仅支持 default 值labels: # 使用 Docker 标签将元数据添加到容器, 与 Dockerfile 中的 LABELS 类似links: # 链接到其它服务中的容器, 该选项是 docker 历史遗留的选项, 目前已被用户自定义网络名称空间取代, 最终有可能被废弃 (在使用 swarm 部署时将忽略该选项)logging: # 设置容器日志服务driver: # 指定日志记录驱动程序, 默认 json-file (等同于 docker run --log-driver 的作用)options: # 指定日志的相关参数 (等同于 docker run --log-opt 的作用)max-size: # 设置单个日志文件的大小, 当到达这个值后会进行日志滚动操作max-file: # 日志文件保留的数量network_mode: # 指定网络模式 (等同于 docker run --net 的作用, 在使用 swarm 部署时将忽略该选项)networks: # 将容器加入指定网络 (等同于 docker network connect 的作用), networks 可以位于 compose 文件顶级键和 services 键的二级键aliases: # 同一网络上的容器可以使用服务名称或别名连接到其中一个服务的容器ipv4_address # IP V4 格式ipv6_address # IP V6 格式

version: '3.7' # 版本必须3.0及以上,否则无法使用docker-stack 运行services: # 定义 service 信息emcs-nginx:image: "nginx:latest" # 使用指定的 docker 镜像#ports:# - "80:80"# - "443:443"ports: # 建立宿主机与容器间的端口映射关系,上面是短语法写法,下面是长语法写法- target: 80 # 容器端口published: 80 # 宿主机端口protocol: tcp # 协议类型mode: host # host在每个节点上发布主机端口,ingress 对于集群模式端口进行负载均衡- target: 443published: 443protocol: tcpmode: hostvolumes: # 定义容器和宿主机的数据卷映射关系- "/u01:/u01" # 映射容器内的 /u01 到宿主机的 /u01目录environment: # 设置环境变量TZ: Asia/Shanghai # 设置时区为上海deploy: # 指定与部署和运行服务相关的配置, deploy部分是docker stack使用的, docker stack依赖docker swarmmode: replicated # 指定模式:global每个集群节点都只有一个容器,# replicated用户可以指定集群中容器的数量(默认)replicas: 1 # deploy的mode为 replicated 时, 指定容器副本的数量update_config: # 用于配置滚动更新的配置parallelism: 1 # 一次性更新的容器数量delay: 10s # 更新一组容器之间的间隔10sorder: stop-first # 指定回滚期间的操作顺序:stop-first旧任务在启动新任务之前停止(默认),# start-first首先启动新任务, 并且正在运行的任务暂时重叠restart_policy: # 定义容器重启策略, 用于代替 restart 参数condition: on-failure # 定义容器重启策略(接受三个参数):# none不尝试重启;any无论如何都会尝试重启(默认)# on-failure只有当容器内部应用程序出现问题才会重启emcs-front: # 第二个服务image: "***/front"volumes:- "/u01/log:/u01/log"environment:TZ: Asia/Shanghaideploy:mode: replicatedreplicas: 1update_config:parallelism: 1delay: 20sorder: stop-firstrestart_policy:condition: on-failure

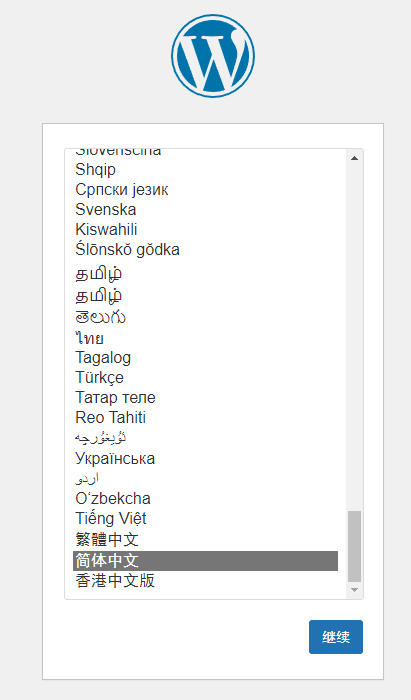

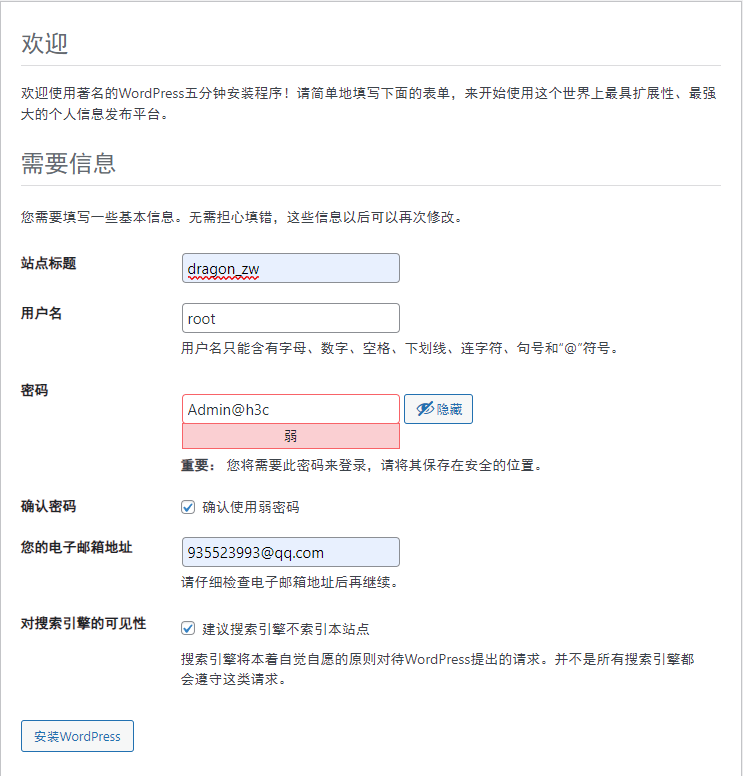

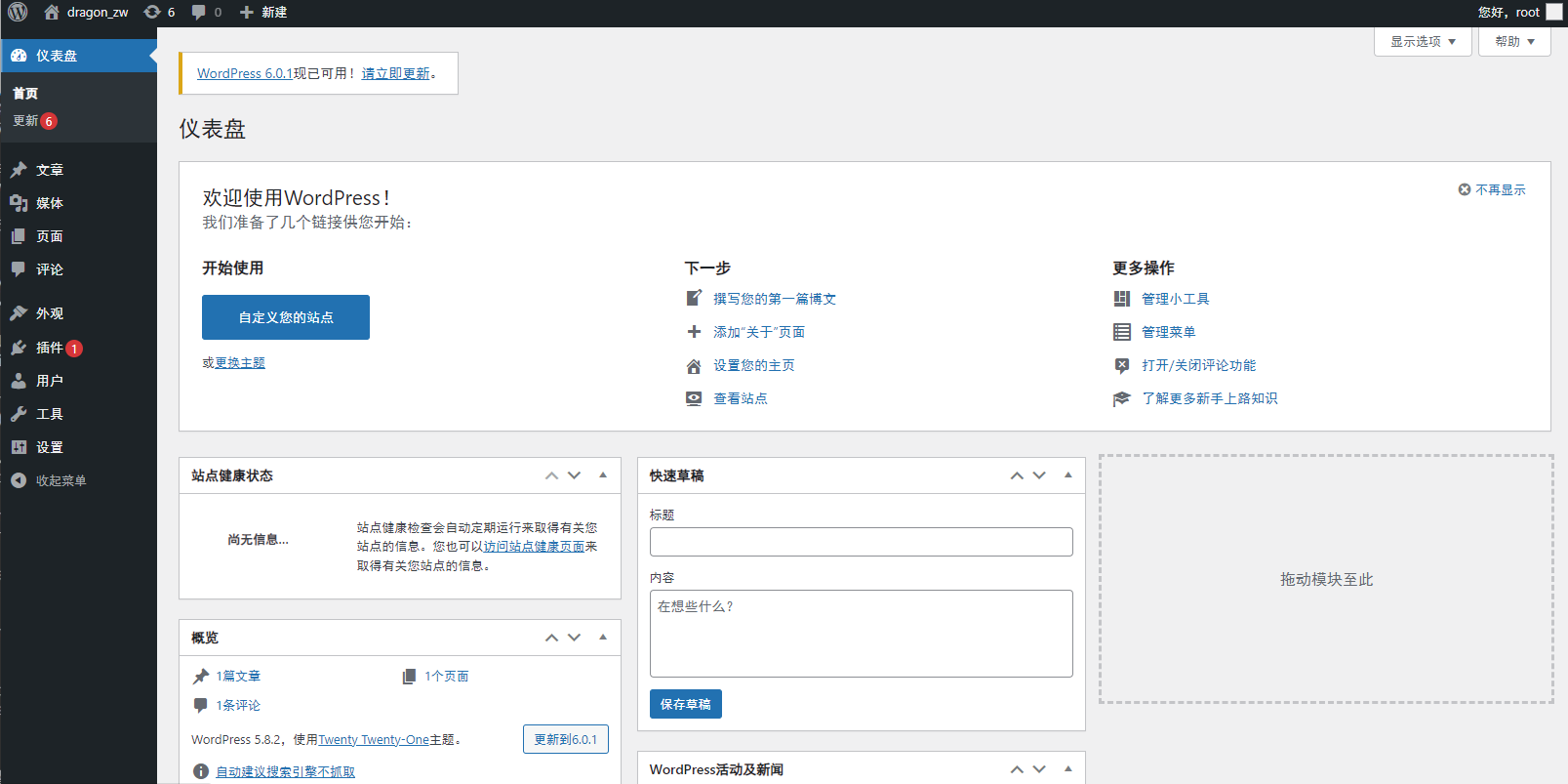

1.6 使用 Compose 一键部署 WordPress 博客

:::color1

传统方式部署博客:- 下载程序,安装数据库,配置……

- compose 应用 => 一键启动

:::

#创建一个项目的文件夹(这就是项目名project)$ mkdir /opt/my_wordpress ; cd /opt/my_wordpress$ vim docker-compose.ymlversion: "3.9"services:db:# We use a mariadb image which supports both amd64 & arm64 architectureimage: mariadb:10.6.4-focal# If you really want to use MySQL, uncomment the following line#image: mysql:8.0.27command: '--default-authentication-plugin=mysql_native_password'volumes:- db_data:/var/lib/mysqlrestart: alwaysenvironment:- MYSQL_ROOT_PASSWORD=somewordpress- MYSQL_DATABASE=wordpress- MYSQL_USER=wordpress- MYSQL_PASSWORD=wordpressexpose:- 3306- 33060wordpress:image: wordpress:latestports:- 80:80volumes:- wordpress_data:/var/www/htmlrestart: alwaysenvironment:- WORDPRESS_DB_HOST=db- WORDPRESS_DB_USER=wordpress- WORDPRESS_DB_PASSWORD=wordpress- WORDPRESS_DB_NAME=wordpressvolumes:db_data: {}wordpress_data: {}#启动项目#-d 后台运行#不加 -d 就是默认前台启动$ docker-compose up -d$ docker psCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES70d3fc3fbb45 wordpress:latest "docker-entrypoint.s…" About a minute ago Up About a minute 0.0.0.0:80->80/tcp, :::80->80/tcp my_wordpress-wordpress-1459eccc745ed mariadb:10.6.4-focal "docker-entrypoint.s…" About a minute ago Up About a minute 3306/tcp, 33060/tcp my_wordpress-db-1$ docker port my_wordpress-wordpress-180/tcp -> 0.0.0.0:8080/tcp -> :::80

http://:80 后续的操作就是 WordPress 根据引导进行部署即可

:::color1

目前的IT主流的技术:Linux + Docker + Kubernetes(掌握) 掌握的技术:Docker 基础、原理、网络、服务、集群、错误排查、日志:::

另一个可用的 WordPress 的 docker-compose.yml 文件:

version: "3.3"services:db:image: mysql:5.7volumes:- db_data:/var/lib/mysqlrestart: alwaysenvironment:MYSQL_ROOT_PASSWORD: somewordpressMYSQL_DATABASE: wordpressMYSQL_USER: wordpressMYSQL_PASSWORD: wordpresswordpress:depends_on:- dbimage: wordpress:latestvolumes:- wordpress_data:/var/www/htmlports:- "8000:80"restart: alwaysenvironment:WORDPRESS_DB_HOST: dbWORDPRESS_DB_USER: wordpressWORDPRESS_DB_PASSWORD: wordpressWORDPRESS_DB_NAME: wordpressvolumes:db_data: {}wordpress_data: {}

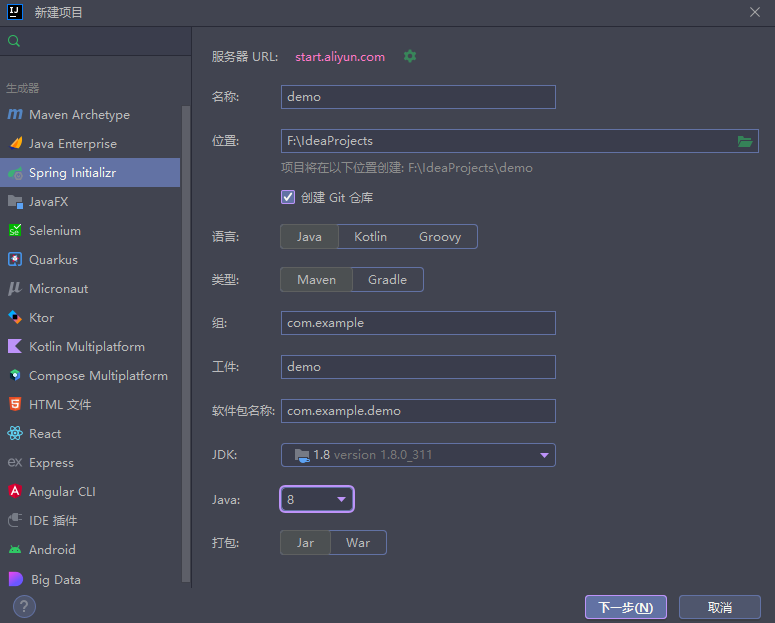

1.7 实战

:::color1

- 编写项目微服务

<font style="color:#000000;">dockerfile</font>构建相应的应用镜像<font style="color:#000000;">docker-compose.yml</font>编排项目- 打包上传到服务器

<font style="color:#000000;">docker-compose up -d</font>即可

:::

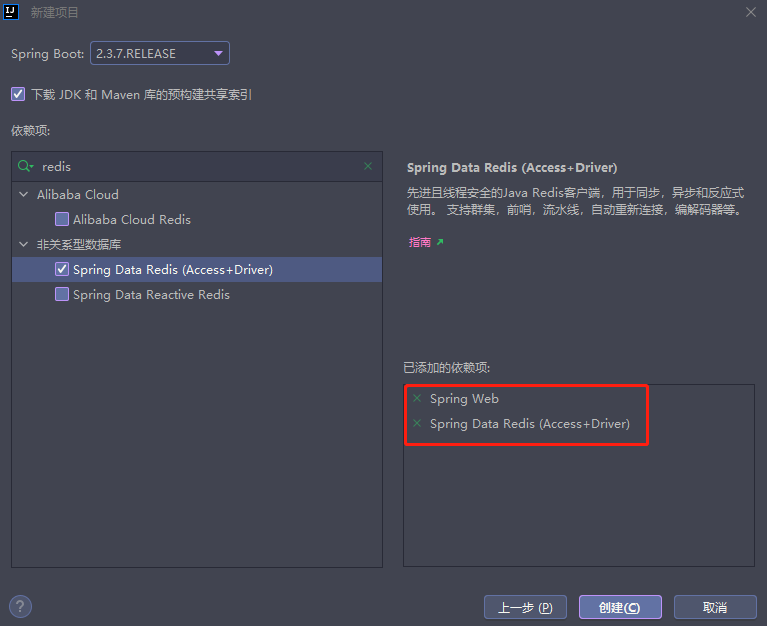

1.7.1 使用 IDEA 创建项目

1.7.2 配置IDEA项目的应用

范例:application.properties 示例

package com.example.demo.controller;import org.springframework.beans.factory.annotation.Autowired;import org.springframework.data.redis.core.RedisTemplate;import org.springframework.web.bind.annotation.GetMapping;import org.springframework.web.bind.annotation.RestController;@RestControllerpublic class HelloController {@AutowiredRedisTemplate redisTemplate;@GetMapping("/hello")public String hello() {Long view = redisTemplate.opsForValue().increment("views");return "Hello, kubesphere, Thank you! views:"+view;}}

范例:Dockerfile 示例

package com.example.demo;import org.springframework.boot.SpringApplication;import org.springframework.boot.autoconfigure.SpringBootApplication;@SpringBootApplicationpublic class DemoApplication {public static void main(String[] args) {SpringApplication.run(DemoApplication.class, args);}}

范例:docker-compose.yml 示例

#配置基础镜像FROM java:8#拷贝jar包到容器内ADD *.jar /app.jar#执行命令CMD ["--server.port=8080"]#提示指定的暴露端口EXPOSE 8080#执行命令ENTRYPOINT ["java", "-jar", "/app.jar"]

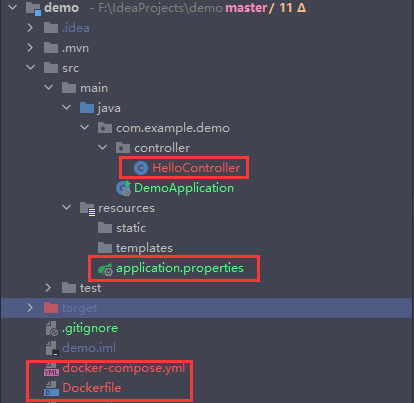

服务器上操作

version: "3"services:web:build: .image: web:1.0ports:- 8080:8080depends_on:- redisredis:image: "redis:alpine"

$ mkdir /opt/my_compose ; cd /opt/my_compose#将文件进行上传$ ls -l /opt/my_composetotal 25020-rw-r--r-- 1 root root 25609796 Aug 27 14:15 demo-0.0.1-SNAPSHOT.jar-rw-r--r-- 1 root root 192 Aug 27 14:16 docker-compose.yml-rw-r--r-- 1 root root 213 Aug 27 14:16 Dockerfile$ docker-compose up -d$ docker psCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES39f4c347a2da web:1.0 "java -jar /app.jar …" 52 seconds ago Up 50 seconds 0.0.0.0:8080->8080/tcp, :::8080->8080/tcp my_compose-web-16d8ec9e73e2a redis:alpine "docker-entrypoint.s…" 52 seconds ago Up 51 seconds 6379/tcp my_compose-redis-1$ docker network lsNETWORK ID NAME DRIVER SCOPE978e62f6ef2c my_compose_default bridge local

:::color1

未来项目只要有 docker-compose.yml 文件。按照这个规则,启动编排容器即可!:::

范例:进行测试假设项目要重新部署打包

$ curl 10.0.0.101:8080/helloHello, kubesphere, Thank you! views:1$ curl 10.0.0.101:8080/helloHello, kubesphere, Thank you! views:2

docker-compose up --build#重新构建镜像

1.8 Docker-compose 常用的命令

:::warning

Compose 常用命令- docker-compose -h —-> 查看帮助

- docker-compose up —-> 启动所有docker-compose服务

<font style="color:#000000;">docker-compose up -d ---> 启动服务 docker-compose 服务,并后台运行</font><font style="color:#000000;">docker-compose down ---> 停止并删除容器、网络、卷、镜像</font>- docker-compose up —build —-> 重新构建项目镜像

- docker-compose exec yml里面的服务id —-> 进入容器实例内部 docker-compose exec

<font style="color:#000000;">docker-compose.yml文件中写的服务id</font>/bin/bash - docker-compose ps —-> 展示当前 docker-compose 编排过的运行的所有容器

- docker-compose top —-> 展示当前 docker-compose 编排过的容器进程

- docker-compose logs yml里面的服务id —-> 检查容器输出日志

<font style="color:#000000;">docker-compose config ---> 检查配置</font><font style="color:#000000;">docker-compose config -q ---> 检查配置,有问题才有输出</font>- docker-compose restart —-> 重启服务

- docker-compose start —-> 启动服务

- docker-compose stop —-> 停止服务

:::

1.9 小总结:

工程Project,服务Services,容器Container 项目 docker-compose :三层:- 工程:project

- 服务:services

- 容器:运行实例!

2 Docker Swarm

集群方式的部署。4台服务器(性能配置:2C4G)可以使用云服务器或者是虚拟机即可。 服务器准备完毕后!3 主 3 从 的集群环境。2.1 4台机器环境配置

我们使用的是(entOS 7 (64-bit) 目前,CentOS仅发行版本中的内核支持Docker。 Docker运行在CentOS 7 上,要求系统为64位、系统内核版本为3.10以上。 尽量使用阿里云进行实验,其内部网络通信十分的快速。 集群规划| 角色 | 操作系统 | 主机名 | IP地址(尽量使用非10网段) | 配置参数 |

|---|---|---|---|---|

| Swarm Manager | CentOS 7.9.2009 | docker-master | 10.0.0.101 | 1C2G |

| Swarm Node | CentOS 7.9.2009 | docker-node1 | 10.0.0.102 | 1C2G |

| Swarm Node | CentOS 7.9.2009 | docker-node2 | 10.0.0.103 | 1C2G |

| Swarm Node | CentOS 7.9.2009 | docker-node3 | 10.0.0.104 | 1C2G |

查看自己的内核

uname -r 命令用于打印当前系统相关信息(内核版本号、硬件架构、主机名称和操作系统类型等)。

$ uname -r3.10.0-1160.el7.x86_64

查看版本信息

cat /etc/os-release关闭防火墙以及SElinux功能

$ cat /etc/os-releaseNAME="CentOS Linux"VERSION="7 (Core)"ID="centos"ID_LIKE="rhel fedora"VERSION_ID="7"PRETTY_NAME="CentOS Linux 7 (Core)"ANSI_COLOR="0;31"CPE_NAME="cpe:/o:centos:centos:7"HOME_URL="https://www.centos.org/"BUG_REPORT_URL="https://bugs.centos.org/"CENTOS_MANTISBT_PROJECT="CentOS-7"CENTOS_MANTISBT_PROJECT_VERSION="7"REDHAT_SUPPORT_PRODUCT="centos"REDHAT_SUPPORT_PRODUCT_VERSION="7"

systemctl disable --now firewalld#对于此测试,您需要两个可以相互通信的不同 Docker 主机。每个主机必须在两个 Docker 主机之间打开以下端口:TCP 端口 2377TCP 和 UDP 端口 7946UDP 端口 4789#设置此设置的一种简单方法是拥有两个 VM(本地或 AWS 等云提供商),每个 VM 都已安装并运行 Docker。#如果您使用的是 AWS 或类似的云计算平台,最简单的配置是使用安全组,#该安全组打开两台主机之间的所有传入端口以及来自客户端 IP 地址的 SSH 端口。#若不关闭防火墙,则需要放通相关的端口firewall-cmd --zone=public --add-port=2377/tcp --permanentfirewall-cmd --zone=public --add-port=7946/tcp --permanentfirewall-cmd --zone=public --add-port=7946/udp --permanentfirewall-cmd --zone=public --add-port=4789/tcp --permanentfirewall-cmd --zone=public --add-port=4789/udp --permanentfirewall-cmd --reloadsetenforce 0sed -i -r '/^SELINUX=/s@(.*)=(.*)@\1=disabled@g' /etc/selinux/config

2.2 安装步骤

1、官网安装参考手册: https://docs.docker.cam/enginelinstall/centos/ 2、确定你是CentOS7及以上版本,我们已经做过了 3、yum安装gcc相关环境(需要确保虚拟机可以上外网)4、卸载旧版本

curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repoyum install -y gcc gcc-c++

5、安装需要的软件包

$ sudo yum remove docker \docker-client \docker-client-latest \docker-common \docker-latest \docker-latest-logrotate \docker-logrotate \docker-engine

6、设置镜像仓库

$ sudo yum install -y yum-utils

7、更新yum软件包的索引

#设置镜像的仓库,默认是国外的$ sudo yum-config-manager \--add-repo \https://download.docker.com/linux/centos/docker-ce.repo#推荐使用阿里云的,速度快$ sudo yum-config-manager \--add-repo \https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

8、安装 Docker-CE

#更新yum软件包的索引$ yum makecache fast

9、启动 Docker

#5.安装Docker相关的 Docker-ce社区版,ee则是企业版$ sudo yum install -y \docker-ce docker-ce-cli containerd.io docker-compose-plugin

10、测试命令

#启动Docker$ systemctl enable --now docker

11、卸载 Docker

#查看Docker的信息$ docker version#判断Docker是否安装成功#运行helloworld$ sudo docker run hello-world#查看镜像$ docker images

$ systemctl stop docker$ sudo yum remove -y \docker-ce docker-ce-cli containerd.io docker-compose-plugin$ rm -rf /var/lib/docker

2.3 配置 Docker 镜像加速器

sudo mkdir -p /etc/dockersudo tee /etc/docker/daemon.json <<-'EOF'{"registry-mirrors": ["https://po13h3y1.mirror.aliyuncs.com","http://hub-mirror.c.163.com","https://mirror.ccs.tencentyun.com","http://f1361db2.m.daocloud.io"]}EOFsudo systemctl daemon-reloadsudo systemctl restart docker

2.4 Docker Swarm 介绍

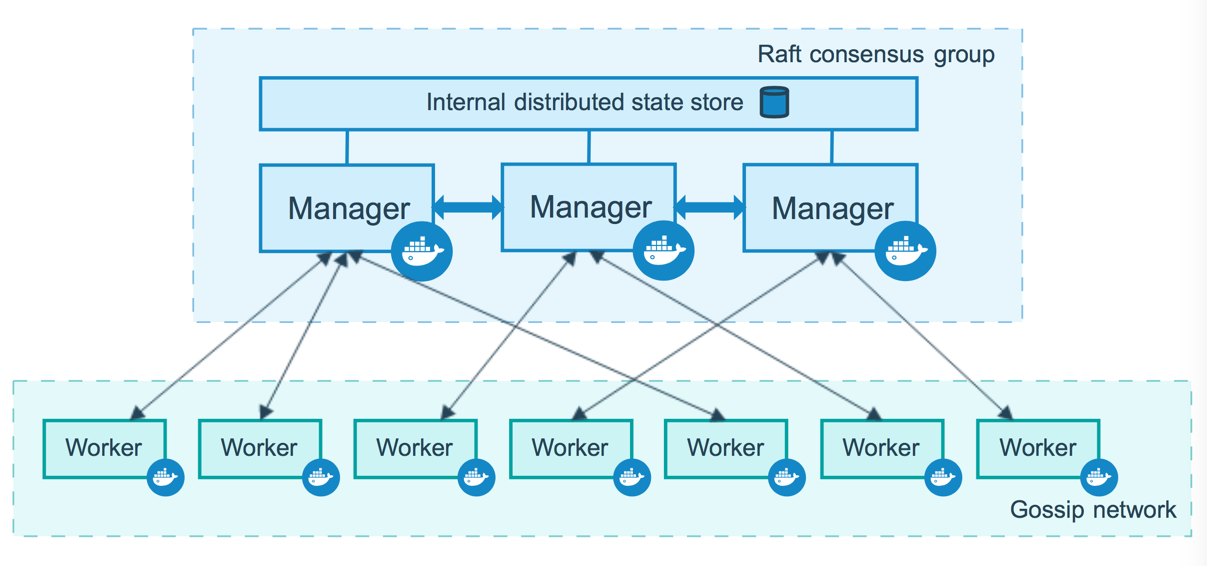

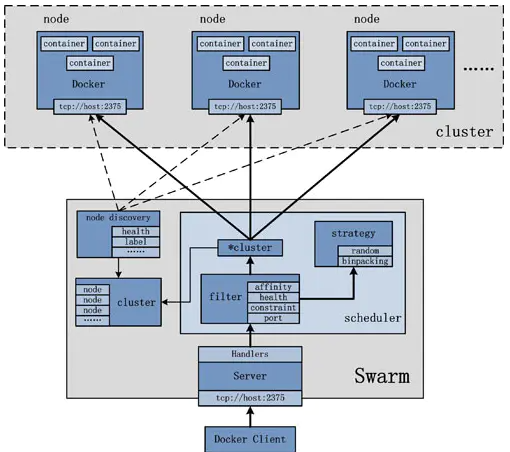

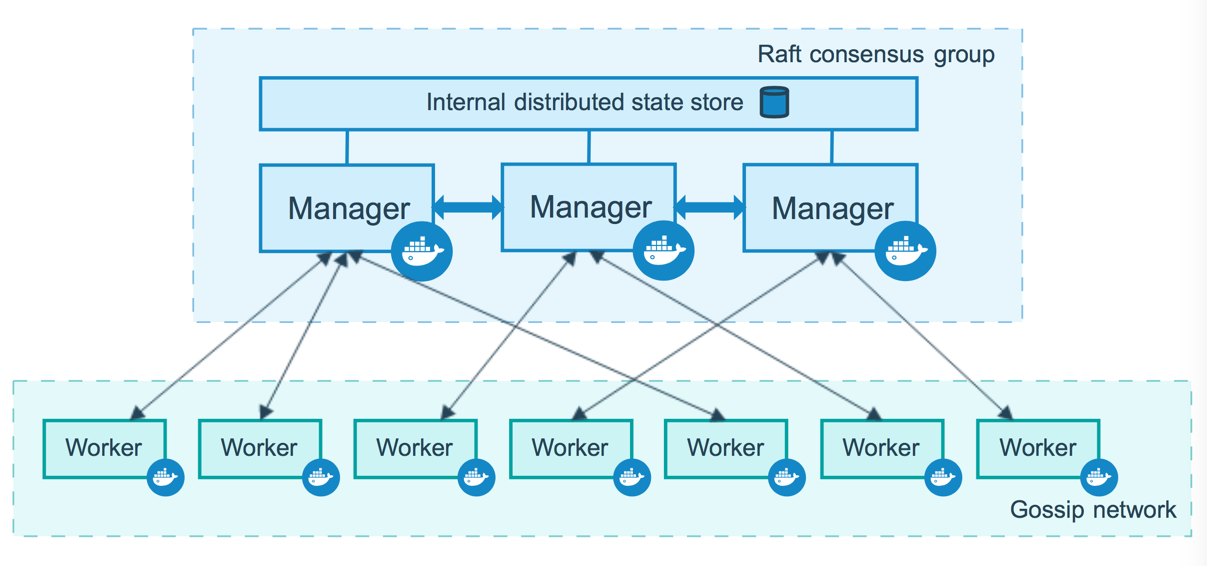

Docker Engine 1.12 引入了集群模式,允许你创建一个或多个Docker引擎的集群,称为群。集群由一个或多个节点组成:集群模式下运行Docker Engine 1.12或更高版本的物理或虚拟机。 有两种类型的节点 : managers 和 workers.

2.4.1 Docker Swarm 几个关键信息

- Swarm

- Node

- Service

- Task

2.4.2 Docker Swarm 的命令使用方法

docker swarm:集群管理,子命令有init, join, leave, update。(docker swarm —help查看帮助) docker node:节点管理,子命令有accept, promote, demote, inspect, update, tasks, ls, rm。(docker node —help查看帮助) docker service:服务创建,子命令有create, inspect, update, remove, tasks。(docker service—help查看帮助)2.4.3 总结

node是加入到swarm集群中的一个docker引擎实体,可以在一台物理机上运行多个node,node分为:- manager nodes,也就是管理节点

- worker nodes,也就是工作节点

- service是运行在worker nodes上的task的描述,service的描述包括使用哪个docker 镜像,以及在使用该镜像的容器中执行什么命令。

2.5 搭建 Swarm 集群

范例:初始化 Docker Swarm 集群

$ docker network lsNETWORK ID NAME DRIVER SCOPEf8457b0dde69 bridge bridge local7e2416a3754e host host localefedf7a831e1 none null local#配置内核参数$ cat >> /etc/sysctl.conf <<EOFnet.bridge.bridge-nf-call-ip6tables=1net.bridge.bridge-nf-call-iptables=1net.bridge.bridge-nf-call-arptables=1net.ipv4.ip_forward=1EOF$ sysctl -p$ systemctl restart network#查看Swarm 帮助$ docker swarm --helpUsage: docker swarm COMMANDManage SwarmCommands:ca Display and rotate the root CAinit Initialize a swarmjoin Join a swarm as a node and/or managerjoin-token Manage join tokensleave Leave the swarmunlock Unlock swarmunlock-key Manage the unlock keyupdate Update the swarmRun 'docker swarm COMMAND --help' for more information on a command.$ docker swarm init --helpUsage: docker swarm init [OPTIONS]Initialize a swarmOptions:--advertise-addr string Advertised address (format: <ip|interface>[:port])--autolock Enable manager autolocking (requiring an unlock key to start a stopped manager)--availability string Availability of the node ("active"|"pause"|"drain") (default "active")--cert-expiry duration Validity period for node certificates (ns|us|ms|s|m|h) (default 2160h0m0s)--data-path-addr string Address or interface to use for data path traffic (format: <ip|interface>)--data-path-port uint32 Port number to use for data path traffic (1024 - 49151). If no value is set oris set to 0, the default port (4789) is used.--default-addr-pool ipNetSlice default address pool in CIDR format (default [])--default-addr-pool-mask-length uint32 default address pool subnet mask length (default 24)--dispatcher-heartbeat duration Dispatcher heartbeat period (ns|us|ms|s|m|h) (default 5s)--external-ca external-ca Specifications of one or more certificate signing endpoints--force-new-cluster Force create a new cluster from current state--listen-addr node-addr Listen address (format: <ip|interface>[:port]) (default 0.0.0.0:2377)--max-snapshots uint Number of additional Raft snapshots to retain--snapshot-interval uint Number of log entries between Raft snapshots (default 10000)--task-history-limit int Task history retention limit (default 5)#查看容器网络$ docker network lsNETWORK ID NAME DRIVER SCOPE0419346c0041 bridge bridge local7e2416a3754e host host locallx0i51ag13ge ingress overlay swarmefedf7a831e1 none null local

#初始化节点 docker swarm init #docker swarm join 加入一个 Node 节点!

# --autolock 启用管理器自动锁定(需要解锁钥匙才能启动已停止的管理器)$ docker swarm init --advertise-addr 10.0.0.101 --autolock=falseSwarm initialized: current node (99uy33e0bqj9vpsgff5m8dhdo) is now a manager.To add a worker to this swarm, run the following command:docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-c0shttrcji8oh9kqecq547zgl 10.0.0.101:2377To add a manager to this swarm, run 'docker swarm join-token manager' and follow the instructions.

#docker-node1节点加入到 docker swarm 集群docker-node1 $ docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-c0shttrcji8oh9kqecq547zgl 10.0.0.101:2377This node joined a swarm as a worker.

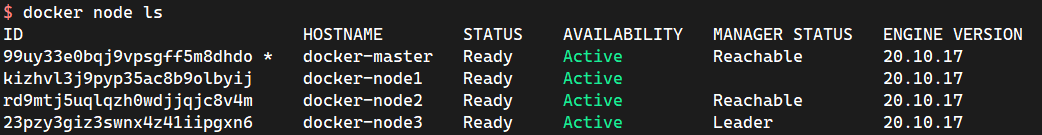

#docker node ls 查看 Docker Swarm 集群节点情况

#获取令牌(Master)docker swarm join-token manager#获取令牌(Worker)docker swarm join-token worker

#docker swarm join 加入一个 Node 节点!

#只有 Manager 节点才能运行该命令$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo * docker-master Ready Active Leader 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17#普通节点运行会报错$ docker node lsError response from daemon: This node is not a swarm manager. Worker nodes can't be used to view or modify cluster state. Please run this command on a manager node or promote the current node to a manager.

#docker swarm join 加入一个 Manager 节点!

#在 Docker Swarm Manager 节点生成一串 Worker 令牌$ docker swarm join-token workerTo add a worker to this swarm, run the following command:docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-c0shttrcji8oh9kqecq547zgl 10.0.0.101:2377#docker-node2节点加入到 docker swarm 集群docker-node2 $ docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-c0shttrcji8oh9kqecq547zgl 10.0.0.101:2377#查看 Docker Swarm 集群节点情况$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo * docker-master Ready Active Leader 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17m23f84nx9fjjsplo3yjpqu61n docker-node2 Ready Active 20.10.17

这就将 Docker Swarm 集群搭建完毕了

#在 Docker Swarm Manager 节点生成一串 Manager 令牌$ docker swarm join-token managerTo add a manager to this swarm, run the following command:docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-el7umy9l5k946v874i5g33tn4 10.0.0.101:2377#docker-node3节点加入到 docker swarm 集群docker-node3 $ docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-el7umy9l5k946v874i5g33tn4 10.0.0.101:2377#查看 Docker Swarm 集群节点情况(docker-master | docker-node3均可以运行)$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo docker-master Ready Active Leader 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17m23f84nx9fjjsplo3yjpqu61n docker-node2 Ready Active 20.10.1723pzy3giz3swnx4z41iipgxn6 * docker-node3 Ready Active Reachable 20.10.17

#两台Manager节点和两个Worker节点#集群其实至少要三台Manager节点(要确保大多数的情况),即奇数个Manager节点$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo * docker-master Ready Active Leader 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17m23f84nx9fjjsplo3yjpqu61n docker-node2 Ready Active 20.10.1723pzy3giz3swnx4z41iipgxn6 docker-node3 Ready Active Reachable 20.10.17

2.5.1 部署 Docker Swarm 健康服务

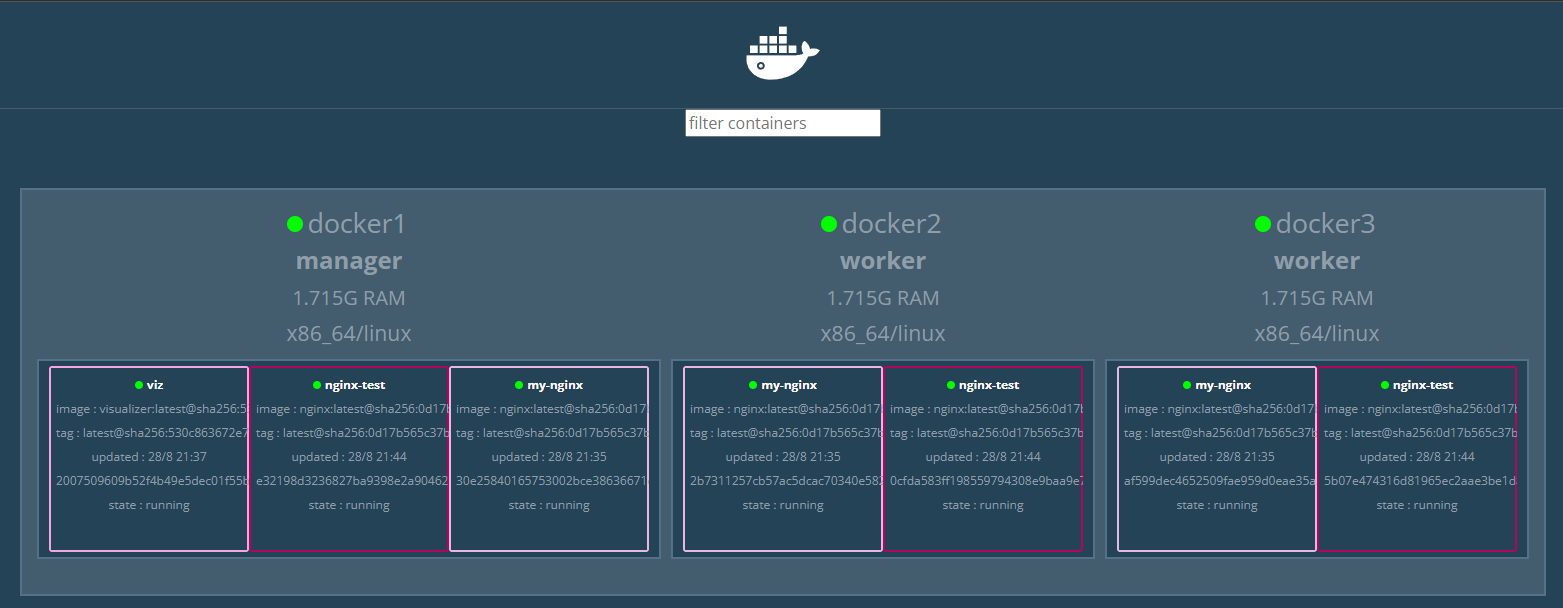

Visualizer非常直观地显示了Swarm集群中,服务器的状态和服务器上面运行容器的状态。Visualizer会占用8080、5000端口,应该规划好,避免使用这两个端口。

#拉取镜像docker pull dockersamples/visualizer#部署监控服务 (#端口不能冲突)docker service create --name viz \--publish 8080:8080/tcp \--constraint=node.role==manager \--mount=type=bind,src=/var/run/docker.sock,dst=/var/run/docker.sock \dockersamples/visualizer

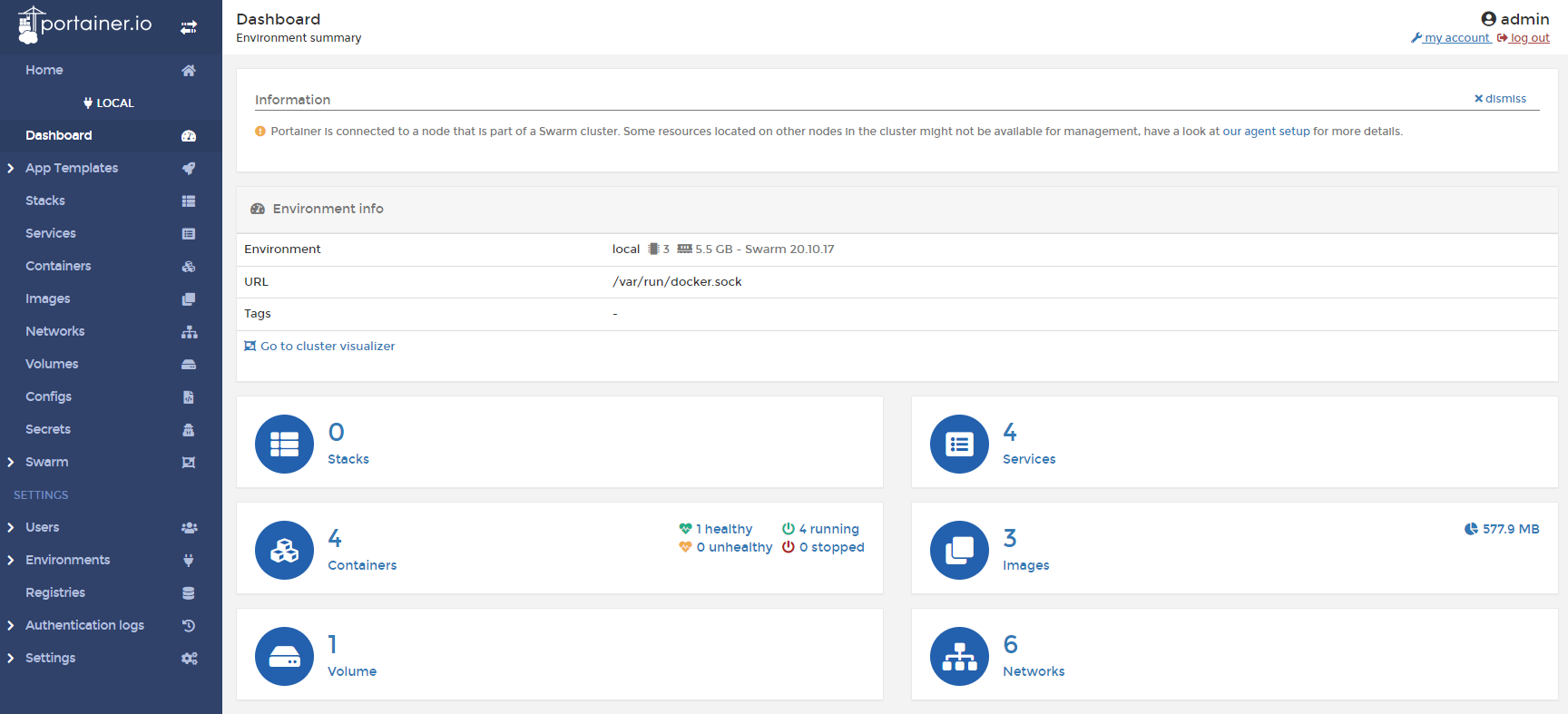

2.5.2 部署 Portainer 图形化集群管理工具

Portainer 是一款轻量级的应用,它提供了图形化界面,用于方便的管理Docker环境,包括单机环境和集群环境(毫不犹豫直接使用 K8S)。用于监控和统计。Portainer 官方站点

官网:https://www.portainer.io/ 安装文档:Install Portainer with Docker on Linux - Portainer Documentation + Rancher (CI/CD使用) + Portainer 先执行使用 Docker图形化界面管理工具!提供一个后台面板供我们操作!bash

$ docker volume create portainer_data

$ docker service create -p 8000:8000 -p 9443:9443 \

--name portainer \

--constraint=node.role==manager \

--mount=type=bind,src=/var/run/docker.sock,dst=/var/run/docker.sock \

--mount src=portainer_data,dst=/data \

portainer/portainer-ce:2.9.3

#访问测试:

#外网:http://IP地址:9443

$ curl -k https://localhost:9443

可以查看相关的Docker面板情况

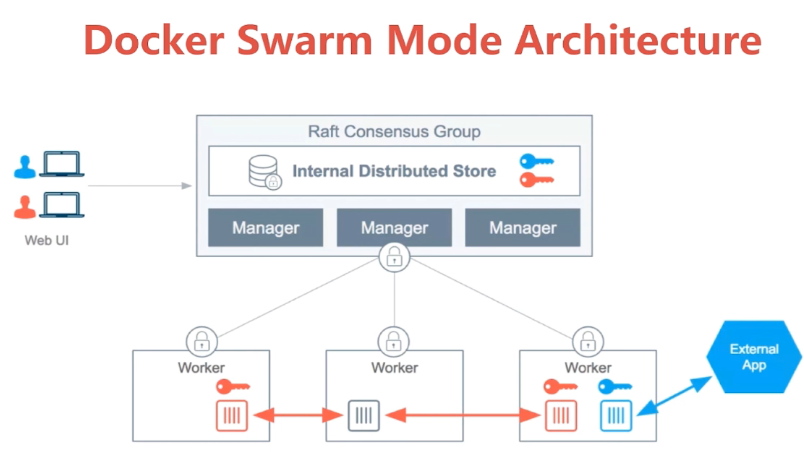

## 2.6 Raft 协议

当 Docker Engine 以 swarm 模式运行时,管理器节点实现 Raft 共识算法来管理全局集群状态。

为什么原因Docker群模式是使用一个共识算法,以确保那些负责在集群中的管理和调度任务的所有经理节点,都存储相同一致的状态。

在整个集群中具有相同的一致状态意味着在发生故障时,任何 Manager 节点都可以接收任务并将服务恢复到稳定状态。例如,如果集群中负责调度任务的Leader Manager意外终止,任何其他 Manager 都可以接手调度的任务并重新平衡任务以匹配所需的状态。

使用共识算法在分布式系统中复制日志的系统确实需要特别小心。它们通过要求大多数节点就值达成一致来确保集群状态在出现故障时保持一致。

Raft 最多可以容忍(N-1)/2失败,并且需要大多数或法定人数的 (N/2)+1成员就提议给集群的值达成一致。这意味着在运行 Raft 的 5 个 Manager 的集群中,如果 3 个节点不可用,系统将无法处理更多请求以安排额外的任务。现有任务继续运行,但如果管理器集不健康,则调度程序无法重新平衡任务以应对故障。

群体模式下共识算法的实现意味着它具有分布式系统固有的特性:

## 2.6 Raft 协议

当 Docker Engine 以 swarm 模式运行时,管理器节点实现 Raft 共识算法来管理全局集群状态。

为什么原因Docker群模式是使用一个共识算法,以确保那些负责在集群中的管理和调度任务的所有经理节点,都存储相同一致的状态。

在整个集群中具有相同的一致状态意味着在发生故障时,任何 Manager 节点都可以接收任务并将服务恢复到稳定状态。例如,如果集群中负责调度任务的Leader Manager意外终止,任何其他 Manager 都可以接手调度的任务并重新平衡任务以匹配所需的状态。

使用共识算法在分布式系统中复制日志的系统确实需要特别小心。它们通过要求大多数节点就值达成一致来确保集群状态在出现故障时保持一致。

Raft 最多可以容忍(N-1)/2失败,并且需要大多数或法定人数的 (N/2)+1成员就提议给集群的值达成一致。这意味着在运行 Raft 的 5 个 Manager 的集群中,如果 3 个节点不可用,系统将无法处理更多请求以安排额外的任务。现有任务继续运行,但如果管理器集不健康,则调度程序无法重新平衡任务以应对故障。

群体模式下共识算法的实现意味着它具有分布式系统固有的特性:

- 容错系统中的值达成一致。

- 通过领导人选举过程相互排斥

- 集群成员管理

- 全局一致的对象排序和 CAS(比较和交换)

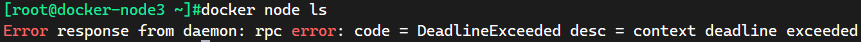

目前实验环境:两台Manager节点和两个Worker节点:假设一个节点挂了!其他节点是否可以用! Raft 协议:保证大多数节点存活才可以用,只要>1,集群则至少大于 3台。 实验:Raft 一致性算法 1、将 docker-master 机器停止,宕机!双主,另外一个主节点也不能使用了!

#docker-master机器停止docker服务$ systemctl stop dockerWarning: Stopping docker.service, but it can still be activated by:docker.socketdocker-node3 $ docker node lsError response from daemon: rpc error: code = DeadlineExceeded desc = context deadline exceede

注意的是:Worker 就是工作节点,无法执行管理节点的操作。目前3台机器已经设置成管理节点了。

#docker-master机器开启docker服务$ systemctl start docker#可以看到docker-master节点状态是Reachable#而docker-node3节点状态是Leader$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo * docker-master Ready Active Reachable 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17m23f84nx9fjjsplo3yjpqu61n docker-node2 Ready Active 20.10.1723pzy3giz3swnx4z41iipgxn6 docker-node3 Ready Active Leader 20.10.17#现在将docker-node2节点设置为Manager节点docker-node2 $ docker swarm leaveNode left the swarm.$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo docker-master Ready Active Reachable 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17#docker-node2在集群中状态是 Downm23f84nx9fjjsplo3yjpqu61n docker-node2 Down Active 20.10.1723pzy3giz3swnx4z41iipgxn6 * docker-node3 Ready Active Leader 20.10.17#删除该Down状态的节点信息$ docker node rm m23f84nx9fjjsplo3yjpqu61nm23f84nx9fjjsplo3yjpqu61n#在Manager节点上生成加入集群的Manager令牌$ docker swarm join-token managerTo add a manager to this swarm, run the following command:docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-el7umy9l5k946v874i5g33tn4 10.0.0.104:2377#docker-node2以 Manager 身份加入到集群中docker-node2 $ docker swarm join --token SWMTKN-1-20u795dhecf4hyuc8rqgmlhcb6d3rvwpn8a3rk3p3jsfilhvrq-el7umy9l5k946v874i5g33tn4 10.0.0.104:2377#再次查看Docker Swarm 节点状态$ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo docker-master Ready Active Reachable 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17rd9mtj5uqlqzh0wdjjqjc8v4m docker-node2 Ready Active Reachable 20.10.1723pzy3giz3swnx4z41iipgxn6 * docker-node3 Ready Active Leader 20.10.17#现在就是三主一从的环境

集群可用!3个主节点。必须要管理节点>1台管理节点的存活

#docker-master机器停止docker服务$ systemctl stop dockerWarning: Stopping docker.service, but it can still be activated by:docker.socket#管理节点的操作依旧可以使用docker-node3 $ docker node lsID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION99uy33e0bqj9vpsgff5m8dhdo docker-master Ready Active Unreachable 20.10.17kizhvl3j9pyp35ac8b9olbyij docker-node1 Ready Active 20.10.17rd9mtj5uqlqzh0wdjjqjc8v4m docker-node2 Ready Active Reachable 20.10.1723pzy3giz3swnx4z41iipgxn6 * docker-node3 Ready Active Leader 20.10.17#docker-node2机器停止docker服务docker-node2 $ systemctl stop dockerWarning: Stopping docker.service, but it can still be activated by:docker.socketdocker-node3 $ docker node lsError response from daemon: rpc error: code = DeadlineExceeded desc = context deadline exceeded

#重新恢复Docker Swarm 的集群状态$ systemctl restart docker

2.7 Docker Swarm 体会

Docker Swarm 弹性,扩缩容,集群环境。 以后要告别 docker run ! docker-compose up 启动一个项目。单机的容器编排工具。 集群:Docker Swarm (docker service)后期的就是 Kubernetes。 docker集群 → 容器是服务 → 服务可以在容器中启动多个(副本数) Nginx 原先要配置负载均衡,需要把对应的服务写在 Nignx 的配置信息里,增加多少个,就写多少个;现在nginx不管这些了,不需要再麻烦的配置了,这就是动态扩缩容吧。灰度发布,金丝雀发布!

#使用 docker 创建一个负载均衡服务 service$ docker service --helpUsage: docker service COMMANDManage servicesCommands:create Create a new serviceinspect Display detailed information on one or more serviceslogs Fetch the logs of a service or taskls List servicesps List the tasks of one or more servicesrm Remove one or more servicesrollback Revert changes to a service's' configurationscale Scale one or multiple replicated servicesupdate Update a serviceRun 'docker service COMMAND --help' for more information on a command.# docker swarm service 特性:#创建服务,动态扩展服务,动态更新服务,日志等

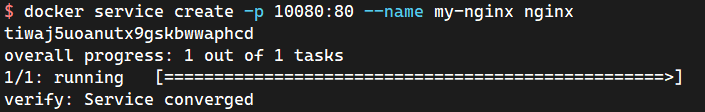

#容器启动!不具有扩缩容的能力$ docker run -it --name my-nginx nignx#服务!具有扩缩容的能力,滚动更新!$ docker service create -p 10080:80 --name my-nginx nginxtiwaj5uoanutx9gskbwwaphcdoverall progress: 1 out of 1 tasks1/1: running [==================================================>]verify: Service converged

范例:实现动态扩缩容

#docker service 需要先做swarm集群#查看docker service服务列表$ docker service lsID NAME MODE REPLICAS IMAGE PORTStiwaj5uoanut my-nginx replicated 1/1 nginx:latest *:10080->80/tcp#查看服务 REPLICAS 副本数#查看 my-nginx 服务在哪个节点上及状态:$ docker service ps my-nginxID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTSw9nlgl140jb0 my-nginx.1 nginx:latest docker-node2 Running Running about a minute ago#查看详细信息$ docker service inspect my-nginx#可以在Worker节点上查看Docker进程docker-node2 $ docker psCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES0c7c9f65a519 nginx:latest "/docker-entrypoint.…" 5 minutes ago Up 5 minutes 80/tcp my-nginx.1.w9nlgl140jb0qkzfr0gttcv41

服务,集群中任意的节点都可以正常访问!

#方法一:使用 docker service scale 进行扩容$ docker service scale --helpUsage: docker service scale SERVICE=REPLICAS [SERVICE=REPLICAS...]Scale one or multiple replicated servicesOptions:-d, --detach Exit immediately instead of waiting for the service to converge$ docker service scale my-nginx=3my-nginx scaled to 3overall progress: 3 out of 3 tasks1/3: running [==================================================>]2/3: running [==================================================>]3/3: running [==================================================>]verify: Service converged#扩容完成后,查看扩容情况$ docker service lsID NAME MODE REPLICAS IMAGE PORTStiwaj5uoanut my-nginx replicated 3/3 nginx:latest *:10080->80/tcp#已经创建了多个副本数$ docker service ps my-nginxID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTSw9nlgl140jb0 my-nginx.1 nginx:latest docker-node2 Running Running 8 minutes agonckmn3z21ijb my-nginx.2 nginx:latest docker-master Running Running about a minute ago6vd1emspxxtr my-nginx.3 nginx:latest docker-node3 Running Running about a minute ago#方法二:使用 docker service update --replicas [int] 进行扩容$ docker service update --replicas 5 my-nginxmy-nginxoverall progress: 5 out of 5 tasks1/5: running [==================================================>]2/5: running [==================================================>]3/5: running [==================================================>]4/5: running [==================================================>]5/5: running [==================================================>]verify: Service converged#扩容完成后,查看扩容情况$ docker service lsID NAME MODE REPLICAS IMAGE PORTStiwaj5uoanut my-nginx replicated 5/5 nginx:latest *:10080->80/tcp$ docker service ps my-nginxID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTSw9nlgl140jb0 my-nginx.1 nginx:latest docker-node2 Running Running 9 minutes agonckmn3z21ijb my-nginx.2 nginx:latest docker-master Running Running 2 minutes ago6vd1emspxxtr my-nginx.3 nginx:latest docker-node3 Running Running 2 minutes agow8phrrpvxrb4 my-nginx.4 nginx:latest docker-node1 Running Running 21 seconds agotf4m0pcr5yvh my-nginx.5 nginx:latest docker-node1 Running Running 21 seconds ago#update 只能扩容。缩容是停止容器而不是rm容器

$ curl 10.0.0.101:10080<!DOCTYPE html><html><head><title>Welcome to nginx!</title><style>html { color-scheme: light dark; }body { width: 35em; margin: 0 auto;font-family: Tahoma, Verdana, Arial, sans-serif; }</style></head><body><h1>Welcome to nginx!</h1><p>If you see this page, the nginx web server is successfully installed andworking. Further configuration is required.</p><p>For online documentation and support please refer to<a href="http://nginx.org/">nginx.org</a>.<br/>Commercial support is available at<a href="http://nginx.com/">nginx.com</a>.</p><p><em>Thank you for using nginx.</em></p></body></html>#云服务器可以安全组放通后,可以直接使用(虚拟机可能会出现一些问题)

2.7.1 Docker Swarm 网络的坑

统一的判断:

- 服务器的防火墙有没有关闭。也可以放通相关的 Docker Swarm 集群端口

#需要放通的端口有:#对于此测试,您需要两个可以相互通信的不同 Docker 主机。Docker 主机之间打开以下端口:TCP 端口 2377TCP 和 UDP 端口 7946UDP 端口 4789#设置此设置的一种简单方法是拥有两个 VM(本地或 AWS 等云提供商),每个 VM 都已安装并运行 Docker。#如果您使用的是 AWS 或类似的云计算平台,最简单的配置是使用安全组,#该安全组打开两台主机之间的所有传入端口以及来自客户端 IP 地址的 SSH 端口。#若不关闭防火墙,则需要放通相关的端口firewall-cmd --zone=public --add-port=2377/tcp --permanentfirewall-cmd --zone=public --add-port=7946/tcp --permanentfirewall-cmd --zone=public --add-port=7946/udp --permanentfirewall-cmd --zone=public --add-port=4789/tcp --permanentfirewall-cmd --zone=public --add-port=4789/udp --permanentfirewall-cmd --reload

- 服务器的主机名需要设置的有意义并且没有冲突

- 需要确认的是服务器的网段是在哪个网段。Docker Swarm 默认服务的 Overlay 网络是在 10 网段,很容易与现网的网段造成冲突。所以服务器网段尽量不要设置成 10 网段的情况,但是一般已经服务器网络无法修改,那么就需要修改 Docker Swarm 默认的 Overlay 网络。(一般以上三点就可以排查出”为什么 Docker Swarm 部署的服务,集群各节点无法正常通信的情况”)

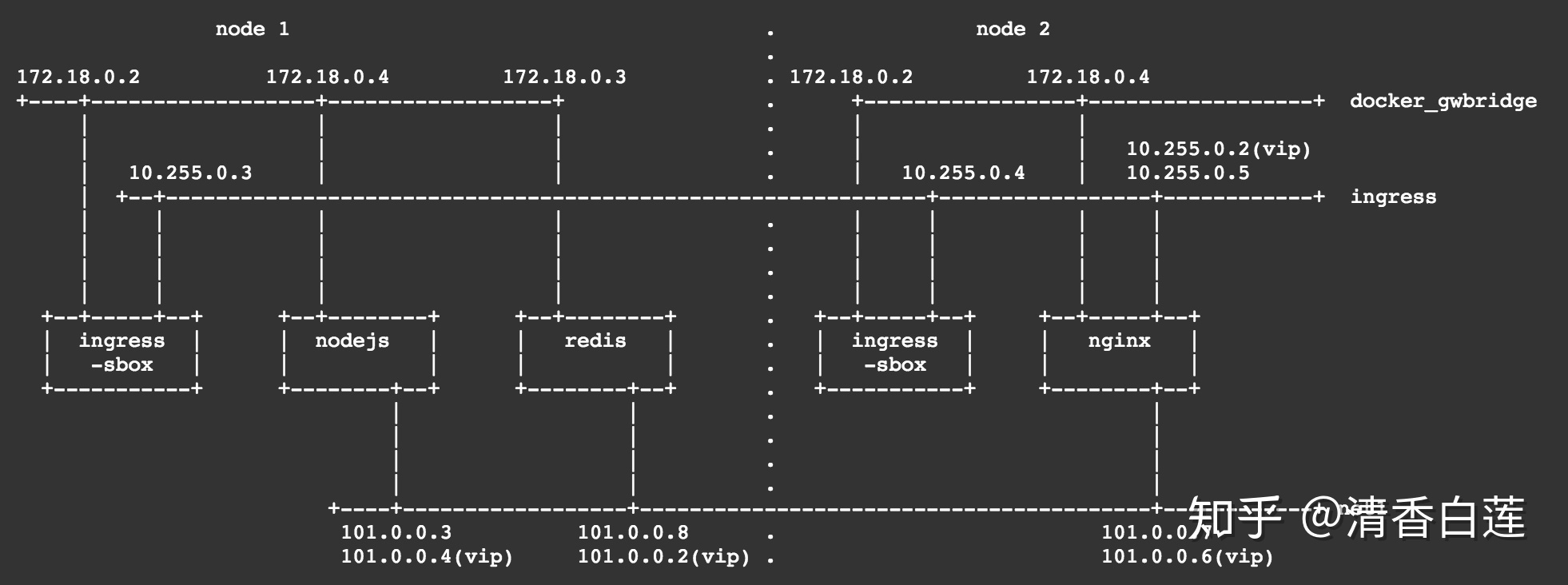

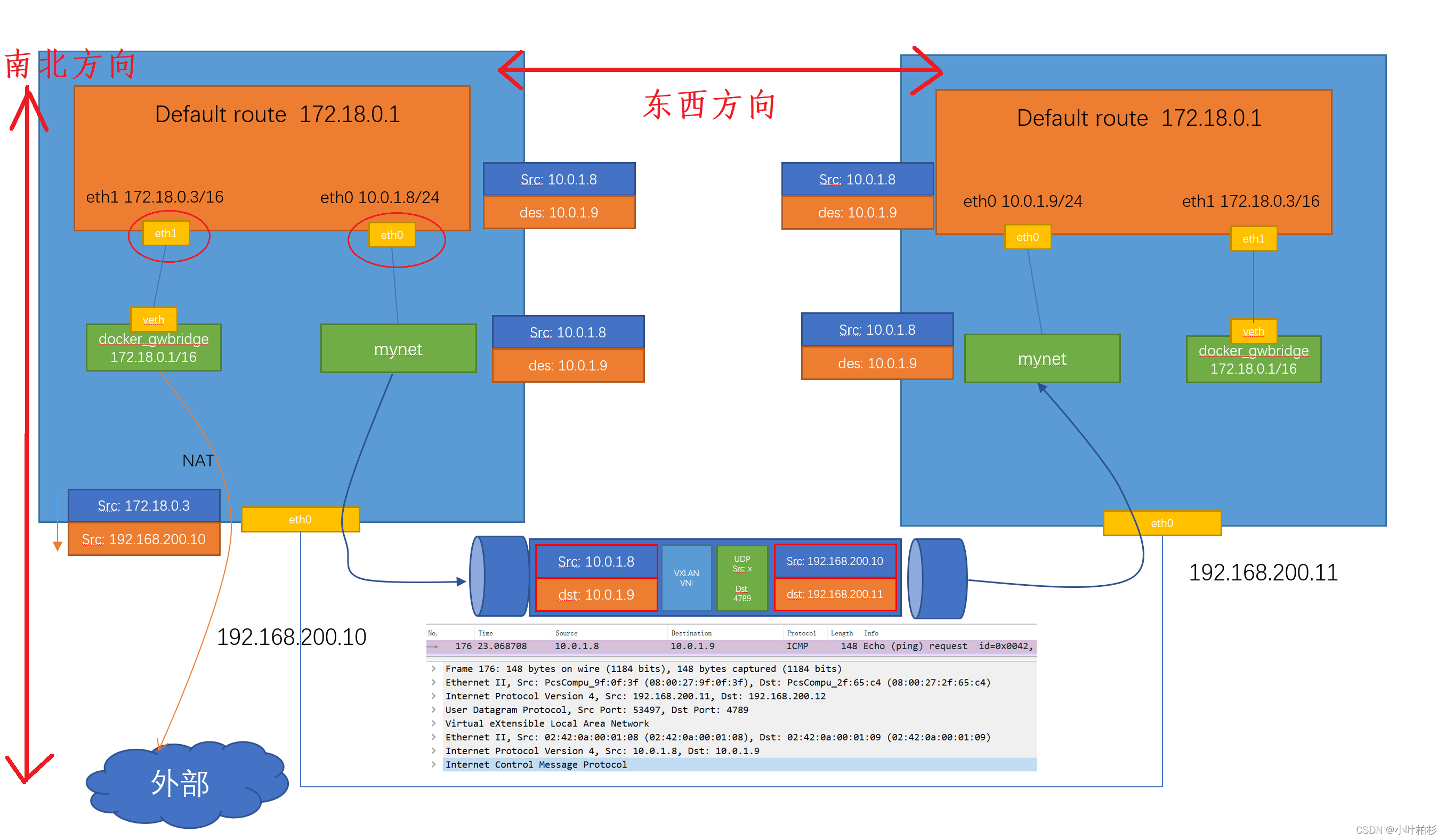

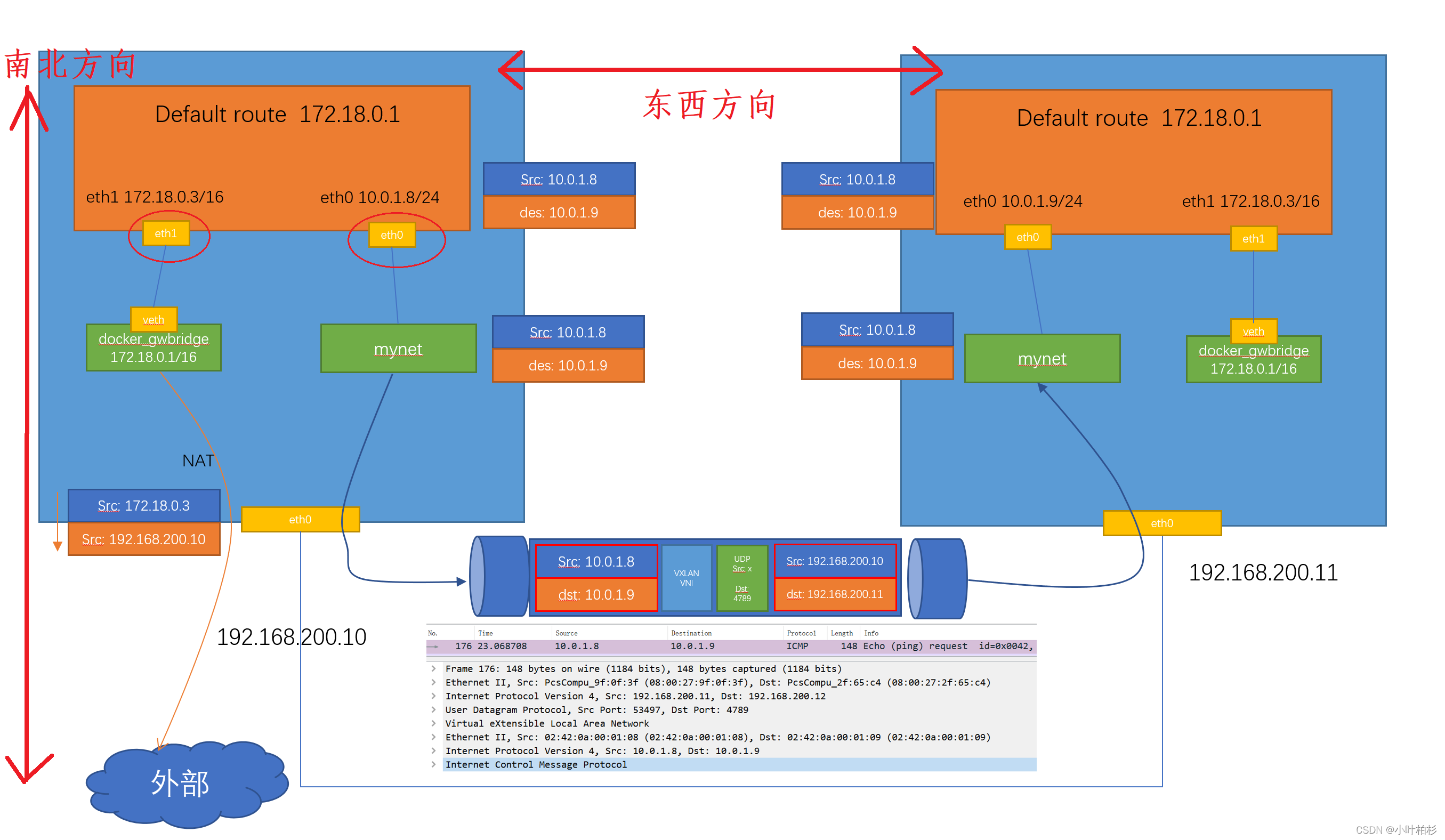

:::info 南北向:主要用于访问外部网络。通过eht1网卡,走veth的docker_gwbridge网络,根据NAT把容器地址转换成主机地址,访问到外部网络。

东西向:用于集群之间的网络访问。192.168.200.10上的容器通过eht0访问overlay的网络mynet,将原始数据加一个VXLAN的头,封装成数据包,这时会原始地址就是192.168.200.10,目标IP地址192.168.200.11,通过这个管道发送到目标机器上,再通过overlay网络的mynet接收解封,发送到192.168.200.11的容器上。

集群的两个节点之间 10.0.1.8 - > 10.0.1.9 转换后两台机器 192.168.200.10 -> 192.168.200.11。

:::

2.8 概念总结

Docker Swarm :集群的管理和容器编排,Docker 可以初始化一个Swarm,其他节点可以加入。(管理节点,工作节点) Node:就是一个 Docker 节点,多个节点就组成了一个网络集群(管理节点,工作节点) Service:任务,可以在管理节点,工作节点来运行。核心!用户访问! Task:容器内的命令,细节任务!

- Docker Engine集成集群管理

- 去中心化设计

- 扩容缩容

- 期望状态协调

- 多主机网络

- 服务发现

- 负载均衡

- 安全传输

- 滚动更新

2.9 工作模式

Node 节点

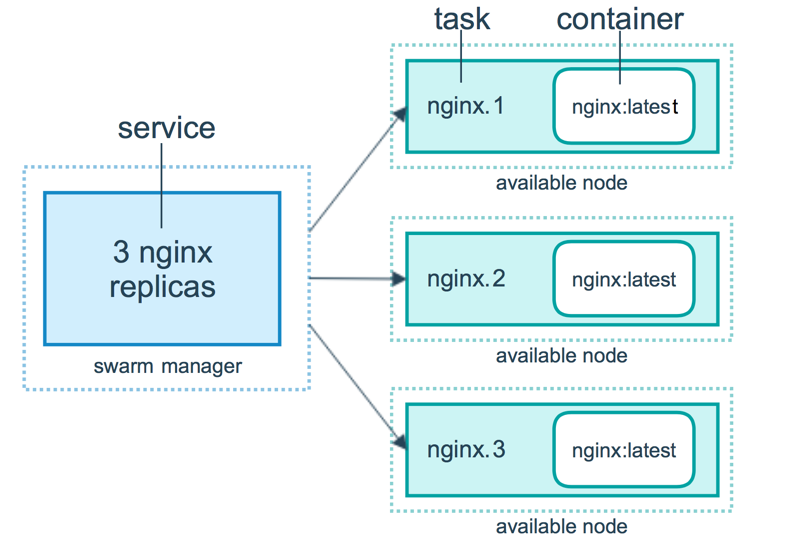

Service当部署服务到 swarm,swarm manager接收你对服务期望状态的定义。然后它为服务在 swarm 中的节点调度一个或多个副本任务。这些任务在 swarm 的节点上彼此独立地运行。

例如假设你想负载均衡三个 HTTP 服务器实例。下面的图表展示了三个 HTTP 服务器副本。

三个 HTTP 实例中的每一个是 swarm 中的一个任务。

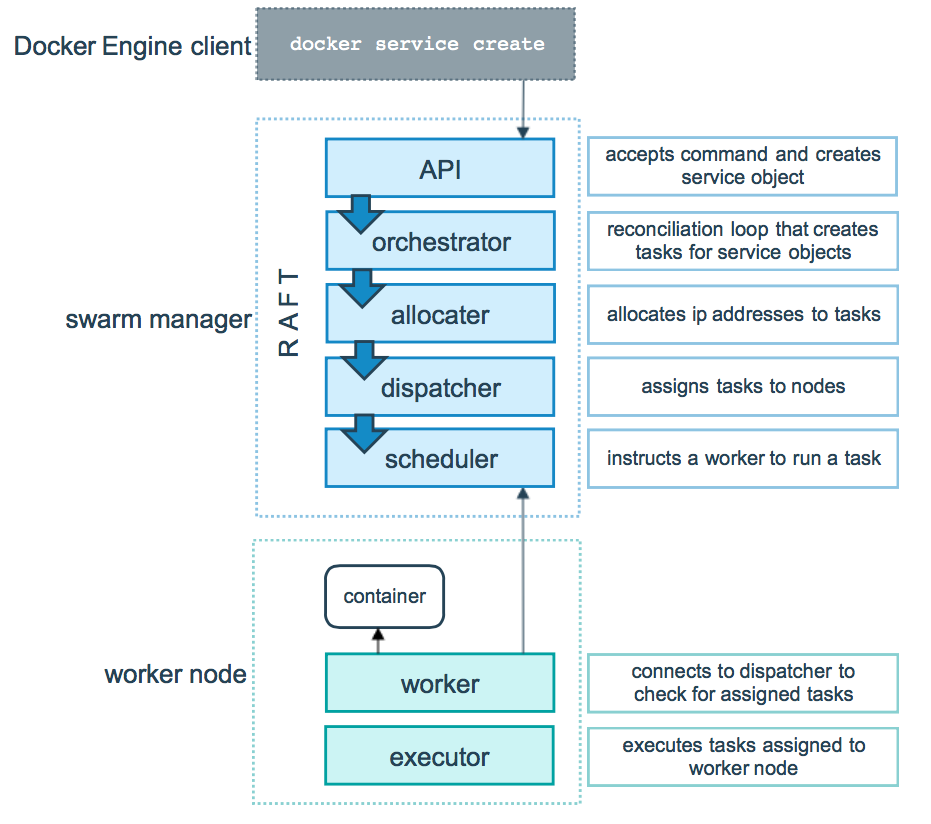

任务与调度

swarm manager:-- 1、API:这个请求直接由Swarm manager的API进行接收,接收命令并创建服务对象。-- 2、orchestrator:为服务创建一个任务。-- 3、allocater:为这个任务分配IP地址。-- 4、dispatcher:将任务分配到指定的节点。-- 5、scheduler:在该节点中下发指定命令。worker node:接收manager任务后去运行这个任务。-- 1、container:创建相应的容器。-- 2、worker:连接到调度程序以检查分配的任务-- 3、executor:执行分配给工作节点的任务

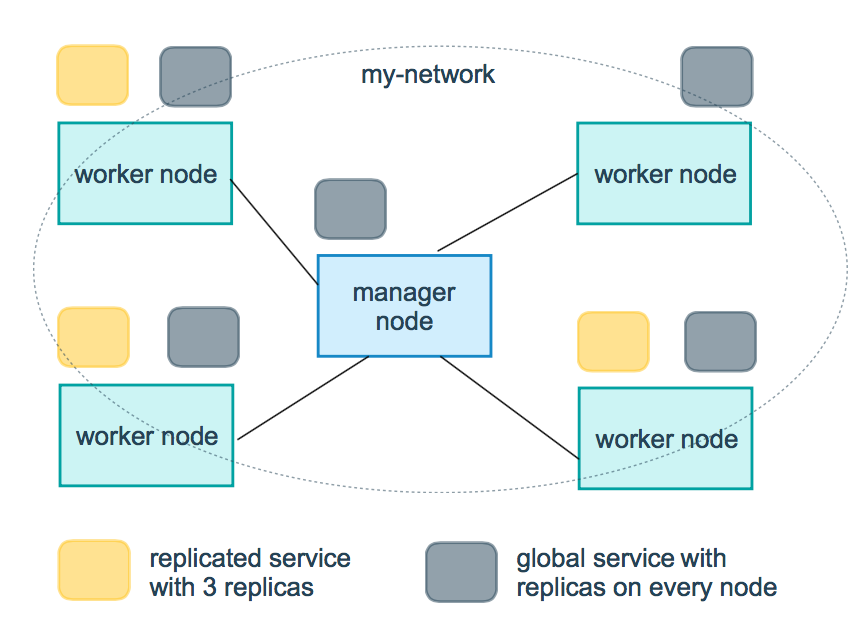

服务副本与全局服务有两种类型的services部署,副本和全局

- Replicated services

可以指定运行相同任务的数量。例如,你决定部署三个 HTTP 实例的副本,每个提供相同的内容。 - global services

在每个节点上运行一个相同的任务。不需要预先指定任务的数量。每次增加一个节点到 swarm 中,协调器就会创建一个任务,然后调度器把任务分配给新节点。

--mode stringservice mode (replicated or globa1) (default "replicated")docker service create --mode replicated --name mytom tomcat:7 #默认的docker service create --mode global --name haha alpine ping baidu.com#场景?日志收集#每一个节点有自己的日志收集器,过滤。把所有日志最终再传给日志中心#服务监控,状态性能。

2.10 网络模式

Docker Swarm 常用的网络模式:- Overlay :传统网络架构叠加虚拟化技术模式

- Ingress :特殊的 Overlay 网络,具有负载均衡的网络。这个网络用于将服务暴露给外部访问,docker swarm就是通过它实现的routing mesh(将外部请求路由到不同主机的容器)。

- docker_gwbridge 为使用多主机群覆盖网络的所有容器和任务提供默认网关功能。它是在每个 Docker 主机上创建的,当 Docker 主机加入集群时创建。

docker_gwbridge 是一个本地桥接网络,在以下两种情况会自动创建:

- 初始化或者加入一个 swarm 集群时,用来在不同 hosts 主机的不同节点间进行通信;

- 在容器中的所有网络都不能访问外部时,Docker 会将 docker_gwbridge 网络加入到容器中,用来访问外部网络或者其他的集群节点。

- 容器可以连接到宿主机。

| 名称 | 类型 | 注释 |

|---|---|---|

| docker_gwbridge | bridge | none |

| ingress | overlay | none |

| overlay | none |

第一是外部如何访问部署运行在swarm集群内的服务,可以称之为 入方向 流量,在swarm里我们通过 ingress 来解决

第二是部署在swarm集群里的服务,如何对外进行访问,这部分又分为两块:

- 第一,东西向流量 ,也就是不同swarm节点上的容器之间如何通信,swarm通过 overlay 网络来解决;

- 第二,南北向流量 ,也就是swarm集群里的容器如何对外访问,比如互联网,这个是 Linux bridge + iptables NAT 来解决的

南北向:主要用于访问外部网络。通过eht1网卡,走veth的docker_gwbridge网络,根据NAT把容器地址转换成主机地址,访问到外部网络。

东西向:用于集群之间的网络访问。192.168.200.10上的容器通过eht0访问overlay的网络mynet,将原始数据加一个VXLAN的头,封装成数据包,这时会原始地址就是192.168.200.10,目标IP地址192.168.200.11,通过这个管道发送到目标机器上,再通过overlay网络的mynet接收解封,发送到192.168.200.11的容器上。

集群的两个节点之间 10.0.1.8 - > 10.0.1.9 转换后两台机器 192.168.200.10 -> 192.168.200.11

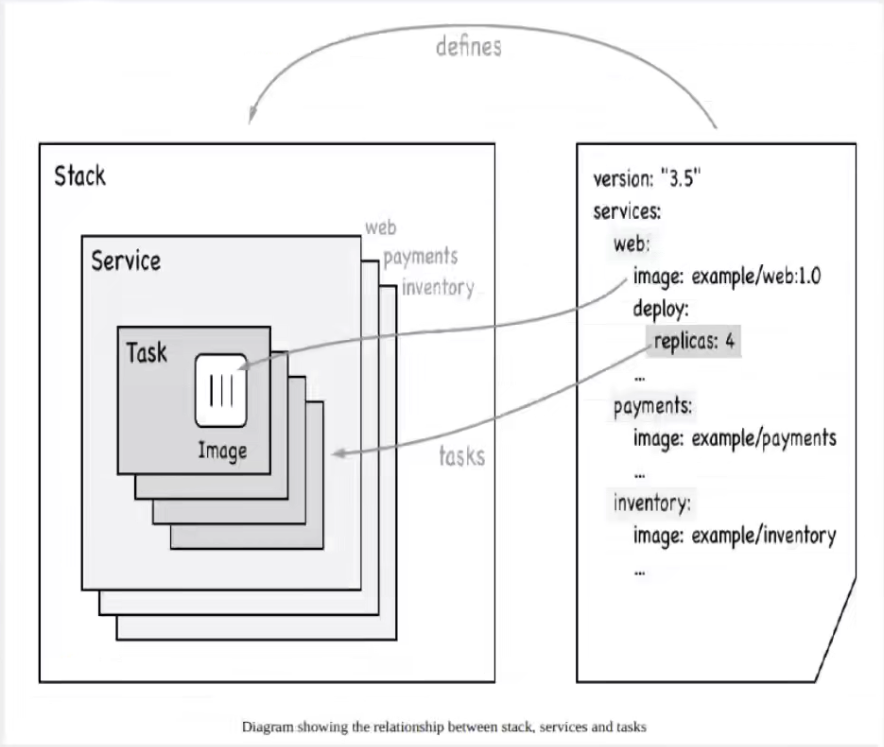

3 Docker Stack

之前学的docker-compose.yml 就是一个单机版的多应用服务启动脚本.那么docker stack 就是个集群版本的多应用服务启动脚本,语法和compose基本相同.docker stack 是基于cluster集群模式,发布服务的一个功能。docker stack 有如下几个命令docker stack deploy 发布或者更新一个stackdocker stack list 获取所有stackdocker stack ps 列出stack中运行的taskdocker stack services 列出stack中的服务docker stack rm 移除stack

#单机docker-compose up -d docker-compose.yml#集群docker stack deploy --compose-file docker-compose.yml#docker-compose.yml 文件version: '3'services:web:image: wordpressports:- 8080:80environment:WORDPRESS_DB_HOST: mysqlWORDPRESS_DB_PASSWORD: rootnetworks:- my-networkdepends_on:- mysqldeploy:mode: replicatedreplicas: 3restart_policy:condition: on-failuredelay: 5smax_attempts: 3update_config:parallelism: 1delay: 10smysql:image: mysql:5.7environment:MYSQL_ROOT_PASSWORD: rootMYSQL_DATABASE: wordpressvolumes:- mysql-data:/var/lib/mysqlnetworks:- my-networkdeploy:mode: globalplacement:constraints:- node.role == managervolumes:mysql-data:networks:my-network:driver: overlay

4 Docker Secret

安全!配置密码,证书! 声明式配置中,若直接定义用户名及密码等环境变量时,会造成安全隐患;因此,引入secret,对保密数据(用户名及密码、ssh key、TLS认证信息、其他需保密数据)进行加密。敏感数据包括密码、私钥、证书及其它所有不能以明文的形式在网络上传输,或者是不能保存在各种文件中的数据,例如Dokerfile、image等。从docker 1.13开始,可以通过secret功能集中的保存与分发这些敏感数据,一个secret只允许被授权的服务在运行的时候访问,另外只有在集群模式下才能使用secret功能。docker以加密的形式保存与传输敏感数据,并且敏感数据会以分布式的形式存储在集群中的所以manager节点上,以提高可用性。

当对一个新建立的或者是运行中的service进行某个secret的授权时,docker会在内存中模拟一个文件,然后将解密后的数据放入文件中,并mount这个文件到容器的文件系统中,默认目录是/run/secrets/

docker secret同时也可以用来管理普通的配置项,但是从Docker 17.06开始,提供了专门用于管理非敏感数据的config。两者的区别是secret用的是RAM来模拟文件系统保存敏感数据,使用敏感数据的容器是只读的。而config则直接使用普通的文件系统存储非敏感数据。

$ docker secret --helpUsage: docker secret COMMANDManage Docker secretsCommands:create Create a secret from a file or STDIN as contentinspect Display detailed information on one or more secretsls List secretsrm Remove one or more secretsRun 'docker secret COMMAND --help' for more information on a command.

5 Docker Config

在动态的、大规模的分布式集群上,管理和分发配置文件也是很重要的工作。传统的配置文件分发方式(如配置文件放入镜像中,设置环境变量,volume 动态挂载等)都降低了镜像的通用性。 在 Docker 17.06 以上版本中,Docker 新增了 docker config 子命令来管理集群中的配置信息,以后你无需将配置文件放入镜像或挂载到容器中就可实现对服务的配置。 注意:config 仅能在 Swarm 集群中使用 可以用target指定路径,如果不指定,默认挂载到容器的根目录下

$ docker config --helpUsage: docker config COMMANDManage Docker configsCommands:create Create a config from a file or STDINinspect Display detailed information on one or more configsls List configsrm Remove one or more configsRun 'docker config COMMAND --help' for more information on a command.

6 扩展到 Kubernetes

Go 是 Google 开发的一种编译型、并发型,并具有垃圾回收功能的编程语言。 Go 的表现力强、简洁、干净、高效。它的并发机制使它能够轻松地编写程序,从而最大限度地利用多核和网络机器,而它新颖的类型系统则使灵活的模块化程序构造成为可能。Go 快速编译成机器代码,但又具有垃圾回收的便利性和运行时反射的强大功能。它是一种快速的、静态类型化的、编译后的语言,感觉就像一种动态类型化的、解释的语言。 Go 语言是基于 Inferno 操作系统所开发的。Go 语言于 2009 年 11 月正式宣布推出,成为开放源代码项目,并在 Linux 及 Mac OS X 平台上进行了实现,后追加 Windows 系统下的实现。 Go(又称Golang)是Google开发的一种静态强类型、编译型、并发型,并具有垃圾回收功能的编程语言,被称为云计算时代的C语言。Go 语言!必须掌握!

- 入门 → 基础语法 → 高级对象 → 操作数据库 → 框架