做好机器学习,数学要学到什么程度? - 人民邮电出版社的回答 - 知乎 https://www.zhihu.com/question/68472622/answer/1781641922

学好机器学习需要哪些数学知识? - SIGAI的文章 - 知乎 https://zhuanlan.zhihu.com/p/36357540

“西瓜书”(《机器学习》,清华大学出版社)和“花书”(《深度学习》,人民邮电出版社)分别是目前国内机器学习、深度学习领域最受欢迎的教材。大家公认它们的质量是很高的,但一个尴尬的现状是:因为数学基础不扎实,很难入门并彻底掌握核心知识。

学好机器学习,需要哪些数学知识?

我们先看典型的机器学习算法所用到的数学知识点,如下表所示。

限于篇幅,这里没有列出强化学习、机器学习理论、自动化机器学习(AutoML)等内容所用的数学知识。

从这张表可以看出来,频繁用到的知识点就是向量和矩阵的运算,梯度下降法等优化算法,概率,信息论中的模型概念。

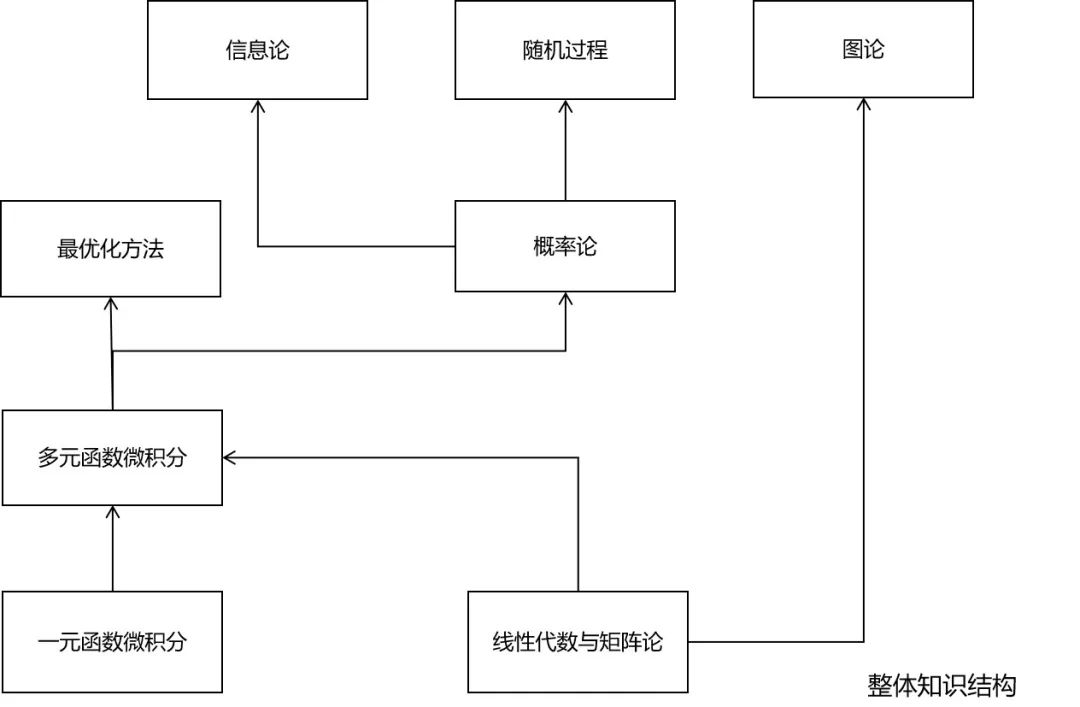

整体来说,就是下面这几门课的内容:

- 微积分

- 线性代数

- 概率论

- 最优化方法

- 信息论

- 随机过程

- 图论

下面这张图列出了这些知识的整体结构。其中线性代数与微积分是基础,其他的课程都是建立在它们之上的。最优化方法严重依赖于微积分的知识,信息论与随机过程是概率论的延伸。

下面我们分别来介绍这几门课在机器学习中到底用到了哪些内容。

微积分

微积分可分为一元函数微积分、多元函数微积分两部分,它是整个高等数学的基石。

通常情况下,机器学习需要得到一个函数(模型,或者说假设),既然是函数,那自然就离不开微积分了。微积分为我们研究函数的性质,包括单调性、凹凸性、以及极值提供了理论依据。同时它也是学习概率论、信息论、最优化方法等后续课程的基础。

总体来说,机器学习中所用的微积分知识,工科微积分教材基本上已经讲了,除了下面这些内容:

1. 上/下确界2. 李普希茨连续性3. 雅克比矩阵4. Hessian矩阵5. 多元函数的凹凸性6. 多元函数的极值7. 多元函数的泰勒公式8. 多重积分的换元法

如果你真的学好了本科微积分,上面这些内容并不难理解。

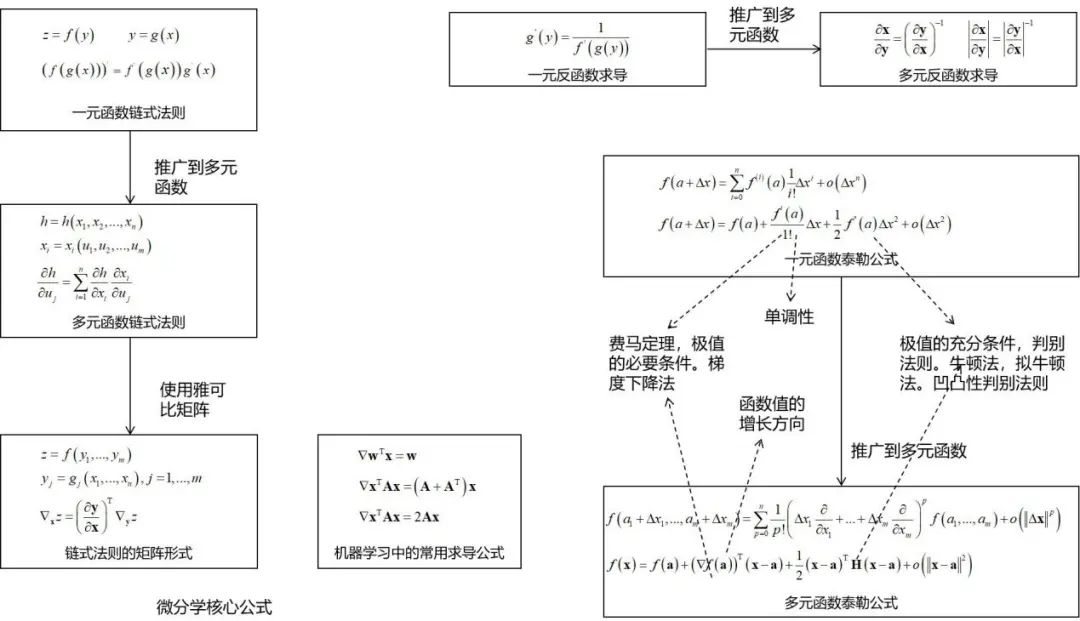

对于微分学习,重点是下面这张图中的内容。包括函数的求导法则(尤其是链式法则),以及泰勒公式。泰勒公式中的一阶导数项和二阶导数项决定了函数的极值,这对后续的梯度下降法,牛顿法,拟牛顿法等优化算法的推导至关重要!

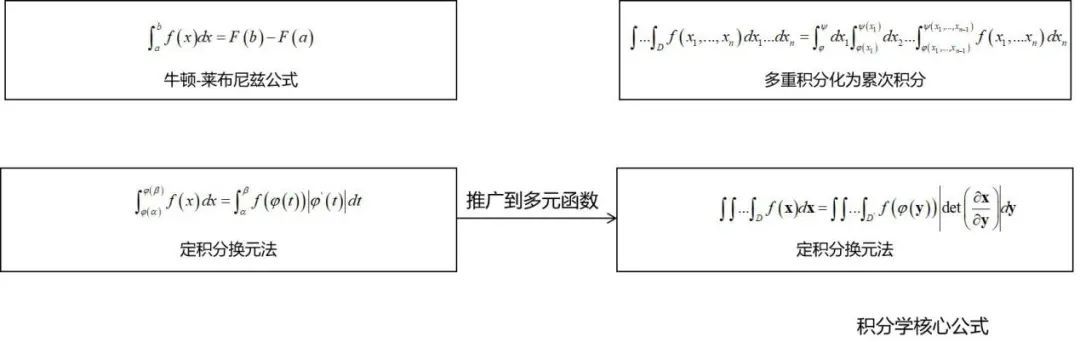

积分学的重点是理解下面这种图中的公式。包括定积分和多重积分的计算,以及积分的换元法。

线性代数

线性代数对于机器学习是至关重要的。机器学习算法的输入、输出、中间结果通常为向量、矩阵、张量。

使用线性代数可以简化问题的表达,用一个矩阵乘法,比写成多重求和要简洁明了得多。线性代数是学习后续数学课程的基础。它可以与微积分结合,研究多元函数的性质。

线性代数在概率论中也被使用,比如随机向量,协方差矩阵。线性代数在图论中亦有应用-如图的邻接矩阵,拉普拉斯矩阵。在随机过程中同样有应用-如状态转移矩阵。

机器学习中所用的线性代数知识,有不少超出了一般线性代数乃至高等代数教材的范畴,对于很多读者来说说陌生的。这包括:

1. 向量的范数2. 矩阵的范数,包括谱范数3. Householder变换4. QR算法5. 广义特征值6. 瑞利商7. 矩阵的条件数8. 矩阵分解,包括Cholesky分解,QR分解,奇异值分解(SVD)等

概率论

概率论对于机器学习来说也是至关重要的,它是一种重要的工具。

如果将机器学习算法的输入、输出看作随机变量/向量,则可以用概率论的观点对问题进行建模。使用概率论的一个好处是可以对不确定性进行建模,这对于某些问题是非常有必要的。另外,它还可以挖掘变量之间的概率依赖关系,实现因果推理。

概率论为某些随机算法-如蒙特卡洛算法、遗传算法,以及随机数生成算法-包括基本随机数生成、以及采样算法提供了理论依据和指导。最后,概率论也是信息论,随机过程的先导课程。

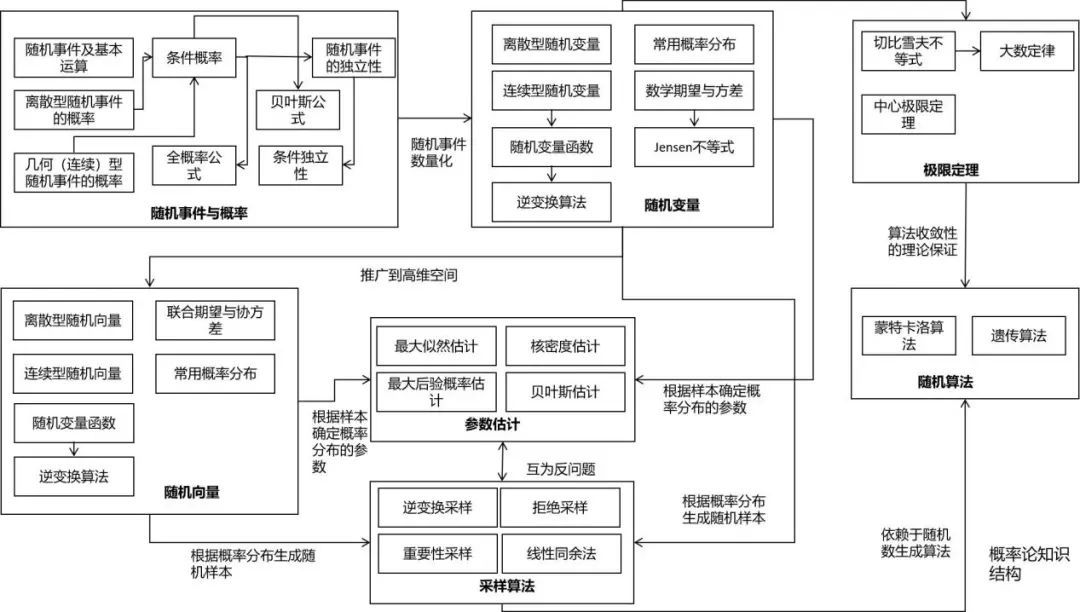

下面这张图清晰的列出了概率论的核心知识。

工科的概率论与数理统计教材,已经讲述了机器学习所需的大部分概率论知识,只有以下的知识点除外:

1. 条件独立性2. Jensen不等式3. 某些概率分布,如多项分布,拉普拉斯分布,t分布等4. 概率分布变换5. 多维正态分布6. 多维概率分布变换7. 某些参数估计方法,包括最大后验概率估计,贝叶斯估计等8. 随机数生成算法,包括逆变换采样,拒绝采样等算法

最优化方法

最优化方法在机器学习中处于中心地位,遗憾的是很多读者并没有系统的学过这门课程,包括线性规划,凸优化,非线性规划。在一般的数值分析课程中,只讲述了最优化方法的小部分内容。

几乎所有机器学习算法最后都归结于求解最优化问题,从而确定模型参数,或直接获得预测结果。

- 前者的典型代表是有监督学习,通过最小化损失函数或优化其他类型的目标函数确定模型的参数;

- 后者的典型代表是数据降维算法,通过优化某种目标函数确定降维后的结果,如主成分分析。

信息论

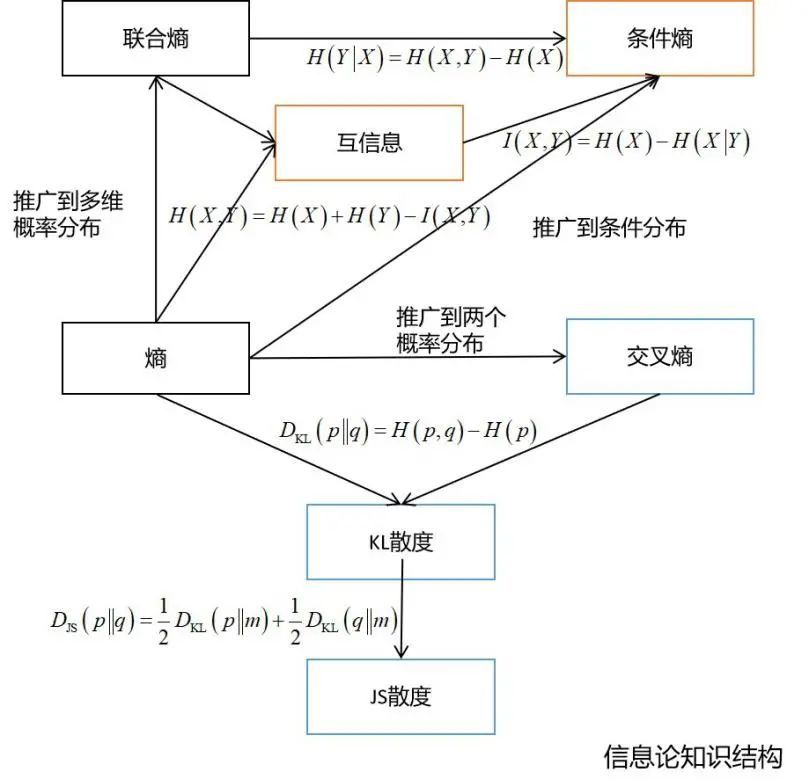

信息论是概率论的延伸,在机器学习与深度学习中通常用于构造目标函数,以及对算法进行理论分析与证明。这同样是很多读者没有学习过的课程。

在机器学习尤其是深度学习中,信息论的知识随处可见:

- 决策树的训练过程中需要使用熵作为指标

- 在深度学习中经常会使用交叉熵、KL散度、JS散度、互信息等概念

- 变分推断的推导需要以KL散度为基础

- 距离度量学习、流形降维等算法也需要信息论的知识

总体来说,在机器学习中用得最多的是熵,交叉熵,KL散度,JS散度,互信息,条件熵等。

下面这张图列出了信息论的核心知识。

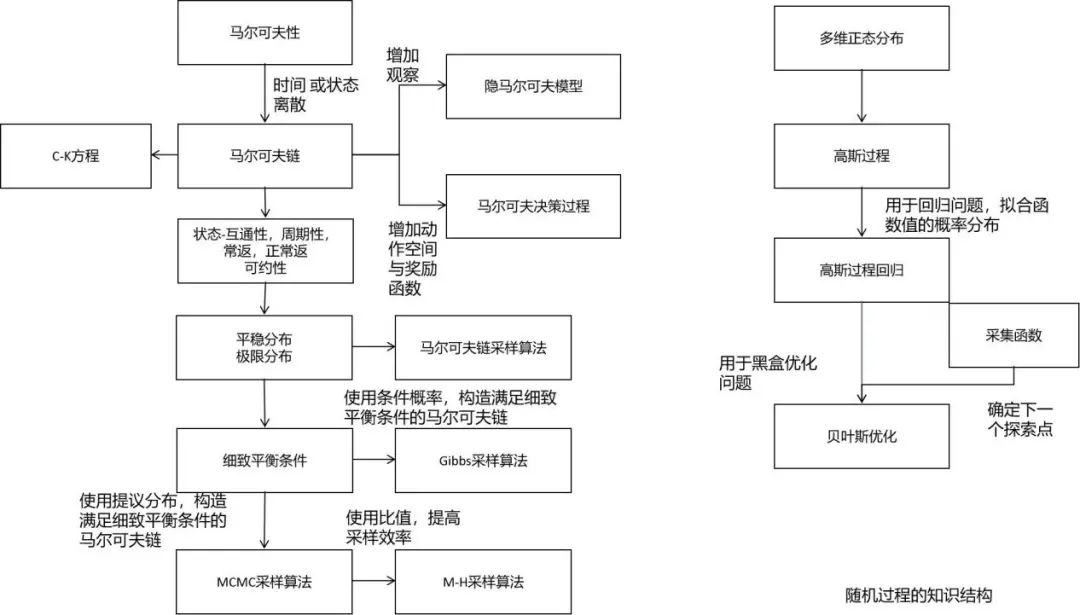

随机过程

随机过程同样是概率论的延伸,这也是大部分读者没有学习过的课程。

在机器学习中,随机过程被用于概率图模型、强化学习、以及贝叶斯优化等方法。不理解马尔可夫过程,你将对MCMC采样算法一头雾水。

下面这张图列出了机器学习中随机过程的核心知识。

在机器学习中所用的主要是马尔可夫过程和高斯过程。隐马尔可夫过程,马尔可夫决策过程都是它的延伸。同时,平稳分布、细致平衡条件也是理解MCMC采样的核心基础。

图论

图论似乎只有计算机相关专业在本科时学过,而且还不完整,比如谱图理论。在机器学习中,概率图模型是典型的图结构。流形降维算法与谱聚类算法均使用了谱图理论。计算图是图的典型代表,图神经网络作为一种新的深度学习模型,与图论也有密切的关系。因此补充图论的知识也是很有必要的。