矩阵补全是推荐系统中的经典问题。近年来,基于深度学习的方法,特别是图神经网络,在这一问题上取得了令人瞩目的进展。但现有基于user-item交互图的方法缺点是模型性能取决于交互作用的密度,而这种密度通常比较稀疏。更重要的是,对于没有任何交互的冷启动user/item,这些方法无法学习user/item 的嵌入,因为在图中没有指向此user/item 的连接。在这篇文章中,作者开发了一种新的图神经网络(AGNN),它利用了属性图而不是常用的user-item Interaction graph。这使得可以学习冷启动user/item 的嵌入的能力。此外,还提出了一种新的图神经网络变体,即gated-GNN,以有效地聚合邻域中不同模式的各种属性。

一、简要信息

| 序号 | 属性 | 值 |

|---|---|---|

| 1 | 论文模型 | AGNN |

| 2 | 所属领域 | 推荐系统 |

| 3 | 研究内容 | Attribute Graph Neural Networks; variational auto-encoder; cold start |

| 4 | 核心内容 | 冷启动问题 |

| 5 | 论文PDF | 2019arxiv-Solving Cold Start Problem in Recommendation with Attribute Graph Neural Networks.pdf |

| 6 | GitHub代码 |

二、研究背景/传统方法

矩阵补全是一项众所周知的推荐任务,旨在为用户尚未评分的那些项目预测用户的评分。协同过滤已成功用于构建各个领域的推荐系统。矩阵分解(MF)是CF中最流行的方法之一,因为它具有很高的预测性能和可伸缩性。给定一个M×N的用户项目评分矩阵,MF首先执行低秩逼近来学习用户和项目的潜在表示(也称为用户或项目的偏好嵌入),然后对获知的偏好嵌入使用评分函数生成矩阵中缺少条目的评分。稀疏性及其极端的冷启动情况(其中没有任何交互的用户/项目)是推荐系统中的严重问题。在稀疏性或冷启动设置中,MF方法的性能将迅速下降。解决此问题的常规CF方法是使用边信息生成特征嵌入。这种方法经常引入其他客观条件,这会使学习和推理过程变得非常复杂。

深度学习的最新进展,尤其是图神经网络(GNN),为这一经典推荐问题提供了新的思路。 GNN的主要优点是可以以任意深度表示其邻域中的信息 。GNN允许学习高质量的user和item表示,从而达到最先进的性能。但是,几乎所有基于GNN的现有方法都建立在user-item二部图的基础上,其中节点表示用户或项目,边是用户与项目之间的交互。这种方法不能用于冷启动推荐。实际上,很少有人关注使用深度网络体系结构来解决冷启动问题。我们知道针对此问题的几种深度学习方法,即DropoutNet(V olkovs,Yu和Poutanen 2017),STARGCN(Zhang等人2019)和HERS(Hu等人2019)。尽管它们有效,但DropoutNet和STAR-GCN都有一个固有的局限性,即它们的性能受交互次数的限制。原因是STAR-GCN依赖于交互图。它需要一种ask-to-rate technique,该技术可能不适用于现实世界的冷启动方案。同时,DropoutNet的目标是重建用户项目对的评分。也就是说,DropoutNet模型的训练仍然取决于现有的交互。而且,尽管HERS利用用户-用户和项目-项目之间的关系通过引用上下文中的有影响力的节点来解决冷启动问题,但缺点是它可能会将流行的项目推荐给新用户,反之亦然,因为它通过邻居聚合来表示冷启动节点,而不考虑新节点自身的属性。

为了解决上述限制,我们通过利用属性图代替广泛使用的用户项目图,提出了一种新颖的框架——属性图神经网络(AGNN)。与评分不同,该属性甚至对于冷启动用户/项目也可用。例如,当商人开始在线销售其产品时,有必要提供产品属性,例如类别,描述和图像。同样,许多网站要求用户在注册时填写其个人资料信息,例如性别和位置。在准备利用属性信息进行冷启动推荐时,存在两个阻碍其潜力的关键挑战。一个是如何转换属性表征到偏好表征。另一个是如何有效地聚合邻域中节点的不同模式的属性,例如文本描述和图像。

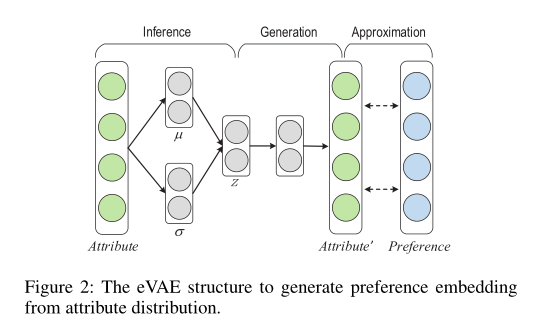

在这项工作中,我们首先将扩展的变分自动编码器(eVAE)结构用于直接从属性分布中学习嵌入的偏好,并认为可以从他们的属性中推断出用户或项目的偏好。例如,女性用户可能更喜欢浪漫电影而不是恐怖电影。我们进一步设计了门控GNN结构,以在同一邻域中聚合复杂的节点嵌入,这可以实现模型容量的飞跃,因为它可以为节点嵌入的每个维度分配不同的重要性。

三、相关工作

协同过滤(CF):CF通常用于利用用户项目交互数据进行推荐。它主要由基于邻居的方法(Sarwar等,2001; Koren 2008)和矩阵分解(MF)方法(Mnih和Salakhutdinov 2008; Koren,Bell和Volinsky 2009)组成。最近,CF方法通过深度学习技术得到扩展(Wang,Wang和Yeung 2015; Dziugaite和Roy 2015; V olkovs,Yu和Poutanen 2017; He和Chua 2017)。

图神经网络方法:用于推荐的第一个GNN架构是GCN。 RMGCNN(Monti,Bronstein,and Bresson 2017)采用了GCN框架来汇总来自用户-用户图和项目-项目图的信息。 GCMC(Berg,Kipf和Welling 2018)将图卷积应用于用户项目评分图上。 PinSage(Ying et al.2018)结合了有效的随机游动和图卷积来生成节点的嵌入。 STAR-GCN(Zhang et al.2019)设计了一个堆叠并重建的GCN,以提高预测性能。 GNN体系结构主要用于社交推荐中的递归扩散(Fan等人2019; Wu等人2019a),而NGCF(Wang等人2019)通过执行嵌入传播对高阶连接进行编码。最后,DANSER(Wu et al.2019b)是第一个部署GAT来为推荐任务协同建模社交效果的人。

我们提出的模型与以前基于GNN的方法有两个不同。首先,我们的模型使用属性图代替用户-项目交互图。几乎所有现有方法都基于交互图。唯一的例外是DiffNet(Wu et al.2019a)基于用户的社交图而不是模型中的属性图。其次,我们设计了门控GNN结构,以区分节点嵌入各个维度的重要性。在上述方法中,只有DANSER会考虑邻域中不同节点的重要性。但是,其模型在节点级别。由于粗粒度,DANSER难以充分利用GNN架构的功能。

处理冷启动问题:稀疏性和冷启动在推荐系统中很普遍。一种有前途的方法是利用辅助信息。常规方法主要利用辅助信息作为MF目标函数的正则化(Ma等,2011; Guo,Zhang和Y orke-Smith,2015)。最近的研究专注于开发各种类型的神经网络以整合此类信息(Zheng,Noroozi和Yu 2017; Chen等2018; Wu等2019b; Xin等2019; Fu等2019)。我们提出的AGNN具有类似的邻域聚合架构,具有几种基于深度学习的方法(Monti,Bronstein和Bresson 2017; Wu等2019b; Zhang等2019; Hu等2019)来解决冷启动问题。关键区别在于eVAE结构,该结构在AGNN中唯一用于根据不同模态的属性嵌入生成优先级嵌入。据我们所知,这是VAE(Kingma and Welling 2014)首次用于此目的,而先前的推荐研究采用VAE来重构具有相同模态的潜在表示(Li and She 2017; Liang et al.2018) ; Sachdeva等人.2019)。

四、主要思想

AGNN模型的体系结构如图1所示,它由一个输入层,一个交互层,一个门控GNN层和一个预测层组成。我们首先设计一个输入层以构建用户(项目)属性图(

)。然后,我们提供一个交互层,将一个节点的不同信息集成到一个统一的嵌入中。我们还开发了一个关键的eVAE组件,以生成该层中冷启动节点的优先嵌入。接下来,我们提出了一个选通的GNN层来聚合属性图中邻域中的复杂节点嵌入。最后,我们添加了一个预测层,以使用户和项目的聚合表示相互交互以计算评分。

eVAE结构图如上图所示。

五、实验评估

数据集

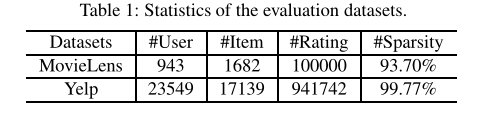

MovieLens-100K:根据影片名称和发行年份,我们从IMDb2爬取明星,导演,编剧和国家/地区来扩展它。我们将类别,明星,导演,编剧和国家/地区作为电影特征,并将性别,年龄和职业作为用户特征。

Yelp:通过删除评分低于20的节点来预处理Yelp数据集。由于缺少Yelp上的个人资料信息,我们将类别,所处的州和所处的城市作为项目要素,并使用社交链接作为用户-用户图以及用户的属性。

Baselines

- NFM(He and Chua 2017)将FM的线性和NN的非线性组合到一个框架中。

- DropoutNet(V olkovs,Yu和Poutanen 2017)将dropout技术应用于冷启动问题。

- sRMGCNN(Monti,Bronstein和Bresson,2017年)采用多图卷积神经网络架构补全矩阵。

- GC-MC(Berg,Kipf和Welling 2018)在用户项目图上采用GCN框架来补全矩阵。

- DiffNet(Wu等人,2019a)包括类似GCN的分层扩散过程,以模拟社交推荐中的动态社交扩散。

- DANSER(Wu et al.2019b)是基于GAT的社交推荐方法。

STAR-GCN(Zhang等人,2019年)是一个堆叠的GCN模型,并通过mask技术解决了冷启动问题。

Evaluation Metrics

RMSE

- MAE

Settings

对于冷启动,我们随机选择20%的项目(或用户)以及它们的交互作为测试集,其余的交互作为训练集。对于热启动,我们随机选择20%的用户与项目互动作为测试集,其余80%作为训练集。区别在于,对于冷启动节点,它们的交互作用已从训练中完全删除。

The hyper-parameter settings in our AGNN are as follows: batch size = 128, embedding dimension D = 30, initial learning rate = 0.0005, slop of LeakyReLU = 0.01, threshold p in graph construction = 5. We use Adam(Kingma and Ba 2015) as optimizer to self-adapt the learning rate.

请注意,所有基线都使用与我们的模型相同的属性信息。我们使用其公共源代码实现sRMGCNN,但它无法扩展到像Yelp这样的大型数据集。此外,由于DANSER不是为合并属性而设计的,因此我们采用属性功能来初始化其对用户和商品的嵌入。对于DANSER和DiffNet,我们删除了用于在MovieLens上建立社交关系建模的部分,因为没有此类信息。最后,在STAR-GCN的测试阶段,我们不将新评分的边添加到冷启动节点中,以便与所有其他方法进行公平比较,并且还可以模拟现实世界中的冷启动场景。实验结果

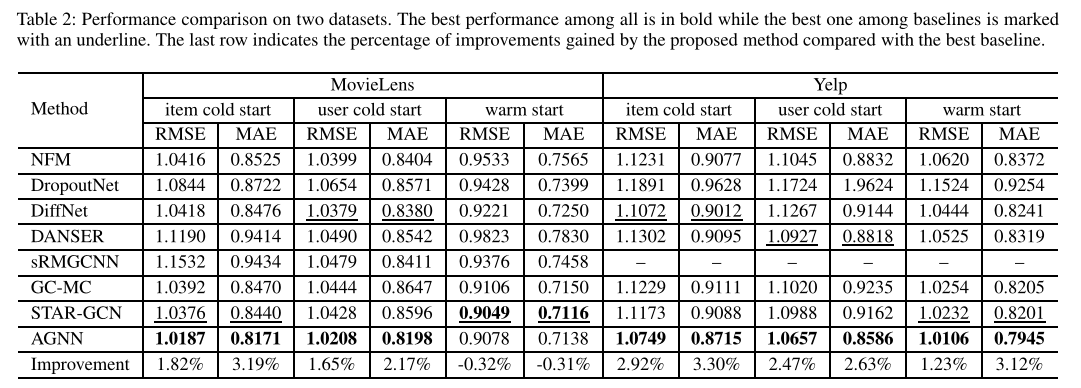

对比试验

- 很明显,在冷启动场景中,我们的AGNN优于所有基线。特别是,对于项和用户冷启动,它在最强的基线上分别获得了改善,MovieLens的RMSE得分为1.82%和1.65%,Yelp的RMSE得分为2.92%和2.47%。结果通过探索用于冷启动推荐的属性图,验证了我们提出的体系结构的优越性。此外,在热启动场景中,我们的AGNN在Yelp上也能获得最佳效果,而在MovieLens上则排名第二,其性能略逊于STAR-GCN。

- 在基线中,sRMGCNN,GC-MC和STAR-GCN在用户项目图上利用图卷积网络。 STAR-GCN之所以获得总体最佳性能,是因为它将内容信息集成到了节点嵌入中,并且还避免了在用户项图上进行卷积时避免标签泄漏问题。 GCMC的性能受到限制,因为它在卷积层之后合并了内容信息。sRMGCNN是最差的,因为它使用属性来构造用户-用户或项目图,而没有将它们包括在卷积操作中。而且,它无法处理像Yelp这样的大型数据集,因为其卷积是在Chebyshev扩展中定义的。

- 两个基准DiffNet和DANSER利用社交图进行推荐。DiffNet在大多数情况下表现更好,因为它结合了用户嵌入以及偏好和属性信息。 DANSER根据共同购买的物品数量构造物品-物品图。这导致其在项目冷启动中的性能较差。DropoutNet和NFM不使用图卷积运算。由于NFM具有学习高阶特征交互的能力,因此它们在许多情况下均表现良好。DropoutNet不好,因为它需要内容信息来近似矩阵分解的结果,并且它的性能取决于预训练的偏好嵌入。

总结,虽然同时利用属性和结构信息可以提高推荐性能,但在属性和结构上,sRMGCNN和GC-MC的效果不如DiffNet,STAR-GCN和AGNN等具有深层交互的效果。此外,尽管STAR-GCN和DropoutNet采用mask和dropout技术来解决冷启动问题,但它们是建立在用户项图上的。交互图的性质使他们很难使用我们的AGNN(具有eVAE结构的属性图)来实现竞争绩效。

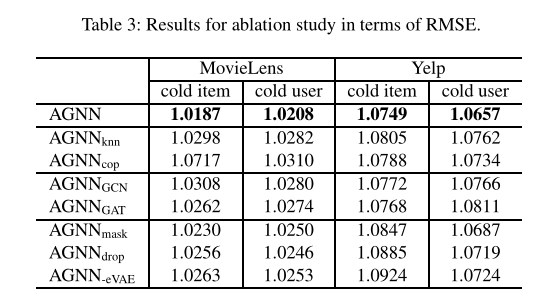

消融试验

首先是研究图构造方法的效果。我们使用从sRMGCNN和DANSER改编的不同图形构造将AGNN及其两个变体进行比较。具体来说,AGNNknn通过仅在用户和项目属性空间中选择最近的10个邻居来构造用户-用户图和项目图。 AGNNcop根据共同购买的项目数构建项目图。如果社交链接不可用,则以类似方式构造用户-用户图。 AGNNcop的性能在Movielens上急剧下降,因为冷启动节点没有邻居。它对冷启动用户的性能在Yelp上不会有太大变化,因为社交链接已经形成了用户-用户图。 AGNN优于AGNN的性能表明,属性和偏好信息都可用于图形构造。此外,AGNN得益于其动态构造策略,因为它允许访问多样化的邻居,因此比具有固定邻居的两个变体产生更好的性能。

- 第二个是研究门控GNN结构的影响。我们使用从GC-MC和DANSER改编的不同GNN结构,将AGNN及其两个变体进行比较。尤其是,

通过使用求和运算来汇总所有邻居的表示,从而使用普通的GCN。

采用了一个注意层来学习聚合之前每个邻居的权重。可以看出,

在大多数情况下均不如

,这表明注意机制可以提高性能。但是,它们都比AGNN差。这验证了区分节点每个维度的重要性可以进一步增强性能,因为它大大扩展了模型容量。

- 第三是研究eVAE结构的影响。我们将AGNN与它的三种变体进行了比较,两种针对STARGCN和DropoutNet采用了不同的冷启动问题策略,另一种是从我们自己的AGNN中删除了eVAE结构。具体来说,AGNNmask随机地屏蔽了20%的输入节点,并在gated-GNN层之后添加了一个解码器,以重建初始输入节点的嵌入。 AGNNdrop随机将输入节点的20%偏好嵌入设置为0。AGNN-eVAE是从AGNN中删除eVAE的简化版本。 AGNN-eVAE的性能最差,因为它不包含删除eVAE结构后用于处理冷启动节点的组件。此外,我们具有eVAE结构的完整AGNN优于AGNNmask和AGNNdrop。这表明所提出的eVAE结构对于我们的AGNN模型至关重要,并且在解决冷启动问题方面比mask和dropout技术更有效。

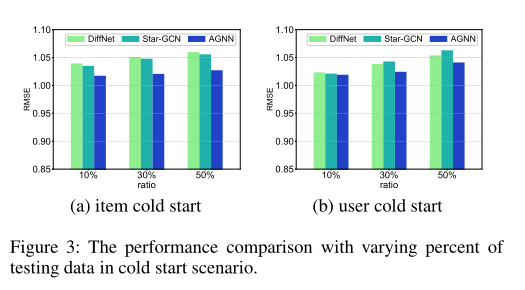

不同冷启动节点率的影响,在冷启动节点的不同部分,AGNN始终优于DiffNet和STAR-GCN。这证明了我们的AGNN在各种冷启动设置下的性能稳定。更重要的是,当增加图中冷启动节点的比率时,DiffNet和STAR-GCN的性能下降的速度比AGNN的下降更快。主要原因是DiffNet和STAR-GCN依赖于用户项目交互图,因此对冷启动节点的数量敏感,而冷启动节点的数量与用户项目图中的边数成正比。相反,AGNN专注于对属性图进行建模,并且不受交互次数有限的影响。

六、总结

在本文中,我们提出了一种新模型,即用于冷启动推荐的AGNN。我们首先强调利用交互积分图来解决神经图推荐系统中的冷启动问题的重要性。然后,我们提出一种eVAE结构,以从属性分布中推断偏好嵌入。此外,我们通过开发可极大提高模型容量的gatedGNN结构来解决在附近聚集各种信息的关键挑战。我们对两个现实世界的数据集进行了广泛的实验。结果证明,AGNN模型优于最新的冷启动推荐方法。在热启动场景中,它也比这些基准获得更好的竞争性能。