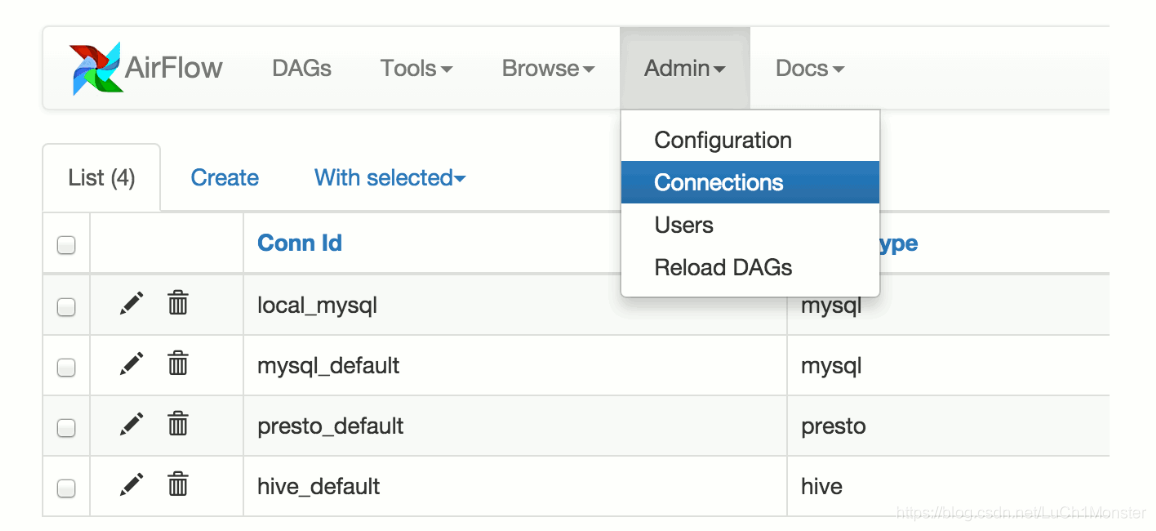

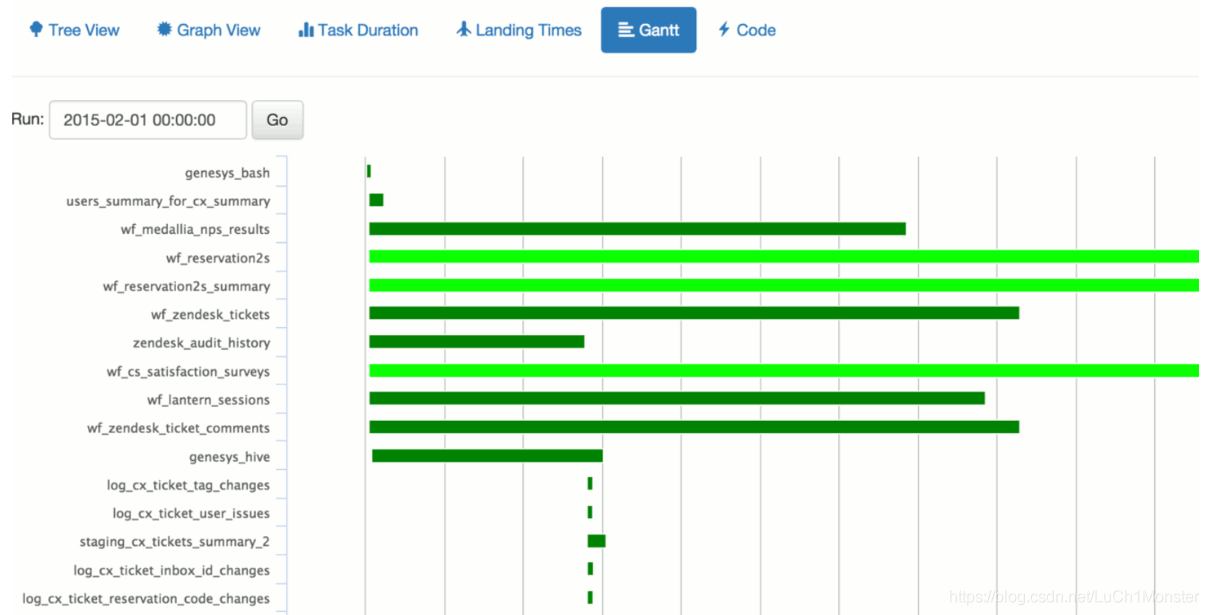

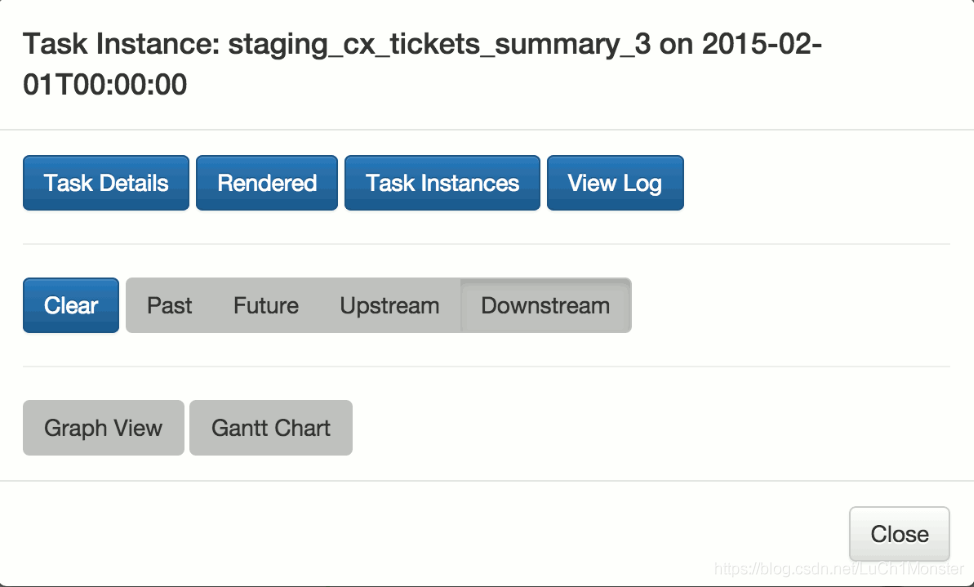

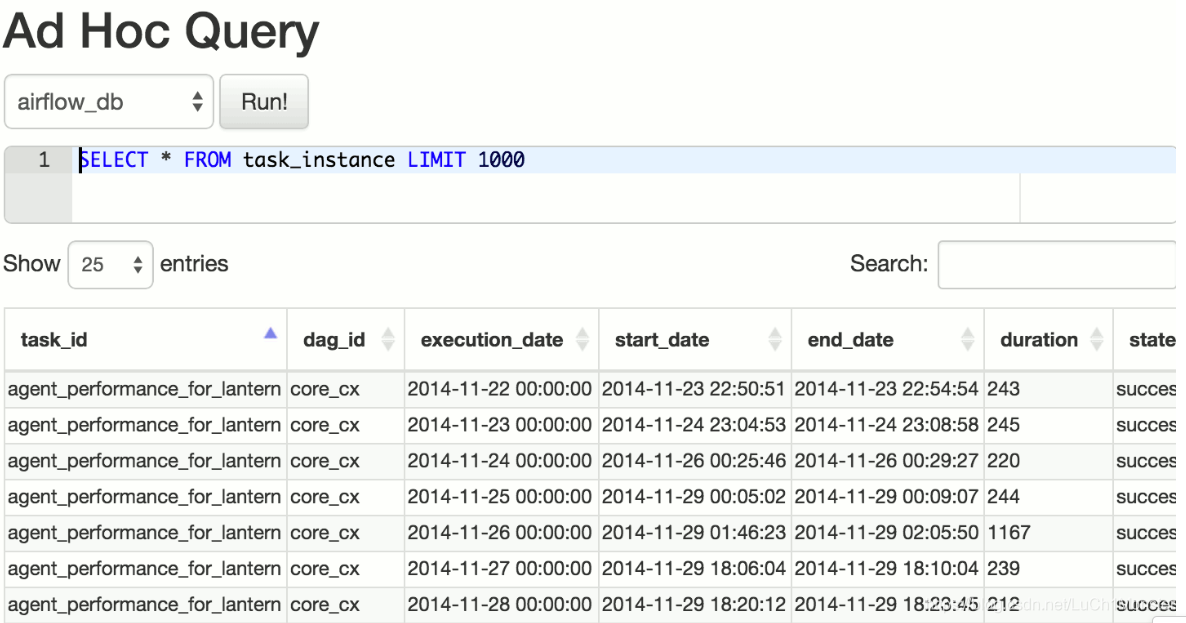

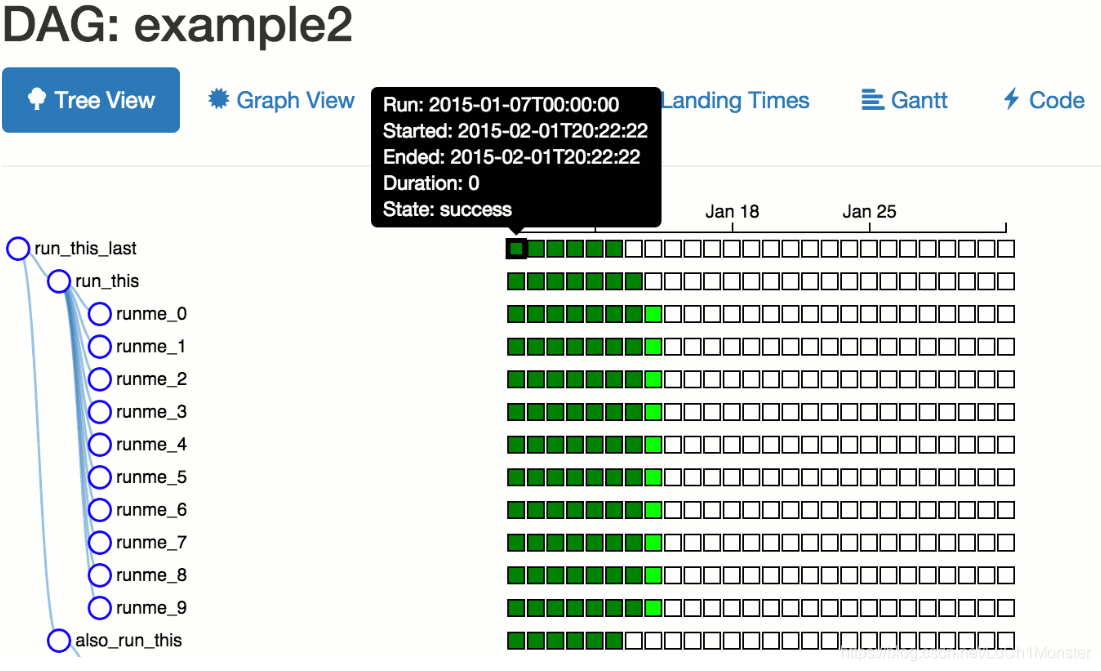

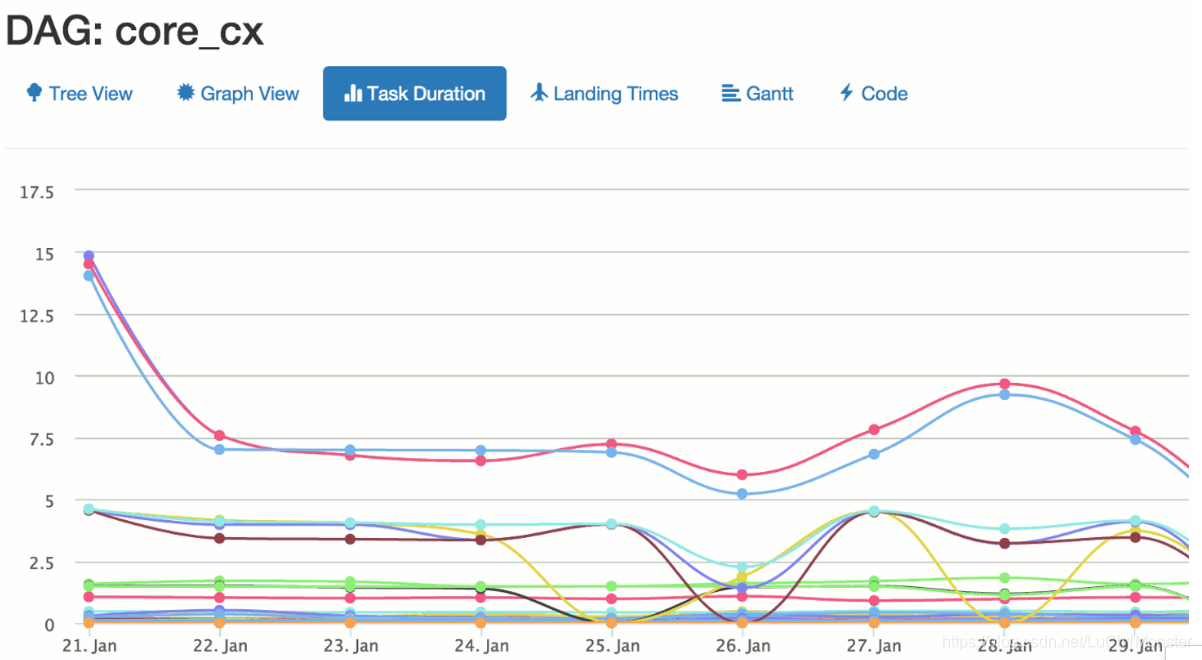

Airflow 作为一个任务平台,它通过编程方式来设计任务的工作流,并提供了强大的调度和监控功能。使用 Airflow 可以将任务设计成有向非循环图(Directed Acyclic Graphs,DAGs),调度器会根据指定的依赖项在工作节点(一个或多个)上执行你的任务。同时,Airflow 提供了丰富的命令行实用程序,使得在 DAGs 执行复杂的操作变得轻而易举。除此之外,Airflow 还具有功能丰富的用户界面,在需要的时候,我们可以非常方便地查看到生产环境中正在运行的任务,监控任务当前的执行进度,以及故障排查。

通过代码的方式来定义工作流,可以使任务更容易维护以及可视化,同时也方便测试和协同工作。

1.1 设计准则

Airflow 作为 Python 的任务调度平台,其设计准则必然很 Pythonable。

- 动态性:在 Python 脚本中 Airflow pipelines 被配置成节点形式,这使得 pipelines 的生成更具有动态性,同时这也使得编写代码时,可以动态地实例化 pipelines。

- 扩展性:轻松自定义 operators 和 executors 以及扩展相应的库,这使得 Airflow 可以非常适配于你当前的开发环境。

- 优雅性:Airflow pipelines 是非常精简的,通过 Jinja 强大的模板引擎可以非常方便地将参数化的脚本构建在 Airflow 核心上执行。

- 灵活性:Airflow 采用模块化结构的设计,通过消息队列来编排任意数量的工作节点,并且它将支持工作节点的数量扩展至无限大。

1.2 课外扩展

Airflow 并不是一个数据流的解决方案,任务节点之间并不能互相移动数据(尽管任务节点间是可以交换元数据的)。值得一提的是,Airflow 并不能组合在 Spark Streaming 或者 Storm 中,它更类似于 Oozie 或者 Azkaban。

预期工作流大都是静态的或者缓慢变化的,你可以认为工作流中的任务节点结构仅仅比数据库结构多一点动态性。Airflow 的工作流是从左到右依次执行的,这使得任务单元间的运行和持续性更加清晰。