AI + Design,设计师真的会被取代吗? 原创 阿吉UX进阶 2023-03-02 08:35 发表于北京

目录

0、初体验

1、AI绘画Stable Diffusion的原理解析

2、AI能否替代设计师?

3、未来会怎样?

4、设计师与AI如何共处,竞争or合作?

因为工作原因,20年底开始接触AIGC(文字类),从默默无闻到ChatGPT的声名鹊起,也算半个见证者。设计圈里声音很多,沉下心做研究的确很少。如今潮水褪去,希望能通过这篇文章,揭开AI绘画的华丽外表,给你带来一些新的角度,重新审视AI与设计师的关系。

如果说22,23年设计圈有什么大事,非AIGC(人工智能生成内容)莫属。其中有两个是设计师要格外关注的,一个是有文字回答类的ChatGPT,另一个是绘画类的Stable Diffusion或Midjourney。

最初我也是抱着看热闹的心态,浅玩了一下Midjourney,直到我尝试着以二十四节气为题,生成了以下海报,大家猜一下哪个是AI生成的?

正确答案是①和②,方案③来自小米日历

当我拿给视觉设计的朋友鉴赏,无不惊叹“稍微修改修改,真的就可以达到商用程度了”,同时也感受到了危机:“怕不是要下岗了!”说实话,初体验确实被惊艳到了。

但随着继续深入,我也感受到AI的一些局限性:

1、随机性。即使是同样的文案每一次结果都是不一样的;

2、部分可控。比如可以改变风格、视图、比例等;但是同样的光照要求,出来的效果也是随机的。

3、精细度不够。想修改某个图上的细节,就没办法,只能手动P;

4、不可解释性。机器创作过程是个黑盒,人无法理解机器的“思考”过程,也就更不要提什么借鉴创作理念。

即便如此,行业里仍然散发出了各种焦虑,比如有人提出:如果我们拿足够多的交互/UI图去训练是不是就可以了?

来自推特@Chris Lüders

我依然觉得不行。举个例子。

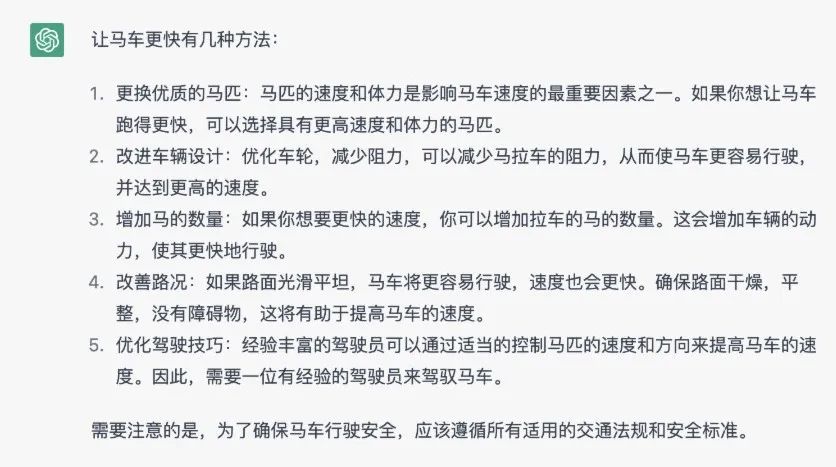

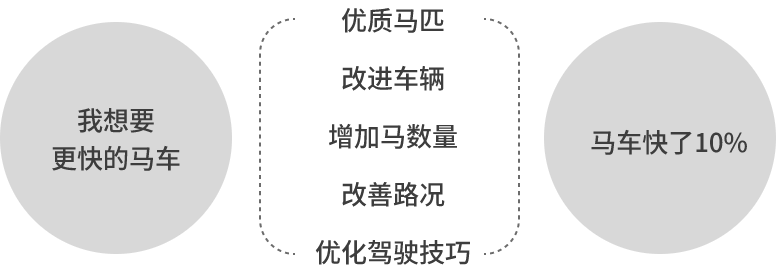

我们的用户说:“我想要更快的马车!”。于是设计师chatGPT先生很快给出了答案:

但另一位设计师human先生经过一些分析和推理,得到了不一样的答案。

用户真正的诉求其实是想更快的达到目的地。方法可以有很多,可以是蒸汽火车、蒸汽轮船、甚至是市面上不曾有过的蒸汽汽车,并不一定是一匹更快的马车。

整个分析流程里,从发散、定位问题,再到发散策略和收敛,AI可能只能帮你完成策略的发散环节,其余推导还是需要人来完成。

当然,上述也只是我的观察和推论。想弄清楚到底行不行,还要从AIGC绘画的实现原理讲起。

01 AIGC的“大脑”

AIGC,全名AI Generated Content,即人工智能生成内容(文字,图像,语音,视频等)。所谓的人工智能,就是通过计算机等人工系统,来模拟人的生理结构及思考方式。

其中最核心的“大脑”——深度学习算法,就是仿照人脑建模的神经网络。深度学习的许多研究成果,都离不开对大脑认知原理的研究,尤其是视觉原理的研究。

AI如何认知图像

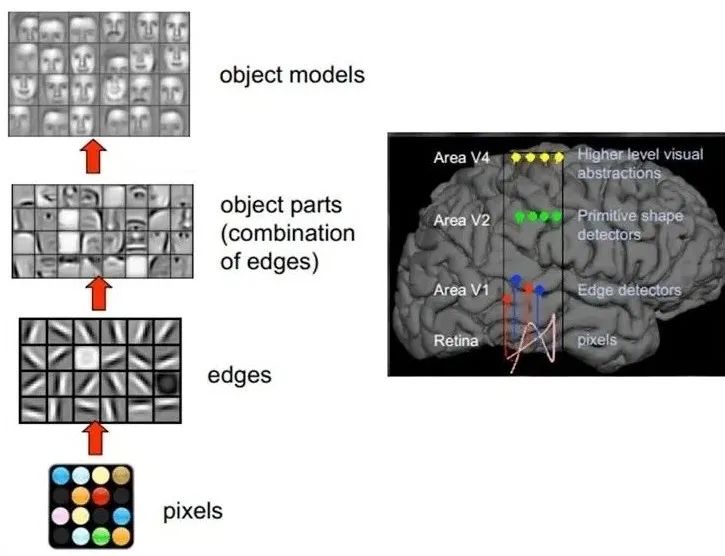

1981 年的诺贝尔医学奖,颁发给了 David Hubel(出生于加拿大的美国神经生物学家) 和TorstenWiesel,以及 Roger Sperry。前两位的主要贡献,是“发现了视觉系统的信息处理”,可视皮层是分级的。

下图是人脑进行人脸识别的一个示例:

- 图像通过光线反射到人眼,视网膜上的细胞将光线转化为电信号,并传给大脑皮层;

- 接着做初步处理:大脑皮层某些细胞发现边缘和方向;

- 然后抽象,将边缘进行组合为眼睛、嘴巴、脸部轮廓等部分,大脑判定眼前的物体的形状是人脸;

- 然后进一步抽象,组合,大脑进一步判定这个人脸是谁。

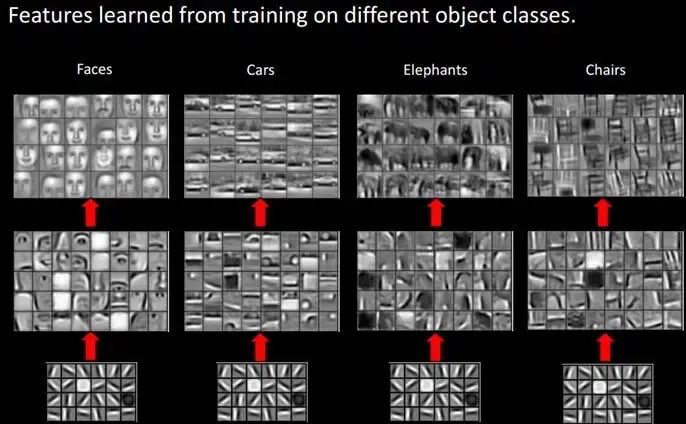

对于不同的物体,也都是通过这样逐层分级来进行认知的:

我们可以看出,最底层特征基本上是类似的,都是各种边缘;但越往上,特征越明显;直到最上层,不同的高级特征最终组合成相应的图像,从而能够让人类准确的区分不同的物体。

深度学习领域中著名的卷积神经网络 (CNN),也正是模仿人类大脑的这个特点,构造多层的神经网络,较低层的识别初级的图像特征,若干底层特征组成更上一层特征,最终通过多个层级的组合,最终在顶层做出分类。

CNN的出现,让人工图像识别向前迈出了一大步。同时在其他领域也有很多参与,比如自然语言处理、围棋领域的AlphaGo等。

深度学习中常见的人工神经网络还有循环神经网络(RNN)、生成对抗网络(GANs)、深度强化学习(RL)等,都参考了大脑神经结构。这里这里不展开细讲了,感兴趣的可以查看文末参考文献。

AI如何学习绘画

因为Midjourney暂未开源,原理不可而知,我们以同样三巨头之一的Stable Diffusion为例。

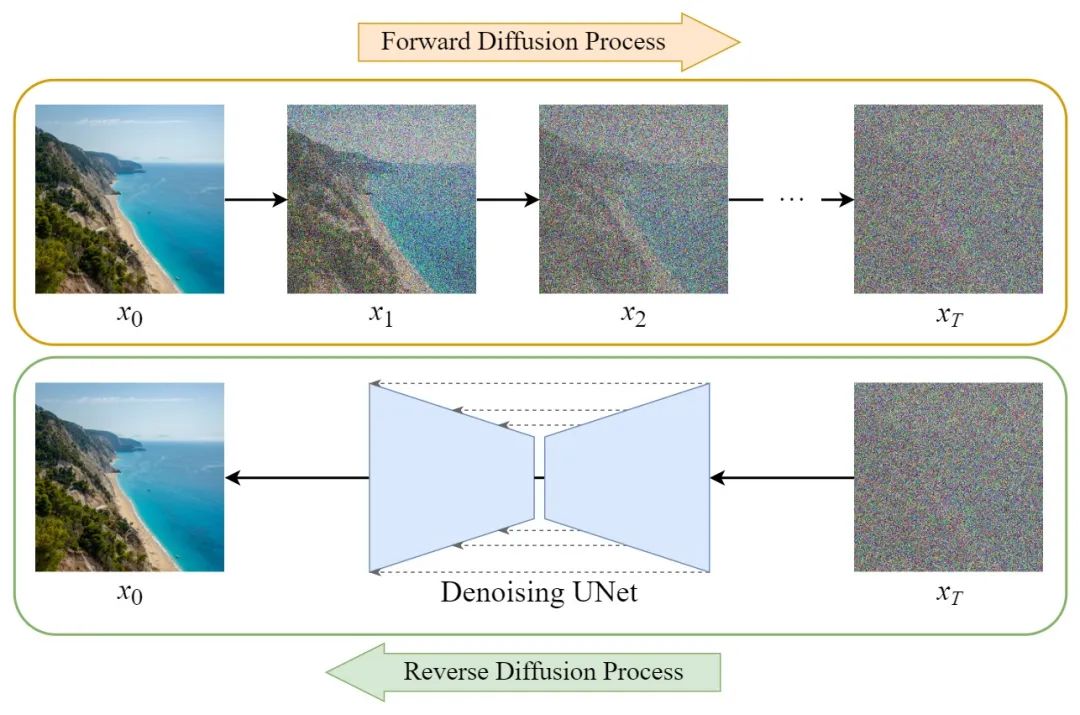

简单来讲,Stable Diffusion的学习中心,是两个扩散模型组成,姑且称为老师(前向扩散Forward Diffusion Process)和学生(反向扩散Reverse Diffusion Process)。

老师负责把图片(下图x0)加上随机的噪点T次(下图橙色部分),然后丢给学生。这里假设添加的噪点值表示为A,整个加噪过程只有老师知道,学生并不知道。

学生的任务就是把这张满是噪点的图还原(上图绿色部分),但是先不急着做,预测一个噪点值,不等于A就继续调整继续猜,直到猜对。

这样的过程要重复N次,直到学生每一次都能答对噪点值。然后图xt减去相应的噪点值,就可以还原为原图x0。

自然,学生就学会了画这张图。

最后,在海量的图和海量的预测后,学生最终得到了强大的预测能力,即预测算法模型Denoising UNet。

比较有趣的是,这里并不是传统意义上直接在白纸上绘制,而是类似于声音处理,从一片嘈杂中,一点点剔除噪声,最终得到一个清晰的人声。

所以某种意义上,Denoising UNet就是Stable Diffusion的技法中心,噪声的丰富度=绘画的丰富度,而噪声的丰富度,取决于老师拿出过多少图片。

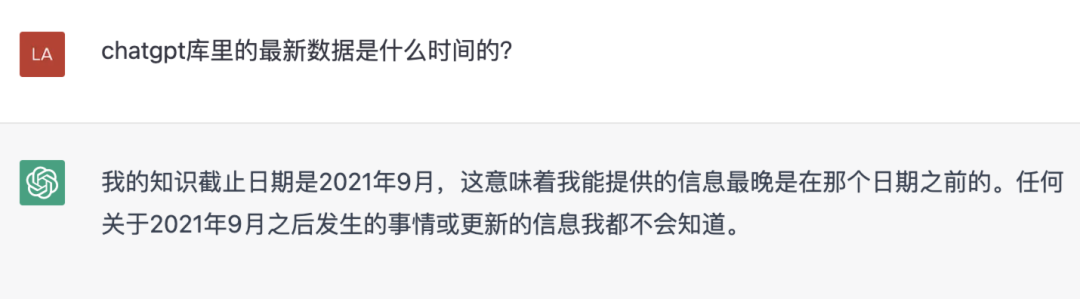

ChatGPT同理,它目前并不能解释22年以后的事情。

AI如何关联文字与图像

在学习阶段,老师会给学生一打带有标题/标签的图,标题或标签对图像内容有一定的描述,如下图:

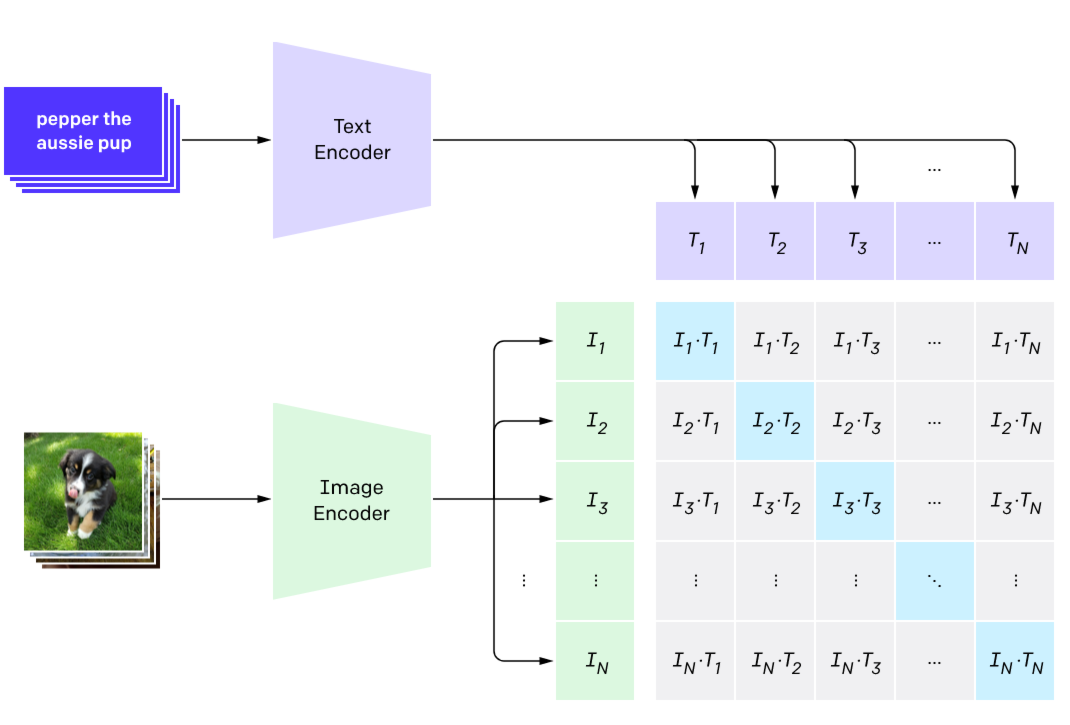

学生拿到图像后,分别会将文字分词和图像预处理,然后提取文字特征(关键词)和图像特征,这里学生会事先知道两组特征对应关系(同一张图),学生需要自己生成一套“思维方式”(神经网络算法),当两组特征输入这个神经网络,输出的结果是:

1、有对应关系的文字和图像特征相似度尽可能的高;

2、不对应的特征相似度尽可能的低。

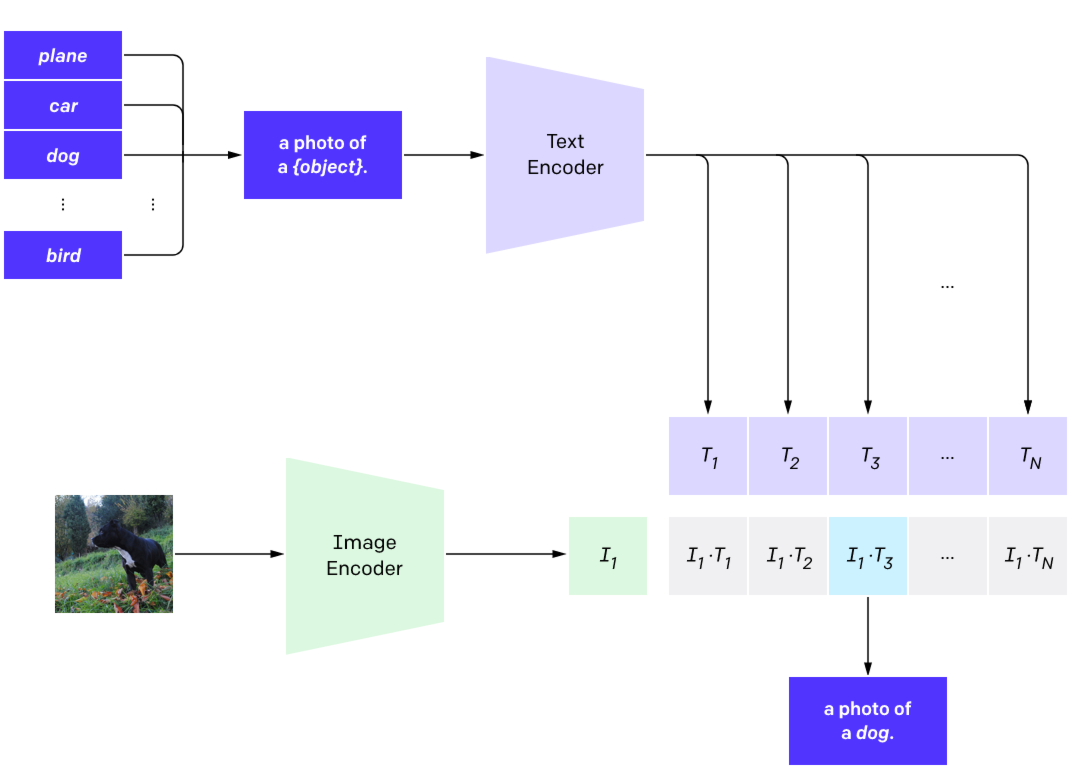

有了这套“思维方式”,当老师会再次拿着一张小狗的图和一堆关键词让学生猜时,学生只需要分别计算图片和各个文字特征的相似度即可,相似度最高的那个大概率就是dog。

这个训练模型称为CLIP(Contrastive Language–Image Pre-training),它是OpenAI的第一篇多模态预训练的算法,延续了GPT系列“大力出奇迹”的传统。为了训练这个模型,OpenAI采集了超过4亿的图像-文本对。

这个原理也解释了为什么不是所有的指令都会奏效,甚至有可能出现很大偏差——因为库里没有的文字特征,是无法找到高相似图像特征的,即使碰巧在计算结果上有相似的,也并不是真实对应的。

如何通过文字影响绘画

做好知识储备,就可以开始创作了:

1、首先是解析文字命令,这一步同样是分词和提取文字特征;

2、接着文字特征→影响图像特征→影响噪声值,相似度低的特征一并剔除掉。最终,文字影响了图像的生成。下图展现了降噪的过程。

可以看到部分人物直接被剔除掉了。

了解了这个原理,我们就明白了什么样的口令 让Stable Diffusion或者midju更精准,与其说富有诗意和意境的描述,还不如更简单直白的关键词。且关键词要尽量选择机器听的懂的维度,说白了,就是网上的标题或者标签格式,比如宫崎骏的吉卜力(风格)、顶视图(视图)、全局光(光照)等。万能的网友们也自发收集编撰了一套民间关键词大全,需要的可以后台回复“mj关键词”。

02 能否代替设计师

聊完Stable Diffusion的基本原理,我们不难看出,它的神经网络中,并没有类似人脑分析推理、解决问题及决策的结构和能力,最核心的两个结构CLIP和Diffusion,本质上都是种概率算法,不存在思想和逻辑。

这也解释了为什么会有开篇的那些感受,在少数事件中,概率确实是随机的、不可控的、且无法解释的。

很遗憾ChatGPT也是同样的底层逻辑,它们不知道自己在做什么以及为什么这样做,它们解决问题的方法,就是依赖于庞大数据以及惊人的硬件算力,通过概率统计得出一个“看起来”华丽的答案。

它更像是一个能将答案高度聚合的搜索引擎。比如这类(下图)问题的处理上真的太好用了。

03 那未来呐?

其实人工智能领域很早就在探讨这个话题。因此也将人工智能做了明确的分级:弱人工智能、强人工智能、超人工智能。

弱人工智能

弱人工智慧或称狭义人工智慧、应用型人工智慧,是实现部份思维的人工智慧,且仅专注于某项特定任务。它们通常使用特定的算法、数据和规则来解决具体问题。

用约翰·瑟尔的话来说,它“对于测试关于思想的假设很有用,但实际上并非思想”。

弱人工智慧专注于模仿人类如何执行基本动作,例如记忆或感知事物、解决简单问题。比如:AlphaGo是一种围棋软体,只能专注于下围棋。再比如今天聊到的ChatGPT、Stable Diffusion和Midjourney。

强人工智能

相反,强人工智能(也称为通用人工智能)是指那些具有类似于人类智慧、有广泛学习和适应能力的人工智能系统。

这些系统可以处理各种复杂的任务,能推理和解决问题,甚至能够通过自我学习和自我改进来不断完善自己。并且,这样的机器将被认为是具有知觉、有自我意识的。

很显然,这种人工智能才能正正意义上的替代人类设计师。不过想要达到强人工智能的水平,至少5-10年内,仍然遥不可及。

04 设计师与AI如何相处

在实际工作中,我相信大多数设计师还是具备分析问题、解决问题的能力的(但有高低差别)。

AI不稳定的“概率算法”能很好的帮我们发散思路,自由组合出更多的可能性;后续极有可能在UX领域大放异彩的模版+算法,都能将我们从繁杂的事务性工作中解脱出来,可以花更多的精力在前期的分析、定位及创作中。

但同样,“毫无意义”的发散也需要我们拥有更好的决策能力。设计师除技法外的“设计思维”,会随着AI的成熟而不断被强调和需要。

对低阶的设计师而言,如何快速具备成熟的“设计思维”会成为必修课;而对于高阶的设计师,如何更好的开发AI工具、提升工作效率和产能,也将是下一波机会点。

05 写在最后

花费了将近20天,肝完了几乎市面上所有的原理讲解,终于还算科学的写完了AI的话题。后续会尽快回归UX主线,为大家带来更多“设计思维”上的干货,咱们下期再见吧~

部分参考资料

(实在太多了尽可能放一些比较重要的):

https://jalammar.github.io/illustrated-stable-diffusion/

https://easyai.tech/ai-knowledge-hub/

wikipedia:artificial intelligence

https://arxiv.org/abs/2112.10752

https://openai.com/research/clip