实验目的

1.理解逻辑回归原理

2.掌握scikit-learn操作逻辑回归方法

实验原理

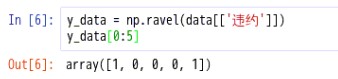

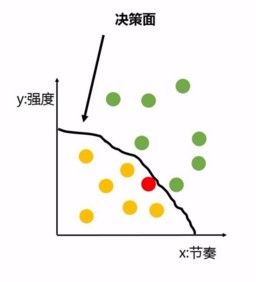

机器学习是博大精深的,除了我们上一次说的线性回归,还有一类重要的回归就是逻辑回归。逻辑回归其实用于二分分类问题,用于判断一个离散性的特征得到的标签类型的概率。举个例子,你是否喜欢一首歌是通过很多这个歌的特征(如节奏、强度等)来判断的,那么我们的数据集就是各种歌的特征,而返回的结果则是一个非1即0,不是喜欢就是不喜欢的结果:

而机器学习可以做到什么呢?它会通过模型形成一个决策面,在你喜欢和不喜欢的歌之间划出一条分界线,就像这样:

用线性回归的拟合线已经无法很好的表示结果了,这时候就是使用逻辑回归来分类的时候了,而对于Logistic Regression来说,其思想也是基于线性回归(Logistic Regression属于广义线性回归模型)。其公式如下:

其中,

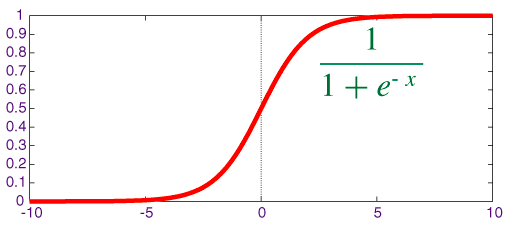

被称作sigmoid函数,我们可以看到,Logistic Regression算法是将线性函数的结果映射到了sigmoid函数中。sigmoid的函数图形如下:

我们可以看到,sigmoid的函数输出是介于(0,1)之间的,中间值是0.5,于是之前的公式 hθ(x) 的含义就很好理解了,因为 hθ(x) 输出是介于(0,1)之间,也就表明了数据属于某一类别的概率,例如 :

hθ(x)hθ(x)<0.5 则说明当前数据属于A类;

hθ(x)hθ(x)>0.5 则说明当前数据属于B类。

所以我们可以将sigmoid函数看成样本数据的概率密度函数

实验内容

根据逻辑回归,分析银行违约客户的各项特征,推测某一客户违约的情况

实验环境

Linux Ubuntu 16.04

Python 3.6.1

Jupyter

实验步骤

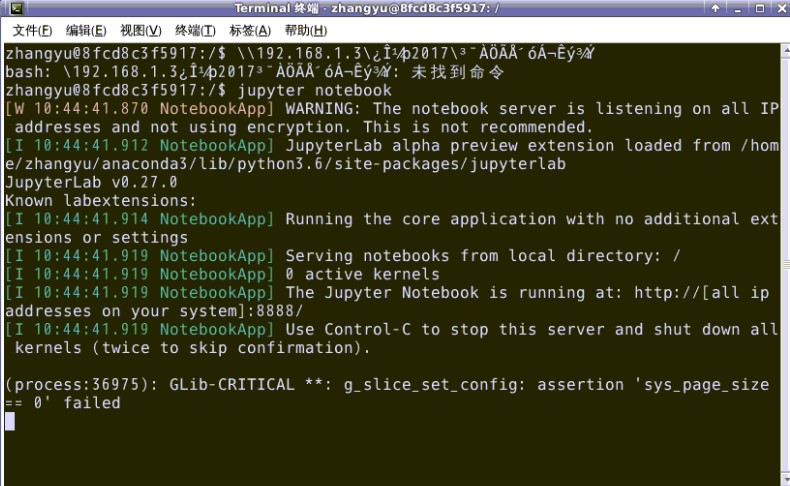

1.首先打开终端模拟器,输入下面命令:jupyter notebook —ip=’127.0.0.1’,

- cd /

- jupyter notebook —ip=’127.0.0.1’

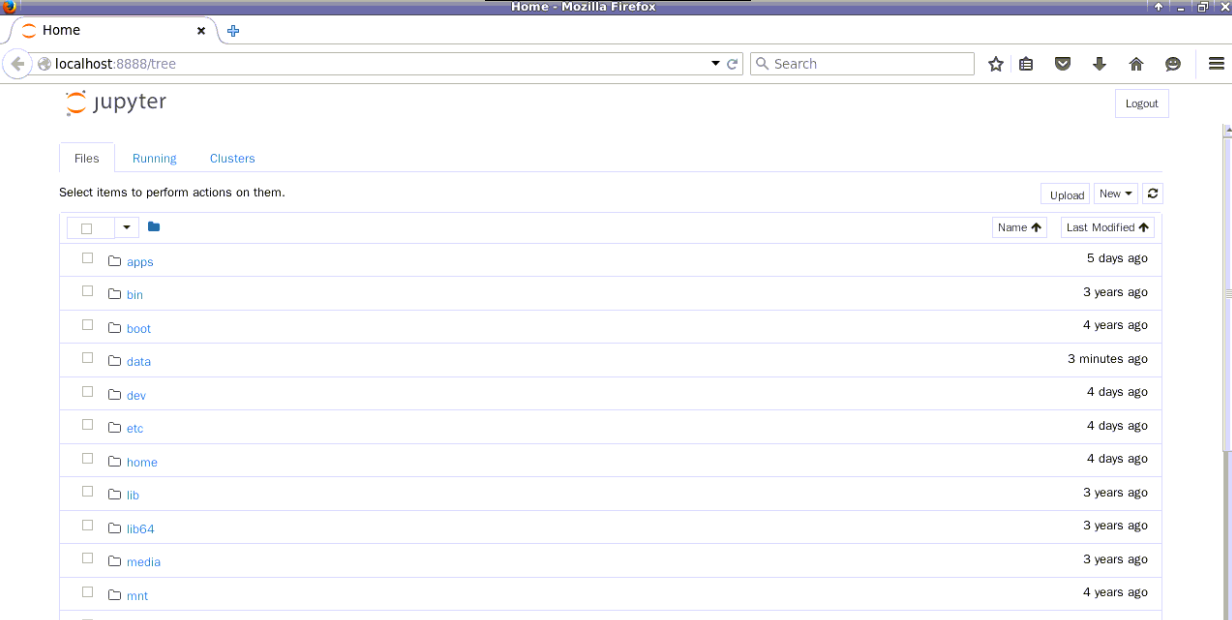

如上图所示,该终端不要关闭,在浏览器中会打开下面界面,

如果是第一次打开,浏览器界面会要求输入密码,密码为zhangyu

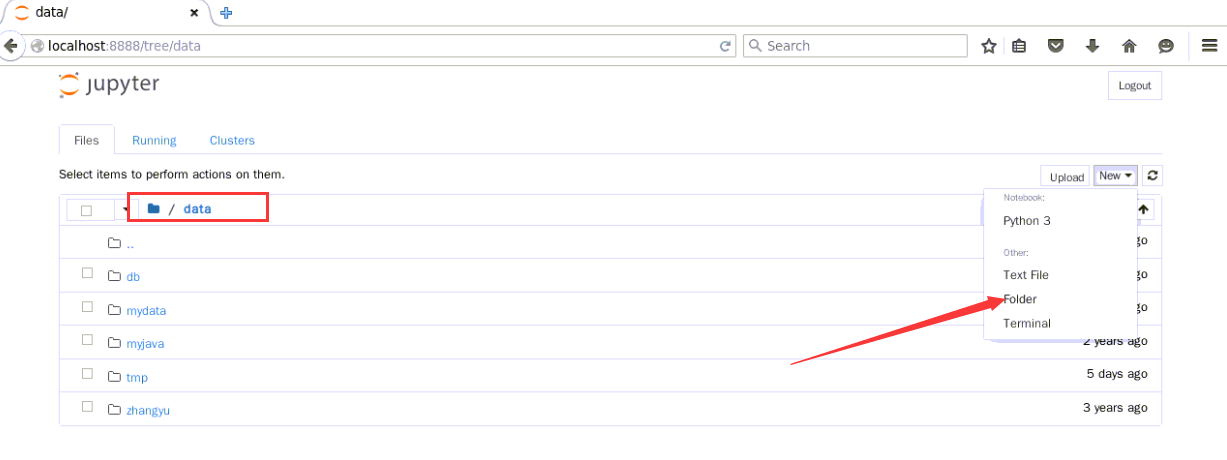

2.切换到/data目录下,点击New,在其下拉框中选择folder

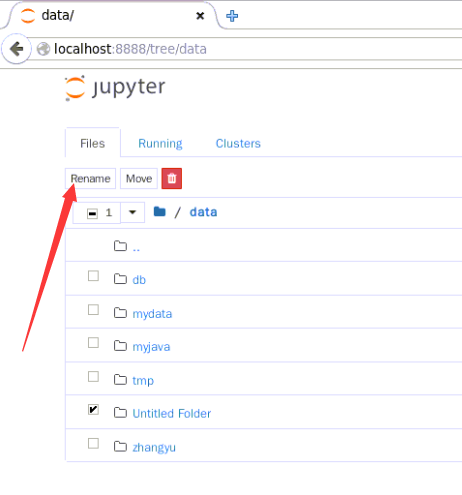

选中刚才创建的文件夹,点击页面左上角的【Rename】

重命名为logic

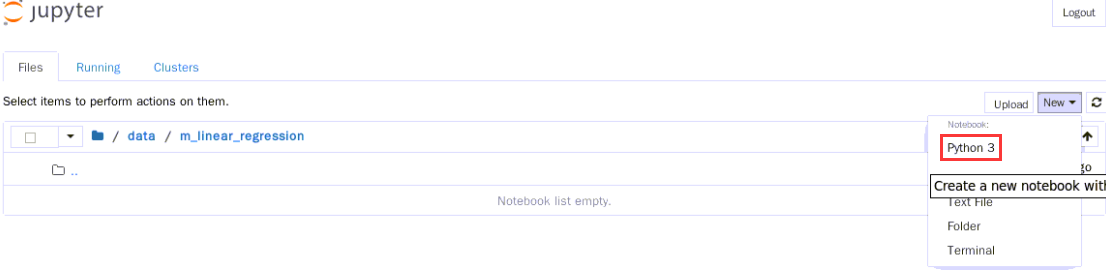

3.切换到logic目录下,新建一个ipynb文件,用于编写并执行代码。点击页面右上角的New,选中【Python3】

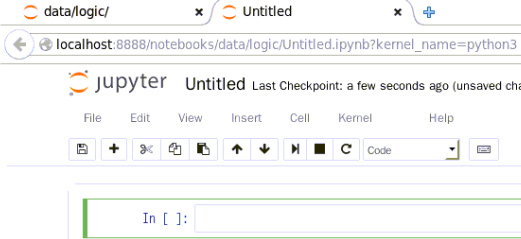

新建ipynb文件如下所示,在此可以编写代码了

4.逻辑回归

逻辑回归用于二分分类问题,回归是一种极易理解的模型,就相当于y=f(x),表明自变量x与因变量y的关系。最常见问题有如医生治病时的望、闻、问、切,之后判定病人是否生病或生了什么病,其中的望闻问切就是获取自变量x,即特征数据,判断是否生病就相当于获取因变量y,即预测分类。

(1)业务理解

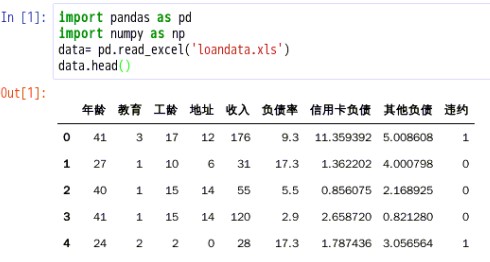

某银行违约客户信息表如下:(这里只展示了部分数据)我们通过银行客户资料违约情况表来做逻辑回归分析,其中的年龄、教育、工龄、地址、收入、 负债率、信用卡负债、其他负债就是获取自变量x,即特征数据,判断是否违约就相当于获取因变量y,即预测分类。

(2)获取数据并读取数据

2.1.打开linux终端,下载所需资源

cd /data/logicwget http://192.168.1.100:60000/allfiles/sklearn/logic/loandata.xls

2.2在刚才新建的ipynb文件中,编写代码,读取数据

#导入pandas库和numpy库import pandas as pdimport numpy as np#读取loandata.xlsdata= pd.read_excel('loandata.xls')#读取前五行数据,如果是最后五行,用df_women.tail()data.head()

2.3.点击如下所示按钮,运行文件

(3)数据理解

3.1.查看数据结构

3.2.查看数据列名称

说明:loandata.xls中列名称为:‘年龄’‘教育’‘工龄’‘地址’‘收入’‘负债率’‘信用卡负债’‘其他负债’’违约‘

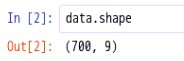

(4)数据准备

4.1.删除’违约‘这一列数据得到特征数据

4.2.获取’违约‘这列数据得到预测分类

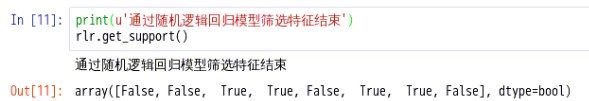

(5)随机逻辑回归模型

5.1.训练模型

fit(X, y) Fit the model using X, y as training data.

- x:array-like, Training samples 训练样本

- y: array-like, Target values 目标值,如果需要的话可以转换为训练样本的数据类型.

5.2. 获取特征筛选结果

get_support([indices=False]) 获取所选列的掩码或整数索引

参数说明:indices:boolean,默认False

返回值:从特征向量中选择保留特征的索引。

如果indices为False,则这是一个布尔数组[#输入要素],如果为其保留选择了其对应的特征,则元素为True

如果indices为True,则这是一个整形数组[#输出要素],其值是输入要素向量中的索引

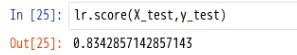

5.3.获得score值

score(X, y[, sample_weight]) 返回给定测试数据和标签的平均精度

(6)训练模型

6.1.创建新的特征矩阵

6.2.建立训练数据和测试数据

- train_test_split是交叉验证中常用的函数,功能是从样本中随机的按比例选取训练数据(train)和测试数据(test)

- 第1个参数:所要划分的样本特征

- 第2个参数:所要划分的样本标签

- random_state:它的用途是在随机划分训练集和测试集时候,划分的结果并不是那么随机,也即,确定下来random_state是某个值后,重复调用这个函数,划分结果是确定的

6.3.进行逻辑训练

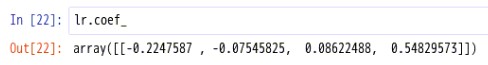

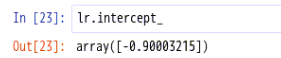

6.4.查看训练模型参数

说明:逻辑回归的回归系数如上所示

说明:逻辑回归截距为 -0.90003215

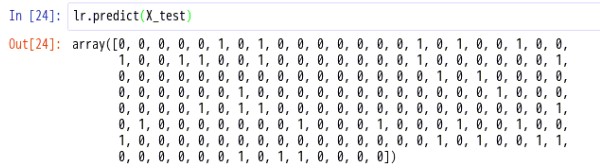

6.5.预测数据

使用模型的predict方法对划分的X测试数据可以进行预测得值“违约”情况

(7)模型评价

我们使用“准确率”来评估模型:

得到的结果准确率为0.834

具体的可以参考http://scikit-learn.org/stable/modules/generated/sklearn.linear_model.LogisticRegression.html#sklearn.linear_model.LogisticRegression

至此,实验结束!