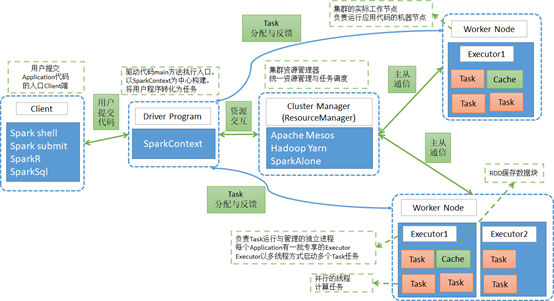

一、Spark架构设计

1、架构设计图

2、相关术语解释

RDD

- 弹性分布式数据集,是对数据集在spark存储和计算过程中的一种抽象。

- 是一组只读、可分区的的分布式数据集合。

- 一个RDD 包含多个分区Partition(类似于MapReduce中的InputSplit),分区是依照一定的规则的,将具有相同规则的属性的数据记录放在一起。

- 横向上可切分并行计算,以分区Partition为切分后的最小存储和计算单元。

- 纵向上可进行内外存切换使用,即当数据在内存不足时,可以用外存磁盘来补充。

Partition(分区)

- Partition类似hadoop的Split,计算是以partition为单位进行的,提供了一种划分数据的方式。

- partition的划分依据有很多,常见的有Hash分区、范围分区等,也可以自己定义的,像HDFS文件,划分的方式就和MapReduce一样,以文件的block来划分不同的partition。

- 一个Partition交给一个Task去计算处理

算子

- 英文简称:Operator,简称op

- 广义上讲,对任何函数进行某一项操作都可以认为是一个算子

- 通俗上讲,算子即为映射、关系、变换。

- MapReduce算子,主要分为两个,即为Map和Reduce两个主要操作的算子,导致灵活可用性比较差。

- Spark算子,分为两大类,即为Transformation和Action类,合计有80多个。

Transformation类算子

- 操作是延迟计算的,也就是说从一个RDD 转换生成另一个 RDD 的转换操作不是马上执行,需要等到有 Action 操作的时候才会真正触发运算。

- 细分类

Value数据类型的Transformation算子

Key-Value数据类型的Transfromation算子

Action类算子

- 会触发 Spark 提交作业(Job),并将数据输出 Spark系统

窄依赖

- 如果一个父RDD的每个分区只被子RDD的一个分区使用 ——> 一对一关系

宽依赖

- 如果一个父RDD的每个分区要被子RDD 的多个分区使用 ——> 一对多关系

Application

- Spark Application的概念和MapReduce中的job或者yarn中的application类似,指的是用户编写的Spark应用程序,包含了一个Driver功能的代码和分布在集群中多个节点上运行的Executor代码一般是指整个Spark项目从开发、测试、布署、运行的全部。

Driver类

- 运行main函数并且创建SparkContext的程序。称为驱动程序,Driver Program类似于hadoop的wordcount程序中的driver类的main函数。

Cluster Manager

- 集群的资源管理器,在集群上获取资源的服务。如Yarn、Mesos、Spark Standalone等。

- 以Yarn为例,驱动程序会向Yarn申请计算我这个任务需要多少的内存,多少CPU等,后由Cluster Manager会通过调度告诉驱动程序可以使用,然后驱动程序将任务分配到既定的Worker Node上面执行。

WorkerNode

- 集群中任何一个可以运行spark应用代码的节点。

- Worker Node就是物理机器节点,可以在上面启动Executor进程。

Executor

- Application运行在Worker节点上的一个进程,该进程负责运行Task,并且负责将数据存在内存或者磁盘上,每个Application都有各自独立专享的一批Executor。

- Executor即为spark概念的资源容器,类比于yarn的container容器,真正承载Task的运行与管理,以多线程的方式运行Task,更加高效快速。

Task

- 与Hadoop中的Map Task或者Reduce Task是类同的。

- 分配到executor上的基本工作单元,执行实际的计算任务。

- Task分为两类,即为ShuffleMapTask和ResultTask。

ShuffleMapTask:即为Map任务和发生Shuffle的任务的操作,由Transformation操作组成,其输出结果是为下个阶段任务(ResultTask)进行做准备,不是最终要输出的结果。

ResultTask:即为Action操作触发的Job作业的最后一个阶段任务,其输出结果即为Application最终的输出或存储结果。

Job

- Spark RDD里的每个action的计算会生成一个job。

- 用户提交的Job会提交给DAGScheduler(Job调度器),Job会被分解成Stage去执行,每个Stage由一组相同计算规则的Task组成,该组Task也称为TaskSet,实际交由TaskScheduler去调度Task的机器执行节点,最终完成作业的执行。

Stage

- Stage是Job的组成部分,每个Job可以包含1个或者多个Stage。

- Job切分成Stage是以Shuffle作为分隔依据,Shuffle前是一个Stage,Shuffle后是一个Stage。即为按RDD宽窄依赖来划分Stage。

- 每个Job会被拆分很多组Task,每组任务被称为Stage,也可称TaskSet,一个作业可以被分为一个或多个阶段

二、Spark用户交互方式

1、操作方式

- spark shell:spark命令行的方式操作

- spark-submit:通过程序脚本提交相关代码,依赖来操作

- spark-sql:通过sql的方式来操作

- spark-class:最底层的方式

- sparkR、sparkPython:通过其他语言直接操作

2、重要操作方式介绍

2.1 spark shell

启动方式:spark-shell —master local [ * ]

相关参数:spark-shell —help2.2 spark-submit

脚本提交任务的模板;

spark-submit \

—class\

—master\

—jars jar_list_by_comma \

—conf= \

… # other options\

[application-arguments]