本文涵盖特征提取(feature detection)、特征描述(feature description)、特征匹配(feature matching)、图像配准(image registration)、立体匹配(stereo matching)、点集或点云配准(point set or point cloud registration)、图匹配(graph matching)、误配剔除与鲁棒估计(mismatch removal,如 RANSAC 系列)等相关子领域。该综述着重介绍了近二十年来图像匹配领域较为经典的方法,以及近年来基于深度学习的方法。同时在图像匹配大框架下分析了各子领域扮演的角色以及他们之间的联系,这亦是该综述的主要特色。此外,相关典型应用和实验对比在文中也有所涉及。

下面就图像匹配中应用极为广泛的特征匹配进行简单介绍,包括问题定义分类、研究背景与意义、研究现状及发展趋势。更多细节可查看原论文。

内容整理自作者的知乎专栏:

https://zhuanlan.zhihu.com/p/112071397

https://zhuanlan.zhihu.com/p/112082541

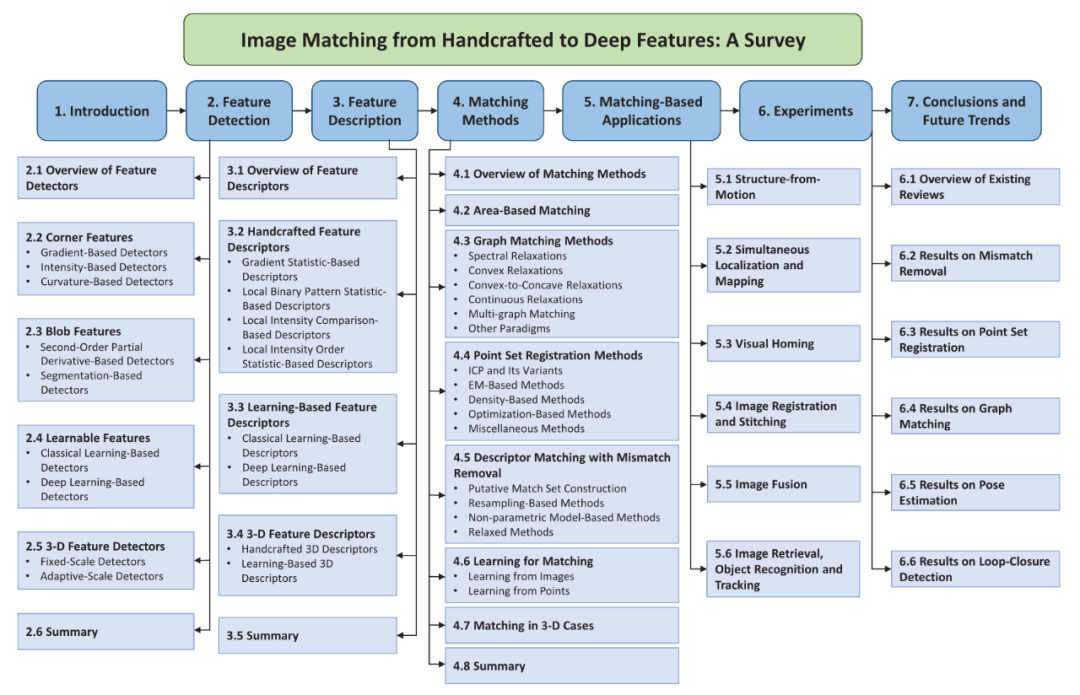

综述整体框架

一、问题定义及分类

图像匹配 [1–6](Image Matching)旨在将两幅图像中具有相同 / 相似属性的内容或结构进行像素上的识别与对齐。一般而言,待匹配的图像通常取自相同或相似的场景或目标,或者具有相同形状或语义信息的其他类型图像对,从而具有一定的可匹配性。

从定义出发,图像匹配主要包含匹配目标和匹配准则两个部分,即以什么信息为目标载体和以何种规则或策略进行匹配。最直接的匹配目标便是整张图像或以截取的图像块(Image Patch),一般被称为基于区域 (Area-Based)的方法,其主要分为两种:i)直接根据图像或图像块灰度信息进行像素上的对齐,该方法主要思想是直接最小化图像信息差异,一般包括交叉相关法(或互 相关法),相关系数度量法,互信息法等 [5,7–9];ii)基于图像域变换的图像匹配,其先将图像信息进行域变换,然后在变换域中对图像进行相似性匹配,包括傅里叶变换法, 相位相关法,沃尔什变换法等 [10–12]。基于区域的图像匹配方法对成像条件、图像形变(特别是要求图像对具有极高的重叠度)以及噪声极其敏感,同时具有较高的计算复杂度,从而限制了其应用能力。

为解决上述问题,基于特征(Feature-Based)的图像匹配方法得到了广泛研究 [5,13]。其首先从图像中提取的具有物理意义的显著结构特征,包括特征点、特征线或边缘以及具有显著性的形态区域 [14–18],然后对所提取的特征结构进行匹配并估计变换函数将其他图像内容进行对齐。尽管特征的提取需要额外的算力消耗,但针对整个基于特征的匹配框架而言,由于特征可以看做整张图像的精简表达,减少了许多不必要的计算,同时能够减少噪声、畸变及其他因素对匹配性能的影响,是目前实现图像匹配的主要形式,也是本文研究重点。

对于特征而言,点特征通常表示图像中具有显著特性的关键点(Key Point)或兴趣点(Interest Point) [19],因而最为简单且稳定,同时其他特征的匹配均可转化为基 于点特征来进行,如线的端点、中点、或离散采样形式,形态区域中心等 [18,20–22]。因 此,特征点匹配在图像匹配中是一个最为基本的问题,而我们所说的特征匹配(Feature Matching)通常意义上指基于特征点的匹配问题,待匹配的点一般由图像像素空间的坐标点表示,而相应的图像匹配则转化为从两幅图像中提取对应的点集并配对的问题。本文主要研究内容便是从特征匹配问题的本质特性出发,结合其他领域技术手段,围绕基于特征点的图像匹配方法展开深入研究,克服图像匹配问题目前面临的诸多挑战。

二、研究背景及意义

近年来,科技水平日益提高,形成了全球自动化的格局,随之而来的人工智能技术蓬勃发展,其主要目的是令机器联合计算机像人类一样感知、理解与行动。视觉感知作为最主要的感知技术之一,在此次人工智能热潮下占据着举足轻重的地位,因而推动着计算机视觉技术迅猛发展。同时,如何理解多个视觉目标之间的区别与联系,并根据特定的需求对感知的信息作相应的处理已然成为整个计算机视觉领域的研究热点之一,而特征匹配作为其中的一个基础而关键的过程,连接着具有相同或相似属性的两个图像目标,是低层视觉通往高层视觉的纽带,是实现信息识别与整合 [23–25] 以及从低维图像恢复高维结构 [26,27] 的有效途径。

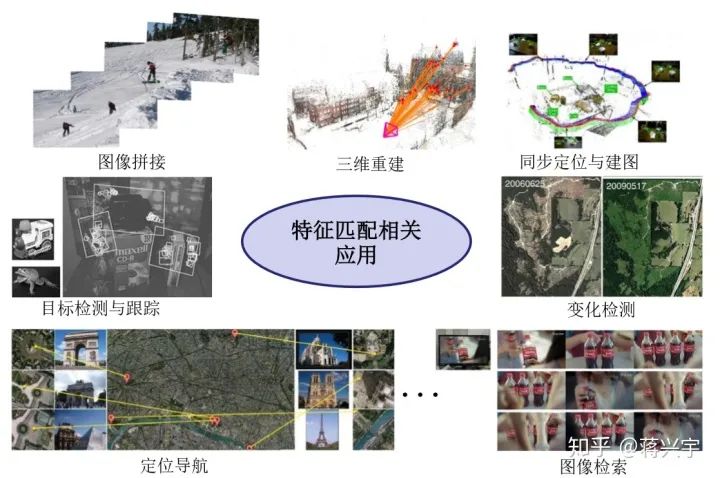

图像特征匹配相关应用

特征匹配的定义和任务目标极为简单且明确,它是一项底层视觉处理技术,直接对图像本身进行特征提取与配对,是许多具体大型视觉任务的首要步骤。据美国自动 成像协会(Automated Imaging Association)统计,40% 以上的视觉感知应用依赖于图像匹配的精度与效率,包括计算机视觉、模式识别、遥感、军事安防以及医学诊断等各领域。具体来讲,根据数据获取条件或者成像条件的差异,特征匹配问题可以划分 为不同时间、不同视角以及不同传感器,或者进行模板图像的匹配 [3,5],并且每一类 型的图像获取形式都有着对应的应用目的:1)基于不同成像时间的特征匹配。主要是对同一场景或目标在不同时间拍摄的图像进行匹配,一般用于场景的变化检测,安防监控与目标跟踪,以及医学诊断治疗中病情跟踪等。2)基于不同视角的特征匹配。其主要目的是匹配从不同视角拍摄的同一目标或场景的序列图像进行匹配,旨在从低维的图像内容恢复高维结构,如恢复相机姿态并建立相机移动轨迹,目标或场景的三维 重建,以及遥感全景影像拼接等。3)基于不同传感器的特征匹配。鉴于不同传感器所获取的图像有着各自的优势且包含不同的感知信息,因而对不同的图像信息进行整合并得到更全面的场景或目标表示是十分必要的,而特征匹配便是将包含多源信息的图像进行关键点配对并估计变换函数从而将图像进行逐像素对齐,便于后续的信息融合,因而又称为多源图像特征匹配。这类匹配常用于医学图像分析中多模图像匹配,安防及军事领域中如红外可见光配准,遥感图像处理中不同分辨率且包含不同光谱信息的 影像配准与融合等。4)基于模板的特征匹配。这类匹配一般给定图像模板,然后将获取的图像与模板进行比较与匹配,常用于模板识别、差异检测或内容检索,如基于视觉的模式识别(字符识别,车牌识别)、图像检索,医学图像分析中病情诊断,标本分类以及遥感图像中航空或卫星图像在已知的其他地理信息地图中的匹配与定位等。

由此可见,特征匹配作为一项基础而关键的技术在诸多领域有着重要地位,因而对其展开深入研究有着重要实际应用价值。此外,作为许多高层视觉任务的底层输入,基于特征点的图像匹配问题也面临着多方面的挑战,其中包括准确性、鲁棒性(普适性)和高效性。

首先,特征匹配精度在许多基于匹配的精准估计应用上有着极高的要求,匹配误差会保留在后续处理环节中并逐渐累积从而严重制约最终视觉任务的有效实施。例如 根据特征点匹配结果求解相机运动参数从而恢复高维结构(Structure From Motion, SFM)的任务, 错误的匹配将产生相机姿态的错误估计,使得类似于三维重建 [27] 和同 步定位与建图 [28,29](Simultaneous Localization and Mapping,SLAM)等任务的结果 严重偏离于真实情形,同时图像融合、图像拼接和变化检测等 [23,25,30] 任务同样严重依赖于图像配准的结果。精度问题通常来自于两个方面——特征提取精度和特征匹配精度。特征点匹配一般需要对从图像中提取出来的关键点进行定位,即以像素坐标的形式表示,通常该坐标要精确到亚像素级且两个待匹配点集应具有较高的重复率,保 证所检测的特征点是真正意义上可匹配的 [13];特征匹配精度则表现为所配对的两个特征点在真实空间中应当属于精确的同名位置,或者具有相同的语义特征,同时匹配结果中需要保证尽可能多的正确匹配以及尽可能少的错误匹配。其次,设计一种鲁棒的特征匹配方法以满足多方面的需求是十分必要的。待匹配图像通常来自不同时间、不同视角和不同传感器,成像条件多样性不可避免地造成了图像的匹配难度,况且图像本身的局部形变或畸变,以及图像之间的复杂变换等因素同样对特征匹配问题造成了严重阻碍。除此之外,如何减少因噪声、畸变、重复图像内容以及遮挡等问题造成的错误匹配也是特征匹配中亟需解决的问题。另一方面,为了满足大规模以及具有实时性要求的视觉任务,特征匹配方法应当满足较少的时间和空间消耗。然而特征点的匹 配问题本质上是一个复杂组合优化难题 [31],为了将 N 个特征点与另外 N 个特征点对齐,尽管这两组点是完全可匹配的,同样也需要 N! 种排列组合,况且离群点和噪声的引入将大大增加问题的求解难度,因而在建模求解过程中,如何减少解的搜索空间,降低问题的计算复杂度也是特征匹配的重要难题。

综上所述,基于特征的图像匹配技术存在多方面的难题,有待进一步深入的研究,以满足众多视觉任务的应用需求,因而开展特征匹配相关的课题具有重要的理论研究与实际应用价值。

三、特征匹配研究现状

在进行特征匹配之前,我们首先需要从两幅图像中提取显著并且具有可区分性和可匹配性的点结构。常见的点结构一般为图像内容中的角点、交叉点、闭合区域中心点等具有一定物理结构的点,而提取点结构的一般思想为构建能够区分其他图像结构的响应函数 [15,32](Response Function)或者从特征线或轮廓中进行稀疏采样 [21]。为此,Morevec [19]于 1977 年首次提出了 “兴趣点” 的概念,并介绍了一种基于局部像素灰度差异的特征点检测方法。然而该方法存在方向、尺度、仿射和噪声上的敏感性,以及较大的时间需求。为此,大量研究者针对该问题提出了一系列的改进措施,其中著名 的 Harris [14] 角点检测器便是运用二阶矩或自相关矩阵来加速局部极值搜索并且保证方向的不变性,为了进一步减少导数的计算,一种基于局部区域像素灰度比较的快速特征提取方法被广泛应用于具有实时要求的视觉任务中,其中包括 SUSAN 算子 [32], 以及采取不同像素比较方法和比较范围的 FAST [16] 及其改进形式如:FAST-ER [33]、 AGAST[34] 等,同时还包括在实时视觉任务中应用极为广泛的 ORB 特征 [28,35]。基于像素比较的特征提取方法也称为二值特征,通常具有极高的提取效率并具有一定的方向不变性以及所提取的特征点具有较高的重复率,对后续的匹配具有重要意义,然而这类方法受尺度和仿射变换的影响较大。

针对上述问题,带有尺度信息的斑点特征成为特征提取的另一种形式,其最早是由 Lindeberg 等人[36] 提出的高斯拉普拉斯(Laplace of Gaussian,LoG)函数响应来实现,并从中提出了尺度空间理论,其利用高斯响应函数的圆对称性和对局部团结构的极值响应特性以及对噪声抑制能力,通过不同高斯标准差实现在尺度空间上的极值搜索,从而提取对尺度、方向和噪声鲁棒的特征点并得到相应的尺度信息。为了避免大量的计算,D.Lowe 等人 [37,38] 介绍了一种高斯差分(Difference-of-Gaussian,DoG) 法来近似 LoG 的计算,并提出了著名的 SIFT 特征描述子。基于相同的思想,Bay 等 人 [39] 在 Hessian 矩阵的基础上结合箱式滤波以及图像积分对梯度进行快速计算,提出了 SURF 算子,极大程度地提升了斑点特征的检测速度。此外,许多基于 SIFT 和 SURF 的改进方法也相继被提出,其中包括减少计算量、提升仿射鲁棒性等 [40–43]。为满足精确的匹配要求,所提取的特征通常需要精确的位置信息并保证两个点集具有较高的可重复性和可匹配性。因此,大多特征提取方法中均会采用非极大值抑制(NMS)来提升局部特征点的显著性和稳定性,并且通过像素空间的插值方法估计特征点在亚像素空间的精确极值位置,具体的特征提取相关综述请参考 [5,13,44–47]。

一旦两个可匹配的点集提取完成,图像匹配任务便转化为对两个特征点集进行配对。对此,目前已涌现出了许多开创性的工作及其后续的改进方案,主要从特征匹配的本质属性入手,从不同角度对特征匹配进行定义与假设,并结合相关技术手段对问题建模与求解。根据现有文献以及相关研究成果,特征匹配问题主要从直接和间接求解两个思路进行。直接匹配的思想主要是将特征匹配问题抽离为两个点集对应的问题,直接从中估计正确的点点对应关系,而间接匹配一般先通过特征点的局部描述子的相 似程度建立初步的对应关系,然后根据几何约束剔除误匹配。此外,由于深度学习 [48] (Deep Learning,DL)技术在深层特征层面强大的学习与表达能力,基于深度卷积网 络的特征匹配技术也得到了广泛关注 [4,49,50],为解决图像匹配问题提供了一个新的方向。本文将对上述解决特征匹配的技术路线中主要方法进行分析总结。

- 3.1 直接匹配策略

前面我们提到,直接匹配主要是将特征匹配问题抽离为两个点集的对应问题,也 称为纯点集匹配问题。首先我们假设待匹配的两个特征点集为 和 , 这里 分别表示不超过 M 和 N 的自然数,点集 分别称为模板点集 和目标点集。匹配的目的即是求解一个指派矩阵 , 其中 代表 和 的对应关系,并通过一定的约束条件以及目标函数构建,优化求解得到指派矩阵。一般而言,以 来表示 与 匹配与否,即 代表两者属于匹配关系, 反之则不匹配;较为松弛的方法便是令 ,即指派变量属于 0 到 1 之间的连 续概率值,用以表征和之间的匹配程度。基于这一策略的特征匹配方法主要有基于对应矩阵估计和基于图模型的特征匹配两种。

i) 基于对应矩阵估计的特征匹配算法。

对应矩阵的估计需要结合变换函数的建模和参数估计而同时进行,一般用于点集配准问题。这类算法的目标通常是通过变换模型与对应矩阵的估计,将目标点集变换并映射到模板点集中,使得变换后两个点集中属于配对的点能够尽可能重合,因此其最小化目标函数一般包含目标点集变换后与模板点集的空间距离和指派矩阵的组合形式构成经验误差项,并且对应矩阵的相关约束条件和变换函数的平滑性、复杂性等将构成额外的惩罚项。为了实现目标函数的优化与求解,常用的方法是两个待求解变量在反复迭代更新中逐渐逼近其最优形式。因此,变换模型的选择也成为了基于对应矩阵估计的特征匹配方法的重点。对于静态场景图像而言,图像对或待匹配的两个点集一般满足多视图几何变换,即极线几何或单应等约束条件,其通常由一个 3×3 的矩阵表示,矩阵中不同元素结构和矩阵的自由度代表 着平移、尺度、旋转、仿射等基础变换,结合点集的齐坐标形式,可以反映点集间的这种静态几何变换的度量与建模。然而图像中一般存在局部形变、成像畸变或者动态目标等非刚性变换,此时静态场景中的全局几何形变模型将无法适用,常用的策略则是 采用插值理论中的几何形变模型,如径向基函数(Radial Basis Function, RBF),其中薄板样条(Thin-PlateSplines,TPS)和高斯径向基函数在非刚性点集配准中得到了广 泛应用 [51,52]。例如,Chui[53] 等人提出了一种基于 TPS 估计的鲁棒点集匹配(Robust PointMatching,RPM)框架,并且为了提升对数据退化的鲁棒性,Myronenko 等人 [54] 基于高斯径向基函数提出了一致性点漂移算法(Coherent Point Drift,CPD)。基于对应矩阵估计的特征匹配算法框架能够在刚性和非刚性匹配中均取得不错效果,但是当点集中存在大量离群点或数据退化严重时,算法性能将大大降低,甚至失效。此外,该模型框架本身属于一个复杂组合优化问题,其求解空间极其复杂,在迭代估计的过程中需要大量的时间消耗。

ii) 基于图模型的特征匹配算法。

图模型的构建为特征匹配问题提供了一个新颖的思路,将待匹配特征点看作图的顶点,点点之间连接成边,便可以通过图论的相关理 论对特征点匹配问题建模与求解,因此也称为图匹配(Graph Matching)[55,56]。图匹配方法主要分为精确图匹配和非精确图匹配,精确方法主要将图匹配看作一个子图同构问题,严格要求图结构的相似性,从而导致其求解难度以及解决实际问题的不适用性,而非精准匹配弱化了图结构的相似度量,在实际问题中更加灵活,目前图匹配的研究重点主要围绕非精确匹配进行。另一方面,图匹配的本质目标是从两个点集中搜索具有相似图结构的最大子集,其关键步骤主要有图的构建和图模型优化求解。图的构建主要在于边的定义以及邻接矩阵(Adjacent Matrix)和关联矩阵(Affinity Matrix)的构建,低阶边的定义通常只包含两点之间的直接距离,而高阶边则由三个或三个以 上的顶点来定义,同时邻接矩阵有全连接形式以及 ϵ− 近邻、K - 近邻和三角连接等稀疏形式两种类型,关联矩阵则用以表征图结构之间的亲和性,主要包含顶点亲和(一阶亲和性)和边亲和(二阶亲和性),不同构图形式将影响模型的求解效率和精度。另外基于图理论的特征匹配模型的研究重点一般是优化方法的探索 [57,58],主要将图匹配问题看做一个二次分配的问题 [56,59](Quadratic Assignment Problem,QAP),现有的求解形式通常是将模型转化为一个能量最小化问题,主要分为基于梯度(Gradient Based)的优化方式以及通过拉普拉斯矩阵(Graph Laplacians)在主特征的基础上进行谱方法(Spectral Based)的求解,例如谱匹配(Spectral Matching,SM) [60] 和移动图匹配 [61](Graph Shift,GS)、蒙特卡罗法 [62](Monte Carlo)、随机行走法 [63] (Random Walk)以及基于聚类的匹配方法 [64] 等。总而言之,基于图理论的特征点匹配方法能够从全局结合局部结构的相似性对特征点集进行结构划分并配对,是实现特征匹配的一个具有较强理论研究意义的途径,然而由于其 QAP 和 NPC 属性,因而具有较高的计算复杂度,同时噪声和离群点的影响会直接制约图匹配算法的有效性。因此,研究图匹配算法的快速优化求解以及针对噪声和离群点的鲁棒建模来提高匹配精度与效率是目前图匹配的研究重点。

- 3.2 间接匹配策略

间接匹配策略一般分为两个阶段,第一个阶段先根据待匹配的特征点构建具有特定属性的描述子(Feature Descriptor),从而为每个特征点赋予各自的特征向量,然后根据描述子的相似程度建立粗略的对应关系。常用的特征描述方法主要分为基于局部图像梯度统计的浮点型描述子和基于像素灰度比较的二值型描述子,前者极具代表性的便是 SIFT 描述子 [37,38],其通过对局部像素进行网格划分并统计 8 个方向上的梯度 同时确定梯度主方向,随后将其排列为一个能够描述该特征点的高维向量。SIFT 能够取得较为满意的匹配效果,并且对光照、方向、尺度以及图像质量具有一定的鲁棒性。为了进一步提升 SIFT 的实现速度以及准确性,SURF 中引入了 Haar 响应策略,并以高斯函数进行局部加权,统计扇形区域导数方向进行特征描述。Yan 等人 [42] 提出了 一种基于特征降维的改进形式 PCA-SIFT,以及其他改进如:C-SIFT [41]、ASIFT [40]、 DSP-SIFT [65] 等。基于像素比较的二值特征描述方法,主要包含不同的采样策略和采样范围,比如:Michael 等人 [66] 于 2010 年在特征点局部矩形区域内针对不同的采样形式进行了对比测试,提出了一种 BRIEF 二值描述方法;次年,Stefan 等人 [67] 提出了一种基于变尺度同心圆采样形式的特征描述方法 BRISK,并且随后的 Alexandre 等人 [68] 提出了一种基于视网膜采样的二进制特征描述子 FREAk。不同特征提取和不同描述方法的相互组合可以得到不同的初始匹配构建效果,如 ORB 特征在 FAST 的基础上根据 Harris 响应进行前 N 个可靠特征挑选,随后采取灰度质心法确定其主方向, 并利用 BRIEF 特征描述方法,结合学习的策略确定二进制编码方式,是目前最为快速的建立初始匹配方法之一。总之,二值型描述子最终通过汉明距离对描述子的相似度进行度量,相对而言具有较高的实现速度,而浮点型描述子则一般采用欧式距离进行相似度度量,具有较高稳定性。针对特征描述的相关综述及其特征提取描述和匹配性能对比,同样可以参考 [13,44–47]。

此外,对于已经存在的两个具有物理形状的待匹配的点集而言,比如从二维形状中离散而来的特征点集,该点集一般会脱离图像本身,因而基于图像信息的描述方法将不再适用,此时可以通过形状上下文 [21](ShapeContext,SC)来构建描述子,或者三维情况则通过自旋图 [69]、以及二维描述子的三维改进形式 [38,70](MeshDOG/MeshHOG)进行特征描述并建立初始匹配。不管怎样,这种粗略的对应由于仅利用了局部信息,同时噪声、离群点、遮挡和重复内容等原因,造成初始匹配中会存在大量的错误匹配关系,比如现有的基于描述子的特征匹配方法一般错误匹配比率高达 50% 以上 [17,45], 而如果设定更严格的阈值条件,正确比率会有很大提升,但同时也会牺牲大量的正确匹配。因此,在下一步中,则需要根据所建立的初始匹配的空间几何约束将误匹配剔除,同时保留尽可能多的正确匹配。

间接匹配策略将特征匹配问题转化为一个从初始匹配集 剔除误匹配的问题,其中 N 表示具有 N 对已建立好初始对应关系的匹配对。一类经典的剔除 \误匹配同时估计参数模型的方法便是随机采样一致性 [71](RANdom SAmple Consensus,RANSAC),以及后续的改进形式如 MLESAC [72]、PROSAC [73]、SCRAMSAC [74]、USAC [75] 等,统称为基于重采样的方法。这类方法旨在初始匹配中通过反复地采样估计匹配点集间预定义的变换模型,来寻找满足其估计的模型的最大内点集作为正确的匹配对。该方法严重依赖于采样的准确性,显然当初始匹配中存在大量离群点时,所需采样次数显著提升,从而使得该方法的效率大大降低,同时变换模型一般无法预先定义,甚至一些非刚性情况无法建模,从而导致这类方法不再适用。另一类用于解决非刚性变换图像匹配的方法则是基于非参数插值或拟合的方法,其主要基于先验条件插值或回归学习出定义的非参数函数,将一幅图像中的特征点映射到另一幅图像中,然后通过核查初始点匹配集中每个匹配对是否与估计出的对应函数一致来剔除 错误匹配。例如通过鲁棒估计对应函数用于离群点剔除的 ICF 算法 [76],以及利用非刚性变换模型在再生核希尔伯特空间 (Reproducing kernel Hilbert spaces, RKHS) 中的 泛函表达形式及其稀疏近似形式,结合高斯混合模型 (Gaussian mixed model, GMM) 与正则化理论在这一匹配框架中取得了卓越的成效 [77–86],较为代表性的算法有基于向量场一致性点集匹配算法 VFC[81]、基于流形正则化点集匹配算法 MR-RPM [87]、基于局部线性迁移匹配算法 LLT[88] 等。该类方法在离群点较多或者点集中存在独立的运动结构以及其他具有极为复杂的变换时匹配精度会急剧下降。此外,一些松弛的方法,例如在建立初始匹配后利用图匹配相关的约束条件,通过局部结构一致性以及分段一 致性的假设,对正确匹配进行鲁棒估计。比如基于局部保留的特征匹配方法 LPM [89]、 GLPM [90],基于网格划分运动一致性算法 [91](GMS),基于分层运动一致性的特征匹配方法 [92,93] 等。由于建立初始匹配通过描述子的相似度量构建,然后根据几何约束剔除误匹配,相比于直接匹配策略,这类方法能够使特征匹配问题得到高效解决。然而,如何快速建立包含正确对应的初始匹配,对匹配问题定义以及挖掘正误匹配之间的分布差异和特点,设计一种快速精确的误配剔除策略也是许多学者关注的重点。

- 3.3 深度学习策略

目前,深度学习方法因其对深层特征有着优越的学习和表达能力,以火爆的方式应用于计算机视觉的各个领域,其同样在图像匹配问题上崭露头角并取得了初步成效。深度学习在图像匹配中最合理的应用便是直接从包含相同或相似结构内容的图像对中学习到像素级别的匹配关系,其主要形式有以下几种:1)以深度学习方法解决传统类似于 SIFT [37,38] 建立初始匹配中的一个或多个环节,又或者直接设计一个端到端的匹配网络,例如学习从图像中检测更精确可靠的特征点集、学习每个特征点的主要 方向或主要尺度及其更具有区分性和可匹配能力的特征描述子 [94–96],一些代表方法如 LIFT [17]、NCN [50]、LF-Net [97]、SuperPoint [98] 等;又或者学习描述子之间更可靠的相似性度量准则等 [99,100]。这一系列的策略在某些方面已经证明了其相对于传统方 法的优越性 [101,102],然而其中同样存在大量的错误匹配,依旧需要误匹配剔除策略进 行后处理。2)在双目立体匹配(Stereo Matching)中,直接从图像对中学习得到深度 图 [103,104],这种方法已在公共数据集 KITTI [105] 和 Middlebury [106] 中取得了统治性的结果,然而其一般依赖于两张图像具有较高的重合度并且经过校正与对齐,因而具有 一定的局限性。3)基于深度学习的图像块匹配 [99,107,108](Patch Matching)涌现出了大量的研究成果,其主要通过深度学习方法获取图像块之间的深层特征,并度量特征之间相似性来建立对应关系,这类方法一般用于提取好的特征点的描述子构建、图像 检索、宽基线立体匹配 [103](Wide-Baseline Stereo Matching)以及图像配准 [99,109,110] 等方面。

深度学习在匹配中的另外的一种应用便是从两个点集中学习其局部和全局特征并建立可靠的点对应关系。由于三维点云数据的稠密特性是的其具有类似于图像的纹理细节信息,可以方便地通过深度卷积方式进行学习,因而应用较广 [111,112]。然而三维点云中的深度学习策略,并不适用于稀疏的特征点集匹配任务,为了解决这一问题,通过深度学习方法学习点集之间的几何拓扑结构也成为当前研究热点之一。其主要目的是学习两个图结构之间的相似性,或者通过局部邻域结构一致性学习来建立点集之间的配对关系 [49,50],又或者通过点集间的几何变换模型进行约束,即在建立匹配的过程中同时学习变换模型的参数 [113,114],如基于学习的可靠匹配搜索 [113](Learning to Find Good Correspondences,LFGC),其旨在从稀疏初始匹配集结合相机本征矩阵学习一个多层深度感知机,结合参数几何变换模型构建损失函数,实现模型估计同时剔除误 匹配,或者基于局部结构一致性的图学习网络来挖掘潜在的正确对应关系 [50,115]。

除此之外,国内学者针对特征匹配问题也进行了较为系统的研究,例如国防科学技术大学赵键 [116] 和复旦大学宋智礼[2] 在他们各自的博士课题中分别针对点模式的匹配问题和图像配准技术及其应用进行了专门研究,华中科技大学马佳义 [3] 的博士课题研究了基于非参数模型的点集匹配模型框架,并提出了一系列的基于正则化理论的非参数建模和快速求解形式,哈尔滨工业大学于伟 [4] 的博士课题则研究了基于深度神经网络特征的图像匹配方法,主要解决深度学习框架下的深层特征表达与语义匹配问题,此外华中科技大学柳成荫 [117] 在其博士课题中,针对不同领域的应用需求,从多模与多视角非刚性图像配准问题展开了专门的研究。

综上所述,特征匹配方法的研究根据问题的定义以及求解策略有着大量的研究成果,然而由于应用场景的复杂性,造成目前的特征匹配方法存在多方面的局限,主要包括处理速度,匹配精度以及针对噪声和非刚性形变的鲁棒性。因此,本文的主旨便是对特征匹配问题进行系统与深入的研究,从不同的角度定义特征匹配问题,并采用有效的技术解决当前匹配算法的应用局限性。

四、特征匹配发展趋势

特征匹配问题由来已久,理论上的突破使得现有的方法具有一定的实际应用能力,然而面对诸多方面的应用需求,以及特征匹配问题本身的复杂特性,其依然是一个具有理论研究意义和实际应用价值的开放性话题,因此需要进一步地深入研究,同时深度学习技术的强大能力也使得特征匹配问题面临着进一步的突破。接下来,综合当前研究现状以及相关难题,特征匹配技术的发展趋势主要涉及以下几个方面:

- 传统方法的进一步推进

根据图像匹配的概念可知,图像匹配技术可以应用于任何含有对相似或相同结构及内容信息的识别、检测、整合与应用的视觉任务中,尽管现阶段深度学习方法在许多视觉任务中逐渐取代了传统的基于图像匹配的思路,并取得了突出的成果,但图像匹配因其高鲁棒性、可扩展性、可解释性依旧是众多领域的主流方法。前面提到,匹配误差会保留在后续处理环节中并逐渐累积从而严重制约最终视觉任务的有效实施,错误的匹配将产生某些精确估计的错误计算会使得一些视觉任务结果严重偏离于真实情形。因而设计一种高精度和高效率的匹配方法,以满足当前具有实性或大规模的实际应用需求,是特征匹配后续发展的主要趋势。另外,一定程度上提升特征点的提取与描述能力,如提取更精确更具有重复性和可匹配能力的特征,更显著和可区分性的特征描述子,获取具有高内点比率和内点数量的初始匹配对,实现实时性的特征提取与匹配方法,以及研究更高效鲁棒的特征点匹配模型及其求解形式都会为特征匹配技术在实际应用中带来实质性的突破。

- 深度学习方法的引入

实现图像匹配方法的多样性,脱离传统的匹配方法,基于深度学习方法的图像匹配将会成为今后研究热点之一。通过深度学习方法解决图像匹配中特征检测、主方向或主尺度检测、特征描述、相似性度量与配对、误匹配剔除、变换模型估计等传统匹配步骤中的一个或多个环节,又或者直接设计一个端到端的匹配网络,从而进一步改善传统图像特征提取、特征描述以及特征匹配中存在的缺陷,比如:提取出更具有表现力和可精确匹配的特征结构,或者传统的特征描述方法仅基于直观的图像梯度或灰度信息统计而得到,因而需要学习一种更为深层且更具有区分力的特征描述方法,又或者基于欧氏距离的浮点型描述子和基于汉明距离的二值型描述子相似度度量形式存在一定的局限,从而需要学习得到一种更合理的度量形式得到更准确的匹配结果。

从图像匹配抽象出来的点集匹配和图匹配问题,会进一步启发基于图理论的深度网络的相关研究。基于稀疏点集的深度学习方法目前存在着两个方面的挑战,首先是 如何将几何数据(稀疏点集)建立成图,此图为 image 而非 graph,或者构建能够处理 几何数据的网络结构。原因在于现有卷积神经网络主要依托于 image 而进行,改变图像内容顺序将很大程度改变整张图像的结构信息,对网络输出结果造成极大影响,而几何数据本身具有无序性,即改变几何数据的排列顺序(如端点顺序),不会影响几何问题本身的任何属性。同时更高维的几何数据是几何问题中常见的数据类型,从高维数据到低维建图也存在严峻挑战。其次,现有深度理论在模式识别中具有显著成效。如何去寻找几何数据的或者空间点的近邻关系,判断其相对位置,识别多点之间的边、角等几何信息,是联合深度卷积理论解决传统几何问题的重要挑战。

- 协同匹配与增量匹配

近年来,多图像协同匹配和增量匹配相关成果初露锋芒 [118–120]。这类匹配在联合多张图像匹配信息,互相监督引导的概念上一定程度地提高了匹配的精度,为了满足这一特性,传统的匹配优化模型需要进一步地扩展,极大程度地增加了求解复杂度。尽管协同匹配与增量匹配在匹配精度和效率上难以取得合理的权衡,然而这一概念在解决多序列图像匹配应用方面依旧具有较大的研究价值。

首先如何对协同匹配问题进行有效建模和高效求解本身是一个极具有理论研究意义的问题,其次,这一理念契合人类视觉对多目标信息的联合挖掘与利用这一特性,同时多图像协同检测、分割、超分等视觉任务目前已取得了不错成效,证明这一理念是可行且有意义的。另外,以多序列图像和增量式为基础的视觉任务,如三维重建、SLAM、机器人导航定位等,目前依旧依赖于传统的两两图像对之间的单一匹配,协同匹配的引入可以简化这些任务中的匹配环节,同时提高匹配精度。同时,多图像的协同匹配保证了充足的数据量以及引入了更丰富的图像间的协同信息,而传统的手工方法难以挖掘其中深层且复杂的匹配信息,基于这一特性,运用深度学习方法解决多图像协同匹配与增量匹配则具有极为广阔的前景。

参考文献

[1] 马颂德. 计算机视觉: 计算理论与算法基础. 北京: 科学出版社 [M]. 1998.

[2] 宋智礼. 图像配准技术及其应用的研究 [D]. 复旦大学, 2010.

[3] 马佳义. 基于非参数模型的点集匹配算法研究 [D]. 华中科技大学, 2014.

[4] 于伟. 基于卷积神经网络特征的图像匹配研究 [D]. 哈尔滨工业大学, 2017.

[5] Zitova B, Flusser J. Image registration methods: a survey[J]. Image and vision computing, 2003, 21(11): 977–1000.

[6] Dawn S, Saxena V, Sharma B. Remote sensing image registration techniques: A survey[C]. International Conference on Image and Signal Processing. 2010: 103– 112.

[7] Pratt W K. Digital image processing john wiley & sons[J]. Inc., New York, 1991.

[8] Viola P, Wells iii W M. Alignment by maximization of mutual information[J]. International journal of computer vision, 1997, 24(2): 137–154.

[9] Barnea D I, Silverman H F. A class of algorithms for fast digital image registration[J]. IEEE transactions on Computers, 1972, 100(2): 179–186.

[10] Bracewell R N, Bracewell R N. The Fourier transform and its applications: Vol 31999[M]. [S.l.]: McGraw-Hill New York, 1986.

[11] De castro E, Morandi C. Registration of translated and rotated images using finite Fourier transforms[J]. IEEE Transactions on pattern analysis and machine intelligence, 1987(5): 700–703.

[12] Chen Q-S, Defrise M, Deconinck F. Symmetric phase-only matched filtering of Fourier-Mellin transforms for image registration and recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 1994(12): 1156–1168.

[13] Tuytelaars T, Mikolajczyk K, others. Local invariant feature detectors: a survey[J]. Foundations and trends® in computer graphics and vision, 2008, 3(3): 177–280.

[14] Harris C G, Stephens M, others. A combined corner and edge detector.[C]. Alvey vision conference: Vol 15. 1988: 10–5244.

[15] BeaudetPR.Rotationallyinvariantimageoperators[C].Proc.4thInt.JointConf. Pattern Recog, Tokyo, Japan, 1978. 1978.

[16] Rosten E, Drummond T. Machine learning for high-speed corner detection[C]. European conference on computer vision. 2006: 430–443.

[17] Yi K M, Trulls E, Lepetit V, et al. Lift: Learned invariant feature transform[C]. European Conference on Computer Vision. 2016: 467–483.

[18] Matas J, Chum O, Urban M, et al. Robust wide-baseline stereo from maximally stable extremal regions[J]. Image and vision computing, 2004, 22(10): 761–767.

[19] Moravec H P. Techniques towards automatic visual obstacle avoidance[J], 1977.

[20] Brogefors G. Hierarchical chamfer matching: A parametric edge matching algorithm[J].IEEETransactionsonPatternAnalysis&MachineIntelligence,1988(6): 849–865.

[21] Belongie S, Malik J, Puzicha J. Shape matching and object recognition using shapecontexts[J].IEEETransactionsonPatternAnalysis&MachineIntelligence, 2002(4): 509–522.

[22] Mikolajczyk K, Schmid C. Indexing based on scale invariant interest points[C]. null. 2001: 525.

[23] Radke R J, Andra S, Al-kofahi O, et al. Image change detection algorithms: a systematic survey[J]. IEEE transactions on image processing, 2005, 14(3): 294– 307.

[24] Zheng L, Yang Y, Tian Q. SIFT meets CNN: A decade survey of instance retrieval[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(5): 1224–1244.

[25] Ma J, Ma Y, Li C. Infrared and visible image fusion methods and applications: A survey[J]. Information Fusion, 2019, 45: 153–178.

[26] Fuentes-pacheco J, Ruiz-ascencio J, Rendón-mancha J M. Visual simultaneous localization and mapping: a survey[J]. Artificial Intelligence Review, 2015, 43(1):

[27] Fan B, Kong Q, Wang X, et al. A Performance Evaluation of Local Features for Image Based 3D Reconstruction[J]. arXiv preprint arXiv:1712.05271, 2017.

[28] Mur-artal R, Montiel J M M, Tardos J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE transactions on robotics, 2015, 31(5): 1147– 1163.

[29] Mur-artalR, TardósJD.Orb-slam2: Anopen-sourceslamsystemformonocular, stereo, andrgb-dcameras[J].IEEETransactionsonRobotics, 2017, 33(5): 1255– 1262.

[30] Hua Z, Li Y, Li J. Image stitch algorithm based on SIFT and MVSC[C]. 2010 Seventh International Conference on Fuzzy Systems and Knowledge Discovery: Vol 6. 2010: 2628–2632.

[31] Wang C, Wang L, Liu L. Progressive mode-seeking on graphs for sparse feature matching[C]. European Conference on Computer Vision. 2014: 788–802.

[32] SmithSM,BradyJM.SUSAN—anewapproachtolowlevelimageprocessing[J]. International journal of computer vision, 1997, 23(1): 45–78.

[33] Rosten E, Porter R, Drummond T. Faster and better: A machine learning approach to corner detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2010, 32(1): 105–119.

[34] MairE,HagerGD,BurschkaD,etal.Adaptiveandgenericcornerdetectionbased on the accelerated segment test[C]. European conference on Computer vision. 2010: 183–196.

[35] Rublee E, Rabaud V, Konolige K, et al. ORB: An efficient alternative to SIFT or SURF.[C]. ICCV: Vol 11. 2011: 2.

[36] Lindeberg T. Feature detection with automatic scale selection[J]. International journal of computer vision, 1998, 30(2): 79–116.

[37] LoweDG, others.Objectrecognitionfromlocalscale-invariantfeatures.[C].iccv: Vol 99. 1999: 1150–1157.

[38] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2): 91–110.

[39] Bay H, Tuytelaars T, Van gool L. Surf: Speeded up robust features[C]. European conference on computer vision. 2006: 404–417.

[40] Morel J-M, Yu G. ASIFT: A new framework for fully affine invariant image comparison[J]. SIAM journal on imaging sciences, 2009, 2(2): 438–469.

[41] Abdel-hakim A E, Farag A A. CSIFT: A SIFT descriptor with color invariant characteristics[C]. 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR’06): Vol 2. 2006: 1978–1983.

[42] Ke Y, Sukthankar R, others. PCA-SIFT: A more distinctive representation for local image descriptors[J]. CVPR (2), 2004, 4: 506–513.

[43] Agrawal M, Konolige K, Blas M R. Censure: Center surround extremas for realtime feature detection and matching[C]. European Conference on Computer Vision. 2008: 102–115.

[44] Schmid C, Mohr R, Bauckhage C. Evaluation of interest point detectors[J]. International Journal of computer vision, 2000, 37(2): 151–172.

[45] Mukherjee D, Wu Q J, Wang G. A comparative experimental study of image feature detectors and descriptors[J]. Machine Vision and Applications, 2015, 26(4): 443–466.

[46] Uchida Y. Local feature detectors, descriptors, and image representations: A survey[J]. arXiv preprint arXiv:1607.08368, 2016.

[47] Krig S. Interest point detector and feature descriptor survey[G]. Computer vision metrics. [S.l.]: Springer, 2016: 187–246.

[48] Lecun Y, Bengio Y, Hinton G. Deep learning[J]. nature, 2015, 521(7553): 436.

[49] Choy C B, Gwak J, Savarese S, et al. Universal correspondence network[C]. Advances in Neural Information Processing Systems. 2016: 2414–2422.

[50] Rocco I, Cimpoi M, Arandjelović R, et al. Neighbourhood consensus networks[C]. Advances in Neural Information Processing Systems. 2018: 1658–1669.

[51] Bookstein F L. Principal warps: Thin-plate splines and the decomposition of deformations[J]. IEEE Transactions on pattern analysis and machine intelligence,1989, 11(6): 567–585.

[52] AradN, DynN, ReisfeldD,etal.Imagewarpingbyradialbasisfunctions: Application to facial expressions[J]. CVGIP: Graphical models and image processing, 1994, 56(2): 161–172.

[53] Chui H, Rangarajan A. A new point matching algorithm for non-rigid registration[J]. Comput. Vis. Image Understand., 2003, 89: 114–141.

[54] Myronenko A, Song X. Point Set Registration: Coherent Point Drift[J]. IEEE Trans. Pattern Anal. Mach. Intell., 2010, 32(12): 2262–2275.

[55] Cook D J, Holder L B. Mining graph data[M]. [S.l.]: John Wiley & Sons, 2006.

[56] BabaiL.Groups,Graphs,Algorithms: TheGraphIsomorphismProblem[J].Proc. Internat. Congr. of Mathematicians 2018, 2018.

[57] Yan J, Cho M, Zha H, et al. Multi-graph matching via affinity optimization with graduated consistency regularization[J]. IEEE Trans. Pattern Anal. Mach. Intell., 2016, 38(6): 1228–1242.

[58] Yan J, Wang J, Zha H, et al. Consistency-driven alternating optimization for multigraph matching: a unified approach.[J]. IEEE Trans. Image Process., 2015, 24(3): 994–1009.

[59] Umeyama S. An eigendecomposition approach to weighted graph matching problems[J]. IEEE transactions on pattern analysis and machine intelligence, 1988, 10(5): 695–703.

[60] Leordeanu M, Hebert M. A Spectral Technique for Correspondence Problems Using Pairwise Constraints[C]. Proc. IEEE Int. Conf. Comput. Vis.. 2005: 1482– 1489.

[61] Liu H, Yan S. Common Visual Pattern Discovery via Spatially Coherent Correspondence[C]. Proc. IEEE Conf. Comput. Vis. Pattern Recognit.. 2010: 1609– 1616.

[62] SuhY,ChoM,LeeKM.Graphmatchingviasequentialmontecarlo[C].European Conference on Computer Vision. 2012: 624–637.

[63] Cho M, Lee J, Lee K M. Reweighted random walks for graph matching[C]. European conference on Computer vision. 2010: 492–505.

[64] CaelliT,KosinovS.Aneigenspaceprojectionclusteringmethodforinexactgraph matching[J]. IEEE transactions on pattern analysis and machine intelligence, 2004, 26(4): 515–519.

[65] Dong J, Soatto S. Domain-size pooling in local descriptors: DSP-SIFT[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 5097–5106.

[66] Calonder M, Lepetit V, Strecha C, et al. Brief: Binary robust independent elementary features[C]. European conference on computer vision. 2010: 778–792.

[67] Leutenegger S, Chli M, Siegwart R Y. BRISK: Binary robust invariant scalable keypoints[M]. [S.l.]: IEEE, 2011.

[68] Alahi A, Ortiz R, Vandergheynst P. Freak: Fast retina keypoint[C]. 2012 IEEE Conference on Computer Vision and Pattern Recognition. 2012: 510–517.

[69] Johnson A E, Hebert M. Using spin images for efficient object recognition in cluttered 3D scenes[J]. IEEE Transactions on pattern analysis and machine intelligence, 1999, 21(5): 433–449.

[70] ZaharescuA,BoyerE,VaranasiK,etal.Surfacefeaturedetectionanddescription with applications to mesh matching[C]. Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2009. 2009: 373–380.

[71] FischlerMA,BollesRC.Randomsampleconsensus: aparadigmformodelfitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 6(6): 381–395.

[72] Torr P H, Zisserman A. MLESAC: A New Robust Estimator with Application to Estimating Image Geometry[J]. Comput. Vis. Image Understand., 2000, 78(1): 138–156.

[73] Chum O, Matas J. Matching with PROSAC - Progressive Sample Consensus[C]. CVPR. 2005: 220–226.

[74] Sattler T, Leibe B, Kobbelt L. SCRAMSAC: Improving RANSAC’s efficiency with a spatial consistency filter[C]. Proc. IEEE Int. Conf. Comput. Vis.. 2009:2090–2097.

[75] Raguram R, Chum O, Pollefeys M, et al. USAC: a universal framework for random sample consensus[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(8): 2022–2038.

[76] LiX,HuZ.RejectingMismatchesbyCorrespondenceFunction[J].Int.J.Comput. Vis., 2010, 89(1): 1–17.

[77] TikhonovAN, ArseninVI.Solutionsofill-posedproblems: Vol14[M].[S.l.]: Vh Winston, 1977.

[78] Boyd S, Vandenberghe L. Convex optimization[M]. [S.l.]: Cambridge university press, 2004.

[79] Ma J, Zhao J, Tian J, et al. Robust Estimation of Nonrigid Transformation for Point Set Registration[C]. CVPR. 2013: 2147–2154.

[80] Ma J, Zhao J, Tian J, et al. Regularized vector field learning with sparse approximation for mismatch removal[J]. Pattern Recognit., 2013, 46(12): 3519–3532.

[81] MaJ,ZhaoJ,TianJ,etal.RobustPointMatchingviaVectorFieldConsensus[J]. IEEE Trans. Image Process., 2014, 23(4): 1706–1721.

[82] Ma J, Zhao J, Ma Y, et al. Non-rigid visible and infrared face registration via regularized Gaussian fields criterion[J]. Pattern Recognit., 2015, 48(3): 772–784.

[83] Ma J, Qiu W, Zhao J, et al. Robust L2E Estimation of Transformation for NonRigid Registration[J]. IEEE Trans. Signal Process., 2015, 63(5): 1115–1129.

[84] WangG, WangZ, ChenY,etal.Arobustnon-rigidpointsetregistrationmethod basedonasymmetricgaussianrepresentation[J].Comput.Vis.ImageUnderstand., 2015, 141: 67–80.

[85] Wang G, Wang Z, Chen Y, et al. Context-Aware Gaussian Fields for Non-rigid Point Set Registration[C]. CVPR. 2016: 5811–5819.

[86] Wang G, Zhou Q, Chen Y. Robust Non-Rigid Point Set Registration Using Spatially Constrained Gaussian Fields[J]. IEEE Trans. Image Process., 2017, 26(4): 1759–1769.

[87] Ma J, Zhao J, Jiang J, et al. Non-Rigid Point Set Registration with Robust Transformation Estimation under Manifold Regularization[C]. Proc. AAAI Conf. Artificial Intelligence. 2017: 4218–4224.

[88] Ma J, Zhou H, Zhao J, et al. Robust Feature Matching for Remote Sensing Image Registration via Locally Linear Transforming[J]. IEEE Trans. Geosci. Remote Sens., 2015, 53(12): 6469–6481.

[89] Ma J, Zhao J, Guo H, et al. Locality preserving matching[C]. Proc. Int. Joint Conf. Artif. Intell.. 2017: 4492–4498.

[90] Ma J, Jiang J, Zhou H, et al. Guided locality preserving feature matching for remote sensing image registration[J]. IEEE Trans. Geosci. Remote Sens., 2018.

[91] BianJ, LinW-Y, MatsushitaY,etal.Gms: Grid-basedmotionstatisticsforfast, ultra-robust feature correspondence[C]. Proc. IEEE Conf. Comput. Vis. Pattern Recognit.. 2017: 2828–2837.

[92] Lin W-Y, Wang F, Cheng M-M, et al. CODE: Coherence based decision boundariesforfeaturecorrespondence[J].IEEETrans.PatternAnal.Mach.Intell.,2018, 40(1): 34–47.

[93] Lin W-Y, Cheng M-M, Lu J, et al. Bilateral functions for global motion modeling[C]. Proc. Eur. Conf. Comput. Vis.. 2014: 341–356.

[94] Simo-serra E, Trulls E, Ferraz L, et al. Discriminative learning of deep convolutionalfeaturepointdescriptors[C].ProceedingsoftheIEEEInternationalConference on Computer Vision. 2015: 118–126.

[95] Mishchuk A, Mishkin D, Radenovic F, et al. Working hard to know your neighbor’s margins: Local descriptor learning loss[C]. Advances in Neural Information Processing Systems. 2017: 4826–4837.

[96] Wei X, Zhang Y, Gong Y, et al. Kernelized subspace pooling for deep local descriptors[C].ProceedingsoftheIEEEConferenceonComputerVisionandPattern Recognition. 2018: 1867–1875.

[97] Ono Y, Trulls E, Fua P, et al. LF-Net: learning local features from images[C]. Advances in Neural Information Processing Systems. 2018: 6237–6247.

[98] DetoneD,MalisiewiczT,RabinovichA.Superpoint: Self-supervised interest point detection and description[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops. 2018: 224–236.

[99] Han X, Leung T, Jia Y, et al. Matchnet: Unifying feature and metric learning for patch-based matching[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 3279–3286.

[100] WangJ,ZhouF,WenS,etal.Deep metric learning with angularl oss[C].ProceedingsoftheIEEEInternationalConferenceonComputerVision.2017: 2593–2601.

[101] Schönberger J L, Hardmeier H, Sattler T, et al. Comparative evaluation of handcrafted and learned local features[C]. Computer Vision and Pattern Recognition (CVPR), 2017 IEEE Conference on. 2017: 6959–6968.

[102] Tian Y, Fan B, Wu F, et al. L2-Net: Deep Learning of Discriminative Patch Descriptor in Euclidean Space.[C]. Cvpr: Vol 1. 2017: 6.

[103] Zbontar J, Lecun Y. Stereo matching by training a convolutional neural network to compare image patches[J]. Journal of Machine Learning Research, 2016, 17(132): 2.

[104] Revaud J, Weinzaepfel P, Harchaoui Z, et al. Deepmatching: Hierarchical deformable dense matching[J]. International Journal of Computer Vision, 2016, 120(3): 300–323.

[105] Menze M, Heipke C, Geiger A. Object Scene Flow[J]. ISPRS Journal of Photogrammetry and Remote Sensing (JPRS), 2018.

[106] ScharsteinD,SzeliskiR.ATaxonomyandEvaluationofDenseTwo-FrameStereo Correspondence Algorithms[J]. International Journal of Computer Vision, 2002, 47(1-3): 7–42.

[107] ZagoruykoS,KomodakisN.Learning to compare image patches via convolutional neural networks[C].ProceedingsoftheIEEEConferenceonComputerVisionand Pattern Recognition. 2015: 4353–4361.

[108] AltwaijryH,TrullsE,HaysJ,etal.Learning to match aerial images with deep attentive architectures[C].ProceedingsoftheIEEEConferenceonComputerVision and Pattern Recognition. 2016: 3539–3547.

[109] Balakrishnan G, Zhao A, Sabuncu M R, et al. An Unsupervised Learning Model for Deformable Medical Image Registration[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 9252–9260.

[110] Jiang P, Shackleford J A. CNN Driven Sparse Multi-Level B-Spline Image Registration[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 9281–9289.

[111] Qi C R, Su H, Mo K, et al. Pointnet: Deep learning on point sets for 3d classification and segmentation[J]. Proc. Computer Vision and Pattern Recognition (CVPR), IEEE, 2017, 1(2): 4.

[112] Deng H, Birdal T, Ilic S. Ppfnet: Global context aware local features for robust 3d point matching[J]. Computer Vision and Pattern Recognition (CVPR). IEEE, 2018, 1.

[113] YiKM,TrullsE,OnoY,etal.LearningtoFindGoodCorrespondences[C].Proc. IEEE Conf. Comput. Vis. Pattern Recognit.. 2018: 1–9.

[114] Luo Z, Shen T, Zhou L, et al. Geodesc: Learning local descriptors by integrating geometry constraints[C]. Proceedings of the European Conference on Computer Vision (ECCV). 2018: 168–183.

[115] Zhao C, Cao Z, Li C, et al. NM-Net: Mining Reliable Neighbors for Robust Feature Correspondences[J]. arXiv preprint arXiv:1904.00320, 2019.

[116] 赵键. 点模式匹配算法研究 [D]. 国防科学技术大学, 2012.

[117] 柳成荫. 基于点特征的多模与多视角图像非刚性配准算法研究 [D]. 华中科技大 学, 2018.

[118] Tron R, Zhou X, Esteves C, et al. Fast multi-image matching via density-based clustering[C]. Proceedings of the IEEE International Conference on Computer Vision. 2017: 4057–4066.

[119] Maset E, Arrigoni F, Fusiello A. Practical and efficient multi-view matching[C]. Proceedings of the IEEE International Conference on Computer Vision. 2017: 4568–4576.

[120] Hu N, Huang Q, Thibert B, et al. Distributable consistent multi-object matching[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 2463–2471.

**