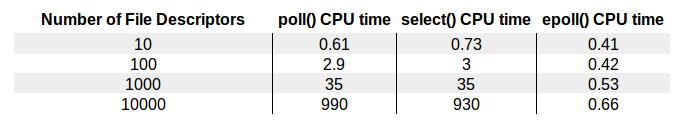

这里有放置了一张图,这张图来自 The Linux Programming Interface(No Starch Press)。这张图直观地为我们展示了 select、poll、epoll 几种不同的 I/O 复用技术在面对不同文件描述符大小时的表现差异。

- real time是从进行开始执行到完成所经历的墙上时钟时间(wall clock)时间,包括其他进程使用的时间片(time slice)和本进程耗费在阻塞(如等待I/O操作完成)上的时间。

- user time是进程执行用户态代码(内核外)耗费的CPU时间,仅统计该进程执行时实际使用的CPU时间,而不计入其他进程使用的时间片和本进程阻塞的时间

- sys time 是该进程在内核态运行所耗费的CPU时间,即内核执行系统调用所使用的CPU时间

从图中可以明显地看到,epoll 的性能是最好的,即使在多达 10000 个文件描述的情况下,其性能的下降和有 10 个文件描述符的情况相比,差别也不是很大。而随着文件描述符的增大,常规的 select 和 poll 方法性能逐渐变得很差。

epoll 的用法

本质上 epoll 还是一种 I/O 多路复用技术, epoll 通过监控注册的多个描述字,来进行 I/O 事件的分发处理。不同于 poll 的是,epoll 不仅提供了默认的 level-triggered(条件触发)机制,还提供了性能更为强劲的 edge-triggered(边缘触发)机制。

使用 epoll 需要三个步骤:

- epoll_create

- epoll_ctl

- epoll_wait

epoll_create

int epoll_create(int size);int epoll_create1(int flags);返回值: 若成功返回一个大于0的值,表示epoll实例;若返回-1表示出错

epoll_create() 方法创建了一个 epoll 实例,从 Linux 2.6.8 开始,参数 size 被自动忽略,但是该值仍需要一个大于 0 的整数。这个 epoll 实例被用来调用 epoll_ctl 和 epoll_wait,如果这个 epoll 实例不再需要,比如服务器正常关机,需要调用 close() 方法释放 epoll 实例,这样系统内核可以回收 epoll 实例所分配使用的内核资源。

epoll_create1() 的用法和 epoll_create() 基本一致,如果 epoll_create1() 的输入 flags 为 0,则和 epoll_create() 一样,内核自动忽略。

epoll_ctl

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);返回值: 若成功返回0;若返回-1表示出错

在创建完 epoll 实例之后,可以通过调用 epoll_ctl 往这个 epoll 实例增加或删除监控的事件。

参数:

- epfd: epoll_create 创建的 epoll 实例

- op: 表示增加/删除监控事件

- EPOLL_CTL_ADD: 向 epoll 实例注册文件描述符对应的事件;

- EPOLL_CTL_DEL:向 epoll 实例删除文件描述符对应的事件;

- EPOLL_CTL_MOD: 修改文件描述符对应的事件

- fd: 注册的事件的文件描述符,比如一个监听套接字。

- event: 要注册的事件的类型, 并且可以在这个结构体里设置用户需要的数据,其中最为常见的是使用联合结构里的 fd 字段,表示事件所对应的文件描述符。

typedef union epoll_data {void *ptr;int fd;uint32_t u32;uint64_t u64;} epoll_data_t;struct epoll_event {uint32_t events; /* Epoll events */epoll_data_t data; /* User data variable */};

事件类型:

- EPOLLIN:表示对应的文件描述字可以读;

- EPOLLOUT:表示对应的文件描述字可以写;

- EPOLLRDHUP:表示套接字的一端已经关闭,或者半关闭;

- EPOLLHUP:表示对应的文件描述字被挂起;

- EPOLLET:设置为 edge-triggered,默认为 level-triggered。

epoll_wait

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);返回值: 成功返回的是一个大于0的数,表示事件的个数;返回0表示的是超时时间到;若出错返回-1.

epoll_wait() 函数类似之前的 poll 和 select 函数,调用者进程被挂起,在等待内核 I/O 事件的分发。

- events: 数组, 返回给用户空间需要处理的 I/O 事件, 数组的大小由 epoll_wait 的返回值决定

- maxevents: 表示 epoll_wait 可以返回的最大事件值

- timeout: epoll_wait 阻塞调用的超时值,如果这个值设置为 -1,表示不超时;如果设置为 0 则立即返回,即使没有任何 I/O 事件发生。

epoll 例子

#include "lib/common.h"

#define MAXEVENTS 128

char rot13_char(char c) {

if ((c >= 'a' && c <= 'm') || (c >= 'A' && c <= 'M'))

return c + 13;

else if ((c >= 'n' && c <= 'z') || (c >= 'N' && c <= 'Z'))

return c - 13;

else

return c;

}

int main(int argc, char **argv) {

int listen_fd, socket_fd;

int n, i;

int efd;

struct epoll_event event;

struct epoll_event *events;

listen_fd = tcp_nonblocking_server_listen(SERV_PORT);

efd = epoll_create1(0); // ------------------------------------------ create

if (efd == -1) {

error(1, errno, "epoll create failed");

}

event.data.fd = listen_fd;

event.events = EPOLLIN | EPOLLET;

if (epoll_ctl(efd, EPOLL_CTL_ADD, listen_fd, &event) == -1) { // ------- ctl

error(1, errno, "epoll_ctl add listen fd failed");

}

/* Buffer where events are returned */

events = calloc(MAXEVENTS, sizeof(event));

while (1) {

n = epoll_wait(efd, events, MAXEVENTS, -1); // -------------------- wait

printf("epoll_wait wakeup\n");

for (i = 0; i < n; i++) { // 某种优化的端倪

if ((events[i].events & EPOLLERR) ||

(events[i].events & EPOLLHUP) ||

(!(events[i].events & EPOLLIN))) {

fprintf(stderr, "epoll error\n");

close(events[i].data.fd);

continue;

} else if (listen_fd == events[i].data.fd) {

struct sockaddr_storage ss;

socklen_t slen = sizeof(ss);

int fd = accept(listen_fd, (struct sockaddr *) &ss, &slen);

if (fd < 0) {

error(1, errno, "accept failed");

} else {

make_nonblocking(fd);

event.data.fd = fd; // 问题: 每有连接过来, 难道不会影响之前的 ctl 吗, 猜测是复制到 events 中了

event.events = EPOLLIN | EPOLLET; //edge-triggered

if (epoll_ctl(efd, EPOLL_CTL_ADD, fd, &event) == -1) { // ---- ctl

error(1, errno, "epoll_ctl add connection fd failed");

}

}

continue;

} else {

socket_fd = events[i].data.fd;

printf("get event on socket fd == %d \n", socket_fd);

while (1) {

char buf[512];

if ((n = read(socket_fd, buf, sizeof(buf))) < 0) {

if (errno != EAGAIN) { // 注意这里是非阻塞操作, 没数据时退出 while

error(1, errno, "read error");

close(socket_fd);

}

break;

} else if (n == 0) {

close(socket_fd);

break;

} else {

for (i = 0; i < n; ++i) {

buf[i] = rot13_char(buf[i]);

}

if (write(socket_fd, buf, n) < 0) {

error(1, errno, "write error");

}

}

}

}

}

}

free(events);

close(listen_fd);

}

实验

启动该服务器:

$./epoll01

epoll_wait wakeup

epoll_wait wakeup

epoll_wait wakeup

get event on socket fd == 6

epoll_wait wakeup

get event on socket fd == 5

epoll_wait wakeup

get event on socket fd == 5

epoll_wait wakeup

get event on socket fd == 6

epoll_wait wakeup

get event on socket fd == 6

epoll_wait wakeup

get event on socket fd == 6

epoll_wait wakeup

get event on socket fd == 5

再启动几个 telnet 客户端,可以看到有连接建立情况下,epoll_wait 迅速从挂起状态结束;并且套接字上有数据可读时,epoll_wait 也迅速结束挂起状态,这时候通过 read 可以读取套接字接收缓冲区上的数据。

$telnet 127.0.0.1 43211

Trying 127.0.0.1...

Connected to 127.0.0.1.

Escape character is '^]'.

fasfsafas

snfsfnsnf

^]

telnet> quit

Connection closed.

edge-triggered VS level-triggered

这里有两个程序,我们用这个程序来说明一下这两者之间的不同。

在这两个程序里,即使已连接套接字上有数据可读,我们也不调用 read 函数去读,只是简单地打印出一句话。

第一个程序我们设置为 edge-triggered,即边缘触发。开启这个服务器程序,用 telnet 连接上,输入一些字符,我们看到,服务器端只从 epoll_wait 中苏醒过一次,就是第一次有数据可读的时候。

$./epoll02

epoll_wait wakeup

epoll_wait wakeup

get event on socket fd == 5

$telnet 127.0.0.1 43211

Trying 127.0.0.1...

Connected to 127.0.0.1.

Escape character is '^]'.

asfafas

第二个程序我们设置为 level-triggered,即条件触发。然后按照同样的步骤来一次,观察服务器端,这一次我们可以看到,服务器端不断地从 epoll_wait 中苏醒,告诉我们有数据需要读取。

$./epoll03

epoll_wait wakeup

epoll_wait wakeup

get event on socket fd == 5

epoll_wait wakeup

get event on socket fd == 5

epoll_wait wakeup

get event on socket fd == 5

epoll_wait wakeup

get event on socket fd == 5

...

这就是两者的区别,条件触发的意思是只要满足事件的条件,比如有数据需要读,就一直不断地把这个事件传递给用户;而边缘触发的意思是只有第一次满足条件的时候才触发,之后就不会再传递同样的事件了。

一般我们认为,边缘触发的效率比条件触发的效率要高,这一点也是 epoll 的杀手锏之一。

epoll 的历史

- Windows 系统就已经在 1994 年引入了 IOCP,这是一个异步 I/O 模型,用来支持高并发的网络 I/O

- 著名的 FreeBSD 在 2000 年引入了 Kqueue——一个 I/O 事件分发框架

- Linux 在 2002 年引入了 epoll,不过相关工作的讨论和设计早在 2000 年就开始了

为什么 Linux 不把 FreeBSD 的 kqueue 直接移植过来,而是另辟蹊径创立了 epoll 呢?

kqueue 的用法:

int kqueue(void);

int kevent(int kq, const struct kevent *changelist, int nchanges,

struct kevent *eventlist, int nevents,

const struct timespec *timeout);

void EV_SET(struct kevent *kev, uintptr_t ident, short filter,

u_short flags, u_int fflags, intptr_t data, void *udata);

struct kevent {

uintptr_t ident; /* identifier (e.g., file descriptor) */

short filter; /* filter type (e.g., EVFILT_READ) */

u_short flags; /* action flags (e.g., EV_ADD) */

u_int fflags; /* filter-specific flags */

intptr_t data; /* filter-specific data */

void *udata; /* opaque user data */

};

Linus 在他最初的设想里,提到了这么一句话,也就是说他觉得类似 select 或 poll 的数组方式是可以的,而队列方式则是不可取的。

精选留言

传说中的成大大

我回想和对了poll和epoll的代码 觉得效率问题主要出现在 epoll返回的是有事件发生的数组,而poll返回的是准备好的个数,每次poll函数返回都要遍历注册的描述符结合数组 尤其是数量越大遍历次数就越多 我觉得性能差异在这里 抛开阻塞和阻塞i/o层面

作者回复: 这是一个很重要的点,恭喜你悟到了 :)

ray

老师您好,

想跟您请教什么时候会触发EPOLLOUT事件,我们的课程范例好像都只有EPOLLIN事件。

当读事件触发后,为什么不用为fd设置EPOLLOUT事件,就可以直接将资料写回fd,这样我们要怎么知道一个fd是否可写呢?

谢谢老师的解答!

作者回复: 非常好的问题。

实际上,确实需要通过注册EPOLLOUT事件,让内核告诉我们可以往某个fd上写数据,课程只是没有展现这部分的能力而已,而在lib/epoll_dispatcher.c中是会注册EPOLLOUT事件的。