事实上,非阻塞 I/O 配合 I/O 多路复用,是高性能网络编程中的常见技术。

阻塞 VS 非阻塞

当应用程序调用阻塞 I/O 完成某个操作时,应用程序会被挂起,等待内核完成操作,感觉上应用程序像是被“阻塞”了一样。实际上,内核所做的事情是将 CPU 时间切换给其他有需要的进程,网络应用程序在这种情况下就会得不到 CPU 时间做该做的事情。

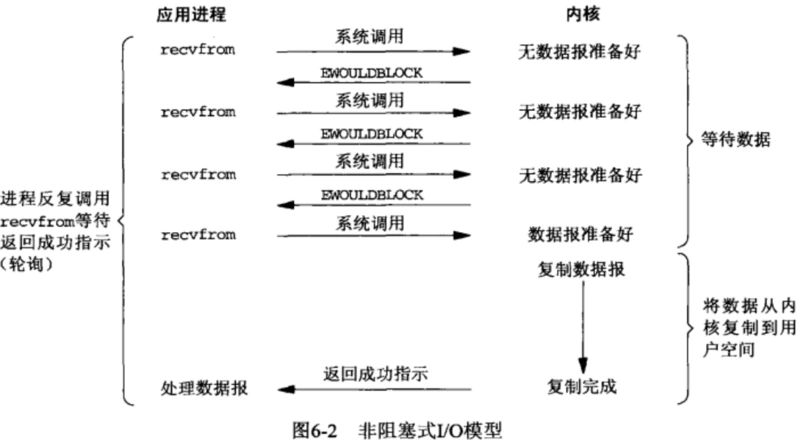

非阻塞 I/O 则不然,当应用程序调用非阻塞 I/O 完成某个操作时,内核立即返回,不会把 CPU 时间切换给其他进程,应用程序在返回后,可以得到足够的 CPU 时间继续完成其他事情。

非阻塞 I/O

读操作

如果套接字对应的接收缓冲区没有数据可读,在非阻塞情况下 read 调用会立即返回,一般返回 EWOULDBLOCK 或 EAGAIN 出错信息。在这种情况下,出错信息是需要小心处理,比如后面再次调用 read 操作,而不是直接作为错误直接返回。这就好像去书店买书没买到离开一样,需要不断进行又一次轮询处理。

写操作

在非阻塞 I/O 的情况下,如果套接字的发送缓冲区已达到了极限,不能容纳更多的字节,那么操作系统内核会尽最大可能从应用程序拷贝数据到发送缓冲区中,并立即从 write 等函数调用中返回。可想而知,在拷贝动作发生的瞬间,有可能一个字符也没拷贝,有可能所有请求字符都被拷贝完成,那么这个时候就需要返回一个数值,告诉应用程序到底有多少数据被成功拷贝到了发送缓冲区中,应用程序需要再次调用 write 函数,以输出未完成拷贝的字节。

与阻塞 I/O 的比较:

- 非阻塞 I/O 需要这样:拷贝→返回→再拷贝→再返回。

- 阻塞 I/O 需要这样:拷贝→直到所有数据拷贝至发送缓冲区完成→返回。

不过在实战中,你可以不用区别阻塞和非阻塞 I/O,使用循环的方式来写入数据就好了。只不过在阻塞 I/O 的情况下,循环只执行一次就结束了。

**

循环 write 的实现, 注意判断非阻塞和阻塞的实现代码:

/* 向文件描述符fd写入n字节数 */ssize_t writen(int fd, const void * data, size_t n){size_t nleft;ssize_t nwritten;const char *ptr;ptr = data;nleft = n;//如果还有数据没被拷贝完成,就一直循环while (nleft > 0) {if ( (nwritten = write(fd, ptr, nleft)) <= 0) {/* 这里EAGAIN是非阻塞non-blocking情况下,通知我们再次调用write() */if (nwritten < 0 && errno == EAGAIN)nwritten = 0;elsereturn -1; /* 出错退出 */}/* 指针增大,剩下字节数变小*/nleft -= nwritten;ptr += nwritten;}return n;}

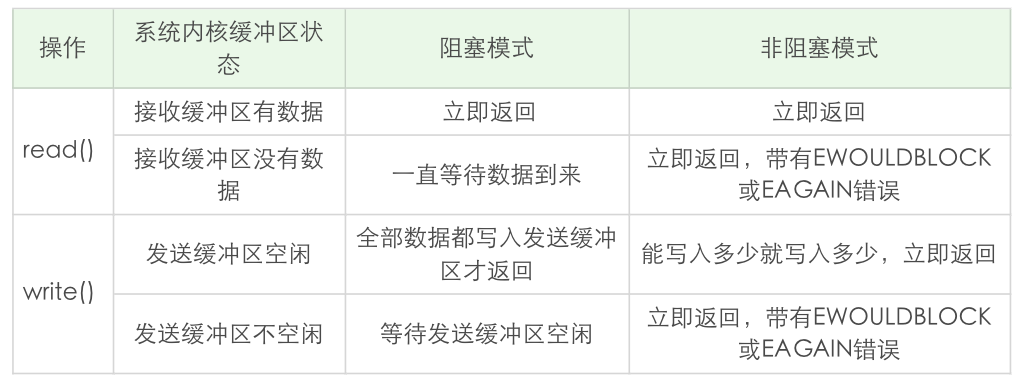

read 和 write 在阻塞模式和非阻塞模式下的不同行为特性

read 总是在接收缓冲区有数据时就立即返回,不是等到应用程序给定的数据充满才返回。

阻塞模式下的 write 有个特例, 就是对方主动关闭了套接字:

- 这个时候 write 调用会立即返回,并通过返回值告诉应用程序实际写入的字节数

- 如果再次对这样的套接字进行 write 操作,就会返回失败。失败是通过返回值 -1 来通知到应用程序的。

accept

当 accept 和 I/O 多路复用 select、poll 等一起配合使用时,如果在监听套接字上触发事件,说明有连接建立完成,此时调用 accept 肯定可以返回已连接套接字。这样看来,似乎把监听套接字设置为非阻塞,没有任何好处。

将 fd 设置为非阻塞就是为了避免这种情况.

实验

构建一个客户端程序,其中最关键的是,一旦连接建立,设置 SO_LINGER 套接字选项,把 l_onoff 标志设置为 1,把 l_linger 时间设置为 0。这样,连接被关闭时,TCP 套接字上将会发送一个 RST。

struct linger ling;

ling.l_onoff = 1;

ling.l_linger = 0;

setsockopt(socket_fd, SOL_SOCKET, SO_LINGER, &ling, sizeof(ling));

close(socket_fd);

服务器端使用 select I/O 多路复用,不过,监听套接字仍然是 blocking 的。如果监听套接字上有事件发生,休眠 5 秒,以便模拟高并发场景下的情形。

if (FD_ISSET(listen_fd, &readset)) {

printf("listening socket readable\n");

sleep(5);

struct sockaddr_storage ss;

socklen_t slen = sizeof(ss);

int fd = accept(listen_fd, (struct sockaddr *) &ss, &slen);

这里的休眠时间非常关键,这样,在监听套接字上有可读事件发生时,并没有马上调用 accept。由于客户端发生了 RST 分节,该连接被接收端内核从自己的已完成队列中删除了,此时再调用 accept,由于没有已完成连接(假设没有其他已完成连接),accept 一直阻塞,更为严重的是,该线程再也没有机会对其他 I/O 事件进行分发,相当于该服务器无法对其他 I/O 进行服务。

如果我们将监听套接字设为非阻塞,上述的情形就不会再发生。只不过对于 accept 的返回值,需要正确地处理各种看似异常的错误,例如忽略 EWOULDBLOCK、EAGAIN 等。

**

设置 fd 为非阻塞:

- 具体参考

lib/tcp_server.c104行

void make_nonblocking(int fd) {

fcntl(fd, F_SETFL, O_NONBLOCK);

}

启发

一定要将监听套接字设置为非阻塞的,尽管这里休眠时间 5 秒有点夸张,但是在极端情况下处理不当的服务器程序是有可能碰到例子所阐述的情况,为了让服务器程序在极端情况下工作正常,这点工作还是非常值得的。

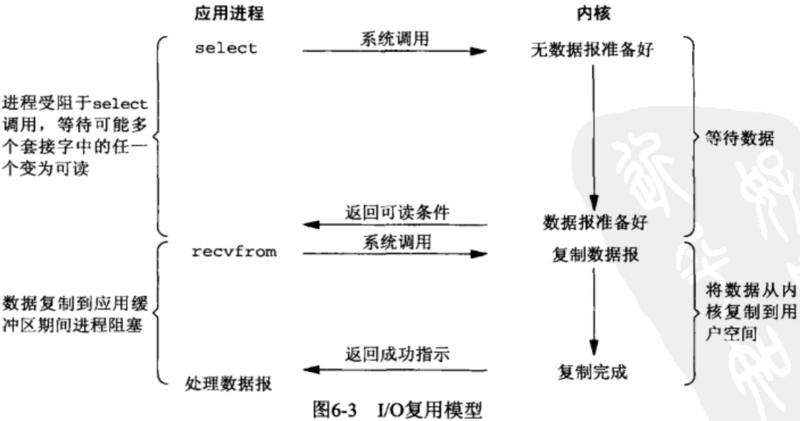

connect

在非阻塞 TCP 套接字上调用 connect 函数,会立即返回一个 EINPROGRESS 错误。TCP 三次握手会正常进行,应用程序可以继续做其他初始化的事情。当该连接建立成功或者失败时,通过 I/O 多路复用 select、poll 等可以进行连接的状态检测。

感觉多路复用就是用于 I/O 事件监听的.

非阻塞 I/O + select 多路复用

例子

- 注意自己加的一点注释

#define MAX_LINE 1024

#define FD_INIT_SIZE 128

char rot13_char(char c) {

if ((c >= 'a' && c <= 'm') || (c >= 'A' && c <= 'M'))

return c + 13;

else if ((c >= 'n' && c <= 'z') || (c >= 'N' && c <= 'Z'))

return c - 13;

else

return c;

}

//数据缓冲区

struct Buffer {

int connect_fd; //连接字

char buffer[MAX_LINE]; //实际缓冲

size_t writeIndex; //缓冲写入位置

size_t readIndex; //缓冲读取位置

int readable; //是否可以读

};

struct Buffer *alloc_Buffer() {

struct Buffer *buffer = malloc(sizeof(struct Buffer));

if (!buffer)

return NULL;

buffer->connect_fd = 0;

buffer->writeIndex = buffer->readIndex = buffer->readable = 0;

return buffer;

}

void free_Buffer(struct Buffer *buffer) {

free(buffer);

}

int onSocketRead(int fd, struct Buffer *buffer) {

char buf[1024];

int i;

ssize_t result;

while (1) {

result = recv(fd, buf, sizeof(buf), 0);

if (result <= 0)

break;

for (i = 0; i < result; ++i) {

if (buffer->writeIndex < sizeof(buffer->buffer))

buffer->buffer[buffer->writeIndex++] = rot13_char(buf[i]);

if (buf[i] == '\n') {

buffer->readable = 1; //缓冲区可以读

}

}

}

if (result == 0) {

return 1;

} else if (result < 0) {

if (errno == EAGAIN)

return 0;

return -1;

}

return 0;

}

int onSocketWrite(int fd, struct Buffer *buffer) {

while (buffer->readIndex < buffer->writeIndex) {

ssize_t result = send(fd, buffer->buffer + buffer->readIndex, buffer->writeIndex - buffer->readIndex, 0);

if (result < 0) {

if (errno == EAGAIN)

return 0;

return -1;

}

buffer->readIndex += result;

}

if (buffer->readIndex == buffer->writeIndex)

buffer->readIndex = buffer->writeIndex = 0;

buffer->readable = 0;

return 0;

}

int main(int argc, char **argv) {

int listen_fd;

int i, maxfd;

struct Buffer *buffer[FD_INIT_SIZE];

for (i = 0; i < FD_INIT_SIZE; ++i) {

buffer[i] = alloc_Buffer();

}

// listen_fd 为非阻塞的

listen_fd = tcp_nonblocking_server_listen(SERV_PORT);

fd_set readset, writeset, exset;

FD_ZERO(&readset);

FD_ZERO(&writeset);

FD_ZERO(&exset);

while (1) {

maxfd = listen_fd;

FD_ZERO(&readset);

FD_ZERO(&writeset);

FD_ZERO(&exset);

// listener加入readset

FD_SET(listen_fd, &readset);

for (i = 0; i < FD_INIT_SIZE; ++i) {

if (buffer[i]->connect_fd > 0) {

if (buffer[i]->connect_fd > maxfd)

maxfd = buffer[i]->connect_fd;

FD_SET(buffer[i]->connect_fd, &readset);

if (buffer[i]->readable) {

FD_SET(buffer[i]->connect_fd, &writeset);

}

}

}

if (select(maxfd + 1, &readset, &writeset, &exset, NULL) < 0) {

error(1, errno, "select error");

}

if (FD_ISSET(listen_fd, &readset)) {

printf("listening socket readable\n");

sleep(5);

struct sockaddr_storage ss;

socklen_t slen = sizeof(ss);

int fd = accept(listen_fd, (struct sockaddr *) &ss, &slen); // 如果没有已连接的 fd, 那么不会阻塞在这里, 是安全的

if (fd < 0) {

error(1, errno, "accept failed");

} else if (fd > FD_INIT_SIZE) {

error(1, 0, "too many connections");

close(fd);

} else {

make_nonblocking(fd); // 对于已接受的 fd, 建议也整成非阻塞的

if (buffer[fd]->connect_fd == 0) {

buffer[fd]->connect_fd = fd;

} else {

error(1, 0, "too many connections");

}

}

}

for (i = 0; i < maxfd + 1; ++i) {

int r = 0;

if (i == listen_fd)

continue;

if (FD_ISSET(i, &readset)) {

r = onSocketRead(i, buffer[i]);

}

if (r == 0 && FD_ISSET(i, &writeset)) {

r = onSocketWrite(i, buffer[i]);

}

if (r) {

buffer[i]->connect_fd = 0;

close(i);

}

}

}

}

第 93 行,调用 fcntl 将监听套接字设置为非阻塞。

fcntl(fd, F_SETFL, O_NONBLOCK);

实验

启动该服务器:

$./nonblockingserver

使用多个 telnet 客户端连接该服务器,可以验证交互正常。

$telnet 127.0.0.1 43211

Trying 127.0.0.1...

Connected to localhost.

Escape character is '^]'.

fasfasfasf

snfsnfsnfs

总结

非阻塞 I/O 可以使用在 read、write、accept、connect 等多种不同的场景,在非阻塞 I/O 下,使用轮询的方式引起 CPU 占用率高,所以一般将非阻塞 I/O 和 I/O 多路复用技术 select、poll 等搭配使用,在非阻塞 I/O 事件发生时,再调用对应事件的处理函数。这种方式,极大地提高了程序的健壮性和稳定性,是 Linux 下高性能网络编程的首选。

精选留言

一天到晚游泳的鱼

老师,我想请教一个问题就是, 当把一个描述符设置为非阻塞的之后,在该描述符上面的操作就会变成非阻塞的吗? 比如说把连接套接字设置为非阻塞的,send和recv就会变成非阻塞的吗?

作者回复: 你的理解是对的。