| 工具名称 | 工具作用 | 是否在线? | 在线预览 | 备注 |

|---|---|---|---|---|

| ChatPaper | 通过ChatGPT实现对论文进行总结,帮助科研人进行论文初筛 | 访问wangrongsheng/ChatPaper 使用 |

|

原项目地址 |

| ChatReviewer | 利用ChatGPT对论文进行优缺点分析,提出改进建议 | 访问ShiwenNi/ChatReviewer 使用 |

|

原项目地址 |

| ChatImprovement | 利用ChatGPT对论文初稿进行润色、翻译等 | 访问wangrongsheng/ChatImprovement 使用 |

|

原项目地址 |

| ChatResponse | 利用ChatGPT对审稿人的提问进行回复 | 访问ShiwenNi/ChatResponse 使用 |

|

原项目地址 |

| ChatGenTitle | 利用百万arXiv论文元信息训练出来的论文题目生成模型,根据论文摘要生成合适题目 |  |

原项目地址 |

开源论文速读总结工具地址

ChatPaper:https://chatpaper.org GitHub页面:https://github.com/kaixindelele/ChatPaper ## 技术原理 论文总结遵循下面四个问题:- 研究背景

- 过去的方案是什么?他们有什么问题?

- 本文方案是什么?具体步骤是什么?

- 本文在哪些任务中,取得了什么效果?

使用步骤

一、以脚本方式运行

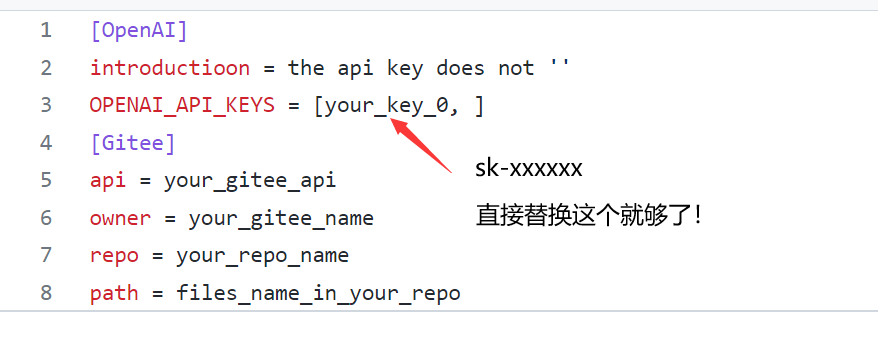

Windows, Mac和Linux系统应该都可以 python版本最好是3.9,其他版本应该也没啥问题- 在apikey.ini中填入你的openai key。注意,这个代码纯本地项目,你的key很安全!如果不被OpenAI封的话~ 小白用户比较多,我直接给截图示意下可能会更好:

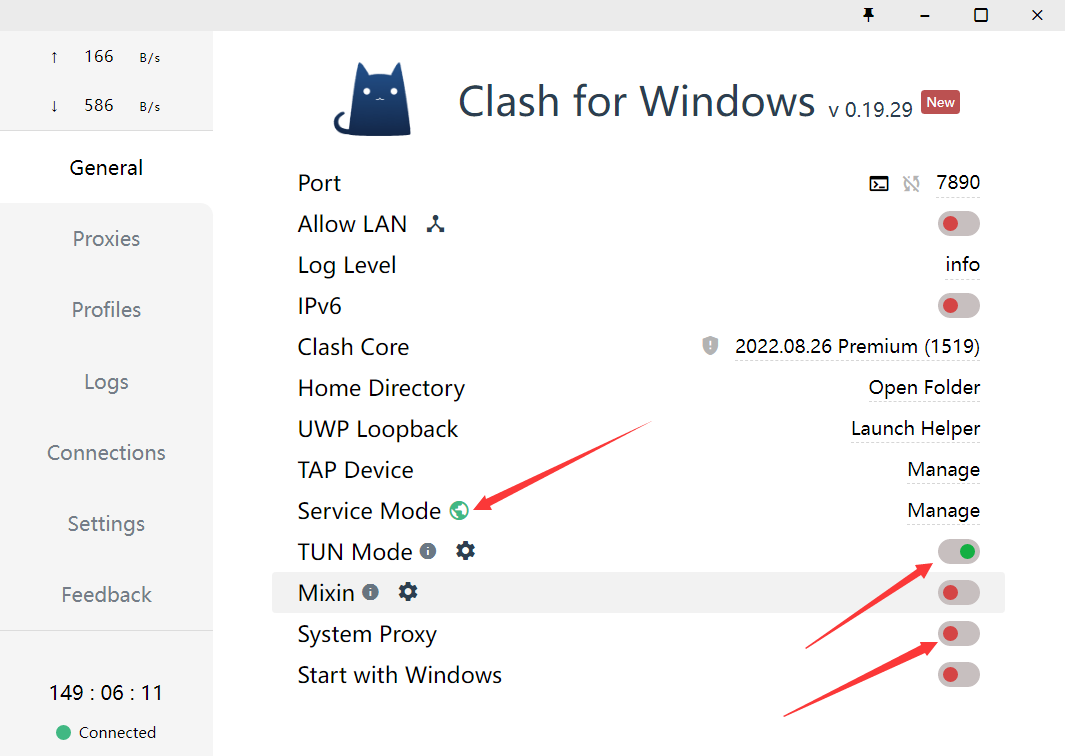

- 使用过程要保证全局代理! 如果客户端时clash的话,可以参考这个进行配置:

- 安装依赖:

注意:搜索词无法识别**-**,只能识别空格!所以原标题的连字符最好不要用! 感谢网友提供的信息

4.2. Arxiv在线批量搜索+下载+总结+高级搜索: 运行chat_paper.py, 比如: python chat_paper.py —query “all: reinforcement learning robot 2023” —filter_keys “reinforcement robot” —max_results 3 💥💥💥7K星了,发布一个猫娘版提示词,希望大家一起让猫娘活起来~:脚本:chat_arxiv_maomao.py,** **总结图片 4.3. Arxiv在线批量搜索+下载+总结+高级搜索+指定作者: 运行chat_paper.py, 比如: python chat_paper.py —query “ti: Sergey Levine” —filter_keys “reinforcement robot” —max_results 3 4.4. 本地pdf总结: 运行chat_paper.py, 比如: python chat_paper.py —pdf_path “demo.pdf” 4.5. 本地文件夹批量总结: 运行chat_paper.py, 比如: python chat_paper.py —pdf_path “your_absolute_path” 4.6. 谷歌学术论文整理: 运行google_scholar_spider.py, 比如:此命令在Google Scholar上搜索与“deep learning”相关的文章,检索30个结果,将结果保存到“./data”文件夹中的CSV文件中,按每年引用次数排序数据,并绘制结果。 具体使用和参数请参考https://github.com/JessyTsu1/google_scholar_spider —- 另外注意,目前这个不支持综述类文章。 B站讲解视频:我把ChatPaper开源了!AI速读PDF论文和速通Arxiv论文 注意:key_word不重要,但是filter_keys非常重要! 一定要修改成你的关键词。 另外关于arxiv的搜索关键词可以参考下图:

python google_scholar_spider.py --kw "deep learning" --nresults 30 --csvpath "./data" --sortby "cit/year" --plotresults 1

- 参数介绍:

[--pdf_path 是否直接读取本地的pdf文档?如果不设置的话,直接从arxiv上搜索并且下载][--query 向arxiv网站搜索的关键词,有一些缩写示范:all, ti(title), au(author),一个query示例:all: ChatGPT robot][--key_word 你感兴趣领域的关键词,重要性不高][--filter_keys 你需要在摘要文本中搜索的关键词,必须保证每个词都出现,才算是你的目标论文][--max_results 每次搜索的最大文章数,经过上面的筛选,才是你的目标论文数,chat只总结筛选后的论文][--sort arxiv的排序方式,默认是相关性,也可以是时间,arxiv.SortCriterion.LastUpdatedDate 或者 arxiv.SortCriterion.Relevance, 别加引号][--save_image 是否存图片,如果你没注册gitee的图床的话,默认为false][--file_format 文件保存格式,默认是markdown的md格式,也可以是txt]parser.add_argument("--pdf_path", type=str, default='', help="if none, the bot will download from arxiv with query")parser.add_argument("--query", type=str, default='all: ChatGPT robot', help="the query string, ti: xx, au: xx, all: xx,")parser.add_argument("--key_word", type=str, default='reinforcement learning', help="the key word of user research fields")parser.add_argument("--filter_keys", type=str, default='ChatGPT robot', help="the filter key words, 摘要中每个单词都得有,才会被筛选为目标论文")parser.add_argument("--max_results", type=int, default=1, help="the maximum number of results")parser.add_argument("--sort", default=arxiv.SortCriterion.Relevance, help="another is arxiv.SortCriterion.LastUpdatedDate")parser.add_argument("--save_image", default=False, help="save image? It takes a minute or two to save a picture! But pretty")parser.add_argument("--file_format", type=str, default='md', help="导出的文件格式,如果存图片的话,最好是md,如果不是的话,txt的不会乱")

二、 以Flask服务运行

- 下载项目并进入项目目录

git clone https://github.com/kaixindelele/ChatPaper.gitcd ChatPaper

- 在项目根目录下的 apikey.ini 文件中填入您的 OpenAI 密钥。

- 配置虚拟环境并下载依赖

pip install virtualenv安装虚拟环境工具virtualenv venv新建一个名为venv的虚拟环境Linux/Mac下:source venv/bin/activateWindows下:.\venv\Scripts\activate.batpip install -r requirements.txt

- 启动服务

访问 http://127.0.0.1:5000/ 后,您将看到主页。在主页上,您可以点击不同的链接来调用各种服务。您可以通过修改链接中的参数值来实现不同的效果。有关参数详细信息,请参阅上一步骤中的详细介绍

python3 app.py# 启动 Flask 服务。运行此命令后,Flask 服务将在本地的 5000 端口上启动并等待用户请求。在浏览器中访问以下地址之一以访问 Flask 服务的主页:# http://127.0.0.1:5000/# 或# http://127.0.0.1:5000/index

- 特别的,这四个接口实际是封装了根目录下四个脚本的 web 界面。参数可以通过链接来修改。例如要运行“arxiv?query=GPT-4&key_word=GPT+robot&page_num=1&max_results=1&days=1&sort=web&save_image=False&file_format=md&language=zh”的话,相当于在根目录下调用 chat_arxiv.py 并返回结果。这个显示的结果和在命令行中调用的结果是一样的(即:python chat_arxiv.py —query “GPT-4” —key_word “GPT robot” —page_num 1 —max_results 1 —days 1 —sort “web” —save_image False —file_format “md” —language “zh”)。您可以通过修改参数来获得其他搜索结果。如果以这种方式部署的话,结果会保存在同级目录下新生成的export、pdf_files 和response_file三个文件夹里

三、以docker形式运行

- 安装docker和docker-compose,可以参考以下链接https://yeasy.gitbook.io/docker_practice/installhttps://yeasy.gitbook.io/docker_practice/compose/install

- 找地方放项目根目录下的“docker-compose.yaml”文件,将21行的YOUR_KEY_HERE替换为自己的openai_key

- 在同级目录下在命令行运行

docker-compose up -d

- 这样的界面代表一些正常,随后访问https://127.0.0.1:28460/ 就可以从网页上打开了!

- 特别的,如果有改进项目的想法,您可以查看 build.sh、dev.sh、tagpush.sh这三个脚本以及根目录docker目录下文件的作用,相信它们会对你容器化封装项目的思想有进一步提升

- 所有的运行结果都被保存在 Docker 的 volumes 中,如果想以服务的形式长期部署,您可以将这些目录映射出来。默认情况下,它们位于 /var/lib/docker/volumes/ 下。您可以进入该目录并查看 chatpaper_log、chatpaper_export、chatpaper_pdf_files 和 chatpaper_response_file 四个相关文件夹中的结果。有关 Docker volumes 的详细解释,请参考此链接:http://docker.baoshu.red/data_management/volume.html。

在线部署

- 在Hugging Face 创建自己的个人账号并登录;

- 进入ChatPaper主仓库:https://huggingface.co/spaces/wangrongsheng/ChatPaper ,您可以在Files and Version 看到所有的最新部署代码;

- [可选]私有化部署使用:点击Duplicate this space ,在弹出的页面中将Visibility选择为Private,最后点击Duplicate Space,Space的代码就会部署到你自己的Space中,为了方便自己每次调用可以不用填写API-key,您可以将app.py#L845 修改为您的密钥:default=”sk-abcdxxxxxxxx” ,点击保存文件就会立即重新部署了;

- [可选]公有化部署使用:点击Duplicate this space ,在弹出的页面中将Visibility选择为Public,最后点击Duplicate Space,Space的代码就会部署到你自己的Space中,这样就可以完成一个公有化的部署。

注:公有化部署和私有化部署根据你的需求二选一即可!