- 为什么要学Stable Diffusion?">为什么要学Stable Diffusion?

- 小白快速上手Stable Diffusio">小白快速上手Stable Diffusio

- 用对模型,照片风格才对味">用对模型,照片风格才对味

- 写好提示词,让你事半功倍">写好提示词,让你事半功倍

- 3.打造你的专属模特">3.打造你的专属模特

- 为什么你生成的图就是跟别人不一样">为什么你生成的图就是跟别人不一样

- 一分钟生成自己的二次元造型">一分钟生成自己的二次元造型

- 局部重绘 给二次元角色换衣服">局部重绘 给二次元角色换衣服

- 8.轻松拯救超糊照片">8.轻松拯救超糊照片

- 轻松获取大佬的提示词">轻松获取大佬的提示词

- ">

- 一招让你自由指定生成的姿势">一招让你自由指定生成的姿势

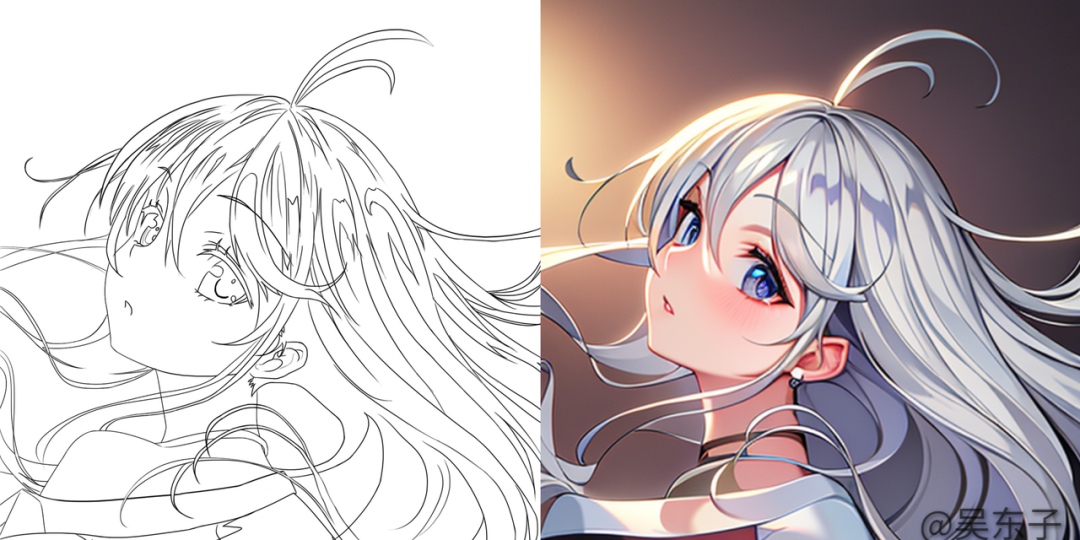

- 11.插画师的福音,线稿秒上色">11.插画师的福音,线稿秒上色

- ">

- ">

- 12.小白也能进行室内设计">12.小白也能进行室内设计

- ">

- ">

- 四、Stable diffusion知识补充">四、Stable diffusion知识补充

- ">

- ">

- 五、大神的模型从哪来">五、大神的模型从哪来

- ">

- ">

- 六、结尾">六、结尾

为什么要学Stable Diffusion?

它有什么用?

Stable Diffusion 是一款超赞的AI绘画软件,Stable Diffusion 有一个很牛的深度学习模型,也被称为生成对抗网络(GAN)。

通过学习和模仿艺术家的创作风格,Stable Diffusion 能够生成与之相似的艺术作品。

我相信大家在刷视频的时候,或多或少都已经看到过很多AI绘画生成的作品了 那SD到底可以用来干什么呢?真人AI美女

画美女,我相信这是刚接触SD的朋友最常用的功能,但这也是它最低级的用法。真人AI美女的账号生成头像 壁纸

以前很多人花钱去找别人定制自己独一无二的头像或者壁纸 现在SD就可以用来定制个人的二次元头像、盲盒模型或定制壁纸绘画辅助

线稿上色,线稿提取,OC,三视图等都可以用SD来辅助完成辅助设计

它可以为产品生成效果图,同时它也具备室内设计能力,通过白模来生成效果图 更多的变现案例如何使用Stable Diffusion

如果你的电脑性能比较好,可以在本地安装

如果你觉得在本地运行不太方便,也可以选择在云端运行

小白快速上手Stable Diffusio

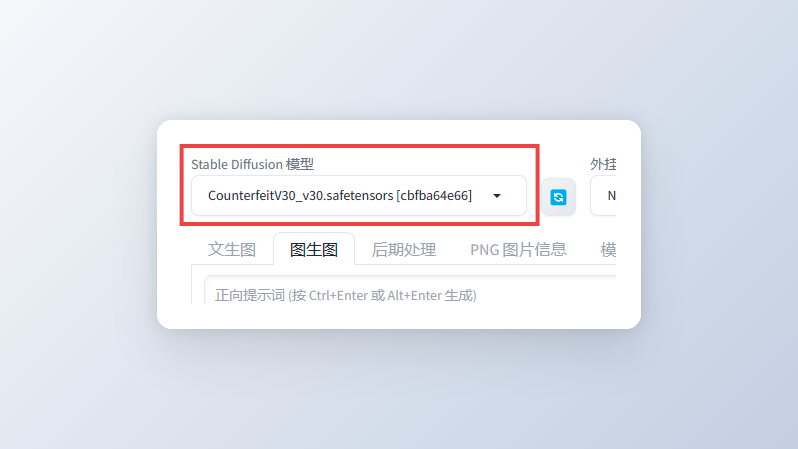

用对模型,照片风格才对味

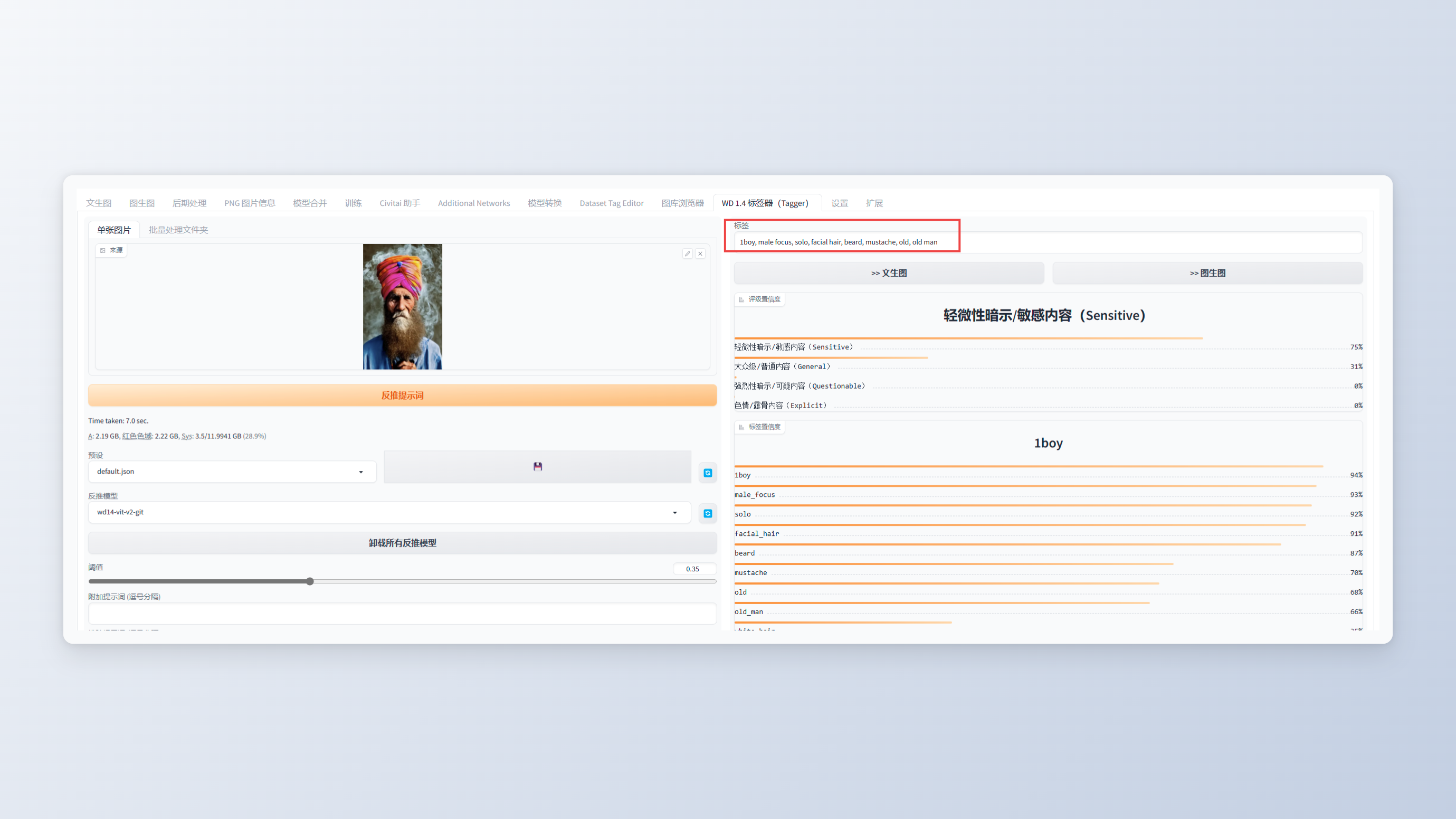

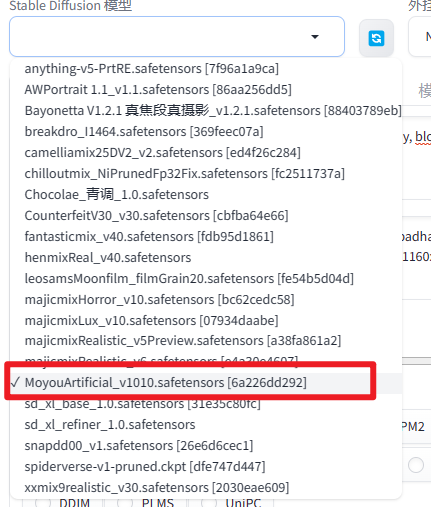

模型可以理解为一个画家,我们要先确定我们需要什么风格的画家 动漫风、写实风、3D盲盒风 不同的模型就代表着不同的照片风格,也就是SD界面左上角的“Stable Diffusion模型” 这里我们以 墨幽人造人 为例

:::color1

具体这些模型的区别,和下载方式,可以看看下面这篇文章:::

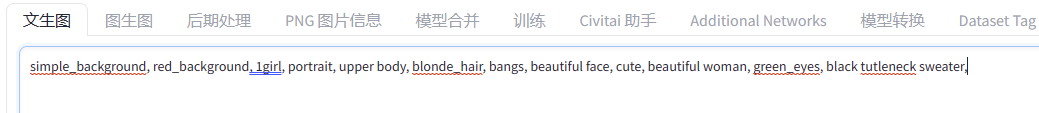

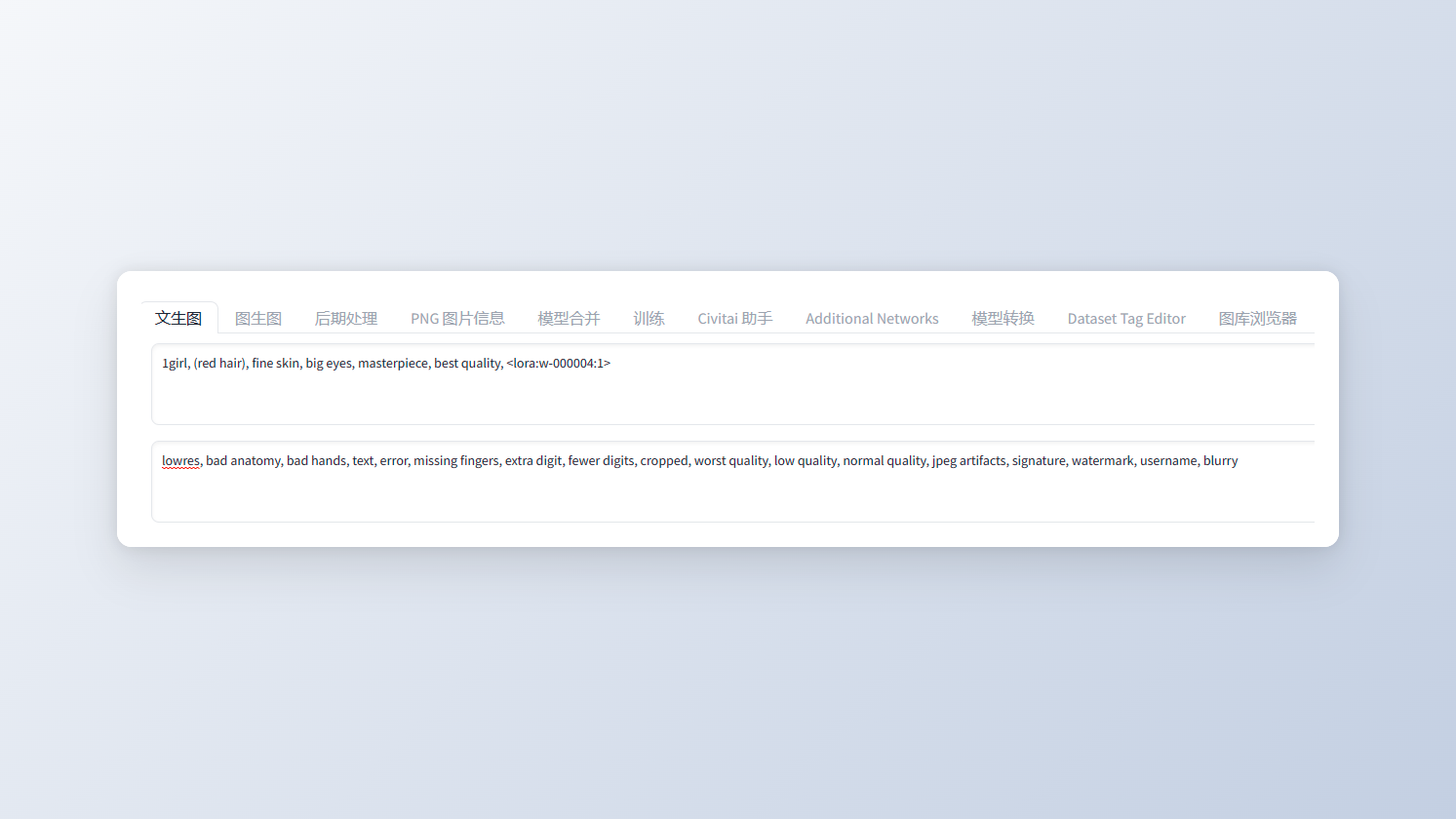

写好提示词,让你事半功倍

选好模型之后,我们就要考虑画面上要有什么东西,不要出现什么东西 这需要输入关键词来告诉SD,我们最后要生成什么样的图画正面提示词

正面提示词就是你希望照片里会出现的内容 输入的关键词越准确,出来的照片就会越接近自己脑海里的画面! 那怎么写关键词呢?

比如说我现在想要生成一个漂亮的小姐姐站在大街上

那我就可以写成:1女孩,漂亮,站着,大街

或者是:1漂亮女孩,站在大街上

又或者我直接写一个句子:1个漂亮女孩站在大街上

我们比较常用的就是直接输入一个个单词,然后这些单词用英文状态下的逗号隔开

SD只能识别英语,但我们也不用担心,直接用翻译就可以啦

那怎么写关键词呢?

比如说我现在想要生成一个漂亮的小姐姐站在大街上

那我就可以写成:1女孩,漂亮,站着,大街

或者是:1漂亮女孩,站在大街上

又或者我直接写一个句子:1个漂亮女孩站在大街上

我们比较常用的就是直接输入一个个单词,然后这些单词用英文状态下的逗号隔开

SD只能识别英语,但我们也不用担心,直接用翻译就可以啦

:::color1

SD支持三种单词、词组、短句的方式的输入 但是需要为英文:::

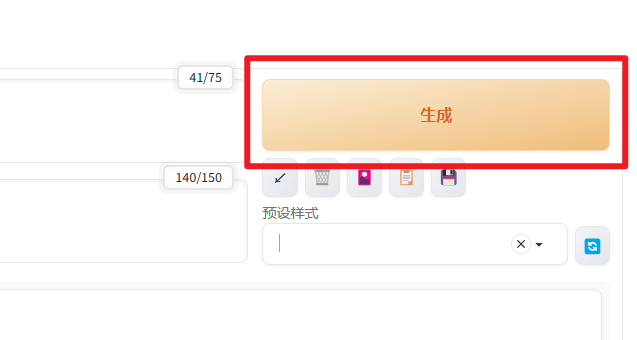

接着点击右边这个“生成”按钮

看到这一大串英文千万别害怕!写关键词也是有模板的!

:::color1

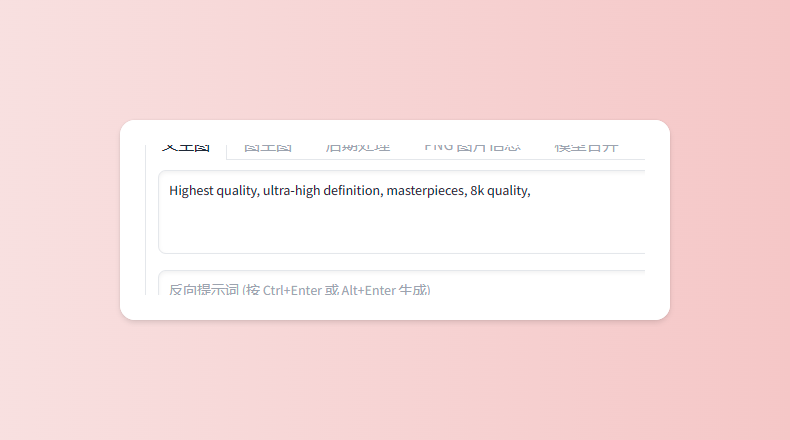

提示词书写结构:画质提示词+主体+主体细节+服装配饰+其他、背景、天气、构图等 ::: 在写跟我们照片有关的关键词之前,我们可以先写一些照片质量的词语,这样出来的照片会更加精致 比如说我们可以写:最高质量,超高清画质,大师的杰作,8k画质等等… 翻译成对应的英文就是:Highest quality, ultra-high definition, masterpieces, 8k quality,

:::color1 注:最新的模型SDXL1.0已经不需要输入质量提示词了,可以直接输入你的关键词就可以得到很好的效果

:::

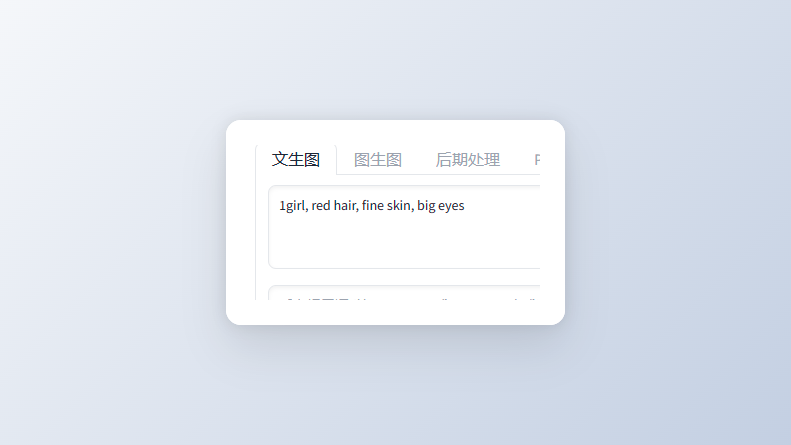

翻译成英文就是:1girl, red hair, fine skin, big eyes

当然这些不是必需的,你也可以写完你的主要部分就留白

:::color1 技巧:

- 越前面的词,SD越会优先考虑,所以重要的词放前面。

- 同类词语放在一起,不要放重复词,比如描写背景的就都写一起。

- 只写必要的关键词

- 描述词的语言的标点符号全部必须用英文的

:::

如果我们在提示词中写了某个元素,例如:红色头发,但是最后生成出来的图并不是红色头发的,那怎么办呢? 我们要做的是增加这个关键词的权重,让SD更加注意这个关键词。 增加权重的方法有:

- 用括号把关键词括起来:(red hair)

- 手动赋予权重,结构为(red hair:1.5)

我们所输入的数值越大,关键词的权重越大

除此之外,可以加权重,那我们也可以减权重,减权重就是用”[]”把单词括起来,如:[curly hair],或者手动赋予1以下的权重负面提示词

当我们尝试多了几次之后,发现画面经常会出现一些我们不需要的元素,那怎么才能减少这些情况出现的概率呢? 那就是告诉SD,不要输出这样的内容,这就是负面提示词 比如说我不希望照片出现:低分辨率,糟糕的结构,糟糕的手,低质量,水印,用户名,模糊我们就需要输入相应的提示词

这里给大家提供现成的,复制就可以直接使用了

当然你如果还有什么不想出现在照片上的东西,也可以自己加上去(worst quality:2), (low quality:2), (normal quality:2), lowres, ((monochrome)), ((grayscale)), bad anatomy,DeepNegative, skin spots, acnes, skin blemishes,(fat:1.2),facing away, looking away,tilted head, lowres,bad anatomy,bad hands, missing fingers,extra digit, fewer digits,bad feet,poorly drawn hands,poorly drawn face,mutation,deformed,extra fingers,extra limbs,extra arms,extra legs,malformed limbs,fused fingers,too many fingers,long neck,cross-eyed,mutated hands,polar lowres,bad body,bad proportions,gross proportions,missing arms,missing legs,extra digit, extra arms, extra leg, extra foot,teethcroppe,signature, watermark, username,blurry,cropped,jpeg artifacts,text,error

:::color1 注意:负面提示词只能减少错误的情况产生的概率,如果输入负面提示词依旧会出现人体结构错误的情况是正常的,这是目前软件的局限性

:::

3.打造你的专属模特

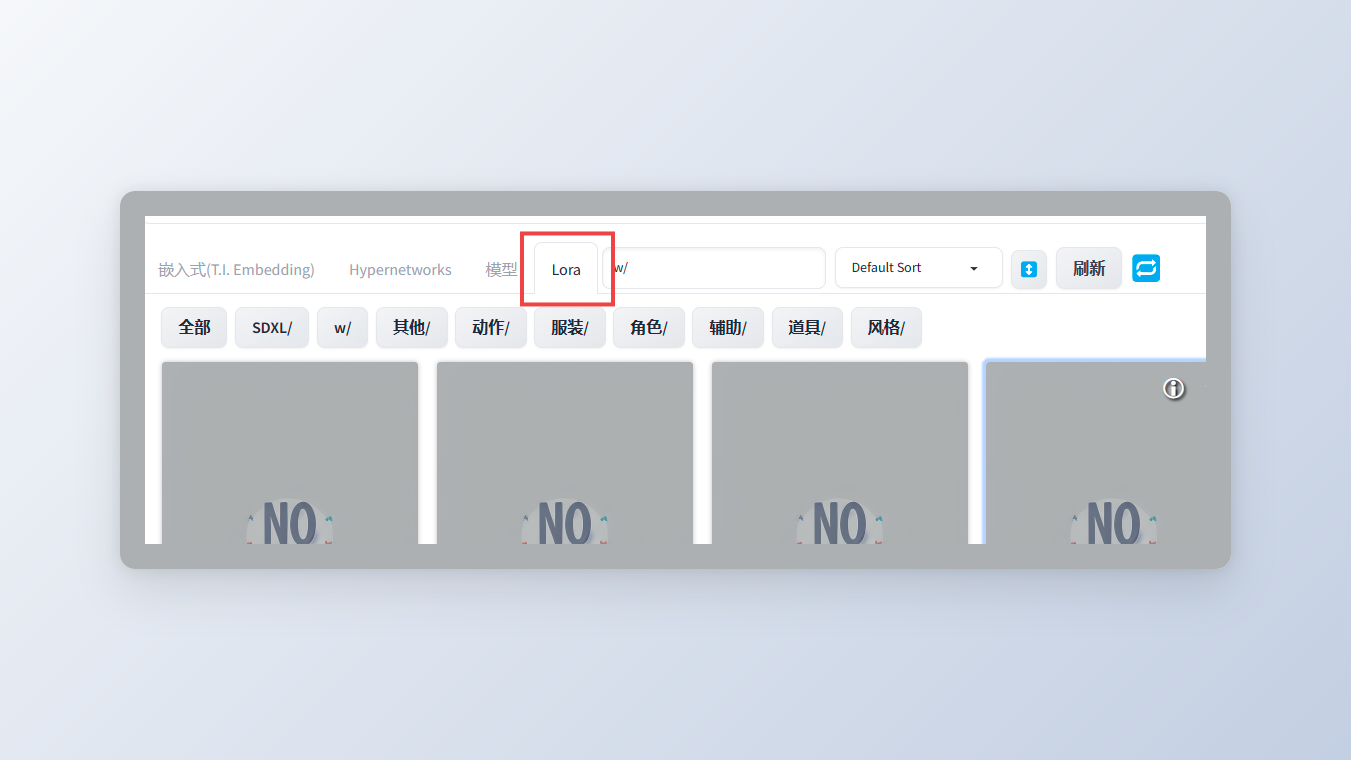

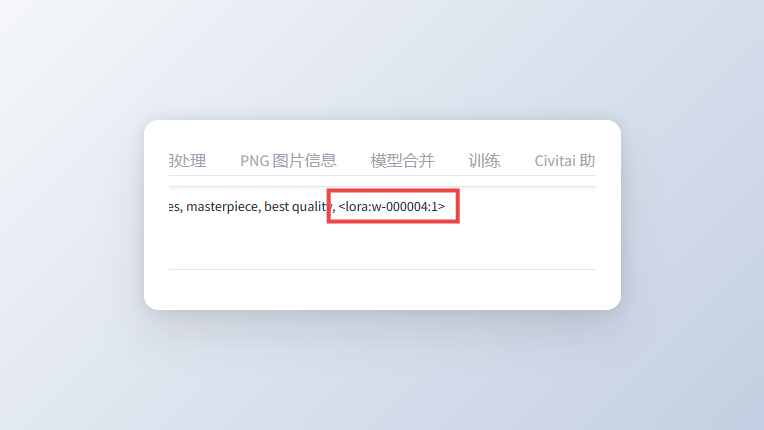

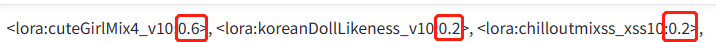

通过输入关键词,我们已经能生成一些不错的照片了 如果我想要生成的照片,都是同一张脸,这怎么办呢?这时候我们就要用到Lora模型

:::color1

Lora模型的功能是固定生成某个特征 不仅可以让SD生成指定的是人物角色,也可以指定服装,场景,动作,照片风格等等:::

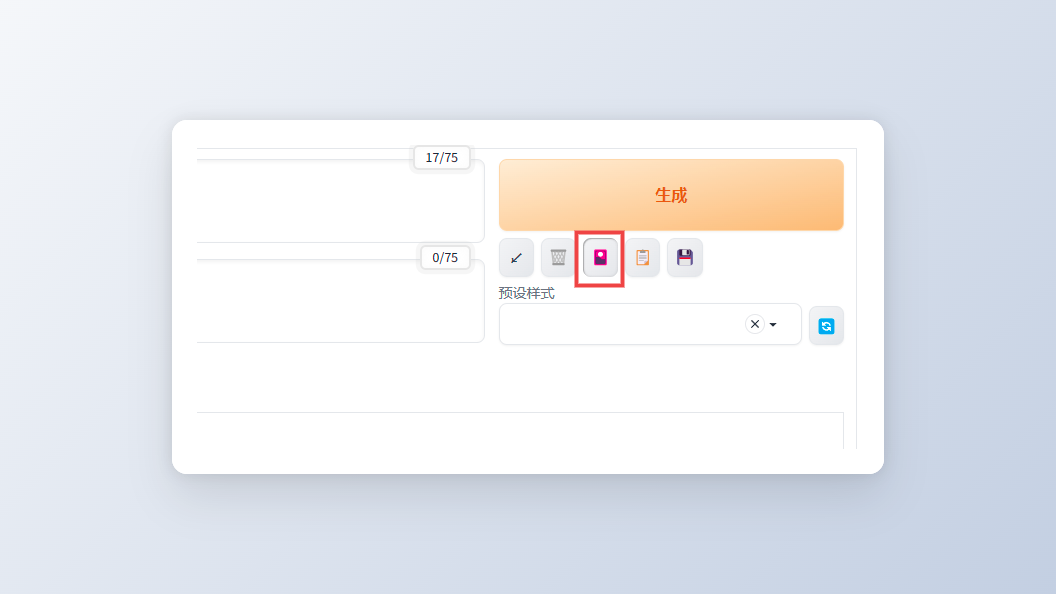

点击“生成”下面的的第三个按钮,就会弹出新的选项框

:::color1

Lora之间一样用英文逗号隔开 Lora也是具有权重的,权重的用法和提示一样,通过引号后面的数字控制权重 且,Lora是可以叠加使用的,但是建议新手不要使用太多lora因为Lora大部分都是用户自行训练,有可能存在问题,如果照片出问题了,你也不知道是哪个Lora有问题

:::

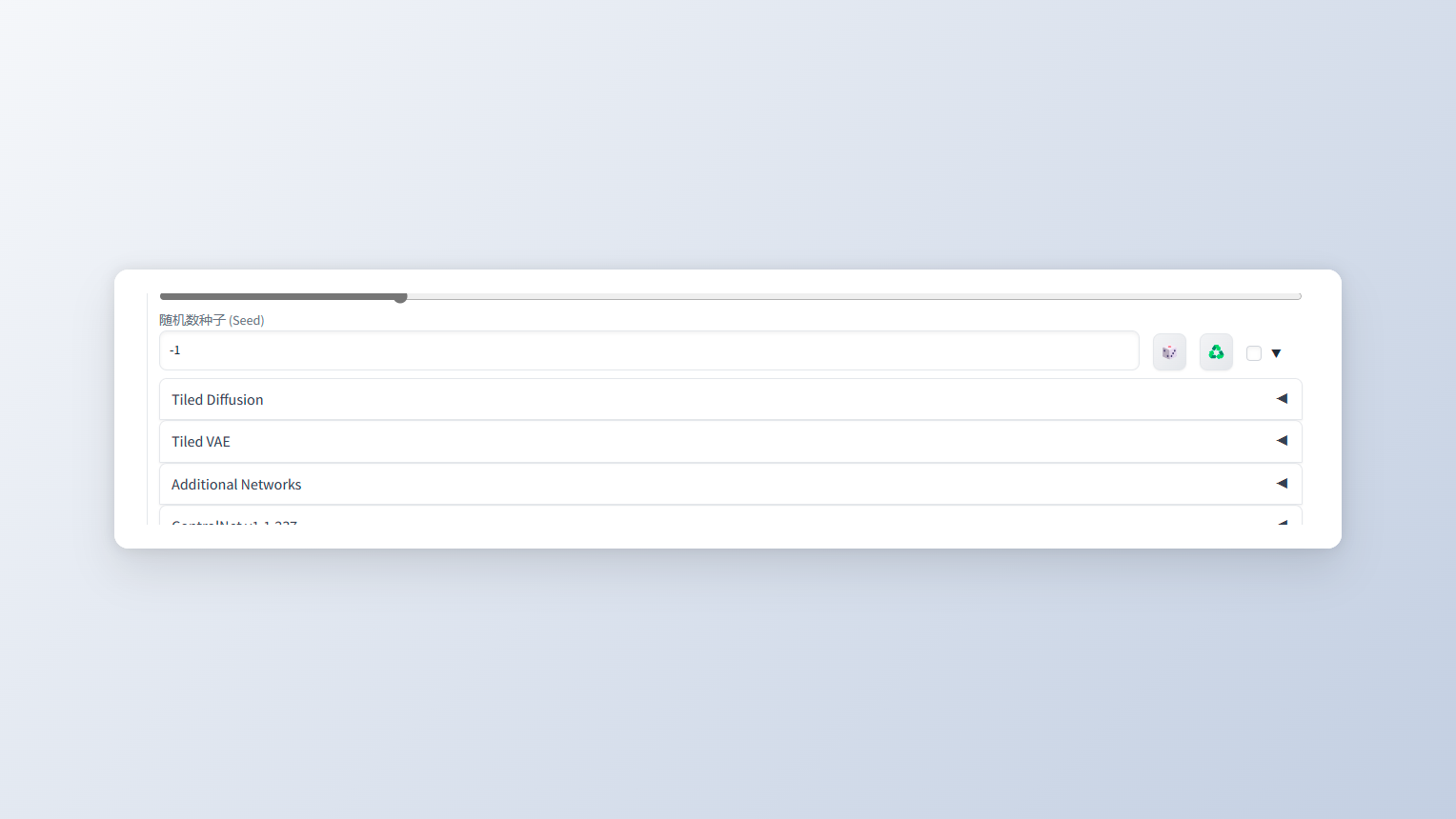

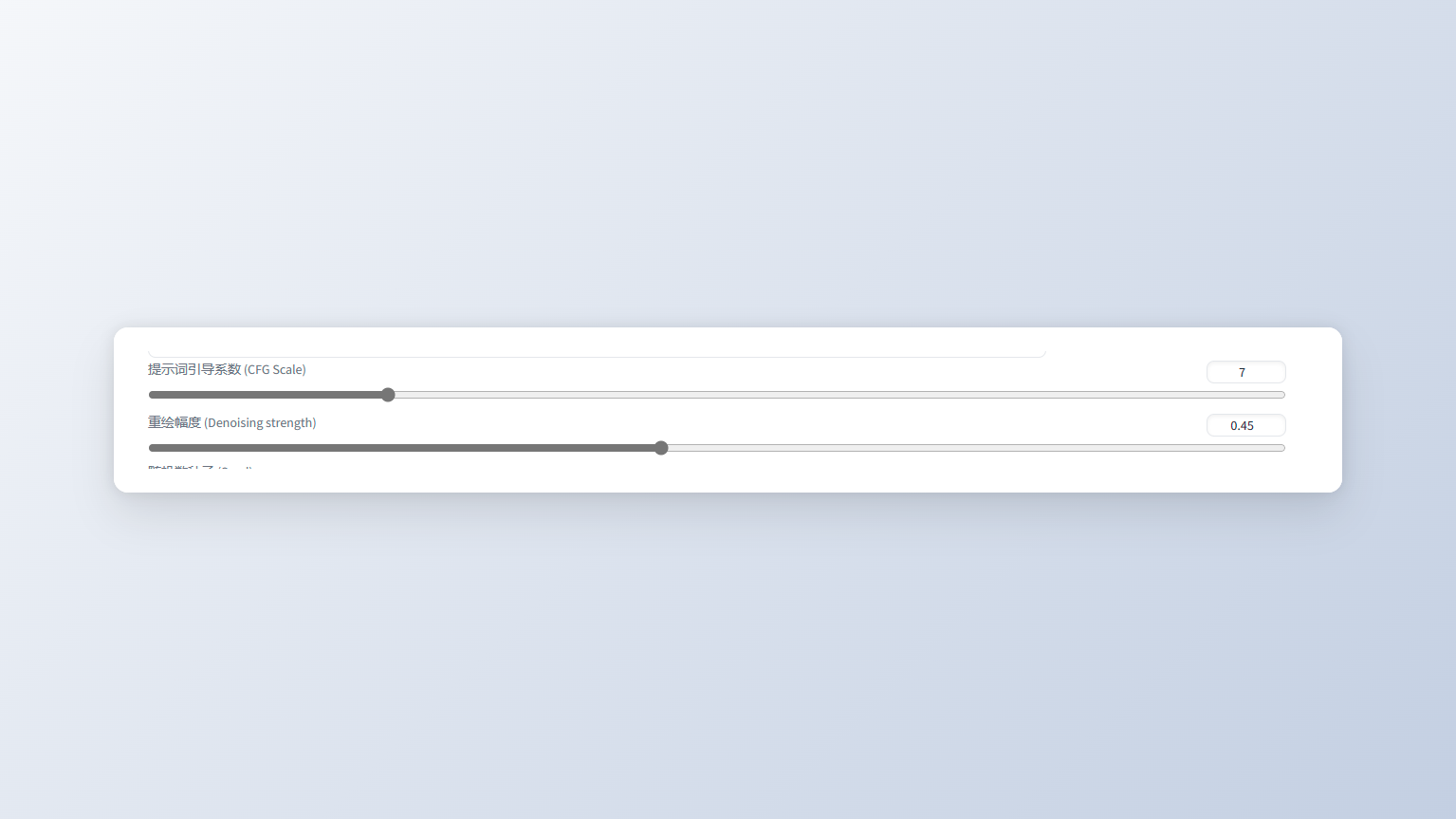

为什么你生成的图就是跟别人不一样

为什么我和别人用的大模型、关键词、Lora全部参数都一样 但是,可偏偏生成出来的图就是不一样? 那是因为影响照片的因素还有一个“随机数种子(Seed)” 随机数种子控制的是最底层的形状,就相当于我们画画最开始的线稿 它会决定我们照片的基础轮廓,相当于决定了我们照片人物的外形轮廓,包括姿势和站位等

一分钟生成自己的二次元造型

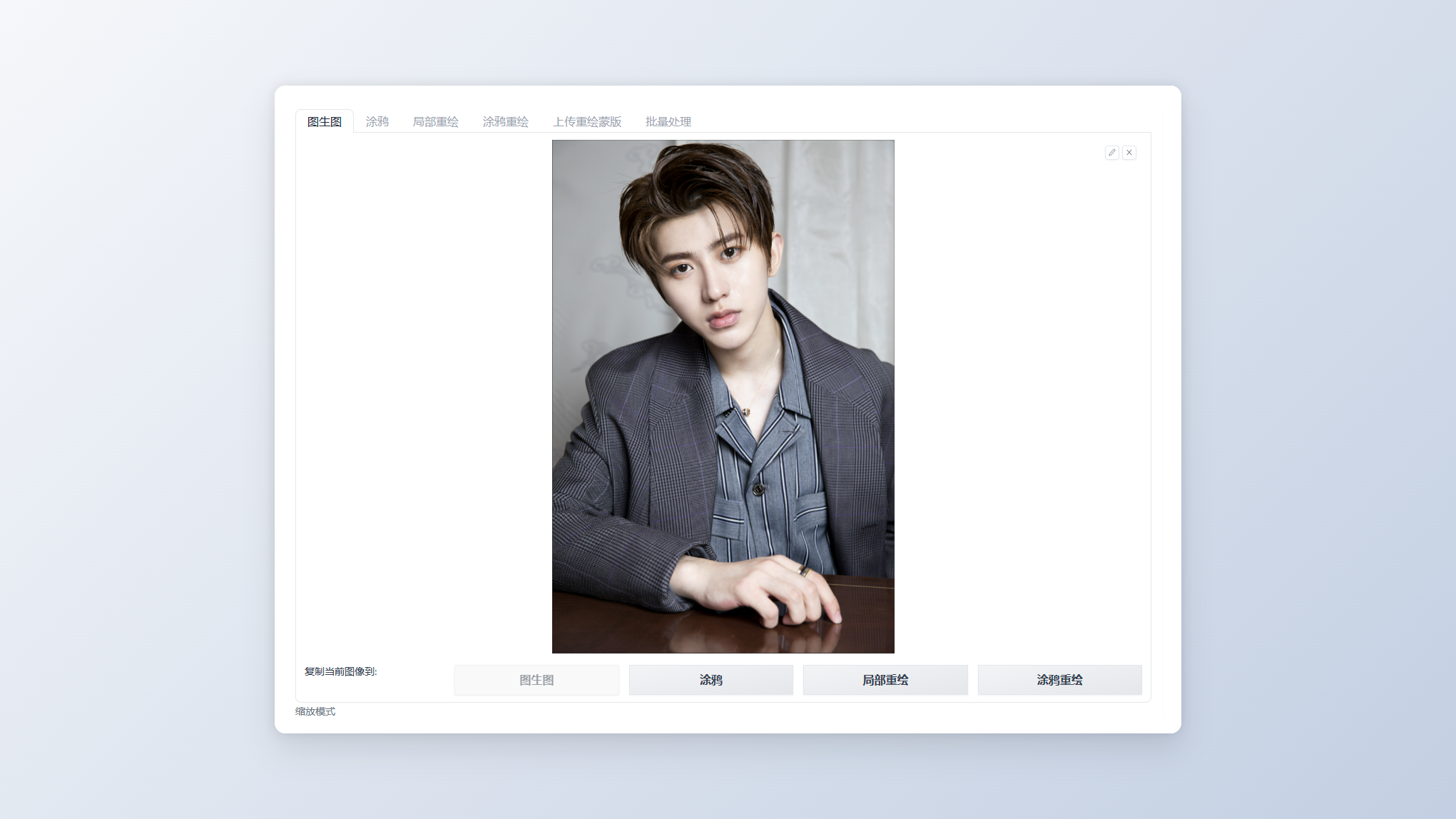

以前很流行画师帮你用照片画一个插画 当AI出来的时候,现在大家都使用AI来给自己画画 Stable Diffusion不用一分钟,不管你是要2.5D还是2D的照片,它都能生成!这里我们用到的是图生图里面的功能

我们是要用自己的照片生成一张二次元的照片

我们现在这里上传我们用来转二次元的照片

我们现在这里上传我们用来转二次元的照片

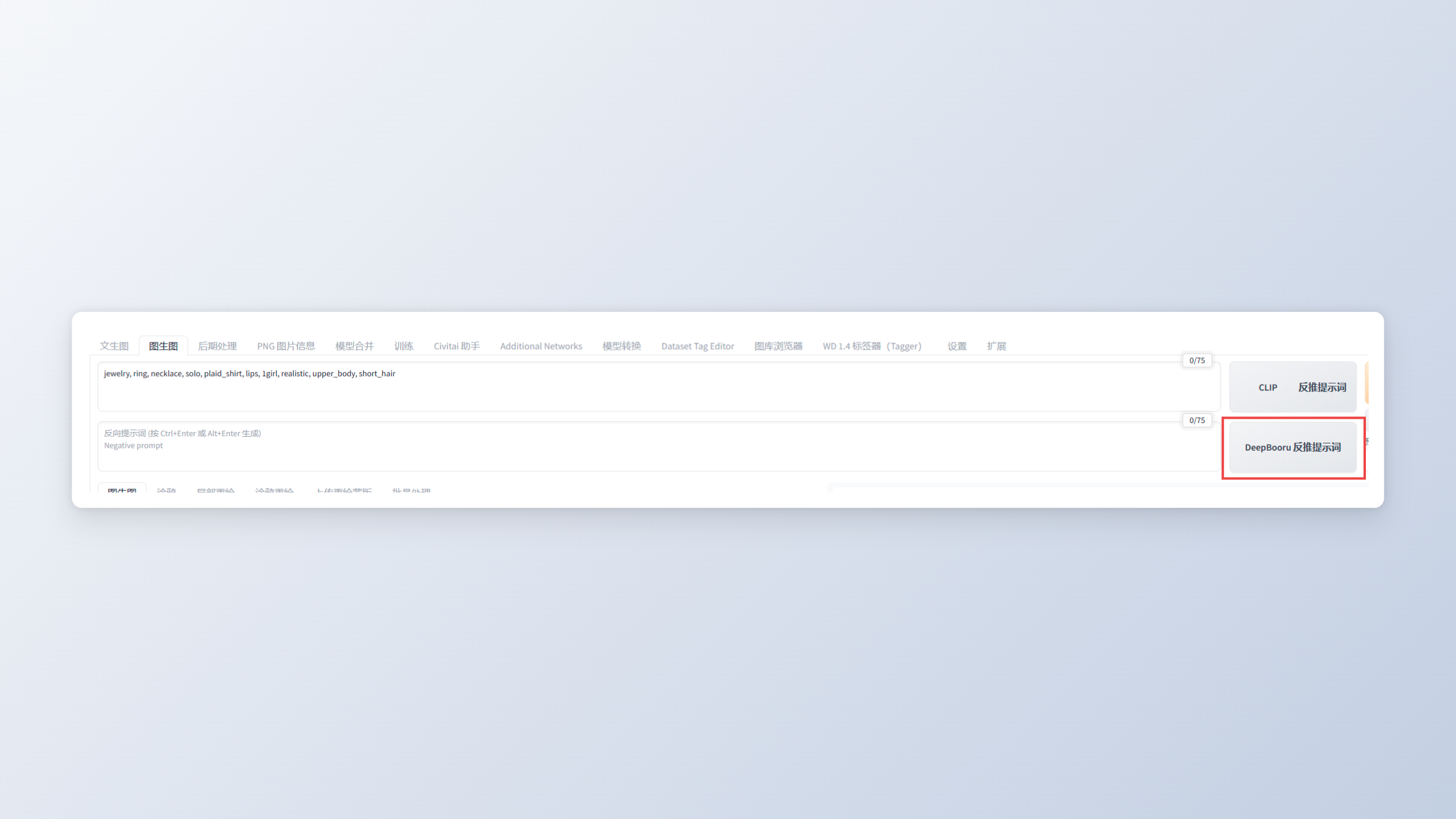

我们可以直接用SD反推提示词,当然反推完你也要检查一下是否有错误的提示词

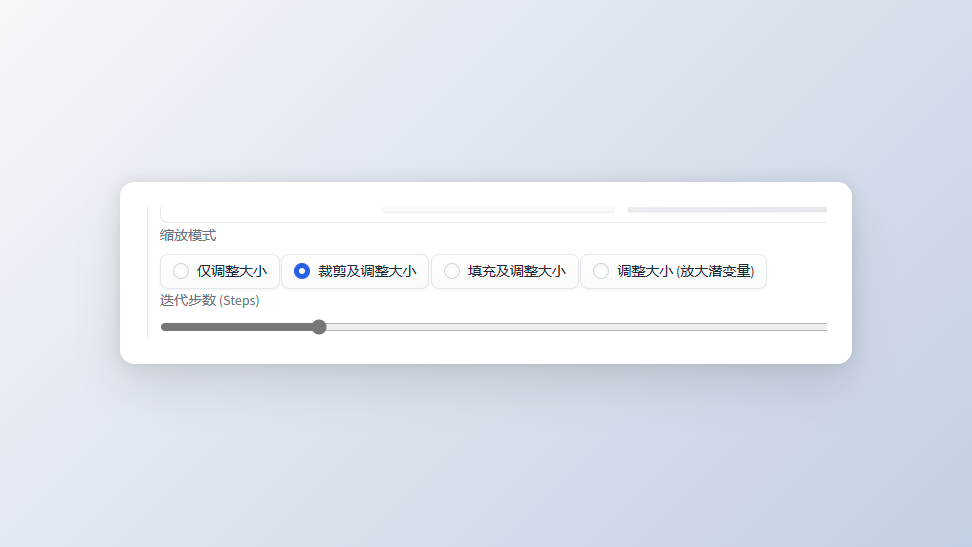

缩放模式记得选为,裁剪及调整大小,然后再调整宽和高,不然出来的图会变形

采样建议使用这个

然后就可以开始生成了

局部重绘 给二次元角色换衣服

假如我现在有一张非常好看的照片,唯独我觉得衣服不好看 那我要怎么在不改变其它地方的情况下,换上更好看的衣服呢?

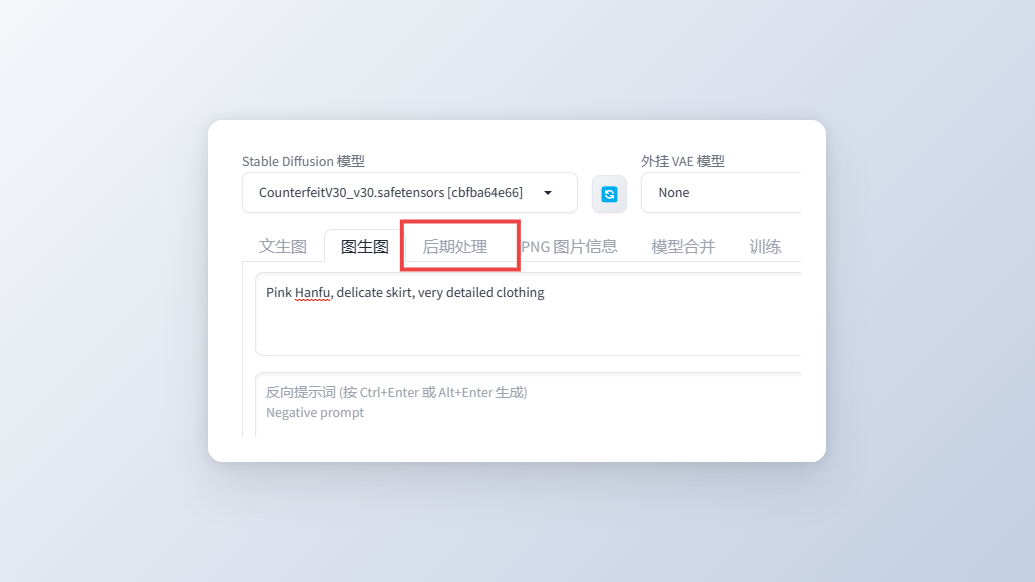

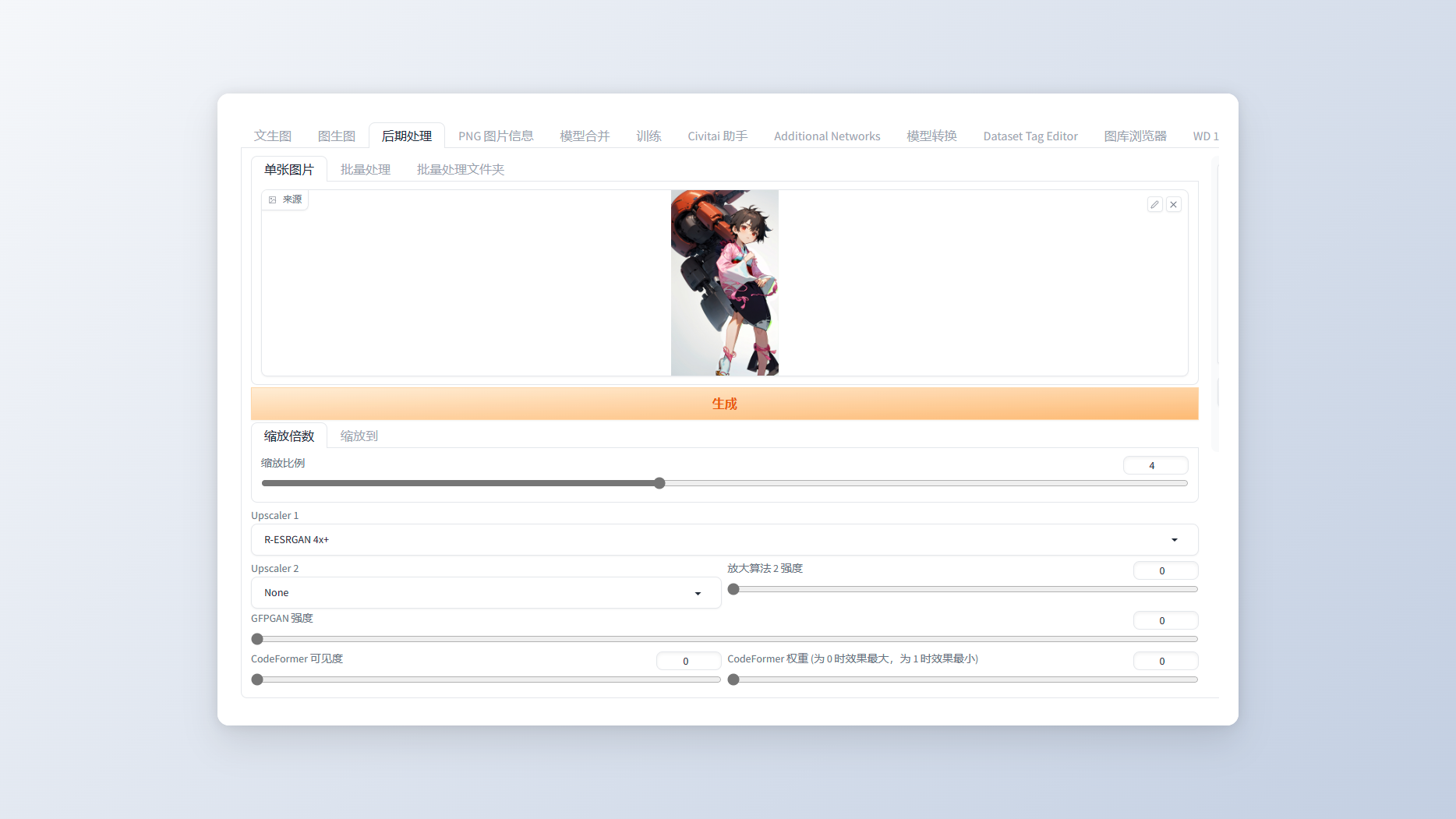

8.轻松拯救超糊照片

SD除了生成新的照片外,还可以用来修复我们比较糊的照片 出来的效果比大多数软件都要好!这个恢复画质的功能在SD里叫“后期处理”,点击下面空白的地方上传图片

:::color1 修复二次元的照片就选“R-ESRGAN 4x+Anime68”

其他实物照片就选“R-ESRGAN 4x+”

:::

其他放大器出来的效果都没有这两个好

最后点击生成就可以!

轻松获取大佬的提示词

在网上经常看到别的大佬的图觉得很好看,想要复制却复制不出来,但其实SD里面就有这样一个功能 把照片导进去,它就能识别出来这张照片用到的咒语或者关键词

一招让你自由指定生成的姿势

现在我们已经能够生成美女的照片了,可以定制出独一无二的脸,换上更好看的衣服但是我们怎么才能让生成的角色摆出指定的姿势呢?

通过关键词去描绘动作,可是出来的照片又不太准确 那我们就可以用到这个“ControlNet”功能,翻译成中文就是控制网络 关于ControlNet的具体功能可以看看这篇文章 简单来说就是可以用它控制照片的线条,比如人物的动作、建筑物的线条等 比如,我现在想让左边照片的小姐姐摆出右边小姐姐的姿势,得到最右边的一张照片 首先,大模型和关键词我们还是正常的填写 生成一张我们我们想要的照片

①点击空白的地方,上传我们需要指定的姿势的照片

②点击“启用”

③在“预处理器”和“模型”里选择“openpose”,这就是用来让计算机识别人物姿势的

①点击空白的地方,上传我们需要指定的姿势的照片

②点击“启用”

③在“预处理器”和“模型”里选择“openpose”,这就是用来让计算机识别人物姿势的然后再生成这样我们一张指定姿势的图片就生成啦!

11.插画师的福音,线稿秒上色

随着AI绘画越来越火,很多人都会说将来可能很多画师的职业都受到威胁了

但是,会用AI绘画的画师一定会比那些不会AI绘画的画师更有优势

当别人为了给线稿上色,花了一天的时间

而你一分钟不到就出了一张质量不错的图 单是工作效率上就领先别人很多了

下面这张就是我在网上随便找的一张线稿图,通过SD上色出来的一张照片

这也是通过使用“ControlNet”这个功能生成的

首先,我们点开”ControlNet”的状态栏

①在空白的地方上传自己的线稿图 ②点击“启用” ③点击“反转输出颜色” ④在模型里面选择“canny”的模型

接着去设置我们前面的内容

①选择合适的大模型 我想要生成二次元的图,就要选择相应的模型

②关键词 跟我们写关键词一样,先写照片质量的关键词(比如:最高质量,大师杰作等)

接着我们就可以指定上什么颜色了

比如我输入的就是:1可爱女孩,五官精致,精致眼睛和嘴巴,银色长发,白皙的皮肤,水汪汪的大眼睛,

最后还加上一个简单的背景

想要色彩更加细节,就可以通过输入更多的关键词来控制照片

负面关键词只要复制前面的就可以

就这样不管再复杂的线稿,在SD里面都可以很快速的上好颜色

12.小白也能进行室内设计

“ControlNet”还有一个非常好用的功能,

那就是进行室内设计

比如说我现在想对房间进行重新装修 我想看看我的房子弄成不同的风格是怎样的

首先先点开“ControlNet”的状态栏

①上传需要进行设计的房间照片 ②点击“启用” ③预处理器和模型都选“msld”,这是用来计算房屋线条的

接着切换一个现实照片的大模型

关键词先输入照片质量关键词

然后就是输入照片的主体:一个客厅

最后点击生成

这样出来的照片既保留了原来房子的构造,又可以看到新的房屋风格!

四、Stable diffusion知识补充

这一节是SD剩余功能的一些补充知识,大家不用担心SD功能太多太复杂,

这一节大多数功能的参数只要照抄就行!

1.VAE

只要知道VAE的作用就是加滤镜和微调照片

下面图片就是没加VAE和加了VAE的区别 没加VAE的照片是灰蒙蒙的

但在一般情况下,如果我们对照片的色彩没有特别要求的时候,只选定一个VAE来使用就可以。

下面这个就是我比较常用的VAE

2.迭代步数

简单的说,我们把在SD生成图片的过程当作在画画

迭代步数的意思就是我们在这幅画上画多少笔

一般我们把参数设置在20~30之间

看下面的图,20步以下的图质量都不高

但不是说步数越多越好 超过30步部分电脑可能就带不动,无法生成照片了

所以,电脑配置稍微低一点的就设置在20~25 电脑配置比较好的就可以设置在25~30之间

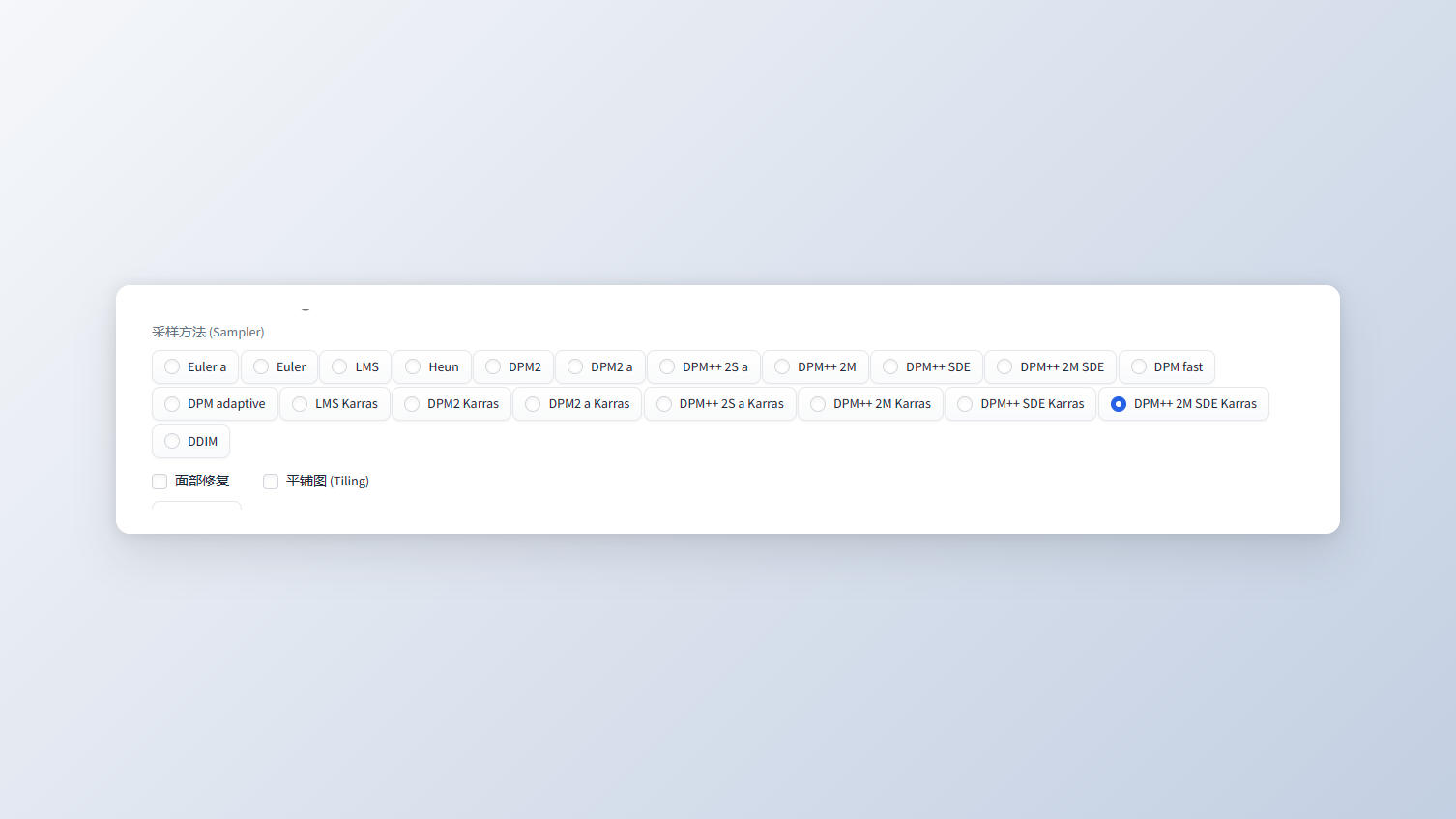

3.采样方法

采用方法的不同就相当于我们画画的方式不一样

那这么多采用方法怎么选呢?

首先,我们看到别人好看的照片,可以看看人家用的是哪一个采用方法

如果实在不知道用哪一个,这里也给大家测试过了,

用下面框出来的几个,出来的照片质量比较高,而且出图速度也比较快

4.面部修复+高分辨率修复

这两个功能没什么好讲的,大家直接抄作业就可以!

面部修复:用在生成真人照片上

高分辨率修复:电脑配置好就可以用;电脑配置稍微差点的别开,否则照片无法生成

5.图片分辨率(图片大小)

这里的宽度和高度就是用来调节照片大小的

一般情况下: 生成正方形的照片:宽度512*高度512 生成长方形的照片:宽度512*高度768

电脑配置稍微差点的朋友们,千万别看网上设置成什么1024、2048,我们电脑跑不动哒!

6.生成多图

通过调整下面这两个参数,可以让我们一次生成多个图

假如我们把两个参数都设置成2

总批次数的意思就是生成两批 单批数量的意思就是一批生成两张照片 所以一共就会生成4张照片

在我们日常使用需要生成多张照片的

我们只调整“总批次数”就可以啦,这意味着我们照片是一张一张生成的

单批数量就意味着同时生成多张照片,这对我们的显卡是有一定要求的,所以这个不要用!!

7.用脚本进行照片对比

我们生成一张照片会输入很多的关键词,

那我们怎么才能看到输入不同的关键词, 出来的照片有什么区别

或者加某个关键词和不加的区别呢?

那我们就要用到最下面“脚本”里的“提示词矩阵”,直接点击就可以

接着来到关键词的文本框

我们前面一直说在写关键词之前,先写照片的质量词

那我们就以这张照片为例子, 看看加上最高质量(the best quality)和不加有什么区别

书写的格式:把需要进行对比的关键词放在最后,用“|”把关键词和前面的关键词分隔开

也就是:关键词|需要对比的关键词

点击生成就会出现两张拼在一起的照片,

我们就可以看到加了“最高质量(the best quality)”的照片会更加清晰

那如果现在想要比较不同的采用方法下,迭代步数不一样,生成的照片有什么区别,该怎么操作呢?

这里用到的就是脚本里的“X/Y/Z图表”

在X轴类型里面选择“迭代步数”,右边的X轴值就输入需要进行比较的步数

在Y轴类型里面选择“采用器”,接着点击最右边的笔记本图标

那样所有采样器的名称都会出现在框框里面,可以自己进行删减

我们这里就选三个比较常用的采样器

点击“生成” 就会生成这么一张大图

我们就可以看到在不同的采用方法下,迭代步数为25的时候,生成出来的照片都差不多

这样比较下来,我们就可以选择自己更喜欢的采样方法和迭代步数

五、大神的模型从哪来

1.模型在哪下载

除了链接里面给大家分享的模型,大家肯定还想去找更多更好看的模型

而大多数的模型都是在Civitai(C站)这个网站里面https://civitai.com/

现在就给大家说一下C站的使用方法:

01.科学上网

02.点击右上角的筛选按钮,在框框里面找到自己需要的模型类型

Checkpoint=大模型 LoRA=Lora

常用的就是这两个

03.看照片,看到感兴趣的就点进去

点击右边的“Download”,也就是下载,保存到电脑本地, 文件保存到哪里在这一节的第二部分

另外,我们还可以点击左上角的“Images”

这里就是看别人已经做好的图片,找到喜欢的点进去

点进去之后的页面我们就可以看到这张图的全部信息,

直接点击Lora和大模型,可以直接跳转到下载页面

下面的就是照片关键词和其他信息 点击最下面的“Copy…Data”就可以复制图片的所有信息

回到SD,粘贴到关键词的文本框,点击右边的按钮

这些信息就会自动分配

要注意的就是,大模型是需要我们手动去换的!

这样我们就可以生成出跟大神几乎一样的照片了!(电脑网络配置的不同,出来的照片有细微差别)

2.模型下载到哪里

这里大家就直接看我文件的保存地址,找到自己电脑里的

01.大模型

02.Lora

03.VAE

3.如何分辨模型

如果我们下载了一个模型,但不知道它是哪个类型的,不知道要放到哪个文件夹

我们就可以用到这个秋叶的模型解析工具 https://spell.novelai.dev/

把模型拖动到空白处

接着就会自动弹出模型的信息

在模型种类里面就可以看到是什么模型啦!

六、结尾

安装包,大模型,lora: 链接:https://pan.baidu.com/s/1hY8CKbYRAj9RrFGmswdNiA?pwd=caru 提取码:caru

好啦,希望这篇文章能够真正帮助到你上手SD

之后我还会出SD的《Stable Diffusion进阶宝典》《热门Lora模型大全》《Lora炼制秘籍》

如果哪里还有疑问,或者对文档的建议欢迎在评论区留言噢!

我们下个文章再见!