完全分布式集群搭建

主要步骤:

- 准备三台服务器hadoop102、hadoop103、hadoop104,关闭防火墙、设置静态IP、配置主机名称和主机映射。

- 安装JDK、Hadoop,配置环境变量

- 配置集群

- 单点启动

- 配置ssh

- 群起并测试集群

集群文件复制分发

scp复制

使用scp将安装包进行分发:

因为在hadoop102上已经搭建好了 jdk、hadoop,所以可以直接复制到其他服务器上: ```java cd /opt/module scp -r jdk1.8.0_331/ tengyer@hadoop103:/opt/module/ scp -r hadoop-3.2.3/ tengyer@hadoop103:/opt/module/

scp -r jdk1.8.0_331/ tengyer@hadoop104:/opt/module/ scp -r hadoop-3.2.3/ tengyer@hadoop104:/opt/module/

也可以在hadoop103上使用scp从hadoop102上拉取

scp -r tengyer@hadoop102:/opt/module/hadoop-3.2.3 ./

<a name="hMGiR"></a>## rsync同步使用rsync远程同步变化的文件:<br />rsync主要用于备份和镜像,具有速度快、避免复制相同内容和支持符号链接的优点。<br />rsync和scp区别:用rsync做文件的复制要比scp速度快,rsync只对差异文件做更新,而scp是把所有文件都复制过去。<br />命令语法:```java# -a :归档拷贝# -v :显示复制过# --delete 当目的路径文件或文件夹比源路径多(源路径删除了文件),删除目的路径的文件rsync -av --delete <要拷贝的文件路径/名称> <目的用户@主机:目的路径/名称>

例如,在hadoop102的/opt/module/hadoop-3.2.3文件夹内增加或删除一个文件,然后执行同步命令:

cd /opt/module/hadoop-3.2.3# hadoop102节点的hadoop-3.2.2中创建一个test.txt文echo "abcd" > test.txt# 同步到hadoop103服务rsync -av --delete ./hadoop-3.2.3/ tengyer@hadoop103:/opt/module/hadoop-3.2.3/

编写自动同步脚本

可以编写一个shell脚本调用rsync命令,将文件同步到所有节点的相同目录下。

#!/bin/bash# 1. 判断参数个数if [ $# -lt 1 ]thenecho Not Enough Argumenexitfi# 2. 遍历集群所有机器for host in hadoop102 hadoop103 hadoop104doecho ================== $host =====================# 3. 遍历所有目录,逐个发送for file in $@do# 4. 判断文件是否存在if [ -e $file ]then# 5. 获取父目录# -P 如果cd后面是一个软链接,-P可以进入软链接指向的真正文件夹pdir=$(cd -P $(dirname $file); pwd)# 6. 获取当前文件名称fname=$(basename $file)# -p 如果存在则不创建,如果不存在则创建ssh $host "mkdir -p $pdir"rsync -av $pdir/$fname $host:$pdirelseecho $file does not exists!fidonedone

执行时,只需:xsync 文件或文件夹1 文件或文件夹2.....执行即可。

例如,将/opt/module文件夹同步到其他几台服务器:

sh xsync /opt/module/

如果要同步的文件是root权限,比如环境变量配置文件/etc/profile.d/my_env.sh,可以使用sudo进行同步:

# 使用sudo时,因为xsync不在root的命令列表,所以需要使用./进行调用sudo ./bin/xsync /etc/profile.d/my_env.s

因为脚本中使用了ssh命令和rsync命令去连接其他服务器,所以每台服务器都要输入两次密码,比较繁琐,可以配置ssh免密登录。

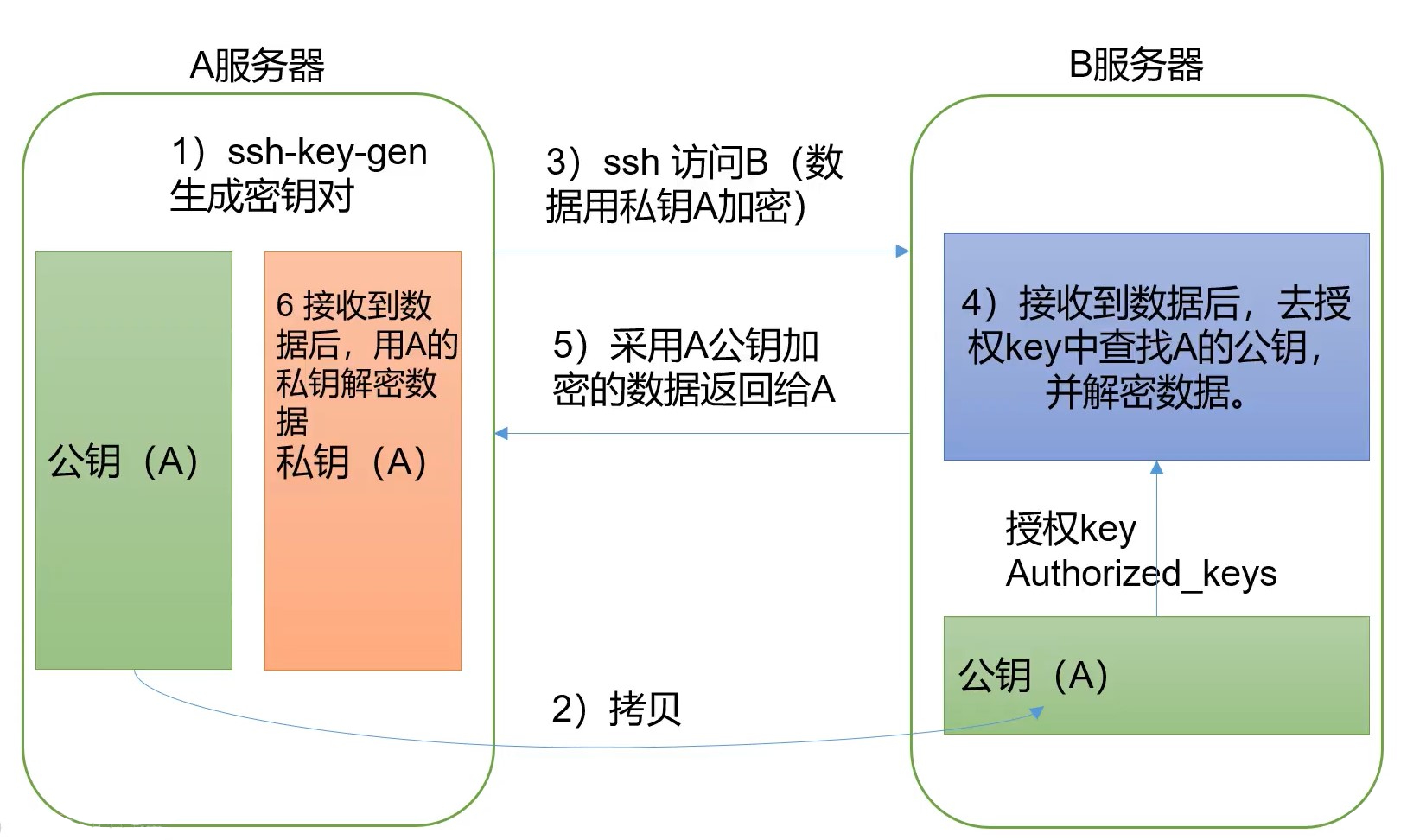

配置ssh免密登录

known_hosts文件:

如果当前服务器使用ssh命令连接过其他服务器,那么在该用户家目录下就会生成一个.ssh文件夹,里面存有一个known_hosts文件,文件中保存的有该用户曾经使用ssh命令远程连接过的服务器。

配置hadoop102免密登录hadoop103、hadoop104:

在hadoop102上创建一个SSH的RSA密钥对:

# 选择非对称加密算法为rsa算法ssh-keygen -t rsa# 然后一路回车即

命令执行后,会在用户家目录下的.ssh文件夹中生成一个公钥文件id_rsa.pub、一个私钥文件id_rsa

如果是非root用户,则在根目录下 执行 cd .ssh 即可进入将hadoop102上的公钥id_rsa.pub拷贝到hadoop103、hadoop104: ```java

将hadoop102的公钥拷贝给hadoop103

命令执行后,需要输入hadoop103的密码

之后hadoop102再用ssh访问hadoop103时便不再需要输入密码

[root@hadoop102 .ssh]# ssh-copy-id hadoop103

配置免密登录 hadoop104

[root@hadoop102 .ssh]# ssh-copy-id hadoop104

3. 另外,还需要对自己设置免密登录,否则hadoop102使用ssh连接 hadoop102` 本身时也需要密码:```java[root@hadoop102 .ssh]# ssh-copy-id hadoop102

进行免密之后,在hadoop103、hadoop104的.ssh文件夹中会多一个authorized_keys文件,里面记录了允许哪些客户机免密登录自己。authorized_keys文件中的内容其实就是hadoop102的公钥文件id_rsa.pub中的内容。

然后在hadoop103、hadoop104上也执行上述同样的操作,使集群中的几台服务器可以互相免密登录。

免密登录是和用户有关的,如果想用其他用户登录,也需要重复上述操作。

集群配置

注意事项:

- NameNode和SecondaryNameNode不要安装到同一台服务器上 (占用内存都很高)

- ResourceManager也很消耗内存,不要和NameNode、SecondaryNameNode配置在同一台机器上

对三台服务器进行如下规划:

| 配置项 | Hadoop102 | Hadoop103 | Hadoop104 |

|---|---|---|---|

| HDFS | NameNode DataNode |

DataNode | SecondaryNameNode DataNode |

| YARN | NodeManager | ResourceMananger NodeManager | NodeMananger |

配置文件配置

Hadoop配置文件分为两类:默认配置文件和自定义配置文件,只有用户想修改某一 默认配置值时,才需要修改自定义配置文件,更改相应属性值。

默认配置文件:

| 默认的四大配置文件 | 存放位置 |

|---|---|

| core-default.xml | hadoop-common-3.1.3.jar/core-default.xml |

| hdfs-default.xml | hadoop-hdfs-3.1.3.jar/hdfs-default.xml |

| yarn-default.xml | hadoop-yarn-common-3.1.3.jar/yarn-default.xml |

| mapred-default.xml | hadoop-mapreduce-client-core-3.1.3.jar/mapred-default.xml |

自定义配置文件:

core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml四个配置文件存放在$HADOOP_HOME/etc/hadoop这个路径上,用户可以根据项目需求重新进行修改配置。

在hadoop102上将配置文件修改,然后分发给hadoop103、hadoop104。

配置核心配置文件core-site.xml:

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 在configuration中添加以下配置信息 --><!-- 指定NameNode的地址 --><!-- core-defualt.xml中该项默认值为本地Linux路径,因为我们集群要用HDFS,所以要改成HDFS路径 --><property><name>fs.defaultFS</name><value>hdfs://hadoop102:8020</value></property><!-- 指定hadoop数据的存储目录 --><!-- core-default.xml中该项默认值为 /tmp/hadoop-${user.name},因为 /tmp在Linux中是临时目录,一段时间(默认一个月)会删除,所以要调整为自定义目录 --><!-- 我们指定的data文件夹如果不存在,hadoop会自动进行创建 --><property><name>hadoop.tmp.dir</name><value>/opt/module/hadoop-3.2.3/data</value></property><!-- 配置HDFS网页登录使用的静态用户为tengyer(即hdfs中的用户) --><!-- 如果不配置,那么在浏览器中默认的是Mr.who,该用户删除hdfs文件时,会提示无权限。--><property><name>hadoop.http.staticuser.user</name><value>kaixin</value></property></configuration

配置HDFS的hdfs-site.xml:

<?xml version="1.0" encoding="UTF-8"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 在configuration中添加以下配置 --><!-- NameNode对外暴露的Web端访问地址 --><property><name>dfs.namenode.http-address</name><value>hadoop102:9870</value></property><!-- 2NN 对外暴露的Web端访问地址(2NN安装在hadoop104上) --><property><name>dfs.namenode.secondary.http-address</name><value>hadoop104:9868</value></property></configuration>

配置Yarn的yarn-site.xml:

<?xml version="1.0"?><configuration><!-- 在configuration中添加以下配置 --><!-- 指定MR走shuffle --><!-- 在yarn-default.xml中该项默认值为空,但是官方推荐使用mapreduce_shuffle --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- 指定ResourceManager的地址(ResourceManager安装在hadoop103) --><property><name>yarn.resourcemanager.hostname</name><value>hadoop103</value></property><!-- 环境变量的继承 --><!-- Hadoop3.1.x需要配置,因为yarn-default.xml中该项默认值缺少了HADOOP_MAPRED_HOME --><!-- 到了Hadoop3.2.x就不需要再配置该项了,可以直接使用yarn-default.xml中的默认值 --><property><name>yarn.nodemanager.env-whitelist</name><value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value></property></configuration>

配置MapReduce的mapred-site.xml:

<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><configuration><!-- 在configuration中添加以下配置 --><!-- 指定MapReduce程序运行在Yarn上 --><!-- mapred-default.xml中该项默认值是local,即在本地运行 --><property><name>mapreduce.framework.name</name><value>yarn</value></property></configuration>

配置完成后,将hadoop102的这些配置同步分发给hadoop103、hadoop104:

cd /opt/module/hadoop-3.2.3/etc# 使用我们编写的同步分发脚本进行分发xsync hadoop/

群起集群

配置workers

workers内容即为集群中的各台主机,默认的是localhost。因为我们使用集群方式,所以可以删掉localhost,然后把几台主机都配置进来。

需要在$HADOOP_HOME/etc/hadoop/workers中将几台节点都添加进去:

hadoop102hadoop10hadoop104

该文件将来会作为hadoop集群启动的脚本一部分,所以主机名后面不能有空格、结尾也不能有空行

将works文件分发给其他服务器:

xsync works

启动集群

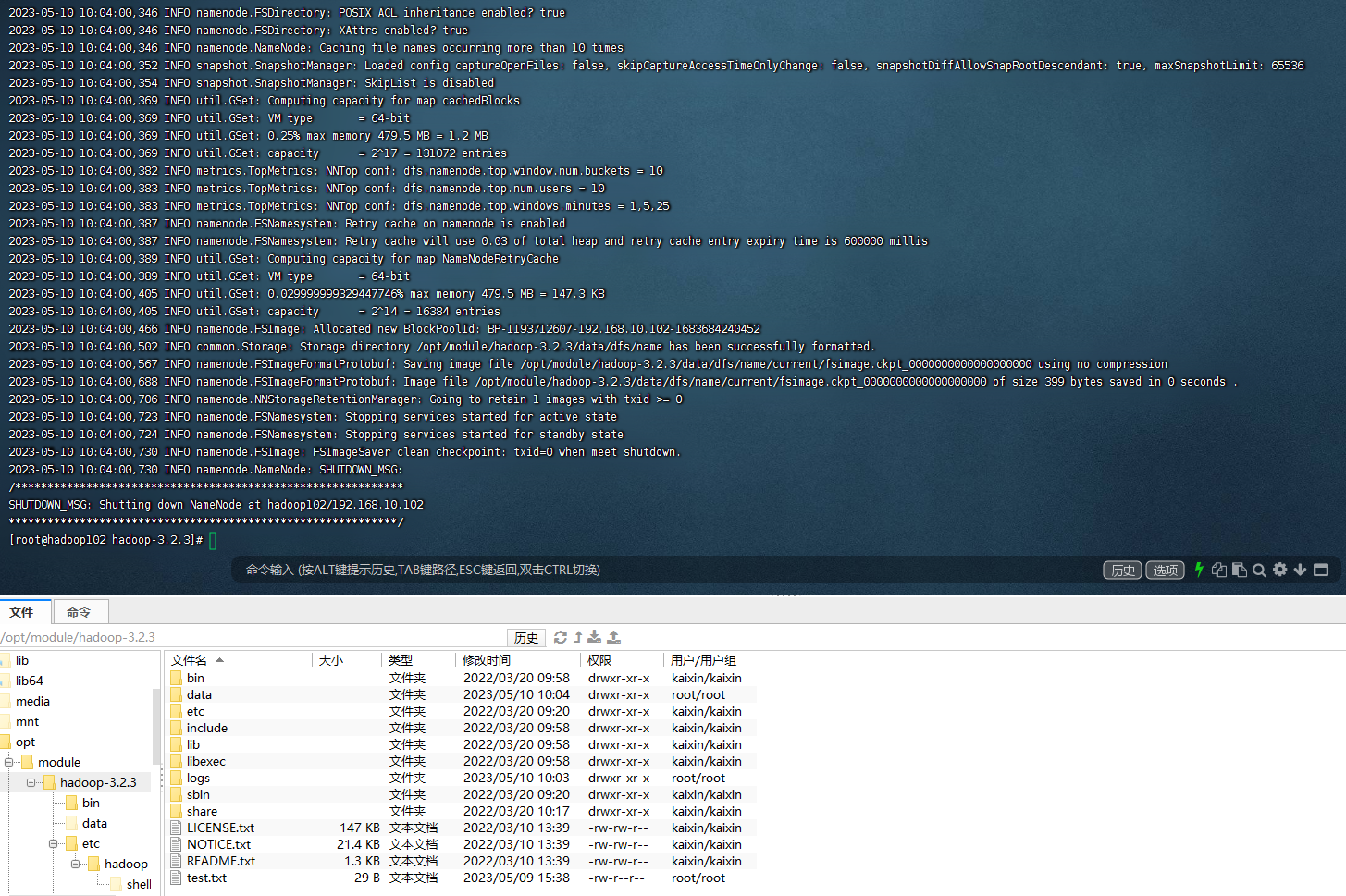

NameNode初始化

根据集群规划,我们的NameNode节点为hadoop102。

如果是第一次启动集群,需要进行初始化操作,在hadoop102节点上格式化NameNode。(类似于电脑新加了一个硬盘,需要给硬盘进行分盘符等初始化操作)

只有第一次启动集群需要进行初始化操作。

如果多次格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到以往数据。如果集群在运行过程中报错,需要重新格式化NameNode的话,一定要先停止NameNode和DataNode的进程,并且要删除所有机器的data和logs目录,然后再进行格式化

注意:需要使用 core-site.xml配置文件中的HFDS用户操作,否则报错。

cd $HADOOP_HOMEhdfs namenode -format

初始化完毕后,会在$HADOOP_HOME文件夹中生成data和logs两个文件夹。

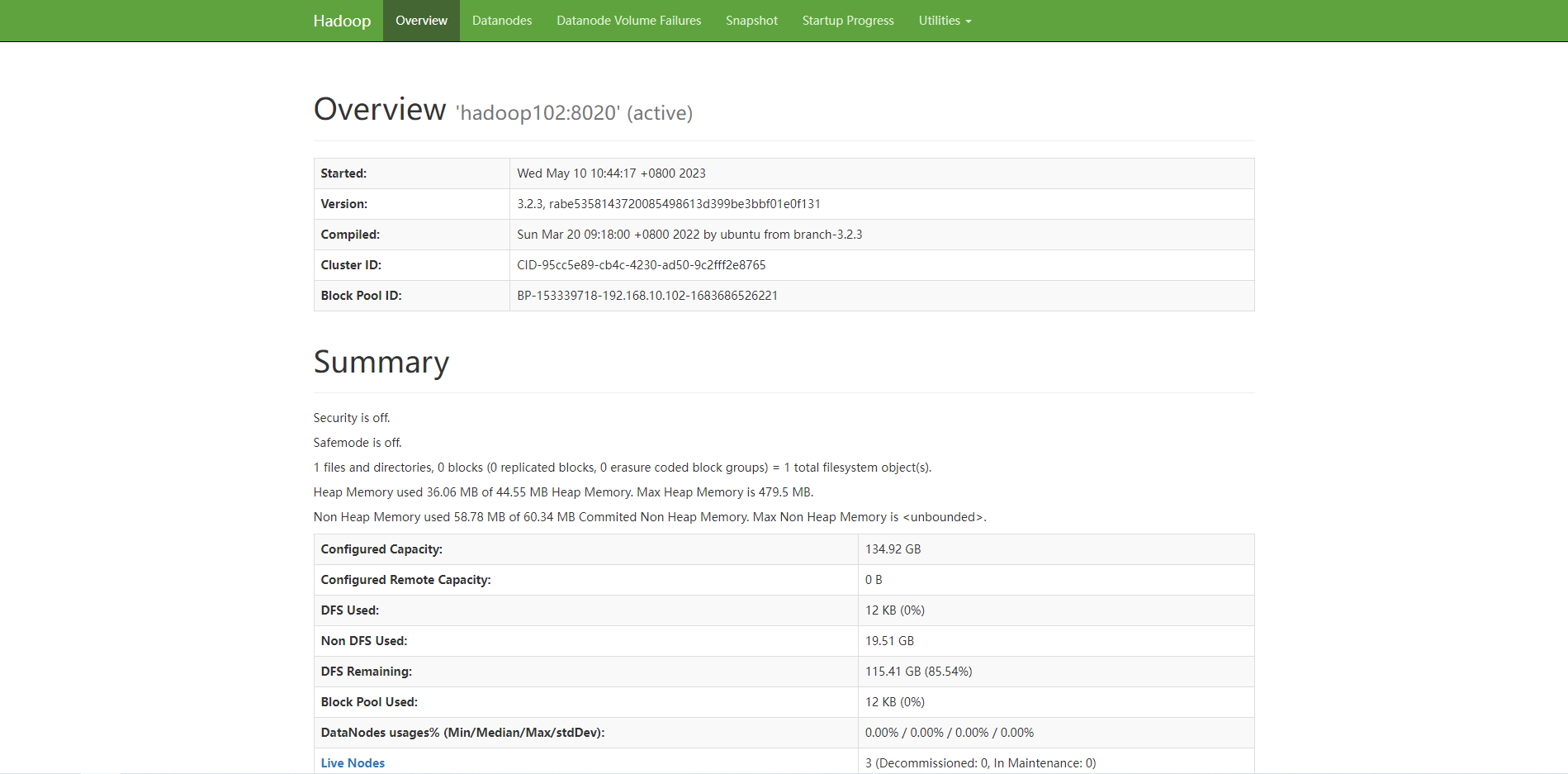

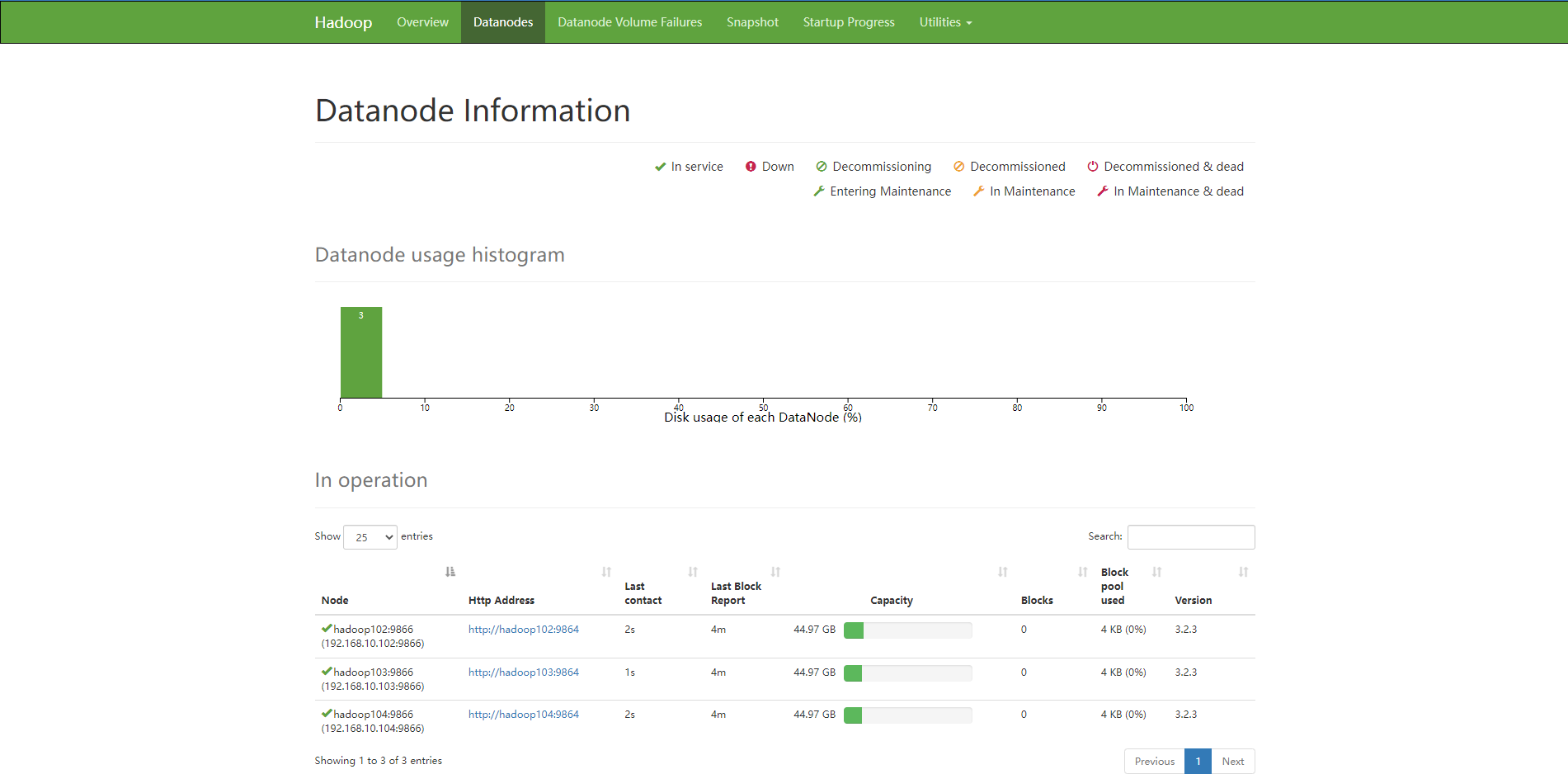

启动HDFS

然后就可以在hadoop102服务器上启动集群:

sbin/start-dfs.sh

启动完毕后,在三台服务器上依次使用jps查看其上面运行的 hdfs 的java进程和集群规划的是否一致。正常情况下,应该为以下形式:

- hadoop102上:jps本身、DataNode、NameNode

- hadoop103上:jps本身、DataNode

- hadoop104上:jps本身、DataNode、SecondaryNameNode

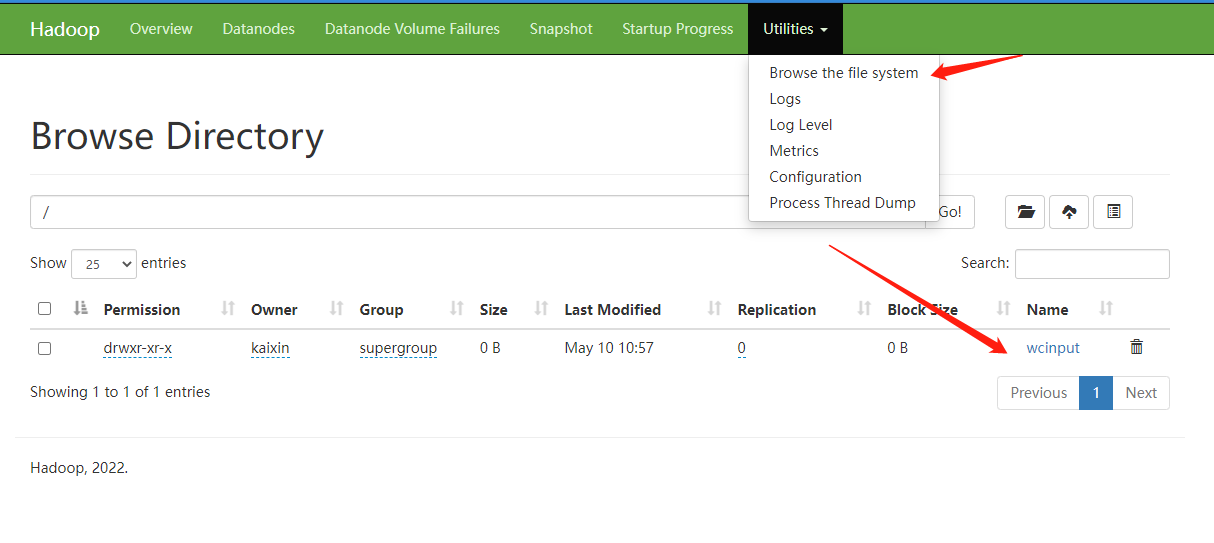

可以使用浏览器访问NameNode(hdfs-site.xml中配置的NameNode暴露的web地址),查看HDFS中的存储数据信息:http://hadoop102:9870

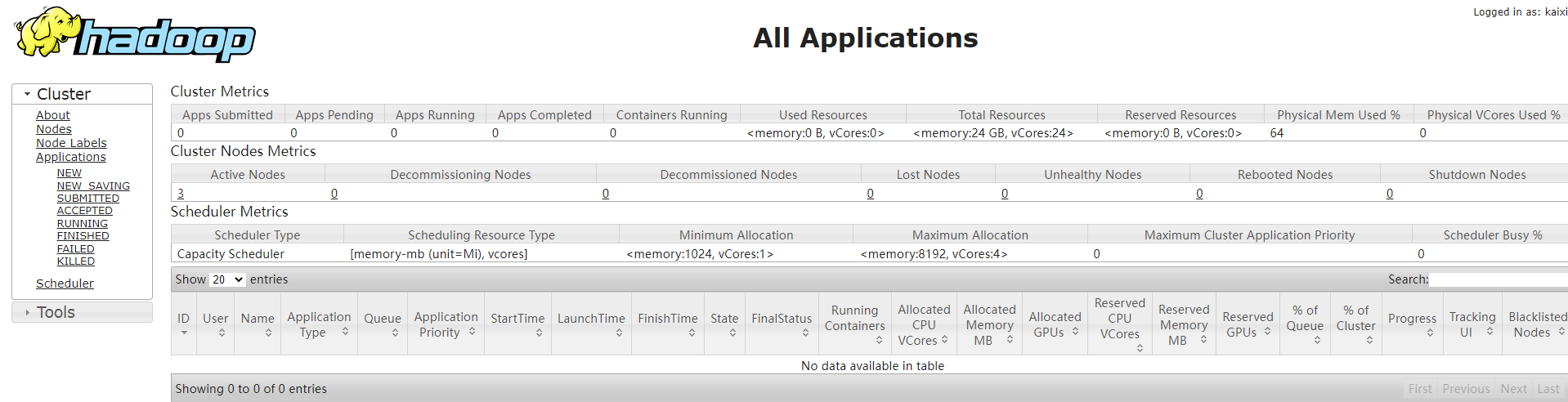

启动YARN

根据集群规划,我们的ResourceManager节点为hadoop103。

在hadoop103上启动YARN:

sbin/start-yarn.sh

启动完毕后,在三台服务器上依次使用jps查看其上面运行的 hdfs、yarn 的java进程和集群规划的是否一致。正常情况下,应该为以下形式:

- hadoop102上:jps本身、DataNode、NameNode、NodeManager

- hadoop103上:jps本身、DataNode、NodeManager、ResourceManager

- hadoop104上:jps本身、DataNode、SecondaryNameNode、NodeManager

可以在浏览器查看Yarn的ResourceManager,查看yarn上运行的jbo信息:http://hadoop103:8088

测试集群运行情况

测试上传文件到集群

上传一个小文件:

# 在Hadoop102服务器上操作# 在hdfs创建一个目hadoop fs -mkdir /wcinput# 将一个文件上传hadoop fs -put test.txt /wcinput

上传之后便可以在NameNode的web页面中进行查看下载,也可以使用命令进行查看和下载:

hadoop fs -ls /wcinputhadoop fs -get /wcinput/test.txt test.tx

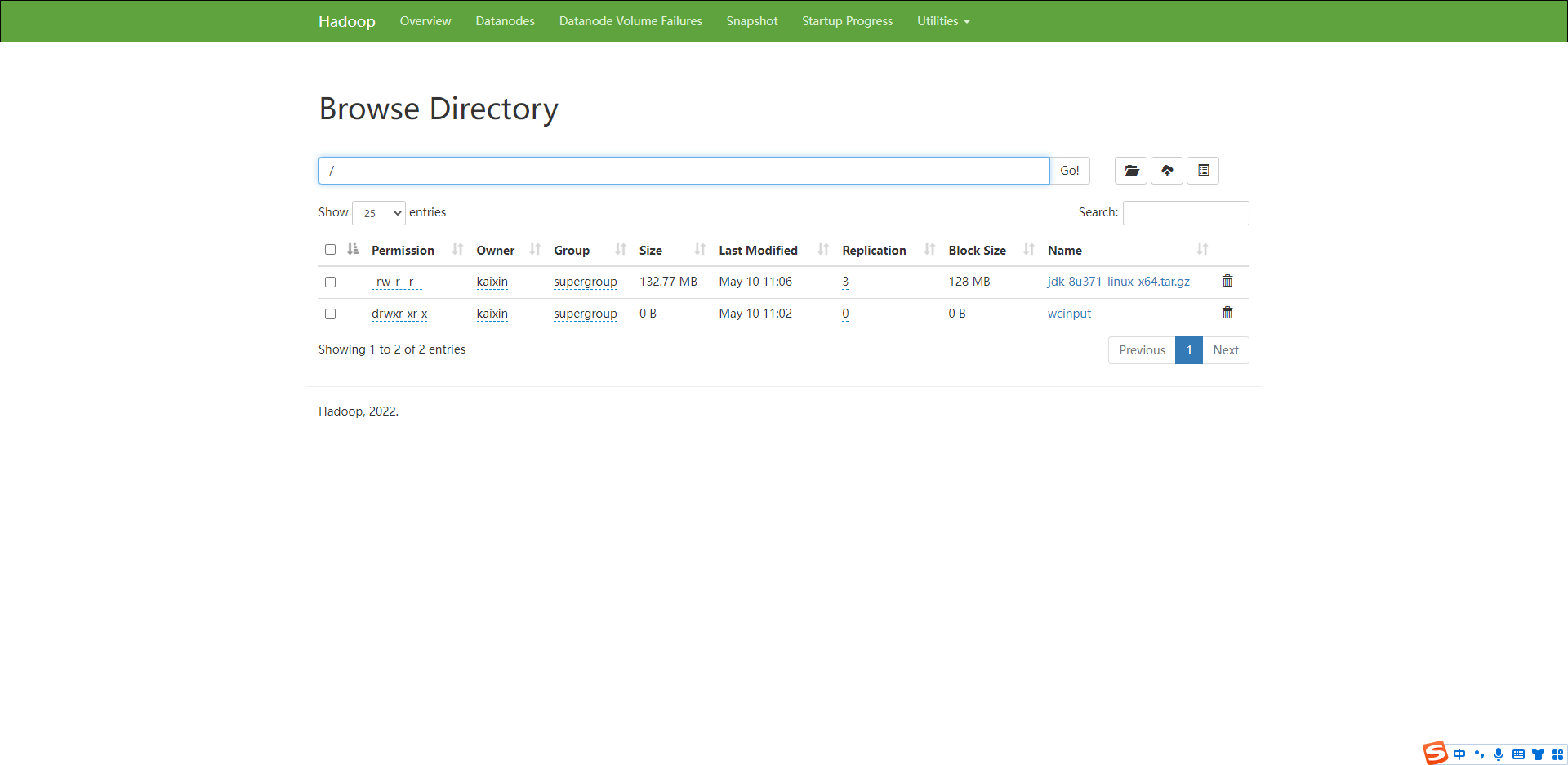

上传一个大文件:

# 将jdk安装包上传到hdfshadoop fs -put /opt/oftware/jdk-8u331-linux-x64.tar.gz /

上传的文件保存在我们在

上传的文件保存在我们在core-site.xml中配置的/opt/module/hadoop-3.2.3/data目录。

因为hadoop上传的文件默认会存储3份进行备份,所以三台服务器上都会保存有刚刚上传的文件,位于:/opt/module/hadoop-3.2.3/data/dfs/data/current/BP-xxxxxxxx/current/finalized/subdir0/subdir0文件夹中。

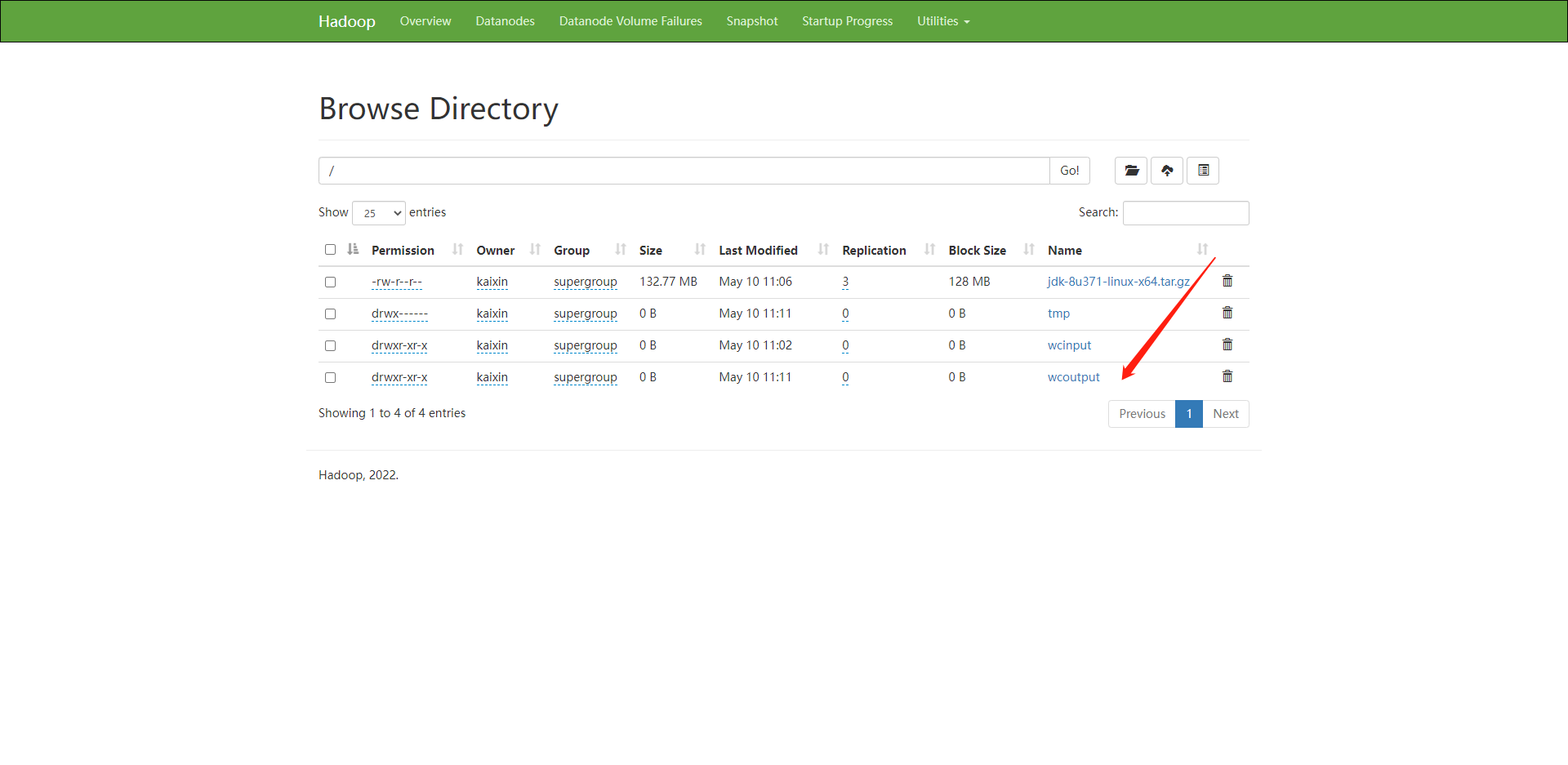

测试Yarn执行wordcount示例程序

在hadoop102上执行Hadoop的wordcount示例程序:

# 统计我们上传导hdfs的 /wcinput/aa.txt中的单词出现次数# 因为我们的core-site.xml中配置的fs.defaultFS不再是local,而是hdfs地址了,所以文件输入路径、结果输出路径应该为hdfs上的路hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.3.jar wordcount /wcinput /wcoutput

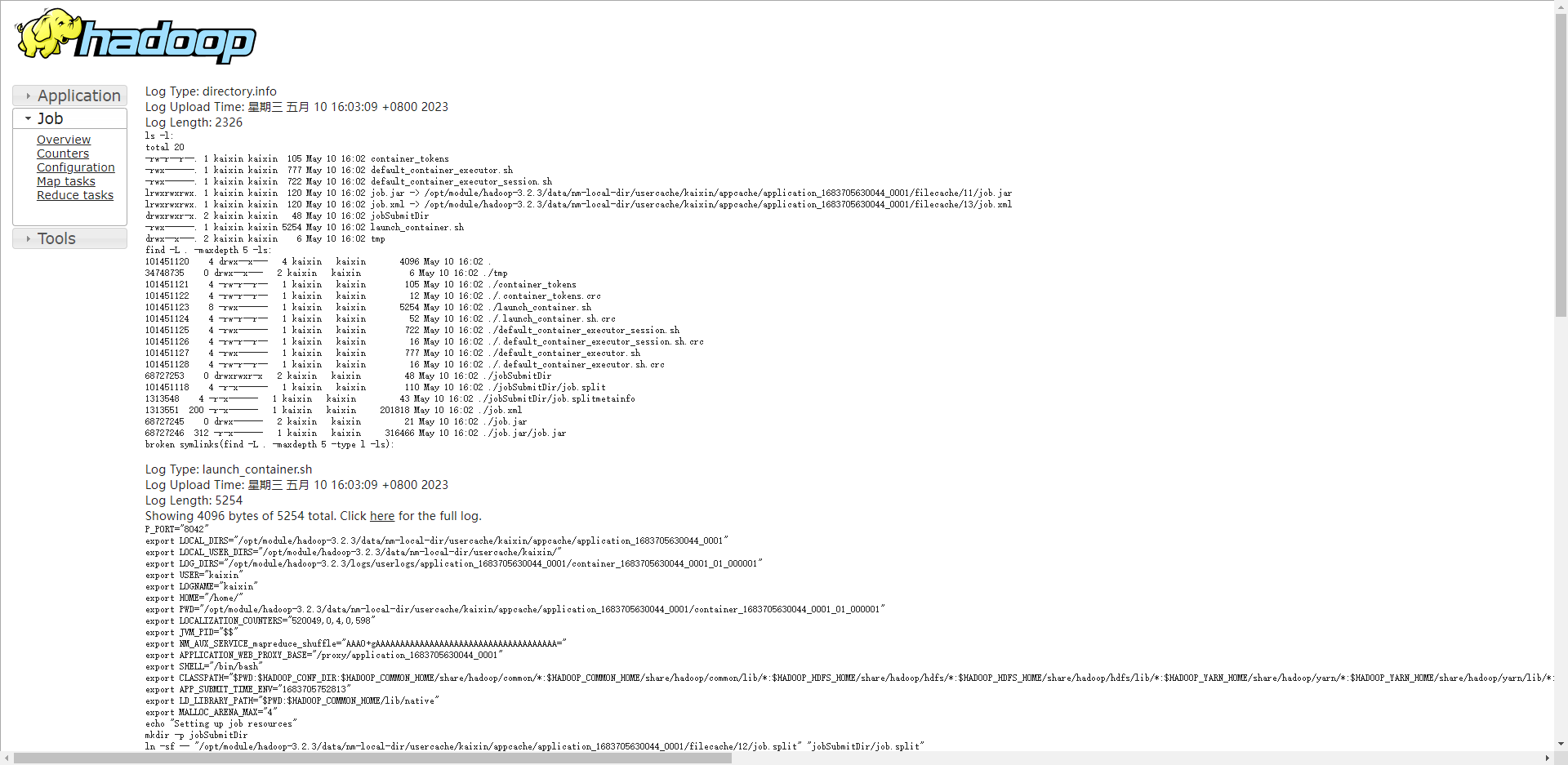

然后通过yarn的web管理页面查看运行的job,可以发现多出来一个正在运行的wordcount任务。

执行完毕后,可以在hdfs上查看到输出的结果/wcoutput/part-r-00000。

执行完毕后,yarn管理页面上的job状态也变为FINISHED。

但是因为我们没有配置历史记录服务器,所以该job后面的History点击出现404。如果没有历史记录服务器,那么yarn无法记录历史job,当前页面展示的 job 信息过段时间就会被清除。

集群崩溃时的处理

集群中如果有服务器 DataNode服务被kill或异常终止了,或者节点的data文件夹被删除了(只删除一两台节点不影响集群,因为hdfs有3个备份,所以需要三台服务器的data都被删掉),此时集群便属于崩溃状态。

如果需要重新格式化NameNode,则可以进行以下操作:

在hadoop103上关闭集群Yarn

sbin/stop-yarn.sh

在hadoop102上关掉集群hdfs

sbin/stop-dfs.sh

删除所有节点上的data、logs文件夹

- 重新进行NameNode格式化

如果不删除所有节点上的data、logs,就直接重启hdfs或者进行NameNode格式化,那么NameNode依然无法启动。hdfs namenode -format

因为两次NameNode格式化产生的namespaceID不同,而namespaceID是和DataNode中的版本号唯一绑定的。如果DataNode中的数据没有被清空,NameNode又格式化产生了新的namespaceID,和DataNode中的版本号无法绑定,就会造成NameNode无法启动。

配置历史服务器

为了查看程序的历史运行情况,需要配置历史服务器。

在hadoop102节点上,修改mapred-site.xml:

<!-- 在configuration标签中加入如下配置 --><!-- 配置历史服务器的内部服务端地址 --><property><name>mapreduce.jobhistory.address</name><value>hadoop102:10020</value></property><!-- 配置历史服务器暴露的web地址 --><property><name>mapreduce.jobhistory.webapp.address</name><value>hadoop102:19888</value></property

将配置信息复制分发到其他服务器:

sh xsync /opt/module/hadoop-3.2.3/etc/hadoop/

在hadoop103节点上重启 Yarn:

sbin/stop-yarn.shsbin/start-yarn.sh

stop-yarn.sh执行时,可能会警告:nodemanager did not stop gracefully after 5 seconds. Trying to kill with kill -9.(NodeManager5秒后如果没有被优雅关闭,尝试使用kill -9杀掉进程),一般情况下都可以被优雅地关闭,无需理会。如果担心没关闭,可以到hadoop102、hadoop104上jps查看下NodeManager有没有被关闭。

因为我们配置了hadoop102为历史服务器,所以需要在hadoop102上启动历史服务器进程:

mapred --daemon start historyserver

启动之后,使用jps查看java进程,可以发现多出来了一个JobHistoryServer进程。

可以在浏览器查看我们的历史服务器信息:http://hadoop102:19888

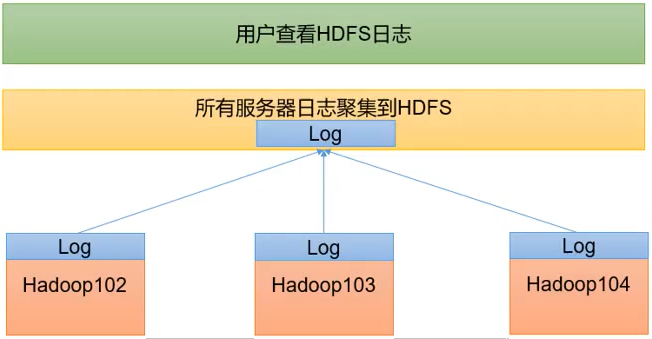

配置日志聚集功能

日志聚集:应用运行完成以后,将程序运行日志信息上传到HDFS系统上。

我们配置的历史服务器虽然可以查看到历史 job 的运行信息,但是如果点击后面的logs链接查看其详细日志,却无法查看,提示Aggregation is not enabled.(日志聚集功能未开启)。

我们开启了日志聚集功能后,可以很方便的查看程序运行详情,方便开发调试。

开启日志聚集功能,需要重新启动 NodeMananger、ResourceMananger、HistoryServer。

在hadoop102节点的yarn-site.xml中加入配置:

<!-- 在configuration中加入以下配置 --><!-- 配置日志聚集功能,yarn-default.xml中该项默认为false --<property><name>yarn.log-aggregation-enable</name><value>true</value></property><!-- 设置日志聚集服务器地址,设置聚集到历史日志服务器上,方便查看 --><property><name>yarn.log.server.url</name><value>http://hadoop102:19888/jobhistory/logs</value></property><!-- 设置日志保留时间:7天 --><property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value></property>

然后分发给其他服务器:

xsync yarn-site.xml

需要重启HistroyServer、Yarn(ResourceManager、NodeManager)。

在hadoop102上停止历史服务器:

mapred --daemon stop historyserver

在hadoop103上重启Yarn:

sbin/stop-yarn.shsbin/start-yarn.s

在hadoop102上启动历史服务器:

mapred --daemon start historyserver

测试:可以删除hdfs上的/wcoutput结果文件夹,然后重新执行wordcount任务:

hadoop fs -rm -f -r /wcoutputhadoop jar share/hadoop/mapreduce/hadoopmapreduce-examples-3.2.3.jar wordcount /wcinput /wcoutput

此时再到http://hadoop102:19888/查看历史任务时,点击logs链接便可以正常查看历史任务日志。

如果未出现,则多等一会,就会看见调度日志。

集群的启停方式总结

整体启动、停止 HDFS:

# 启动hdfs集群sbin/start-dfs.sh# 停止hdfs集群sbin/stop-dfs.s

整体启动、停止 YARN:

# 启动YARN集群sbin/start-yarn.s# 停止YARN集群sbin/stop-yarn.sh

分别启动、停止 HDFS 组件(例如某台DataNode宕机了,需要只将该服务器的DataNode重新启动,无需整个集群重启):

# hadoop 3.x版本命令hdfs --daemon start/stop namenode/datanode/secondarynamenod# 例如:启动 namenodehdfs --daemon start namenode# hadoop 2.x版本命令# hadoop-daemon.sh start/stop namenode/datanode/secondarynamenode

启动、停止YARN组件:

# hadoop 3.x版本命令yarn --daemon start/stop resourcemanager/nodemanage# hadoop 2.x版本命令# yarn-daemon.sh start/stop resourcemanager/nodemanager

Hadoop如果报错了,需要查看启动日志:$HADOOP_HOME/logs文件夹中各个进程的日志

编写常用脚本

编写脚本集中启动、停止:myhadoop.sh

#!/bin/bashif [ $# -lt 1 ]thenecho "No args Input..."exit;ficase $1 in"start")echo "============= 启动hadoop集群 ======================"echo "------------- 启动 hdfs ---------------------------"ssh hadoop102 "/opt/module/hadoop-3.2.3/sbin/start-dfs.sh"echo "------------- 启动 yarn ---------------------------"ssh hadoop103 "/opt/module/hadoop-3.2.3/sbin/start-yarn.sh"echo "---------- 启动 historyserver ----------------------"ssh hadoop102 "/opt/module/hadoop-3.2.3/bin/mapred --daemon start historyserver";;"stop")echo "================ 关闭hadoop集群 =========================="echo "-------------- 关闭historyserver ------------------------"ssh hadoop102 "/opt/module/hadoop-3.2.3/bin/mapred --daemon stop historyserver"echo "---------------- 关闭 yarn ------------------------------"ssh hadoop103 "/opt/module/hadoop-3.2.3/sbin/stop-yarn.sh"echo "---------------- 关闭 hdfs ------------------------------"ssh hadoop102 "/opt/module/hadoop-3.2.3/sbin/stop-dfs.sh";;*)echo "Input Args Error...";;esac

使用脚本进行集群整体的启停:

# 停止整个historyserver、yarn、hdfs集群myhadoop.sh stop# 启动整个hdfs、yarn、historyserver集群myhadoop.sh start

编写脚本,遍历集群中每台服务器调用jps查看上面的java进程启动情况:jpsall

#!/bin/bashfor host in hadoop102 hadoop103 hadoop104doecho ================= $host =================ssh $host jpsdone

执行脚本查看集群所有服务器的java进程情况:

jpsall

将hadoop102上编写好的这两个脚本分发给其他服务器:

xsync jpsall myhadoop.sh

Hadoop常用端口和配置文件

常用端口号不同:

Hadoop 3.x中:

- HDFS NameNode 内部通讯端口:8020/9000/9820

- HDFS NameNode 对用户的web查询端口:9870

- Yarn查看任务运行情况的web页面端口:8088

- 历史服务器对外暴露的web页面端口:19888

Hadoop 2.x中:

- HDFS NameNode 内部通讯端口:8020/9000

- HDFS NameNode 对用户的web查询端口:50070

- Yarn查看任务运行情况的web页面端口:8088

- 历史服务器对外暴露的web页面端口:19888

常用配置文件不同:

hadoop 3.x中:core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml、workers

hadoop 2.x中:core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml、slaves

集群时间同步

如果是虚拟机环境,虚拟机环境可以连接外网,所以不需要配置时间同步。内网服务器才需要配置

如果服务器在公网环境(能连接外网),可以不采用集群时间同步,因为服务器会定期和公网时间进行校准。

如果服务器在内网环境,必须要配置集群时间同步,否则时间久了会产生时间偏差,导致集群执行任务时间不同步。

时间服务器配置,例如以hadoop102作为时间服务器(必须使用root用户进行配置):

- 查看所有节点ntpd服务开启状态和开机自启状态: ```java systemctl status ntpd

如果没启则进行启动

systemctl start ntp

systemctl is-enabled ntpd

2. 修改hadoop102的/etc/ntp.conf配置文件。```java# 授权192.168.29.0-192.168.29.255网段上所有机器都可以从这台机器上查询和同步时间# 找到:Hosts on local network are less restricted. 在下面添加配置restrict 192.168.29.0 mask 255.255.255.0 nomodify notrap

修改hadoop102的/etc/sysconfig/ntpd文件:

# 在文件中添加以下内容,使硬件时间和系统时间一起同步SYNC_HWCLOCK=ye

重启ntpd服务,并设置开机自启:

systemctl restart ntpdsystemctl enable ntp

在hadoop103、hadoop104上使用crontab配置一个定时任务,定时每隔1分钟与时间服务器hadoop102同步一次:

关闭hadoop103、hadoop104节点上的ntp服务,并禁止自启动。

编写crontab表达式,每隔1分钟从hadoop102同步一次时间

*/1 * * * * /usr/sbin/ntpdate hadoop102

测试验证是否生效,修改hadoop103上面的时间为一个任意的错误时间:

date -s "2022-5-1 11:11:11"

1分钟之后,查看hadoop103上的时间是否变为了和hadoop102相同的时间:

date

常见问题解决

Hadoop不显示全部的DataNode节点信息 http://hadoop102:9870/dfshealth.html#tab-datanode

正常情况下,集群启动的DataNode信息都会在网页中展示,如果展示不全,可能存在以下问题:

- 机器的域名hostname不正常,网络不通

- hadoop分发,导致几台的版本配置一样(/opt/module/hadoop-3.2.3/data/dfs/data/current/VERSION 里面的版本一致,正常情况下应该都一样),从而导致的只显示一个Live Nodes的原因。