一、虚拟机的安装

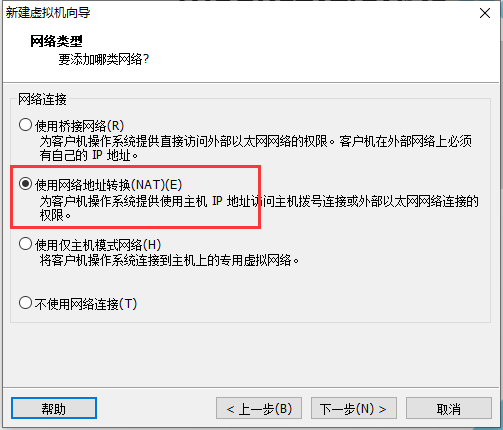

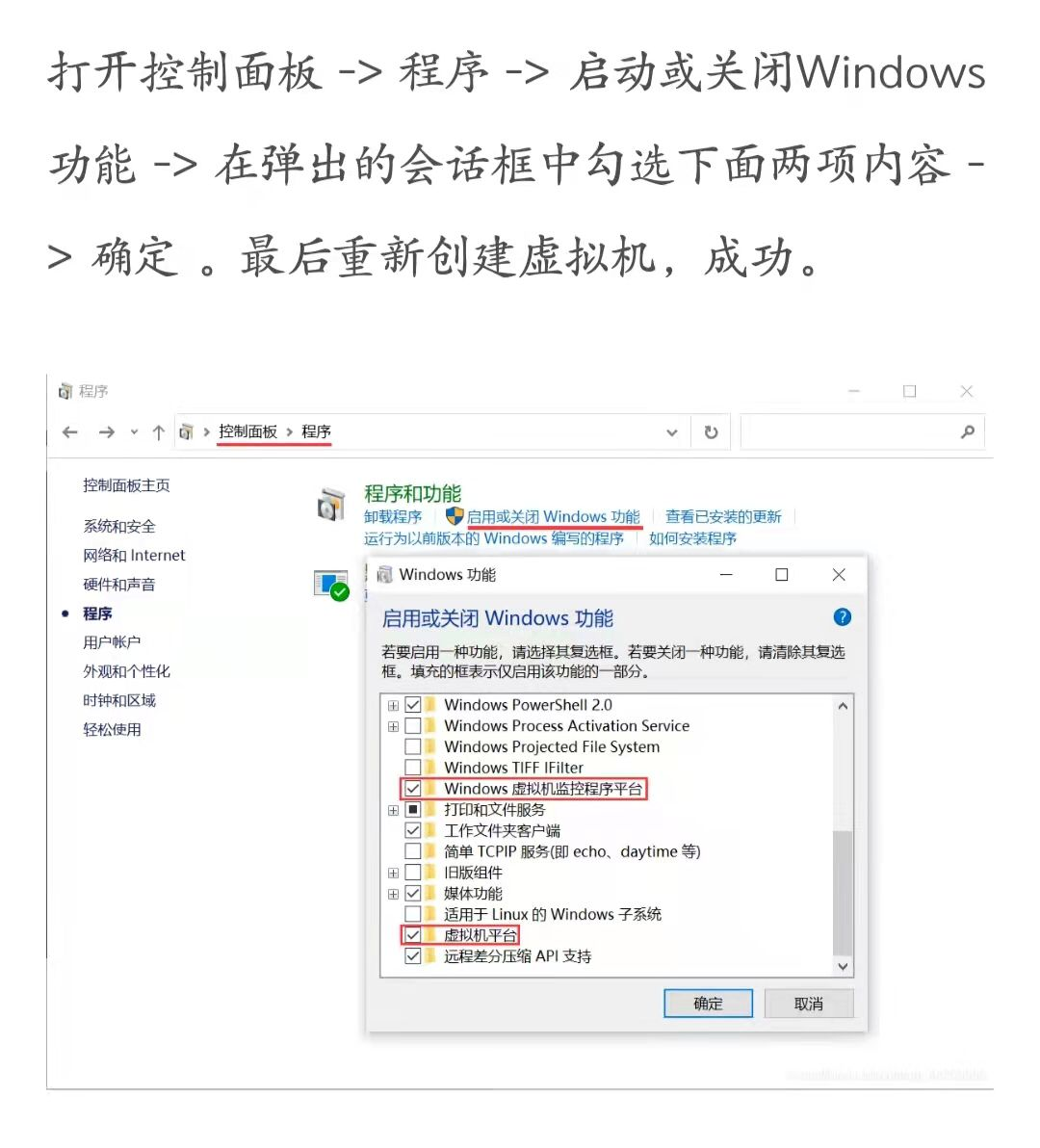

有一些同学出现闪退、或者HyTer-V 不兼容等问题,可以现在最新的VmWare进行安装。

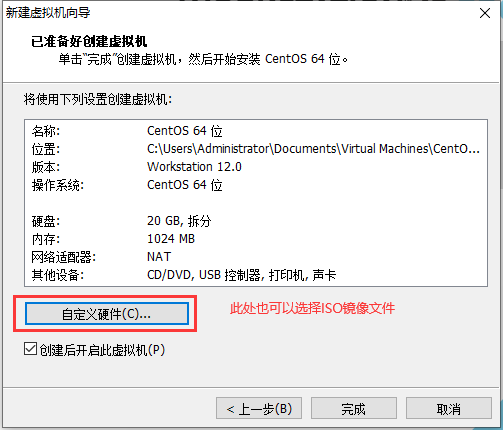

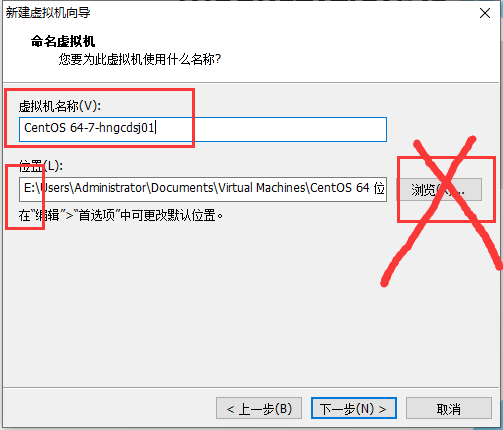

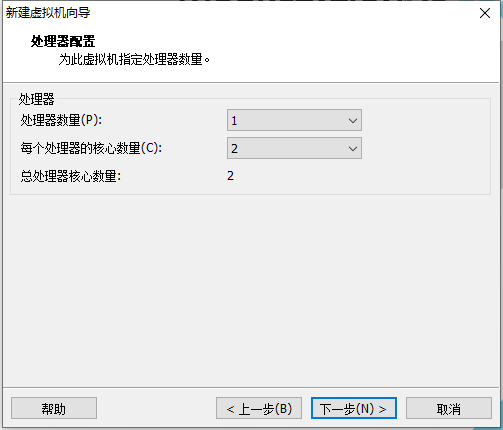

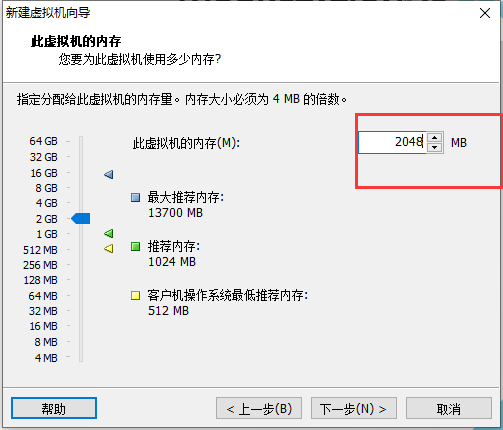

二、CentOS的安装

记得选择镜像文件

如果报虚拟化错误,记得在BIOS操作系统界面开启一下。

安装的时候可以不用选择分区的设置。

中间的一些设置:

如果你的虚拟机安装过程中老黑屏,试试如下设置。

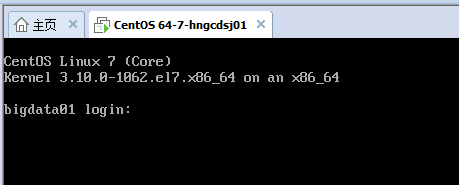

安装成功后,不会出现图形化界面的。

三、讲解远程连接工具的使用

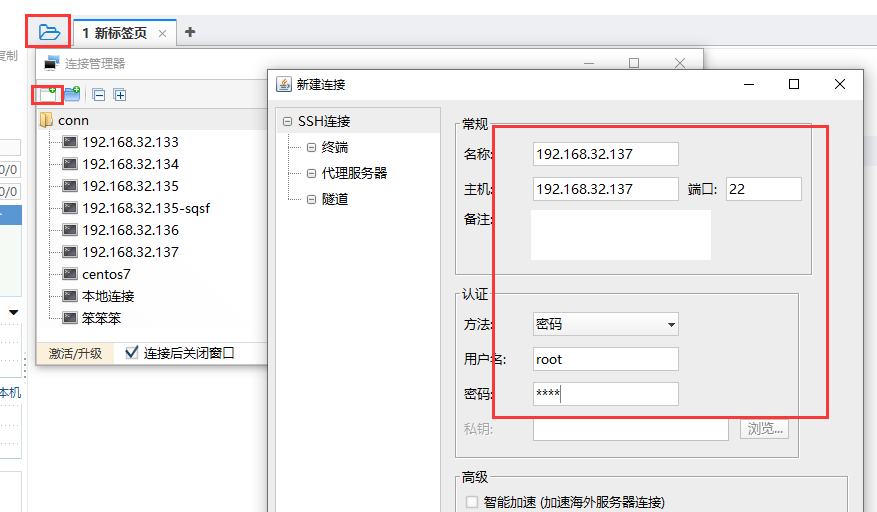

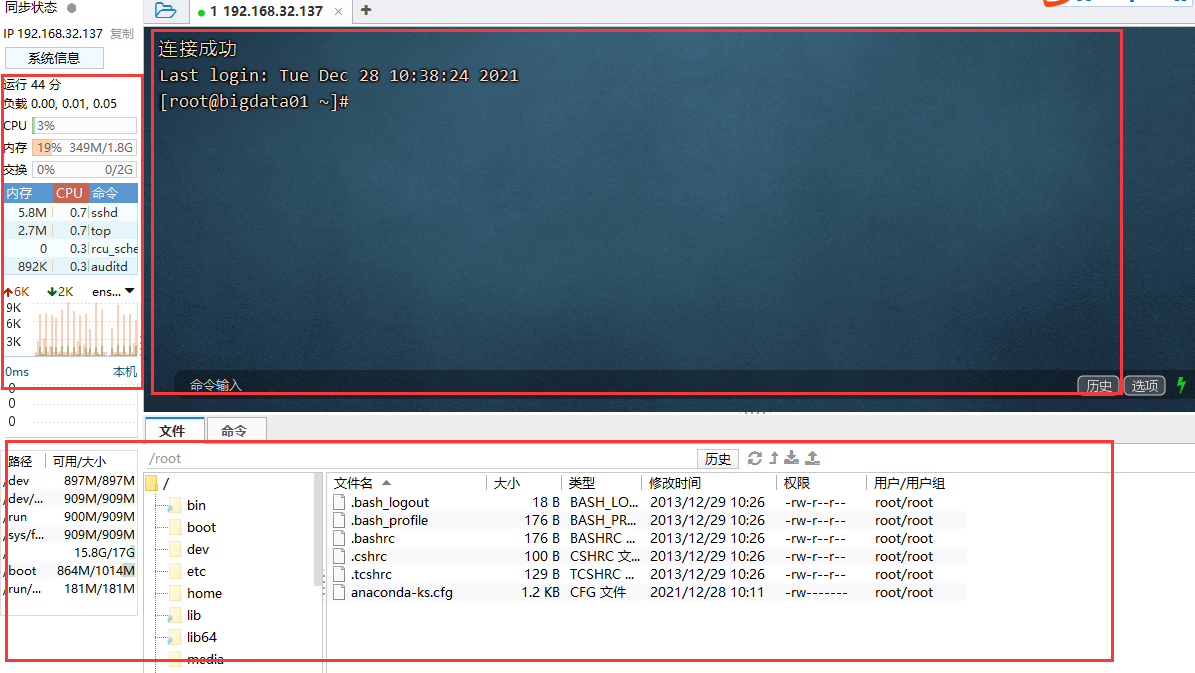

1、通过finalShell 远程连接Linux

FinalShell 可以远程输入Linux的命令操作,类似于Linux的黑窗口

还可以远程将本地的文件上传给Linux,Linux下的文件也可以下载到本地电脑。

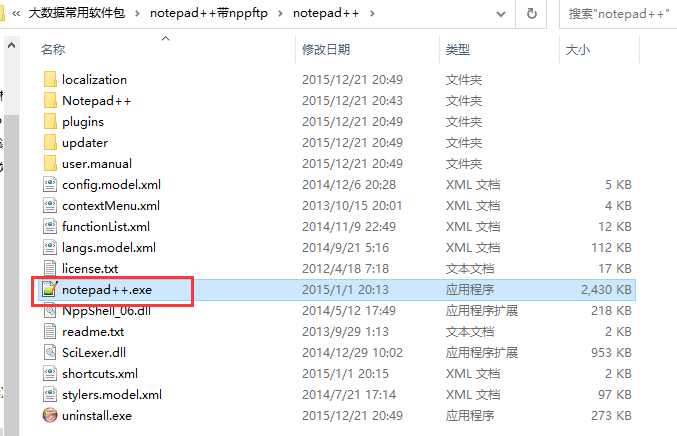

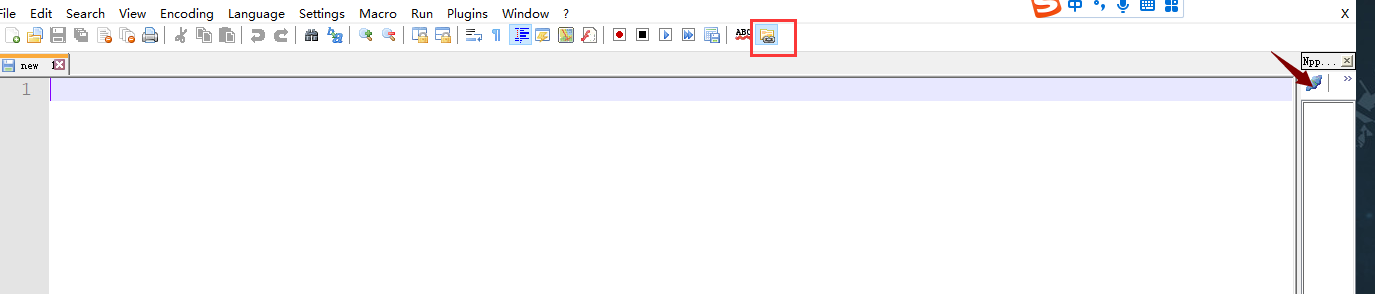

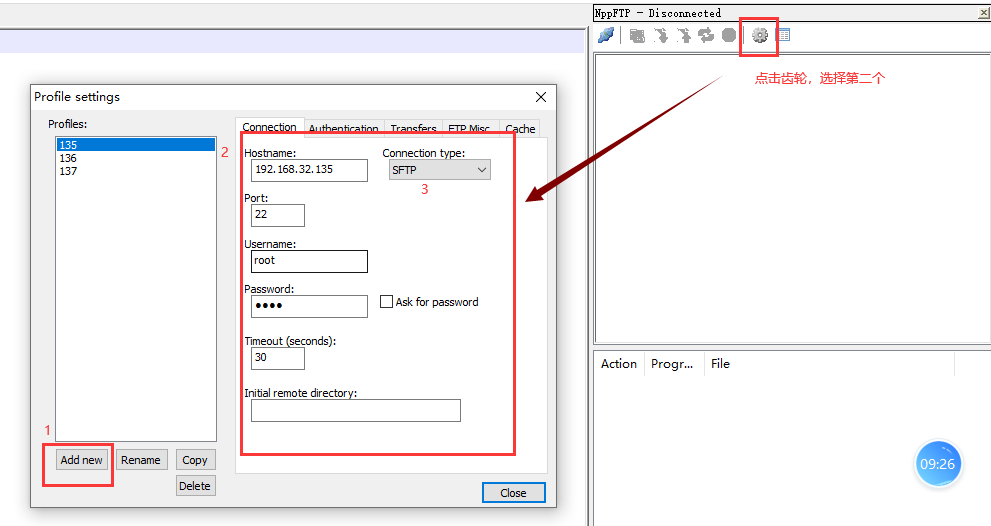

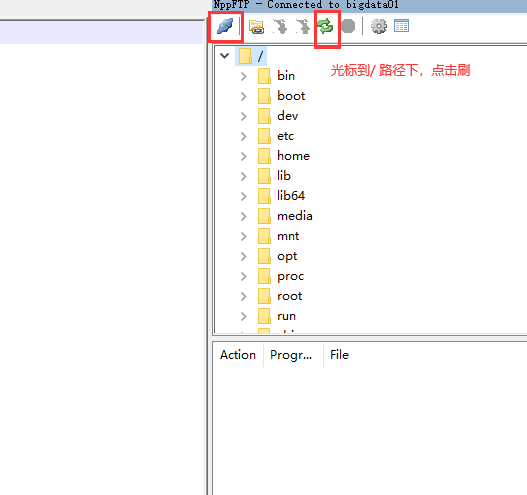

2、通过NodePad++ 远程连接Linux

它只用于操作Linux中的文本文件。

当我需要修改Linux中的任何文本内容的时候,只需要双击就可以修改,修改完之后一定要报错才能上传至Linux.

四、虚拟机进行一些设置

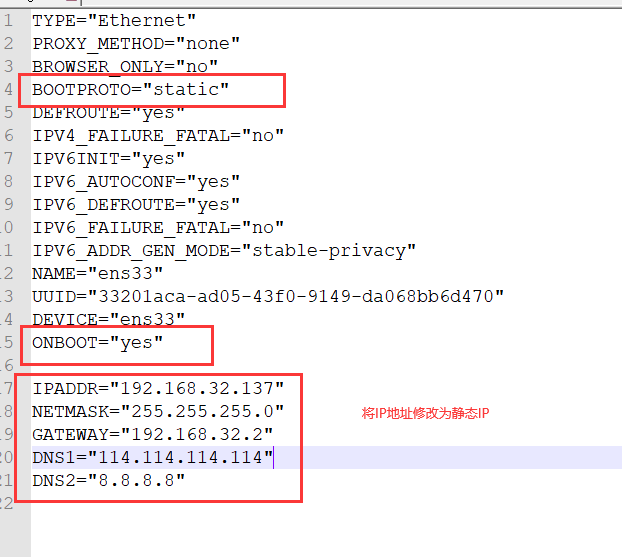

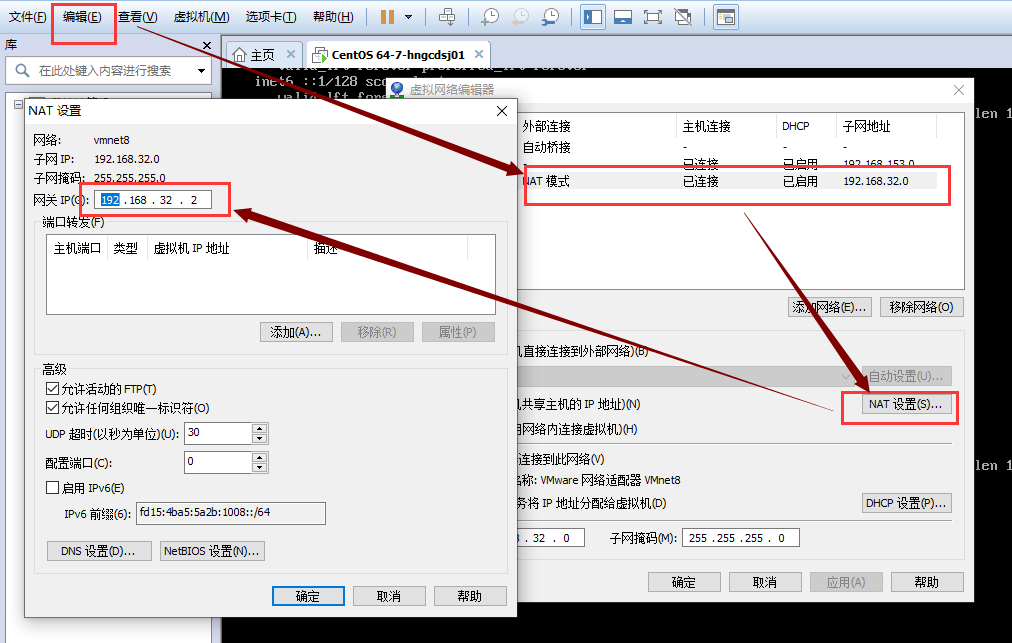

1、设置网络为静态网络

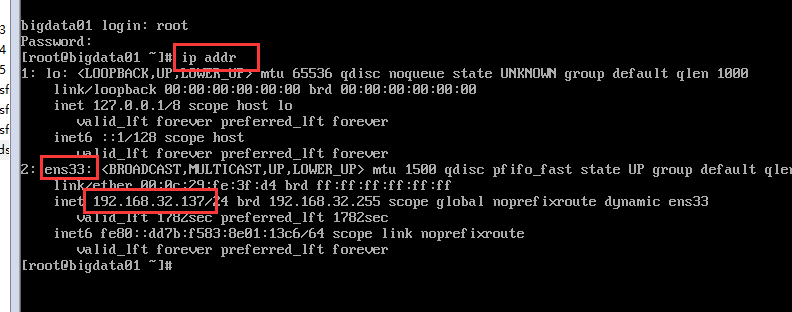

先检查网络是否正常

ip addr 查看网络地址

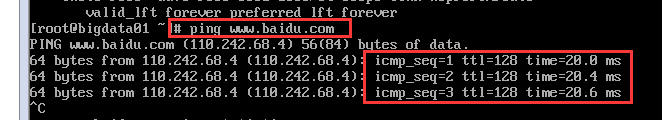

ping www.baidu.com 如果ping的通,说明外网访问也没有问题

设置IP地址为固定IP:

通过修改Linux中的某个配置文件,达到固定IP的作用。

使用nodepad++ 找到 /etc/sysconfig/network-scripts/ifcfg-ens33 这个文件,双击

一定记得不要写错单词,IPADDR 和 GATEWAY 修改成自己的.

为什么是xx.2?

修改完成后,记得重启网卡 : systemctl restart network

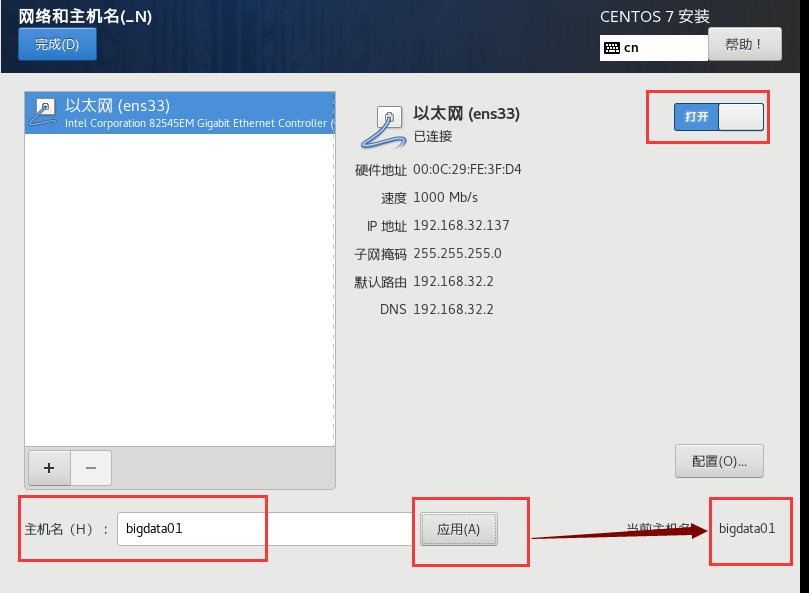

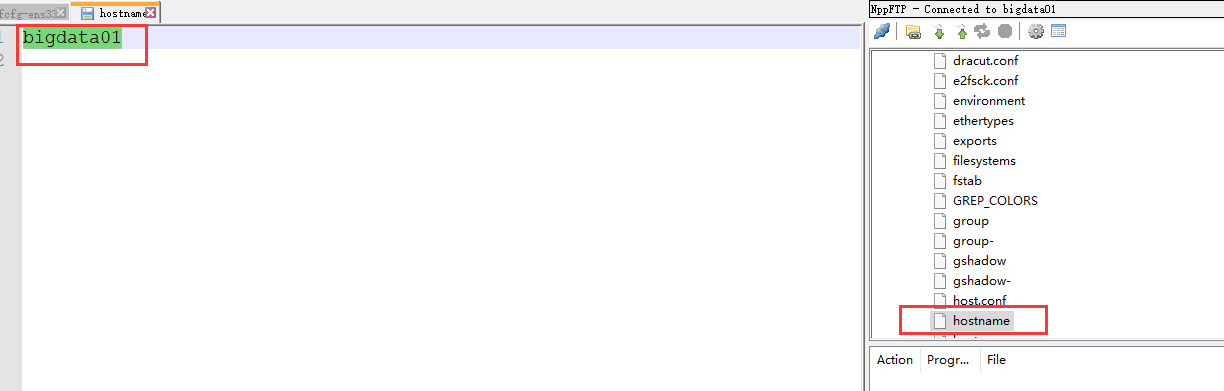

2、设置hostname

1) 查看当前的主机名 hostname<br /> 2) 临时修改主机名 hostname bigdata01<br /> 3) 修改主机名 通过修改文件的形式修改主机名<br /> vi /etc/hostname 进行编辑即可。<br /> 或者使用NodePad++进行修改也可以。<br />

3、关闭防火墙

关闭防火墙<br /> 查看防火墙状态: systemctl status firewalld<br /> 关闭: systemctl stop firewalld <br /> 为了防止下一次重启的时候防火漆再次开启,我们要设置开机不启动: systemctl disable firewalld

4、同步linux的时间

1) date 查看当前时间<br /> 2) 如果时间跟网络上的时间不一致,我们需要进行时间的同步<br /> yum install -y ntpdate 安装软件<br /> ntpdate -u ntp.api.bz 通过该软件进行时间的同步

五、在Linux上安装jdk

1) /root 下创建一个文件夹 software ,便于将来我把需要安装的安装包都先放在此文件夹下。

mkdir software

2)进入到software文件夹下,通过finalshell 将本地的jdk安装包拖拽到 software文件夹下

3)解压jdk

tar -xvf jdk-8u221-linux-x64.tar.gz -C /usr/local

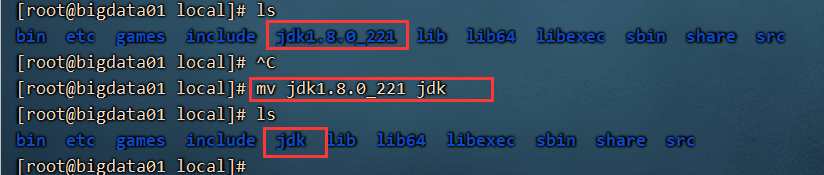

4) 进入到 /usr/local 下查看一下

cd /usr/local/

5) 修改文件名

mv jdk1.8.0_221 jdk

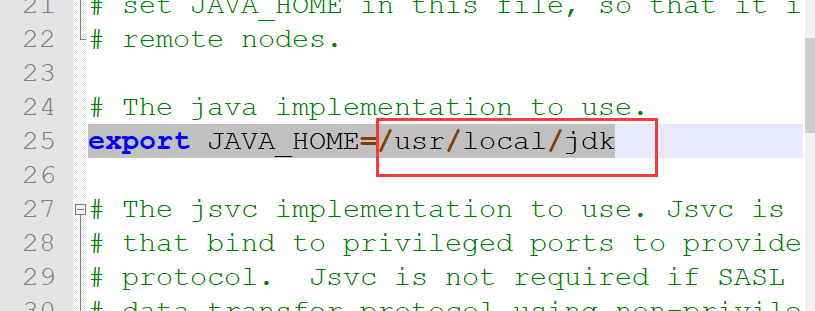

6、进行环境变量的配置

修改 /etc/profile 建议使用nodepad++ 修改

在profile文件的最后,追加以下配置

export JAVA_HOME=/usr/local/jdk

export PATH=$PATH:$JAVA_HOME/bin

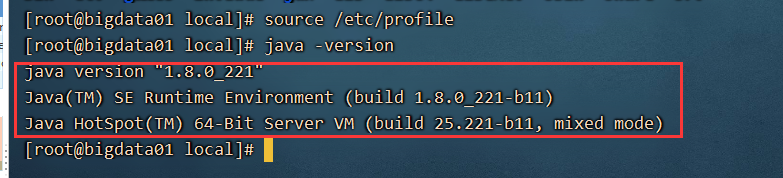

7、刷新一下配置文件 source /etc/profile

8、验证jdk是否安装成功 java -version

六、Linux安装Hadoop

1、将Hadoop 的安装包,上传到 /root/software下

2、解压该安装包到 /usr/local/

tar -xvf hadoop-2.7.6.tar.gz -C /usr/local

3、修改hadoop 的文件夹名字 mv hadoop-2.7.6 hadoop

4、配置环境变量 修改 /etc/profile

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

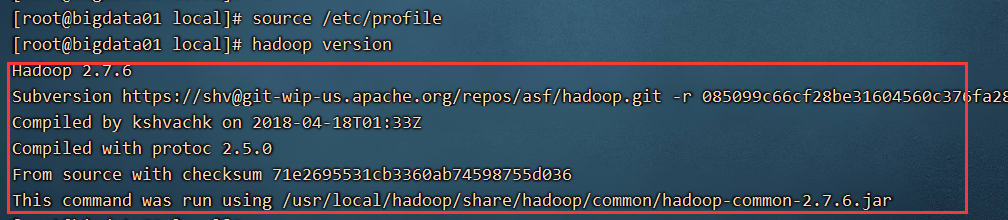

5、刷新一下配置文件 source /etc/profile

6、验证配置是否生效

hadoop version

七、跑一个wordcount 案例

1、hadoop 环境安装好之后,创建三个文本文件 a.txt b.txt c.txt 存放在 /home/input 下

2、运行hadoop 自带的wordcount案例jar包

hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.6.jar wordcount /home/input/ /home/output/

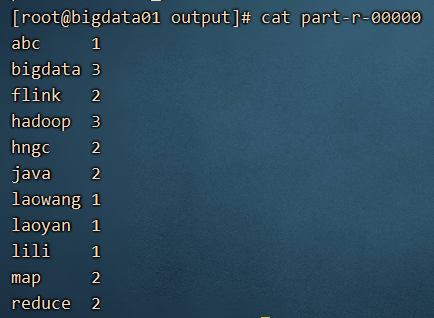

3、查看执行结果 ,进入/home/output 下 ,查看 cat /home/output/part-r-00000 这样一个统计的结果

八、搭建大数据平台

1、伪分布式搭建 —> 伪分布式搭建,步骤完全按照分布式进行搭建,但是电脑只有一台,所有叫伪分布式搭建

准备工作:

1) 修改 /etc/hosts文件

192.168.32.137 bigdata01

192.168.32.138 bigdata02

192.168.32.139 bigdata03

2)免密登录需要做好(为了将来搭建全分布式环境,电脑之间传递数据时方便)

ssh-keygen -t rsa 生成公钥和私钥,生成的公钥和私钥存放在 .ssh 文件夹下

ssh-copy-id root@localhost 通过该命令将产生的公钥拷贝到指定电脑上。

ssh 需要连接的IP(hostname) 就可以连接上。

开始进行伪分布平台的搭建: /usr/local/hadoop/etc/hadoop/ 此文件夹下是hadoop的配置文件

1、修改core-site.xml

<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:8020/</value></property></configuration>

2、修改hdfs-site.xml

<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>

3、修改hadoop-env.sh

4、namenode 的格式化

hdfs namenode -format

中间不能有任何的错误,格式化不成功,需要仔细看日志

5、启动hdfs start-dfs.sh

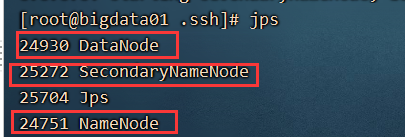

6、通过 jps 查看进程,如果出现三个,说明正确

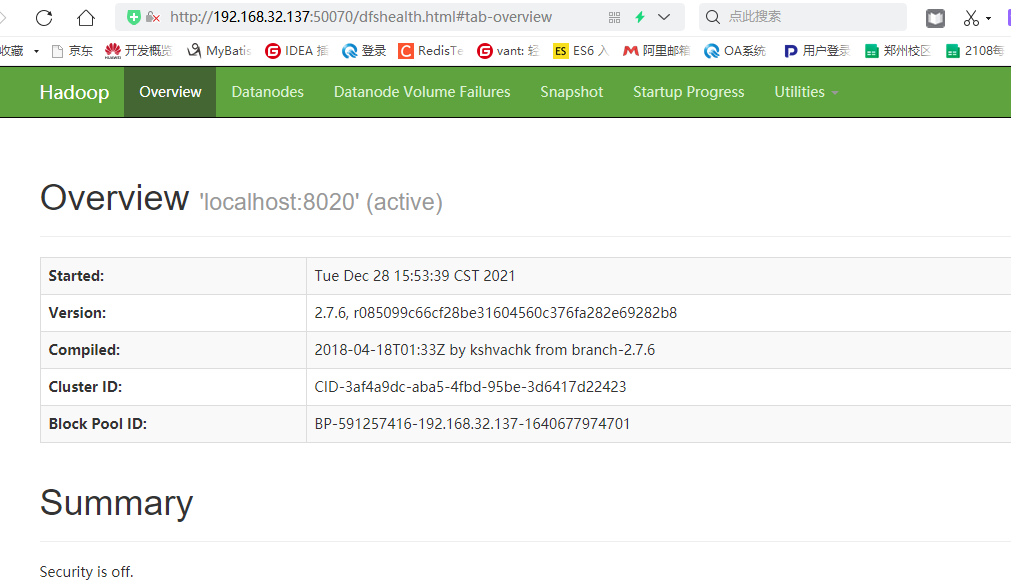

7、通过浏览器可以查看图形化界面 http://192.168.32.137:50070

2、全分布式项目搭建

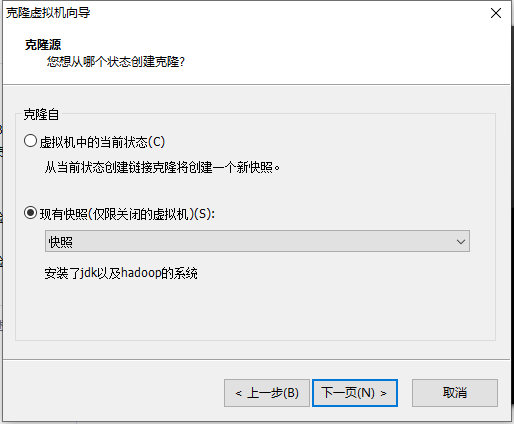

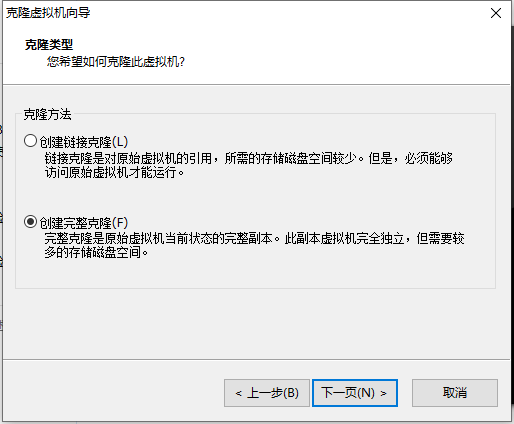

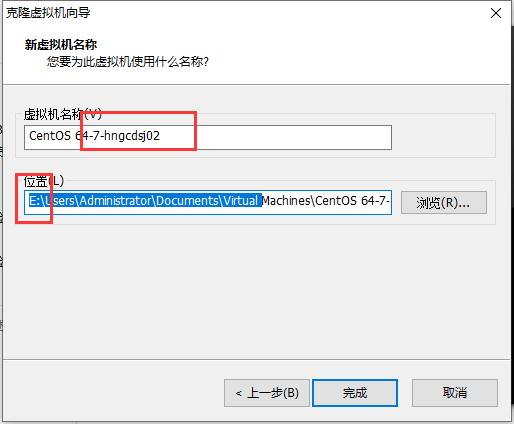

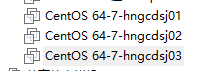

如果我们是从伪分布式环境过渡多来的话,需要先进行一些处理。<br /> 1) 停止hdfs stop-dfs.sh<br /> 2) 删除namenode datanode 的临时文件夹<br /> /tmp/hadoop-root<br /> 删除里面的全部内容 rm -rf /tmp/hadoop-root/*<br /> 操作完成后,将虚拟机停止,进行快照,并且克隆两份<br /> 先进行快照,选中虚拟机,右键,选择快照即可。<br /><br /><br /><br /><br />克隆出来的系统跟原来的系统是一模一样的。<br />我们需要修改如下内容:<br />1、需要修改IP地址<br /> 需要将两台服务器,启动起来,通过vi 编辑器修改IP<br />vi /etc/sysconfig/network-scripts/ifcfg-ens33<br />修改里面的ipaddr 保存即可。<br />2、hostname 也一模一样<br /> vi /etc/hostname 或者使用hostnamectl set-hostname 名称