- 第一章 小滴课堂-海量数据处理商用短链平台大课介绍

- 第二章 不在其位要谋其政,技术Leader能力模型提升

- 第三章 商用短链平台介绍和技术Leader常用方法论介绍

- 按照依赖

- 配置yum源(比较慢,不用)

- 配置yum源 使用国内的

- 查看版本

- 1. 安装docker

- 2. 查看docker版本

- 3. 启动docker

- 4. 查看docker 启动状态

- 改为下面内容,然后重启docker

- 查看信息

- 安装mysql8,让容器使用宿主机的时间,容器时间与宿主机时间同步

- Mysql工具连接测试

- 连接数配置

- 第六章 短链平台项目创建+git代码管理+开发分层规范讲解

- 第七章 商用短链平台实战-账号微服务+流量包设计

- —————sms短信配置———————

- 第十二章 账号微服务-阿里云OSS接入实战

- 阿里云OSS配置

- 数据源 ds0 第一个数据库

- 指定traffic表的数据分布情况,配置数据节点,行表达式标识符使用 ${…} 或 $->{…},但前者与 Spring 本身的文件占位符冲突,所以在 Spring 环境中建议使用 $->{…}

- 水平分表策略+行表达式分片

- id生成策略

- id生成策略

- —————服务注册和发现———————

- ———-redis连接配置———-

- ———-分库分表数据源配置———-

- 指定traffic表的数据分布情况,配置数据节点,行表达式标识符使用 ${…} 或 $->{…},但前者与 Spring 本身的文件占位符冲突,所以在 Spring 环境中建议使用 $->{…}

- 水平分表策略+行表达式分片

- id生成策略

- —————sms短信配置———————

- —————阿里云OSS配置———————

- —————短链组,策略:水平分库,不水平分表———————

- 先进行水平分库, 水平分库策略,行表达式分片

- ds0配置

- ds1配置

- dsa配置

- —————短链,策略:分库+分表———————

- 先进行水平分库,然后再水平分表

- 水平分表策略,自定义策略。 真实库.逻辑表

- id生成策略

- —————配置默认数据库,比如短链域名,不分库分表———————

- 默认id生成策略

- 第二十五章 短链服务冗余双写-链路测试和异常消息处理实战

- 第二十六章 短链服务冗余双写问题抛出-MQ消费者链路开发

- 第二十七章 短链码生成端选择和Lua分布式锁实战

- 第二十八章 短链服务-冗余双写B端分库分表和链路测试

- 第二十九章 短链服务-冗余双写架构删除和更新开发实战

- 第三十章 短链服务-冗余双写架构删除和更新消费者开发实战

- 第三十一章 流量包商品服务需求和库表讲解

- 第三十二章 流量包订单模块需求讲解和库表介绍

- 第三十三章 流量包商品服务-下单模块开发和订单防重提交

- 第三十四章 流量包商品服务-多场景自定义注解防重提交实战

- 第三十五章 下单接口-超时关闭订单功能设计+延迟队列实战

- 第三十六章 短链平台-从0教你掌握微信支付-最新V3版-准备阶段

- 第三十七章 密码安全-对称加密和非对称加密技术你知道多少

- 商户号

- 公众号id 需要和商户号绑定

- 商户证书序列号,需要和证书对应

- api密钥

- 商户私钥路径(微信服务端会根据证书序列号,找到证书获取公钥进行解密数据)

- 支付成功页面跳转

- 支付成功,回调通知

- —————kafka配置———————

- —————服务注册和发现———————

- 设置日志级别,ERROR/WARN/INFO/DEBUG,默认是INFO以上才显示

- 1.先安装yml

- 2.设置阿里云镜像

- 3.查看可安装的docker版本

- 4. 安装docker

- 5. 查看docker版本

- 6. 启动docker

- 7. 查看docker 启动状态

- 查看端口占用命令安装

- 1.先安装yml

- 2.设置阿里云镜像

- 3. 安装docker

- 4. 查看docker版本

- 5. 启动docker

- 6. 查看docker 启动状态

- 1.先安装yml

- 2.设置阿里云镜像

- 3. 安装docker

- 4. 查看docker版本

- 5. 启动docker

- 6. 查看docker 启动状态

- 这条配置表示开启xpack认证机制

- 创建目录

- 宿主机权限不够

- 启动运行

- —————服务注册和发现———————

- 用于rpc调用token验证

- ———-redis连接配置———-

- ———-分库分表数据源配置———-

- 指定traffic表的数据分布情况,配置数据节点,行表达式标识符使用 ${…} 或 $->{…},但前者与 Spring 本身的文件占位符冲突,所以在 Spring 环境中建议使用 $->{…}

- 水平分表策略+行表达式分片

- id生成策略

- —————sms短信配置———————

- —————阿里云OSS配置———————

- 需要手工创建虚拟主机

- 消息确认方式,manual(手动ack) 和auto(自动ack); 消息消费重试到达指定次数进到异常交换机和异常队列,需要改为自动ack确认消息

- 开启重试,消费者代码不能添加try catch捕获不往外抛异常

- 最大重试次数

- 重试消息的时间间隔,5秒

- —————xxl-job配置———————

- http://address01,http://address02“">调度中心部署地址,多个配置逗号分隔 “http://address01,http://address02“

- 执行器token,非空时启用 xxl-job, access token

- 执行器app名称,和控制台那边配置一样的名称,不然注册不上去

- [选填]执行器注册:优先使用该配置作为注册地址,为空时使用内嵌服务 ”IP:PORT“ 作为注册地址。

- 从而更灵活的支持容器类型执行器动态IP和动态映射端口问题。

- [选填]执行器IP :默认为空表示自动获取IP(即springboot容器的ip和端口,可以自动获取,也可以指定),多网卡时可手动设置指定IP,该IP不会绑定Host仅作为通讯实用;地址信息用于 “执行器注册” 和 “调度中心请求并触发任务”,

- [选填]执行器端口号:小于等于0则自动获取;默认端口为9999,单机部署多个执行器时,注意要配置不同执行器端口;

- 执行器日志文件存储路径,需要对该路径拥有读写权限;为空则使用默认路径

- 执行器日志保存天数

- 应用名称

- 服务注册发现

- 设置日志级别,ERROR/WARN/INFO/DEBUG,默认是INFO以上才显示

- 启动

- 重新加载配置文件

- 1.打开文件

- 2.添加环境变量

- 3.编译生效

- 1.捕获网络流量,表示监听80端口发生的所有网络活动记录到stdout

- 2.重放,将原始流量重放到其他环境中,同一个服务器但是端口不同,多个亦可

- 3.捕抓流量请求并保存到文件中,实际会保存为requests.gor文件名

- 4.从保存下来的流量文件中提取流量向某个端口输出

- 5.请求过滤指定路径流量,使用该机制,只记录/account-server/api路径下的请求

- 流量录制的监听命令

- —input-file 从文件中获取请求数据,重放的时候5倍速度重放; 比如10秒20条请求,扩大2倍后就是5秒就跑完20条请求

- —input-file-loop 无限循环,而不是读完这个文件就停止

- http://xdclass.net">—output-http 发送请求到 http://xdclass.net

- —stats —output-http-stats 每 5 秒输出一次 TPS 数据

- 查看当前连接数

- 查看最大连接数

- 查看连接睡眠时间,默认是 28800,相对较少调整这个,不能太短,也不能过长;

- 代码封装

- 第八十章 海量数据项目大课-商用短链平台总结

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第一章 小滴课堂-海量数据处理商用短链平台大课介绍

第1集 海量数据处理商用短链平台大课介绍

简介:海量数据处理商用短链平台大课介绍

- 课程核心介绍

- 目标岗位能力说明

- 适合人员

第2集 商用短链平台技术栈介绍和观看形式-更新周期

简介:商用短链平台技术栈介绍和观看形式-更新周期

第3集 海量数据处理商用短链平台项目核心亮点《上》

简介:海量数据处理商用短链平台项目亮点《上》

第4集 海量数据处理商用短链平台项目核心亮点《下》

简介:海量数据处理商用短链平台项目亮点《下》

第5集 大课解决的问题和跳槽职业发展规划

简介:大课解决的问题和跳槽职业发展规划

第6集 大课疑惑解答+学习准备

简介:大课疑惑解答+学习准备

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第二章 不在其位要谋其政,技术Leader能力模型提升

第1集 互联网大厂里 技术Leader的能力模型-不单写代码

简介:职级的能力模型,不要只顾自己的一亩三分地

前言先说

- 可能同学到现在都不知道【商用短链平台】是什么,没关系,后续讲完前面几章我们就开始了

- 前面几章是讲 产品方法论,就是技术Leader需要掌握的内容

不管你是否校招、社招、工作5到10年的人

- 不要说【二当家小D】瞎扯淡!!!不讲技术只讲虚幻的

- 我需要给大家打个强心剂!!!!

- 大课软硬技能都有,但是层级高的或者野心大的,就必须学

【不画大饼】看我们课程不会让你成为CTO、阿里P7、P8

- 课程让你成为CTO、阿里P7、P8的助力器,

- 我很鼓励团队的人进行充电,不管是线上还是线下

始终相信

- 量变->质变,没量变的人,是不可能有质变的

- 光输出不输入,你觉得能成长多少

浅谈Leader的好处和坏处

当leader好处

- 待遇高、股票、奖金

- 接触面、圈子广

- 软技能多方面提升

当leader坏处

- 多数是晚上才能安心写代码

- 背负团队KPI:技术+业务

- 操心事多

你上司为啥是你上司?(也就是大家需要提升的方向,并非一朝一夕,而是先有意识,然后不断积累)

- 能力模型

多个能力汇总起来就是商业化产品构建能力,负责业务产品线一号位的能力

- 帮企业找到新的盈利方向

- 商业模式(外) × 发展空间(外) × 核心壁垒(内) × 企业文化(内)

接下去重点教大家《产品+运营》这块的能力,然后为啥需要这能力,就不会觉得虚幻了

掌握这些能力的好处多多!!!!!

如果选一个好的公司,进公司如何转岗去一个好的部门-》发现能力

知道未来1~3年哪些方向好,万一站在风口上是吧,薪资待遇、股票期权

- 蚂蚁的一个同事:虽然是P7,但是第一批员工,如果蚂蚁上市-据说是整层楼最有钱的了

避免进入错的方向:公司倒闭、裁员、发不出工资

技术Leader的必备能力

- 公司技术产品的研发,比如算法平台、DevOps平台、规则引擎等

第2集 技术人的产品运营能力提升-竞品分析

简介:竞品分析-入职-提升-运营能力

什么是竞品分析

- 竞品:竞争对手的产品,叫竞品

- 分析:对这些收集的竞品加以分析,从而对自己的产品设计产生帮助

为什么要做竞品分析

- 熟悉产品

利用现有的商业模式去改进

- 抖音、视频号

- 拼多多、淘宝特价版(明星部门重要性-同事转岗去特价版,年终奖20个月+,然后晋升绿色通道)

谁去做?

- 产品

- 运营

- 技术leader

为啥是技术leader去做?

- C端产品文档,这个基本就不用技术去做了

但是大厂里面都是做C端的吗?

- BI后台

- 自动化测试平台

- APP应用配置中心

- 性能分析平台

- 看下阿里云产品线:https://www.aliyun.com/product/list

第3集 跳出自己的技术思维模型-上司给你团队安排任务

简介:跳出自己的技术思维模型-上司给你团队安排任务

目标

- 跳出自己的技术思维模型,去分析产品需求背后的合理性和必要性

- 让自己更快理解业务需求,从而进行开发

- 看需求文档

- 写需求文档

说说我的情况

- 产品经理:常规进行操作,技术负责开发

- 老板开会:探讨新业务、然后就是技术负责人进行分析

- 团队的产品经理:P7产品专家,技术出身,然后转产品

沟通起来特别轻松

- 数据埋点、AB测试、流量模型、扩容、性能

- 偶尔还能帮技术定位问题、看监控等

大老板阿里CEO张勇在20年内部也发话了

阿里未来的产品经理都是技术出身

- 技术:研发能力强

- 产品:思维能力强

- 技术+产品:知道解决方案、研发工时、技术合理性、数据能力、分析能力

多数例子

- 百度:李彦宏

- 腾讯:马化腾

- 微信:张小龙

- 字节:张一鸣

- 360:周鸿祎

- 阿里:马云(但是对技术是最看重的)

- Facebook:扎克伯格

- 微软:比尔盖茨

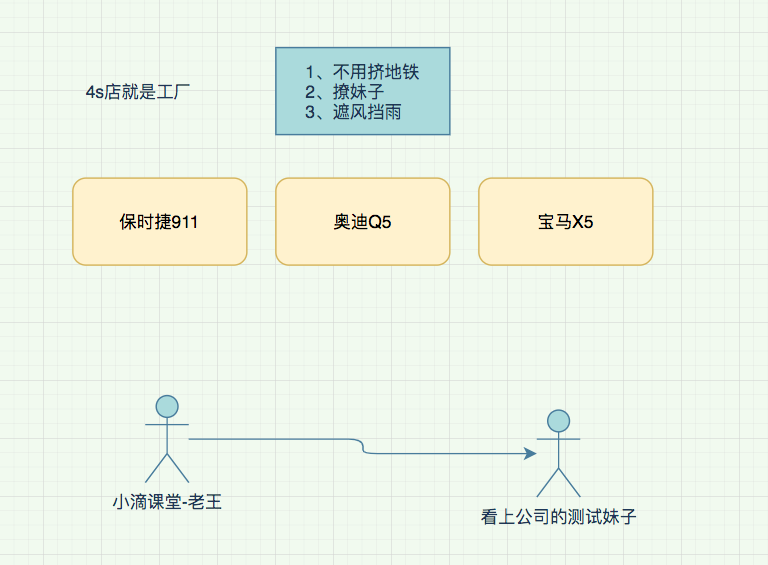

大气的老板:想做个短链平台,赋能公司业务,然后开启商业化对外出售

- 让你写-知道怎么写不

- 小滴短链商用平台需求文档地址: https://zhuanlan.zhihu.com/p/428514067

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第三章 商用短链平台介绍和技术Leader常用方法论介绍

第1集 商用短链平台业务介绍+需求背景说明

简介: 短链平台业务介绍+需求背景说明

- 什么是短链平台,应用场景有哪些

- 短链长啥样?

业务背景:为啥需要短链?

- 公司电商产品推广、业务活动页、广告落地页 缺少实时【数据反馈和渠道效果分析】

老项目业务推广【没人维护,无法做埋点】需要统计效果

- APP和营销活动发送营销短信链接过长,【浪费短信发送费用】

- 国内【反垄断后】微信、抖音、淘宝 流量互通,很多知识付费公司需要做 私域流量、社群运营

- 可以对外做产品输出,实现商业化能力增加公司营收

- 积累终端数据和人群数据,为公司未来产品人群做策略助力

更多。。。。

- 盈利点

用户按量付费,根据流量包选择付费购买对应的套餐

不同流量包权益不一样

- 每天可以创建的短链次数不一样

- 流量包使用时间限制、支持流量包叠加

- 注册用户每天有一定免费使用次数,但是不能查看数据

- 短链平台产品目标

满足公司现有业务的营销推广需求、数据分析和拉新促活能力

- 对外进行付费商用,支持企业私有化部署

- 首年日活用户: 10万

- 首年日新增短链数据:10万*50 = 500万

- 年新增用户数:50万/1年

- 年营收目标: 10万付费用户 * 客单价200元 = 2千万

- 新增短链:50条/用户每日

- 年私有化部署用户数:1K用户 * 3万/单价 = 3千万

上面需求背景、产品目标是怎么来的?为啥能想到这些?有没风险?有没遗漏的内容?

- 这个就是做事、思考 的方法论!!!

- 接下去几集重点要掌握(不要求一次性彻底掌握, 但是要有大概的认知,然后边学边实践,这个才能成长)

第2集 为什么需要学方法论 避免无章法做事和跳槽面试

简介: 避免无章法管理和做事,为什么需要学方法论

- 方法论:通俗来说就是【做事套路,解决问题的方法(手段/途径/工具)】 喜欢学术性的介绍可以百度更多的

你是否被问过类似这些 方法论技术面试题(考查你的逻辑思维是否清晰)

线上接口响应慢,你会怎么定位问题

- 监控统计问题、机房问题、某个节点问题、服务器带宽问题、CPU内存问题、网关问题、业务逻辑问题、并发量问题、数据库问题

sql查询耗时久,你会怎么排查优化

java应用发生了OOM,你会怎么排查问题

订单支付成功率下滑严重,你会怎么排查问题

RabbitMQ和RocketMQ技术选型,你会怎么选,考虑哪些因素

为什么要学方法论,常见的有哪些是必备的

新业务规划(PEST)

- 上线被下架 (K12教育、互联网金融)

运营推广(AARRR)

- 不被产品牵着走,但是也不盲目

SWOT态势分析法

- 个人成长、技术解决方案

团队管理(SMART)

- 合适的人合适的事

- 工作量分配

- 跳槽面试(逻辑考查)

第3集 公司行业前景分析-PEST方法论-选择大于努力

简介: 公司行业前景分析-PEST方法论-选择大于努力

PEST方法论

指的是政治(Political)、经济(Economic)、社会(Social)和技术(Technological)

- 政治环境主要是看我们的国家现在是否鼓励相关的业务

- 经济环境又可以分为宏观经济和微观经济,包括居民消费水平、产业结构

- 社会环境则是说跟社会的风俗习惯是否吻合

- 技术环境当然就是说的我们的技术实力(ASML光刻机)

案例:BAT区块链大牛找你开发特币交易平台app

- P 国家出台了相关政策、法律法规监管

- E 大家有闲钱,现在人居可支配收入高

- S 人口规模大,生活方式改变,投资理财越来越多

- T 团队已有对应的技术,行业领先,移动互联网成熟

案例延伸

互联网金融贷款产品 p2p

高中在线辅导产品

初中同学找你开发电商平台-对标淘宝、拼多多

聪明的人做聪明的事,避免自己入坑

行业选择错:白忙活几年,领域专家也吃亏

公司裁员、倒闭发不出工资:白干几个月,辛苦大半年,一夜回到解放前

大厂也一样:字节、阿里、腾讯、京东等

第4集 技术Leader必备方法论-用户增长的数据分析模型AARRR

简介: 技术Leader必备方法论-用户增长的数据分析模型AARRR

什么是AARRR用户增长模型

- AARRR是Acquisition、Activation、Retention、Revenue、Referral 五个单词的缩写,对应用户生命周期中的5个重要环节。

- 通俗来说就是一个产品从0~1到100的方法论

- 指引产品运营在不同的产品运营阶段,思考哪些关键节点,更好各个节点的指标数据

AARRR详细解释

- 获取:新用户首单免费/低价(瑞幸、拼多多)、厂商预装(手机)、买量投放

- 激活:app推送、短信推送、产品价值激活

- 留存:签到、活动短信推送、平台价值提供

- 收益:平台广告、电商变现、付费会员、融资、软件服务

- 传播:好友助力、分享抽奖、兄弟砍我一刀

第5集 技术Leader必备方法论-SWOT态势分析法-个人能力与技术解决方案

简介: 技术Leader必备方法论-SWOT态势分析法-个人能力与技术解决方案

什么是SWOT态势分析

- 官方:用来确定企业自身的竞争优势、劣势、外部市场的机会和威胁,从而将公司的战略与公司内部资源、外部环境有机地结合起来的一种科学的分析方法

4个单词的缩写 优势=strength、劣势=weakness、机会=opportunity、威胁=threats

- 优势和弱势是内部环境的分析,机会和威胁是对于外部环境的分析

```

外部的机会正好是你的优势,赶紧利用起来

```

外部的机会正好是你的优势,赶紧利用起来

外部的机会但是你的劣势,需要改进

自身具有优势但外部存在威胁,就需要时刻思考、保持警惕

是威胁又是你的劣势,就规避并消除

-案例应用场景-个人做技术Leader能力分析(工作3年,高级java,技术能力不错,项目组长刚离职)-优势:技术不错、对公司业务熟悉(个人内部)-劣势:项目管理能力不足、PPT汇报能力不足(个人内部)-机会: 独立负责的项目把控、直接和领导汇报,成为管理层(个人外部)-威胁:项目的规范机制没有建立、项目的核心难点没有攻破、加班比较多(个人外部)-技术解决方案分析(团队熟悉RabbitMQ,新来的组长熟悉RocketMQ,技术选型思考)- 优势:RabbitMQ团队多人用过、AMQP跨语言、模型API丰富(团队内部)- 劣势:阅读过源码的人过少, Erlang开发,二次修改不容易,项目组长对这个不熟悉(团队内部)- 机会:项目可以快速上线,减少采坑(团队外部)- 威胁:未来可能有更强大的MQ产品出现或公司改动架构(团队外部)-总结:根据SWOT进行充分分析,然后进行取舍选择,考虑更全面(对比没用这个分析你会怎么选择)<a name="66f08107"></a>#### 第6集 技术Leader必备方法论SMART衡量需求、工作的利器**简介: 技术Leader必备方法论SMART衡量需求、工作的利器**-什么是SMART方法论-源于国外管理大师的《管理的实践》-是为了利于员工更加明确高效地工作,更是为了管理者将来对员工实施绩效考核提供了考核目标和考核标准,使考核更加科学化、规范化-是5个单词的缩写- SMART原则【目标管理、设置】- Specific:目标要具体- Measurable:目标成果要可衡量(量化)- Attainable:目标要可实现,避免过高/过低- Relevant:与其他目标有一定的相关性- Time bound:目标必须有明确的期限-意义:在制定工作目标或者任务目标时,考虑一下目标与计划是不是SMART化的。只有具备SMART化的计划才是具有良好可实施性的,也才能指导保证计划得以实现-案例- 短链平台项目组成员,每天需要开晨会-并记录 ( 周一 早上团队开周会,每个人列出本周事项安排)- 张三的周报如下- 周三前完成短链平台数据库设计并输出相关sql文件(SMART)- 周四前完成短链平台整体架构搭建和工作任务拆分并评审完成(SMART)- 周二完成短链微服务开发工作 (SM RT)- 开发账号微服务 (S)- 解决老项目的bug ( )- 周二完成优化电商项目里面的下单接口RT响应时间,把500ms优化到200ms响应(SMART) **愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="8324eb53"></a>### 第四章 商用短链平台-功能需求介绍和微服务拆分讲解<a name="1952de4d"></a>#### 第1集 学以致用-商用短链平台需求文档拆分和总结**简介:学以致用-短链平台实战需求文档拆分和总结**- 看了前面的方法论和拓展知识,我们再来巩固下需求文档和功能- 小滴短链商用平台需求文档地址: [https://zhuanlan.zhihu.com/p/428514067](https://zhuanlan.zhihu.com/p/428514067)<a name="0ee11249"></a>#### 第2集 商用短链平台-微服务拆分和技术栈版本说明**简介:海量数据处理商用短链平台-微服务拆分和技术栈版本说明**-Maven聚合工程拆分- dcloud-common- 公共依赖包- dcloud-app- Flink+Kafka实时计算- dcloud-account- 账号+流量包微服务- dcloud-data- 数据可视化微服务- dcloud-gateway- 业务网关- dcloud-link- 短链微服务- dcloud-shop- 流量包商品+支付微服务-微服务技术栈+前置中间件版本说明- JDK11- SpringBoot 2.5.5- SpringCloud 2020.0.4- AlibabaCloud 2021.1- Sharding-JDBC 4.1.1- Mysql 8.0- Nacos 2.0.2- Redis 6.2.4- RabbitQM 3.8.15- Kafka : wurstmeister/kafka:2.13-2.7.0- 为啥有RabbitMQ还要有Kafka(单机写入TPS约在百万条/秒,最大的优点,就是吞吐量高)- 一个是业务MQ、一个大数据流式处理的MQ,建议分开- 还有更多的中间件用的时候再安装<a name="b3e4db94"></a>#### 第3集 商用短链平台-业务架构图讲解**简介:商用短链平台-业务架构图讲解**- 整体业务应用架构图- 各个微服务模块解析 **愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="07197cf7"></a>### 第五章 阿里云Linux服务器选配和常用中间件环境安装<a name="3a663876"></a>#### 第1集 云服务器配置和搭建Docker相关讲解**简介:云服务器配置和搭建Docker环境讲解**-云服务器购买-厂商-阿里云:[https://www.aliyun.com/](https://www.aliyun.com/)-腾讯云:[https://cloud.tencent.com/](https://cloud.tencent.com/)-亚马逊云:[https://aws.amazon.com/](https://aws.amazon.com/)-腾讯云新用户折扣地址- [https://cloud.tencent.com/act/cps/redirect?redirect=1575&cps_key=3cb5dbec53a023baba788acac8d11871&from=console](https://cloud.tencent.com/act/cps/redirect?redirect=1575&cps_key=3cb5dbec53a023baba788acac8d11871&from=console)-阿里云新用户地址(如果地址失效,联系我或者客服即可,买2核8g或者16g以上,如果资金允许-买3年)- [https://www.aliyun.com/minisite/goods?userCode=r5saexap&share_source=copy_link](https://www.aliyun.com/minisite/goods?userCode=r5saexap&share_source=copy_link)-服务器说明

阿里云-服务器根据情况买1~2台就行, 建议买2核8g以上可以1年或者3年长久,建议大课群里3人组队,每人买1台就够用的了,组合起来就是3台了,大家学习时间基本是错开的,然后MQ、mysql、nacos 约定好命名空间,就不会冲突的

也可以自己账号买1台长久使用,然后结尾部署的时候使用按量付费的形式就行购买多节点则省钱

PS:建议用新用户注册比如家人的(手机号、身份证、设备),购买成功后可以换绑手机号

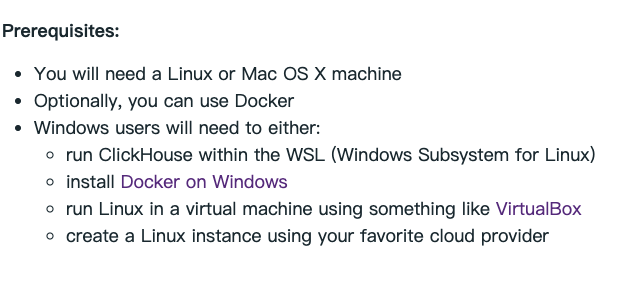

- 环境问题说明- 务必使用CentOS 7 以上版本,64位系统,不要在Windows系统操作!!!!推荐是CentOS 7.8- 带宽可以选择固定带宽1M~5M都行,或者按量付费(带宽过小,后续Jenkins构建推送镜像比较慢)- 避免使用本地用虚拟机(后续部署很多中间件+本地多个微服务开发会很卡,且容易采坑)- 谁都不能保证每个人-硬件组成-系统版本-虚拟机软件版本都一样- 出现问题,大家结合报错日志搜索博文解决- 少数同学 -Win7、Win8、Win10、Mac、虚拟机等等,可能存在兼容问题- 记得重置密码和配置网络安全组相关操作,我这边就不多说了- Docker安装

按照依赖

yum install -y yum-utils device-mapper-persistent-data lvm2

配置yum源(比较慢,不用)

yum-config-manager —add-repo https://download.docker.com/linux/centos/docker-ce.repo

配置yum源 使用国内的

yum-config-manager —add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

查看版本

yum list docker-ce —showduplicates | sort -r

1. 安装docker

yum -y install docker-ce-20.10.10-3.el7

2. 查看docker版本

docker -v

3. 启动docker

systemctl start docker

4. 查看docker 启动状态

systemctl status docker

检查安装结果。 docker info

启动使用Docker systemctl start docker #运行Docker守护进程 systemctl stop docker #停止Docker守护进程 systemctl restart docker #重启Docker守护进程

docker ps查看容器 docker stop 容器id

修改镜像仓库 vim /etc/docker/daemon.json

改为下面内容,然后重启docker

{ “debug”:true,”experimental”:true, “registry-mirrors”:[“https://pb5bklzr.mirror.aliyuncs.com","https://hub-mirror.c.163.com","https://docker.mirrors.ustc.edu.cn“] }

查看信息

docker info

注意:不使用1.13.1版本,该版本在jenkins使用docker命令时会说找不到配置文件!

<a name="45ca822b"></a>#### 第2集 云服务器基础设施安装之Mysql8.0+Redis6.X安装**简介:云服务器基础设施安装之Mysql8.0+Redis6.X安装**- Mysql8.0安装

安装mysql8,让容器使用宿主机的时间,容器时间与宿主机时间同步

docker run \ -p 3306:3306 \ -e MYSQL_ROOT_PASSWORD=root \ -v /home/data/mysql/data:/var/lib/mysql:rw \ -v /etc/localtime:/etc/localtime:ro \ —name root \ —restart=always \ -d mysql:8.0

Mysql工具连接测试

连接数配置

show variables like ‘%max_connections%’; set GLOBAL max_connections=5000; set GLOBAL mysqlx_max_connections=5000;

- Redis6安装

docker run -itd —name my_redis1 -p 6379:6379 -v /mydata/redis/data:/data redis:6.2.4 —requirepass root

进入容器的redis docker exec -it 容器id redis-cli

工具测试连接

<a name="83e46b0e"></a>#### 第3集 云服务器基础设施安装之Nacos2.x+Mysql8配置持久化-避坑**简介:云服务器基础设施安装之Nacos2.x+Mysql8配置持久化-避坑**-Nacos持久化SQL数据脚本- 第5章第3集资料里面- 默认登录- 账户nacos- 密码 nacos-Nacos2.x安装(生产环境让运维人员配置网络,不暴露公网)- 配置中心需要加认证信息才可以访问

开源版本的 Nacos server 配置中,不会对客户端鉴权,即任何能访问 Nacos server 的用户,都可以直接获取 Nacos 中存储的配置,假如一个黑客攻进了企业内网,就能获取所有的业务配置,这样肯定会有安全隐患。

需要先开启 Nacos server 的鉴权,在 Nacos server 上修改 application.properties 中的 nacos.core.auth.enabled 值为 true 即可

```docker run -d \-e NACOS_AUTH_ENABLE=true \-e MODE=standalone \-e JVM_XMS=128m \-e JVM_XMX=128m \-e JVM_XMN=128m \-p 8848:8848 \-e SPRING_DATASOURCE_PLATFORM=mysql \-e MYSQL_SERVICE_HOST=192.168.200.204 \-e MYSQL_SERVICE_PORT=3306 \-e MYSQL_SERVICE_USER=root \-e MYSQL_SERVICE_PASSWORD=root \-e MYSQL_SERVICE_DB_NAME=nacos_config \-e MYSQL_SERVICE_DB_PARAM='characterEncoding=utf8&connectTimeout=10000&socketTimeout=30000&autoReconnect=true&useSSL=false' \--restart=always \--privileged=true \-v /home/data/nacos/logs:/home/nacos/logs \--name nacos \nacos/nacos-server:2.0.2

第4集 云服务器基础设施安装之RabbitMQ安装

简介:云服务器基础设施安装之RabbitMQ安装

- RabbitMQ安装

docker run -d --name xd_rabbit -e RABBITMQ_DEFAULT_USER=admin -e RABBITMQ_DEFAULT_PASS=password -p 15672:15672 -p 5672:5672 rabbitmq:3.8.15-management#网络安全组记得开放端口4369 erlang 发现口5672 client 端通信口15672 管理界面 ui 端口25672 server 间内部通信口访问管理界面ip:15672

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第六章 短链平台项目创建+git代码管理+开发分层规范讲解

第1集 短链平台实战-Maven聚合工程创建微服务项目

简介:Maven聚合工程创建微服务项目实战

Maven聚合工程拆分

dcloud-common

- 公共依赖包

dcloud-app

- Flink+Kafka实时计算

dcloud-account

- 账号+流量包微服务

dcloud-data

- 数据可视化微服务

dcloud-gateway

- 业务网关

dcloud-link

- 短链微服务

dcloud-shop

- 流量包商品+支付微服务

创建项目(记得删除聚合工程src目录)

添加依赖

<properties><!--JDK版本,如果是jdk8则这里是 1.8--><java.version>11</java.version><maven.compiler.source>11</maven.compiler.source><maven.compiler.target>11</maven.compiler.target><spring.boot.version>2.5.5</spring.boot.version><spring.cloud.version>2020.0.4</spring.cloud.version><alibaba.cloud.version>2021.1</alibaba.cloud.version><mybatisplus.boot.starter.version>3.4.0</mybatisplus.boot.starter.version><lombok.version>1.18.16</lombok.version><commons.lang3.version>3.9</commons.lang3.version><commons.codec.version>1.15</commons.codec.version><xxl-job.version>2.3.0</xxl-job.version><aliyun.oss.version>3.10.2</aliyun.oss.version><captcha.version>1.1.0</captcha.version><docker.image.prefix>dcloud</docker.image.prefix><redission.version>3.10.1</redission.version><jwt.version>0.7.0</jwt.version><sharding-jdbc.version>4.1.1</sharding-jdbc.version><!--跳过单元测试--><skipTests>true</skipTests><junit.version>4.12</junit.version><druid.version>1.1.16</druid.version></properties><!--锁定版本--><dependencyManagement><dependencies><!--https://mvnrepository.com/artifact/org.springframework.boot/spring-boot-dependencies/2.3.3.RELEASE--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-dependencies</artifactId><version>${spring.boot.version}</version><type>pom</type><scope>import</scope></dependency><!--https://mvnrepository.com/artifact/org.springframework.cloud/spring-cloud-dependencies/Hoxton.SR8--><dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-dependencies</artifactId><version>${spring.cloud.version}</version><type>pom</type><scope>import</scope></dependency><!--https://mvnrepository.com/artifact/com.alibaba.cloud/spring-cloud-alibaba-dependencies/2.2.1.RELEASE--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-alibaba-dependencies</artifactId><version>${alibaba.cloud.version}</version><type>pom</type><scope>import</scope></dependency><!--mybatis plus和springboot整合--><dependency><groupId>com.baomidou</groupId><artifactId>mybatis-plus-boot-starter</artifactId><version>${mybatisplus.boot.starter.version}</version></dependency><!--https://mvnrepository.com/artifact/org.projectlombok/lombok/1.18.16--><!--scope=provided,说明它只在编译阶段生效,不需要打入包中, Lombok在编译期将带Lombok注解的Java文件正确编译为完整的Class文件--><dependency><groupId>org.projectlombok</groupId><artifactId>lombok</artifactId><version>${lombok.version}</version><!--<scope>provided</scope>--></dependency><!-- https://mvnrepository.com/artifact/org.apache.commons/commons-lang3 --><dependency><groupId>org.apache.commons</groupId><artifactId>commons-lang3</artifactId><version>${commons.lang3.version}</version></dependency><!-- https://mvnrepository.com/artifact/commons-codec/commons-codec --><!--用于加密--><dependency><groupId>commons-codec</groupId><artifactId>commons-codec</artifactId><version>${commons.codec.version}</version></dependency><!--验证码kaptcha依赖包--><dependency><groupId>com.baomidou</groupId><artifactId>kaptcha-spring-boot-starter</artifactId><version>${captcha.version}</version></dependency><!--阿里云oss--><dependency><groupId>com.aliyun.oss</groupId><artifactId>aliyun-sdk-oss</artifactId><version>${aliyun.oss.version}</version></dependency><!-- JWT相关 --><dependency><groupId>io.jsonwebtoken</groupId><artifactId>jjwt</artifactId><version>${jwt.version}</version></dependency><!--分布式锁--><dependency><groupId>org.redisson</groupId><artifactId>redisson</artifactId><version>${redission.version}</version></dependency><!--https://mvnrepository.com/artifact/org.apache.shardingsphere/sharding-jdbc-spring-boot-starter--><dependency><groupId>org.apache.shardingsphere</groupId><artifactId>sharding-jdbc-spring-boot-starter</artifactId><version>${sharding-jdbc.version}</version></dependency><dependency><groupId>junit</groupId><artifactId>junit</artifactId><version>${junit.version}</version></dependency><!-- https://mvnrepository.com/artifact/com.xuxueli/xxl-job-core --><dependency><groupId>com.xuxueli</groupId><artifactId>xxl-job-core</artifactId><version>${xxl-job.version}</version></dependency></dependencies></dependencyManagement><!-- 代码库 --><repositories><repository><id>maven-ali</id><url>http://maven.aliyun.com/nexus/content/groups/public//</url><releases><enabled>true</enabled></releases><snapshots><enabled>true</enabled><updatePolicy>always</updatePolicy><checksumPolicy>fail</checksumPolicy></snapshots></repository></repositories><pluginRepositories><pluginRepository><id>public</id><name>aliyun nexus</name><url>http://maven.aliyun.com/nexus/content/groups/public/</url><releases><enabled>true</enabled></releases><snapshots><enabled>false</enabled></snapshots></pluginRepository></pluginRepositories><!--module不用添加打包版本信息--><build><plugins><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-compiler-plugin</artifactId><version>2.1</version><configuration><skip>true</skip></configuration></plugin><plugin><groupId>org.springframework.boot</groupId><artifactId>spring-boot-maven-plugin</artifactId><version>${spring.boot.version}</version><configuration><fork>true</fork><addResources>true</addResources></configuration></plugin></plugins></build>

第2集 Gitee仓库介绍和项目纳入版本管理+ignore文件配置

简介:开源中国Gitee仓库-介绍和项目纳入版本管理+ignore文件配置置

Git介绍

- 是一个版本管理工具, 其作用就是可以让你更好的管理你的程序,比如你原来提交过的内容,以后虽然修改了,但是通过git这个工具,可以把你原来提交的内容重现出来,这样对于你后来才意识到的一些错误的更改,可以进行还原

基于git协议的代码仓库

- github 全球最大同性交友社区

- gitee 开源中国

- gitlab 开源的git仓库平台,阿里等大厂就是基于这个搭建

- codeup 阿里云上的免费git仓库

gitee仓库地址

大课项目必须用git吗?

- 如果是因为不会git,而不用则不行,因为这个是互联网公司必备的

- 可以看联系客服看小滴课堂 git+gitlab专题视频

本地安装文档

大课项目加入git管理(是公钥设置,不是秘钥设置)

本地生成公钥 ssh-keygen -t rsa -C “794666918@qq.com“

- 进入项目目录

配置gitignore文件

- 根目录创建文件 .gitignore

# Compiled class file*.class# Log file*.log# BlueJ files*.ctxt# Mobile Tools for Java (J2ME).mtj.tmp/# Package Files #*.jar*.war*.nar*.ear*.zip*.tar.gz*.rar.DS_Store.idea# virtual machine crash logs, see http://www.java.com/en/download/help/error_hotspot.xmlhs_err_pid*

第3集 阿里编码规范里面Manager分层介绍-和开发规范说明

简介:阿里编码规范里面Manager分层介绍-专用名词和POJO实体类约定

开发人员:张三、李四、王五

一定要避免单点故障

- 一个微服务起码两个人熟悉:一个是主程一个是技术leader ,推荐是团队里面两个开发人员

- N方库说明

一方库: 本工程内部子项目模块依赖的库(jar 包)。二方库: 公司内部发布到中央仓库,可供公司内部其它应用依赖的库(jar包)。三方库: 公司之外的开源库(jar 包)。

- POJO实体类

POJO(Plain Ordinary Java Object): 在手册中,POJO 专指只有 setter / getter / toString的简单类,包括DO/DTO/BO/VO等, 禁止命名成xxxPOJO

- 各个层级约束规范

A) Service/DAO层方法命名规约1) 获取单个对象的方法用get做前缀。2) 获取多个对象的方法用list做前缀,复数形式结尾如:listObjects。3) 获取统计值的方法用count做前缀。4) 插入的方法用save/insert做前缀。5) 删除的方法用remove/delete做前缀。6) 修改的方法用update做前缀。B) 领域模型命名规约1) 数据对象:xxxDO,xxx即为数据表名。2) 一般数据传输对象:xxxDTO,xxx为业务领域相关的名称,项目里面也用VO。3) 展示对象:xxxVO,也就是响应给前端的实体包装类。4) 接收前端json对象请求的命名为 XXXRequest

Manager分层说明 通用业务处理层,它有如下特征

- 对第三方平台封装的层,预处理返回结果及转化异常信息

- 对Service层通用能力的下沉,如缓存方案、中间件通用处理;

- 与DAO层交互,对多个DAO的组合复用。

·

更多开发规范,可以参考阿里巴巴编码手册(资料里面有 第6章第3集资料里面)

- 有兴趣的同学也可以安装IDEA编码扫描插件,不过前期可以先不用开启,会影响电脑卡顿和强迫症

第4集【重要】dcloud-common通用模块配置使用实战和新版改动

简介:短链平台dcloud-common通用模块配置使用实战

- pom文件配置

<dependencies><dependency><groupId>org.projectlombok</groupId><artifactId>lombok</artifactId></dependency><!--项目中添加 spring-boot-starter--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-web</artifactId></dependency><!--数据库连接--><dependency><groupId>mysql</groupId><artifactId>mysql-connector-java</artifactId></dependency><!--mybatis plus--><dependency><groupId>com.baomidou</groupId><artifactId>mybatis-plus-boot-starter</artifactId></dependency><!--单元测试--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-test</artifactId></dependency><!--redis客户端--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-data-redis</artifactId><exclusions><exclusion><groupId>io.lettuce</groupId><artifactId>lettuce-core</artifactId></exclusion></exclusions></dependency><dependency><groupId>redis.clients</groupId><artifactId>jedis</artifactId></dependency><!-- https://mvnrepository.com/artifact/org.apache.commons/commons-lang3 --><dependency><groupId>org.apache.commons</groupId><artifactId>commons-lang3</artifactId></dependency><!--用于加密--><dependency><groupId>commons-codec</groupId><artifactId>commons-codec</artifactId></dependency><!-- JWT相关 --><dependency><groupId>io.jsonwebtoken</groupId><artifactId>jjwt</artifactId></dependency><!--redisson分布式锁--><dependency><groupId>org.redisson</groupId><artifactId>redisson</artifactId></dependency><!--Hoxton.M2版本之后不再使用Ribbon而是使用spring-cloud-loadbalancer,所以不引入spring-cloud-loadbalancer会报错,所以加入spring-cloud-loadbalancer依赖 并且在nacos中排除ribbon依赖,不然loadbalancer无效 --><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId><exclusions><exclusion><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-netflix-ribbon</artifactId></exclusion></exclusions></dependency><dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-loadbalancer</artifactId></dependency><!--配置中心, 留坑,后续用的时候再讲--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-nacos-config</artifactId></dependency><!--Feign远程调用--><dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-openfeign</artifactId></dependency><!--限流依赖--><dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-sentinel</artifactId></dependency><!--限流持久化到nacos--><dependency><groupId>com.alibaba.csp</groupId><artifactId>sentinel-datasource-nacos</artifactId></dependency><!--Springboot项目整合spring-kafka依赖包配置--><dependency><groupId>org.springframework.kafka</groupId><artifactId>spring-kafka</artifactId></dependency><!--引入AMQP--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-amqp</artifactId></dependency><!--spring cache依赖包--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-cache</artifactId></dependency><dependency><groupId>org.apache.shardingsphere</groupId><artifactId>sharding-jdbc-spring-boot-starter</artifactId></dependency><!-- https://mvnrepository.com/artifact/com.xuxueli/xxl-job-core --><!--分布式调度--><dependency><groupId>com.xuxueli</groupId><artifactId>xxl-job-core</artifactId></dependency><dependency><groupId>junit</groupId><artifactId>junit</artifactId></dependency></dependencies>

第5集 统一接口响应协议-响应工具类封装

简介:统一接口响应协议和响应工具类封装

统一业务状态码 BizCodeEnum开发

- 状态码定义约束,共6位数,前三位代表服务,后3位代表接口

- 比如 商品服务210

/*** 小滴课堂,愿景:让技术不再难学** @Description 状态码定义约束,共6位数,前三位代表服务,后3位代表接口* 比如 商品服务210,购物车是220、用户服务230,403代表权限***/public enum BizCodeEnum {/*** 短链分组*/GROUP_REPEAT(23001,"分组名重复"),GROUP_OPER_FAIL(23503,"分组名操作失败"),GROUP_NOT_EXIST(23404,"分组不存在"),/***验证码*/CODE_TO_ERROR(240001,"接收号码不合规"),CODE_LIMITED(240002,"验证码发送过快"),CODE_ERROR(240003,"验证码错误"),CODE_CAPTCHA_ERROR(240101,"图形验证码错误"),/*** 账号*/ACCOUNT_REPEAT(250001,"账号已经存在"),ACCOUNT_UNREGISTER(250002,"账号不存在"),ACCOUNT_PWD_ERROR(250003,"账号或者密码错误"),ACCOUNT_UNLOGIN(250004,"账号未登录"),/*** 短链*/SHORT_LINK_NOT_EXIST(260404,"短链不存在"),/*** 订单*/ORDER_CONFIRM_PRICE_FAIL(280002,"创建订单-验价失败"),ORDER_CONFIRM_REPEAT(280008,"订单恶意-重复提交"),ORDER_CONFIRM_TOKEN_EQUAL_FAIL(280009,"订单令牌缺少"),ORDER_CONFIRM_NOT_EXIST(280010,"订单不存在"),/*** 支付*/PAY_ORDER_FAIL(300001,"创建支付订单失败"),PAY_ORDER_CALLBACK_SIGN_FAIL(300002,"支付订单回调验证签失败"),PAY_ORDER_CALLBACK_NOT_SUCCESS(300003,"支付宝回调更新订单失败"),PAY_ORDER_NOT_EXIST(300005,"订单不存在"),PAY_ORDER_STATE_ERROR(300006,"订单状态不正常"),PAY_ORDER_PAY_TIMEOUT(300007,"订单支付超时"),/*** 流控操作*/CONTROL_FLOW(500101,"限流控制"),CONTROL_DEGRADE(500201,"降级控制"),CONTROL_AUTH(500301,"认证控制"),/*** 流量包操作*/TRAFFIC_FREE_NOT_EXIST(600101,"免费流量包不存在,联系客服"),TRAFFIC_REDUCE_FAIL(600102,"流量不足,扣减失败"),TRAFFIC_EXCEPTION(600103,"流量包数据异常,用户无流量包"),/*** 通用操作码*/OPS_REPEAT(110001,"重复操作"),OPS_NETWORK_ADDRESS_ERROR(110002,"网络地址错误"),/*** 文件相关*/FILE_UPLOAD_USER_IMG_FAIL(700101,"用户头像文件上传失败");@Getterprivate String message;@Getterprivate int code;private BizCodeEnum(int code, String message){this.code = code;this.message = message;}}

- 接口统一协议 JsonData工具类开发

@Data@AllArgsConstructor@NoArgsConstructorpublic class JsonData {/*** 状态码 0 表示成功*/private Integer code;/*** 数据*/private Object data;/*** 描述*/private String msg;/*** 获取远程调用数据* 注意事项:* 支持多单词下划线专驼峰(序列化和反序列化)*** @param typeReference* @param <T>* @return*/public <T> T getData(TypeReference<T> typeReference){return JSON.parseObject(JSON.toJSONString(data),typeReference);}/*** 成功,不传入数据* @return*/public static JsonData buildSuccess() {return new JsonData(0, null, null);}/*** 成功,传入数据* @param data* @return*/public static JsonData buildSuccess(Object data) {return new JsonData(0, data, null);}/*** 失败,传入描述信息* @param msg* @return*/public static JsonData buildError(String msg) {return new JsonData(-1, null, msg);}/*** 自定义状态码和错误信息* @param code* @param msg* @return*/public static JsonData buildCodeAndMsg(int code, String msg) {return new JsonData(code, null, msg);}/*** 传入枚举,返回信息* @param codeEnum* @return*/public static JsonData buildResult(BizCodeEnum codeEnum){return JsonData.buildCodeAndMsg(codeEnum.getCode(),codeEnum.getMessage());}}

第6集 微服务自定义全局异常+处理器handler开发

简介:自定义全局异常+处理器开发

- 自定义全局异常

/*** 全局异常处理*/@Datapublic class BizException extends RuntimeException {private Integer code;private String msg;public BizException(Integer code, String message) {super(message);this.code = code;this.msg = message;}public BizException(BizCodeEnum bizCodeEnum) {super(bizCodeEnum.getMsg());this.code = bizCodeEnum.getCode();this.msg = bizCodeEnum.getMsg();}}

- 自定义异常处理器

@ControllerAdvice@Slf4jpublic class ExceptionHandle {@ExceptionHandler(value = Exception.class)@ResponseBodypublic JsonData handle(Exception e) {if (e instanceof BizException) {BizException bizException = (BizException) e;log.info("[业务异常]{}", e);return JsonData.buildError(bizException.getMsg(), bizException.getCode());} else {log.info("[系统异常]{}", e);return JsonData.buildError("全局异常,未知错误");}}}

第7集 common通用工具和时间格式化工具类讲解

简介:common通用工具和时间格式化工具类讲解

- 时间格式化工具类封装

public class TimeUtil {/*** 默认日期格式*/private static final String DEFAULT_PATTERN = "yyyy-MM-dd HH:mm:ss";/*** 默认日期格式*/private static final DateTimeFormatter DEFAULT_DATE_TIME_FORMATTER = DateTimeFormatter.ofPattern(DEFAULT_PATTERN);private static final ZoneId DEFAULT_ZONE_ID = ZoneId.systemDefault();/*** LocalDateTime 转 字符串,指定日期格式* @param time* @param pattern* @return*/public static String format(LocalDateTime localDateTime,String pattern){DateTimeFormatter formatter = DateTimeFormatter.ofPattern(pattern);String timeStr = formatter.format(localDateTime.atZone(DEFAULT_ZONE_ID));return timeStr;}/*** Date 转 字符串, 指定日期格式* @param time* @param pattern* @return*/public static String format(Date time,String pattern){DateTimeFormatter formatter = DateTimeFormatter.ofPattern(pattern);String timeStr = formatter.format(time.toInstant().atZone(DEFAULT_ZONE_ID));return timeStr;}/*** Date 转 字符串,默认日期格式* @param time* @return*/public static String format(Date time){String timeStr = DEFAULT_DATE_TIME_FORMATTER.format(time.toInstant().atZone(DEFAULT_ZONE_ID));return timeStr;}/*** timestamp 转 字符串,默认日期格式** @param time* @return*/public static String format(long timestamp) {String timeStr = DEFAULT_DATE_TIME_FORMATTER.format(new Date(timestamp).toInstant().atZone(DEFAULT_ZONE_ID));return timeStr;}/*** 字符串 转 Date** @param time* @return*/public static Date strToDate(String time) {LocalDateTime localDateTime = LocalDateTime.parse(time, DEFAULT_DATE_TIME_FORMATTER);return Date.from(localDateTime.atZone(DEFAULT_ZONE_ID).toInstant());}/*** 获取当天剩余的秒数,用于流量包过期配置* @param currentDate* @return*/public static Integer getRemainSecondsOneDay(Date currentDate) {LocalDateTime midnight = LocalDateTime.ofInstant(currentDate.toInstant(),ZoneId.systemDefault()).plusDays(1).withHour(0).withMinute(0).withSecond(0).withNano(0);LocalDateTime currentDateTime = LocalDateTime.ofInstant(currentDate.toInstant(),ZoneId.systemDefault());long seconds = ChronoUnit.SECONDS.between(currentDateTime, midnight);return (int) seconds;}}

- Json序列化工具类封装

public class JsonUtil {private static final ObjectMapper mapper = new ObjectMapper();static {//设置可用单引号mapper.configure(JsonParser.Feature.ALLOW_SINGLE_QUOTES, true);//序列化的时候序列对象的所有属性mapper.setSerializationInclusion(JsonInclude.Include.ALWAYS);//反序列化的时候如果多了其他属性,不抛出异常mapper.configure(DeserializationFeature.FAIL_ON_UNKNOWN_PROPERTIES, false);//如果是空对象的时候,不抛异常mapper.configure(SerializationFeature.FAIL_ON_EMPTY_BEANS, false);//取消时间的转化格式,默认是时间戳,可以取消,同时需要设置要表现的时间格式mapper.configure(SerializationFeature.WRITE_DATES_AS_TIMESTAMPS, false);mapper.setDateFormat(new SimpleDateFormat("yyyy-MM-dd HH:mm:ss"));}/*** 对象转为Json字符串* @param data* @return*/public static String obj2Json(Object obj) {String jsonStr = null;try {jsonStr = mapper.writeValueAsString(obj);} catch (JsonProcessingException e) {e.printStackTrace();}return jsonStr;}/*** json字符串转为对象* @param str* @param valueType* @return*/public static <T> T json2Obj(String jsonStr, Class<T> beanType) {T obj = null;try {obj = mapper.readValue(jsonStr, beanType);} catch (Exception e){e.printStackTrace();}return obj;}/*** json数据转换成pojo对象list* @param jsonData* @param beanType* @return*/public static <T> List<T> json2List(String jsonData, Class<T> beanType) {JavaType javaType = mapper.getTypeFactory().constructParametricType(List.class, beanType);try {List<T> list = mapper.readValue(jsonData, javaType);return list;} catch (Exception e) {e.printStackTrace();}return null;}/*** 对象转为byte数组* @param data* @return*/public static byte[] obj2Bytes(Object obj) {byte[] byteArr = null;try {byteArr = mapper.writeValueAsBytes(obj);} catch (JsonProcessingException e) {e.printStackTrace();}return byteArr;}/*** byte数组转为对象* @param byteArr* @param valueType* @return*/public static <T> T bytes2Obj(byte[] byteArr, Class<T> beanType) {T obj = null;try {obj = mapper.readValue(byteArr, beanType);} catch (Exception e) {e.printStackTrace();}return obj;}}

- common工具大集合

@Slf4jpublic class CommonUtil {/*** 获取ip** @param request* @return*/public static String getIpAddr(HttpServletRequest request) {String ipAddress = null;try {ipAddress = request.getHeader("x-forwarded-for");if (ipAddress == null || ipAddress.length() == 0 || "unknown".equalsIgnoreCase(ipAddress)) {ipAddress = request.getHeader("Proxy-Client-IP");}if (ipAddress == null || ipAddress.length() == 0 || "unknown".equalsIgnoreCase(ipAddress)) {ipAddress = request.getHeader("WL-Proxy-Client-IP");}if (ipAddress == null || ipAddress.length() == 0 || "unknown".equalsIgnoreCase(ipAddress)) {ipAddress = request.getRemoteAddr();if (ipAddress.equals("127.0.0.1")) {// 根据网卡取本机配置的IPInetAddress inet = null;try {inet = InetAddress.getLocalHost();} catch (UnknownHostException e) {e.printStackTrace();}ipAddress = inet.getHostAddress();}}// 对于通过多个代理的情况,第一个IP为客户端真实IP,多个IP按照','分割if (ipAddress != null && ipAddress.length() > 15) {// "***.***.***.***".length()// = 15if (ipAddress.indexOf(",") > 0) {ipAddress = ipAddress.substring(0, ipAddress.indexOf(","));}}} catch (Exception e) {ipAddress = "";}return ipAddress;}/*** 获取全部请求头* @param request* @return*/public static Map<String, String> getAllRequestHeader(HttpServletRequest request){Enumeration<String> headerNames = request.getHeaderNames();Map<String, String> map = new HashMap<>();while (headerNames.hasMoreElements()) {String key = (String)headerNames.nextElement();//根据名称获取请求头的值String value = request.getHeader(key);map.put(key,value);}return map;}/*** MD5加密** @param data* @return*/public static String MD5(String data) {try {MessageDigest md = MessageDigest.getInstance("MD5");byte[] array = md.digest(data.getBytes("UTF-8"));StringBuilder sb = new StringBuilder();for (byte item : array) {sb.append(Integer.toHexString((item & 0xFF) | 0x100).substring(1, 3));}return sb.toString().toUpperCase();} catch (Exception exception) {}return null;}/*** 获取验证码随机数** @param length* @return*/public static String getRandomCode(int length) {String sources = "0123456789";Random random = new Random();StringBuilder sb = new StringBuilder();for (int j = 0; j < length; j++) {sb.append(sources.charAt(random.nextInt(9)));}return sb.toString();}/*** 获取当前时间戳** @return*/public static long getCurrentTimestamp() {return System.currentTimeMillis();}/*** 生成uuid** @return*/public static String generateUUID() {return UUID.randomUUID().toString().replaceAll("-", "").substring(0, 32);}/*** 获取随机长度的串** @param length* @return*/private static final String ALL_CHAR_NUM = "0123456789ABCDEFGHIJKLMNOPQRSTUVWXYZabcdefghijklmnopqrstuvwxyz";public static String getStringNumRandom(int length) {//生成随机数字和字母,Random random = new Random();StringBuilder saltString = new StringBuilder(length);for (int i = 1; i <= length; ++i) {saltString.append(ALL_CHAR_NUM.charAt(random.nextInt(ALL_CHAR_NUM.length())));}return saltString.toString();}/*** 响应json数据给前端** @param response* @param obj*/public static void sendJsonMessage(HttpServletResponse response, Object obj) {response.setContentType("application/json; charset=utf-8");try (PrintWriter writer = response.getWriter()) {writer.print(JsonUtil.obj2Json(obj));response.flushBuffer();} catch (IOException e) {log.warn("响应json数据给前端异常:{}",e);}}}

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第七章 商用短链平台实战-账号微服务+流量包设计

第1集 账号微服务和流量包数据库表+索引规范讲解《上》

简介:账号微服务和流量包数据库表+索引规范讲解

短链平台大课难度层级曲线图:由浅入深

索引规范

- 主键索引名为 pk_字段名; pk即 primary key;

- 唯一索引名为 uk_字段名;uk 即 unique key

- 普通索引名则为 idx_字段名;idx 即index 的简称

- account表

CREATE TABLE `account` (`id` bigint unsigned NOT NULL AUTO_INCREMENT,`account_no` bigint DEFAULT NULL,`head_img` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '头像',`phone` varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '手机号',`pwd` varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '密码',`secret` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '盐,用于个人敏感信息处理',`mail` varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '邮箱',`username` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '用户名',`auth` varchar(32) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '认证级别,DEFAULT,REALNAME,ENTERPRISE,访问次数不一样',`gmt_create` datetime DEFAULT CURRENT_TIMESTAMP,`gmt_modified` datetime DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,PRIMARY KEY (`id`),UNIQUE KEY `uk_phone` (`phone`) USING BTREE,UNIQUE KEY `uk_account` (`account_no`) USING BTREE) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin;

第2集 账号微服务和流量包数据库表+索引规范讲解《下》

简介:账号微服务和流量包数据库表+索引规范讲解

- 账号和流量包的关系:一对多

traffic流量包表

思考点

- 海量数据下每天免费次数怎么更新?

- 海量数据付费流量套餐包每天次数限制怎么更新?

- 高性能扣减流量包设计怎么做?

- 流量包数据更新处理-高并发下分布式事务怎么解决

CREATE TABLE `traffic` (`id` bigint unsigned NOT NULL AUTO_INCREMENT,`day_limit` int DEFAULT NULL COMMENT '每天限制多少条,短链',`day_used` int DEFAULT NULL COMMENT '当天用了多少条,短链',`total_limit` int DEFAULT NULL COMMENT '总次数,活码才用',`account_no` bigint DEFAULT NULL COMMENT '账号',`out_trade_no` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '订单号',`level` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '产品层级:FIRST青铜、SECOND黄金、THIRD钻石',`expired_date` date DEFAULT NULL COMMENT '过期日期',`plugin_type` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '插件类型',`product_id` bigint DEFAULT NULL COMMENT '商品主键',`gmt_create` datetime DEFAULT CURRENT_TIMESTAMP,`gmt_modified` datetime DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,PRIMARY KEY (`id`),UNIQUE KEY `uk_trade_no` (`out_trade_no`,`account_no`) USING BTREE,KEY `idx_account_no` (`account_no`) USING BTREE) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin;

- traffic_task 流量包任务表(先建-后续会讲用途)

CREATE TABLE `traffic_task` (`id` bigint unsigned NOT NULL AUTO_INCREMENT,`account_no` bigint DEFAULT NULL,`traffic_id` bigint DEFAULT NULL,`use_times` int DEFAULT NULL,`lock_state` varchar(16) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '锁定状态锁定LOCK 完成FINISH-取消CANCEL',`message_id` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT '唯一标识',`gmt_create` datetime DEFAULT CURRENT_TIMESTAMP,`gmt_modified` datetime DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,PRIMARY KEY (`id`),UNIQUE KEY `uk_msg_id` (`message_id`) USING BTREE,KEY `idx_release` (`account_no`,`id`) USING BTREE) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin;

第3集 账号微服务-流量包业务模型概念补充

简介:账号微服务流量包业务模型概念补充

- 业务模型补充

第4集 项目引入Mybatis-plus-generator代码自动生成工具

简介:介绍Mybatis-plus-generator代码自动化生成工具

介绍

- 底层是模板引擎技术,可以自定义生成的java类模板

- 基础版mybatis-genarator

- 进阶版mybatis-plus-genarator

注意

- 使用起来和普通版的mybatis generator一样,但是这个纯代码,不用复杂xml配置

- 任何框架,不要使用过多的侵入或者框架定制化深的内容,防止后续改动耦合性高,成本大

添加依赖

- 统一Common项目添加,各个项目测试类里面配置

<!-- 代码自动生成依赖 begin --><dependency><groupId>com.baomidou</groupId><artifactId>mybatis-plus-generator</artifactId><version>3.4.1</version></dependency><!-- velocity --><dependency><groupId>org.apache.velocity</groupId><artifactId>velocity-engine-core</artifactId><version>2.0</version></dependency><!-- 代码自动生成依赖 end-->

- 代码(标记TODO的记得修改)

package com.example.db;import com.baomidou.mybatisplus.annotation.DbType;import com.baomidou.mybatisplus.annotation.IdType;import com.baomidou.mybatisplus.generator.AutoGenerator;import com.baomidou.mybatisplus.generator.config.DataSourceConfig;import com.baomidou.mybatisplus.generator.config.GlobalConfig;import com.baomidou.mybatisplus.generator.config.PackageConfig;import com.baomidou.mybatisplus.generator.config.StrategyConfig;import com.baomidou.mybatisplus.generator.config.rules.DateType;import com.baomidou.mybatisplus.generator.config.rules.NamingStrategy;/*** @author yinxin* @version 1.0* @Description:* @date 2022/6/210:32*/public class MyBatisPlusGenerator {public static void main(String[] args) {//1. 全局配置GlobalConfig config = new GlobalConfig();// 是否支持AR模式config.setActiveRecord(true)// 作者.setAuthor("二当家小D")// 生成路径,最好使用绝对路径,window路径是不一样的//TODO TODO TODO TODO.setOutputDir("D:\\Code\\项目实战\\dcloud-short-link\\dcloud-account\\src\\main\\java")// 文件覆盖.setFileOverride(true)// 主键策略.setIdType(IdType.AUTO).setDateType(DateType.ONLY_DATE)// 设置生成的service接口的名字的首字母是否为I,默认Service是以I开头的.setServiceName("%sService")//实体类结尾名称.setEntityName("%sDO")//生成基本的resultMap.setBaseResultMap(true)//不使用AR模式.setActiveRecord(false)//生成基本的SQL片段.setBaseColumnList(true);//2. 数据源配置DataSourceConfig dsConfig = new DataSourceConfig();// 设置数据库类型dsConfig.setDbType(DbType.MYSQL).setDriverName("com.mysql.cj.jdbc.Driver")//TODO TODO TODO TODO.setUrl("jdbc:mysql://192.168.200.204:3306/cloud_account?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=Asia/Shanghai").setUsername("root").setPassword("root");//3. 策略配置globalConfiguration中StrategyConfig stConfig = new StrategyConfig();//全局大写命名stConfig.setCapitalMode(true)// 数据库表映射到实体的命名策略.setNaming(NamingStrategy.underline_to_camel)//使用lombok.setEntityLombokModel(true)//使用restcontroller注解.setRestControllerStyle(true)// 生成的表, 支持多表一起生成,以数组形式填写//TODO TODO TODO TODO.setInclude("account","traffic","traffic_task");//4. 包名策略配置PackageConfig pkConfig = new PackageConfig();pkConfig.setParent("com.example").setMapper("mapper").setService("service").setController("controller").setEntity("model").setXml("mapper");//5. 整合配置AutoGenerator ag = new AutoGenerator();ag.setGlobalConfig(config).setDataSource(dsConfig).setStrategy(stConfig).setPackageInfo(pkConfig);//6. 执行操作ag.execute();System.out.println("======= Done 相关代码生成完毕 ========");}}

导入生成好的代码

- model (为啥不放common项目,如果是确定每个服务都用到的依赖或者类才放到common项目)

- mapper 类接口拷贝

- resource/mapper文件夹 xml脚本拷贝

- controller

- service 不拷贝

- Mybatis plus配置控制台打印日志

#配置plus打印sql日志mybatis-plus:configuration:log-impl: org.apache.ibatis.logging.stdout.StdOutImpl

第5集 账号微服务注册Nacos+配置文件增加

简介:账号微服务注册Nacos+配置文件增加

启动账号微服务

排除sharding-jdbc依赖

<exclusions><exclusion><groupId>org.apache.shardingsphere</groupId><artifactId>sharding-jdbc-spring-boot-starter</artifactId></exclusion></exclusions>

增加main函数主类 ``` @MapperScan(“net.xdclass.mapper”) @EnableTransactionManagement @EnableFeignClients @EnableDiscoveryClient @SpringBootApplication public class AccountApplication {

public static void main(String[] args) { SpringApplication.run(AccountApplication.class, args); }

}

- 配置文件

cloud: nacos: discovery: server-addr: 120.79.150.146:8848 username: nacos password: nacos

datasource: driver-class-name: com.mysql.cj.jdbc.Driver url: jdbc:mysql://120.79.150.146:3306/dcloud_account?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=Asia/Shanghai username: root password: xdclass.net168

-多个微服务增加配置+代码生成配置映入 **愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="bd5a9492"></a>### 第八章 账号微服务注册模块+短信验证码+阿里云OSS开发实战<a name="91b73ba7"></a>#### 第1集 账号微服务注册功能和流程介绍**简介:介绍微服务注册功能和流程介绍**-功能需求- 使用手机号注册,已经注册的手机号不能重复注册,密码不能使用简单的MD5加密- 用户上传头像需要用文件存储-安全需求- 高并发下账号唯一性 注册邮箱或者手机验证码不能被恶意调用- 验证码+唯一索引- 头像文件存储访问方便扩容和管理- 阿里云OSS- 针对每个功能,初级开发和高级开发的思路是不一样- 产品经理提业务需求 安全需求就是自己的经验,不然最终背锅的还是自己- 高并发处理- 异步+池化思想-短链平台选择- 使用短信验证码注册- 头像存储使用阿里云OSS<a name="684a30ed"></a>#### 第2集 第三方短信验证码平台接入申请操作指引**简介:账号微服务短信验证码接入申请操作指引**-短信验证码平台选择考虑点- 各个类型短信价格- 短信到达率、到达时间- 短信内容变量灵活,方便支持多场景- 支持多种推广内容的短信发放,例如业务推广、新产品宣讲、会员关怀等内容的短信- 多维度数据统计-查看请求量、发送成功量、失败量、等-短信平台- 阿里云:[https://www.aliyun.com/product/sms](https://www.aliyun.com/product/sms)- 推荐- 腾讯云:[https://cloud.tencent.com/product/sms](https://cloud.tencent.com/product/sms)- 推荐- 第三方厂商:[https://market.aliyun.com/products/57000002/cmapi00046920.html](https://market.aliyun.com/products/57000002/cmapi00046920.html)- 提供测试模板、免审核、测试成本更低-选择申请接入-阿里云市场:[https://market.console.aliyun.com/imageconsole/index.htm](https://market.console.aliyun.com/imageconsole/index.htm)-参数

AppKey:204000913 AppSecret:UaIdIkE9gEdjeZRGYLpgOq5FYAAYBfbD 复制

AppCode:6999d4df3e7d48028470bbe517169a8d 复制

免费测试的模板ID: M72CB42894

<a name="fb63d971"></a>#### 第3集 账号微服务短信验证码发送工具类封装实战**简介:账号微服务短信验证码发送工具类封装实战**- RestTemplate配置

@Beanpublic RestTemplate restTemplate(ClientHttpRequestFactory factory) {return new RestTemplate(factory);}@Beanpublic ClientHttpRequestFactory simpleClientHttpRequestFactory() {SimpleClientHttpRequestFactory factory = new SimpleClientHttpRequestFactory();factory.setReadTimeout(10000);factory.setConnectTimeout(10000);return factory;}

- SmsConfig配置

—————sms短信配置———————

sms: app-code: 6999d4df3e7d48028470bbe517169a8d template-id: M72CB42894

@ConfigurationProperties(prefix = “sms”) @Configuration @Data public class SmsConfig {

private String templateId;private String appCode;

}

- SmsComponent工具类封装

private void send(String to, String templateId, String value) {

String url = String.format(urlTemplate, to, templateId, value);HttpHeaders headers = new HttpHeaders();//最后在header中的格式(中间是英文空格)为Authorization:APPCODE 83359fd73fe94948385f570e3c139105headers.set("Authorization", "APPCODE " + smsConfig.getAppCode());HttpEntity<String> entity = new HttpEntity<>(headers);ResponseEntity<String> response = restTemplate.exchange(url, HttpMethod.POST, entity, String.class);log.info("url={},body={}", url, response.getBody());if (response.getStatusCode() == HttpStatus.OK) {log.info("发送短信成功,响应信息:{}", response.getBody());} else {log.error("发送短信失败,响应信息:{}", response.getBody());}}

<a name="d762bb19"></a>#### 第4集 账号微服务短信验证码发送工具类单元测试**简介:账号微服务短信验证码发送工具类单元测试**- 单元测试

@RunWith(SpringRunner.class) @SpringBootTest(classes = AccountApplication.class) @Slf4j public class SmsTest {

@Autowiredprivate SmsComponent smsComponent;@Testpublic void testSendSms(){smsComponent.sendCode("13113777337","M72CB42894","223344");}

}

**愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="3d77e11d"></a>### 第九章 架构核心技术-池化思想-异步结合 性能优化最佳实践《上》<a name="a3e32de6"></a>#### 第1集 接口压测和常用压力测试工具对比**简介:目前用的常用测试工具对比**-LoadRunner- 性能稳定,压测结果及细粒度大,可以自定义脚本进行压测,但是太过于重大,功能比较繁多-Apache AB(单接口压测最方便)- 模拟多线程并发请求,ab命令对发出负载的计算机要求很低,既不会占用很多CPU,也不会占用太多的内存,但却会给目标服务器造成巨大的负载, 简单DDOS攻击等-Webbench- webbench首先fork出多个子进程,每个子进程都循环做web访问测试。子进程把访问的结果通过pipe告诉父进程,父进程做最终的统计结果。-Jmeter (GUI )- 开源免费,功能强大,在互联网公司普遍使用- 压测不同的协议和应用-1. Web - HTTP, HTTPS (Java, NodeJS, PHP, ASP.NET, …)-2. SOAP / REST Webservices-3. FTP-4. Database via JDBC-5. LDAP 轻量目录访问协议-6. Message-oriented middleware (MOM) via JMS-7. Mail - SMTP(S), POP3(S) and IMAP(S)-8. TCP等等- 使用场景及优点- 1)功能测试- 2)压力测试- 3)分布式压力测试- 4)纯java开发- 5)上手容易,高性能- 4)提供测试数据分析- 5)各种报表数据图形展示- 压测工具本地快速安装Jmeter5.x- 需要安装JDK8 以上- 建议安装JDK环境,虽然JRE也可以,但是压测https需要JDK里面的 keytool工具- 快速下载 [https://jmeter.apache.org/download_jmeter.cgi](https://jmeter.apache.org/download_jmeter.cgi)- 文档地址:[http://jmeter.apache.org/usermanual/get-started.html](http://jmeter.apache.org/usermanual/get-started.html)-目录

bin:核心可执行文件,包含配置

jmeter.bat: windows启动文件(window系统一定要配置显示文件拓展名)

jmeter: mac或者linux启动文件

jmeter-server:mac或者Liunx分布式压测使用的启动文件

jmeter-server.bat:window分布式压测使用的启动文件

jmeter.properties: 核心配置文件

extras:插件拓展的包

lib:核心的依赖包

-Jmeter语言版本中英文切换- 控制台修改 menu -> options -> choose language-配置文件修改- bin目录 -> jmeter.properties- 默认 #language=en- 改为 language=zh_CN<a name="53899add"></a>#### 第2集 Jmeter5.X基础功能组件介绍+线程组和Sampler**简介:讲解Jmeter里面GUI菜单栏主要组件**-添加->threads->线程组(控制总体并发)

线程数:虚拟用户数。一个虚拟用户占用一个进程或线程

准备时长(Ramp-Up Period(in seconds)):全部线程启动的时长,比如100个线程,20秒,则表示20秒内 100个线程都要启动完成,每秒启动5个线程

循环次数:每个线程发送的次数,假如值为5,100个线程,则会发送500次请求,可以勾选永远循环

-线程组->添加-> Sampler(采样器) -> Http (一个线程组下面可以增加几个Sampler)

名称:采样器名称 注释:对这个采样器的描述 web服务器: 默认协议是http 默认端口是80 服务器名称或IP :请求的目标服务器名称或IP地址

路径:服务器URL

-查看测试结果

线程组->添加->监听器->察看结果树 线程组->添加->监听器->聚合报告

-常规压测流程-内网环境-非GUI下压测-停止其他无关资源进程-压测机和被压测机器隔离<a name="518c0198"></a>#### 第3集 调用第三方服务组件改造+Jmeter5.x性能压测实践**简介:调用第三方服务组件改造+Jmeter5.x性能压测实践**-埋点http请求得出请求响应耗时【粗略统计,非线上大量数据测试得出】-增加代码NotifyController、NotifyService- test方法测试-压测参数配置- 200并发- 2秒启动- 循环500次-同步发送+resttemplate未池化- 错误:Connection timed out- 400到500 qps<a name="20e53c2c"></a>#### 第4集 高并发下异步请求解决方案- @Async注解应用实战**简介:高并发下异步请求解决方案一- @Async组件应用实战**-问题- 由于发送短信涉及到网络通信, 因此sendMessage方法可能会有一些延迟. 为了改善用户体验, 我们可以使用异步发送短信的方法-什么是异步任务- 异步调用是相对于同步调用而言的,同步调用是指程序按预定顺序一步步执行,每一步必须等到上一步执行完后才能执行,异步调用则无需等待上一步程序执行完即可执行- 多线程就是一种实现异步调用的方式- MQ也是一种宏观上的异步-使用场景- 适用于处理log、发送邮件、短信……等- 涉及到网络IO调用等操作-使用方式- 启动类里面使用@EnableAsync注解开启功能,自动扫描- 定义异步任务类并使用@Component标记组件被容器扫描,异步方法加上[@Async ](/Async )-注意:@Async失效情况-注解@Async的方法不是public方法-注解@Async的返回值只能为void或者Future-注解@Async方法使用static修饰也会失效-spring无法扫描到异步类,没加注解[@Async ](/Async ) 或 @EnableAsync注解-调用方与被调方不能在同一个类- Spring 在扫描bean的时候会扫描方法上是否包含@Async注解,动态地生成一个子类(即proxy代理类),当这个有注解的方法被调用的时候,实际上是由代理类来调用的,代理类在调用时增加异步作用- 如果这个有注解的方法是被同一个类中的其他方法调用的,那么该方法的调用并没有通过代理类,而是直接通过原来的那个 bean,所以就失效了- 所以调用方与被调方不能在同一个类,主要是使用了动态代理,同一个类的时候直接调用,不是通过生成的动态代理类调用- 一般将要异步执行的方法单独抽取成一个类-类中需要使用@Autowired或@Resource等注解自动注入,不能自己手动new对象-在Async 方法上标注@Transactional是没用的,但在Async 方法调用的方法上标注[@Transactional ](/Transactional ) 是有效的-编码实践

//启动类增加 @EnableAsync// @Override@Asyncpublic void testSend() {

// try { // TimeUnit.MILLISECONDS.sleep(2000); // } catch (InterruptedException e) { // e.printStackTrace(); // }

long beginTime = CommonUtil.getCurrentTimestamp();ResponseEntity<String> forEntity = restTemplate.getForEntity("http://old.xdclass.net", String.class);String body = forEntity.getBody();long endTime = CommonUtil.getCurrentTimestamp();log.info("耗时={},body={}",endTime-beginTime,body);}

<a name="81ed5763"></a>#### 第5集 异步调用-压测高QPS后的背后原因和问题拆解**简介:异步调用-压测高QPS后的背后原因和问题拆解**- 默认参数下压测结果-现象:压测后很快跑完全部内容,是因为都在线程池内部的阻塞队列里面-极容易出现OOM,或者消息丢失-默认8个核心线程数占用满了之后, 新的调用就会进入队列, 最大值是Integer.MAX_VALUE,表现为没有执行- task-XXX 日志里面会出现递增-设置下idea启动进程的jvm参数: -Xms50M -Xmx50M-代码位置- TaskExecutionProperties- TaskExecutionAutoConfiguration-说明:- 直接使用 [@Async ](/Async ) 注解没指定线程池的话,即未设置TaskExecutor时- 默认使用Spring创建ThreadPoolTaskExecutor- 核心线程数:8- 最大线程数:Integer.MAX_VALUE ( 21亿多)- 队列使用LinkedBlockingQueue- 容量是:Integer.MAX_VALUE- 空闲线程保留时间:60s- 线程池拒绝策略:AbortPolicy-如何解决上面说的问题?<a name="066a590f"></a>#### 第6集 【底层原理】Async+ThreadPoolTaskExecutor自定义线程池进阶实战**简介:高并发下异步请求 @Async+ThreadPoolTaskExecutor自定义线程池实战**- 自定义线程池可以解决上述的问题-大家的疑惑 使用线程池的时候搞混淆ThreadPoolTaskExecutor和ThreadPoolExecutor-ThreadPoolExecutor,这个类是JDK中的线程池类,继承自Executor,里面有一个execute()方法,用来执行线程,线程池主要提供一个线程队列,队列中保存着所有等待状态的线程,避免了创建与销毁的额外开销-ThreadPoolTaskExecutor,是spring包下的,是Spring为我们提供的线程池类- Spring异步线程池的接口类是TaskExecutor,本质还是java.util.concurrent.Executor-解决方式- spring会先搜索TaskExecutor类型的bean或者名字为taskExecutor的Executor类型的bean,- 所以我们最好来自定义一个线程池,加入Spring IOC容器里面,即可覆盖-自定义线程池

@Configuration @EnableAsync public class ThreadPoolTaskConfig {

@Bean("threadPoolTaskExecutor")public ThreadPoolTaskExecutor threadPoolTaskExecutor(){ThreadPoolTaskExecutor threadPoolTaskExecutor = new ThreadPoolTaskExecutor();//线程池创建的核心线程数,线程池维护线程的最少数量,即使没有任务需要执行,也会一直存活//如果设置allowCoreThreadTimeout=true(默认false)时,核心线程会超时关闭threadPoolTaskExecutor.setCorePoolSize(4);//最大线程池数量,当线程数>=corePoolSize,且任务队列已满时。线程池会创建新线程来处理任务//当线程数=maxPoolSize,且任务队列已满时,线程池会拒绝处理任务而抛出异常threadPoolTaskExecutor.setMaxPoolSize(8);//缓存队列(阻塞队列)当核心线程数达到最大时,新任务会放在队列中排队等待执行threadPoolTaskExecutor.setQueueCapacity(124);//当线程空闲时间达到keepAliveTime时,线程会退出,直到线程数量=corePoolSize//允许线程空闲时间60秒,当maxPoolSize的线程在空闲时间到达的时候销毁//如果allowCoreThreadTimeout=true,则会直到线程数量=0threadPoolTaskExecutor.setKeepAliveSeconds(30);//spring 提供的 ThreadPoolTaskExecutor 线程池,是有setThreadNamePrefix() 方法的。//jdk 提供的ThreadPoolExecutor 线程池是没有 setThreadNamePrefix() 方法的threadPoolTaskExecutor.setThreadNamePrefix("小滴课堂Spring自带Async前缀:");threadPoolTaskExecutor.setWaitForTasksToCompleteOnShutdown(true);// rejection-policy:当pool已经达到max size的时候,如何处理新任务// CallerRunsPolicy():交由调用方线程运行,比如 main 线程;如果添加到线程池失败,那么主线程会自己去执行该任务,不会等待线程池中的线程去执行

//AbortPolicy():该策略是线程池的默认策略,如果线程池队列满了丢掉这个任务并且抛出RejectedExecutionException异常。 //DiscardPolicy():如果线程池队列满了,会直接丢掉这个任务并且不会有任何异常 //DiscardOldestPolicy():丢弃队列中最老的任务,队列满了,会将最早进入队列的任务删掉腾出空间,再尝试加入队列

threadPoolTaskExecutor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());threadPoolTaskExecutor.initialize();return threadPoolTaskExecutor;}

}

//使用实战, 启动类可以不加@EnableAsync,改上面加 @Async(“threadPoolTaskExecutor”)

- 总结【方便记忆】- 先是CorePoolSize是否满足,然后是Queue阻塞队列是否满,最后才是MaxPoolSize是否满足<a name="cc4e1083"></a>#### 第7集 ThreadPoolTaskExecutor线程池的面试题你知道怎么回答不**简介:ThreadPoolTaskExecutor线程池的面试题你知道怎么回答不**-请你说下 ThreadPoolTaskExecutor线程池 有哪几个重要参数,什么时候会创建线程- 查看核心线程池是否已满,不满就创建一条线程执行任务,否则执行第二步。- 查看阻塞队列是否已满,不满就将任务存储在阻塞队列中,否则执行第三步。- 查看线程池是否已满,即是否达到最大线程池数,不满就创建一条线程执行任务,否则就按照策略处理无法执行的任务。-高并发下核心线程怎么设置?-分IO密集还是CPU密集- CPU密集设置为跟核心数一样大小- IO密集型设置为2倍CPU核心数-非固定,根据实际情况压测进行调整,俗称【调参程序员】【调参算法工程师】<a name="dd20ff47"></a>#### 第8集 实践出真知-线程池多参数调整-性能压测+现象对比分析**简介:实践出真知-线程池多参数调整-现象报告对比分析**-异步发送 + resttemplate未池化- 线程池参数

threadPoolTaskExecutor.setCorePoolSize(4); threadPoolTaskExecutor.setMaxPoolSize(16); threadPoolTaskExecutor.setQueueCapacity(32);

- qps少,等待队列小-异步发送+resttemplate未池化- 线程池参数

threadPoolTaskExecutor.setCorePoolSize(32); threadPoolTaskExecutor.setMaxPoolSize(64); threadPoolTaskExecutor.setQueueCapacity(10000); //如果等待队列长度为10万,则qps瞬间很高8k+,可能oom

- qps,等待队列大(瞬间高)-问题- 采用异步发送用户体验变好了,但是存在丢失的可能,阻塞队列存储内存中,如果队列长度过多则重启容易出现丢失数据情况- 采用了异步发送了+阻塞队列存缓冲,刚开始瞬间QPS高,但是后续也降低很多- 问题是在哪里?消费方角度,提高消费能力 **愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="739935b1"></a>### 第十章 架构核心技术-池化思想-异步结合 性能优化最佳实践《下》<a name="39662d8f"></a>#### 第1集 RestTemplate里面的存在的问题你知道多少- Broken pipe错误**简介: RestTemplate里面的存在的问题你知道多少**-还原代码(暂时不用异步)- 异步-里面是用线程池-是池化思想的一种应用-同步发送+resttemplate未池化-压测结果 几百吞吐量-错误Caused by: java.io.IOException: Broken pipe- 服务端向前端socket连接管道写返回数据时 链接(pipe)却断开了- 从应用角度分析,这是因为客户端等待返回超时了,主动断开了与服务端链接- 连接数设置太小,并发量增加后,造成大量请求排队等待- 网络延迟,是否有丢包- 内存是否足够多支持对应的并发量-问题分析- resttemplate底层是怎样的?- 基于之前的认知-池化思想,联想到是否使用了http连接池?-重新认识RestTemplate- RestTemplate是Spring提供的用于访问Rest服务的客户端- 底层通过使用java.net包下的实现创建HTTP 请求- 通过使用ClientHttpRequestFactory指定不同的HTTP请求方式,主要提供了两种实现方式- SimpleClientHttpRequestFactory(默认)- 底层使用J2SE提供的方式,既java.net包提供的方式,创建底层的Http请求连接- 主要createRequest 方法( 断点调试),每次都会创建一个新的连接,每次都创建连接会造成极大的资源浪费,而且若连接不能及时释放,会因为无法建立新的连接导致后面的请求阻塞- HttpComponentsClientHttpRequestFactory- 底层使用HttpClient访问远程的Http服务-问题解决- 客户端每次请求都要和服务端建立新的连接,即三次握手将会非常耗时- 通过http连接池可以减少连接建立与释放的时间,提升http请求的性能- Spring的restTemplate是对httpclient进行了封装, 而httpclient是支持池化机制- 拓展- 对httpclient进行封装的有:Apache的Fluent、es的restHighLevelClient、spring的restTemplate等<a name="11d9dbe0"></a>#### 第2集 高性能RestTemplate连接池封装配置实战**简介: 高性能RestTemplate封装配置实战**- 配置RestTemplate连接池实战

@Bean public RestTemplate restTemplate(ClientHttpRequestFactory factory) { return new RestTemplate(factory); }

@Beanpublic ClientHttpRequestFactory httpRequestFactory() {return new HttpComponentsClientHttpRequestFactory(httpClient());}/*** @return*/@Beanpublic HttpClient httpClient() {Registry<ConnectionSocketFactory> registry = RegistryBuilder.<ConnectionSocketFactory>create().register("http", PlainConnectionSocketFactory.getSocketFactory()).register("https", SSLConnectionSocketFactory.getSocketFactory()).build();PoolingHttpClientConnectionManager connectionManager = new PoolingHttpClientConnectionManager(registry);//设置整个连接池最大连接数connectionManager.setMaxTotal(500);//MaxPerRoute路由是对maxTotal的细分,每个主机的并发,这里route指的是域名connectionManager.setDefaultMaxPerRoute(200);RequestConfig requestConfig = RequestConfig.custom()//返回数据的超时时间.setSocketTimeout(20000)//连接上服务器的超时时间.setConnectTimeout(10000)//从连接池中获取连接的超时时间.setConnectionRequestTimeout(1000).build();return HttpClientBuilder.create().setDefaultRequestConfig(requestConfig).setConnectionManager(connectionManager).build();}

<a name="3bc2feee"></a>#### 第3集 【10倍+QPS提升】Jmeter5.x压测 优化后RestTemplate前后性能对比**简介: 【10倍+提升】Jmeter5.x压测 优化后RestTemplate前后性能对比**-同步发送+resttemplate未池化- 压测结果 几百 吞吐量-同步发送+resttemplate池化- 压测结果-检查你自己公司的项目,是否存在对应的问题- 这些都是面试跳槽里面-项目的亮点- 发现问题- 找出原因- 解决问题 **愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="458c965d"></a>### 第十一章 账号微服务-发送短信验证码-池化+异步结合最佳实践<a name="3a5e785e"></a>#### 第1集 调用第三方短信验证码组件性能优化实战**简介:调用第三方短信验证码组件性能优化实战**-调整代码-采用异步调用方式-采用 resttemplate池化方式-对比第一个高并发项目大课- 海量数据项目大课更加偏底层+性能优化- 两个大课有部分接口是重复的,但是虽然是同个接口-大家可以压测对比下两个接口的性能<a name="cf97a9ed"></a>#### 第2集 说说小滴课堂之前的被薅羊毛的事情+防范解决方案**简介: 说说小滴课堂前不久的被薅羊毛的事情+防范解决方案**- 请大家先看一个自动化脚本技术视频- 第2分35秒:[https://xdclass.net/#/dplayer?video_id=16&e_id=1000](https://xdclass.net/#/dplayer?video_id=16&e_id=1000)- 延伸- 抢票- 稀缺的酒、鞋等-短信邮箱轰炸机- 什么是短信-邮箱轰炸机:

手机短信轰炸机是批量、循环给手机无限发送各种网站的注册验证码短信的方法。

- 美好的初衷-发明的由来

最早发明是用来整治街头广告电话号泛滥的一种手段,采用“手机短信轰炸机”软件可无限发送垃圾短信到牛皮癣小广告的手机号码上,使对方的手机快速消耗电量,变成高频率振动棒,且无法正常使用。

“短信轰炸机”可严厉打击城市“牛皮癣”,还城市明净容颜。

- 灰色产业的目光-也就是部分不法分子利用

某次大型程序员相亲现场-老王得罪了小王, 小王不爽,就道听途说知道了”短信轰炸机“,1天50元,轰炸了5天还打折300元。

一天内接到来自全国各地数千个陌生电话短信的轰炸骚扰,导致个人通讯中断,被工作生活受到严重影响,连刚相亲到的女友没没法联系上了。

-原理

很多人都用手机注册一些网站的验证了,比如手机验证码。先填手机号,然后发一条验证码过去,输入验证码,完成验证,注册成功。

寻找大量肉鸡网站,寻找发送验证码的请求接口

如果找不到接口,也可以使用自动化UI工具触发

编写程序和调度任务,相关脚本录入数据库

输入目标手机号或者邮箱,触发攻击 ```

公司带来的损失

- 短信一条5分钱,如果被大量盗刷大家自己计算

- 邮箱通知不用钱,但被大量盗刷,带宽、连接等都被占用,导致无法正常使用

如何避免自己的网站成为”肉鸡“或者被刷呢

- 增加图形验证码(开发人员)

- 单IP请求次数限制(开发人员)

- 限制号码发送(一般短信提供商会做)

是否可以一劳永逸???

没有百分百的安全,验证码是可以破解的,ip也是可以租用代理ip的

攻防永远是有的,只过加大了攻击者的成本,ROI划不过来自然就放弃了

小滴课堂注册页面-短信验证码没加防范,被刷了,也不知道意图如何,反正就亏了几万块吧

第3集 图形验证码开发之谷歌kaptcha引入

简介:谷歌开源kaptcha图形验证码开发

Kaptcha 框架介绍 谷歌开源的一个可高度配置的实用验证码生成工具

- 验证码的字体/大小/颜色

- 验证码内容的范围(数字,字母,中文汉字!)

- 验证码图片的大小,边框,边框粗细,边框颜色

- 验证码的干扰线

- 验证码的样式(鱼眼样式、3D、普通模糊)

- 聚合工程依赖添加(使用国内baomidou二次封装的springboot整合starter)

<!--kaptcha依赖包--><dependency><groupId>com.baomidou</groupId><artifactId>kaptcha-spring-boot-starter</artifactId><version>1.1.0</version></dependency>

- 账号微服务添加

<dependency><groupId>com.baomidou</groupId><artifactId>kaptcha-spring-boot-starter</artifactId></dependency>

- 开发配置(任何框架和springboot整合基本都是)

@Configurationpublic class CaptchaConfig {/*** 验证码配置* Kaptcha配置类名** @return*/@Bean@Qualifier("captchaProducer")public DefaultKaptcha kaptcha() {DefaultKaptcha kaptcha = new DefaultKaptcha();Properties properties = new Properties();// properties.setProperty(Constants.KAPTCHA_BORDER, "yes");// properties.setProperty(Constants.KAPTCHA_BORDER_COLOR, "220,220,220");// //properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_FONT_COLOR, "38,29,12");// properties.setProperty(Constants.KAPTCHA_IMAGE_WIDTH, "147");// properties.setProperty(Constants.KAPTCHA_IMAGE_HEIGHT, "34");// properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_FONT_SIZE, "25");// //properties.setProperty(Constants.KAPTCHA_SESSION_KEY, "code");//验证码个数properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_CHAR_LENGTH, "4");// properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_FONT_NAMES, "Courier");//字体间隔properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_CHAR_SPACE,"8");//干扰线颜色// properties.setProperty(Constants.KAPTCHA_NOISE_COLOR, "white");//干扰实现类properties.setProperty(Constants.KAPTCHA_NOISE_IMPL, "com.google.code.kaptcha.impl.NoNoise");//图片样式properties.setProperty(Constants.KAPTCHA_OBSCURIFICATOR_IMPL, "com.google.code.kaptcha.impl.WaterRipple");//文字来源properties.setProperty(Constants.KAPTCHA_TEXTPRODUCER_CHAR_STRING, "0123456789");Config config = new Config(properties);kaptcha.setConfig(config);return kaptcha;}}

- 开发一个Controller使用测试

第4集 池化思想应用-Redis6.X配置连接池实战

简介:池化思想应用-Redis6.X配置连接池实战

连接池好处

- 使用连接池不用每次都走三次握手、每次都关闭Jedis

- 相对于直连,使用相对麻烦,在资源管理上需要很多参数来保证,规划不合理也会出现问题

- 如果pool已经分配了maxActive个jedis实例,则此时pool的状态就成exhausted了

连接池配置 common项目

<!--redis客户端--><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-data-redis</artifactId><exclusions><exclusion><groupId>io.lettuce</groupId><artifactId>lettuce-core</artifactId></exclusion></exclusions></dependency><dependency><groupId>redis.clients</groupId><artifactId>jedis</artifactId></dependency><dependency><groupId>org.apache.commons</groupId><artifactId>commons-pool2</artifactId></dependency>

- 配置Redis连接

redis:client-type: jedishost: 120.79.150.146password: xdclass.netport: 6379jedis:pool:# 连接池最大连接数(使用负值表示没有限制)max-active: 100# 连接池中的最大空闲连接max-idle: 100# 连接池中的最小空闲连接min-idle: 100# 连接池最大阻塞等待时间(使用负值表示没有限制)max-wait: 60000

- 序列化配置

@Configurationpublic class RedisTemplateConfiguration {/*** @param redisConnectionFactory* @return*/@Beanpublic RedisTemplate<Object, Object> redisTemplate(RedisConnectionFactory redisConnectionFactory) {RedisTemplate<Object, Object> redisTemplate = new RedisTemplate<>();redisTemplate.setConnectionFactory(redisConnectionFactory);// 使用Jackson2JsonRedisSerialize 替换默认序列化Jackson2JsonRedisSerializer jackson2JsonRedisSerializer = new Jackson2JsonRedisSerializer(Object.class);ObjectMapper objectMapper = new ObjectMapper();objectMapper.setVisibility(PropertyAccessor.ALL, JsonAutoDetect.Visibility.ANY);jackson2JsonRedisSerializer.setObjectMapper(objectMapper);// 设置key和value的序列化规则redisTemplate.setKeySerializer(new StringRedisSerializer());redisTemplate.setValueSerializer(jackson2JsonRedisSerializer);// 设置hashKey和hashValue的序列化规则redisTemplate.setHashKeySerializer(new StringRedisSerializer());redisTemplate.setHashValueSerializer(jackson2JsonRedisSerializer);return redisTemplate;}}

第5集 账号微服务开发图形验证码加入缓存+Try-with-resource知识巩固

简介:账号微服务开发图形验证码接口+Try-with-resource知识巩固

redis做隔离, 多集群:核心集群和非核心集群,高并发集群和非高并发集群

- 资源隔离

- 数据保护

- 提高性能

key规范:业务划分,冒号隔离

- account-service:captcha:xxxx

- 长度不能过长

- 验证码接口开发

/***临时使用10分钟有效,方便测试*/private static final long CAPTCHA_CODE_EXPIRED = 60 * 1000 * 10;/*** 获取图形验证码* @param request* @param response*/@GetMapping("captcha")public void getCaptcha(HttpServletRequest request, HttpServletResponse response) {String captchaText = captchaProducer.createText();log.info("图形验证码:{}", captchaText);//存储redisTemplate.opsForValue().set(getCaptchaKey(request),captchaText, CAPTCHA_CODE_EXPIRED, TimeUnit.MILLISECONDS);BufferedImage bufferedImage = captchaProducer.createImage(captchaText);try (ServletOutputStream outputStream = response.getOutputStream()){ImageIO.write(bufferedImage, "jpg", outputStream);outputStream.flush();} catch (IOException e) {log.error("获取图形验证码异常:{}", e);}}

什么是try-with-resources

- 资源的关闭很多⼈停留在旧的流程上,jdk7新特性就有, 但是很多⼈以为是jdk8的

- 在try( …)⾥声 明的资源,会在try-catch代码块结束后⾃动关闭掉

注意点

- 实现了AutoCloseable接⼝的类,在try()⾥声明该类实例的时候,try结束后⾃动调⽤的 close⽅法,这个动作会早于finally⾥调⽤的⽅法

- 不管是否出现异常,try()⾥的实例都会被调⽤close⽅法

- try⾥⾯可以声明多个⾃动关闭的对象,越早声明的对象,会越晚被close掉

第6集 账号微服务之注册短信验证码接口开发

简介:注册短信验证码接口开发

- 接口开发

- service层

@Overridepublic JsonData sendCode(SendCodeEnum sendCodeType, String to) {if(CheckUtil.isEmail(to)){//邮箱验证码}else if(CheckUtil.isPhone(to)){//短信验证码}return JsonData.buildResult(BizCodeEnum.CODE_TO_ERROR);}

- 邮箱工具类正则

public class CheckUtil {/*** 邮箱正则*/private static final Pattern MAIL_PATTERN = Pattern.compile("^([a-z0-9A-Z]+[-|\\.]?)+[a-z0-9A-Z]@([a-z0-9A-Z]+(-[a-z0-9A-Z]+)?\\.)+[a-zA-Z]{2,}$");/*** 手机号正则*/private static final Pattern PHONE_PATTERN = Pattern.compile("^((13[0-9])|(14[0-9])|(15[0-9])|(17[0-9])|(18[0-9]))\\d{8}$");/*** @param email* @return*/public static boolean isEmail(String email) {if (null == email || "".equals(email)) {return false;}Matcher m = MAIL_PATTERN.matcher(email);return m.matches();}/**** @param phone* @return*/public static boolean isPhone(String phone) {if (null == phone || "".equals(phone)) {return false;}Matcher m = PHONE_PATTERN.matcher(phone);boolean result = m.matches();return result;}}

第7集 关于注册短信验证码防刷设计方案你能想到几个

简介:注册短信验证码防刷方案你能想到几个

需求:一定时间内禁止重复发送短信,大家想下有哪几种实现方式

两个时间要求

- 60秒后才可以重新发送短信验证码

- 发送的短信验证码10分钟内有效

方式一:前端增加校验倒计时,不到60秒按钮不给点击

- 简单

- 不安全,存在绕过的情况

方式二:增加Redis存储,发送的时候设置下额外的key,并且60秒后过期

非原子操作,存在不一致性

增加的额外的key - value存储,浪费空间

/*** 前置:判断是否重复发送** 1、存储验证码到缓存** 2、发送短信验证码** 后置:存储发送记录**/

方式三:基于原先的key拼装时间戳

- 好处:满足了当前节点内的原子性,也满足业务需求

第8集 【重要】注册邮箱验证码防刷代码落地+整体测试

简介:注册邮箱验证码防刷落地和整体测试

@Overridepublic JsonData sendCode(SendCodeEnum sendCodeEnum, String to) {String cacheKey = String.format(RedisKey.CHECK_CODE_KEY,sendCodeEnum.name(),to);String cacheValue = redisTemplate.opsForValue().get(cacheKey);//如果不为空,再判断是否是60秒内重复发送 0122_232131321314132if(StringUtils.isNotBlank(cacheValue)){long ttl = Long.parseLong(cacheKey.split("_")[1]);//当前时间戳-验证码发送的时间戳,如果小于60秒,则不给重复发送long leftTime = CommonUtil.getCurrentTimestamp() - ttl;if( leftTime < (1000*60)){log.info("重复发送短信验证码,时间间隔:{}秒",leftTime);return JsonData.buildResult(BizCodeEnum.CODE_LIMITED);}}String code = CommonUtil.getRandomCode(6);//生成拼接好验证码String value = code+"_"+CommonUtil.getCurrentTimestamp();redisTemplate.opsForValue().set(cacheKey,value,CODE_EXPIRED,TimeUnit.MILLISECONDS);if(CheckUtil.isEmail(to)){//发送邮箱验证码 TODO}else if(CheckUtil.isPhone(to)){//发送手机验证码smsComponent.send(to,smsConfig.getTemplateId(),code);}return JsonData.buildSuccess();}

- 整体测试和总结

愿景:”让编程不再难学,让技术与生活更加有趣”

愿景:”让编程不再难学,让技术与生活更加有趣”

更多架构课程请访问 xdclass.net

第十二章 账号微服务-阿里云OSS接入实战

第1集 分布式文件存储业界常见解决方案介绍

简介:分布式文件存储常见解决方案介绍

目前业界比较多这个解决方案,这边就挑选几个介绍下

- MinIO ``` 是在 Apache License v2.0 下发布的对象存储服务器,学习成本低,安装运维简单,主流语言的客户端整合都有, 号称最强的对象存储文件服务器,且可以和容器化技术docker/k8s等结合,社区活跃但不够成熟,业界参考资料较少

- FastDFS

一个开源的轻量级分布式文件系统,比较少的客户端可以整合,目前主要是C和java客户端,在一些互联网创业公司中有应用比较多,没有官方文档,社区不怎么活跃. 架构+部署结构复杂,出问题定位比较难定位,可以说是fastdfs零件的组装过程,需要去理解fastDFS的架构设计,才能够正确的安装部署

-云厂商-阿里云OSS-七牛云-腾讯云-亚马逊云-CDN最强:Akamai [https://www.akamai.com/cn](https://www.akamai.com/cn)-选云厂商理由- 优点:开发简单,功能强大,容易维护(不同网络下图片质量、水印、加密策略、扩容、加速)- 缺点:要钱, 个性化处理,未来转移比较复杂,不排除有些厂商会提供一键迁移工具-选开源MinIO的理由- 优点:功能强大、可以根据业务做二次的定制,新一代分布式文件存储系统,容器化结合强大,更重要的是免费(购买磁盘、内存、带宽)- 缺点:自己需要有专门的团队进行维护、扩容等-文件上传流程- web控制台- 前端->后端程序->阿里云OSS<a name="58477ac9"></a>#### 第2集 阿里云OSS分布式对象存储介绍开通**简介:阿里云OSS对象存储介绍和开通**- 阿里云OSS介绍

对象存储OSS(Object Storage Service)是阿里云提供的海量、安全、低成本、高持久的云存储服务。其数据设计持久性不低于99.9999999999%(12个9),服务设计可用性不低于99.995%。

OSS具有与平台无关的RESTful API接口,您可以在任何应用、任何时间、任何地点存储和访问任意类型的数据。

提供标准、低频访问、归档和冷归档四种存储类型,全面覆盖从热到冷的各种数据存储场景:

| 标准存储类型 | 高持久、高可用、高性能的对象存储服务,支持频繁的数据访问。是各种社交、分享类的图片、音视频应用、大型网站、大数据分析的合适选择。 || --- | --- || 低频访问存储类型 | 适合长期保存不经常访问的数据(平均每月访问频率1到2次)。存储单价低于标准类型,适合各类移动应用、智能设备、企业数据的长期备份,支持实时数据访问。 || 归档存储类型 | 适合需要长期保存(建议半年以上)的归档数据,在存储周期内极少被访问,数据进入到可读取状态需要1分钟的解冻时间。适合需要长期保存的档案数据、医疗影像、科学资料、影视素材。 || 冷归档存储类型 | 适合需要超长时间存放的极冷数据。例如因合规要求需要长期留存的数据、大数据及人工智能领域长期积累的原始数据、影视行业长期留存的媒体资源、在线教育行业的归档视频等。 |-开通阿里云OSS-有阿里云账号、实名认证-OSS介绍:[https://www.aliyun.com/product/oss](https://www.aliyun.com/product/oss)-OSS控制台:[https://oss.console.aliyun.com/bucket](https://oss.console.aliyun.com/bucket)-学习路径:[https://help.aliyun.com/learn/learningpath/oss.html](https://help.aliyun.com/learn/learningpath/oss.html)-开通后的操作- 创建Bucket- 上传文件- 访问文件<a name="cf67ccb2"></a>#### 第3集 权限知识 RBAC-ACL模式应用之阿里云RAM访问控制**简介:权限知识 RBAC-ACL模式应用之阿里云RAM访问控制**-ACL: Access Control List 访问控制列表- 以前盛行的一种权限设计,它的核心在于用户直接和权限挂钩- 优点:简单易用,开发便捷- 缺点:用户和权限直接挂钩,导致在授予时的复杂性,比较分散,不便于管理- 例子:常见的文件系统权限设计, 直接给用户加权限-RBAC: Role Based Access Control- 基于角色的访问控制系统。权限与角色相关联,用户通过成为适当角色的成员而得到这些角色的权限- 优点:简化了用户与权限的管理,通过对用户进行分类,使得角色与权限关联起来- 缺点:开发对比ACL相对复杂- 例子:基于RBAC模型的权限验证框架与应用 Apache Shiro、spring Security-总结:不能过于复杂,规则过多,维护性和性能会下降, 更多分类 ABAC、PBAC等-RAM权限介绍-阿里云用于各个产品的权限,基于RBAC、ACL模型都有,进行简单管理账号、统一分配权限、集中管控资源,从而建立安全、完善的资源控制体系。-众多产品,一般采用子账号进行分配权限,防止越权攻击<br />-建立用户,勾选编程访问(保存accessKey和accessSecret,只出现一次)- 用户登录名称 [dcloud_link@1701673122790560.onaliyun.com](mailto:dcloud_link@1701673122790560.onaliyun.com)<br />AccessKey ID : LTAI5tHVGvYw7twoVFyruB1H<br />AccessKey Secret : r4d0EudzSvPfVMb9Zp0TfmsE32RXmN-为新建用户授权OSS全部权限<a name="39aa066b"></a>#### 第4集 阿里云OSS客户端SDK集成和上传组件功能开发**简介:阿里云OSS对象存储客户端集成和测试服务**-添加阿里云OSS的SDK-地址:[https://help.aliyun.com/document_detail/32008.html](https://help.aliyun.com/document_detail/32008.html)-添加maven依赖- 底层聚合工程添加版本

<dependency><groupId>com.aliyun.oss</groupId><artifactId>aliyun-sdk-oss</artifactId><version>3.10.2</version></dependency>

- 账号微服务添加

<dependency><groupId>com.aliyun.oss</groupId><artifactId>aliyun-sdk-oss</artifactId></dependency>

-账号微服务配置OSS

阿里云OSS配置

aliyun: oss: endpoint: oss-cn-guangzhou.aliyuncs.com access-key-id: LTAI5tHVGvYw7twoVFyruB1H access-key-secret: r4d0EudzSvPfVMb9Zp0TfmsE32RXmN bucketname: dcloud-link

- 新建配置类 (配置里面的横杠会,自动转驼峰)

@ConfigurationProperties(prefix = “aliyun.oss”) @Configuration @Data public class OSSConfig {

private String endpoint;private String accessKeyId;private String accessKeySecret;private String bucketname;

}

-开发controller-开发service

@Service @Slf4j public class FileServiceImpl implements FileService {

@Autowiredprivate OSSConfig ossConfig;@Overridepublic String uploadUserImg(MultipartFile file) {//获取相关配置String bucketname = ossConfig.getBucketname();String endpoint = ossConfig.getEndpoint();String accessKeyId = ossConfig.getAccessKeyId();String accessKeySecret = ossConfig.getAccessKeySecret();//创建OSS对象OSS ossClient = new OSSClientBuilder().build(endpoint, accessKeyId, accessKeySecret);//获取原生文件名 xxx.jpgString originalFileName = file.getOriginalFilename();//JDK8的日期格式LocalDateTime ldt = LocalDateTime.now();DateTimeFormatter dtf = DateTimeFormatter.ofPattern("yyyy/MM/dd");//拼装路径,oss上存储的路径 user/2022/12/1/sdfdsafsdfdsf.jpgString folder = dtf.format(ldt);String fileName = CommonUtil.generateUUID();String extension = originalFileName.substring(originalFileName.lastIndexOf("."));// 在OSS上的bucket下创建 user 这个文件夹String newFileName = "user/"+folder+"/"+fileName+ extension;try {PutObjectResult putObjectResult = ossClient.putObject(bucketname,newFileName,file.getInputStream());//拼装返回路径if(putObjectResult != null){String imgUrl = "https://"+bucketname+"."+endpoint+"/"+newFileName;return imgUrl;}} catch (IOException e) {log.error("文件上传失败:{}",e);} finally {//oss关闭服务,不然会造成OOMossClient.shutdown();}return null;}

}

<a name="42cda4f8"></a>#### 第5集 账号微服务头像上传阿里云OSS接口和PostMan测试**简介: 账号微服务头像上传阿里云OSS接口和PostMan测试**-文件上传流程- 先上传文件,返回url地址,再和普通表单一并提交(推荐这种,更加灵活,失败率低)- 文件和普通表单一并提交(设计流程比较多,容易超时和失败)-注意:默认SpringBoot最大文件上传是1M,大家测试的时候记得关注下-开发controller- @requestPart注解 接收文件以及其他更为复杂的数据类型

/**

* 上传用户头像** 默认文件大小 1M,超过会报错** @param file* @return*/

@PostMapping(value = “upload”) public JsonData uploadHeaderImg(@RequestPart(“file”) MultipartFile file){

String result = fileService.uploadUserHeadImg(file);return result != null?JsonData.buildSuccess(result):JsonData.buildResult(BizCodeEnum.FILE_UPLOAD_USER_IMG_FAIL);}

**愿景:"让编程不再难学,让技术与生活更加有趣" ****更多架构课程请访问 xdclass.net**<a name="e3363686"></a>### 第十三章 账号微服务注册-登录功能开发完善<a name="eb446409"></a>#### 第1集 账号微服务注册功能业务介绍和代码编写**简介:账号微服务注册接口介绍和业务代码编写**-微服务注册接口开发- 请求实体类编写- controller- service- 手机验证码验证- 密码加密(TODO)- 账号唯一性检查(TODO)- 插入数据库- 新注册用户福利发放(TODO)- mapper-密码存储安全- 彩虹表暴力破解- 网站:[https://www.cmd5.com/](https://www.cmd5.com/)- 密码存储常用方式- 双重MD5- MD5+加盐- 双重MD5+加盐<a name="14060ec2"></a>#### 第2集 注册手机号唯一性保证方案和作业-分库分表下的思考**简介:注册手机号唯一性安全保证方案和作业-分库分表下的思考**-注册业务- 同个时刻注册,需要保证注册手机号在数据库里唯一-高并发下问题发现扩大- 万分之一的时间,放大100万倍- 不是你的代码安全,而是你的并发量过少,几个几十个并发量发现不了问题- 几十万几百万并发 ,线下难模拟- 代码暂停思维:假如非原子性代码运行到某一行暂停,其他线程重新操作是否会出问题- 时间扩大思维:1纳秒的时间,扩大到1分钟,代码逻辑是否会有问题- 类似幂等性处理-Redis:先看redis是否有,然后没的话则是新的注册- key -value 存储, 配置60秒过期- 非原子性操作,存在不一致-数据库唯一索引(建表的时间已经添加)

CREATE TABLE account (

id bigint unsigned NOT NULL AUTO_INCREMENT,

account_no bigint DEFAULT NULL,

head_img varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘头像’,

phone varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘手机号’,

pwd varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘密码’,

secret varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘盐,用于个人敏感信息处理’,

mail varchar(128) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘邮箱’,

username varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘用户名’,

auth varchar(32) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin DEFAULT NULL COMMENT ‘认证级别,DEFAULT,REALNAME,ENTERPRISE,访问次数不一样’,

gmt_create datetime DEFAULT CURRENT_TIMESTAMP,

gmt_modified datetime DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

PRIMARY KEY (id),

UNIQUE KEY uk_phone (phone) USING BTREE,

UNIQUE KEY uk_account (account_no) USING BTREE

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin;

-留个作业-分库分表下- 手机号唯一性保证怎么做?-知乎讨论:[https://www.zhihu.com/people/xdclass/asks](https://www.zhihu.com/people/xdclass/asks)<a name="67fafe60"></a>#### 第3集 账号微服务开发之登录模块逻辑和解密**简介:账号微服务登录模块开发**- 核心逻辑- 通过phone找数据库记录- 获取盐,和当前传递的密码就行加密后匹配- 生成token令牌- controller

/**

* 登录* @param loginRequest* @return*/@PostMapping("login")public JsonData register(@RequestBody UserLoginRequest loginRequest){JsonData jsonData = userService.login(loginRequest);return jsonData;}

- service<a name="fc4dd2bf"></a>#### 第4集 分布式应用下登录检验解决方案 JWT讲解**简介:分布式应用的登录检验解决方案 JWT讲解 json web token**-什么是JWT- JWT 是一个开放标准,它定义了一种用于简洁,自包含的用于通信双方之间以 JSON 对象的形式安全传递信息的方法。 可以使用 HMAC 算法或者是 RSA 的公钥密钥对进行签名- **简单来说: 就是通过一定规范来生成token,然后可以通过解密算法逆向解密token,这样就可以获取用户信息**

{id:888,name:'小D',expire:10000}funtion 加密(object, appsecret){xxxxreturn base64( token);}function 解密(token ,appsecret){xxxx//成功返回true,失败返回false}

-优点- 生产的token可以包含基本信息,比如id、用户昵称、头像等信息,避免再次查库- 存储在客户端,不占用服务端的内存资源-缺点-token是经过base64编码,所以可以解码,因此token加密前的对象不应该包含敏感信息,如用户权限,密码等-如果没有服务端存储,则不能做登录失效处理,除非服务端改秘钥-JWT格式组成 头部、负载、签名- header+payload+signature- 头部:主要是描述签名算法- 负载:主要描述是加密对象的信息,如用户的id等,也可以加些规范里面的东西,如iss签发者,exp 过期时间,sub 面向的用户- 签名:主要是把前面两部分进行加密,防止别人拿到token进行base解密后篡改token-关于jwt客户端存储- 可以存储在cookie,localstorage和sessionStorage里面<a name="b181b054"></a>#### 第5集 登录校验Json Web Token实战之封装通用方法**讲解:引入相关依赖并开发JWT工具类, 开发生产token和校验token的办法**-聚合工程加入版本依赖,common项目加入相关依赖

<!-- JWT相关 --><dependency><groupId>io.jsonwebtoken</groupId><artifactId>jjwt</artifactId><version>0.7.0</version></dependency>

-common项目中封装生产token方法

/*** 根据用户信息,生成令牌** @param user* @return*/public static String geneJsonWebToken(LoginUser user) {Long userId = user.getId();String token = Jwts.builder().setSubject(SUBJECT).claim("head_img", user.getHeadImg()).claim("id", userId).claim("name", user.getName()).claim("phone", user.getPhone()).setIssuedAt(new Date()).setExpiration(new Date(System.currentTimeMillis() + EXPIRE)).signWith(SignatureAlgorithm.HS256, SECRET).compact();token = TOKEN_PREFIX + token;return token;}

-封装校验token方法

/**

* 校验token的方法** @param token* @return*/public static Claims checkJWT(String token) {try {final Claims claims = Jwts.parser().setSigningKey(SECRET).parseClaimsJws(token.replace(TOKEN_PREFIX, "")).getBody();return claims;} catch (Exception e) {return null;}}

-登录整合

//生成token令牌LoginUser userDTO = new LoginUser();BeanUtils.copyProperties(userDO, userDTO);String token = JWTUtil.geneJsonWebToken(userDTO);return JsonData.buildSuccess(token);

<a name="6008edef"></a>#### 第6集 请求路径调整+账号微服务注册登录全流程测试**简介: 账号微服务之注册登录全流程测试**- 请求路径调整- 注册流程验证- 登录流程验证<a name="bd08c79b"></a>#### 第7集 账号微服务之通用登录拦截器开发和用户信息传递**简介:账号微服务登录拦截器开发和用户信息传递**-开发登录拦截器- 解密JWT- 传递登录用户信息- attribute传递- threadLocal传递-SpringBoot拦截器代码开发

@Slf4j public class LoginInterceptor implements HandlerInterceptor {